英伟达 NVIDIA AI 全景解析

NVIDIA 概述

公司概况

NVIDIA作为全球顶尖科技公司,早期深耕图形处理器设计制造,现已跃升为人工智能领域的领军者,产品和服务覆盖AI应用的全方位,引领科技潮流。

NVIDIA,1993年创立于美国加州,由黄仁勋、Chris Malachowsky和Curtis Priem创立。其GPU从游戏领域拓展至AI、数据中心、汽车、医疗和机器人等多元领域。凭借卓越的股市表现和AI产业对高性能GPU的强劲需求,NVIDIA已稳固确立为全球领先的AI芯片公司。

All in AI 战略

NVIDIA CEO黄仁勋在2023年GTC大会上宣布,公司将全面进军AI领域,推出全新服务和硬件,为AI产品提供强大动力,引领行业新潮流。

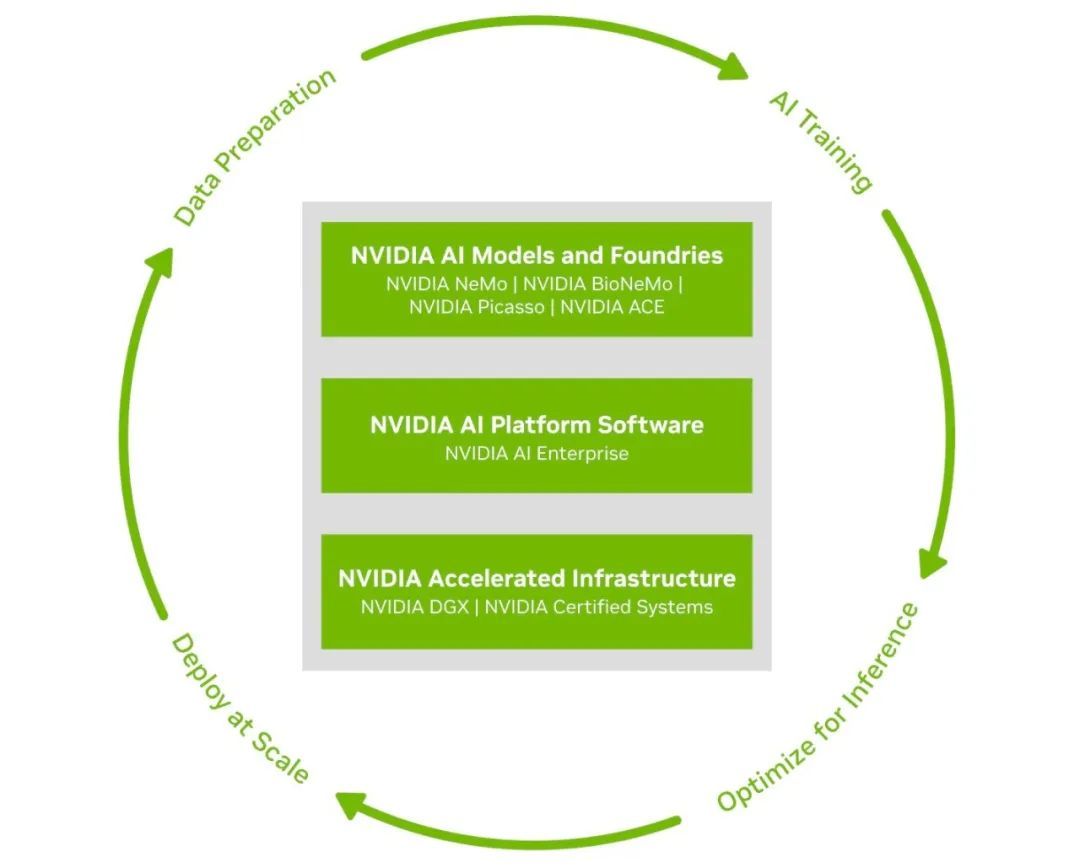

NVIDIA 的 AI 产品和服务主要包括以下几个方面:

- AI 硬件平台

- AI 软件和工具

- AI 企业软件套件

- AI 应用框架

- AI 云服务

NVIDIA提供从硬件到软件的全方位AI解决方案,推动AI技术广泛应用与创新,助力各行业数字化转型,引领智能未来。

NVIDIA AI 产品体系

核心支撑技术

Ada Lovelace 架构

NVIDIA Ada Lovelace架构,第五代GPU革新之作,2022年9月问世。专为游戏、创作、AI及高性能计算量身打造,引领性能革命。这一里程碑式架构,标志着光线追踪与AI神经图形技术的飞跃,大幅刷新GPU性能基准,引领未来。

揭秘NVIDIA Ada Lovelace架构,引领未来图形处理新纪元!探索其强大性能,尽在[链接]。立即点击,体验视觉革命!

Ada Lovelace 架构的关键特性如下:

- 第四代Tensor Core革新AI技术,支持NVIDIA DLSS及全新DLSS 3,借助Hopper数据中心GPU的FP8 Transformer引擎,首次实现吞吐量飞跃,引领AI性能新纪元。

- 第三代RT Core显著增强光线与三角形求交性能,RT-TFLOP峰值性能飙升。配备全新Opacity Micromap (OMM) 与Displaced Micro-Mesh (DMM) 引擎,实时光线追踪处理复杂几何场景能力大幅跃升,为游戏与图形设计带来前所未有的视觉震撼。

- 着色器执行重排序(SER)技术,动态优化工作负载,增强光线追踪着色器性能高达2倍,助力游戏帧率飙升25%。

- DLSS 3,NVIDIA的革命性图形技术,由第四代Tensor Core与光流加速器赋能,AI驱动,打造卓越画质,帧数飞跃提升,引领图形处理新纪元。

- 全新GPU架构搭载第八代NVIDIA编码器(NVENC),支持AV1编码,效率较H.264提升40%。主播在保持推流比特率稳定的同时,可轻松升级直播画面分辨率,呈现更高清画质。

Hopper 架构

NVIDIA Hopper,第四代GPU架构,引领AI与高性能计算(HPC)前沿。2022年3月问世,主打H100 Tensor Core GPU,融合多项创新技术,满足计算需求激增。NVIDIA Hopper,加速计算领域的革新之作,为您带来前所未有的体验。

以下是 Hopper 架构的一些关键特性:

- Hopper架构通过引入专为加速Transformer模型设计的Transformer引擎,显著提升AI模型训练效率。该引擎对自然语言处理(NLP)等关键AI应用具有重大意义,确保训练过程更高效、专业。

- Hopper架构的Tensor Core实现FP8和FP16混合精度,高效执行AI计算,提升速度。此混合精度技术确保精度与性能双提升,尤其适用于大规模AI工作负载,实现高效能AI运算。

- Hopper架构显著优化性能,TF32、FP64、FP16及INT8精度的FLOPS提升高达3倍,大幅加速HPC与AI工作负载的处理速度,实现效率飞跃。

- Hopper架构强势融入第四代NVLink与第三代NVSwitch技术,赋予多GPU间前所未有的高速通信能力,这一突破对于推动大规模AI和HPC应用的发展具有举足轻重的意义。

- Hopper架构革新引入机密计算,确保数据处理全程安全。数据与应用代码在处理中均受保护,即便在存储和传输时加密,也能维护数据的安全。

- Hopper架构革新多实例GPU(MIG)技术,实现单GPU多实例分割,每实例独立内存与计算资源,大幅提升资源利用率和安全性。

- DPX指令:Hopper架构独具DPX指令,专为动态编程算法加速设计,广泛适用于最短路径问题、生物信息学等多计算场景,提升处理效率。

NVIDIA Hopper架构,凭借其卓越特性,成为处理AI与HPC领域大数据与复杂计算的理想之选。技术创新让Hopper架构在数据中心和科学计算中展现空前性能与效率,引领下一代工作负载处理新纪元。

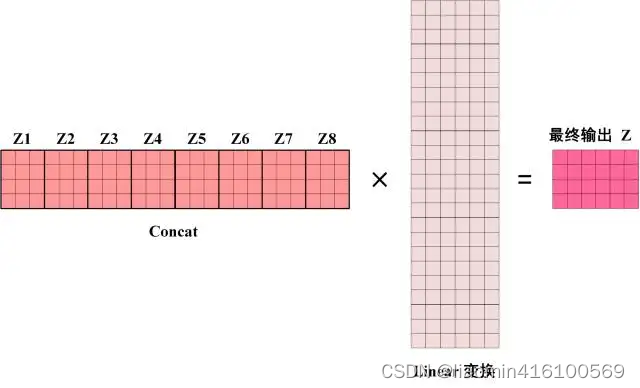

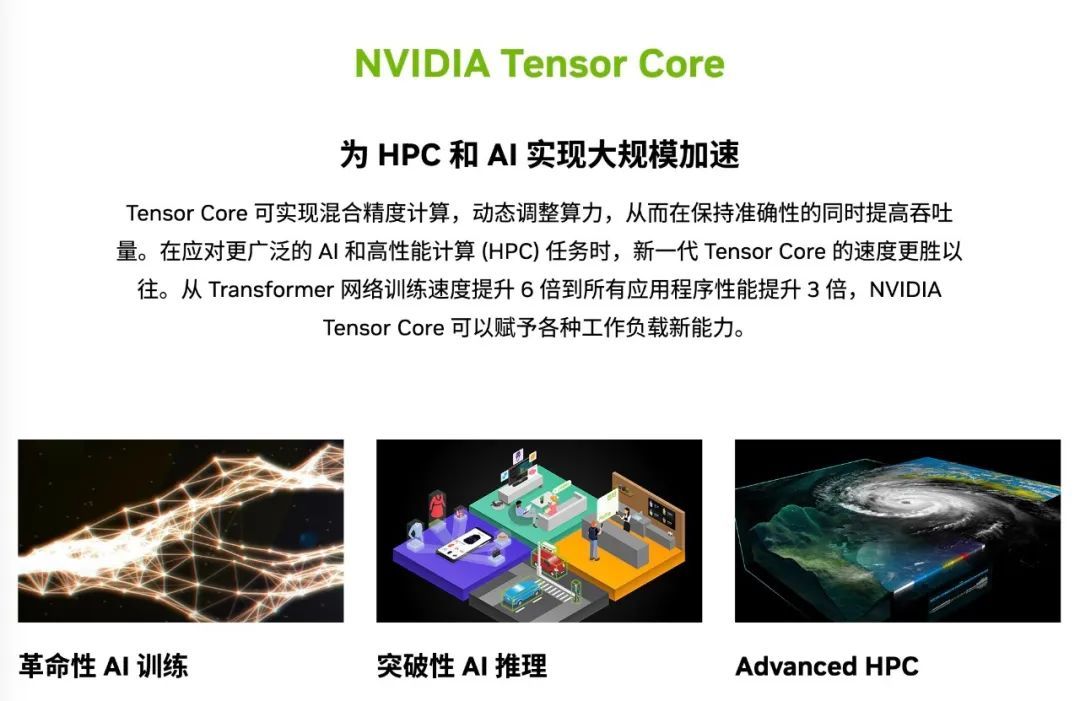

Tensor Cores

NVIDIA GPU中的Tensor Core专为加速深度学习和高性能计算中的矩阵运算而设计。其高效多精度计算能力在保持精准度的同时,显著提升吞吐量,对AI推理和训练具有至关重要的作用。Tensor Core是推动AI创新的关键组件。

探索NVIDIA数据中心Tensor Cores的强大性能,为您的数据中心计算提供前所未有的速度和精度。立即访问:https://www.nvidia.cn/data-center/tensor-cores/

以下是 NVIDIA Tensor Core 早期版本及其特性:

第一代:NVIDIA Volta Tensor Core

- 于 2017 年 5 月发布。

- Volta,NVIDIA的首代Tensor Core架构,凭借FP16与FP32混合精度矩阵乘法,实现性能飞跃,引领行业新标杆。

- Volta架构在训练和推理性能上大幅超越Pascal,其峰值TFLOPS性能分别飙升12倍(训练)和6倍(推理),展现了卓越的效能飞跃。

第二代:NVIDIA Turing Tensor Core

- 于 2018 年 9 月发布。

- Turing架构显著增强了Tensor Core的算力,支持FP32至FP16,乃至INT8和INT4的多精度计算。其性能较Pascal GPU有了质的飞跃,为数据处理提供了更为高效和灵活的选择。

- Turing 集成了 RT Core 第一代,实现了高效的 AI 推理。

第三代:NVIDIA Ampere Tensor Core

- 于 2020 年 5 月发布。

- Ampere架构的Tensor Core革新性引入TF32与FP64精度,并将功能拓宽至HPC领域。其第三代技术不仅支持BFloat16、INT8及INT4,更打造了AI训练与推理的通用加速器,显著提升计算效率,引领行业进入全新阶段。

- GPU A100与A30架构集高效能运算与强大Tensor核心于一体,支持完整矩阵运算,通过IEEE认证,并采用FP64精度,确保运算精准高效。

- Ampere架构革新,GPU支持多实例GPU(MIG)功能,实现工作负载的GPU共享。MIG技术使GPU分割成多个独立、受保护的实例,每个实例均享有独立的高带宽内存、快取和运算核心,实现更高效的资源利用。

Tensor Core,NVIDIA GPU之核心,携手NVIDIA NGC目录中的硬件、网络、软件、库及优化的AI模型与应用,打造强大端到端AI与HPC平台。该平台助力研究人员迅速获取计算结果,实现解决方案的规模化生产部署,加速科研与产业发展。

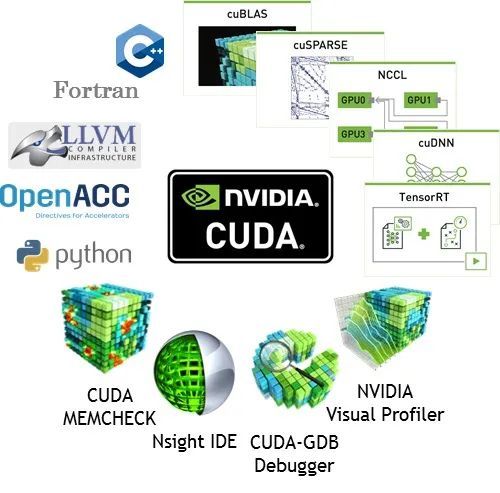

CUDA

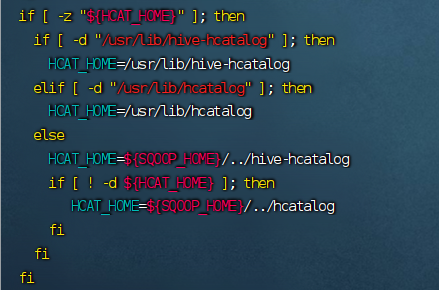

NVIDIA CUDA,即计算统一设备架构,是NVIDIA针对GPU上通用计算打造的并行计算平台与编程模型。它赋予开发者利用NVIDIA GPU进行高性能计算任务的能力,实现了GPU加速计算,极大地提升了计算效率与性能。

CUDA为开发者提供了一站式编程解决方案,涵盖编译器nvcc、调试器cuda-gdb、性能分析器nvprof,及丰富的库如cuBLAS、cuFFT等。这些强大工具支持开发者编写GPU并行程序,并通过API直接控制GPU资源,包括内存管理和执行流,助力开发者高效利用GPU性能,实现卓越的计算效率。

CUDA 的主要特点包括:

- CUDA编程模型简便易用,采用类似C/C++的接口,让基础编程者也能编写GPU加速代码。支持主流语言(C、C++、Fortran、Python、MATLAB),仅通过几个关键字即可表达并行性,为开发者提供高效、灵活的编程体验。

- CUDA生态系统强大,拥有庞大开发者社区、丰富文档资源、持续更新的软件库和工具,全面支持最新GPU技术,引领行业前沿。

- CUDA跨平台兼容Windows、Linux、macOS,助力开发者实现多系统无缝应用开发与部署,轻松应对多样化环境需求。

借助CUDA,开发者释放GPU的并行处理潜能,加速计算任务,助力科学研究、工程设计和数据分析等领域实现革命性成果。

CUDA-X

NVIDIA CUDA-X,专为AI应用打造的GPU加速软件库,基于CUDA并行编程模型,提供深度学习、机器学习及高性能计算(HPC)的顶级优化功能,助力AI应用程序的高效开发与快速部署。

探索NVIDIA CUDA-X技术,开启高性能计算新时代,详情请访问:[https://www.nvidia.cn/technologies/cuda-x/。](https://www.nvidia.cn/technologies/cuda-x/%E3%80%82)

以下是 CUDA-X AI 的主要组成部分和特点:

- cuML:专为数据科学和机器学习设计的GPU加速库,接口友好兼容scikit-learn,大幅提升算法运行效率。

- cuDF:GPU加速的DataFrame库,高效处理大数据,媲美Pandas,为数据分析提供强大动力。

- cuGraph:提供在图形上执行高性能分析的库,支持图形算法和数据结构。

- CUDA-X AI库完美融入主流深度学习框架(TensorFlow、PyTorch、MXNet)与数据科学软件(RAPIDS),无缝对接领先云平台(AWS、Microsoft Azure、Google Cloud)。NVIDIA GPU Cloud (NGC)网站提供免费下载,让AI应用部署更便捷,集成度高,可用性广,助您轻松驾驭AI时代。

- CUDA-X AI库兼容性强,支持在台式机、工作站、服务器、云计算及IoT设备中的NVIDIA GPU上部署,实现多设备协同工作,助力AI应用广泛落地。

- 性能飞跃:与NVIDIA Tensor Core GPU完美融合,大幅加速AI应用程序的开发与部署,效率卓越。

CUDA-X AI赋能开发者,释放GPU强大算力,加速工作效率,畅享卓越性能提升。无论是创新应用还是优化旧有程序,CUDA-X AI皆提供高效、实用的解决方案,助您轻松驾驭未来。

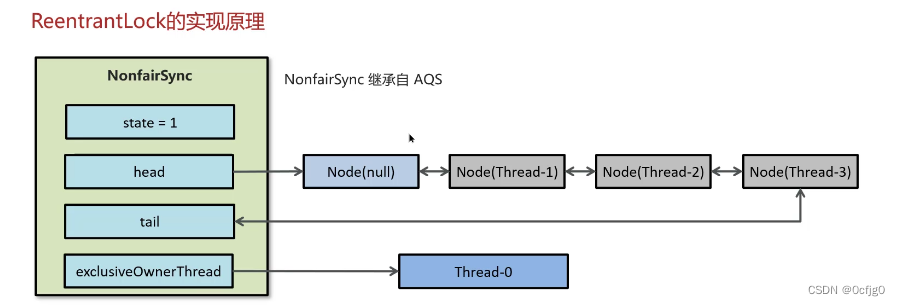

NVLink 和 NVSwitch

NVIDIA的NVLink与NVSwitch技术,专为数据中心与高性能计算(HPC)应用打造,显著提升多GPU系统以及CPU与GPU间的通信速度和效率,是业界领先的高速互连解决方案。

探索NVIDIA NVLink高速互连技术,赋能数据中心,释放强大计算潜能,链接未来可能。立即访问:[链接]

NVIDIA NVLink 技术

NVLink,高速互连技术的典范,实现GPU间及GPU与CPU间的极速数据传输。其芯片间直连设计,带宽超越传统PCIe,延迟更低。NVLink技术,以卓越性能,引领数据传输新纪元。

- NVIDIA NVLink第四代技术实现超高带宽,其性能是PCIe 5.0的7倍。搭载NVIDIA H100 Tensor Core GPU的系统,单GPU支持总带宽高达900 GB/s,领先业界,加速计算体验。

NVIDIA NVSwitch 技术

NVSwitch,基于NVLink构建,专为计算密集型工作负载定制,实现超高带宽与超低延迟通信,确保数据高效传输,助力高性能计算新纪元。

- NVSwitch采用多对多通信设计,通过多个NVLink端口,实现节点内外GPU间全带宽互联,显著提升数据传输效率。

- NVSwitch搭载NVIDIA SHARP引擎,实现网络内归约与组播加速,显著提升集合运算效率,为性能注入强劲动力。

- 打造高效大型GPU集群:利用NVSwitch,跨节点扩展NVLink连接,构建数据中心级GPU集群,助力大型AI任务飞速完成。

NVLink与NVSwitch技术融合,打造NVIDIA超强端到端AI与HPC平台。赋能研究者与企业,实现结果快速获取,并高效部署至生产环境,实现全规模加速,引领行业前沿。

NVIDIA重磅推出NVLink-C2C技术,这是一项革新性的芯片互连解决方案。该技术将NVLink扩展至芯片间互连,让GPU、DPU、CPU与定制芯片无缝融合。NVLink-C2C凭借快速数据传输、行业兼容协议、低延迟、低功耗及高密度连接等特性,成为半定制芯片设计的首选。这一技术将助力构建高性能、高效率的计算系统,引领行业迈向新的里程碑。

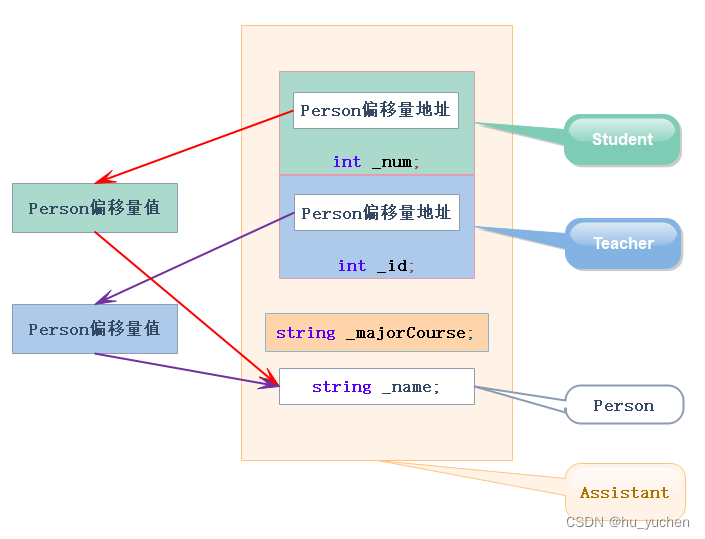

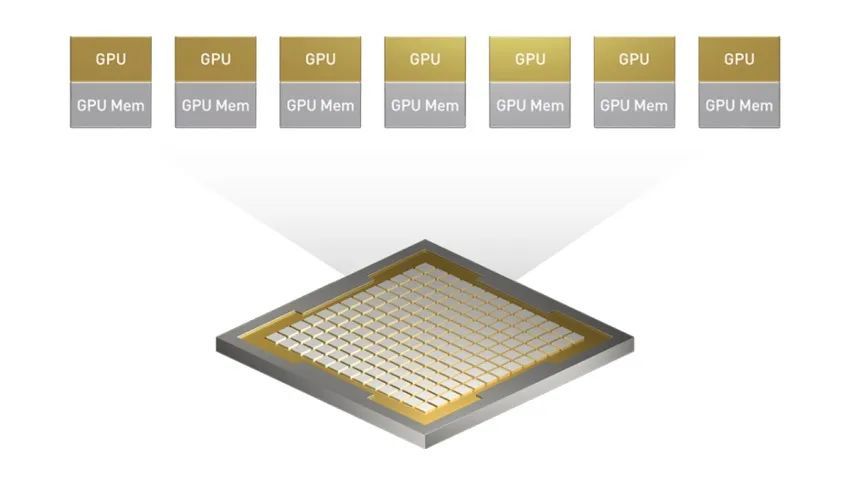

多实例 GPU

NVIDIA多实例GPU(MIG)技术,实现GPU的虚拟化创新。该技术将单一物理GPU分割为多个独立实例,并行执行不同任务,显著提升GPU利用率,优化数据中心资源分配,实现高效能计算新境界。

探索NVIDIA多实例GPU技术,一卡多用,释放极致性能。立即访问[链接],了解如何优化您的图形处理体验!

MIG 技术的主要功能和技术特点:

- MIG多实例分割技术,可将NVIDIA H100、A100或A30 Tensor Core GPU高效划分为七个独立实例。每实例均配备高带宽显存、缓存及计算核心,实现资源最大化利用。

- 通过MIG技术,管理员可在单一GPU上实现资源倍增,最高达7倍,极大提升研发资源的灵活性与充裕度,满足研发团队的广泛需求。

- MIG优化GPU利用率,灵活选择实例大小,为工作负载精准匹配GPU资源,提升数据中心投资回报率,实现高效能利用。

- MIG技术赋能,单GPU并行运行推理、训练及HPC等多重工作负载,显著提升并行处理性能,高效处理各类任务。

- 动态配置与资源优化:管理员灵活调整MIG实例,满足日间低吞吐量推理与夜间深度学习训练需求,实时响应用户与业务变动。

- MIG实例采用专用硬件资源,实现高效安全隔离,保障稳定QoS,有效避免故障扩散,确保应用稳定运行,互不干扰。

- MIG实例支持多类工作负载,涵盖交互式模型开发、深度学习训练、AI推理及高性能计算等,全面满足您的多样化应用需求。

- MIG赋能IT与开发运营团队,实现GPU精细配置,全面兼容主流企业计算环境,无需改变CUDA平台,满足多样化计算需求。

NVIDIA MIG技术实现GPU资源共享与隔离的高效管理,为云计算服务与企业数据中心带来操作灵活性与显著的成本效益。

机密计算

NVIDIA机密计算(CCX)是数据安全的新标杆,确保数据在收集、存储、使用各阶段均受严密保护。此技术为AI应用处理敏感数据提供坚实后盾,全程保障数据机密性与完整性,引领行业安全新高度。

以下是 NVIDIA 机密计算的主要功能特性:

- NVIDIA机密计算实现端到端数据保护,贯穿传输、处理与存储全流程,有效抵御外部攻击与内部威胁,确保数据安全无虞。

- 实现硬件级安全隔离,无论本地、云端或边缘,我们均确保虚拟机完全隔离,并保障数据在CPU与H100 GPU间传输时全程加密解密,守护数据安全。

- 打造安全的执行环境,我们运用内置硬件防火墙,构建物理隔离的受信任执行环境(TEE),全方位保护H100 GPU工作负载,确保数据仅由授权用户访问和处理。

- 设备认证强化:通过CCX功能,仅授权用户能在H100的TEE中执行数据与代码,确保使用正版NVIDIA H100 GPU,固件安全无篡改,全面保障数据执行的可信与可靠。

- 无需修改应用代码,即可通过CCX充分利用H100 GPU优势,加速端到端AI工作负载,轻松实现GPU加速,提升工作效率。

- CCX严密守护H100 GPU上AI模型与算法的机密与完整,确保ISV能在共享或远程架构上高效分发、部署其专有AI模型,全面捍卫AI知识产权。

- CCX赋能安全多方协作,保障组织与伙伴共同训练、评估AI模型,数据模型双重保护,严防未授权访问及内部威胁,协作无忧。

NVIDIA机密计算为AI应用提供安全计算环境,确保敏感数据处理安全,保护企业数据和知识产权,满足监管合规,为数据安全保驾护航。

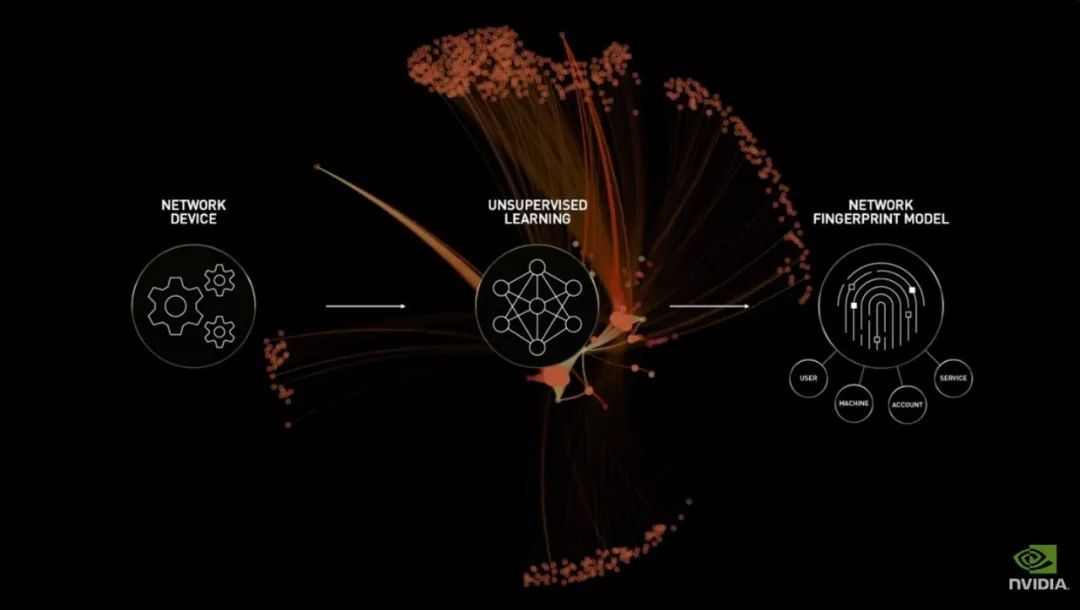

Morpheus AI

NVIDIA Morpheus AI框架,综合解决方案,强化AI与机器学习模型的安全与鲁棒性。先进技术护航,助开发者与企业抵御网络攻击,确保数据安全无虞,免受泄露威胁。

以下是 Morpheus AI 框架的关键功能和技术特点:

- Morpheus框架支持对抗性训练,通过引入对抗性样本强化模型鲁棒性,有效识别并抵御潜在攻击,提升模型安全性能。

- Morpheus运用差分隐私与同态加密技术,确保数据隐私安全,实现敏感信息无泄露的数据处理与模型训练。

- Morpheus端到端解决方案,全面涵盖数据收集、预处理、模型训练、部署及监控,全程安全无忧,一站式解决您的所有需求。

- Morpheus实现高效集成与广泛兼容,无缝融入AI与机器学习流程,兼容多种深度学习框架与工具,助力您轻松构建智能应用。

NVIDIA Morpheus AI框架致力于构筑AI系统的安全基石,确保其在复杂网络威胁下稳定运行。该框架不仅促进AI技术的可持续发展,更强化用户与企业数据安全防护,为AI未来保驾护航。

AI 硬件

GPU

Hopper-赫伯架构

NVIDIA Hopper 架构 GPU 主要包括以下系列:

- H100 系列:满足了数据中心和 HPC 应用的需求

- Quadro RTX 6000系列,专为专业工作站和数据中心打造,性能卓越,可靠性一流,助力您的工作更高效、更稳定。

主打型号:

H100:面向数据中心和高性能计算 (HPC),提供最高性能和可扩展性。

- 搭载80GB HBM3显存,实现614 TFLOPS的FP64双精度浮点性能,AI性能更是高达1.5 PFLOPS,为各类应用提供强劲的计算支持。

- 支持 PCIe Gen5 和 HBM3 等最新技术。

Ampere-安培架构

NVIDIA Ampere 架构 GPU 主要包括以下系列:

- A100 系列:满足了数据中心和 HPC 应用的需求

- GeForce RTX 30系列,游戏玩家尽享极致体验,创意人士释放无限创作潜能,引领未来娱乐与创意新纪元。

主打型号:

A100:面向数据中心和高性能计算,提供最高性能和可扩展性。

- 配备80GB HBM2显存,具备19.5 TFLOPS卓越FP64双精度浮点运算能力及高达319 TFLOPS的AI性能,助力前沿科技腾飞。

- 支持 PCIe Gen 4、ECC 内存和虚拟化等技术。

L4/L40 系列:提供卓越的性能,能够满足各种数据中心应用的需求。

- 支持 PCIe Gen 5 和 GDDR6X 显存

Turing-图灵架构

NVIDIA Turing 架构 GPU 主要包括以下系列:

- Titan RTX:满足了专业人士和发烧友的需求

- Quadro RTX 系列:为专业工作站和数据中心提供了专业级的性能和可靠性

Volta-瓦特架构

NVIDIA Volta 架构 GPU 主要包括以下系列:

- Tesla V100:满足了数据中心和 HPC 应用的需求

- Titan V:为专业人士和发烧友提供了极致的性能

- Quadro GV100:为专业工作站和数据中心提供了专业级的性能和可靠性

NVIDIA H200

NVIDIA H200 Tensor Core GPU,基于领先的Hopper架构,专为加速生成性AI与高性能计算(HPC)打造。作为全球首款HBM3e内存GPU,H200以其超大内存容量与极速内存带宽,在处理海量数据集时展现出卓越性能,尤其在生成性AI与大型语言模型(LLMs)应用中,更是如虎添翼,为数据中心带来前所未有的计算动力。

以下是NVIDIA H200 GPU的一些关键特性和优势:

- H200 GPU搭载141GB HBM3e内存,带宽高达4.8TB/s,内存容量近乎NVIDIA H100的两倍,带宽提升达1.4倍,展现卓越性能。

- H200 GPU在处理LLMs如Llama2时,推理速度比H100提升高达2倍。对于内存密集型HPC应用,其高内存带宽实现数据高效访问与处理,相较CPU加速高达110倍,显著提升性能。

- H200 GPU在功耗等同H100的同时,实现卓越性能,为AI工厂与超级计算系统带来速度飞跃与环保革新。其高效能源利用,不仅助力AI与科学领域飞速发展,更为社区创造显著经济优势。

- NVIDIA Hopper架构引领性能革新,相较前代实现巨大飞跃,并凭借NVIDIA TensorRT-LLM™等软件增强技术,持续推动性能提升,展现无限可能。

- NVIDIA AI Enterprise携手H200 GPU,构筑高效AI就绪平台。简化开发流程,加速生成性AI、计算机视觉、语音AI等应用的生产就绪部署。企业级的安全、管理、稳定性与支持,为您的AI之旅保驾护航。

NVIDIA H200 GPU凭借卓越性能,成为推动AI与科学计算革新的利器,专治大数据与复杂计算难题。尽管尚未上市,但预计将在GTC 2024震撼亮相,引领新一轮计算革命。

NVIDIA Tesla

NVIDIA Tesla,数据中心GPU的佼佼者,专为高性能计算和超大规模数据中心工作负载而生。其强大性能助力数据科学家和研究人员在能源勘探、深度学习等领域飞速处理海量数据,效率倍增。

探索NVIDIA数据中心GPU的无限潜能,访问我们的专业介绍页面,了解最新技术和产品,助您打造高效能数据中心:

以下是 NVIDIA Tesla 的主要特点:

- NVIDIA Tesla GPU加速器卓越性能,轻松应对严苛HPC工作负载,解析PB级数据速度远超传统CPU,实现数量级提升。

- Tesla GPU加速器广泛适用,不仅助力高性能计算(HPC),更显著提升虚拟桌面、应用程序及工作站性能,用户密度大增。

- NVIDIA携手合作伙伴推出GPU加速服务器平台,专为AI、HPC及加速计算工作负载设计。该平台涵盖训练(HGX-T)、推理(HGX-I)及超级计算(SCX)应用,为您提供卓越性能的理想选择。

- NVIDIA GPU服务器加速深度学习训练,将数月缩短至数小时甚至数分钟。对于推理任务,Tesla GPU提供远超单插槽CPU服务器的推理吞吐量,大幅提升性能。

NVIDIA数据中心GPU,以卓越性能助力数据中心,加速计算密集型任务,促进科研与商业应用领域的飞速创新与发展。

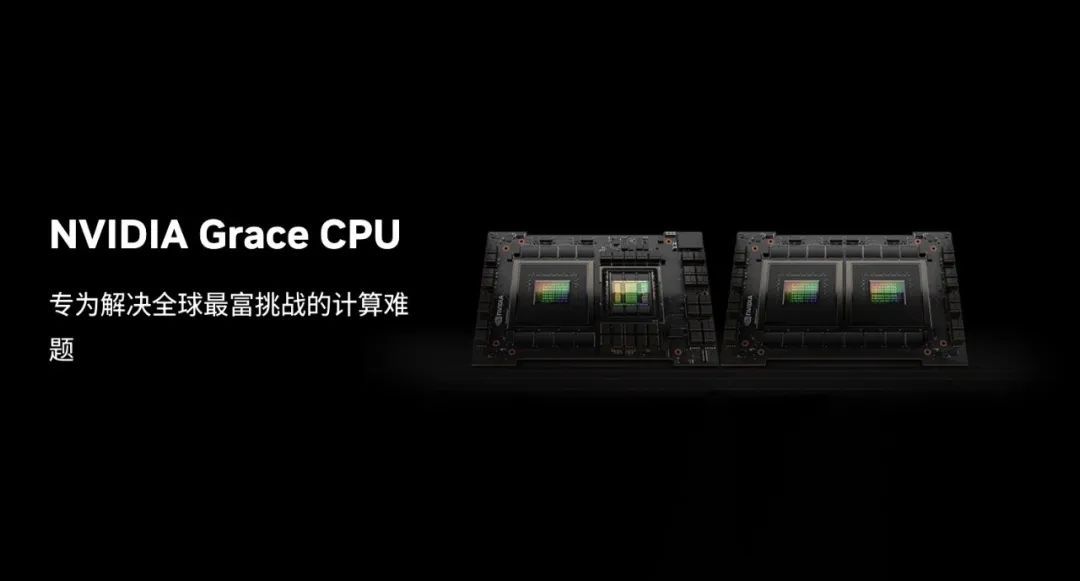

Grace CPU

NVIDIA Grace CPU超级计算平台,专为高性能计算、AI、数据分析等应用打造,满足现代数据中心对性能、能效及带宽的极致追求,引领计算新纪元。

以下是 NVIDIA Grace CPU 超级计算平台的主要特点:

- Grace CPU:专为高性能计算打造,提供卓越效能与能效,支持多配置高带宽连接,轻松应对严苛计算挑战。

- Grace Hopper超级芯片融合Grace与Hopper架构,搭载NVIDIA NVLink-C2C技术,为AI和HPC应用带来革命性的CPU+GPU一致性内存模型,引领性能新纪元。

- Grace CPU超级芯片:搭载NVLink-C2C技术,集成144个Arm Neoverse V2核心,内存带宽高达1TB/s,引领性能巅峰。

- Grace系列参考设计专为现代工作负载打造,聚焦数字孪生、AI与HPC领域。融合NVIDIA GPUs与BlueField-3 DPU,为多元应用量身优化系统设计,引领未来计算新潮流。

- Grace CPU搭载Arm Neoverse V2核心,节能高效设计释放卓越性能,助力科学家与研究人员轻松应对复杂问题,提升工作效率。

- Grace CPU搭载LPDDR5X内存,实现高带宽与能效双优,且借助ECC技术,确保服务器级可靠性,为您的业务保驾护航。

NVIDIA Grace CPU超级计算平台赋能新一代ARM超级计算机,驱动大规模模型训练与尖端科学计算,引领科学发现与技术创新的浪潮。

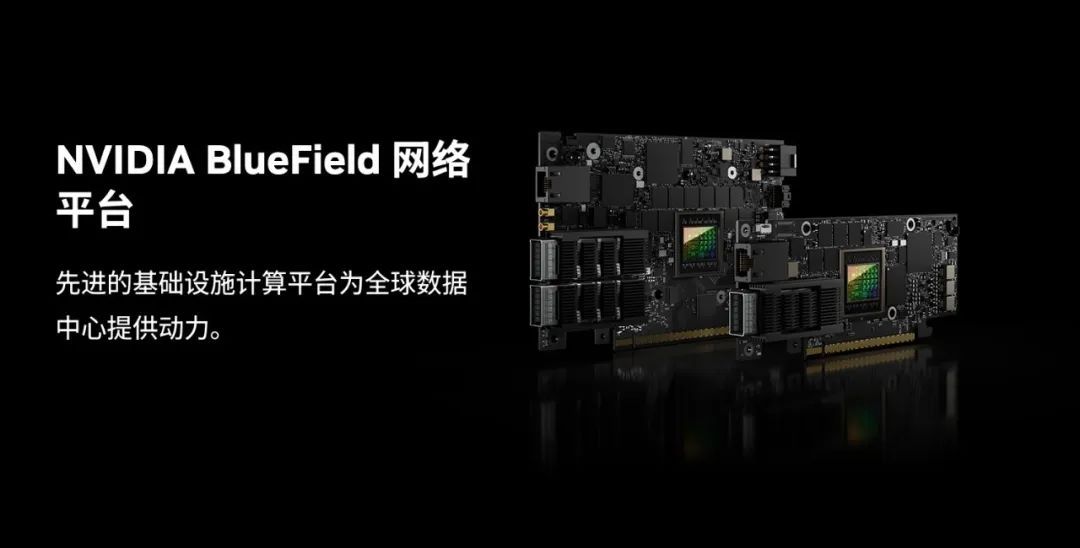

BlueField DPU

NVIDIA BlueField网络平台,专为现代数据中心和超级计算集群打造的数据处理器(DPUs)和超级网络接口控制器(SuperNICs),引领企业迈向加速计算和AI新时代。

以下是 NVIDIA BlueField 网络平台的主要特点:

- BlueField网络平台凭借卓越计算力和内置的软件定义硬件加速器,为数据中心转型提供安全、高效的加速基础设施,轻松驾驭多样工作负载。

- 产品系列:

- BlueField-3 DPU,400Gb/s极速基础设施计算平台,线速处理网络、存储与安全任务,软件定义硬件加速,打造智能计算新纪元。

- BlueField-3 SuperNIC,超大规模AI工作负载的网络加速器,以高达400Gb/s的RDMA连接,卓越优化AI性能,为AI工作负载效率保驾护航。

- BlueField-2 DPU集成NVIDIA ConnectX-6 Dx功能与可编程Arm核心,为主机提供卓越加速能力、安全保障与运行效率,是您的理想选择。

- NVIDIA DOCA:专为BlueField DPU打造的软件开发套件,助力快速构建应用与服务,引领数据中心创新风潮。

- BlueField网络平台,专为AI设计,高效支持AI工作负载,引领数据中心网络迈入AI新时代,以高性能网络满足AI需求,驱动智能未来。

NVIDIA BlueField网络平台凭借DPU和SuperNIC创新产品,专为数据中心打造高性能、高安全、高效率的网络基础设施,特别在AI与加速计算领域展现卓越性能。

Quantum InfiniBand

NVIDIA InfiniBand,高性能网络解决方案,专为超级计算机、AI及云数据中心定制。高速、低延迟、可扩展,轻松驾驭高分辨率模拟、大数据处理及并行算法,满足您复杂工作负载的卓越需求。

探索NVIDIA Infiniband产品系列,领先的高速互联解决方案,助您构建高效、可靠的数据中心网络,点击链接了解更多。

以下是 NVIDIA InfiniBand 网络解决方案的主要组件和特点:

- InfiniBand网卡(HCA)凭借极低延迟、超高吞吐量,搭载NVIDIA网络计算引擎,为现代工作负载带来前所未有的加速体验。

- NVIDIA BlueField DPU集计算力、高速网络与可编程性于一身,为高强度工作负载提供卓越的硬件加速解决方案,助力性能飞跃。

- InfiniBand交换机:以卓越性能、高端口密度及NVIDIA SHARP等创新技术,引领工业、AI和科学应用领域的性能飞跃。

- 路由器与网关系统:卓越呈现InfiniBand路由器、MetroX-2长距离连接以及Skyway InfiniBand至Ethernet网关系统,确保网络可扩展性与子网隔离,为您打造高效、安全的网络环境。

- NVIDIA MetroX远程互连系统,实现远程InfiniBand数据中心与存储的无缝连接,有效扩展InfiniBand覆盖范围,助力高效数据传输。

- LinkX InfiniBand线缆与收发器,专为提升HPC网络性能设计,满足高带宽、低延迟的顶尖连接需求。

- 增强功能:包括网络计算、网络自愈、服务质量和支持多种网络拓扑的集中式管理。

- 软件支持卓越:集成MLNX_OFED、HPC-X、UFM、Magnum IO等工具,全面优化网络性能,简化管理,助力高效运维。

NVIDIA InfiniBand网络方案凭借尖端技术与软件支持,为高性能计算、AI及超大规模云基础设施实现性能飞跃,并大幅降低成本与复杂性。

软件与服务

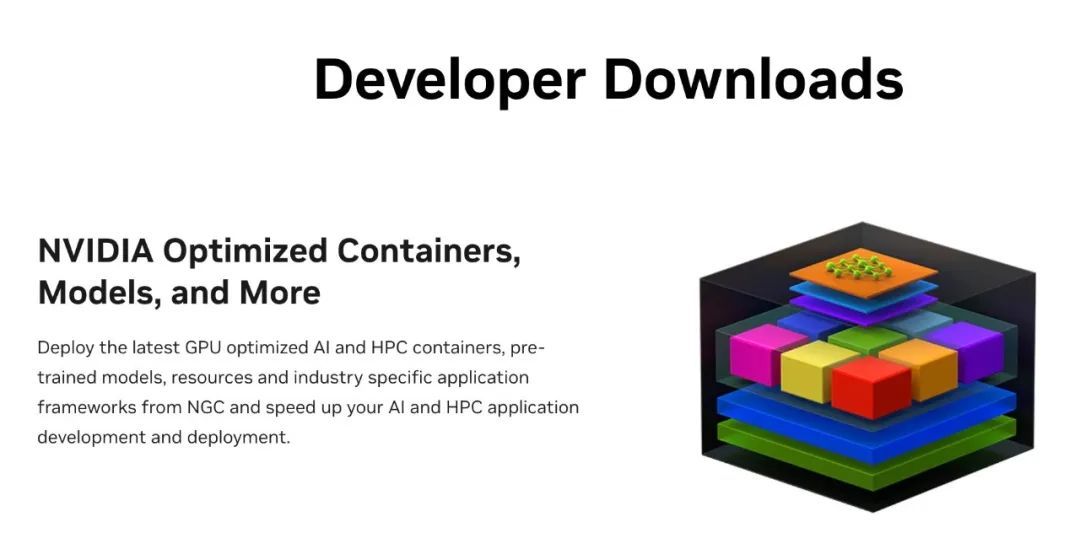

NGC

NVIDIA NGC,即NVIDIA GPU Cloud,专为端到端AI和数字孪生打造。它汇聚企业服务、软件、管理工具及支持,助力用户通过性能卓越的软件,在云、本地或边缘系统上迅速构建并部署解决方案,推动创新。

以下是 NVIDIA NGC 的主要信息:

- 企业服务和支持:NGC 提供管理服务和支持,帮助用户快速将解决方案推向市场。

- NGC软件中心,GPU优化,支持企业级容器、AI预训练模型和行业SDK,加速端到端工作流,专业且高效。

- AI Playground,简易界面,浏览器直达生成式AI模型体验,无需配置,轻松上手,畅享智能乐趣。

- 预训练模型:提供先进的预训练模型,帮助用户快速构建自定义模型。

- Jupyter Notebook提供丰富资源,数百个笔记本助力用户高效理解、个性化定制、快速测试与构建模型,加速您的数据分析之旅。

- 安全软件:每月对容器进行安全扫描并提供详细报告,确保容器符合公司的安全策略。

- NGC多用例平台:为各行业用例提供即用型容器、预训练模型、SDK及Helm图表,加速应用开发与部署,提升效率。

- NGC目录软件灵活部署,支持裸金属服务器、Kubernetes及虚拟化环境,充分释放GPU性能,实现高效利用。

NGC目录,NVIDIA GPU Cloud的核心,为数据科学家、开发者和研究人员提供一站式资源宝库,涵盖容器、预训练模型、专业SDK、定制用例集及高效AI实施的Helm图表。这些资源助力用户迅速发现、构建及部署AI解决方案,加速创新步伐。

AI Enterprise

NVIDIA AI企业套件是一款高效部署和管理企业级AI应用的软件堆栈,专注于帮助企业攻克AI部署难题,迅速实现AI价值转化,助力企业智能化升级。

NVIDIA AI企业版产品,专为数据中心设计,领先的技术赋能AI发展。点击[链接](https://www.nvidia.cn/data-center/products/ai-enterprise/),探索更多可能。

NVIDIA AI Enterprise 套件的主要功能包括:

- AI 基础设施: 提供统一的 AI 基础设施,支持各种 AI 框架和工作负载。

- AI 安全: 提供安全功能,保护敏感数据和模型。

- AI 管理: 提供易于使用的管理工具,简化 AI 应用的部署和管理。

- AI 优化: 提供性能优化功能,提高 AI 应用的性能。

NVIDIA AI Enterprise 套件适用于各种应用场景,包括:

- 智能制造: 提高生产效率,降低运营成本。

- 智能医疗: 辅助诊断,提高治疗效果。

- 智能金融: 识别欺诈,优化风险管理。

- 智能零售: 个性化推荐,提升客户体验。

NVIDIA AI Enterprise,强效工具助力企业轻松部署管理AI应用,迅速克服部署难题,高效获取AI价值,是您AI战略的得力助手。

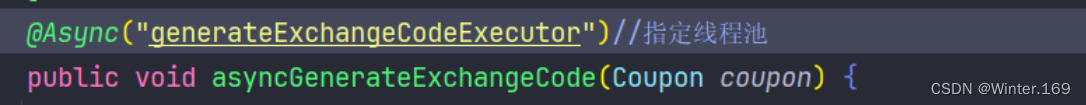

AI Workflow

NVIDIA AI工作流,云原生封装典范,展示NVIDIA AI框架构建解决方案的高效之道。集成预训练模型、训练推理流程、Jupyter Notebook教程与Helm图表,一站式加速AI解决方案的开发与部署,轻松驾驭AI创新之旅。

以下是 NVIDIA AI 工作流的主要优势和组成部分:

- NVIDIA AI工作流赋能多元场景,涵盖生成式AI聊天机器人、智能虚拟助理、音频转录,以及鱼叉式网络钓鱼与内部威胁检测等网络安全应用。此外,还助力路线优化、多摄像头追踪,并为零售店提供精准分析与损失预防方案。全面满足AI应用需求,引领智能化未来。

- NVIDIA LaunchPad诚邀开发者免费体验AI实验,亲身感受NVIDIA AI工作流的高效与便捷,助力您迅速启动并加速AI项目进程。

NVIDIA AI工作流全面整合资源与工具,助力开发者简化、加速AI解决方案开发,快速实现技术应用与创新,引领AI时代潮流。

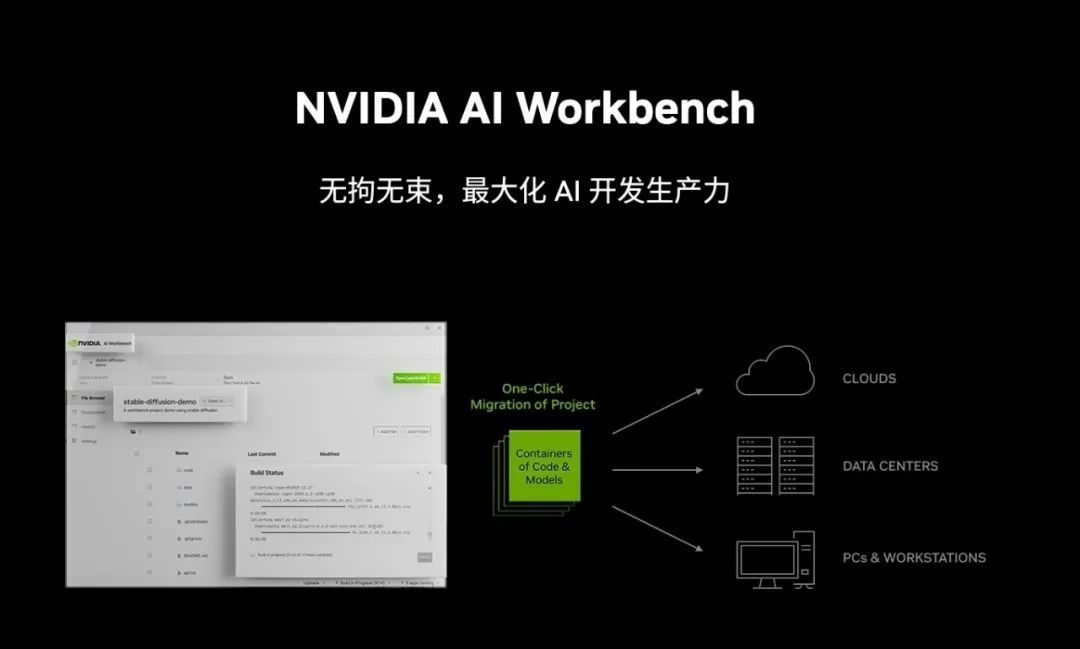

AI Workbench

NVIDIA AI Workbench,专为AI和数据科学精英打造,全面提升生产力,简化工作流程。一站式提供数据处理、模型训练、分析与部署工具,助力高效工作,引领AI新纪元。

以下是 NVIDIA AI Workbench 的主要特点:

- 高效数据处理,支持数据极速导入、清洗、转换与预处理,助您轻松准备机器学习及深度学习所需的高质量数据集。

- 模型训练与调优解决方案,集成多种AI框架如TensorFlow、PyTorch,支持高效训练与精准调优,助力模型性能卓越提升。

- 协作和共享:支持项目和模型的版本控制,便于团队协作和知识共享。

- 部署和管理:简化模型的部署流程,支持将训练好的模型部署到不同的平台和设备上。

- 性能监控:提供性能监控工具,帮助用户了解模型在不同硬件上的运行效率和资源消耗。

NVIDIA AI Workbench高效助力AI与数据科学工作者,提供从数据准备到模型部署的一站式解决方案,加速AI开发周期,打造便捷高效工作环境。

NVIDIA MLOps

NVIDIA MLOps,即机器学习运营解决方案,集高效工具与最佳实践于一体,专为加速AI与机器学习流程而设计。这套方案助力企业轻松驾驭AI运行,确保高效、稳定地实现智能化转型。

以下是 NVIDIA MLOps 的特色:

- NVIDIA DGX-Ready软件计划,搭载企业级MLOps解决方案,经严格测试与认证,完美适配DGX系统。该计划助力企业加速AI部署,优化工作流程,显著提升AI基础架构的部署效率、可访问性及利用率,为AI应用提供强大支撑。

- NVIDIA推理平台以卓越的可扩展性,在云、数据中心、网络边缘及自主机器上提供顶尖性能、效率与响应速度,助力新一代AI产品和服务全面升级。

- NVIDIA Triton 推理服务器,开源软件先锋,兼容GPU/CPU架构,支持TensorFlow、PyTorch等多框架部署AI模型。高效利用GPU/CPU资源,实现低延迟、高吞吐量。与Kubernetes无缝集成,轻松实现编排、监控与自动扩展。助您轻松构建、部署及优化AI应用,释放数据价值,加速业务创新。

- NVIDIA携手众多软件与服务巨头,推出逾百款MLOps软件与云服务,助力企业高效构建与扩展MLOps工作流,实现智能化升级。

- NVIDIA的MLOps解决方案,为企业级应用提供一站式支持:涵盖数据源管理、AI模型仓库、自动化ML流程,并依托Kubernetes实现软件容器化,助力从开发到部署的全流程高效执行。

- MLOps解决方案促进数据科学家与ML工程师高效协作,实现自动化流程,轻松解释与复现模型,助力项目高效执行。

NVIDIA MLOps解决方案旨在通过自动化和优化AI模型的开发与部署,实现AI的持续高效交付,加速数据科学与AI领域的革新与发展。

NVIDIA Triton

NVIDIA Triton AI推理服务器,高效开源,轻松部署管理深度学习模型于各平台,助力开发者高效推理。

它提供了以下主要功能:

高性能推理

- 兼容ONNX、TensorRT、TensorFlow SavedModel等多种模型格式,轻松集成各类深度学习模型。

- 支持动态批处理,可提高推理性能。

易于使用

- 提供易于使用的 API 和工具,方便开发者快速上手。

- 支持多种编程语言,包括 C++、Python 和 Java。

- 提供丰富的示例和文档。

可扩展性

- 支持分布式部署,可满足大规模推理需求。

- 支持自定义扩展,可满足不同场景需求。

- 与 Kubernetes 等容器编排平台兼容。

NVIDIA Triton AI推理服务器,强大易用且可扩展,助力开发者轻松部署、管理深度学习模型于各平台,适配广泛AI场景,助您高效应对AI应用挑战。

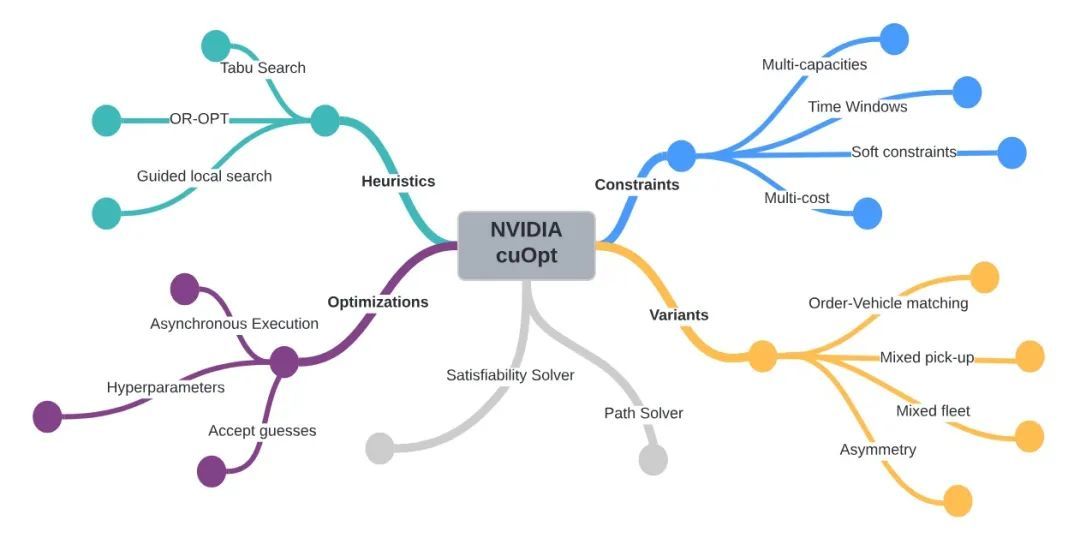

NVIDIA cuOpt

NVIDIA cuOpt,高性能加速优化引擎,专为解决复杂物流、路线问题而设。借GPU并行处理能力,实现快速、精确解决,尤其胜任多重约束路由挑战。

以下是 NVIDIA cuOpt 的主要特点和功能:

- cuOpt精准应对多重约束的复杂路由难题,支持动态重新路由、高效作业调度与逼真机器人模拟,助力团队高效解决挑战。

- cuOpt:高效Python接口,依托NVIDIA CUDA库与RAPIDS原语,为开发者提供便捷、强大的CUDA编程体验,助力高效数据处理与分析。

- 云平台支持:cuOpt 支持所有主要的公共云平台,便于在各种环境中部署和使用。

- 动态重路由高效应对突发状况,如驾驶员故障、车辆故障、交通/天气中断及新订单,实时重新运行模型,确保灵活调整。

- cuOpt在Gehring & Homberger基准测试中,以仅2.98%的误差差距,刷新了准确度世界纪录,彰显其卓越性能与精确度。

NVIDIA cuOpt凭借GPU加速的物流求解器,为物流和路线优化提供强大工具,轻松应对不同规模和复杂度的优化挑战,助力高效决策。

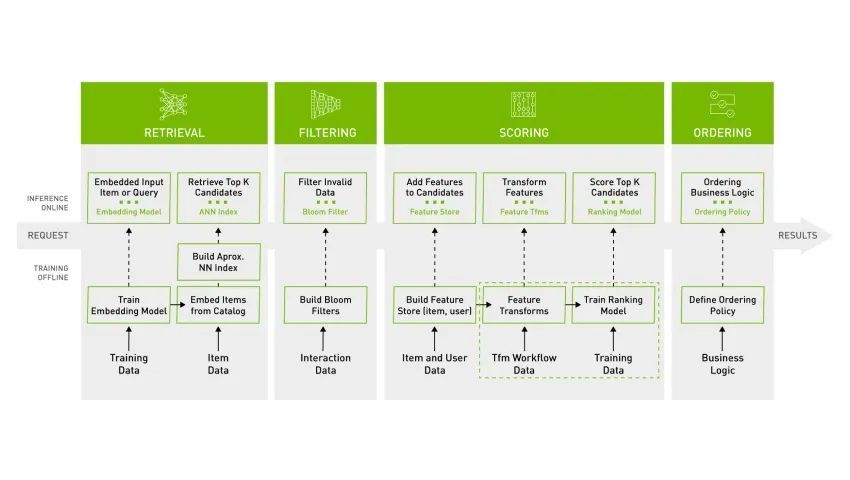

NVIDIA Merlin

NVIDIA Merlin,专为高性能推荐系统设计的开源框架,为数据科学家、机器学习工程师及研究人员提供一站式工具和库,简化数据处理至模型部署的全流程,打造卓越推荐器。

以下是 NVIDIA Merlin 框架的一些关键特性:

- Merlin提供端到端解决方案,涵盖数据摄入、预处理、特征工程、训练、推理至生产部署,助力构建并高效部署生产级推荐系统。

- Merlin组件与功能卓越,优化处理数百TB数据检索、过滤、评分与排序,拥有高效能及可扩展性,并提供用户友好的API。

- Merlin Models库,汇集众多标准推荐系统模型,并在CPU/GPU上提供从机器学习至深度学习模型的高效实现,助力您轻松打造卓越推荐系统。

- Merlin HugeCTR,专为GPU优化的深度神经网络框架,助力推荐系统。支持分布式模型并行训练和推理,确保卓越性能和可扩展性,引领行业新潮流。

- Merlin Systems提供高效库,简化新模型和工作流部署至生产,助力ML工程师和运营人员迅速部署端到端推荐系统。

- Merlin与NVIDIA AI平台深度集成,携手RAPIDS、cuDF及NVIDIA Triton推理服务器等软件库与工具,为数据科学和分析流程提供强劲加速,共同打造卓越的人工智能应用体验。

- Merlin 用户借助NVIDIA AI企业版,尊享NVIDIA专家技术支持、安全维护版本优先通知、长期支持和定制升级选项,企业级服务,助您无忧前行。

NVIDIA Merlin框架,助力开发者构建精准高效推荐系统,迅速部署至生产环境。以其卓越灵活性和性能,成为现代推荐系统的首选方案。

NVIDIA Maxine

NVIDIA Maxine,引领AI视频分析新纪元。作为NVIDIA精心打造的软件技术组合,它专注提升视频会议与远程协作质量,凭借实时音视频处理能力,为您带来无与伦比的通信体验。

探索NVIDIA MAXINE强大功能,解锁AI驱动的全新视界。立即访问:https://developer.nvidia.com/MAXINE

以下是 NVIDIA MAXINE 的主要特点和功能:

- MAXINE AI视频增强技术,运用先进算法降噪、锐化、色彩校正,显著提升视频质量,带来无与伦比的清晰视觉体验。

- MAXINE低带宽优化技术,智能编码减少数据传输,确保视频通话高质量,即便在低带宽条件下,依然保持清晰流畅的沟通体验。

- NVIDIA MAXINE凭借便捷的SDK和API,助力开发者轻松集成其强大功能,为应用程序增添卓越性能,实现高效开发与集成。

NVIDIA MAXINE运用尖端AI技术,优化视频通信质量,提升效率,在远程工作与在线协作风潮中,为用户打造卓越的虚拟会议体验。

NVIDIA Riva

NVIDIA Riva,一款GPU加速的多语种语音与翻译AI套件,助您轻松构建并部署实时、高度可定制的对话式AI应用。涵盖ASR、TTS、NMT等先进技术,支持多语言高精度语音输出。适用于云端、数据中心、边缘及嵌入式设备,打造表现力卓越的语音体验,引领AI对话新时代。

以下是 NVIDIA Riva 的主要功能特点:

- Riva提供全面定制服务:开发者可针对语言、口音、领域等定制ASR流程,同时个性化所需语音和语调以定制TTS流程,满足多样需求。

- Riva灵活部署,适用于数据中心、本地、云、边缘及嵌入式设备,高效处理数十万输入流,满足不同场景需求。

- Riva展现卓越实时性能,提供实时语音转录与合成,满足高速响应需求。技术栈持续优化,性能飙升12倍,彰显顶尖语音AI处理能力,为您的应用场景注入高效动力。

- Riva借助NVIDIA GPU技术,为语音AI模型提供卓越的计算能力,显著加速模型训练与推理,实现高效能语音处理。

- NVIDIA AI Enterprise集成:Riva,作为该平台的核心组件,高效简化生产级AI的开发与部署,为您带来前所未有的流畅体验。

- Riva预训练模型,开箱即用,经NVIDIA超级计算机数千小时音频训练,助力快速构建高效能音频处理应用。

- NVIDIA提供全面开发资源,涵盖教程、Jupyter Notebook及详尽文档,助力开发者高效构建并部署领先的语音与翻译AI工作流。

NVIDIA Riva旨在助力企业与开发者高效构建并部署高质量多语种语音AI应用,以强大、灵活和易用性推动实时对话式AI技术的广泛普及与应用。

NVIDIA Metropolis

NVIDIA Metropolis集应用框架、开发工具及合作伙伴生态于一身,结合视觉数据与AI技术,显著提升行业运营效率和安全性。该平台专注智能视频分析,运用数万亿传感器数据,为零售、库存管理、智能城市建设等提供深刻洞察,助您驾驭未来。

以下是 NVIDIA Metropolis 框架的主要特点和应用:

- Metropolis平台跨行业应用广泛,涵盖智能城市、零售物流、工业制造及医疗保健,借助AI与IoT技术,革新应用,推动行业升级。

- Metropolis智能城市引领未来,集成智能交通、访问控制、公共交通及智能建筑,高效维护并优化城市基础设施。

- Metropolis通过无摩擦结账、防盗技术、智能路线规划及库存管理,显著提升零售与物流行业的客户满意度与业务效率。

- Metropolis运用自动化光学检查、预防性维护、远程监控和安全合规技术,显著提升工业检查效率与制造生产力。

- Metropolis革新医疗保健,通过体温筛查、防护装备检测、患者监护及手术分析,优化病人护理,提升医疗设施运营效率。

- Metropolis 汇集强大开发工具,搭载NVIDIA DeepStream、迁移学习工具包及CUDA-X™加速库,助力开发者提升AI视频分析性能与可扩展性,引领智能时代新潮流。

- Metropolis预训练模型为大型数据集提供定制训练,降低从头建模需求,提升模型准确性,助您轻松应对复杂任务。

- TAO工具包:Metropolis的TAO工具包,高效加速深度学习训练,助力开发者迅速推向市场,实现快速迭代与创新。

- DeepStream SDK,AI赋能的实时视频分析利器,显著增强性能与吞吐量,打造高效视觉处理新体验。

- NVIDIA Jetson边缘AI平台凭借Metropolis的专属API与微服务,显著加速视觉AI应用的开发与部署,助力前沿科技快速落地。

NVIDIA Metropolis框架凭借尖端技术和广泛的合作网络,强力支持从边缘到云端的AI与IoT应用的创建、部署与扩展,引领智能未来。

NVIDIA vGPU

NVIDIA虚拟GPU(vGPU)软件专为数据中心虚拟化设计,实现多虚拟机共享物理GPU资源,提供卓越的GPU加速效能,助力高效计算。

探索NVIDIA数据中心虚拟解决方案,解锁卓越性能与灵活性。立即访问:[https://www.nvidia.cn/data-center/virtual-solutions/,](https://www.nvidia.cn/data-center/virtual-solutions/%EF%BC%8C)开启未来数据中心新篇章。

以下是 NVIDIA vGPU 方案的主要特点和优势:

- NVIDIA 推出多款vGPU软件版本,全面覆盖虚拟计算服务器(vCS)、虚拟工作站(vWS)、虚拟PC(vPC)及虚拟应用程序(vApp)等多元工作负载,满足不同需求,助力业务高效运行。

- NVIDIA AI Enterprise,专为虚拟化数据中心量身打造,提供全面的云原生AI与数据分析软件套件。它完美支持VMware vSphere与Tanzu虚拟化环境,为您带来高效、稳定的AI与数据分析体验。

- NVIDIA vGPU 行业解决方案助力建筑、工程、医疗、媒体、娱乐及公共事业,高效解决各类复杂难题。

NVIDIA vGPU解决方案运用虚拟化技术,灵活高效提升GPU加速能力,助力各规模企业和组织在云计算环境中实现高性能计算和AI工作负载的卓越表现。

RAPIDS

RAPIDS,一款开源GPU加速数据科学库,运用NVIDIA GPU的卓越计算能力,全面提速数据科学流程。该库配备与PyData库相匹配的API,让数据科学家和分析师在熟悉环境中畅享GPU并行处理优势,大幅提升数据处理、机器学习和图形分析的速度,轻松应对数据挑战。

以下是 RAPIDS 的主要信息:

- RAPIDS利用GPU显著加速数据加载、处理及机器学习,端到端数据科学流程提速高达50倍,助您飞速推进工作流程。

- RAPIDS实现无缝集成,通过GPU加速Apache Spark等平台,无需代码改动,迅速提升用户价值实现效率。

- RAPIDS,一个全开源生态系统,搭载于GitHub,依托NVIDIA CUDA与Apache Arrow尖端技术,通过用户友好接口,充分释放GPU潜能,加速数据处理与分析。

- RAPIDS 跨平台兼容性强,支持在Ubuntu、CentOS、Rocky Linux及最新Windows 11等操作系统上无缝安装与运行,确保您的数据科学工作流畅无阻。

- RAPIDS集多种高效库和工具于一体,涵盖cuDF加速Pandas,cuML支持机器学习建模,cuGraph助力图形分析。更与Dask、MLFlow、Kubernetes无缝集成,为数据处理与分析提供一站式解决方案。

- RAPIDS通过NVIDIA AI Enterprise提供企业级支持,涵盖卓越性能、认证硬件配置及直接IT支持,确保企业AI部署的高效稳定。

- RAPIDS显著提升数据处理和机器学习性能,尤其在大型数据集上,保持与CPU同等精度,性能飞跃式提升。

- 采用RAPIDS,企业能显著减少硬件需求,进而降低本地数据中心与云环境中的基础设施成本,实现高效成本削减。

- RAPIDS提供简便安装方案,涵盖Conda、pip、Docker及Windows WSL2安装指南,确保用户轻松上手,尽享高效数据处理体验。

NVIDIA RAPIDS方案,数据科学家与分析师的高效之选。借助GPU加速,大幅提升数据科学任务性能,同时保持开源与企业级易用性,是您数据处理的得力助手。

生成式AI

NVIDIA NeMo

NVIDIA NeMo,云原生框架,专为构建、训练和部署大型语言模型(LLM)而生。提供全面工具与功能,支持灵活生成式AI模型开发。涵盖训练、推理框架、护栏工具包、数据管理及预训练模型,为企业提供快速、经济、便捷的生成式AI解决方案。选择NeMo,轻松开启智能新时代。

以下是 NVIDIA NeMo 框架的主要特点:

- NeMo企业级应用,高效训练、定制LLM并规模化部署,加速上市时间,提升投资回报率,助力企业快速发展。

- 先进的训练方法:提供了分布式训练工具,提升了训练的规模、速度和效率。

- NVIDIA Triton优化,实现与推理服务器的无缝集成,高效部署AI模型,加速推理过程,提升性能。

- 借助NeMo与NVIDIA AI Foundation模型,打造专业预训练的自定义企业模型。这些模型汇聚了社区与NVIDIA的智慧,历经精心构建与优化,助力企业实现卓越性能。

- 检索增强型生成技术:构建强大的生成式 AI 应用,从企业数据来源获取信息和见解。

NVIDIA NeMo框架助力企业开发者高效构建、定制、部署生成式AI模型,加速AI技术创新与应用落地。

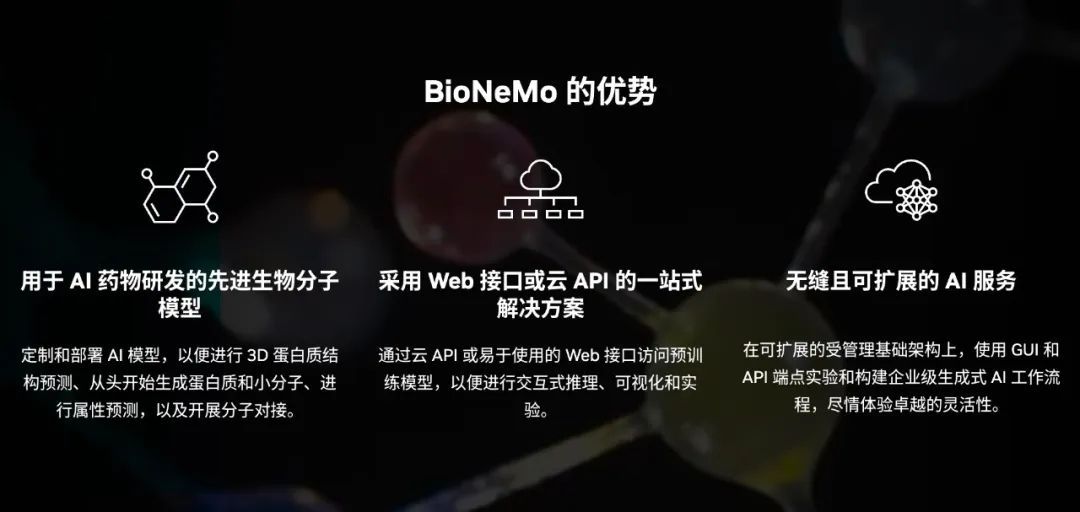

NVIDIA BioNeMo

NVIDIA BioNeMo,专为药物研发量身打造的生成式AI平台,简化用户数据模型训练,加速研发应用部署。平台提供高效工具与服务,赋能AI驱动的药物研发,实现研发流程的极速推进。

探索NVIDIA Clara Bionemo,引领医疗AI新纪元,链接未来健康科技!立即访问了解更多。

以下是 NVIDIA BioNeMo 框架的主要特点:

- BioNeMo,领先的生物分子模型,提供AI定制与部署,卓越执行3D蛋白质结构预测、蛋白质与小分子生成、属性预测及分子对接等前沿任务,助力科研新突破。

- 一站式解决方案,支持云API与Web接口,轻松访问预训练模型,实现交互式推理、可视化和实验,高效便捷。

- 高效无缝的AI服务,构建于可扩展的受管理基础架构之上。通过GUI和API端点,轻松实验并打造企业级生成式AI工作流程,引领未来创新。

- BioNeMo训练服务,一站式优化解决方案,涵盖顶尖模型、高效数据加载、专业训练流程、循环验证及企业支持,为您的训练需求保驾护航。

- BioNeMo云API赋能用户定制、部署生成式AI,专注药物研发,摆脱计算设施管理与复杂软件维护的束缚。

- AI超级计算机在NVIDIA DGX Cloud上高效训练与优化模型,依托NVIDIA Base Command Platform的强大支持,打造一站式AI工作流程管理SaaS,全面助力AI创新与发展。

NVIDIA BioNeMo框架专为药物研发领域科学家打造,利用AI技术加速药物发现与开发,为科学家提供强大工具,助力创新突破。

NVIDIA Picasso

NVIDIA Picasso,专为视觉内容创作而生的生成式AI服务平台,凭借前沿模型架构,赋能企业开发者、软件创作者和服务商高效构建、定制及部署基础模型。专注于图像、视频、3D内容、360 HDRi及PBR材料的生成与修改,简化NVIDIA Omniverse Cloud上的基础模型训练、优化及推理流程,助力创意无限释放。

深入探索NVIDIA Picasso GPU云服务,解锁无限计算潜能,助力高效数据处理与AI创新,尽在[链接]!

以下是 NVIDIA Picasso 平台的主要特点:

- 工作流程:提供构建基础模型、自定义预训练基础模型和加速任何基础模型的工作流程。

- Picasso模型架构囊括多种尖端生成式AI基础模型,涵盖图像、视频及3D内容的生成与修改,功能全面而先进。

- Picasso与NVIDIA Omniverse Cloud完美融合,凭借卓越推理优化功能,为用户带来前所未有的交互式体验,引领行业新潮流。

- Picasso携手行业巨头Getty Images、Adobe及Shutterstock,成功合作开发并部署前沿生成式AI模型,共创智能未来。

- 资源与支持齐备:涵盖文档、教程、社区支持与客户案例研究,助力用户高效运用Picasso框架,实现卓越性能。

NVIDIA Picasso框架旨在以AI技术为视觉内容创作领域提供强大助力,加速创意流程,打造别具一格的视觉盛宴。

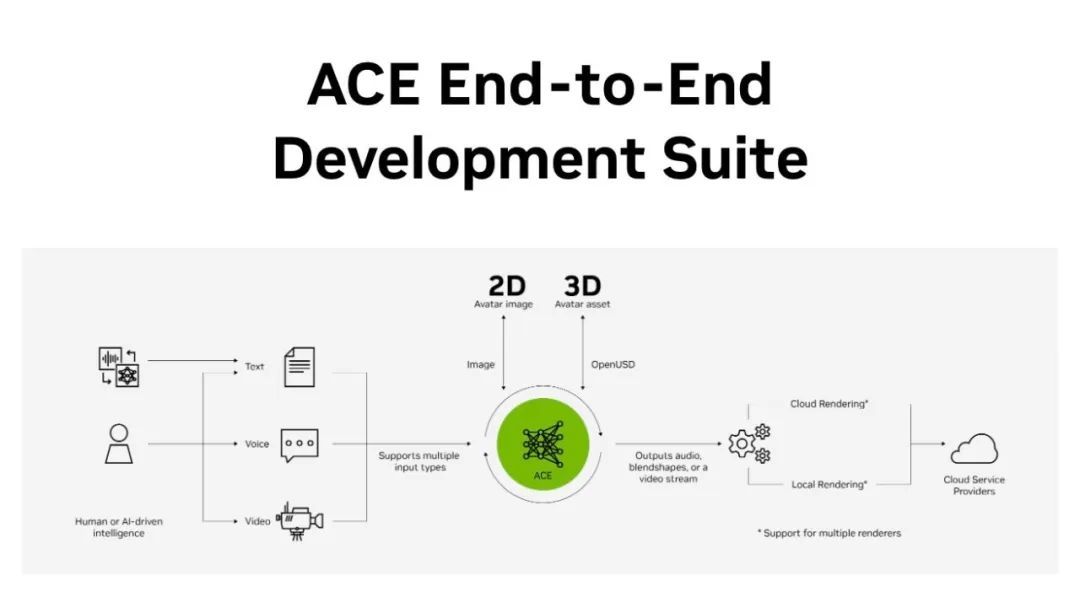

NVIDIA ACE

NVIDIA ACE云端服务震撼上线,助力开发者打造栩栩如生的人工智能虚拟形象,引领未来虚拟形象新潮流,NVIDIA创新技术再显实力!

ACE云端微服务,运用先进生成式AI技术,助力开发者轻松打造聊天机器人、多模态助手及互动式虚拟形象,实现应用的快速构建、部署与管理。

ACE 的主要功能包括:

- 逼真的形象创建: 利用 AI 模型生成逼真的人脸、表情、动作和声音。

- 强大的对话管理: 支持可组合的对话管理,使虚拟形象能够自然流畅地进行对话。

- 集成功能卓越:无缝融合NVIDIA Riva语音AI、NLP服务、域实现及用户界面,打造全方位集成体验。

- 灵活的部署选项: 支持云端或本地部署。

ACE 可广泛应用于以下场景:

- 客服: 利用虚拟形象提供 7x24 小时全天候客服服务。

- 教育: 创建虚拟教师或助教,提供个性化的学习体验。

- 娱乐: 创建虚拟主持人或游戏角色,提升用户体验。

- 虚拟社交: 打造逼真的虚拟社交平台,让人们进行虚拟互动。

NVIDIA ACE是构建逼真AI虚拟形象的利器,助力开发者高效创建、部署和管理虚拟形象应用,革新各行业的数字化体验,开启全新视觉时代。

NVIDIA Tokkio

NVIDIA Tokkio凭借NVIDIA ACE,助力开发者高效构建、个性化定制和灵活部署高度逼真的虚拟助手和数字人物。

NVIDIA Omniverse ACE Tokkio 展示页面,体验尖端科技融合,探索未来视觉盛宴。立即访问https://developer.nvidia.cn/omniverse/ace/tokkio-showcase,开启无限创意之旅!

以下是 Tokkio 的主要特点:

- Violet,一款由NVIDIA Tokkio打造的AI客服助理,拥有观看、感知、智能对话与建议能力,为提升客户服务体验注入全新活力。

- 云托管:Tokkio 虚拟形象托管在云端,使得交互式体验可以无处不在,随时可用。

- Tokkio集成NVIDIA尖端AI技术,融合Omniverse Audio2Face实现逼真面部动画,搭载NeMo Megatron-Turing 530B语言模型与NVIDIA Riva语音AI,深度理解并生成富有意义的对话,展现AI技术的无限可能。

- Tokkio运用3D虚拟形象,打造实时客户服务新体验,用户可轻松通过自然对话与虚拟助手互动,享受即时响应。

- Tokkio呈现多样化应用场景,涵盖QSR客户服务、自然专业问答助手及DRIVE Concierge个性化服务,全方位满足您的需求。

NVIDIA Tokkio融合尖端AI与图形技术,致力于打造更富互动性的虚拟形象体验,为客户提供自然、个性化的服务,革新客户服务及多领域交互模式。

平台化方案

DGX

NVIDIA DGX是企业全面AI解决方案的先锋系统,融合顶尖硬件、软件与专业知识,提供云端至本地数据中心的统一开发环境。无论云上或本地,DGX均助您轻松实现AI的开发与训练,释放无限创新潜能。

探索NVIDIA DGX平台,专为数据中心设计,性能卓越,引领行业前沿。立即访问[链接],了解更多详情。

以下是 NVIDIA DGX 平台的主要特点:

- DGX平台,集NVIDIA软硬件技术之大成,打造无缝AI开发环境,云端本地灵活部署,加速智能应用创新。

- NVIDIA AI专业技术与服务助力平台用户,配备AI专家支持,精准优化AI工作负载,加速成果落地,为您的AI项目提供强大动力。

- DGX平台以AI技术赋能各行各业,从能源创新到工厂物流优化,全面提升企业效率和生产力,展现多元化应用案例。

- NVIDIA DGX云提供灵活部署选项,用户可迅速启用DGX平台,并支持本地及混合云部署,轻松满足多样化需求。

- DGX平台搭载NVIDIA AI Enterprise软件套件,集先进数据科学工具、预训练模型、优化框架于一体,辅以企业级支持,铸就强大AI软件解决方案。

- 硬件产品系列:推出DGX A100、DGX H100、DGX GH200等AI超级计算机,专为不同规模的AI工作负载量身打造,性能卓越,助力AI发展。

- NVIDIA提供全方位企业服务,涵盖支持、培训与专业服务,助您最大化DGX平台价值,赋能企业创新与发展。

NVIDIA DGX平台致力于为企业构建强大、灵活且易管理的AI基础设施,驱动AI技术创新与应用,助力企业在AI领域实现创新与变革。

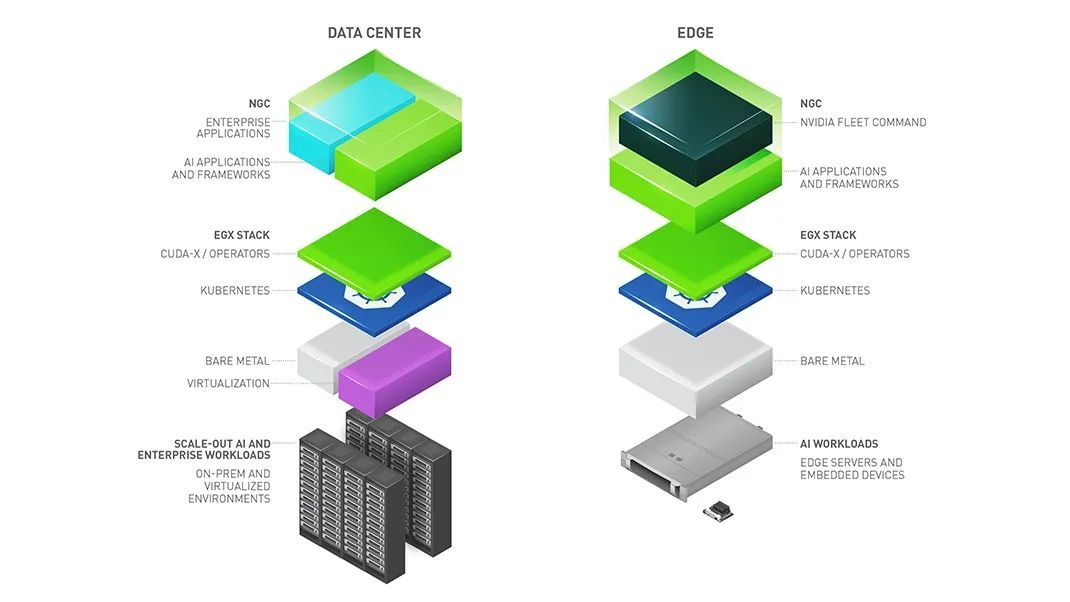

EGX

NVIDIA EGX平台,云原生高性能边缘计算方案,专为AI计算打造。软件堆栈易于部署,管理服务完善,搭配优化硬件,实现AI计算能力从数据中心至网络边缘的无缝扩展,引领AI计算新纪元。

探索NVIDIA数据中心EGX系列,高效能计算与AI融合,驱动行业创新,详情尽在[链接],立即体验未来科技魅力!

以下是 NVIDIA EGX 平台的关键特点:

- EGX平台:企业级AI软件翘楚,专为数据中心至边缘的AI运算设计。借助NVIDIA AI Enterprise,企业可在VMware vSphere上无缝运行经NVIDIA优化、认证的软件套件,加速AI与数据分析,引领行业前沿。

- EGX堆栈集成了NVIDIA GPU与网络操作器,完美兼容Red Hat OpenShift及混合云平台。它极大简化了Kubernetes集群的部署与自动化管理,助力企业高效构建与运维云原生应用。

- NVIDIA Fleet Command简化边缘端AI应用部署与管理,无线更新系统、软件,实时监控位置运作,高效管理无忧。

- EGX平台革新企业应用加速,集成AI与传统应用,全面支持AI、数据分析、高性能计算及可视化等多领域加速,助力企业实现技术飞跃。

- EGX AI平台引领边缘计算,为顶尖AI应用与框架奠定统一基石,实时处理数据,洞察先机,助力决策加速。

- NVIDIA携手服务器制造商、混合云平台及Jetson Micro边缘服务器伙伴,构建强大的合作伙伴生态系统,共同推出卓越的EGX产品和服务。

- 数据中心与边缘AI融合,EGX平台以NVIDIA认证系统为基础,搭载高性能GPU与NVIDIA Mellanox高速网络,为企业提供卓越性能的服务器,简化管理,大幅削减成本。

- 借助NVIDIA高端GPU、vGPU软件及Omniverse协作平台,实现高效可视化应用访问,支持专业级远程协作,提升工作效率。

- EGX平台搭载Omniverse,实现跨地区系统团队的实时远程协作,经济高效、可扩展,推动团队协作新纪元。

NVIDIA EGX平台,专为企业打造,提供强大、灵活、安全的边缘计算方案,全面助力AI与数据密集型应用的创新与发展。

HGX

NVIDIA HGX AI超级计算平台,专为AI与高性能计算(HPC)量身打造,是集成的端到端加速解决方案。它汇聚了NVIDIA的GPU技术、NVLink互联、网络技术及优化的AI与HPC软件堆栈,旨在提供无与伦比的应用性能,加速洞察获取,助力您轻松应对复杂计算挑战。

以下是 NVIDIA HGX AI 超级计算平台的主要特点:

- HGX平台,专为AI与HPC设计,融合多高速GPU与全加速软件堆栈,助力复杂AI模型训练与大规模模拟,释放无限算力潜能。

- NVIDIA HGX H200搭载H200 Tensor Core GPU与高速互连技术,支持8个GPU,提供1.1TB GPU内存、38TB/s聚合内存带宽及32 petaFLOP性能,实现端到端加速,为您带来前所未有的计算体验。

- 卓越网络体验:HGX H200与HGX H100搭载前沿网络选项,支持高达400 Gb/s的传输速度。采用NVIDIA Quantum-2 InfiniBand与Spectrum-X以太网技术,为您的AI应用提供无与伦比的性能保障。

- DPU技术融合NVIDIA BlueField-3 DPU,赋能云网络、灵活存储、零信任安全及GPU计算弹性,打造全面高效的数据处理解决方案。

- HGX H200和H100搭载Transformer引擎(FP8精度),显著提升大语言模型训练速度,并在Megatron聊天机器人模型中,实现惊人的30倍推理性能跃升,让深度学习及推理性能迈上新台阶。

- HGX平台凭借卓越的高内存带宽,为内存密集型高性能计算(HPC)应用带来显著加速,极大缩短结果获取时间。

- NVIDIA HGX与Quantum InfiniBand网络融合,释放无与伦比的性能与效率,让计算资源得到充分释放,为您的业务提供强劲动力。

- HGX平台搭载单一基板,集成4至8个H200/H100或A100 GPU,为AI超级计算提供卓越性能支持。其强大硬件与软件结合,为各类AI应用提供坚实后盾,展现无与伦比的计算能力。

NVIDIA HGX AI超级计算机平台,专为处理海量数据集与复杂计算任务设计,提供卓越性能与效率,是企业与科研机构的高效计算首选。

IGX

NVIDIA IGX平台,专为工业和医疗环境打造的边缘AI先锋,融合高性能、高安全性和可靠性,助力企业安全、可靠地部署AI技术,引领人机协作新纪元。

以下是 NVIDIA IGX 平台的关键特性:

- 高性能系统:IGX 平台为低延迟的实时应用提供高效的高性能系统。

- 功能安全性:内置安全扩展程序,确保在自主环境中提供主动安全性。

- 端到端安全:提供从嵌入式设备安全到远程调配和管理的端到端可靠安全性。

- 长期支持:硬件和软件的长期支持确保产品的长期使用寿命。

- NVIDIA IGX Orin专为工业级系统而生,集极致速度与小巧于一身,以275TOPS每秒的AI性能,在边缘计算领域展现超凡实力。

NVIDIA IGX平台专为工业和医疗领域打造,提供强大、安全、可靠的边缘计算方案,助力AI技术创新与应用,引领行业变革。

OVX

NVIDIA OVX系统,高性能计算平台的翘楚,专为加速数据中心AI工作负载而生。融合RTX尖端技术,赋能AI与图形性能卓越,轻松应对大型语言模型(LLM)等严苛工作负载,实现训练、推理、渲染及3D图形处理的高效加速,展现NVIDIA技术的非凡实力。

OVX系统的核心特点包括:

- 高性能计算:系统提供卓越的图形和计算性能,以满足AI和图形密集型应用的需求。

- OVX系统卓越的多GPU支持能力,轻松驾驭多达八个NVIDIA Ada Lovelace L40S GPU,融合ConnectX高性能网络与Bluefield DPU技术,释放强大计算力,满足高端计算需求。

- NVIDIA Omniverse Cloud:OVX系统赋能Omniverse Cloud,打造可扩展的端到端云平台,加速3D工作流程,创新元宇宙应用的创建、仿真与运行,引领未来数字世界的新潮流。

NVIDIA OVX系统,由NVIDIA认证伙伴精心打造,满足企业大规模加速性能需求。该系统不仅助力企业实现卓越性能,更推动AI及元宇宙创新前行,为新时代的发展注入强大动力。

Omniverse

NVIDIA Omniverse,是NVIDIA倾力打造的虚拟世界与实时物理级模拟协作平台。依托Universal Scene Description (USD)技术,该平台为3D设计、工程与娱乐行业专家提供无缝连接、高度互动的虚拟体验,引领行业进入全新协作纪元。

以下是 NVIDIA Omniverse 产品体系的构成:

Omniverse 平台:

- 一个计算平台,允许个人和团队开发基于 USD 的三维工作流和应用程序。

- 支持在 3D 中快速创建,通过 AI 增强开发,几乎不需要编码。

- 打破 3D 数据孤岛,实现大型企业团队的统筹和协作。

USD 3D 框架:

- 一个开放、可扩展的生态系统,用于描述、合成、仿真和协作 3D 世界。

- 提供 API 用于合成、编辑、查询、渲染、协作和仿真。

- 支持非破坏性工作流和协作,以及与文件系统无关的资产解析器。

Omniverse Cloud:

- 提供单一来源解决方案,易于扩展,支持企业和团队构建基于 USD 的工具和应用。

- 包括 NVIDIA 专家和企业支持,确保系统高效运行。

Omniverse 应用程序和服务:

- Omniverse Configurator助力用户云端发布高级交互式产品配置器,实现高效便捷的产品定制体验。

- Omniverse Simple Share简化3D场景分享,支持在线链接一键打包分享,用户与团队轻松协作。

- Omniverse Nucleus Cloud简化云端Nucleus实例设置,实现USD场景实时共享协作编辑,助力团队高效协作,共创卓越。

- Omniverse App Streaming 革新体验,让设计师、创作者和工程师随时随地在任何设备上流畅使用Omniverse应用,无缝衔接创意与工程。

Omniverse 企业版:

- 为企业提供的端到端云服务,支持复杂的设计工作流和实时协作。

- 通过集中式项目数据实现多用户和多地点的实时协作。

NVIDIA Omniverse平台引领元宇宙应用开发,覆盖概念设计、产品配置、数字孪生、合成数据生成、机器人测试模拟、自动驾驶训练验证等多领域。其强大工具与服务正革新3D创作与工程行业,构筑未来虚拟世界与数字化工作流程的基石,开启无限可能。

Jetson

NVIDIA Jetson嵌入式系统,专为边缘计算和自主机器量身打造。融合尖端AI能力与卓越能效管理,赋能开发者高效处理机器人、智能城市、医疗成像、工业自动化等复杂计算任务,开启无限创新可能。

以下是 NVIDIA Jetson 嵌入式系统系列的主要产品系列:

- Jetson Nano,入门级AI开发利器,兼具基础AI功能与出色性价比,助力初学者及小型项目轻松起航。

- NVIDIA Jetson Xavier NX系列,以其卓越的AI性能引领高端市场,专为应对复杂边缘计算挑战而设计,展现无与伦比的智能实力。

- Jetson AGX Xavier系列,专为工业级应用打造,凭借卓越可靠性与强劲算力,满足高性能需求。

- Jetson Orin系列,引领AI新纪元,展现无与伦比的性能,赋能下一代自主机器与边缘计算,开创无限可能。

Jetson 系统的特点包括:

- AI性能卓越,覆盖数百GFLOPS至数百TOPS级别,灵活适应各类应用需求,性能强劲,满足多样化挑战。

- GPU架构涵盖Maxwell、Pascal、Volta及Ampere,以卓越并行计算能力,满足高效计算需求。

- CPU配置卓越,涵盖四核ARM Cortex-A57至多核NVIDIA Carmel Arm v8.2 64位处理器,确保高效、强大的

- 显存与存储全面升级:尊享4GB LPDDR4至64GB LPDDR5的显存选择,更有16GB eMMC至支持外部NVMe的顶尖存储方案,满足您各类高性能需求。

- 视频处理能力:支持多路高清视频编解码,适用于需要视频分析的应用。

- 摄像头接口:支持多达数十个摄像头的接入,适用于视觉密集型应用。

- 功耗:从几瓦到几十瓦不等,根据产品系列和应用需求提供能效优化。

- 规格尺寸:提供多种尺寸的模组和开发套件,以适应不同的集成需求。

Jetson嵌入式系统以卓越AI计算力和高效能源管理,助力开发者在边缘设备上实现先进机器学习与深度学习应用,引领智能设备及自主机器革新。

Jetson Generative AI Lab

NVIDIA Jetson平台携手生成式AI技术,赋予开发者和创新者强大力量,轻松在边缘设备上创建并部署前沿的生成式AI应用。

以下是关于如何使用 Jetson 平台带来生成式 AI 能力的一些要点:

- Jetson平台专为实时、高吞吐、低延迟AI应用打造,尤其擅长生成式AI,如图像视频生成、自然语言处理,满足您的高效智能需求。

- 生成式AI引领创新,直接在边缘设备创建图像、音乐、文本,无需依赖云计算。Jetson平台凭借卓越算力,实现实时内容生成,开启智能应用新纪元。

- Jetson平台赋能边缘计算,运行生成式AI应用时显著降低网络依赖和延迟,提升数据处理速度,确保数据隐私安全,实现高效智能处理。

- Jetson平台集成了NVIDIA DeepStream、TensorRT等高效开发工具与库,助力开发者优化并加速AI模型训练与部署,实现高效能、智能化的解决方案。

- Jetson平台搭载高性能GPU,显著加速AI模型推理,确保生成式AI应用实时响应,为用户提供即时、精准的反馈与结果,满足快速决策需求。

NVIDIA Jetson Generative AI Lab,展示Jetson平台上的生成式AI项目。实验室聚焦Jetson平板的高性能计算,驱动先进AI应用的发展,尤其在生成式AI领域,展现无限创新可能。

Jetson Generative AI Lab 提供详尽教程,指导用户利用Jetson平台开发生成式AI。内容覆盖开发环境设置、模型选择与训练,直至AI应用的部署与优化,全程指导,助您轻松掌握生成式AI开发之道。

AI 应用方案

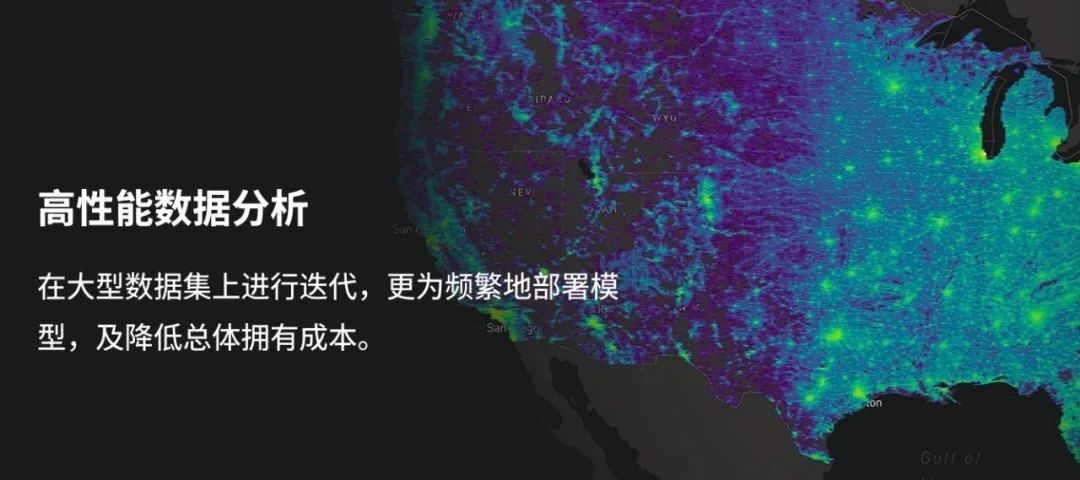

数据分析

NVIDIA数据分析解决方案利用GPU加速技术,显著提升性能,降低成本,加速价值创造,助力优化数据分析工作流。

深入探索NVIDIA深度学习AI解决方案,专注于数据分析领域,释放数据潜能。立即访问[链接],开启智能数据分析新纪元,引领行业变革。

以下是 NVIDIA 数据分析解决方案的关键要点:

- 高性能数据分析:NVIDIA GPU解决方案在处理大规模数据时,性能超越CPU达20倍,兼具卓越性能与成本效益优势。

- 加速分析,助力数据科学家、工程师及IT/DevOps专家极速处理数据,缩短等待时间,提升结果精度,且无需重构现有工具链,实现高效数据处理新体验。

- 利用RAPIDS、Spark 3.0、Dask、cuML、Plotly Dash及FIL等尖端工具库,我们大幅提升了数据加载、处理、训练及推理的速度,确保数据处理高效且精准。

NVIDIA数据分析解决方案凭借GPU加速技术,助力企业高效利用数据,加速洞察,助您在竞争中保持领先地位。

机器学习

NVIDIA机器学习解决方案,运用GPU加速技术,助力企业提升数据分析能力,优化客户服务、产品开发及运营效率,实现业务飞跃。

以下是 NVIDIA 机器学习解决方案的关键要点:

- NVIDIA解决方案生态系统强大,全面支持Apache Spark、cuPY、Dask、XGBoost、Numba等数据科学框架,以及PyTorch、TensorFlow等深度学习框架的无缝集成,为数据科学与AI应用提供坚实支撑。

- RAPIDS助力云端机器学习加速,兼容Amazon Web Services、Google Cloud及Microsoft Azure,让企业轻松在云平台上实现高效机器学习,提升业务效率。

- RAPIDS 超参数优化(HPO)和森林推理库(FIL)等创新工具,显著加速机器学习关键操作,提升效率,推动技术前沿。

NVIDIA机器学习解决方案以高性能GPU加速数据价值挖掘,加速洞察生成,助力企业实现业务增长与创新,推动行业前行。

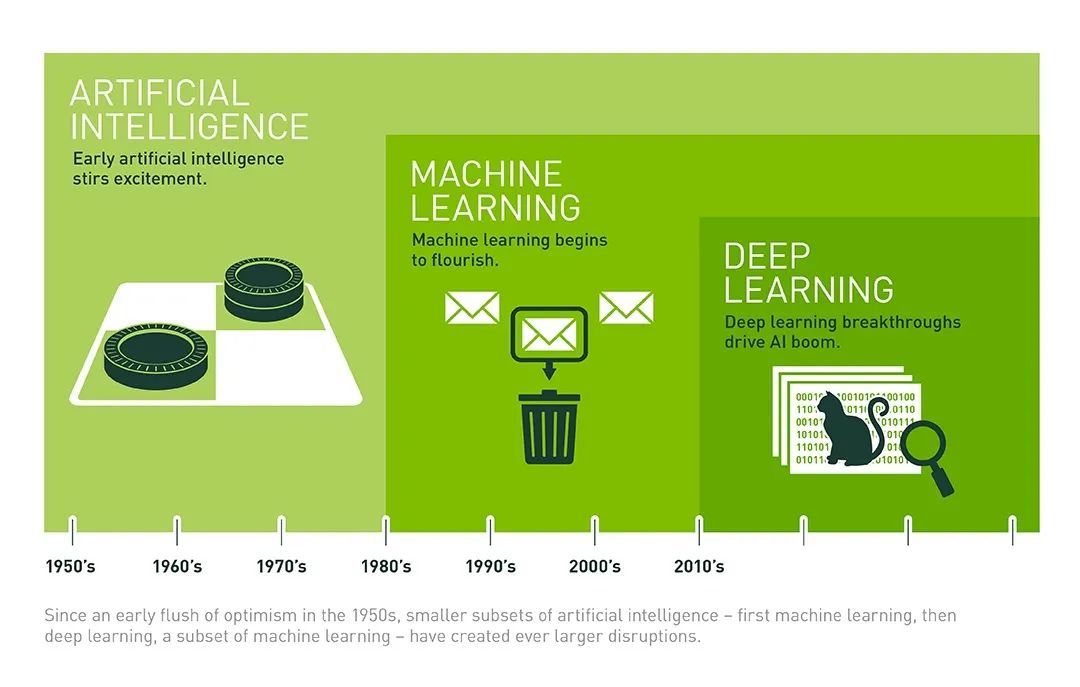

深度学习训练

NVIDIA深度学习训练解决方案,以GPU加速技术为核心,大幅提升模型训练速度,缩短训练时间,降低成本,实现高效投资回报(ROI)。

以下是 NVIDIA 深度学习训练解决方案的关键特点:

- NVIDIA Volta架构与Tesla V100 GPU强势助力,以卓越的计算能力,满足从桌面到数据中心深度学习训练的全方位需求,助力智能升级。

- NGC GPU Cloud助力用户无缝接入NVIDIA GPU优化的深度学习训练软件,轻松提升深度学习训练效率,一站式解决方案尽在掌握。

NVIDIA深度学习训练方案,以卓越硬件与便捷软件工具赋能研究者和开发者,加速复杂模型训练,引领AI技术革新与应用,推动行业发展。

AI 推理

NVIDIA AI推理解决方案为深度学习模型部署提供高效平台,支持所有主流AI框架,保障广泛适用性和灵活性,轻松应对生产环境挑战。

探索NVIDIA深度学习AI解决方案,我们为您提供卓越的推理平台。立即访问[链接],解锁无限可能,加速您的AI推理之旅,助力业务创新与发展。

以下是 NVIDIA AI 推理解决方案的关键特点:

- 全面兼容TensorFlow、PyTorch、ONNX等主流AI框架,无缝集成,助力开发者轻松将训练模型部署至生产环境,实现高效应用。

- NVIDIA Triton推理引擎,高效部署AI模型,性能卓越,兼容广泛。作为推理服务器,它支持多种模型和数据格式,助力智能应用高效运行。

- NVIDIA TensorRT,高性能深度学习推理优化器,显著提升模型推理速度和效率,助力深度学习应用更高效运行。

- NVIDIA Triton管理服务简化Kubernetes环境中Triton推理服务器的部署,轻松实现模型部署与扩展,为您带来高效便捷的管理体验。

- NVIDIA AI Enterprise:企业级软件套件,全面支持AI工作负载,涵盖推理与训练,实现端到端高效能处理。

- NVIDIA L4、L40、H100、GH200等GPU强势助力,高效加速AI推理任务,满足大规模计算需求,为您的AI应用注入强大动力。

NVIDIA AI推理解决方案,铸就企业AI部署新高度。该平台强大易用,快速高效部署模型,即时洞察数据价值。加速创新,提升运营效率,优化客户体验,引领企业迈向智能新纪元。

预测与预报

NVIDIA预测解决方案融合加速数据科技,精准建模未来趋势,深度解析大规模数据,为企业带来精准洞察,助力数据驱动决策。

以下是该解决方案的关键要点:

- NVIDIA解决方案高效应对预测分析挑战,解决耗时数据处理、高昂成本及繁琐部署,助力企业轻松应对挑战,实现卓越性能。

- NVIDIA方案简化GPU加速,数据科学家无需重构,仅少量代码改动即可利用熟悉工具实现高效计算,学习成本大幅降低。

- NVIDIA AI Enterprise提供企业级全面支持,保障快速响应、安全更新,并享与AI专家直接交流机会,助力企业高效利用AI技术。

- NVIDIA解决方案与Apache Spark、cuPY、Dask、XGBoost、Numba等数据科学框架,以及PyTorch、TensorFlow等深度学习框架无缝集成,显著提升采用率,彰显卓越的互操作性和集成能力。

NVIDIA预测与预报解决方案助力企业加速数据分析,精准预测,提升决策质量,优化运营,确保市场领先地位,应对激烈竞争。

对话式 AI

NVIDIA对话式AI解决方案助力开发者高效构建高精度、低延迟的会话AI应用,如虚拟助手、数字人类及聊天机器人,提供个性化、自然交互体验,革新人机对话模式,开启智能交流新纪元。

深入探索NVIDIA的会话式AI解决方案,开启智能对话新时代。我们的技术助力企业实现更自然、更高效的人机交互,引领AI行业前沿。立即访问:[链接],开启未来智能对话之旅。

以下是 NVIDIA 对话式 AI 解决方案的主要特点:

- NVIDIA Riva GPU加速语音和翻译AI SDK支持实时多语言模型,轻松应对各种语言、口音和方言,助力高效开发部署。

- 借助AI工作流、企业支持、框架与预训练模型,以及Helm chart、Jupyter Notebooks等丰富资源,我们高效加速会话AI应用的开发与部署,实现业务价值的快速转化。

NVIDIA的对话式AI解决方案致力于为企业提供一体化平台,借助AI技术优化客户服务、提升用户体验,并推动创新会话式AI应用的发展。

语音 AI

NVIDIA语音AI解决方案,集成先进技术与工具,涵盖语音识别、合成及翻译。借助GPU加速,实现实时高效语音处理,支持多语言及方言,满足您的全面需求。

以下是 NVIDIA 语音 AI 解决方案的主要特点:

- NVIDIA Riva预训练模型高度可定制,实时支持多语言语音识别与合成,轻松应对各种语言和方言需求。

- 语音AI解决方案在NVIDIA GPU上运行,实现高性能,提供极速响应与高吞吐量,完美适配实时交互应用,满足您的即时需求。

- NVIDIA Riva轻松部署于云端、数据中心、嵌入式及边缘设备,灵活满足各类性能与延迟需求,部署无忧,性能卓越。

- NVIDIA倾力提供丰富开发资源,涵盖预训练模型、AI工作流、Helm chart、Jupyter Notebook及详尽文档,助力开发者高效构建与定制语音AI应用,实现创新突破。

- NVIDIA Riva企业版提供全方位企业支持,涵盖安全更新、性能调优及专业技术服务,助力企业无忧运行。

NVIDIA语音AI解决方案,旨在为开发者和企业打造高效、灵活、易用的工具集,助力高质量语音AI应用快速部署,推动语音技术行业应用的革新与发展。

大语言模型和GenAI

NVIDIA推出生成式AI解决方案,是创新与实现的桥梁,助力解决全球挑战。该平台整合了NVIDIA强大的加速计算能力和AI软件栈,为开发者和企业量身打造、快速部署生成式AI模型,将创意轻松转化为现实。

以下是 NVIDIA 生成式 AI 解决方案的关键组成部分:

- NVIDIA AI代工厂:集成生成式模型架构、加速计算及丰富工具,一键简化AI训练、定制、优化及部署流程。

- NVIDIA NeMo:领先的大语言基础模型,搭配定制工具与大规模部署功能,助力企业AI应用高度个性化实现。

- NVIDIA Picasso赋能企业、软件创作者与服务提供商,以专有数据训练高级生成模型,快速生成图像、视频、3D及360° HDRi内容,助力创意无限。

- NVIDIA ACE:赋能中间件、工具与游戏开发者,轻松构建与部署语音、对话及动画AI模型,提升软件与游戏体验。

- NVIDIA推出由社区和自身构建的生成式AI模型,涵盖GPT、T5和Llama等,可通过Hugging Face或NGC目录轻松下载,并在AI Playground中高效测试,助您快速掌握AI前沿技术。

NVIDIA 生成式 AI 方案优势和特点包括:

- NVIDIA生成式AI解决方案优势显著:快速部署、模型制作简便、企业级模型即刻生产,助力企业迅速响应市场需求。

- NVIDIA生成式AI在可再生能源预测、药物研发、欺诈预防及野火探测等行业大显身手,成功引领行业变革。

- NVIDIA提供全方位资源支持:技术培训、认证计划、开发者论坛、技术支持及初创公司加速计划,助力您轻松前行。

NVIDIA的生成式AI解决方案为企业和开发者赋能,提供尖端工具与资源,驱动创新,助力新品研发与服务升级,解决实际问题,引领未来。

行业整体方案

数据中心和云计算

NVIDIA数据中心与云计算解决方案,综合创新技术体系,融合GPU、DPU、CPU集成架构与软件定义数据中心(SDDC)概念,构建高性能、高效率、安全可靠的云计算环境,满足现代数据中心需求,助力企业与服务提供商迈向卓越。

NVIDIA数据中心和云计算解决方案的主要信息如下:

核心架构

- NVIDIA GPU加速器为数据中心注入高性能计算力,卓越应对AI训练与推理、数据分析、科学计算和图形渲染等计算密集型任务,大幅提升处理效率。

- NVIDIA BlueField DPU革命性加速数据中心性能,专为网络、存储和安全任务设计,有效卸载负载,释放CPU资源,助力更高效的数据处理工作。

- NVIDIA Grace CPU架构专为数据中心打造,协同GPU与DPU,实现卓越数据处理能力,满足高性能需求。

云计算解决方案

- NVIDIA EGX平台专为边缘计算打造,支持近数据源数据处理,显著减少延迟,提升响应速度,兼容广泛云计算应用,助力实时、高效的数据处理。

- NVIDIA OVX平台:赋能Omniverse工业数字孪生,超强算力轻松应对复杂工程与模拟挑战,助力行业革新。

技术服务体系

- 提供部署NVIDIA AI和加速计算技术的专业工具和指南,助力企业迅速部署并高效扩展数据中心中的工作负载。

- 企业AI与数据分析:助力构建与扩展AI工作负载,加速数据分析与AI应用开发,提供深度学习培训及行业AI实施方案。

- 工作负载优化,全面覆盖AI训练与推理、高性能计算、数据分析、渲染和虚拟化,为您的业务需求量身定制解决方案。

- 资源丰富,包括GPU优化软件与NVIDIA合作伙伴网络(NPN),全方位支持企业高效寻找并合作加速计算领域的专业伙伴。

NVIDIA倾心打造现代化数据中心与云计算环境,助力企业和服务提供商应对数据增长与计算挑战,实现高效、安全运营。

高性能计算

NVIDIA融合高性能计算与AI技术,为科研和工业领域提供高效精准的解决方案,助力工作效率与准确度的双重提升。

以下是该解决方案的关键内容要点:

- AI赋能HPC模拟技术,助力科研与工程加速。研究人员与工程师借此实现精准高效的结果获取,推动科学突破与复杂技术难题的解决。

- NVIDIA推出GPU加速软件系列,涵盖AI与HPC领域,包括PyTorch、TensorFlow、TorchANI等,均经GPU深度优化。轻松从NVIDIA NGC目录获取,无缝部署于GPU加速的HPC集群、云实例及工作站,性能卓越,助力科研与业务飞速发展。

- NVIDIA Modulus,融合物理信息与神经网络(PINN)的高效工具包,轻松应对AI与物理技术融合挑战,支持正向、反向及数据同化处理,助力创新突破。

NVIDIA的HPC与AI解决方案,凭借卓越计算力与高效软件工具,加速科研和工业创新,显著提升工作效率,并在多领域实现突破性成果。

自动驾驶

NVIDIA自动驾驶技术,构建全面生态系统,赋能自动驾驶汽车的全流程开发、测试与部署。涵盖硬件、软件、数据中心及仿真平台,为汽车制造商、供应商、初创企业及科研机构提供强大工具与技术支撑。

以下是 NVIDIA 自动驾驶技术方案的关键组成部分:

- NVIDIA DRIVE平台,一站式自动驾驶方案,融合尖端硬件、软件与云服务,赋予车辆观察、思考与学习能力,引领自动驾驶新时代。

- DRIVE硬件平台集大成者:NVIDIA DRIVE Hyperion,量产自动驾驶汽车的标杆参考架构,搭载DRIVE Orin高性能AI计算与全套传感器套件,为自动驾驶未来注入强劲动力。

- DRIVE软件:集自动驾驶汽车所需的感知、定位、绘图、规划控制、驾驶监控等多功能于一体的专业应用方案。

- NVIDIA DRIVE Sim结合Omniverse,打造物理级精准仿真环境,全面助力自动驾驶汽车在各种复杂场景下的高效测试与验证。

- NVIDIA DRIVE 数据中心解决方案提供一站式硬件、软件和工作流,全面支持神经网络开发、训练、验证及仿真测试,高效助力数字化转型。

- NVIDIA AI Enterprise与Omniverse Cloud引领云服务革新,提供云端虚拟测试车队,助力OEM在高度逼真的物理虚拟环境中高效测试与验证自动驾驶汽车,开启自动驾驶新时代。

NVIDIA以先进技术方案引领自动驾驶汽车行业发展,助力合作伙伴快速打造安全、可靠、领先的自动驾驶系统。

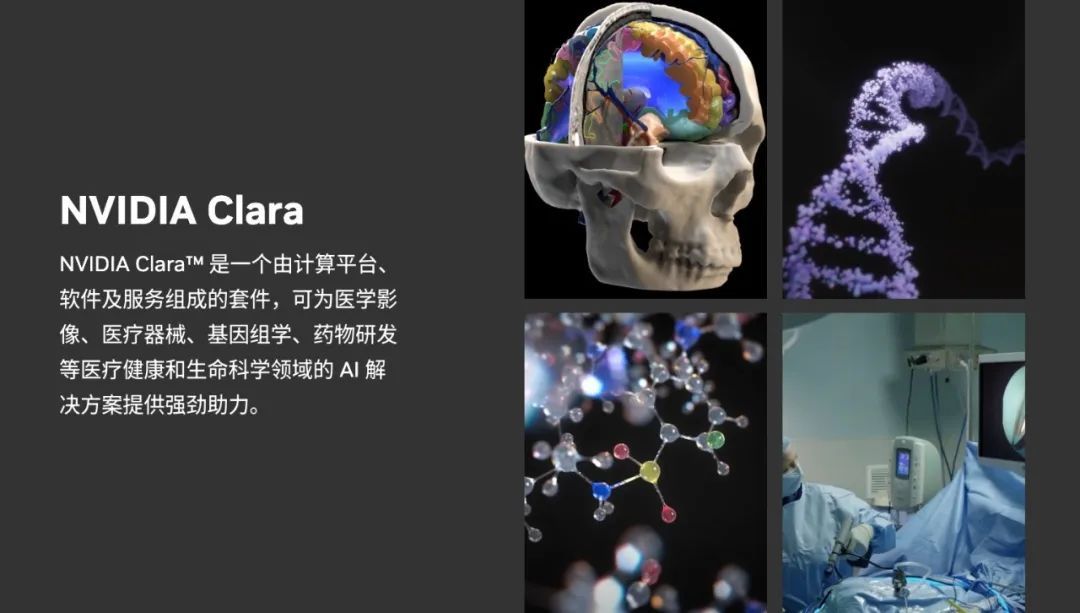

医疗健康

NVIDIA Clara,医疗健康AI创新引擎,集结GPU技术与医疗设备、研究人员及开发者之力,驱动医疗领域变革。平台配备全套工具与库,助力医疗专家轻松开发、部署AI应用,革新病人护理,加速药物研发,提升临床研究效率。NVIDIA Clara,引领医疗创新,守护生命之光。

以下是 NVIDIA Clara 方案的主要特点:

- Clara AI赋能医疗设备革新,助力开发者打造利用AI进行图像处理、诊断辅助和患者监护的下一代医疗神器。

- Clara展现卓越跨平台兼容性,轻松部署于NVIDIA DGX系统、认证GPU加速平台等多类操作系统与硬件,实现高效运行。

NVIDIA Clara旨在借助顶尖AI计算力与简化开发工具,驱动医疗健康领域的技术革新,为患者打造更优质的医疗服务体验。

机器人

NVIDIA AI机器人平台集成尖端软硬件技术,助力开发者高效推进大规模AI机器人训练、开发与部署,为机器人行业提供一站式解决方案,加速创新步伐。

NVIDIA Isaac软件方案是核心,涵盖机器人仿真、导航及操作的SDK。它提供高级机器人API、仿真环境Isaac Sim,及构建自主机器人应用的强大工具和库,助您轻松打造智能化机器人应用。

以下是 NVIDIA AI 机器人方案及 Isaac 框架的关键特性:

- NVIDIA提供端到端工作流,涵盖仿真至实际部署,确保开发者在安全虚拟环境中轻松测试与验证机器人行为。

- Isaac集成摄像头、激光雷达、超声波与触觉传感器,赋予机器人全方位的环境感知能力,实现精准感知与决策。

- Isaac凭借卓越的SLAM技术和路径规划算法,实现精准导航与地图构建,助力机器人在复杂环境中游刃有余。

- NVIDIA构建强大的合作伙伴生态,提供从专用板卡、AI软件、应用设计到传感器和开发者工具的全方位支持,助力创新与发展。

- NVIDIA AI机器人方案已广泛应用于制造、零售、农业、仓储物流、配送及医疗健康等行业,有效优化流程、降低风险,显著削减企业成本。

- NVIDIA为开发者提供视频、博客、研究文献及咨询服务等丰富资源,助力其充分利用机器人开发解决方案,实现卓越性能。

NVIDIA AI机器人方案与Isaac框架强强联手,为开发者构建强大平台,加速机器人技术的创新与应用发展。

工业级 AI

NVIDIA工业级AI,专为制造业和工业环境量身打造,以高性能边缘计算平台为核心,推动工业自动化,优化运营效率,保障操作安全可靠。

以下是 NVIDIA 工业级 AI 方案的主要特点:

- NVIDIA IGX平台,专为边缘AI打造的工业级高性能平台,兼具卓越功能与安全性。适用于工业、医疗领域,支持人机协作,确保AI技术安全无忧地提供强大支持。

- NVIDIA IGX Orin,高性能系统,专为实时应用而生。其AI计算能力卓越,每秒高达275TOPS,且配备高级安全功能,确保低延迟运行,为IGX平台注入强大动力。

- NVIDIA为企业提供卓越支持:长达10年的IGX软件栈支持,涵盖工业医疗认证文档,以及针对IGX硬件的Linux板级支持包与驱动,确保无忧运行。

- NVIDIA工业级AI解决方案凭借GPU加速计算,强势驱动工业自动化与医疗设备领域的大规模AI应用,高效优化运营,实现分析时间的大幅缩减。

- NVIDIA GPU助力开发高精度自动化检测与GPU加速的预测性维护解决方案,显著提升检测精确度,并有效减少运营成本。

- NVIDIA解决方案助力智能工厂,支持定制任务机器人、自动巡航小车及协同机器人,显著提升效率,降低运营成本,引领机器人技术新篇章。

- NVIDIA边缘加速计算:Tesla级边缘GPU与Jetson解决方案赋能工业边缘计算,以GPU驱动强大计算能力,支持工业检测、机器人及预测性维护,助力行业前沿应用。

- NVIDIA GPU Cloud (NGC)携手合作伙伴生态系统,以GPU加速容器简化深度学习框架部署,提供开箱即用解决方案,加速云计算与生态合作,创新无限。

NVIDIA AI 研究推广

NVIDIA Research

研究中心概况

NVIDIA Research专注研发前沿AI、图形与计算技术,不断推动创新边界,引领行业科技新潮流。

NVIDIA Research汇聚全球200+顶尖科学家与工程师,专注引领人工智能、计算机视觉等领域的前沿创新。

- 图形: 开发新的图形技术,以创建更逼真、更身临其境的视觉体验。

- 计算: 开发新的计算架构和软件,以提高计算性能和效率。

成果与贡献

NVIDIA Research 取得了许多重大成果,包括:

- 开发了用于深度学习的 CUDA 并行计算平台。

- 开发了用于图形的 PhysX 物理模拟引擎。

- 开发了用于人工智能的 DRIVE 自主驾驶平台。

- 开发了用于云计算的 EGX 加速计算平台。

- 发表了数百篇研究论文,并在顶级学术会议上发表演讲。

NVIDIA Research 的工作对各个行业产生了重大影响,包括:

- 娱乐: 提高了视频游戏和电影的视觉效果。

- 医疗: 辅助诊断和治疗疾病。

- 制造: 提高生产效率和产品质量。

- 交通: 开发自动驾驶汽车和卡车。

- 科学: 加速科学研究和发现。

NVIDIA Research的突破性研究不仅驱动了公司产品与方案革新,更为科技行业的飞速发展立下汗马功劳。

主要研究领域

NVIDIA Research深耕计算机图形、人工智能、高性能计算和深度学习等前沿技术,研究范围广泛,引领科技潮流。

以下是 NVIDIA Research 的主要研究领域:

- 计算机视觉涵盖图像识别、目标检测、分割及视频分析,专注于通过视觉技术优化用户体验,包括图像/视频分析、3D重建与场景深度理解。

- 图形渲染技术涵盖光线追踪、物理模拟等,专注于探索先进方法,打造逼真、高质量的视觉体验,赋能虚拟现实与增强现实应用。

- 高性能计算涵盖并行、异构、云计算及数据科学,通过算法优化,利用GPU强大算力,高效解决科学与工程难题。

- 自动驾驶:研究和开发使自动驾驶汽车能够安全、高效运行的技术和算法。

- 医疗成像和生命科学:利用AI和图形技术来改进医疗成像、疾病诊断和个性化医疗。

AI Playground

NVIDIA AI Playground,体验尖端AI科技的在线乐园!探索NVIDIA最新研究,通过交互式演示感受技术魅力,并发挥创意,创造你的专属作品。无需专业知识,轻松玩转AI,开启智能探索之旅!

主要功能

- 体验最新的深度学习研究成果,包括:

- 图像修复:去除图片中的瑕疵并生成逼真的填充效果。

- 风格迁移:将一种图像的风格应用到另一张图像上。

- 照片合成:使用深度学习生成逼真的图像和虚拟环境。

- 轻松创建自己的作品:

- 上传自己的照片或视频,并使用 AI 技术进行处理。

- 调整参数并实时查看结果。

- 将作品保存或分享给他人。

适合人群

- 对人工智能和机器学习感兴趣的任何人

- 想体验最新 AI 技术的人

- 希望学习如何使用 AI 进行创作的人

- 开发人员和研究人员

NVIDIA AI Playground,直观探索AI技术的先锋平台,助力用户领略AI的无限潜能,激发无限创造力,轻松开启AI学习之旅。

NVIDIA Developer

NVIDIA开发者社区:全球开发者的资源宝库,助力您高效利用NVIDIA技术,打造卓越应用程序与解决方案,激发无限创新潜能。

NVIDIA Developer 主要提供以下内容:

学习资源:

- 教程、文档、示例代码和博客文章,帮助开发者学习如何使用 NVIDIA 技术。

- 技术论坛和社区活动,让开发者与专家和同行交流学习。

开发工具:

- CUDA、cuDNN、TensorRT等尖端工具与SDK,助您高效开发GPU加速应用程序,释放无限计算潜能。

- NGC 容器平台,提供预训练模型、应用程序和工具的容器镜像。

- AI 指南,提供各种 AI 应用领域的最佳实践和建议。

开发者计划:

- NVIDIA 初创加速计划,帮助初创公司利用 NVIDIA 技术快速发展。

- NVIDIA 深度学习研究所 (DLI),提供各种 AI 和 HPC 培训课程。

NVIDIA 开发者社区主要面向以下人群:

- 软件开发人员

- 数据科学家

- 机器学习工程师

- HPC 工程师

- 研究人员

- 初创公司

NVIDIA开发者社区,集结技术与创意的殿堂。丰富资源、高效工具,助力开发者释放NVIDIA技术潜能,共创卓越应用与解决方案。

NVIDIA DLI

NVIDIA深度学习研究所(DLI)提供免费的和付费的培训平台,专为开发者和专业人士打造,旨在助力他们高效掌握深度学习技术,引领科技前沿。

DLI 提供以下主要内容:

课程:

- 提供一系列涵盖深度学习基础知识、高级主题和特定应用领域的免费和付费课程。

- 课程内容涵盖深度学习理论、实践应用、最新技术趋势等。

- 课程形式包括视频、讲义、动手实践等。

认证:

- 我们推出深度学习领域的专业认证考试,如DLI认证深度学习专家,助您展现深度学习领域的专业技能,提升行业竞争力。

- 认证考试可以帮助学员验证其深度学习技能,并获得行业认可的证书。

学习资源:

- 提供丰富的学习资源,包括教程、文档、示例代码等。

- 学习资源可以帮助学员巩固所学知识,并进行更深入的学习。

社区:

- 提供 DLI 社区平台,让学员可以交流学习经验,并与专家互动。

- DLI 社区可以帮助学员拓展人脉,并获得最新行业资讯。

DLI 提供以下服务:

- 课程咨询: 帮助学员选择合适的课程,并提供课程学习指导。

- 技术支持: 提供技术支持,帮助学员解决学习过程中遇到的问题。

- 认证考试报名: 提供认证考试报名服务,并协助学员准备考试。

- 企业培训: 提供定制化企业培训服务,帮助企业提升员工的深度学习技能。

DLI 面向以下人群提供服务:

- 开发人员

- 数据科学家

- 机器学习工程师

- 研究人员

- 学生

- 对深度学习感兴趣的任何人

NVIDIA DLI,深度学习技术的精英训练场。丰富课程、资源、认证服务助力学员迅速提升技能,赢取行业认可证书,开启AI未来之旅。

NVIDIA Open Source

NVIDIA 积极参与开源社区,并致力于开源软件的开发和贡献。

NVIDIA 开源项目涵盖以下几个方面:

- 深度学习: TensorFlow、PyTorch、ONNX、RAPIDS 等。

- 高性能计算: CUDA、cuDNN、MPI、OpenCL 等。

- 图形: Vulkan、OpenGL、DirectX 等。

- 人工智能: Triton AI、Hopper AI 等。

- 云计算: Kubernetes、Docker 等。

NVIDIA 在开源领域做出了以下重要贡献:

- NVIDIA积极投入开源,至2023年已向200+项目贡献超1400万行代码,助力技术创新与生态繁荣。

- 开源硬件引领未来,NVIDIA的DRIVE AGX Xavier和Jetson系列嵌入式平台,引领行业创新,助力智能化升级。

- 高效开源之选:NVIDIA AI Enterprise与Omniverse,引领AI与3D仿真技术的创新平台。

- 支持开源社区: 赞助开源项目和活动,并为开源开发者提供支持。

NVIDIA 的开源贡献对各个领域产生了重大影响:

- 促进了一些关键技术的标准化: 例如 Vulkan 和 ONNX。

NVIDIA作为开源社区的重要力量,其开源项目与贡献在各领域均发挥积极作用。公司坚定推动开源技术创新,与社区携手共建更加繁荣的开源生态,共创未来。

GTC

NVIDIA GTC:聚焦AI、深度学习、加速计算和GPU技术的全球技术盛会,引领科技前沿,共创未来。

GTC大会汇聚业界领袖、开发者、研究人员与商业策略专家,共绘AI与加速计算蓝图。这里不仅是交流平台,更是知识分享、技术革新的热土,助力参与者建立深厚联系,共创未来。

GTC 2024 概览

- 日期:2024年3月18日至21日

- 地点:美国加州圣何塞会议中心

- 形式:线上直播和线下会议相结合

主要内容和亮点

- 会议和讲座:超过900场的会议和20多场的技术讲座,涵盖各种技术主题和行业应用。

- 展商:200多家展商展示最新的产品和服务。

- 精选中文内容:NVIDIA揭秘最新架构与LLM全栈方案,China AI Day、DriveDevDay TA等盛会,探讨AI前沿,引领创新风潮。

历届GTC情况

GTC大会盛况空前,年年吸引数千精英。技术研讨、实践工作坊、产品展示、网络活动精彩纷呈。每届大会均展示NVIDIA在GPU技术和AI领域的尖端成果,以及与行业领军者的合作典范,不容错过!

GTC是AI硬件推广与NVIDIA在AI领域领导地位的盛会,为AI及加速计算专家提供学习与交流平台。线上直播或现场参与,均可汲取宝贵知识与灵感,助力职业成长与技术革新,不容错过!

NVIDIA AI 愿景

AI 理念

NVIDIA 的 AI 发展愿景是:

- 推动 AI 在各行各业的应用: 赋能各行各业,解决现实世界中的挑战。

NVIDIA 采取了以下措施来实现其 AI 理念和发展愿景:

- 我们推出了集GPU、AI加速器和DGX超级计算平台于一体的AI加速硬件系列,为AI应用提供无与伦比的计算动力。

- 隆重推出AI软件平台与工具套件:CUDA、cuDNN、TensorRT及Metropolis,一站式简化AI应用的开发部署流程,助您高效创新。

- NVIDIA 设立AI研究院,携手学术界与产业界,深入参与AI研发与标准制定,共促技术创新与产业发展,引领行业新潮流。

NVIDIA秉持AI变革世界的信念,以AI理念与发展愿景为核心,推动技术创新和应用,为全球人类带来福祉。

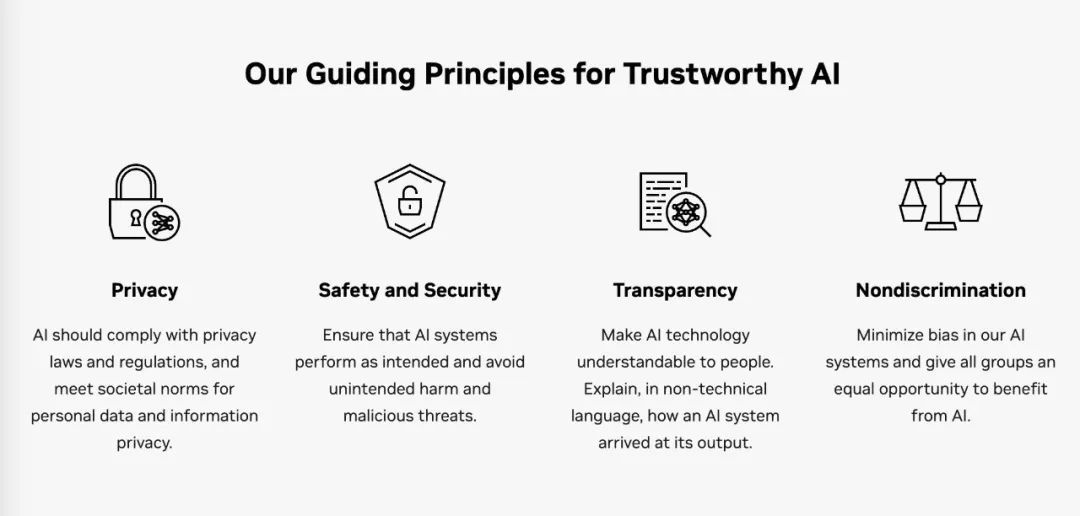

可信 AI

探索NVIDIA可信AI,引领智能未来。我们致力于构建安全、可靠的人工智能解决方案。

其核心理念包括:

- 安全性: 确保 AI 系统免受攻击和滥用,保护用户隐私和数据安全。

- 可靠性: 确保 AI 系统能够稳定、一致地运行,并提供可解释的结果。

- 公平性: 确保 AI 系统不会产生偏见或歧视,并以公平公正的方式对待所有用户。

- 道德规范: 确保 AI 系统符合道德规范,并以负责任的方式应用。

NVIDIA 关于可信AI的主要指导原则:

- 隐私:AI应遵守隐私法律和法规,符合社会对个人数据和信息隐私的规范。

- 安全与安全:确保AI系统按预期运行,避免意外伤害和恶意威胁。

- 透明度:使AI技术易于理解,用非技术语言解释AI系统如何得出其输出。

- 非歧视:减少AI系统中的偏见,确保所有群体平等受益于AI。

NVIDIA携手合作伙伴,通过一系列创新解决方案,全力推进可信AI的发展,实现AI技术的可信赖与可靠性。

- NVIDIA Omniverse Replicator DRIVE Sim高效生成多元化合成数据集,有效减少偏见、保护隐私,精准复制自动驾驶、工业检测与机器人仿真的真实场景,助力行业精准模拟,提升效率。

- NeMo Guardrails确保大型语言模型(LLM)驱动的智能应用精准、恰当、相关且安全,保障用户体验无忧。

NVIDIA携手Te Hiku Media、Getty Images和Adobe Firefly,共推可信AI技术革新。公司专注研发提升人类能力、解决复杂难题的高效算法与系统,同时坚守隐私、透明度、非歧视和安全的指导原则,确保研究实践的全面性与严谨性,引领行业迈向更高效率。

NVIDIA坚信可信AI是AI发展的必由之路。我们积极倡导并实践这一理念,力促AI技术安全、可靠、公平且负责任地服务人类,共筑智能未来。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-

![[优选算法]------滑动窗⼝——209. 长度最小的子数组](https://img-blog.csdnimg.cn/direct/583104cca6d540c58db06717ac8c809f.png)