生产者分区

分区的原因

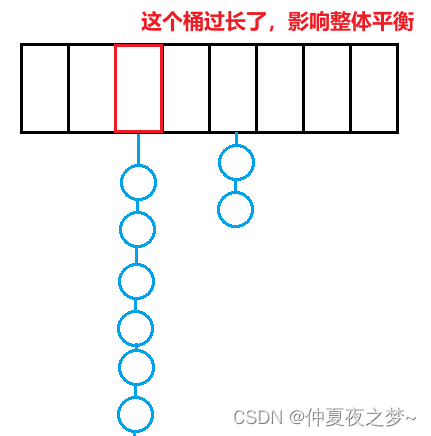

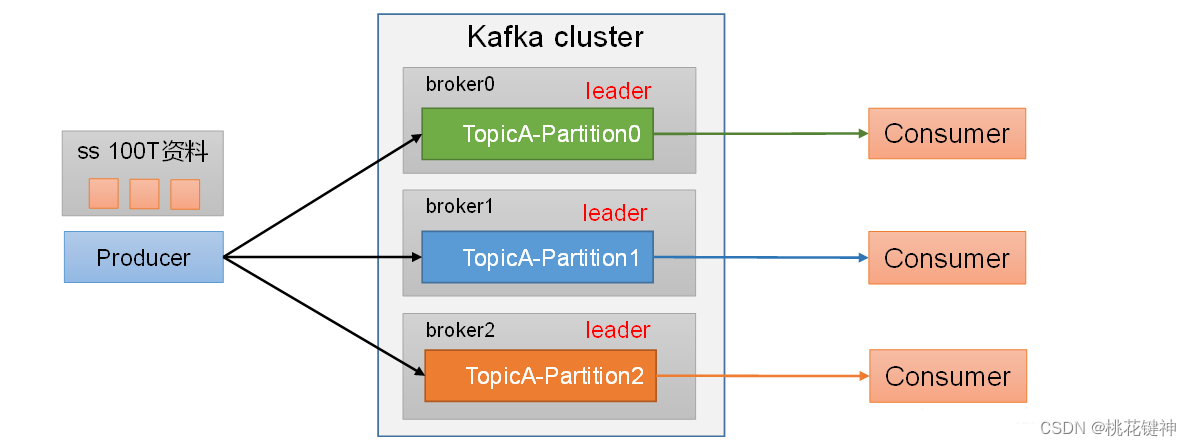

(1)便于合理使用存储资源,每个Patition在一个Broker上存储,可以把海量的数据按照分区切割成一块一块数据存储在多台Broker上。合理控制分区的任务,可以实现负载均衡的效果。

(2)提高并行度,生产者可以以分区为单位发送数据;消费者可以以分区为单位进行消费数据

生产者分区策略

1.默认分区器DefaultPartitioner

public class DefaultPartitioner implements Partitioner {

… …

}

2.使用:

1) 我们需要将producer发送的数据封装成一个ProducerRecord对象。

2) 上述的分区策略,我们在ProducerRecord对象中进行配置。

3)策略实现:

| 代码 | 解释 |

|---|---|

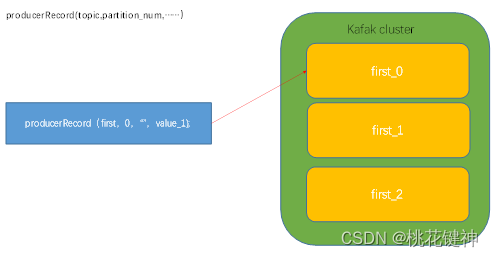

| ProducerRecord(topic,partition_num,……) | 指明partition的情况下直接发往指定的分区,key的分配方式将无效 |

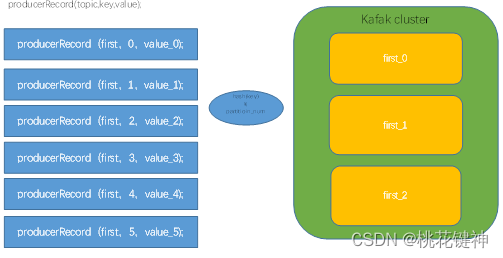

| ProducerRecord(topic,key,value) | 没有指明partition值但有key的情况下:将key的hash值与topic的partition个数进行取余得到分区号; |

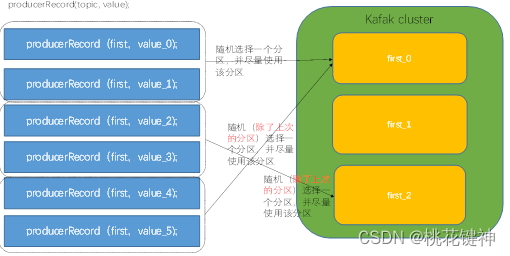

| ProducerRecord(topic,value) | 既没有 partition 值又没有 key 值的情况下:kafka采用Sticky Partition(黏性分区器),会随机选择一个分区,并尽可能一直使用该分区,待该分区的batch已满或者已完成,kafka再随机一个分区(绝对不会是上一个)进行使用. |

- 案例实操:

1)案例1:将数据发送到指定partition的情况下,如:将所有消息发送到分区1中。

package com.atguigu.kafka.producer;

import org.apache.kafka.clients.producer.*;

import java.util.Properties;

public class CustomProducerCallbackPartitions {

public static void main(String[] args) {

// 1. 创建kafka生产者的配置对象

Properties properties = new Properties();

// 2. 给kafka配置对象添加配置信息

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG,"hadoop102:9092");

// key,value序列化(必须):

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

// 3. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<>(properties);

// 4. 造数据

for (int i = 0; i < 5; i++) {

// 指定数据发送到1号分区,key为空(IDEA中ctrl + p查看参数)

kafkaProducer.send(new ProducerRecord<>("first", 1,"","atguigu " + i), new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e == null){

System.out.println("主题:" + metadata.topic() + "->" + "分区:" + metadata.partition()

);

}else {

e.printStackTrace();

}

}

});

}

kafkaProducer.close();

}

}

2)测试:

① 在hadoop102上开启kafka消费者

[atguigu@hadoop104 kafka]$ sbin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic first

② 在IDEA中执行代码,观察hadoop102上的消费者消费情况

[atguigu@hadoop104 kafka]$ sbin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic first

atguigu0

atguigu1

kafka2

……

③ 观察IDEA中控制台输出

主题:first->分区:1

主题:first->分区:1

主题:first->分区:1

主题:first->分区:1

主题:first->分区:1

3)案例2:没有指明partition但是有key的情况下的消费者分区分配

package com.atguigu.kafka.producer;

import org.apache.kafka.clients.producer.*;

import java.util.Properties;

public class CustomProducerCallbackKey {

public static void main(String[] args) {

// 1. 创建配置对象

Properties properties = new Properties();

// 2. 配置属性

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG,"hadoop102:9092");

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

// 3. 创建生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<>(properties);

// 4. 造数据

for (int i = 1; i < 11; i++) {

// 创建producerRecord对象

final ProducerRecord<String, String> producerRecord = new ProducerRecord<>(

"first",

i + "",// 依次指定key值为i

"atguigu " + i);

kafkaProducer.send(producerRecord, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e == null){

System.out.println("消息:"+producerRecord.value()+", 主题:" + metadata.topic() + "->" + "分区:" + metadata.partition()

);

}else {

e.printStackTrace();

}

}

});

}

kafkaProducer.close();

}

}

4)测试

观察IDEA中控制台输出

消息:atguigu 1, 主题:first->分区:0

消息:atguigu 5, 主题:first->分区:0

消息:atguigu 7, 主题:first->分区:0

消息:atguigu 8, 主题:first->分区:0

消息:atguigu 2, 主题:first->分区:2

消息:atguigu 3, 主题:first->分区:2

消息:atguigu 9, 主题:first->分区:2

消息:atguigu 4, 主题:first->分区:1

消息:atguigu 6, 主题:first->分区:1

消息:atguigu 10, 主题:first->分区:1

自定义分区器

- 生产环境中,我们往往需要更加自由的分区需求,我们可以自定义分区器。

- 需求:在上面的根据key分区案例中,我们发现与我们知道的hash分区结果不同。那么我们就实现一个。

3.实现步骤:

① 定义类,实现Partitioner接口

② 重写partition()方法 - 代码实现:

package com.atguigu.kafka.partitioner;

import org.apache.kafka.clients.producer.Partitioner;

import org.apache.kafka.common.Cluster;

import java.util.Map;

/**

* @author leon

* @create 2020-12-11 10:43

* 1. 实现接口Partitioner

* 2. 实现3个方法:partition,close,configure

* 3. 编写partition方法,返回分区号

*/

public class MyPartitioner implements Partitioner {

/**

* 分区方法

**/

@Override

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

// 1. 获取key

String keyStr = key.toString();

// 2. 创建分区号,返回的结果

int partNum;

// 3. 计算key的hash值

int keyStrHash = keyStr.hashCode();

// 4. 获取topic的分区个数

int partitionNumber = cluster.partitionCountForTopic(topic);

// 5. 计算分区号

partNum = Math.abs(keyStrHash) % partitionNumber;

// 4. 返回分区号

return partNum;

}

// 关闭资源

@Override

public void close() {

}

// 配置方法

@Override

public void configure(Map<String, ?> configs) {

}

}

- 测试

在生产者代码中,通过配置对象,添加自定义分区器

// 添加自定义分区器

properties.put(ProducerConfig.PARTITIONER_CLASS_CONFIG," com.atguigu.kafka.partitioner.MyPartitioner ");

在hadoop102上启动kafka消费者

[atguigu@hadoop102 kafka]$ sbin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic first

在IDEA中观察回调信息

消息:atguigu 2, 主题:first->分区:2

消息:atguigu 5, 主题:first->分区:2

消息:atguigu 8, 主题:first->分区:2

消息:atguigu 1, 主题:first->分区:1

消息:atguigu 4, 主题:first->分区:1

消息:atguigu 7, 主题:first->分区:1

消息:atguigu 10, 主题:first->分区:1

消息:atguigu 3, 主题:first->分区:0

消息:atguigu 6, 主题:first->分区:0

消息:atguigu 9, 主题:first->分区:0