基本概念

我们知道,所谓的神经网络其实就是一个复杂的非线性函数,网络越深,这个函数就越复杂,相应的表达能力也就越强,神经网络的训练则是一个拟合的过程。

当模型的复杂度小于真实数据的复杂度,模型表达能力不够,不足以表达真实数据,这种情况就叫欠拟合,其典型表现是即使是在训练集上依然达不到一个很好的水平,准确度和loss都比较差。欠拟合可以通过增加模型复杂度来改善。

但是,当模型过于复杂时,拟合能力过强,这就会导致模型拟合了训练集中的一些噪声点,在测试集上的性能反而不强,这就造成了过拟合现象,因为我们希望模型学习到的应该是普适的规律,而不是训练集中的一些特殊情况。其典型表现是在训练集上的性能逐渐变强(损失还在下降),但是在测试集上的损失开始稳定上升。下图中的三种曲线分别代表了欠拟合、好的拟合和过拟合三种情况:

如何应对?

应对过拟合

解决过拟合最好的方法就是获取更多的训练数据。只要给足够多的数据,让模型学习尽可能多的情况,它就会不断修正自己,从而获得更强的性能。但是在实验的过程中,获取有效的数据往往是非常困难的,或者说我们需要使用固定的数据集。那么就需要在模型结构和训练方式上下点功夫。

Dropout正则化层的使用

Dropout正则化是一种广泛使用的技术,用于减少神经网络中的过拟合问题。这是一种随机丢弃神经元的方法,在模型的某层映射后添加dropout层,网络在经过该层映射时,每个神经元都有一定的概率被丢弃,这意味着在每个训练批次中,不同的神经元会被丢弃,从而使得网络更加健壮和通用,增加网络的鲁棒性。这样,网络不会过度依赖任何一个特定的神经元,从而减少过拟合的风险。

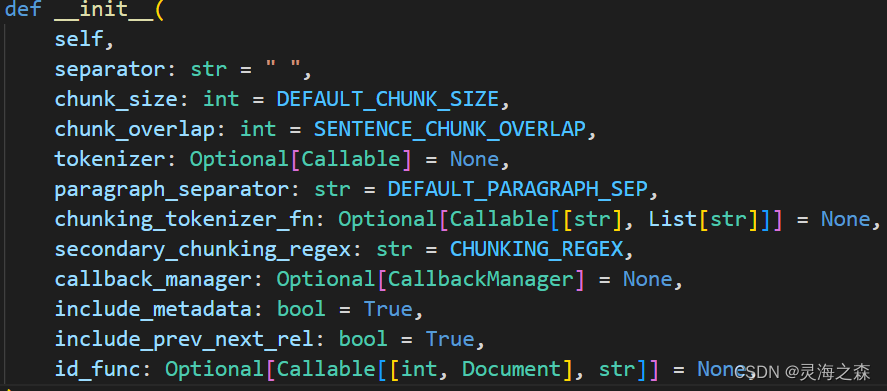

pytorch中的dropout层:

output = torch.nn.functional.dropout(input, p=0.5, training=True, inplace=False)

其中p值表示该层零化元素的概率,即每一次使多少随机的神经元失活,默认为0.5。p值的设置比较重要,设置太大可能会造成信息丢失,设置太小可能效果不明显,0.5是一个比较常用的值。

正则化(权值衰减)

权值衰减是一直以来经常被使用的一种抑制过拟合的方法。该方法通过在学习过程中对大的权重进行惩罚,来抑制过拟合。因为很多过拟合原本就是因为权重参数取值过大才发生的。

神经网络的习目的是减小损失函数的值。这时,例如为损失函数加上权值的平方范数(L2范数)。这样就可以抑制权重变大。L2范数的计算方式为:

L

2

r

e

g

u

l

a

r

i

z

a

t

i

o

n

t

e

r

m

=

∣

∣

w

∣

∣

2

2

=

w

1

2

+

w

2

2

+

.

.

.

+

w

n

2

L_2 regularization term = ||w||_2^2=w_1^2+w_2^2+...+w_n^2

L2regularizationterm=∣∣w∣∣22=w12+w22+...+wn2 在这个公式中,接近于 0 的权重对模型复杂度几乎没有影响,而离群值权重则可能会产生巨大的影响。我们可以使用python计算L2范数的值:

def loss(self, predict,label):

weight_decay = 0

# 计算所有权重的L2范数

for idx in range(1, self.hidden_layer_num + 2):

W = self.params['W' + str(idx)]

weight_decay += 0.5 * self.weight_decay_lambda * np.sum(W ** 2)

loss = loss_fun(predict,label) + weight_decay

应对欠拟合

欠拟合的主要表现是模型在训练集就无法得到一个很好的性能,也就是无法收敛,这代表模型没有能力捕获重要的特征,可以想象,这样的模型在测试集的变现更差。这种情况可以从数据集和模型两方面考虑,从数据集的角度来说,有可能是样本质量较低,数据本身就不包含足够的特征供网络学习,如果数据集本身是常用的,无法改变的。从模型的角度来说,可以尝试以下几种方法:

增加模型复杂度

模型的复杂程度越高,就可以拟合出更复杂的函数,相应的学习能力也就越强,对于神经网络模型,可以增加隐藏层数或者每层的神经元个数,以增加模型的复杂度。

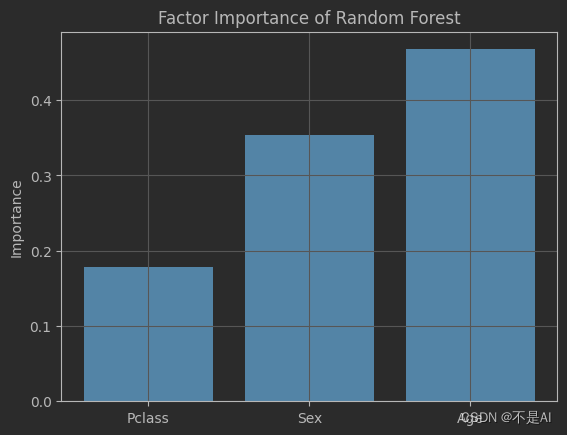

特征工程

对数据特征进行处理,主要包括特征选择、特征提取、特征变换三种。特征选择是指选择对目标变量具有较大影响的特征,去除无关特征,减少噪声的干扰;特征提取是指从原始数据中提取更有用的特征,例如通过统计学方法、主成分分析等方法提取出更具代表性的特征;特征变换是指对原始特征进行变换,例如对数变换、归一化、标准化等,使得特征更符合模型的假设。

调整超参数

bachsize、学习率等超参数也可能会带来一定影响,使用一个太大的batch size会因为降低了梯度下降的随机性,导致降低了网络的准确度。学习率对训练网络的容易程度以及准确度也会产生很大的影响。