文章目录

- Multi-Head Multi-Loss Model Calibration

- 摘要

- 方法

- Multi-Head Ensemble Diversity

- 实验结果

Multi-Head Multi-Loss Model Calibration

摘要

当然,我会按照你的要求逐步列出:

背景:

- 提供有意义的不确定性估计对于机器学习模型在临床实践中的成功部署至关重要。

- 不确定性量化的核心是模型返回的预测与实际正确概率一致,即模型校准。

- 尽管已经提出了许多改善校准的方法,但没有任何技术能够与训练深度神经网络集成的简单但昂贵的方法相媲美。

方法:

- 介绍了一种简化集成的形式,绕过了深度集成的昂贵训练和推断,但保持了其校准能力。

- 将网络末端的常见线性分类器替换为一组头部,这些头部受到不同损失函数的监督,以引入预测多样性。

- 每个头部都被训练来最小化加权的交叉熵损失,但这些权重在不同的分支中是不同的。

- 结果表明,由此产生的平均预测可以在不牺牲准确性的情况下实现出色的校准,在组织病理学和内窥镜图像分类的两个具有挑战性的数据集中。

- 实验表明,多头多损失分类器天生具有良好的校准性,优于其他最近的校准技术,甚至挑战了深度集成的性能。

代码地址

方法

Multi-Head Ensemble Diversity

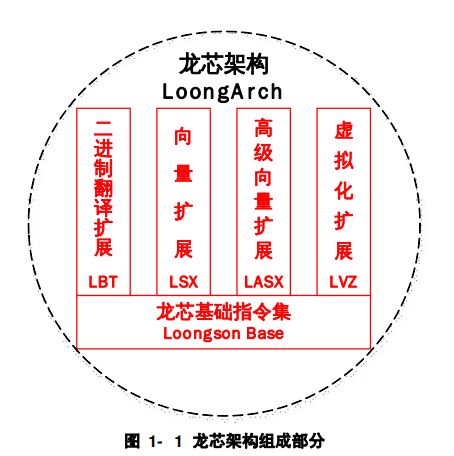

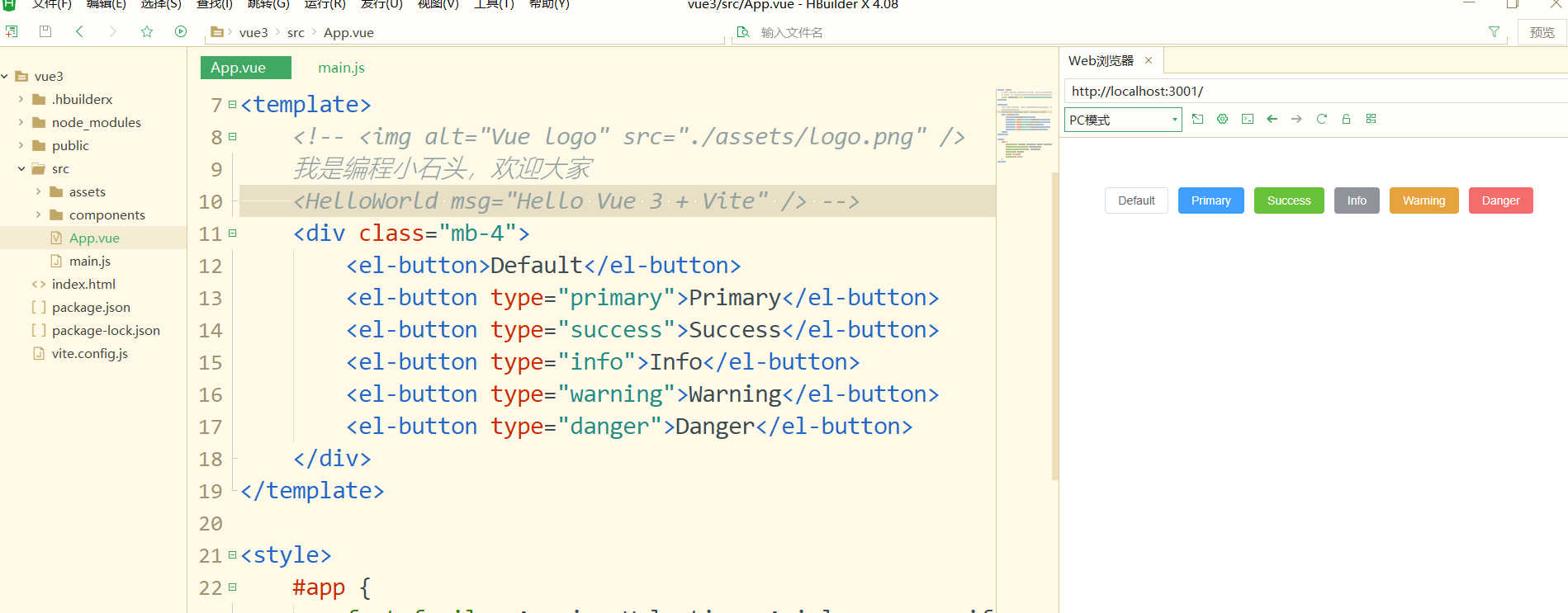

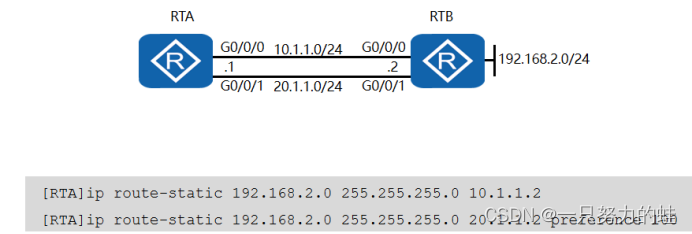

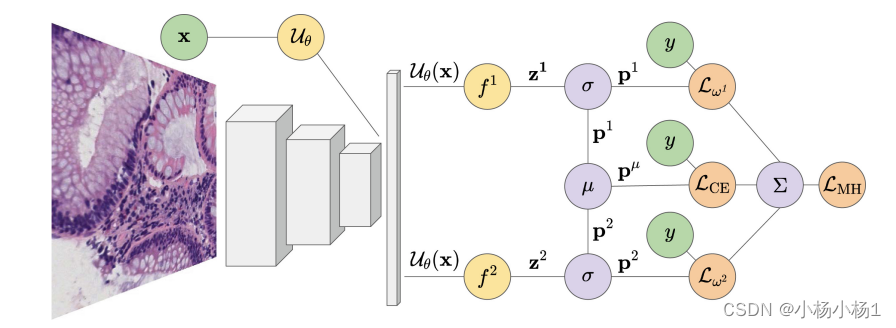

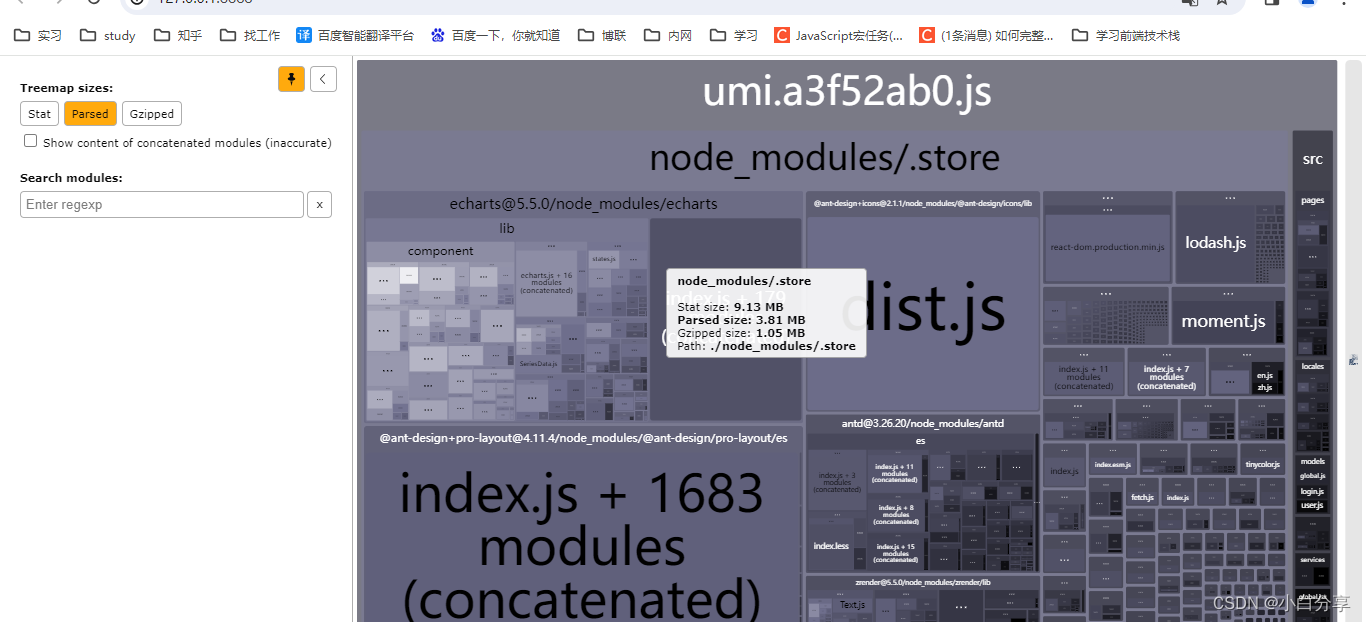

图1. 展示了一个具有M=2个头部的多头多损失模型。图像

x

x

x经过神经网络

U

θ

U_{\theta}

Uθ处理,然后被

M

M

M个头部

{

f

m

}

m

=

1

M

\{f_m\}_{m=1}^{M}

{fm}m=1M线性转换,接着进行softmax操作

σ

\sigma

σ,转换成概率向量

{

p

m

}

m

=

1

M

\{p_m\}_{m=1}^{M}

{pm}m=1M。最终的损失

L

M

H

LMH

LMH是每个头部加权交叉熵损失

L

ω

m

−

C

E

(

p

m

,

y

)

L_{\omega_m-CE}(p_m, y)

Lωm−CE(pm,y)和平均预测

p

μ

=

μ

(

p

1

,

.

.

.

,

p

m

)

p_{\mu} = \mu(p_1, ..., p_m)

pμ=μ(p1,...,pm)的交叉熵损失

L

C

E

(

p

μ

,

y

)

L_{CE}(p_{\mu}, y)

LCE(pμ,y)的总和。我们调整分支之间的权重

ω

m

\omega_m

ωm,以在训练过程中实现更多样化的梯度。

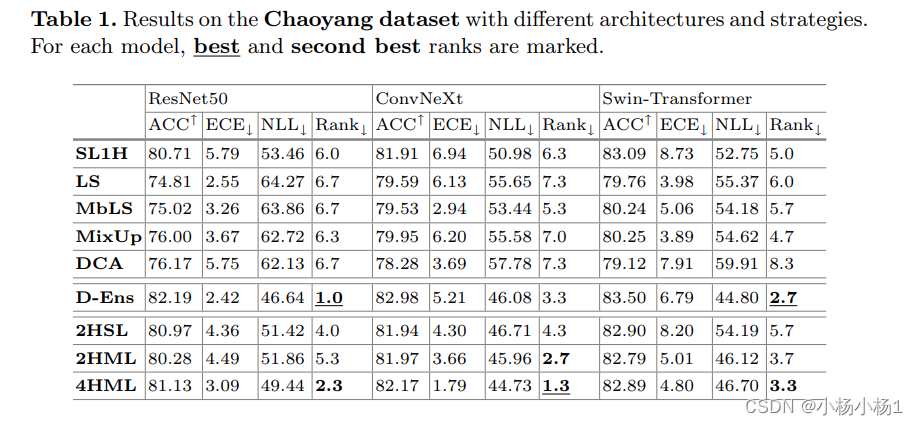

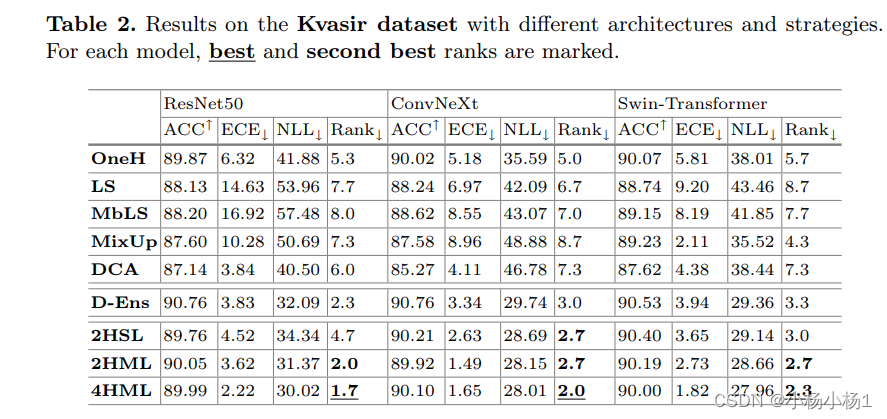

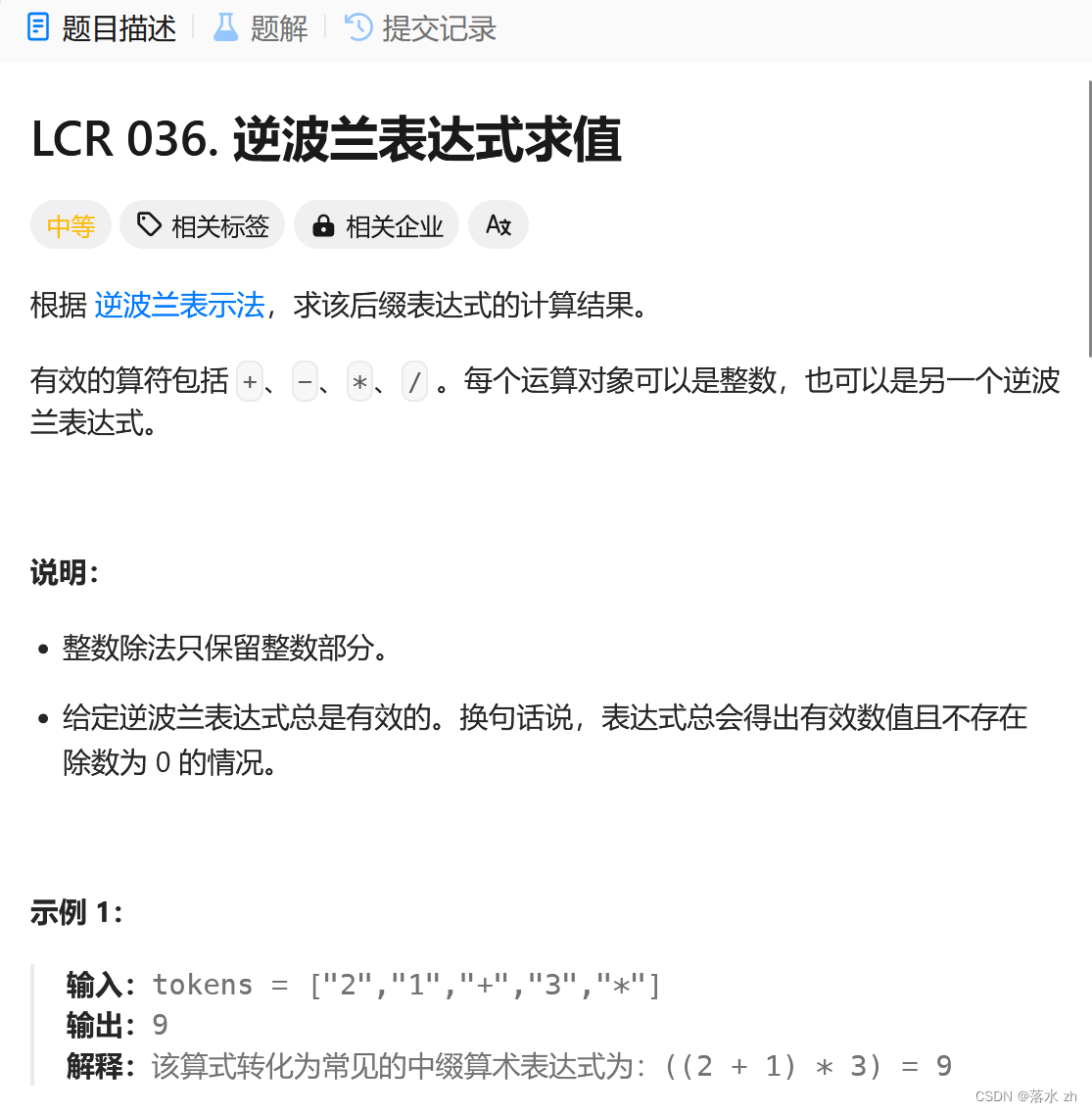

实验结果

![[iOS]使用CocoaPods发布公开库](https://img-blog.csdnimg.cn/direct/23755e62033e441bbcb8f92c929df518.png)