Contents

- Introduction

- Method

- Learn Hierarchical Augmentation Invariance

- Feature expansion with augmentation embeddings

- Experiments

- References

Introduction

- 在对比学习中,数据增强是非常重要的,对比学习的本质就是通过让模型对数据增强具有不变性来使其从样本中抽取出最本质的语义信息 (representational invariance). 目前的对比学习工作大都通过实验预先选取若干种训练时使用的数据增强方法,例如 random cropping and resizing, horizontal flipping, color jittering, converting to grayscale 和 Gaussian blurring. 然而,人工事先确定数据增强方法和数据增强强度实际上会带来一系列的问题:

- (1) 固定的数据增强类型:下图 (a) 展示了不同数据增强类型对 ImageNet 中的多少类别有正面作用,从这一实验结果来看,我们会更倾向于选择 color jittering 而非 rotation 作为我们的数据增强方法,但如图 (b) 所示,对于某些下游任务而言,rotation 可能比 color jittering 更合适。因此,事先确定数据增强类型相当于给模型施加了 implicit knowledge of invariance,这对于某些下游任务是不合适的

- (2) 数据增强强度:SimCLR 证明了 strong data augmentations 利于对比学习,但用 strong augmentations 学出来的特征可能会导致 encoder 具有 unnecessary invariance,无法辨别出一些对下游任务比较重要的细粒度信息。虽然 SimCLR 用 projection head 来隐式地缓解这一问题,但无监督对比学习领域还没有提出显式地解决该问题的方法

- (1) 固定的数据增强类型:下图 (a) 展示了不同数据增强类型对 ImageNet 中的多少类别有正面作用,从这一实验结果来看,我们会更倾向于选择 color jittering 而非 rotation 作为我们的数据增强方法,但如图 (b) 所示,对于某些下游任务而言,rotation 可能比 color jittering 更合适。因此,事先确定数据增强类型相当于给模型施加了 implicit knowledge of invariance,这对于某些下游任务是不合适的

- 为了解决上述问题,作者提出了新的用于对比学习的数据增强策略来帮助模型学得 Hierarchical Augmentation Invariance,该策略可以集成到现有的对比学习方法中,对细粒度分类提升尤为明显。

Method

Learn Hierarchical Augmentation Invariance

- General contrastive learning framework. data augmentation module + siamese structure + contrastive loss

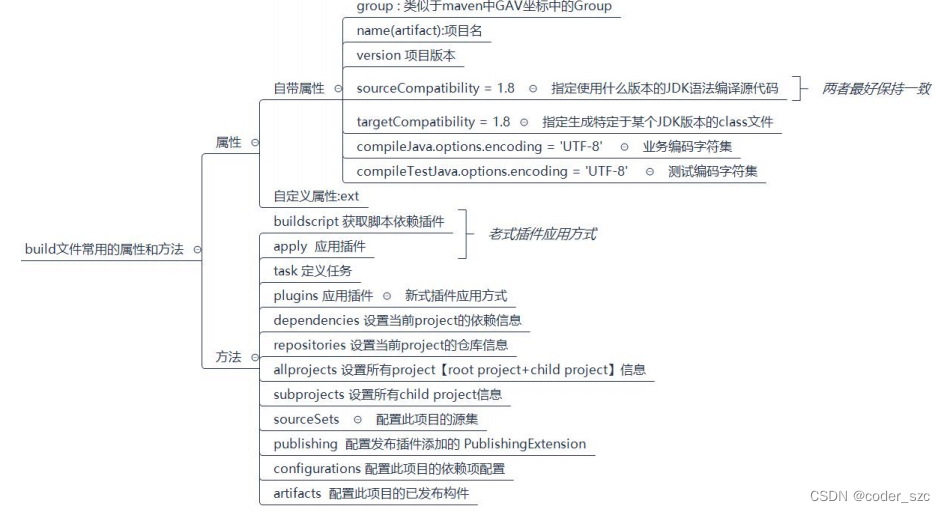

- Augmentation module. 为了减少固定数据增强类型引入的 invariance 先验信息,在数据增强时,作者不是用固定的数据增强方法生成 one pair of views,而是采用 add-one strategy 用 4 个数据增强模块

T

1

∼

T

4

T_1\sim T_4

T1∼T4 生成 four pairs of views

{

v

i

,

v

i

′

}

\{v_i,v_i'\}

{vi,vi′} (现有对比学习工作只使用

T

4

T_4

T4),add-one strategy 是指每个数据增强模块都比上一个模块多使用一种数据增强方法

其中,

t

0

t_0

t0 为 base augmentations,作者选用的是 random cropping and resizing,用于将输入图像调整为相同大小,

t

1

∼

t

4

t_1\sim t_4

t1∼t4 依次为 horizontal flipping, color jittering, converting to grayscale, and Gaussian blurring,它们的顺序按照重要性进行排序. 可见,每对 views 的对齐都给模型引入了一种特定的 augmentation invariance,并且越基础的数据变换不变性在 encoder 里分布得就越广,i.e., the invariances of augmentation

t

0

t_0

t0 and

t

1

t_1

t1 are most widely distributed, while the invariance of

t

4

t_4

t4 is restricted to the deepest stage of the encoder.

其中,

t

0

t_0

t0 为 base augmentations,作者选用的是 random cropping and resizing,用于将输入图像调整为相同大小,

t

1

∼

t

4

t_1\sim t_4

t1∼t4 依次为 horizontal flipping, color jittering, converting to grayscale, and Gaussian blurring,它们的顺序按照重要性进行排序. 可见,每对 views 的对齐都给模型引入了一种特定的 augmentation invariance,并且越基础的数据变换不变性在 encoder 里分布得就越广,i.e., the invariances of augmentation

t

0

t_0

t0 and

t

1

t_1

t1 are most widely distributed, while the invariance of

t

4

t_4

t4 is restricted to the deepest stage of the encoder. - Siamese Structure. 作者将 encoder 分成 4 个 stage,每个 stage 分别抽取出一对 views 的特征然后计算对比损失。这样 encoder 的每个部分就具备了不同的 invariance 特性

其中,

f

i

f_i

fi 为

T

i

T_i

Ti 对应的 encoder 部分,

g

i

g_i

gi 为额外的卷积网络,用于得到与最后一个 stage 相同形状的特征输出,conv layers is 3,2,1 for the first three stages,最后一个 stage 的

g

i

g_i

gi 为恒等映射

其中,

f

i

f_i

fi 为

T

i

T_i

Ti 对应的 encoder 部分,

g

i

g_i

gi 为额外的卷积网络,用于得到与最后一个 stage 相同形状的特征输出,conv layers is 3,2,1 for the first three stages,最后一个 stage 的

g

i

g_i

gi 为恒等映射 - Contrastive Loss. 抽取出的特征加上 MLP-based projection head (3 个全连接层) 后计算对比损失。总的对比损失为 4 对 views 的对比损失之和

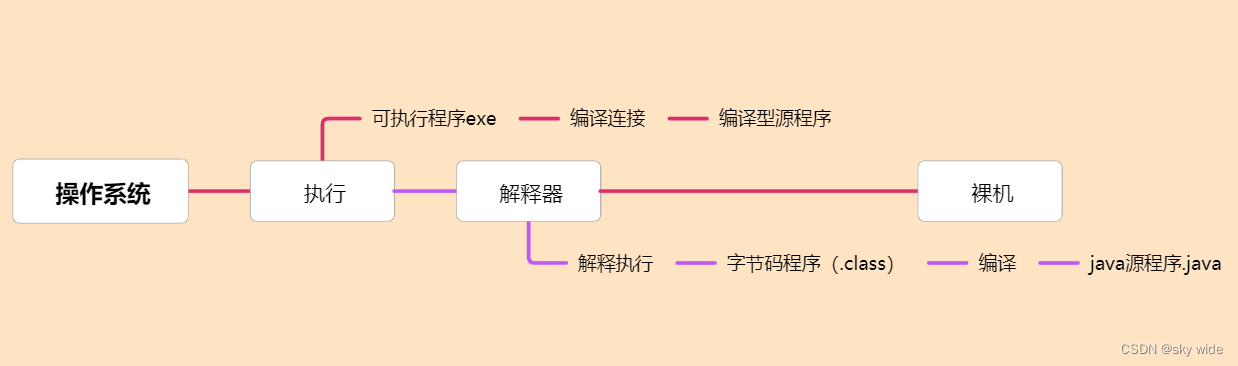

Feature expansion with augmentation embeddings

- 上面的方法可以缓解固定数据增强类型带来的问题,但依然没有解决数据增强强度带来的问题。为此,作者用一个全连接层 (FC + BN + ReLU) f a u g \boldsymbol{f_{aug}} faug 得到 embeddings of specific augmentation parameters { e a u g , e a u g ′ } \{e_{aug},e_{aug}'\} {eaug,eaug′}. 以 color jittering 为例,brightness, contrast, saturation 和 hue 分别为 [ b , c , s , h ] [b, c, s, h] [b,c,s,h],经过输入维度为 4 的线性层即可得到参数的 embed e a u g = f a u g ( [ b , c , s , h ] ) e_{aug}=f_{aug}([b, c, s, h]) eaug=faug([b,c,s,h])

- 在 projection head 前,将 view feature 和 augmentation embed 做向量连接

这样就显式地让 projection head 考虑数据增强带来的影响,从而使得 backbone

f

f

f 中包含更多有用的信息,去除 backbone 中的 unnecessary invariance

这样就显式地让 projection head 考虑数据增强带来的影响,从而使得 backbone

f

f

f 中包含更多有用的信息,去除 backbone 中的 unnecessary invariance

Experiments

- Unsupervised pre-training. 预训练数据集使用 ImageNet ILSVRC-2012

- Linear evaluation. 可以看到,该方法在细粒度分类数据集上提升尤为明显

- Detection and Segmentation.

- Add radom rotation? 在现有对比学习框架中,加上旋转变换甚至可能让模型掉点,但作者用实验证明,通过将 invariance 限制在部分模型上,添加旋转变换是可以涨点的. These results indicate that enlarging the distribution of rotation invariance in the model is harmful to representation learning, which is in line with our intuition and motivation.

- Arrangement modes of augmentations. 越基础的数据变换不变性在 encoder 中的分布就应该越广,因此应该根据数据变换的重要性确定它们的顺序

- Ablation study. (1) 作者设计了两种 baseline,uniform 是指所有 stage 使用相同的数据增强策略,hierarchical strength 是指所有 stage 使用相同的数据增强策略,并且数据增强的强度逐渐增加。add-one strategy 的性能远超上述 baseline,这说明简单的设置多目标损失或是降低浅层网络的数据增强强度并不能有效提升模型性能

(2) Effectiveness of augmentation embed. 以下实验说明采用 augmentation embed 能有效地将数据变换不变性从 backbone 转移到 projection head.

e

e

e 中包含较多数据变换的相关信息,而经过 projection head 后的

h

(

e

)

h(e)

h(e) 就具备了数据变换不变性,预测准确率接近于随机预测

(2) Effectiveness of augmentation embed. 以下实验说明采用 augmentation embed 能有效地将数据变换不变性从 backbone 转移到 projection head.

e

e

e 中包含较多数据变换的相关信息,而经过 projection head 后的

h

(

e

)

h(e)

h(e) 就具备了数据变换不变性,预测准确率接近于随机预测

(3) Embedding types. embedding cropping parameters also leads to an accuracy boost compared with baseline but is less effective than embedding color parameters. Combining cropping embeddings with color embeddings has an unstable effect on different benchmarks.

(3) Embedding types. embedding cropping parameters also leads to an accuracy boost compared with baseline but is less effective than embedding color parameters. Combining cropping embeddings with color embeddings has an unstable effect on different benchmarks.

(4) Effectiveness of the two proposed modules.

(4) Effectiveness of the two proposed modules.

References

- Zhang, Junbo, and Kaisheng Ma. “Rethinking the Augmentation Module in Contrastive Learning: Learning Hierarchical Augmentation Invariance with Expanded Views.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.