前言

嗨喽,大家好呀~这里是爱看美女的茜茜呐

又到了学Python时刻~

环境使用:

-

Python 3.8 解释器

-

Pycharm 编辑器

模块

-

import re

-

import requests >>> pip install requests

( 更多资料、教程、文档点击此处跳转跳转文末名片加入君羊,找管理员小姐姐领取呀~ )

模块安装问题:

-

如果安装python第三方模块:

-

win + R 输入 cmd 点击确定, 输入安装命令 pip install 模块名 (pip install requests) 回车

-

在pycharm中点击Terminal(终端) 输入安装命令

-

-

安装失败原因:

-

失败一: pip 不是内部命令

解决方法: 设置环境变量

-

失败二: 出现大量报红 (read time out)

解决方法: 因为是网络链接超时, 需要切换镜像源

清华:https://pypi.tuna.tsinghua.edu.cn/simple 阿里云:https://mirrors.aliyun.com/pypi/simple/ 中国科技大学 https://pypi.mirrors.ustc.edu.cn/simple/ 华中理工大学:https://pypi.hustunique.com/ 山东理工大学:https://pypi.sdutlinux.org/ 豆瓣:https://pypi.douban.com/simple/ 例如:pip3 install -i https://pypi.doubanio.com/simple/ 模块名 -

失败三: cmd里面显示已经安装过了, 或者安装成功了, 但是在pycharm里面还是无法导入

解决方法: 可能安装了多个python版本 (anaconda 或者 python 安装一个即可) 卸载一个就好

或者你pycharm里面python解释器没有设置好

-

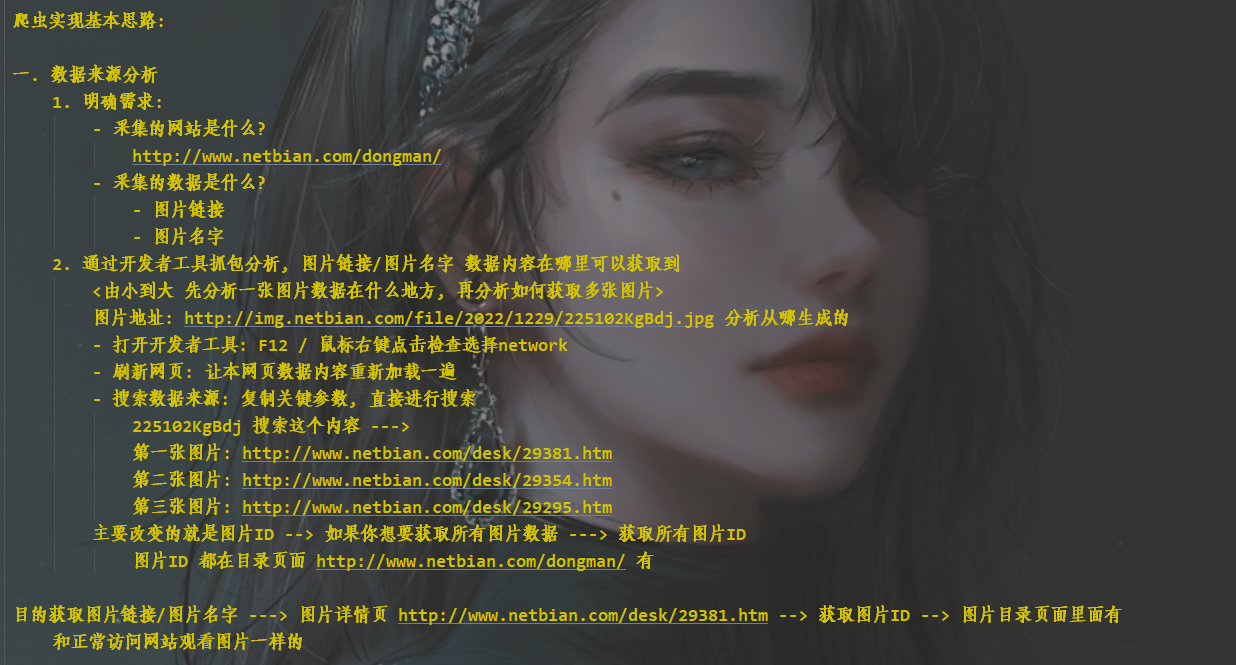

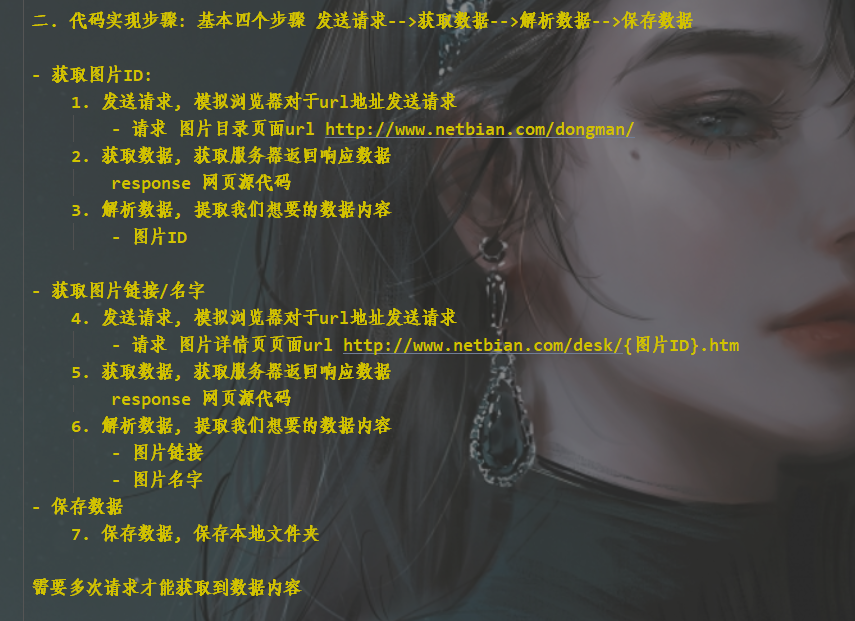

思路

代码展示

( 完整源码点击此处跳转跳转文末名片加入君羊,找管理员小姐姐领取呀~ )

导入模块

# 导入数据请求模块 --> 第三方模块, 需要安装 pip install requests

import requests

# 导入正则模块 --> 内置模块, 不需要安装

import re

“”"

-

发送请求, 模拟浏览器对于url地址发送请求

-

模拟浏览器 <反爬处理> 请求头 <字典数据类型>

如果你不伪装, 可能会被识别出来是爬虫程序, 从而得到数据内容

可以直接复制粘贴 --> 开发者工具里面就可以复制 -

<Response [200]> 响应对象

Response: 中文意思–>响应

<>: 表示对象

200: 状态码 表示请求成功

发送请求, 请求成功了

-

“”"

for page in range(2, 11):

print(f'=================正在采集第{page}页的数据内容=================')

请求图片目录页面url

url = f'http://www.****.com/dongman/index_{page}.htm'

伪装模拟成浏览器

headers = {

# User-Agent 用户代理 浏览器基本身份信息

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/101.0.0.0 Safari/537.36'

}

发送请求

调用requests模块里面get请求方法, 对于url地址发送请求, 并且携带上headers请求头伪装, 最后用自定义变量名response接受返回的数据

response = requests.get(url=url, headers=headers)

“”"

-

获取数据, 获取服务器返回响应数据

response 网页源代码

response.text 获取响应文本数据 <网页源代码>

-

解析数据, 提取我们想要的数据内容

- 图片ID

正则表达式Re

调用re模块里面findall方法 --> 找到所有我们想要的数据

re.findall(‘找什么数据’, ‘从哪里找’) --> 从什么地方, 去匹配找什么样的数据内容

从 response.text<网页源代码> 里面 去找 <a href=“/desk/(\d+).htm” 其中 (\d+) 就是我们要的内容

\d+ 表示任意数字

“”"

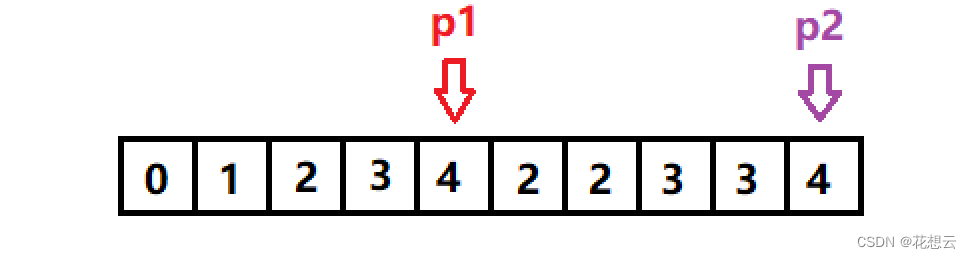

提取图片ID --> 列表 <盒子/箱子> ‘29381’ 是列表<箱子>里面元素<苹果>

img_id_list = re.findall('<a href="/desk/(\d+).htm"', response.text)

for循环遍历, 把列表里面元素 一个一个提取出来

for img_id in img_id_list:

# img_id变量<袋子> 给 img_id_list 列表<盒子> 里面 元素<苹果> 给装起来

print(img_id)

“”"

4. 发送请求, 模拟浏览器对于url地址发送请求

- 请求 图片详情页页面url http://www.****.com/desk/{图片ID}.htm

-

获取数据, 获取服务器返回响应数据

response 网页源代码

“”"

请求详情页链接 --> f’{img_id}’ 字符串格式化方法

link = f'http://www.*****.com/desk/{img_id}.htm'

发送请求

response_1 = requests.get(url=link, headers=headers)

获取数据内容 网页源代码 —> 乱码了, 进行转码

response_1.encoding = 'gbk'

- 解析数据, 提取我们想要的数据内容<图片链接/图片标题>

img_url, img_title = re.findall('<img src="(.*?)" alt="(.*?)"', response_1.text)[0]

- 保存数据 --> 先获取图片数据内容

img_content = requests.get(url=img_url, headers=headers).content

with open('img\\' + img_title + '.jpg', mode='wb') as f:

f.write(img_content)

print(img_url, img_title)

效果

尾语

感谢你观看我的文章呐~本次航班到这里就结束啦 🛬

希望本篇文章有对你带来帮助 🎉,有学习到一点知识~

躲起来的星星🍥也在努力发光,你也要努力加油(让我们一起努力叭)。

![[前端笔记] 1.WEB基本概念](https://img-blog.csdnimg.cn/82d7df4ff0b2451b9cb26c015f7ce2cb.png)