原文:Generative AI with LangChain

译者:飞龙

协议:CC BY-NC-SA 4.0

一、生成模型是什么?

人工智能(AI)取得了重大进展,影响着企业、社会和个人。在过去的十年左右,深度学习已经发展到可以处理和生成文本、图像、视频等非结构化数据。这些基于深度学习的先进 AI 模型在各行各业中备受青睐,包括大型语言模型(LLMs)。目前,媒体和行业对 AI 存在相当大的炒作。这是由多种因素驱动的,包括技术的进步、知名应用以及在多个领域产生变革性影响的潜力。在本章中,我们将讨论生成模型,特别是 LLMs,以及它们在文本、图像、声音和视频等领域的应用。我们将介绍一些技术背景,解释它们的工作原理以及它们是如何训练的。我们将从介绍开始,澄清我们在技术发展的最前沿所处的位置,以及炒作的原因。

为什么会有这样的炒作?

媒体广泛报道了与 AI 相关的突破性进展及其潜在影响。这些进展涵盖了从自然语言处理和计算机视觉的进步到像 GPT-3 这样的复杂语言模型的发展。媒体经常强调 AI 的能力以及其颠覆性潜力,例如在医疗保健、金融、交通等行业的革新。特别是,生成模型因其能够生成文本、图像和其他创意内容(往往难以与人类生成的内容区分开)而受到了广泛关注。这些模型还提供了广泛的功能,包括语义搜索、内容操作和分类。这可以通过自动化实现成本节约,并使人类能够以前所未有的水平发挥创造力。这张图表受到了 Stephen McAleese 在 LessWrong 上关于 GPT-4 预测的博文的启发,展示了 LLMs 在大规模多任务语言理解(MMLU)基准测试中的改进,该测试旨在量化基本数学、美国历史、计算机科学、法律等领域的知识和问题解决能力。

图 1.1:大型语言模型(LLM)在大规模多任务语言理解(MMLU)基准测试中的平均表现。请注意,大多数基准测试结果来自 5-shot,少数 GPT-2、PaLM 和 PaLM-2 的结果是指微调模型。

近年来在基准测试中可以看到进展。特别值得强调的是 OpenAI 通过公共用户界面提供的模型的进步,特别是从 GTP-2 到 GPT-3 再到 GPT-3.5 再到 GPT-4 的改进。这些模型最近才开始表现优于平均人类评分者,但仍未达到人类专家的水平。这些人类工程的成就令人印象深刻;然而,应该注意到这些模型的表现取决于领域;大多数模型在小学数学单词问题的 GSM8K 基准测试中仍表现不佳。

OpenAI是一个旨在推广和发展友好人工智能的美国人工智能研究实验室。它成立于 2015 年,得到了几位有影响力的人物和公司的支持,他们承诺向这个项目投资超过 10 亿美元。该组织最初致力于非营利性,通过向公众开放其专利和研究成果与其他机构和研究人员合作。2018 年,埃隆·马斯克因担心与特斯拉的角色存在潜在利益冲突而辞去了董事会职务。2019 年,OpenAI 转变为营利性组织,随后微软对 OpenAI 进行了重大投资,导致 OpenAI 系统与微软基于 Azure 的超级计算平台以及必应搜索引擎的整合。该公司最重要的成就包括用于训练强化学习算法的 OpenAI Gym,以及最近推出的 GPT-n 模型和 DALL-E,另一个能够从文本生成图像的深度学习模型。

生成式预训练变换器(GPT)模型,如最近推出的 OpenAI 的 ChatGPT,是 LLM 领域人工智能进步的典范。ChatGPT 通过在更大规模上训练并比以往模型更大,极大地提升了聊天机器人的能力。这些基于人工智能的聊天机器人可以生成类似人类的实时反馈给客户,并可应用于从软件开发和测试到诗歌和商业沟通等各种用例。在行业内,人们对人工智能的能力和其对业务运营的潜在影响感到越来越兴奋。我们将在第十章,生成模型的未来中更详细地探讨这一点。随着 OpenAI 的 GPT 等人工智能模型的不断改进,它们可能成为需要多样知识和技能的团队不可或缺的资产。例如,GPT-4 可以被视为一个“博学多才”的人工智能,可以在不要求报酬(除了订阅或 API 费用)的情况下不知疲倦地工作,在数学、语言、统计学、宏观经济学、生物学甚至通过司法考试等学科提供帮助。随着这些人工智能模型变得更加熟练和易于访问,它们可能在塑造未来工作和学习方面发挥重要作用。通过使知识更易获取和适应,这些模型有潜力拉平竞争场地,为来自各行各业的人们创造新机会。这些模型在需要更高层次推理和理解的领域显示出潜力,尽管进展因所涉及任务的复杂性而有所不同。至于具有图像的生成模型,我们可以期待具有更好能力的模型协助创建视觉内容,并可能改进计算机视觉任务,如目标检测、分割、字幕等等。让我们更清晰地澄清术语,并更详细地解释生成模型、人工智能、深度学习和机器学习的含义。

生成模型是什么?

在媒体上,当提到这些新模型时,经常使用术语人工智能。值得更清楚地区分一下生成模型这个术语与人工智能、深度学习、机器学习和语言模型的区别:

-

人工智能(AI)是计算机科学的一个广泛领域,涉及创建智能代理的系统,这些系统可以自主推理、学习和行动。

-

机器学习(ML)是人工智能的一个子集,涉及开发能够从数据中学习的算法。机器学习算法在一组数据上进行训练,然后可以使用该数据进行预测或决策。

-

深度学习(DL)是机器学习的一个子集,它使用人工神经网络从数据中学习。神经网络受人脑启发,能够从数据中学习复杂模式。

-

生成模型是一种可以生成新数据的 ML 模型。生成模型在一组数据上进行训练,然后它们可以利用该数据创建类似于训练数据的新数据。

-

语言模型是预测序列中的标记(通常是单词)的统计模型。其中一些模型,能够执行更复杂的任务,包含许多参数(数量达到数十亿甚至数万亿),因此被称为大型语言模型。

生成模型与其他类型的 ML 模型的主要区别在于,生成模型不仅仅是做出预测或决策。它们实际上可以创建新数据。这使得生成模型非常强大,可以用于各种任务,如生成图像,文本,音乐和视频。以下是总结 AI,ML,DL,语言模型和生成模型之间区别的表格:

| 术语 | 定义 |

|---|---|

| 人工智能 | 一门涉及智能代理创建的计算机科学广泛领域。 |

| 机器学习 | 处理可以从数据中学习的算法开发的 AI 的一个子集。 |

| 深度学习 | 使用人工神经网络从数据中学习的 ML 的一个子集。 |

| 生成模型 | 一种可以生成新数据的 ML 模型。 |

| 语言模型 | 一种模型,现在主要是深度学习模型,可以预测上下文中的标记。 |

图 1.2:术语 - 人工智能,机器学习,深度学习和生成模型。生成模型是一种强大的 AI 类型,可以生成类似于训练数据的新数据样本。生成 AI 模型已经取得了长足的进步,通过数据中的模式生成新的示例。这些模型可以处理不同类型的数据,并在各个领域中使用,包括文本生成,图像生成,音乐生成和视频生成。对于语言模型,重要的是要注意,其中一些模型,特别是新一代的模型,是生成型的,可以生成语言(文本),而其他模型则不是。这些生成模型有助于创建合成数据来训练 AI 模型,当真实数据稀缺或受限时。这种数据生成方式降低了标记成本并提高了训练效率。微软研究采用了这种方法(“只需教科书”,2023 年 6 月)来训练他们的 phi-1 模型,他们使用 GPT-3.5 创建了合成教科书和练习作为他们的训练数据集。在接下来的章节中,我们将探讨生成模型的不同领域,如文本,图像,声音,视频。这些应用主要围绕内容生成,编辑和处理(识别)。让我们从文本开始!

文本

文本生成,例如 OpenAI 的 GPT-4,可以生成连贯和语法正确的诗歌,或者用不同语言编写代码并提取关键词和主题等特征。这些模型在内容创作和自然语言处理(NLP)等领域具有实际应用,其最终目标是创建能够解释人类语言的算法。语言建模旨在根据序列中的前一个词、字符甚至句子来预测下一个词。在这个意义上,语言建模作为一种将语言的规则和结构编码成机器可理解的方式。大型语言模型捕捉了人类语言的语法、句法和语义结构。这些模型很重要,因为它们构成了许多更大的 NLP 任务的基础,如内容创作、翻译、摘要、机器翻译和文本编辑任务,如拼写纠正。在其核心,语言建模,以及更广泛的自然语言处理,严重依赖于表示学习的质量。一个训练良好的语言模型对其训练的文本编码信息,并根据这些学习生成新文本,从而承担文本生成的任务。最近,大型语言模型已经应用于文章生成、代码开发、翻译和理解基因序列等任务。语言模型的更广泛应用涉及多个领域,例如:

-

问答系统:AI 聊天机器人和虚拟助手可以提供个性化和高效的帮助,减少客户支持中的响应时间,从而增强客户体验。这些系统可用于解决特定问题,如餐厅预订和购票。

-

自动摘要:语言模型可以创建文章、研究论文和其他内容的简洁摘要,使用户能够快速消化和理解信息。

-

情感分析:通过分析文本中的意见和情感,语言模型可以帮助企业更有效地理解客户反馈和意见。

-

主题建模和语义搜索:这些模型可以识别、按主题分类和压缩文档为简洁向量,使组织更容易进行内容管理和发现。

-

机器翻译:由人工智能驱动的语言模型可以将一种语言的文本翻译成另一种语言,支持企业在全球扩张努力中。新的生成模型可以与商业产品(例如谷歌翻译)竞争。

尽管取得了显著的成就,语言模型在处理复杂的数学或逻辑推理任务时仍面临限制。目前尚不清楚不断增加语言模型规模是否必然会导致新的推理能力。正如前文所述,我们还必须考虑数据质量和规模的重要性,因为这些因素在改善语言模型在不同任务和领域中的性能方面起着重要作用。生成模型的另一个领域是图像生成,让我们看看这是怎么回事!

图像

生成人工智能广泛用于生成 3D 图像、头像、视频、图表、虚拟或增强现实中的插图、视频游戏图形设计、标志创建、图像编辑或增强。这张图展示了从具有稳定扩散的文本提示生成图像(来源:“改进生成过程的重新启动采样”作者为 Yilun Xu 等人,来自麻省理工学院和谷歌研究,2023 年 6 月;https://arxiv.org/pdf/2306.14878.pdf):

图 1.3:从文本提示“由玻璃制成的透明鸭子雕塑”生成图像。

使用稳定扩散模型,您可以看到仅通过对模型的初始设置进行最小更改或者 - 如本例中 - 数值求解器和采样器,就可以看到各种各样的结果。尽管它们有时会产生引人注目的结果,但这种不稳定性和不一致性是将这些模型更广泛应用的重要挑战。像MidJourney、DALL-E 2和Stable Diffusion这样的服务提供了从文本输入或其他图像派生的创意和逼真图像。像DreamFusion、Magic3D和Get3D这样的服务使用户能够将文本描述转换为 3D 模型和场景,推动设计、游戏和虚拟体验的创新。主要有三个应用场景:

-

图像生成:模型可以生成各种图像,如绘画、照片和草图。这可以用于各种目的,如创作艺术、设计产品和生成逼真的视觉效果。

-

图像编辑:模型可以执行诸如移除对象、更改颜色和添加效果等任务。这可以用于提高图像质量,并使其更具视觉吸引力。

-

图像识别:大型基础模型可用于识别图像,包括场景分类,还有物体检测,例如检测人脸。

像生成对抗网络(GANs)和 DALL-E 这样的模型。GANs 生成逼真的图像,具有许多商业应用,而 DALL-E 则根据文本描述创建图像,对于设计广告、产品和时尚等创意产业非常有帮助。图像编辑涉及通过改变内容或样式属性来修改图像的语义,使用面部属性编辑或图像变形等技术。基于优化和学习的方法通过使用预训练的 GAN 模型(如 StyleGAN)的潜在表示生成具有风格的图像。扩散模型最近被用于高级图像编辑任务,例如通过文本引导无缝连接手动设计的遮罩区域或生成 3D 对象操作。这些技术实现了灵活的图像生成,但面临着有限多样性问题,可以通过将其他文本输入纳入过程中来缓解。图像编辑的范畴还包括图像恢复等任务,这意味着从受损版本中恢复清晰图像,包括图像超分辨率、修补、去噪、去雾和去模糊等任务。基于深度学习的方法使用 CNN 和 transformer 架构,由于与传统方法相比具有更优越的视觉质量。生成模型如 GANs 和扩散模型(DMs)用于恢复,但可能遭受复杂的训练过程和模式崩溃。多扭曲数据集和具有注意力模块或引导子网络的单网络方法提高了处理多种退化类型的效果。接下来我们将看看模型可以如何处理声音和音乐。

声音和音乐

生成模型可以根据文本输入开发歌曲和音频剪辑,识别视频中的物体并创建相应的音频,以及创作定制音乐。我们可以粗略地将应用程序再次分类为生成、编辑和识别:

-

音乐生成:生成模型可用于生成音乐,如歌曲、节拍和旋律。这可以用于各种目的,如创作新音乐、谱写配乐和生成个性化播放列表。

-

声音编辑:生成模型可用于编辑声音,如消除噪音、改变音调和添加效果。这可以用于提高声音质量,并使其在听觉上更具吸引力。

-

声音识别:生成模型可用于识别声音,如识别乐器、分类流派和检测语音。这可以用于各种目的,如音乐分析、搜索和推荐系统。

音乐生成算法始于 20 世纪 50 年代的算法作曲,并见证了像谷歌的 WaveNet 和 OpenAI 的 Jukebox 这样的最新创新。这些模型导致了 AI 作曲助手的出现,可以以各种风格生成音乐,并实现新的应用,如语音合成。作��一个特例,语音到文本生成,也称为自动语音识别(ASR),是将口语转换为文本的过程。它们是在声音和文本上进行训练的。ASR 系统变得越来越准确,现在被广泛应用于各种应用中。然而,仍然存在一些需要解决的挑战,比如处理嘈杂环境和不同口音的能力。随着许多潜在应用,如语音拨号和像 Alexa 和 Siri 这样的计算机辅助个人助手,ASR 背后的技术从马尔可夫模型发展到依赖于 GPT。接下来我们将看到视频。

视频

视频生成模型,如DeepMind的 Motion to Video 和NVIDIA的Vid2Vid依赖于GANs进行高质量视频合成。它们可以在不同领域之间转换视频,修改现有视频,并使静态图像动画化,展示了视频编辑和媒体制作的巨大潜力。像 Make-a-Video 和 Imagen Video 这样的工具将自然语言提示转换为视频片段,简化了视频制作和内容创作过程。这些应用的广泛类别是:

-

视频生成:生成模型可以用于生成视频,如短片、动画和广告。这可以用于创作新内容、广告产品和生成逼真的视觉效果。

-

视频编辑:我们可以编辑视频,如移除物体、更改颜色和添加效果。这可以帮助提高视频质量,并使其更具视觉吸引力。

-

视频识别:模型可以识别视频,如识别物体、分类场景和检测人脸。这可以帮助应用于安全、搜索和推荐系统等领域。

一些模型可以在多个领域或模态中生成内容。这些被称为多模型。

多模

多模生成模型可以生成文本、图像、声音和视频。这使它们能够创造更加逼真和沉浸式的体验。多模型仍处于发展的早期阶段,但它们有潜力彻底改变我们与计算机互动和体验世界的方式。例如,这些进展显著提高了图像字幕任务的性能,即通过自然语言描述图像内容的过程。多模型采用融合图像和字幕的生成架构,形成一个共享学习空间的单一模型。这个过程涉及两步编码器-解码器架构:视觉编码和语言解码。我们可以区分这些潜在的用例:

-

虚拟现实:这些模型可以用来创建更加逼真和沉浸式的虚拟现实体验。这对于游戏、教育和培训都有帮助。

-

增强现实:它们可以创建增强现实体验,将数字内容叠加在现实世界上。这对于导航、购物和娱乐都是有用的。

在接下来的部分,我们将讨论大型语言模型的技术背景。

什么是 GPT?

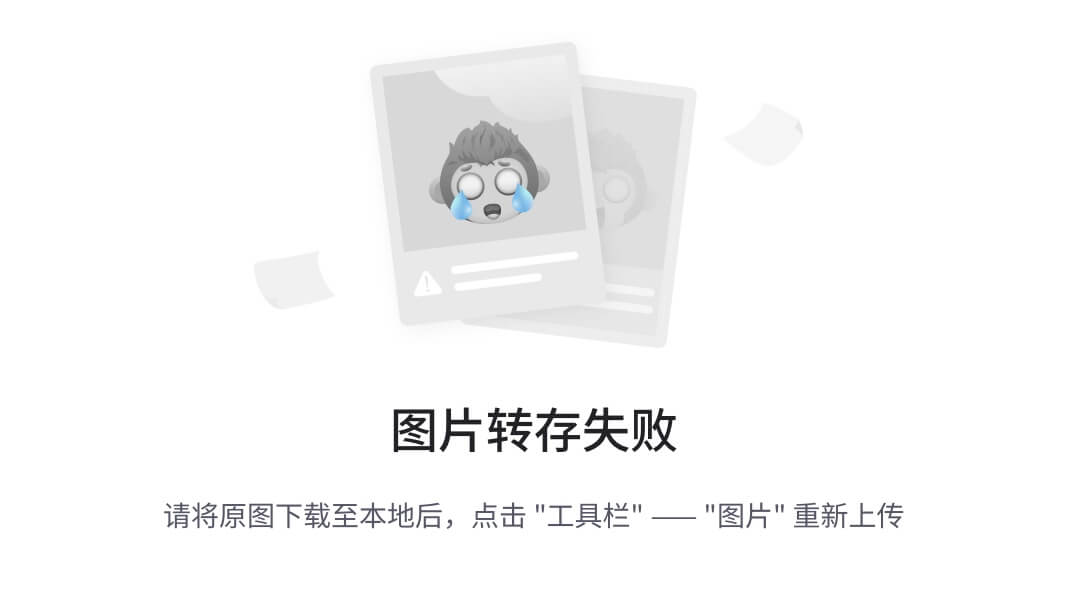

大型语言模型(LLMs)是深度训练的神经网络,擅长理解和生成人类语言。当前一代的 LLMs,如 ChatGPT,是利用 Transformer 模型的深度神经网络架构,在广泛的文本数据上进行无监督学习的预训练,使其能够学习语言模式和结构。最新一代 LLMs 的显著优势在于作为对话接口(ChatBot)时,能够生成连贯和上下文适当的回应,即使在开放式对话中也是如此。通过基于前面的单词生成下一个单词,该模型经常产生流畅和连贯的文本,往往难以与人类产生的文本区分开。然而,OpenAI 在免责声明中表达了 ChatGPT“有时会写出听起来合理但不正确或荒谬的答案”的观察。这被称为幻觉,这只是围绕 LLMs 的关注之一。Transformer是一种深度学习架构,于 2017 年首次由谷歌和多伦多大学的研究人员引入(在一篇名为“注意力机制是你所需要的一切”的文章中),它包括自注意力和前馈神经网络,使其能够有效地捕捉句子中的单词关系。注意机制使模型能够专注于输入序列的不同部分。生成式预训练变换器(GPTs)是由 OpenAI 的研究人员于 2018 年推出的,与他们的首个同名 GPT 模型 GPT-1 一起发布,并发表为“通过生成式预训练改进语言理解”。预训练过程涉及预测文本序列中的下一个单词,增强模型对语言的理解,这可以通过输出质量来衡量。在预训练之后,模型可以针对特定的语言处理任务进行微调,如情感分析、语言翻译或聊天。无监督和监督学习的结合使 GPT 模型在各种 NLP 任务中表现更好,并减少了训练 LLMs 所面临的挑战。LLMs 的训练语料库规模急剧增加。OpenAI 于 2018 年推出的 GPT-1 是在包含 985 百万个单词的 BookCorpus 上进行训练的。BERT 在同一年发布,是在BookCorpus和英文维基百科的合并语料库上进行训练的,总计33 亿个单词。现在,LLMs 的训练语料库已经扩展到数万亿个标记。这张图说明了 LLMs 的规模一直在不断增长:

图 1.4:从 BERT 到 GPT-4 的大型语言模型 - 大小、训练预算和组织。

数据点的大小表示以 petaFLOP 天为单位的训练成本。对于一些模型,特别是专有和闭源模型,这些信息是未知的 - 在这些情况下,我放了一个叉。例如,对于 XLNet,论文没有提供有关 flops 计算的信息,然而,训练是在 512 个 TPU v3 芯片上进行的,历时 2.5 天。数据点的颜色显示了开发模型的公司或组织 - 由于这些颜色可能在打印版或 Kindle 上不明显(除非您有一款彩色 Kindle),您可以在此 URL 找到此图的彩色版本:GPT 模型的发展取得了显著进展,OpenAI 的 GPT-n 系列引领着创建基础 AI 模型的道路。LLM 的训练语料库规模急剧增加。OpenAI 于 2018 年推出的 GPT-1 是在包含 985 百万个单词的 BookCorpus 上进行训练的。BERT 于同一年发布,是在 BookCorpus 和英文维基百科的合并语料库上进行训练的,总计 33 亿个单词。现在,LLM 的训练语料库已经扩展到数万亿个标记。

基础模型(有时称为基础模型)是一个大型模型,它在规模上经过大量数据的训练,以便可以适应各种下游任务。在 GPT 模型中,这种预训练是通过自监督学习完成的。

经过对 3000 亿标记的训练,GPT-3拥有1750 亿参数,这是深度学习模型中前所未有的规模。GPT-4是该系列中最新的版本,尽管由于竞争和安全问题,其规模和训练细节尚未公布,但不同的估计将其参数放在200 到 5000 亿之间。Sam Altman,OpenAI 的首席执行官表示,训练GPT-4的成本超过了 1 亿美元。ChatGPT 是一个对话模型,由OpenAI于 2022 年 11 月发布。基于之前的GPT模型(特别是GPT-3)并针对对话进行了优化,它使用人类生成的角色扮演对话和人类标记者演示所需模型行为的数据集。该模型展示了出色的能力,如广泛的知识保留和在多轮对话中精确的上下文跟踪。另一个重大进展是GPT-4,于 2023 年 3 月推出,它不仅限于文本输入,还包括多模态信号。GPT-4在各种评估任务上表现出优越的性能,同时由于训练期间六个月的迭代对齐,对恶意或挑衅性查询的响应避免能力显著提高。除 OpenAI 之外,其他值得注意的基础 GPT 模型还包括谷歌的PaLM2。尽管GPT-4在性能方面领先大多数基准测试,但这些和其他模型在某些任务中表现出可比较的性能,并促进了基于生成变压器的语言模型的进步。Meta 的LLaMA训练了1.4 万亿标记,而谷歌聊天机器人Bard背后的模型PaLM2由3400 亿参数组成,比以前的 LLM 规模小,但在至少 100 种语言的训练数据上似乎具有更大的规模。

有相当多的公司和组织正在开发 LLM,并以不同的条件发布它们。OpenAI 发布了 GPT-2,随后的模型是闭源的,但可以通过他们的网站或 API 使用。Meta 发布了从 RoBERTa、BART 到 LLaMA 的模型,包括模型的参数(权重),尽管在非商业许可下,以及用于设置和训练模型的源代码。Google AI 及其 DeepMind 部门开发了许多大型语言模型,包括 BERT、GPT-2、LaMDA、Chinchilla、Gopher、PaLM 和 PaLM2。他们已经在开源许可下发布了一些模型的代码和权重,尽管最近他们在开发中更趋向于保密。微软开发了许多大型语言模型,包括 Turing NLG 和 Megatron-Turing NLG,但他们已将 OpenAI 模型整合到 Microsoft 365 和必应中。阿布扎比政府资助的科技创新研究所(TII)已经为研究和商业用途开源了 Falcon LLM。

GPT 模型还可以处理文本以外的输入和输出形式,正如 GPT-4 能够处理图像输入和文本一样。此外,它们还为文本到图像技术(如扩散和并行解码)奠定了基础,从而实现了与图像一起工作的视觉基础模型(VFMs)的发展。总之,GPT 模型发展迅速,为创建适用于各种下游任务和形式的多功能基础人工智能模型奠定了基础,最终推动了各种应用和行业的创新。在接下来的部分中,我们将回顾深度学习和生成模型近年来取得的进展,这些进展导致了明显能力的爆炸性增长以及这些模型所受到的关注。

为什么现在?

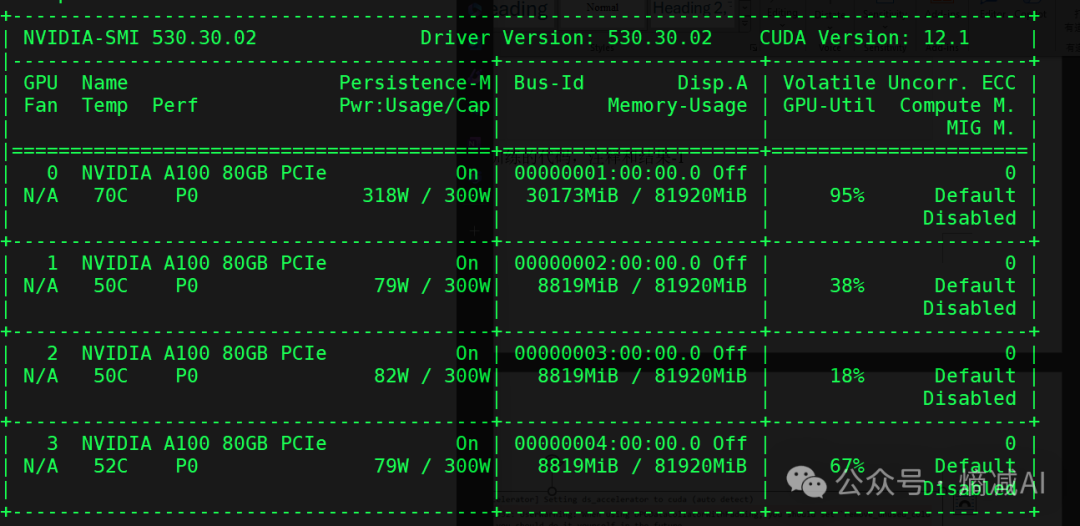

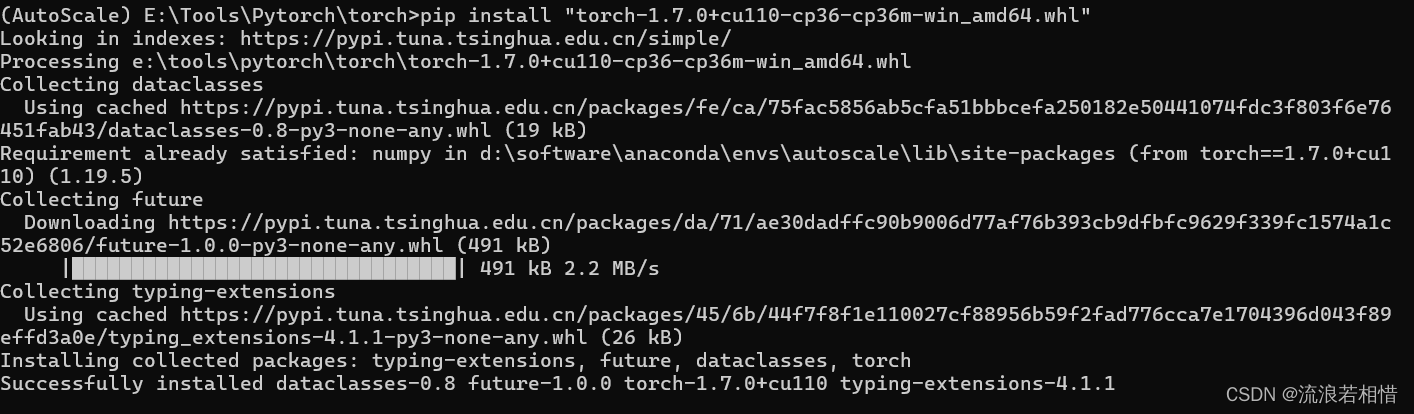

2022 年生成式人工智能成功进入公众视野的原因可以归因于几个相互关联的推动因素。生成模型的发展和成功依赖于改进的算法、计算能力和硬件设计的显著进步、大规模标记数据集的可用性,以及积极合作的研究社区帮助发展一套工具和技术。更复杂的数学和计算方法的发展在生成模型的进步中发挥了至关重要的作用。上世纪 80 年代由杰弗里·辛顿、大卫·鲁梅尔哈特和罗纳德·威廉姆斯引入的反向传播算法就是一个例子。它提供了一种有效训练多层神经网络的方法。在 21 世纪初,神经网络开始重新流行,研究人员开发了更复杂的架构。然而,深度学习的出现,一种具有众多层的神经网络,标志着这些模型性能和能力的重大转折点。有趣的是,尽管深度学习的概念已存在一段时间,但生成模型的发展和扩展与硬件的显著进步相关,特别是图形处理单元(GPU),这些硬件在推动该领域向前发展方面起到了关键作用。正如前面提到的,更便宜和更强大的硬件的可用性是发展更深层模型的关键因素。这是因为深度学习模型需要大量的计算能力来训练和运行。这涉及到处理能力、内存和磁盘空间的所有方面。这张图显示了随着时间推移,不同介质(如磁盘、固态、闪存和内存)的计算机存储成本,以每 TB 美元的价格计算(来源:Our World in Data;ourworldindata.org/moores-law):

图 1.5:自 1950 年代以来每 TB 的计算机存储成本。

过去,训练深度学习模型的成本非常昂贵,但随着硬件成本的降低,现在可以在更大的数据集上训练更大的模型。模型大小是决定模型能够多好地逼近(以困惑度衡量)训练数据集的因素之一。

LLM 中参数数量的重要性:模型的参数越多,其捕捉单词和短语之间关系的能力就越强。举个简单的例子来说明这些高阶相关性,LLM 可以学习到单词“猫”如果前面是“追逐”这个词,那么后面更可能是“狗”,即使中间有其他词。一般来说,模型的困惑度越低,它的表现就越好,比如在回答问题方面。特别是,在由 20 亿到 70 亿参数组成的模型中,似乎会出现新的能力,比如生成不同的创意文本格式,如诗歌、代码、脚本、音乐作品、电子邮件、信件,并以信息丰富的方式回答问题,即使这些问题是开放性和具有挑战性的。

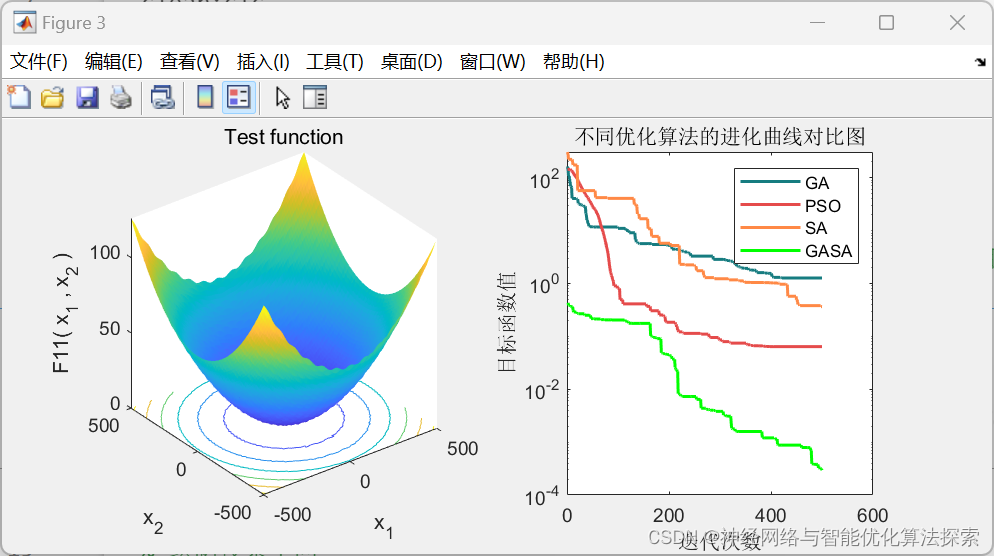

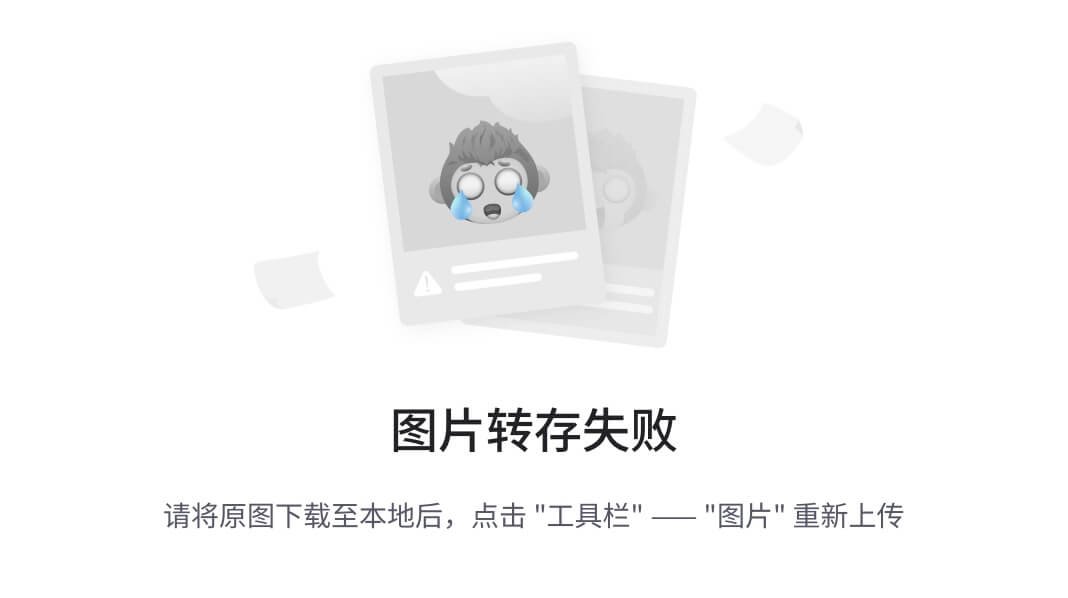

这种朝着更大模型的趋势始于 2009 年,当 Nvidia 推动了深度学习的“大爆炸”。GPU 特别适合进行训练深度学习神经网络所需的矩阵/向量计算,因此显著提高了这些系统的速度和效率,将运行时间从几周缩短到几天。特别是,Nvidia 的CUDA平台允许直接编程 GPU,使研究人员和开发人员可以更轻松地尝试和部署复杂的生成模型。在 2010 年代,不同类型的生成模型开始受到关注。自编码器是一种可以学习将数据从输入层压缩到表示层,然后重构输入的神经网络,为更高级的模型如 2013 年首次提出的变分自编码器(VAEs)奠定了基础。VAEs与传统自编码器不同,它使用变分推断来学习数据的分布,也称为输入数据的潜在空间。与此同时,生成对抗网络(GANs)在 2014 年由 Ian Goodfellow 等人提出。训练 GANs 的设置如下图所示(摘自“使用生成对抗网络进行文本生成的调查”,G de Rosa 和 J P. Papa,2022 年;arxiv.org/pdf/2212.11119.pdf):

图 1.6:生成对抗网络(GAN)训练。

GANs 由两个网络组成,在类似游戏的设置中相互对抗 - 生成器生成新数据,通常是图像,鉴别器估计新数据为真实数据的概率。随着它们相互竞争,GANs 在任务中变得更加优秀,能够生成逼真的图像和其他类型的数据。在过去的十年中,深度学习中使用的基本算法取得了重大进展,如更好的优化方法,更复杂的模型架构和改进的正则化技术。Transformer 模型于 2017 年推出,建立在这一进展的基础上,实现了像 GPT-3 这样的大规模模型的创建。Transformers 依赖于注意力机制,并导致生成模型性能的进一步飞跃。这些模型,如谷歌的 BERT 和 OpenAI 的 GPT 系列,可以生成高度连贯和上下文相关的文本。迁移学习技术的发展也是显著的,它允许在一个任务上预训练的模型在另一个类似任务上进行微调,这些技术使训练大型生成模型更加高效和实用。此外,生成模型的崛起部分归因于专门设计用于处理这些人工神经网络的软件库和工具(TensorFlow,PyTorch,Keras),简化了构建、训练和部署它们的过程。为了进一步推动生成模型的发展,研究界定期举办像 ImageNet 这样的图像分类挑战赛,并已开始为生成模型做同样的事情,如生成对抗网络(GAN)竞赛。除了更便宜和更强大的硬件的可用性外,标记数据的大型数据集的可用性也是生成模型发展的关键因素。这是因为深度学习模型,特别是生成模型,需要大量的文本数据进行有效训练。互联网上数据的爆炸性增长,尤其是在过去的十年中,为这些模型蓬勃发展创造了适当的环境。随着互联网的普及,收集大量文本、图像和其他数据集变得更加容易。这使得在比过去可能的更大数据集上训练生成模型成为可能。总之,生成建模是一个迷人且快速发展的领域。它有潜力彻底改变我们与计算机的互动方式以及我们创造新内容的方式。我很期待看到这个领域的未来。让我们深入了解细节 - 这是如何工作的?

这是如何工作的?

诸如 BERT 和 GPT 之类的模型得以实现,得益于Transformer深度神经网络架构,这对自然语言处理产生了深远影响。Transformer 架构旨在避免递归,以允许并行计算,不同变体的 Transformer 架构不断推动自然语言处理和生成式人工智能领域的可能性边界。Transformer 的一个显著特征是注意力机制。传统的序列到序列模型经常面临处理长依赖性的问题 - 如果序列过长,它们很难记住相关信息。Transformer 模型引入了注意力机制来解决这个问题。自注意力机制,通常被称为 Transformer 模型的核心,为序列中的每个单词分配一个分数,确定应该给予该单词多少关注。Transformer 由可以堆叠的模块组成,从而创建可以学习大规模数据集的非常大的模型。这些在这里的图表中指示出来:

图 1.7:Transformer 架构(来源:Yuening Jia,Wikimedia Commons)

促成 Transformer 成功的架构特征:

-

编码器-解码器结构:Transformer 模型遵循编码器-解码器结构。编码器接受输入序列并为每个单词计算一系列表示(上下文嵌入)。这些表示不仅考虑单词的固有含义(语义值),还考虑它们在序列中的上下文。解码器然后使用这些编码信息逐个生成输出序列项,利用先前生成项的上下文。

-

位置编码:由于 Transformer 不是按顺序处理单词,而是同时处理所有单词,它缺乏单词顺序的概念。为了弥补这一点,将单词在序列中的位置信息通过位置编码注入模型中。这些编码被添加到表示每个单词的输入嵌入中,从而使模型能够考虑序列中单词的顺序。

-

层归一化:为了稳定网络的学习,Transformer 使用一种称为层归一化的技术。这种技术在特征维度上对模型的输入进行归一化(而不是批量维度,如批量归一化),从而提高了学习的整体速度和稳定性。

-

多头注意力:Transformer 不是一次应用注意力,而是并行多次应用注意力 - 提高了模型关注不同类型信息的能力,从而捕捉到更丰富的特征组合。

另一个可选的架构特性,不特定于变压器的是跳跃连接(也称为残差连接)。这些被引入以减轻网络变得更深时的退化问题,使用了跳跃连接。这允许梯度在层间不变地流动,通过将输入直接传递给更深的层。变压器在自然语言处理中推动了 NLP 的发展,特别是在翻译和语言理解方面。神经机器翻译(NMT)是一种使用深度学习捕捉句子中长距离依赖关系的机器翻译主流方法。基于变压器的NMT优于以往的方法,如使用循环神经网络,特别是长短期记忆(LSTM)网络。这可以归因于这种强大的架构,首先是注意力,它允许变压器模型以灵活的方式处理单词顺序,无论它们之间有多远,这对每种特定情况都是最佳的。此外,这些架构特性的组合使其能够成功处理涉及理解和生成人类语言以及其他领域的任务。OpenAI 强大的用于语言生成的 GPT 模型也是一个变压器,同样,DeepMind 的 AlphaFold 2 是一个从基因序列预测蛋白质结构的模型。变压器能够比其他模型更好地在较长序列上保持性能,例如循环神经网络。这一直是它们成功的原因,然而,变压器架构意味着它们只能捕捉固定输入宽度内的依赖关系。早期的注意力机制随着数据点数量的平方级增长,使其在具有大量输入的情况下无法应用。已经提出了许多方法来获得效率提升,例如稀疏的、低秩的自注意力和潜在的瓶颈,仅举几例。其他工作尝试扩展超出固定输入大小的序列,如 Transformer-XL 架构通过存储已编码句子的隐藏状态来重新引入递归,以便在后续编码下一个句子时利用它们。GPT 的特殊之处及其名称的起源在于预训练。让我们看看这些 LLM 是如何训练的!

预训练

训练大型语言模型(LLM)的第一步是进行标记化。这个过程涉及将单词转换为数字,以便模型可以处理它们,因为LLMs是需要数字输入和输出的数学函数。为了进行这种标记化,LLMs使用独特的标记器。标记器将文本中的单词映射到相应的整数列表。在训练LLM之前,标记器通常会适应整个训练数据集,然后被冻结。常用的标记器类型是字节对编码。需要注意的是,标记器不会产生任意整数。相反,它们输出特定范围内的整数 - 从到,其中表示标记器的词汇量。现在,考虑输出,当 LLM 接收到文本时,主要产生一个落在的向量。然后,将该输出向量通过 softmax 函数传递,产生另一个向量,称为概率向量。由于其条目为非负且总和为,这个向量可以被解释为LLM词汇的概率分布。此外,需要指出LLMs只能基于不超过其上下文窗口的一系列标记生成标记。这个上下文窗口指的是LLM可以使用的最长标记序列的长度。如果提供了比这个窗口更长的序列,LLM需要截断序列或使用算法修改来处理它。LLMs的典型上下文窗口大小可以在大约 1,000 到 10,000 个标记之间。训练LLMs涉及特定的过程,将输入数据标记化,馈送到模型中,并生成一个概率分布,覆盖模型的词汇。这个过程中的具体机制,如 softmax 函数和上下文窗口,有助于促进LLMs对输入数据的理解和响应。负对数似然(NLL)和困惑度(PPL)是在训练和评估语言模型过程中使用的重要指标。NLL是机器学习算法中使用的损失函数,旨在最大化正确预测的概率。较低的NLL表示网络已成功从训练集中学习到模式,因此它将能够准确预测训练样本的标签。需要提到NLL是一个在正区间内约束的值。另一方面,困惑度(PPL)是NLL的指数,提供了更直观地理解模型性能的方式。较小的PPL值表示训练良好的网络可以准确预测,而较高的值表示学习性能差。直观地说,我们可以说低困惑度意味着模型对下一个词不太惊讶。因此,在预训练中的目标是最小化困惑度,这意味着模型的预测更符合实际结果。在比较不同的语言模型时,困惑度通常被用作各种任务的基准指标。它提供了关于语言模型表现如何的想法,较低的困惑度表示模型对其预测更有把握。因此,与困惑度较高的其他模型相比,困惑度较低的模型将被认为表现更好。

缩放

至少简要讨论架构的选择以及为什么这些模型如此庞大是值得的。在 2020 年的一篇来自 OpenAI 的研究人员 Kaplan 等人的论文中,他们讨论了缩放定律和参数选择。有趣的是,他们比较了许多不同的架构选择,并且在其他方面表明,变压器在很大程度上由于更好地利用长上下文而优于LSTMs作为语言模型,而这些循环网络在不到 100 个标记后就达到了平稳状态,而变压器则通过整个上下文改进。因此,变压器不仅在训练和推理速度上比变压器更好,而且在查看相关上下文时也表现更好。此外,他们发现数据集大小、模型大小(参数数量)和训练计算量之间存在幂律关系,换句话说,为了将性能提高一定因子,其中一个因素必须按照该因子的幂进行扩展,然而,为了获得最佳性能,这三个因素必须同时扩展,以避免出现瓶颈效应。DeepMind 的研究人员(Hoffmann 等人,2022 年)分析了LLMs的训练计算量和数据集大小,并得出结论,根据缩放定律,LLMs在计算预算和数据集大小方面训练不足。他们预测,如果大型模型比现在大大缩小并且训练时间更长,大型模型将表现更好,并且事实上,通过将70 亿参数的 Chinchilla 模型与他们的 Gopher 模型(包含2800 亿参数)在基准测试中进行比较,他们验证了他们的预测。最近,该团队发现,以更多的纪元进行更长时间的训练或以更多的 petaflops 进行更多的计算似乎不再改善性能,而较小的网络和更高质量的数据集可以提供非常有竞争力的性能。

条件化

对大型语言模型进行条件化是指为特定任务调整模型。不同的条件化方法包括微调、提示、指令调整和强化学习:

-

微调涉及通过监督学习在特定任务上训练预训练的语言模型。例如,为了使模型更适合与人类对话,模型会在自然语言指令形式的任务示例上进行训练(指令调整)。

-

提示技术将问题呈现为文本提示,并期望模型完成。

对于微调,通常,强化学习将监督微调与使用人类反馈的强化学习相结合,根据人类偏好训练模型。LLMs 可以在一个由 LLM 生成的示例训练集上进行训练(从一小部分人类生成的初始示例引导),例如 Microsoft Research 的 phi-1 的训练集(“只需教科书”,2023 年 6 月)。通过提示技术,将呈现类似问题及其解决方案的文本示例。零-shot 提示涉及没有解决的示例,而少量-shot 提示包括少量类似(问题,解决方案)对的示例。这些调节方法不断发展,变得更加有效,对各种应用非常有用。第八章 提示工程将进一步探讨提示工程和调节方法。

如何尝试一下?

你可以通过他们的网站或 API 访问 OpenAI 的模型。如果你想在笔记本电脑上尝试其他大型语言模型,开源 LLMs 是一个很好的起点。这里有一大堆东西!你可以通过 Hugginface 或其他提供商访问这些模型。你甚至可以下载它们,微调它们,或者 - 如果你感觉很高级 - 完全训练一个模型。我们将在第九章 LLM 在生产中的应用中更详细地讨论如何使用这些模型。在下一节中,我们将看看稳定扩散以及它是如何工作的。

什么是稳定扩散模型?

图像生成模型是一种生成模型,可用于生成图像。图像生成模型是一个强大的工具,可用于生成逼真和创意的图像。它们仍处于早期开发阶段,但有潜力彻底改变我们创建和消费图像的方式。最受欢迎的图像生成模型之一是稳定扩散,另一个是Midjourney。简单来说,这些是一种深度学习模型,根据文本提示创建图像。Google Brain 在 2022 年宣布了两个文本到图像模型的创建,Imagen和Parti。

它是如何工作的?

稳定扩散模型是由慕尼黑路德维希·马克西米利安大学的计算机视觉组和 Runway 的研究人员开发的一种深度学习文本到图像模型。它生成根据文本描述条件的详细图像,并利用潜在扩散模型架构。该模型的源代码甚至权重已经在CreativeML OpenRAIL-M 许可证下公开发布,该许可证“不对重用、分发、商业化、适应性施加任何限制”。该模型可以在配备适度 GPU 的消费者硬件上运行(例如GeForce 40系列)。稳定扩散是一种使用 Gumbel 分布向图像添加噪声的扩散模型。Gumbel 分布是一种连续概率分布,通常在机器学习中使用,因为它易于抽样,并且具有更稳定的特性。稳定性意味着模型不太可能陷入局部最小值,这可能会发生在其他类型的扩散模型中。该模型由变分自动编码器(VAE)、U-Net和文本编码器组成。VAE有两部分,编码器和解码器,将原始高维图像压缩成较低维的潜在空间,并将其重构回图像空间。潜在空间显著降低了计算复杂性,使扩散过程更快。VAE编码器将图像压缩到潜在空间,而U-Net通过前向扩散进行去噪以获得潜在表示。然后VAE解码器生成最终图像。该模型可以灵活地根据各种形式进行条件化,并利用交叉注意机制来整合条件信息。U-Net是一种流行的对称编码器-解码器结构的卷积神经网络(CNN)。它通常用于图像分割任务,但在稳定扩散的背景下,它用于预测图像中的噪声。U-Net 将嘈杂图像作为输入,并通过一系列卷积层处理以提取特征和学习表示。这些卷积层通常组织在一个收缩路径中,减少空间维度同时增加通道数。一旦收缩路径达到 U-Net 的瓶颈,它通过对称扩展路径进行扩展。在扩展路径中,应用转置卷积(也称为上采样或反卷积)逐渐上采样空间维度同时减少通道数。在扩散过程中,U-Net 的扩展路径接受嘈杂图像并从前向扩散中重建潜在表示。通过将重建的潜在表示与真实潜在表示进行比较,U-Net 预测原始图像中的噪声估计。这种噪声的预测有助于在反向扩散过程中恢复原始图像。扩散模型通过类似于物理学中的扩散的过程运作。它通过向图像添加噪声进行前向扩散过程,直到图像变得不典型和嘈杂。这个过程类似于一滴墨水落入水杯中逐渐扩散的过程。这里的独特之处在于反向扩散过程,模型试图从嘈杂、无意义的图像中恢复原始图像。通过逐步从嘈杂图像中减去估计的噪声,最终恢复类似于原始图像的图像。去噪过程在这个图中展示(来源:维基共享资源用户 Benlisquare):

图 1.8:在日本创造的欧式城堡,使用稳定扩散 V1-5 AI 扩散模型。仅显示 40 步生成过程中的步骤。

在图中,您可以逐步看到图像生成过程,使用 DDIM 采样方法的 U-Net 去噪过程,该方法重复去除高斯噪声,然后将去噪输出解码为像素空间。稳定扩散是一种利用扩散过程从文本提示生成图像的深度学习模型,通过几个清晰的步骤:

-

它从在潜在空间中生成一个随机张量(随机图像)开始,这作为我们初始图像的噪声。

-

一个噪声预测器(U-Net)接收潜在嘈杂图像和提供的文本提示,并预测噪声。

-

模型然后从潜在图像中减去潜在噪声。

-

步骤 2 和 3 会重复进行一定数量的采样步骤,例如,在图中显示的 40 次。

-

最后,VAE的解码器组件将潜在图像转换回像素空间,提供最终输出图像。

在图像生成模型的训练过程中,使用损失函数来评估生成图像的质量。一个常用的损失函数是均方误差(MSE)损失,它量化生成图像与目标图像之间的差异。模型被优化以最小化这种损失,鼓励它生成与期望输出密切相似的图像。该模型是在一个名为LAION-5B的数据集上训练的,该数据集源自 Common Crawl 数据,包括数十亿的图像-文本对。训练数据集根据语言、分辨率、水印可能性和美学评分进行分类。稳定扩散是在该数据集的子集上进行训练的。该模型的训练数据来源多样,其中有相当大一部分来自Pinterest、WordPress、Blogspot、Flickr、DeviantArt等网站。总的来说,像稳定扩散和 Midjourney 这样的图像生成模型将文本提示处理成生成的图像,利用正向和反向扩散过程的概念,并在较低维度的潜在空间中运行以提高效率。到目前为止,稳定扩散有两个主要版本,版本 1和2。让我们看看它们有何不同。

模型差异

稳定扩散 v1 和 v2 在文本处理、训练数据和结果方面有所不同。在文本处理方面,稳定扩散 v2 使用 OpenClip 进行文本嵌入,而 v1 使用 Open AI 的 CLIP ViT-L/14 进行文本嵌入。OpenClip 比 CLIP 大五倍,提高了图像质量,也让研究人员在研究和优化模型时更加透明。关于训练数据,稳定扩散 v1.4 使用三个不同的数据集进行训练,而 稳定扩散 v2 则是在一个经过过滤的 LAION-5B 子集上进行训练,该子集过滤了明确的色情材料(NSFW 过滤器)和美学评分高于阈值的内容。LAION 5B 数据集是一个包含 58.5 亿个 CLIP 过滤的图像文本对的大规模数据集。数据集中超过 23 亿个样本包含英语,而22 亿个样本来自其他 100 多种语言。剩下的 10 亿个样本不允许特定语言分配,比如姓名。数据集的获取流程复杂,需要大量处理。它包括对 PB 级 Common Crawl 数据集的分布式处理,图像的分布式下载,以及少量 GPU 节点的数据后处理,生成最终数据集。过滤还删除了重复样本,并将数据集从 500 亿个候选样本削减到不到 60 亿个 CLIP 过滤的图像文本对。在结果方面,稳定扩散 v2 更难用于控制风格和生成名人。这种差异可能是由于训练数据的不同,因为 Open AI 的专有数据可能包含更多艺术作品和名人照片,这些内容不包含在稳定扩散 v2 的训练数据中。总之,稳定扩散 v2 使用了不同的文本嵌入模型,并在不同的数据子集上进行了训练,与 稳定扩散 v1 相比产生了不同的结果。虽然 稳定扩散 v2 可能更透明,更适合长期发展,但 稳定扩散 v1 可能在特定用例中表现更好,比如控制风格或生成名人,这是由于其训练数据的原因。现在我们将看一下文本到图像使用案例中模型的条件。

条件化

条件过程允许这些模型受到输入文本提示或其他输入类型(如深度图或轮廓)的影响,以便更精确地创建相关图像。在条件过程中,提示被标记化,每个标记被转换为一个嵌入,一个长度为某个特定值的向量,有时是 768 个值。这些嵌入考虑了单词之间的语义关系,然后由文本变压器处理,并馈送给噪声预测器,引导其生成与文本提示相符的图像。在文本到图像的过程中,模型使用文本提示生成一个全新的图像。文本提示被编码到潜在空间中,扩散过程逐渐添加噪声(由去噪强度控制)以使初始图像演变为输出图像。让我们总结本章!

总结

像大型语言模型(LLMs)这样的生成模型因其在革新许多行业和任务方面的潜力而受到广泛关注。特别是它们在文本生成和图像合成方面的应用引起了媒体的极大关注。领先的公司如 OpenAI 正在推动 LLMs 的边界,他们的生成式预训练变压器(GPT)系列因其出色的语言生成能力而受到广泛关注。在本章中,我们讨论了最新突破所吸引的媒体关注,深度学习和人工智能的最近历史,生成模型,LLMs 和预训练生成模型(GPT)以及支撑它们的理论思想,特别是变压器架构。我们还讨论了图像的扩散模型以及文本,图像,声音和视频的应用。下一章将探讨生成和特别是 LLMs 的工具化,重点介绍 Langchain 框架的基础知识,实施和使用这个特定工具来优化和增强 LLMs。我认为在阅读技术书籍时检查自己是否消化了材料是一个好习惯。我为本章创建了一些问题。

问题

如果你已经阅读并理解了本章,你应该能够回答这些问题:

-

什么是生成模型?

-

生成模型有哪些应用?

-

什么是大型语言模型(LLM)以及它的作用是什么?

-

我们如何从 LLMs 中获得更好的性能?

-

使这些模型成为可能的条件是什么?

-

哪些公司和组织是开发 LLMs 的主要参与者?

-

什么是变压器,它由什么组成?

-

GPT 是什么意思?

-

稳定扩散是如何工作的?

-

稳定扩散是如何训练的?

如果你在回答这些问题时遇到困难,请回到本章的相应部分,确保你已经理解了材料。

二、介绍 LangChain

在本章中,我们讨论了 LLMs 的限制,以及如何将 LLMs 与工具结合起来以克服这些挑战,从而构建创新的基于语言的应用程序。有一些强大的框架为开发人员提供了强大的工具,用于快速工程、链接、数据检索等。无论您是开发人员、数据科学家还是对自然语言处理(NLP)或生成式人工智能的技术进步感兴趣,您都应该了解这些框架中最强大和流行的 LangChain。LangChain 解决了与使用 LLMs 相关的痛点,并提供了一个直观的框架来创建定制的 NLP 解决方案。在 LangChain 中,像 LLMs、互联网搜索和数据库查找这样的组件可以链接在一起,这意味着根据数据或任务的要求按顺序执行不同的任务。通过利用其功能,开发人员可以构建动态和数据感知的应用程序,利用我们在第一章讨论的最新技术突破。我们将列举一些用例,以说明该框架如何帮助不同领域的企业和组织。LangChain 对代理和内存的支持使得可以构建比仅通过 API 调用语言模型更强大和灵活的各种应用程序。我们将讨论与框架相关的重要概念,如代理、链、行动计划生成和内存。理解这些概念对于了解 LangChain 的工作原理至关重要。主要部分包括:

-

LLMs 的限制是什么?

-

什么是 LLM 应用程序?

-

什么是 LangChain?

-

LangChain 如何工作?

我们将从介绍 LLMs 的限制开始本章。

LLMs 的限制是什么?

大型语言模型(LLMs)因其生成类似人类文本和理解自然语言的能力而受到广泛关注和流行,这使它们在围绕内容生成、文本分类和摘要的场景中非常有用。虽然LLMs提供了令人印象深刻的功能,但它们存在一些限制,可能会影响其在某些场景中的有效性。了解这些限制在开发应用程序时至关重要。与大型语言模型相关的一些痛点包括:

-

过时的知识:LLMs无法提供实时或最新数据,因为它们完全依赖于提供给它们的训练数据。

-

无法执行操作:LLMs无法执行操作或与外部系统交互,限制了其功能。例如,它们无法启动网络搜索、实时查询数据库或使用计算器进行数字乘法。

-

缺乏上下文和额外信息:LLMs可能难以理解和整合来自先前提示或对话的上下文。它们可能不记得先前提到的细节或未能提供除给定提示之外的额外相关信息。

-

复杂性和学习曲线:使用大型语言模型开发应用程序通常需要对人工智能概念、复杂算法和 API 有深入的理解。这可能对那些在这些领域没有专业知识的开发人员构成挑战。

-

幻觉:LLMs在它们的权重中隐含了对世界的许多常识。然而,它们可能对某些主题了解不足,并生成不准确或不连贯的回应。例如,它们可能产生不存在的信息或提供不准确的细节。

-

偏见和歧视:根据它们训练的数据,大型语言模型可能表现出宗教、意识形态、政治等方面的偏见。

LLMs 没有关于当前事件的信息,因为它们与外部世界没有连接,也不会知道它们没有接受过训练的任何事情,比如截止日期之后的任何事情,即训练数据生成的时间。更重要的是,它们在超出训练数据限制的上下文理解方面遇到困难。例如,由于模型无法执行操作或直接与外部系统交互,它们不会知道天气,也无法访问您的文档。这个截止日期问题在 OpenAI ChatGPT 聊天界面中询问LangChain时得到了说明:

图 1.1:ChatGPT - 缺乏最新信息。

在这种情况下,模型能够正确地捕捉问题并给出正确的反馈。然而,如果我们在GPT-3游乐场问同样的问题,我们会得到这样的回答:

图 1.2:带有 GPT 3.5 的 OpenAI 游乐场 - 幻觉。

在这种情况下,我们可以看到模型虚构了这个术语,并发明了一个名为去中心化平台。这是一种幻觉。需要注意这些问题。这个问题可以通过访问外部数据来解决,比如天气 API、用户偏好或来自网络的相关信息,这对于创建个性化和准确的语言驱动应用程序至关重要。LLMs擅长生成文本,但缺乏真正的理解和推理能力。然而,它们可能在逻辑推理方面遇到困难。例如,即使是高级的LLMs在高中水平的数学方面表现不佳,无法执行它们之前没有见过的简单数学运算。我们可以通过一个简单的演示来说明这一点:

图 1.3:ChatGPT 数学求解。

因此,该模型对第一个问题提出了正确的回答,但在第二个问题上失败了。以防你想知道真正的结果是什么 - 如果我们使用计算器,我们会得到这个结果:

图 1.4:使用计算器进行乘法(BC)。

LLM 没有存储计算结果或者在训练数据中遇到足够多次以便可靠地记住它作为其权重中的编码。因此,它未能正确提出解决方案。在这种情况下,基于 Transformer 的 LLM 不是合适的工具。在部署应用程序之前,LLMs的输出可能需要监控和校正以确保准确性和偏见以及不当语言。在领域如客户服务、教育和营销中部署应用程序之前,需要监控和校正LLMs的输出以确保准确性和偏见。在 Chatbot 中找到偏见的例子并不难 - 只需回想一下 Tay Chatbot,因为其中包含种族歧视和其他仇外言论而成为微软的公关灾难。为了解决所有这些问题,LLMs需要与外部数据源、内存和能力集成,以便根据提供的数据与其环境动态交互并做出适当的响应。然而,将大型语言模型与不同的数据源和计算连接起来可能会很棘手,需要开发和仔细测试特定的定制工具。因此,使用生成式 AI 构建数据响应型应用程序可能会很复杂,可能需要大量编码和数据处理。最后,直接使用LLM模型可能具有挑战性且耗时。这从提示工程开始,但延伸得更远。困难在于导航这些复杂的模型,提供有效的提示,并解析它们的输出。

什么是 LLM 应用?

为了解决上述挑战和限制,LLMs可以与其他程序或服务的调用结合使用。主要思想是通过连接工具来增强 LLMs 的能力。将LLMs与其他工具结合到使用专门工具的应用程序中,LLM驱动的应用程序有潜力改变我们的数字世界。通常通过一条或多条提示调用LLMs的链来完成这一点,但也可以利用其他外部服务(如 API 或数据源)来完成特定任务。

一个LLM 应用是一种使用大型语言模型(LLMs)如 ChatGPT 来辅助各种任务的应用程序。它通过向语言模型发送提示来生成响应,并且还可以与其他外部服务(如 API 或数据源)集成,以实现特定目标。

为了说明一个LLM应用程序可能是什么样子,这里有一个非常简单的LLM应用程序,包括一个提示和一个LLM(来源:github.com/srush/MiniChain):

图 1.5:一个简单的 LLM 应用,将提示与 LLM 结合在一起。

LLM应用对人类有着重要潜力,因为它们增强了我们的能力,简化了流程,并在各个领域提供了有价值的帮助。以下是LLM应用重要的几个原因:

-

效率和生产力:LLM应用自动化任务,实现重复或复杂操作更快、更准确地完成。它们可以处理数据处理、分析、模式识别和决策,速度和准确性超过人类能力。这提高了数据分析、客户服务、内容生成等领域的效率和生产力。

-

任务简化:LLM应用通过将复杂任务分解为可管理的步骤或为用户提供直观界面来简化复杂任务。这些工具可以自动化复杂工作流程,使其对更广泛范围的用户可访问,而无需专业知识。

-

增强决策能力:LLM应用提供先进的分析能力,实现数据驱动的决策。它们可以快速分析大量信息,识别人类无法察觉的趋势或模式,并为战略规划或问题解决提供有价值的见解。

-

个性化:基于个人偏好和行为模式,AI 驱动的推荐系统个性化用户体验。这些应用考虑用户数据,提供定制建议、推荐和个性化内容,涵盖电子商务、娱乐和在线平台等各个领域。

公司数据,尤其是客户数据,与LLMs的使用是增长的一个特定领域。然而,我们必须谨慎考虑隐私和数据保护的影响。我们绝不能将个人可识别(PII)数据输入公共 API 端点。对于这些用例,部署模型在内部基础设施或私有云中至关重要,细化甚至训练专门模型提供重要改进。这就是我们将在第九章LLM 应用在生产中中讨论的内容。让我们比较一些可以帮助构建LLM应用的框架。

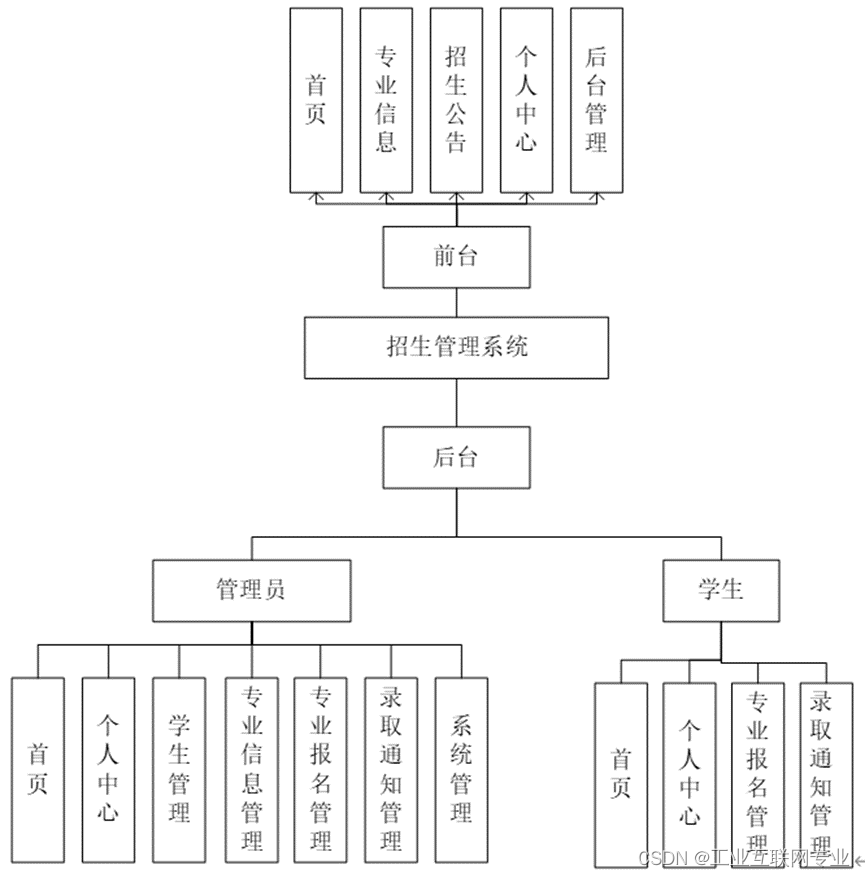

框架比较

LLM应用框架已经发展出来,提供专门的工具,可以有效利用LLMs的力量来解决复杂问题。一些库已经出现,满足有效结合生成式 AI 模型和其他工具构建LLM应用的要求。有几个开源框架可用于构建动态LLM应用。它们在开发尖端 LLM 应用方面提供价值。这张图显示它们随时间的流行度(数据来源:github 星标历史;star-history.com/):

图 1.6:Python 中不同框架受欢迎程度的比较。我们可以看到每个项目随时间在 github 上的星星数量。

我们可以从图表中看到,Haystack 是比较的框架中最古老的,始于 2020 年初(根据 github 提交记录)。在 github 上,它也是最不受欢迎的。Langchain,LlamaIndex(之前称为 GPTIndex),以及SuperAGI在 2022 年末或 2023 年初开始,它们都在很短的时间内迅速走红,其中LangChain增长最为显著。在本书中,我们将看到为什么它的受欢迎程度正在迅速增长。LlamaIndex专注于高级检索,而不是LLM应用的更广泛方面。同样,Haystack 专注于创建大规模搜索系统,其组件专门设计用于可扩展信息检索,使用检索器、阅读器和其他数据处理程序结合通过预训练模型进行语义索引。LangChain擅长使用代理将LLMs链接在一起,用于将动作委托给模型。其用例强调及时优化和上下文感知信息检索/生成,但是由于其 Python 式高度模块化界面和庞大的工具集,它是实现复杂业务逻辑的头号工具。SuperAGI具有与LangChain类似的功能。它甚至配备了一个市场,一个工具和代理的存储库。然而,它不像LangChain那样广泛和得到良好支持。我没有包括AutoGPT(以及类似的工具如AutoLlama),这是一个递归应用,用于分解任务,因为它的推理能力,基于人类和 LLM 反馈,与LangChain相比非常有限。因此,它经常陷入逻辑循环,并经常重复步骤。我还省略了一些专注于提示工程的库,例如 Promptify。还有其他语言中的 LLM 应用框架,如 Rust、Javascript、Ruby 和 Java。例如,用 Rust 编写的 Dust 专注于 LLM 应用的设计和部署。让我们更深入地了解一下LangChain。

什么是 LangChain?

LangChain 是一个基于语言模型的应用程序开发框架,使用户能够更有效地使用LLMs构建应用程序。它为连接语言模型到其他数据源提供了标准接口,同时也为构建可以与环境交互的代理提供了支持。LangChain 被设计为模块化和可扩展的,使得构建适用于各种领域的复杂应用程序变得容易。LangChain 是开源的,使用 Python 编写,尽管还存在使用 JavaScript 或者更准确地说是 Typescript(LangChain.js)实现的伴随项目,以及为 Ruby 提供了 Ruby 解释器用于代码执行的新兴项目 Langchain.rb。在本书中,我们专注于该框架的 Python 版本。

LangChain 是一个开源框架,允许 AI 开发人员将像 ChatGPT 这样的 LLMs 与其他计算和信息源结合在一起。

LangChain 由 Harrison Chase 于 2022 年 10 月作为一个开源项目在 github 上启动,采用 MIT 许可证,这是一种常见的许可证,允许商业使用、修改、分发和私人使用,但限制了责任和保证。LangChain 目前仍然很新,但已经拥有数百个集成和工具。在 discord 聊天服务器上有活跃的讨论,有博客,并且定期在旧金山和伦敦举行聚会。甚至有一个名为 ChatLangChain 的聊天机器人,可以回答关于 LangChain 文档的问题,该机器人是使用 LangChain 和 FastAPI 构建的,并且可以通过文档网站在线访问!该项目已经吸引了 Sequoia Capital 和 Benchmark 等公司的数百万美元的风险投资,这些公司曾为苹果、思科、谷歌、WeWork、Dropbox 等许多成功公司提供资金。LangChain 配备了许多扩展和正在围绕它发展的更大生态系统。正如前面提到的,它已经拥有大量的集成,每周还会有许多新的集成。这个截图展示了一些集成(来源:integrations.langchain.com/trending):

图 1.7:LangChain 集成。

例如,LangChainHub 是一个存储库,其中包含对LangChain有用的工件,如提示、链和代理,它们结合在一起形成复杂的 LLM 应用程序。受 HuggingFace Hub 的启发,这是一个模型集合,旨在成为一个中央资源,用于共享和发现高质量的LangChain基元和应用程序。目前,该存储库仅包含一系列提示,但 - 希望 - 随着社区不断增加到这个集合,您可能很快就能找到链和代理。此外,LlamaHub库通过为Google Docs、SQL 数据库、PowerPoints、Notion、Slack和Obsidian等提供更多数据加载器和阅读器,扩展了 LangChain 和 LlamaIndex。LangFlow是一个 UI,允许通过将侧边栏组件拖放到画布上并将它们连接在一起来创建您的流水线的可执行流程图。这是一个快速尝试和原型设计流水线的方法。下面是一个基本聊天流水线的屏幕截图,其中包含一个提示模板和一个对话缓冲区作为记忆:

图 1.8:带有基本聊天的 LangFlow UI。

在浏览器界面的侧边栏(此处未显示),您可以看到所有不同的LangChain组件,如零-shot 提示、数据加载器和语言模型包装器。这些流程可以直接在LangChain中导出和加载,也可以通过 API 调用本地服务器来调用。LangChain和LangFlow可以在本地部署,例如使用 Chainlit 库,也可以在包括 Google Cloud 在内的不同平台上部署。langchain-serve 库有助于通过单个命令将LangChain和LangFlow部署在Jina AI 云上作为 LLM 应用程序服务。LangChain提供了一个直观的框架,使开发人员、数据科学家,甚至对 NLP 技术新手来说更容易使用大型语言模型创建应用程序。值得注意的是LangChain既不是模型也不是提供者,而是一个促进与不同模型无缝交互的框架。使用LangChain,您不需要成为 AI 或复杂算法的专家 —— 它简化了流程并减少了学习曲线。

请注意,尽管 LangChain 的主要重点是 LLMs,这在本书中将是我们主要讨论的内容,但也有用于图像生成的集成。

通过具有数据意识和代理性,LangChain可以轻松集成各种数据源,包括Google Drive、Notion、Wikipedia、Apify Actors等。这种数据意识使应用程序能够根据用户偏好或来自外部来源的实时信息生成个性化和上下文相关的响应。让我们探讨一下LangChain为什么重要,然后它被用来做什么。

为什么 LangChain 很重要?

LangChain填补了我们在开始时概述的许多需求,包括LLMs的限制和LLM应用程序的出现。简而言之,它简化和优化了使用LLMs构建应用程序的开发过程。它提供了一种构建比通过 API 简单调用语言模型构建的应用程序更强大和灵活的方式。特别是,LangChain对代理和内存的支持允许开发人员以更复杂的方式与其环境进行交互,并且可以随时间存储和重复使用信息。LangChain可用于改善各种领域的应用程序的性能和可靠性。在医疗保健领域,它可以用于构建能够回答患者问题并提供医疗建议的聊天机器人。在这种情况下,我们必须非常注意信息可靠性和保密性方面的监管和道德约束。在金融领域,该框架可用于构建可以分析财务数据并进行预测的工具。在这里,我们必须考虑这些模型的可解释性。在教育领域,LangChain可以用于构建可以帮助学生学习新概念的工具。这可能是最令人兴奋的领域之一,LLMs 可以将完整的教学大纲分解并以定制的互动会话形式传递,个性化地适应个体学习者。LangChain的多功能性使其能够以几种动态方式使用,如构建能够回忆先前互动的虚拟个人助手;提取分析结构化数据集;创建提供与提供实时更新的 API 互动的问答应用程序;执行代码理解,从 GitHub 提取交互源代码,从而丰富开发人员体验并增强编码性能。使用LangChain有许多好处,包括:

-

增强的灵活性:它提供了广泛的工具和功能,用于构建强大的应用程序。此外,其模块化设计使得构建复杂应用程序变得容易,可以适应各种领域。

-

提高性能:支持行动计划生成可以帮助提高应用程序的性能。

-

增强可靠性:LangChain 对内存的支持可以通过存储和重复使用信息,以及通过访问外部信息来减少幻觉,从而提高应用程序的可靠性。

-

开源:开放的商业友好许可证以及庞大的开发者和用户社区意味着您可以根据自己的需求定制它,并依赖广泛的支持。

总之:有许多理由使用LangChain。但是,我应该警告说,由于LangChain仍然相当新,可能存在一些尚未解决的错误或问题。文档已经相对全面且庞大,但在某些地方还在建设中。

我可以用 LangChain 构建什么?

LangChain赋予各种 NLP 用例权力,例如虚拟助手、用于摘要或翻译的内容生成模型、问答系统等。它已被用于解决各种现实世界问题。例如,LangChain已被用于构建聊天机器人、问答系统和数据分析工具。它还被用于许多不同领域,包括医疗保健、金融和教育。您可以使用LangChain构建各种应用程序,包括:

-

聊天机器人:可用于构建可以以自然方式与用户交互的聊天机器人。

-

问答:LangChain可用于构建能够回答各种主题问题的问答系统。

-

数据分析:您可以将其用于自动化数据分析和可视化以提取见解。

-

代码生成:您可以设置软件对编程助手,帮助解决业务问题。

-

还有更多!

LangChain 如何工作?

使用LangChain,您可以构建利用最新自然语言处理技术突破的动态应用程序。通过连接多个模块的组件(链接),您可以创建围绕大型语言模型定制的独特应用程序。从情感分析到聊天机器人,可能性是巨大的。LangChain 框架的主要价值主张包括以下部分:

-

组件:

-

模型 I/O:此组件提供 LLM 包装器,作为连接到语言模型的标准化接口。

-

提示模板:这使您可以管理和优化提示。

-

记忆:索引用于在链/代理的调用之间存储和重复使用信息。

-

-

代理:代理允许 LLMs 与其环境进行交互。它们决定要采取的行动并执行该行动。

-

链:这些组件将组件组合在一起以解决任务。它们可以由对语言模型和其他实用程序的调用序列组成。

这里是这些部分的可视化表示:

图 1.9:LangChain 组件。

关于这些部分有很多内容需要解释。让我们稍微详细讨论一下!虽然LangChain本身不提供模型,但通过与各种不同语言模型提供者的LLM包装器进行集成,支持与聊天模型以及文本嵌入模型提供者进行交互。支持的提供者包括OpenAI、HuggingFace、Azure 和 Anthropic。提供标准化接口意味着可以轻松地更换模型以节省金钱和能源,或获得更好的性能。LangChain的核心构建块之一是提示类,允许用户通过提供简明的说明或示例与LLMs进行交互。提示工程有助于优化提示以获得最佳模型性能。模板在输入和可用提示集合方面提供了灵活性,在各种应用程序中经过了实战测试。当处理大型文档时,向量存储器会发挥作用,其中文档需要被分块以传递给LLM。文档的这些部分将被存储为嵌入,这意味着它们是信息的向量表示。所有这些工具增强了LLMs的知识,并提高了它们在问答和摘要等应用中的性能。有许多用于向量存储的集成。这些包括阿里巴巴云 OpenSearch、AnalyticDB for PostgreSQL、Meta AI 的 Annoy 库用于近似最近邻(ANN)搜索、Cassandra、Chroma、ElasticSearch、Facebook AI 相似性搜索(Faiss)、MongoDB Atlas 向量 搜索、PGVector作为Postgres的向量相似性搜索、Pinecone、Scikit-Learn(用于 k 最近邻搜索的SKLearnVectorStore),以及许多其他。还有一些其他模块包括:

-

数据连接器和加载器:这些组件提供了连接到外部数据源的接口。

-

回调:回调用于记录和流式传输任何链的中间步骤。

数据连接器包括用于存储数据和与外部系统交互的实用程序模块,如网络搜索或数据库,最重要的是数据检索。示例包括 Microsoft Doc(docx)、超文本标记语言(HTML)以及其他常见格式,如 PDF、文本文件、JSON 和 CSV。其他工具将向潜在客户发送电子邮件,向您的关注者发送有趣的双关语,或向您的同事发送 Slack 消息。让我们更详细地看看,代理可以做什么以及它们如何做出决策。

什么是代理?

代理在LangChain中用于控制应用程序的执行流程,与用户、环境和其他代理进行交互。代理可用于决定采取哪些行动,与外部数据源交互,以及随时间存储和重复使用信息。代理可以转账、预订航班,或与您的客户交谈。

一个代理是一个软件实体,可以在世界中执行动作和任务,并与其环境进行交互。在LangChain中,代理获取工具和链,并将它们组合以执行任务并决定使用哪个。

代理可以与外部世界建立连接。例如,可以利用搜索引擎或向量数据库来查找最新和相关的信息。然后可以将这些信息提供给模型。这被称为检索增强。通过整合外部信息源,LLMs可以从当前信息和扩展知识中汲取。这是代理如何克服LLMs固有弱点并通过将工具与模型结合来增强它们的一个例子。在关于LLMs限制的部分,我们已经看到,对于计算,一个简单的计算器胜过由数十亿参数组成的模型。在这种情况下,代理可以决定将计算传递给计算器或 Python 解释器。我们可以在这里看到一个简单的应用程序,将 OpenAI 语言模型输出连接到 Python 函数:

图 1.10:在 LangFlow 中可视化的带有 Python 函数的简单 LLM 应用程序。

图 1.10:在 LangFlow 中可视化的带有 Python 函数的简单 LLM 应用程序。

我们将在第三章,开始使用 LangChain中实际看到这一点。LangChain中的代理可用于执行各种任务,例如:

-

搜索信息

-

调用 APIs

-

访问数据库

-

代码执行

每个代理都可以决定何时使用哪个工具。由于这对于理解LangChain的工作方式至关重要,让我们稍微详细地看一下这一点。

动作执行

每个代理都配备了这些子组件:

-

工具,这些是功能组件,

-

工具包(这些是工具的集合),以及

-

代理执行器。

代理执行器是允许在工具之间进行选择的执行机制。 代理执行器可以被视为代理和执行环境之间的中介。 它接收来自代理的请求或命令,并将其翻译成可以由底层系统或软件执行的操作。 它管理这些操作的执行并向代理提供反馈或结果。 我们将看到不同类型的执行或决策模式。 ReAct 模式(由普林斯顿大学和 Google DeepMind 的研究人员于 2023 年 5 月发表的“ReACT:在语言模型中协同推理和行动”),简称为 Reason and Act,其中代理主动将任务分配给适当的工具,为其定制输入,并解析其输出以解决任务。 在论文中,使用了文档存储库,其中将搜索答案 - 这被实现为ReAct 文档存储模式。 在LangChain中,默认情况下,代理遵循Zero-shot ReAct 模式(ZERO_SHOT_REACT_DESCRIPTION),其中决策仅基于工具的描述。 可以通过记忆来扩展此机制,以考虑完整的对话历史。 使用ReAct,而不是要求LLM在您的文本上自动完成,您可以提示它以思考/行动/观察循环回应。 LLM的提示是逐步回应并将这些步骤与行动相关联。 这些步骤的结果,例如搜索结果,然后传递回LLM以进行下一次思考,因为它朝着目标迭代。 对于 ZeroShot 模式,提示非常重要,它是由连接前缀,描述工具及其用途的字符串,格式说明和后缀组成的:

PREFIX = """Answer the following questions as best you can. You have access to the following tools:"""

FORMAT_INSTRUCTIONS = """Use the following format:

Question: the input question you must answer

Thought: you should always think about what to do

Action: the action to take, should be one of [{tool_names}]

Action Input: the input to the action

Observation: the result of the action

... (this Thought/Action/Action Input/Observation can repeat N times)

Thought: I now know the final answer

Final Answer: the final answer to the original input question"""

SUFFIX = """Begin!

Question: {input}

Thought:{agent_scratchpad}"""

要看到这一实践,例如,我们可以询问LangChain代理执行器和LangChain执行计划之间的区别。以下是LangChain中的日志 - 首先问题传递给语言模型:

I'm not familiar with these terms, so I should search for information about them.

Action: Search

Action Input: "difference between langchain agent executor and langchain execution plan"

Observation: The Concept of Agents in LangChain Action Agents decide an action to take and execute that action one step at a time. They are more conventional and suitable for small tasks. On the other hand, Plan-and-Execute Agents first decide a plan of actions to take, and then execute those actions one at a time.

Thought:Based on the observation, a langchain agent executor is an agent that decides and executes actions one step at a time, while a langchain execution plan is an agent that first decides a plan of actions and then executes them one at a time.

Final Answer: A langchain agent executor executes actions one step at a time, while a langchain execution plan first decides a plan of actions and then executes them.

还有一些实施的机制。 华盛顿大学的研究人员,MosaicAI,Meta AI 研究和艾伦研究所(2022 年 10 月的论文“测量和缩小语言模型中的组合性差距”中)发现LLMs可能经常无法给出需要组合推理的问题的正确和完整答案,其中必须将多个信息片段放在一起。 自问自答搜索模式将问题分解为组成部分,并调用搜索引擎方法以检索必要的信息以回答问题。 用户 nkov 在 LangChain 的 github 上讨论了这种强大的机制的示例。 问题是谁活得更久,穆罕默德·阿里还是艾伦·图灵,对话发展如下:

Question: Who lived longer, Muhammad Ali or Alan Turing?

Are follow up questions needed here: Yes.

Follow up: How old was Muhammad Ali when he died?

Intermediate answer: Muhammad Ali was 74 years old when he died.

Follow up: How old was Alan Turing when he died?

Intermediate answer: Alan Turing was 41 years old when he died.

So the final answer is: Muhammad Ali

在每一步中,LLM决定是否需要后续搜索,并将此信息反馈给LLM。最近,OpenAI 模型(gpt-3.5-turbo-0613,gpt-4-0613)已经被微调以检测何时应执行函数调用以及应将哪些输入馈送到函数中。为了使其正常工作,函数也可以在 API 调用中描述给这些语言模型。这也在LangChain中实现了。在LangChain中,还有一些尚未(尚未)实施为执行机制的策略:

-

递归批评和改进其输出(RCI)方法(“语言模型可以解决计算机任务”;Kim 等人,2023 年 6 月)使用LLM作为规划者来构建一个代理,前者在执行动作之前使用LLM生成思路,而后者则提示 LLM 为改进后续情节思考出教训。

-

思维树(ToT)算法(由普林斯顿大学和谷歌 DeepMind 的研究人员于 2023 年 5 月发表的“思维树:使用大型语言模型进行深思熟虑的问题解决”)通过遍历搜索树推进模型推理。基本策略可以是深度优先或广度优先树遍历,然而许多其他策略也可以并且已经被测试,如最佳优先、蒙特卡洛和 A*。这些策略已被发现显著提高了问题解决的成功率。

这些决策可以提前计划或在每一步中进行。创建代理可以采取的一系列行动序列以实现目标的过程称为行动计划生成。根据任务所需的动态性,可以选择两种不同类型的代理通过行动计划生成:

-

行动代理根据所有先前行动的输出,在每次迭代中决定下一步行动。

-

计划执行代理在开始时决定所有行动的完整计划。然后他们执行所有这些行动而不更新顺序。这种在LangChain中的实现受到BabyAGI的启发。

一般来说,行动代理更加灵活,而计划执行代理更擅长保持长期目标。如果我们希望尽可能灵活,我们可以为我们的代理指定一个零-shot ReAct机制,以便在每个转弯时做出决策。现在让我们来看看链条吧!

什么是链条?

LangChain中的核心思想是LLMs和其他组件的组合性共同工作。例如,用户和开发人员可以将多个LLM调用和其他组件放在一个序列中,以创建类似聊天机器人的社交互动、数据提取和数据分析等复杂应用。

在最通用的术语中,链是一系列对组件的调用,其中可以包括其他链。

例如,提示链接是一种可以用来提高 LangChain 应用程序性能的技术。提示链接涉及将多个提示链接在一起以自动完成更复杂的响应。简而言之,链和代理都是组件的包装器。它们都可以通过使它们能够与外部系统交互并收集最新信息来扩展 LLMs 的功能。将应用程序模块化为链和代理等构建块可以使调试和维护变得更容易。链的最无害的例子可能是PromptTemplate,它将格式化的响应传递给语言模型。链的更有趣的例子包括用于数学查询的LLMMath和用于查询数据库的SQLDatabaseChain。这些被称为实用链,因为它们将语言模型与特定工具结合在一起。一些链可以做出自主决策。类似于代理,路由链可以根据其描述决定使用哪个工具。RouterChain可以动态选择要使用的检索系统,例如提示或索引。LangChain 实现链以确保输出内容不会有毒或违反 OpenAI 的管理规则(OpenAIModerationChain),或符合道德、法律或自定义原则(ConstitutionalChain)。LLMCheckerChain 可以通过验证提供的陈述和问题的基础假设来防止幻觉并减少不准确的响应。在 2023 年 5 月的一篇由卡内基梅隆大学、艾伦研究所、华盛顿大学、英伟达、加州大学圣地亚哥分校和谷歌研究人员撰写的论文(“SELF-REFINE: Iterative Refinement with Self-Feedback”)中,发现这种策略可以使任务性能平均提高约 20%。让我们来看看记忆策略!

什么是记忆?

LLMs 和工具在某种意义上是无状态的,它们不保留任何关于先前响应和对话的信息。记忆是 LangChain 中的一个关键概念,可以通过存储先前调用语言模型、用户、代理操作环境状态以及代理目标的结果来改善 LangChain 应用程序的性能。这可以帮助减少语言模型需要被调用的次数,并确保即使环境发生变化,代理也能继续运行。

记忆 是一种数据结构,用于在一段时间内存储和重复使用信息。

记忆有助于为应用程序提供上下文,并使 LLM 的输出更连贯和与上下文相关。例如,我们可以存储所有对话(ConversationBufferMemory)或使用缓冲区保留对话中最后的消息,使用ConversationBufferWindowMemory。记录的消息在每次调用时都包含在模型的历史参数中。然而,我们应该注意,这将增加令牌使用量(因此增加 API 费用)和响应的延迟。这也可能影响模型的令牌限制。还有一种对话摘要记忆策略,其中 LLM 用于总结对话历史 - 这可能会导致额外的 API 调用费用。关于这些记忆选项有一些有趣的细微差别。例如,一个有趣的特性是,与 LLM 的对话可以被编码为知识图(ConversationKGMemory),这可以被集成回提示或用于预测响应,而无需访问 LLM。

知识图是使用图结构数据模型表示数据的一种形式,通常以三元组的形式集成数据,主语、谓语和宾语,例如主语=Sam,谓语=loves,宾语=apples。这个图存储了关于实体(如人、地点或事件)及其之间关系的信息。

总之,LangChain中的记忆可以用于存储各种信息,包括:

-

先前对语言模型的调用结果

-

代理操作的环境状态

-

代理正在努力实现的目标。

现在,我们将看看我们可以使用的不同工具。

有哪些种类的工具?

工具是LangChain中的组件,可以与模型结合以扩展其功能。LangChain提供了诸如文档加载器、索引和向量存储等工具,这些工具有助于检索和存储数据,以增强LLMs中的数据检索。有许多可用的工具,以下只是一些示例,您可以使用工具做什么:

-

机器翻译器:语言模型可以使用机器翻译器更好地理解和处理多种语言的文本。这个工具使非翻译专用的语言模型能够理解并回答不同语言的问题。

-

计算器:语言模型可以利用简单的计算器工具解决数学问题。计算器支持基本算术运算,使模型能够准确解决专门设计用于数学问题解决的数据集中的数学查询。

-

地图:通过连接必应地图 API 或类似服务,语言模型可以检索位置信息,协助路线规划,提供驾驶距离计算,并提供附近景点的详细信息。

-

天气:天气 API 为语言模型提供全球城市的实时天气信息。模型可以回答关于当前天气状况或预测特定位置在不同时间范围内的天气的查询。

-

股票:连接股票市场 API(如 Alpha Vantage)使语言模型能够查询特定股票市场信息,如开盘价、收盘价、最高价、最低价等。

-

幻灯片:配备幻灯片制作工具的语言模型可以利用诸如 python-pptx 库提供的高级语义或根据给定主题从互联网检索图像来创建幻灯片。这些工具有助于在各种专业领域中需要的幻灯片制作任务。

-

表格处理:使用 pandas DataFrame 构建的 API 使语言模型能够在表格上执行数据分析和可视化任务。通过连接这些工具,模型可以为用户提供更流畅和自然的处理表格数据体验。

-

知识图谱:语言模型可以使用模拟人类查询过程的 API 查询知识图谱,例如查找候选实体或关系、发送 SPARQL 查询并检索结果。这些工具有助于基于知识图谱中存储的事实知识回答问题。

-

搜索引擎:通过利用 Bing Search 等搜索引擎 API,语言模型可以与搜索引擎互动,提取信息并回答实时查询。这些工具增强了模型从网络中收集信息并提供准确响应的能力。

-

维基百科:配备维基百科搜索工具的语言模型可以在维基百科页面上搜索特定实体,查找页面内的关键词,或消除具有相似名称的实体。这些工具有助于使用从维基百科检索的内容进行问答任务。

-

在线购物:将语言模型与在线购物工具连接起来,使其能够执行搜索商品、加载有关产品的详细信息、选择商品特性、浏览购物页面,并根据特定用户指令做出购买决策等操作。

其他工具包括 AI 绘画,允许语言模型使用 AI 图像生成模型生成图像;3D 模型构建,使语言模型能够使用先进的 3D 渲染引擎创建三维(3D)模型;化学性质,利用像 PubChem 这样的 API 解决关于化学性质的科学问题;数据库工具促进对数据库数据的自然语言访问,以执行 SQL 查询并检索结果。这些各种工具为语言模型提供了额外的功能和能力,以执行超出文本处理范围的任务。通过通过 API 连接这些工具,语言模型可以增强其在翻译、数学问题解决、基于位置的查询、天气预测、股市分析、幻灯片制作、表格处理和分析、图像生成、文本转语音转换以及许多其他专业任务领域的能力。所有这些工具都可以为我们提供先进的 AI 功能,工具几乎没有限制。我们可以轻松构建自定义工具来扩展 LLMs 的能力,正如我们将在下一章节 3 中看到的那样。使用不同的工具扩展了语言模型的应用范围,并使其能够更有效地处理各种现实世界任务。让我们总结一下!

总结

在当今世界,准确理解和处理语言对于开发智能应用程序以及创建个性化和有效的用户体验至关重要。因此,大型语言模型(LLMs)理想地适用于为应用程序提供这种能力。然而,正如我们在本章中讨论的那样,独立的LLMs存在其局限性。如果我们用工具补充LLMs,我们可以克服其中一些限制,并大大增强它们的性能,创建LLM应用程序。这就是 LangChain 的作用所在,这是一个旨在为 AI 开发人员建立代理应用程序的框架 - 这些代理由计算实体组成,如 LLMs 和其他可以自主执行某些任务的工具。我们已经讨论了它的重要概念,首先是代理和链条的概念。总之,LangChain 是一个有价值的开源框架,旨在简化使用来自 OpenAI 和 Hugging Face 等提供商和平台的大型语言模型(LLMs)开发应用程序。这个框架在释放生成式 AI 的力量方面提供了巨大价值。在接下来的章节中,我们将通过构建LLM应用程序来进一步发展LangChain的核心原则。通过利用LangChain的能力,开发人员可以释放LLMs的全部潜力。在第三章,开始使用 LangChain中,我们将使用Langchain实现我们的第一个应用程序!让我们看看你是否记得本章的一些关键要点!

问题

请看看是否能回答这些问题。如果你对任何问题不确定,我建议你回到本章的相应部分查看:

-

LLMs 的局限性是什么?

-

什么是 LLM 应用?

-

什么是 LangChain,为什么你应该使用它?

-

LangChain 的主要特点是什么?

-

LangChain 中的代理是什么?

-

什么是行动计划生成?

-

什么是链?

-

为什么 LangChain 应用需要记忆?

-

有哪些可用的工具?

-

LangChain 是如何工作的?

三、使用 LangChain 入门

在本章中,我们将首先设置LangChain和本书所需的库,提供了关于常见依赖管理工具如Docker、Conda、Pip和Poetry的说明。然后我们将介绍可以使用的模型集成,如OpenAI的Chatgpt,Huggingface 和 Jina AI 上的模型等。我们将依次介绍、设置和使用几个提供商。我们将获取 API 密钥令牌,然后进行一个简短的实际示例。这将为我们提供更多关于如何有效使用LangChain的上下文,并介绍使用它的技巧和窍门。作为最后一部分,我们将开发一个LangChain应用程序,这是一个实际示例,说明了在客户服务的实际业务用例中如何应用LangChain。主要部分包括:

-

如何设置LangChain?

-

模型集成

-

客户服务助手

我们将从在您的计算机上设置LangChain开始本章。

如何设置 LangChain?

在本书中,我们谈论的是 LangChain。我们可以通过在终端中简单地输入pip install langchain来安装 LangChain,然而,在本书中,我们还将在几种不同的用例中使用各种其他工具和集成。为了确保所有示例和代码片段按预期工作,并且不仅仅在我的机器上工作,而是对于任何安装此软件的人都能工作,我提供了设置环境的不同方法。设置 Python 环境有各种方法。在这里,我们描述了四种安装相关依赖项的流行方法:Docker、Conda、Pip 和 Poetry。如果在安装过程中遇到问题,请参考各自的文档或在本书的 Github 存储库上提出问题。这些不同的安装在发布本书时已经经过测试,但是事情可能会发生变化,我们将在线更新 Github 自述文件,包括可能出现问题的解决方法。请在本书的存储库中找到一个用于 docker 的Dockerfile,一个用于 pip 的requirements.txt,一个用于 poetry 的pyproject.toml和一个用于Conda的langchain_ai.yml文件:github.com/benman1/generative_ai_with_langchain让我们从 Python 开始设置我们的环境。

Python 安装

在设置 Python 环境并安装相关依赖项之前,通常应该安装 Python 本身。我假设,大多数购买本书的人都已经安装了 Python,但是,为了确保,让我们来看看。您可以从 python.org 下载最新版本适用于您操作系统的版本,或者使用您平台的软件包管理器。让我们看看在 MacOS 使用 Homebrew 和在 Ubuntu 使用 apt-get。在 MacOS 上,使用 Homebrew,我们可以:

brew install python

对于 Ubuntu,我们可以使用 apt-get:

sudo apt-get updatesudo apt-get install python3.10

提示:如果您是编程或 Python 的新手,建议在继续 LangChain 和本书中的应用之前先参考一些初学者级别的教程。

一个重要的工具,用于交互式地尝试数据处理和模型的是 Jupyter 笔记本和 lab。让我们现在来看看这个。

Jupyter Notebook 和 JupyterLab

Jupyter Notebook 和 JupyterLab 是用于创建、共享和协作计算文档的开源基于 Web 的交互式环境。它们使用户能够在单个称为笔记本的文档中编写代码、显示可视化效果并包含解释性文本。两者之间的主要区别在于它们的界面和功能。

Jupyter Notebook 的目标是支持像 Julia、Python 和 R 这样的各种编程语言 - 实际上,项目名称是对这三种语言的引用。Jupyter Notebook 提供了一个简单的用户界面,允许用户使用线性布局创建、编辑和运行笔记本。它还支持用于额外功能和自定义的扩展。

另一方面,JupyterLab 是 Jupyter Notebook 的增强版本。JupyterLab 于 2018 年推出,提供了一个更强大和灵活的环境,用于处理笔记本和其他文件类型。它提供了一个模块化、可扩展和可定制的界面,用户可以在其中并排排列多个窗口(例如笔记本、文本编辑器、终端),从而促进更高效的工作流程。

您可以像这样从终端在计算机上启动笔记本服务器:

jupyter notebook

您应该看到您的浏览器打开一个新标签页,显示类似这样的 Jupyter 笔记本:

图 3.1:带有 LangChain 代理的 Jupyter Notebook。

或者,我们也可以使用 JupyterLab,这是下一代带来显著改进的笔记本服务器。您可以像这样从终端启动 JupyterLab 笔记本服务器:

jupyter lab

我们应该看到类似这样的东西:

图 3.2:带有 LangChain 代理的 Jupyter Lab。

Jupyter notebook或JupyterLab中的任何一个都将为您提供一个集成开发环境(IDE),用于处理本书中将介绍的一些代码。安装 Python 和笔记本或实验室后,让我们快速探讨依赖管理工具(Docker、Conda、Pip和Poetry)之间的区别,并使用它们完全设置我们的环境,以便在 LangChain 项目中进行工作!

环境管理

在我们探索为在LangChain中使用生成模型设置 Python 环境的各种方法之前,了解主要依赖管理工具之间的区别是至关重要的:Docker、Conda、Pip和Poetry。这四个工具在软件开发和部署领域被广泛使用。

Docker 是一个提供操作系统级虚拟化的开源平台,通过容器化自动化应用程序的部署。它在安装了 Docker 的任何系统上都可以一致地运行轻量级、可移植的容器内的应用程序。

Conda 是一个跨平台的包管理器,擅长安装和管理来自多个渠道的软件包,不仅限于 Python。主要面向数据科学和机器学习项目,它可以强大地处理复杂的依赖关系树,满足具有大量依赖关系的复杂项目的需求。

Pip 是 Python 最常用的包管理器,允许用户轻松安装和管理第三方库。然而,Pip 在处理复杂依赖关系时存在局限性,增加了在安装包时出现依赖冲突的风险。

Poetry 是一个较新的包管理器,结合了 Pip 和 Conda 的最佳特性。拥有现代直观的界面、强大的依赖解析系统以及支持创建虚拟环境,Poetry 提供了额外的功能,如依赖隔离、锁定文件和版本控制。

诗歌和 Conda 都简化了虚拟环境管理,而使用 Pip 通常涉及使用类似 virtualenv 的单独工具。这里推荐使用 Conda 进行安装。我们也会为 Pip 提供一个 requirements 文件以及 Poetry 的说明,但在某些情况下可能需要进行一些调整。我们将依次使用这些不同的工具进行安装。对于所有的说明,请确保您已经下载了本书的存储库(使用 Github 用户界面)或在您的计算机上克隆,并且已经切换到项目的根目录。以下是您在 Github 上找到下载选项的方法:

图 3.3:Github 用户界面(UI)中的下载选项。

如果您是 git 的新手,您可以按下 Download ZIP,然后使用您喜欢的工具解压缩存档。或者,使用 git 克隆存储库并切换到项目目录,您可以输入以下命令:

git clone https://github.com/benman1/generative_ai_with_langchain.git

cd generative_ai_with_langchain

现在我们在计算机上有了存储库,让我们从 Docker 开始吧!

Docker

Docker 是一个平台,使开发人员能够自动化部署、打包和管理应用程序。Docker 使用容器化技术,有助于标准化和隔离环境。使用容器的优势在于它保护您的本地环境免受您在容器内运行的任何 - 可能不安全的 - 代码的影响。缺点是镜像可能需要一些时间来构建,并且可能需要大约 10 千兆字节的存储容量。与其他环境管理工具类似,Docker 很有用,因为您可以为项目创建一个可重现的环境。您可以使用 Docker 创建一个包含您项目所需的所有库和工具的环境,并与他人共享该环境。要开始使用 Docker,请按照以下步骤进行:

-

在您的计算机上安装 Docker。您可以在您的网络浏览器中转到 Docker 网站,并按照此处的安装说明进行操作:

docs.docker.com/get-docker/ -

在终端中运行以下命令构建 Docker 镜像(请注意:您需要在项目根目录中才能正常工作)。

docker build -t langchain_ai

这将从 Docker Hub 拉取 continuumio/miniconda3 镜像,并构建镜像。

- 使用创建的镜像交互式地启动 Docker 容器:

docker run -it langchain_ai

这将在容器内启动我们的笔记本。我们应该能够从浏览器中导航到Jupyter Notebook。我们可以在此地址找到它:http://localhost:8080/接下来让我们看看 conda。

Conda

Conda 允许用户为不同项目管理多个环境。它适用于 Python、R 和其他语言,并通过维护与 Python 库相关的库列表来帮助安装系统库。开始使用 conda 的最佳方法是按照此链接中的说明安装 anaconda 或 miniconda:docs.continuum.io/anaconda/install/虽然 conda 环境占用的磁盘空间比 Docker 少,但从 anaconda 开始,完整环境仍然需要大约 2.5 千兆字节。miniconda 设置可能会节省一些磁盘空间。还有一个图形界面可以使用 conda,Anaconda Navigator,可以安装在 macOS 和 Windows 上,并且可以从终端安装任何依赖项以及 conda 工具。让我们继续使用 conda 工具并安装本书的依赖项。要创建一个新环境,请执行以下命令:

conda env create --file langchain_ai.yml

Conda允许我们创建具有许多不同库的环境,还可以使用不同版本的 Python。我们在本书中一直使用 Python 3.10。通过运行以下命令激活环境:

conda activate langchain_ai

这就是全部,我们完成了。我们可以看到这应该是轻松和直接的。您现在可以在环境中启动jupyter notebook或jupyter lab,例如:

jupyter notebook

让我们来看一下 pip,这是conda的一个替代方案。

Pip

Pip是 Python 的默认软件包管理器。它允许您轻松安装和管理第三方库。我们可以安装单个库,还可以维护完整的 Python 库列表。如果它尚未包含在您的 Python 发行版中,请按照pip.pypa.io/上的说明安装 pip。要使用 pip 安装库,请使用以下命令。例如,要安装 NumPy 库,您将使用以下命令:

pip install numpy

您也可以使用pip来安装库的特定版本。例如,要安装 NumPy 库的 1.0 版本,您将使用以下命令:

pip install numpy==1.0

为了设置一个完整的环境,我们可以从一个要求列表开始 - 按照惯例,这个列表在一个名为requirements.txt的文件中。我已经将这个文件包含在项目的根目录中,列出了所有必要的库。您可以使用以下命令安装所有库:

pip install -r requirements.txt

请注意,正如前面提到的,Pip 不负责环境。Virtualenv 是一个可以帮助维护环境的工具,例如不同版本的库。让我们快速看一下这个:

# create a new environment myenv:

virtualenv myenv

# activate the myenv environment:

source myenv/bin/activate

# install dependencies or run python, for example:

python

# leave the environment again:

deactivate

Please note that in Windows, the activation command is slightly different – you'd run a shell script:

# activate the myenv environment:

myenv\Scripts\activate.bat

接下来让我们来看一下 Poetry。

Poetry

Poetry 是 Python 的依赖管理工具,简化了库的安装和版本控制。安装和使用都很简单,我们将看到。以下是 poetry 的快速概述:

-

按照

python-poetry.org/上的说明安装 poetry -

在终端中运行

poetry install(从之前提到的项目根目录)

该命令将自动创建一个新环境(如果您尚未创建),并安装所有依赖项。这就完成了 Poetry 的设置。现在我们将开始使用模型提供程序。

模型集成

在正式开始生成式人工智能之前,我们需要设置访问大型语言模型(LLMs)或文本到图像模型等模型的访问权限,以便将它们集成到我们的应用程序中。正如在第一章中讨论的生成模型是什么中所述,各大科技巨头都有各种LLMs,如OpenAI的GPT-4,Google的BERT和PaLM-2,Meta AI的LLaMA等等。借助LangChain的帮助,我们可以与所有这些模型进行交互,例如通过应用程序编程接口(APIs),或者我们可以调用我们在计算机上下载的开源模型。其中一些集成支持文本生成和嵌入。在本章中,我们将重点讨论文本生成,并在第五章中讨论嵌入、向量数据库和神经搜索,构建类似 ChatGPT 的聊天机器人。有许多模型托管提供商。目前,OpenAI、Hugging Face、Cohere、Anthropic、Azure、Google Cloud Platform Vertex AI(PaLM-2)和Jina AI是LangChain支持的众多提供商之一,但这个列表一直在不断增长。您可以在integrations.langchain.com/llms查看所有支持的LLMs的集成。至于图像模型,主要开发者包括OpenAI(DALL-E)、Midjourney 公司(Midjourney)和 Stability AI(Stable Diffusion)。LangChain目前没有直接处理非文本模型的功能,但其文档描述了如何与 Replicate 合作,后者也提供了与 Stable Diffusion 模型交互的接口。对于这些提供商中的每一个,要调用他们的应用程序编程接口(API),您首先需要创建一个帐户并获取一个 API 密钥。这对所有人都是免费的。有些提供商甚至不需要您提供信用卡信息。为了在环境中设置 API 密钥,在 Python 中我们可以这样做:

import os

os.environ["OPENAI_API_KEY"] = "<your token>"

这里OPENAI_API_KEY是适用于 OpenAI 的环境密钥。将密钥设置在您的环境中的好处是我们不需要将它们包含在我们的代码中。您也可以像这样从终端暴露这些变量:

export OPENAI_API_KEY=<your token>

让我们依次介绍一些知名的模型提供商。我们将为每个模型提供一个示例用法。让我们从一个用于测试的 Fake LLM 开始,以便展示基本思想!

Fake LLM

Fake LM 是用于测试的。LangChain 文档中有一个关于该工具与 LLMs 一起使用的示例。您可以直接在 Python 中执行此示例,也可以在笔记本中执行。

from langchain.llms.fake import FakeListLLM

from langchain.agents import load_tools

from langchain.agents import initialize_agent

from langchain.agents import AgentType

tools = load_tools(["python_repl"])

responses = ["Action: Python_REPL\nAction Input: print(2 + 2)", "Final Answer: 4"]

llm = FakeListLLM(responses=responses)

agent = initialize_agent(

tools, llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

agent.run("whats 2 + 2")

我们连接了一个工具,一个名为 Python Read-Eval-Print Loop(REPL)的工具,根据LLM的输出来调用。虚拟列表LLM将给出两个响应,responses,这些响应不会根据输入而改变。我们设置了一个代理,根据我们在第二章中解释的 ReAct 策略做出决策,这个策略是基于 LangChain 的介绍(ZERO_SHOT_REACT_DESCRIPTION)。我们用一个文本运行代理,问题是“2 + 2 等于多少”。我们可以观察到虚拟 LLM 的输出如何导致调用 Python 解释器,后者返回 4。请注意,操作必须与工具的name属性匹配,即PythonREPLTool,它的启动方式如下:

class PythonREPLTool(BaseTool):

"""A tool for running python code in a REPL."""

name = "Python_REPL"

description = (

"A Python shell. Use this to execute python commands. "

"Input should be a valid python command. "

"If you want to see the output of a value, you should print it out "

"with `print(...)`."

)

工具的名称和描述被传递给LLM,然后根据提供的信息做出决定。Python 解释器的输出被传递给虚拟LLM,后者忽略观察结果并返回 4。显然,如果我们将第二个响应更改为“最终答案:5”,代理的输出将不对应问题。在接下来的章节中,我们将通过使用一个真实的LLM而不是一个虚假的LLM来使这更有意义。目前,任何人首先会想到的提供者之一是 OpenAI。

OpenAI

如第一章中所解释的,生成模型是什么?,OpenAI 是一家美国人工智能研究实验室,目前是生成式人工智能模型的市场领导者,尤其是 LLM。他们提供一系列不同功率级别的模型,适用于不同的任务。在本章中,我们将看到如何使用LangChain和 OpenAI Python 客户端库与 OpenAI 模型进行交互。OpenAI 还为文本嵌入模型提供了一个 Embedding 类。我们将主要用 OpenAI 进行我们的应用。有几种模型可供选择 - 每个模型都有自己的优点、令牌使用计数和用例。主要的 LLM 模型是 GPT-3.5 和 GPT-4,具有不同的令牌长度。你可以在openai.com/pricing看到不同模型的定价。我们首先需要获取一个 OpenAI API 密钥。要创建 API 密钥,请按照以下步骤操作:

-

你需要在

platform.openai.com/创建一个登录账号。 -

设置你的账单信息。

-

你可以在个人 -> 查看 API 密钥下看到API 密钥。

-

点击创建新的秘密密钥并给它一个名称。

这是在 OpenAI 平台上的样子:

图 3.4:OpenAI API 平台 - 创建新的秘密密钥。

点击“创建秘钥”后,您应该会看到消息“API 秘钥已生成”。您需要将该秘钥复制到剪贴板并保存。我们可以将该秘钥设置为环境变量(OPENAI_API_KEY),或者在每次构建 OpenAI 调用类时作为参数传递。我们可以使用OpenAI语言模型类来建立一个LLM以进行交互。让我们创建一个使用这个模型进行计算的代理 - 我省略了前一个示例中的导入部分:

from langchain.llms import OpenAI

llm = OpenAI(temperature=0., model="text-davinci-003")

agent = initialize_agent(

tools, llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

agent.run("whats 4 + 4")

我们应该看到以下输出:

> Entering new chain...

I need to add two numbers

Action: Python_REPL

Action Input: print(4 + 4)

Observation: 8

Thought: I now know the final answer

Final Answer: 4 + 4 = 8

> Finished chain.

'4 + 4 = 8'

这看起来相当有前途,我认为。让我们继续前往下一个提供商和更多示例!

Hugging Face

Hugging Face 是自然语言处理领域中非常重要的参与者,在开源和托管解决方案方面具有相当大的影响力。该公司是一家美国公司,开发用于构建机器学习应用程序的工具。其员工开发和维护 Transformers Python 库,用于自然语言处理任务,包括 BERT 和 GPT-2 等最先进和流行的模型的实现,并兼容PyTorch、TensorFlow和JAX。Hugging Face 还提供 Hugging Face Hub,这是一个托管基于 Git 的代码存储库、机器学习模型、数据集和 Web 应用程序的平台,提供超过 12 万个模型、2 万个数据集和 5 万个演示应用程序(Spaces)供机器学习使用。这是一个在线平台,人们可以在此协作并共同构建机器学习。这些工具允许用户加载和使用来自 Hugging Face 的模型、嵌入和数据集。例如,HuggingFaceHub集成提供了访问不同模型的功能,如文本生成和文本分类。HuggingFaceEmbeddings集成允许用户使用句子转换模型。他们在其生态系统中还提供了其他各种库,包括用于数据集处理的 Datasets,用于模型评估的Evaluate,用于模拟的Simulate,以及用于机器学习演示的Gradio。除了他们的产品,Hugging Face 还参与了一些倡议,如 BigScience 研究研讨会,他们发布了一个名为 BLOOM 的开放大型语言模型,拥有 1760 亿个参数。他们获得了大量资金,包括 4 亿美元的 B 轮融资和最近由 Coatue 和 Sequoia 领投的 C 轮融资,估值 20 亿美元。Hugging Face 还与 Graphcore 和亚马逊网络服务等公司合作,优化其产品并使其面向更广泛的客户群体。要将 Hugging Face 用作您模型的提供商,您可以在huggingface.co/settings/profile上创建帐户和 API 秘钥。您可以将令牌作为HUGGINGFACEHUB_API_TOKEN在您的环境中使用。让我们看一个示例,我们使用了由 Google 开发的开源模型 Flan-T5-XXL:

from langchain.llms import HuggingFaceHub

llm = HuggingFaceHub(

model_kwargs={"temperature": 0.5, "max_length": 64},

repo_id="google/flan-t5-xxl"

)

prompt = "In which country is Tokyo?"

completion = llm(prompt)

print(completion)

我们得到了回应"japan"。LLM接受文本输入,本例中是一个问题,并返回一个完成。该模型具有大量知识,可以回答知识性问题。我们还可以得到简单的建议:

Azure

由微软运行的云计算平台 Azure 与 OpenAI 集成,提供强大的语言模型,如 GPT-3、Codex 和 Embeddings。它通过全球数据中心提供访问、管理和开发应用程序和服务,用例包括写作辅助、摘要、代码生成和语义搜索。它提供软件即服务(SaaS)、平台即服务(PaaS)和基础设施即服务(IaaS)等功能。通过 Github 或微软凭据进行身份验证,我们可以在azure.microsoft.com/上创建 Azure 账户。然后可以在Cognitive Services -> Azure OpenAI下创建新的 API 密钥。这涉及到一些步骤,个人而言,我觉得这个过程很烦人和令人沮丧,所以我放弃了。设置完成后,模型应该可以通过LangChain中的AzureOpenAI() llm 类访问。

Google Cloud

通过Google Cloud Platform(GCP)和其机器学习平台 Vertex 提供许多模型和功能。Google Cloud 提供访问LLM,如LaMDA、T5和PaLM。Google 还更新了 Google Cloud 自然语言(NL)API,使用基于 LLM 的新模型进行内容分类。这个更新版本提供了一个广泛的预训练分类分类法,以帮助广告定位和基于内容的过滤。NL API 的改进 v2 分类模型增加了超过 1,000 个标签,并支持 11 种语言,具有更高的准确性。对于 GCP 中的模型,您需要安装 gcloud 命令行界面(CLI)。您可以在这里找到说明:cloud.google.com/sdk/docs/install然后可以通过终端使用以下命令进行身份验证并打印一个密钥令牌:

gcloud auth application-default login

您还需要为您的项目启用 Vertex。如果您还没有启用它,您应该会收到一个有用的错误消息,指向正确的网站,在那里您必须点击"启用"。让我们运行一个模型!

from langchain.llms import VertexAI

from langchain import PromptTemplate, LLMChain

template = """Question: {question}

Answer: Let's think step by step."""

prompt = PromptTemplate(template=template, input_variables=["question"])

llm = VertexAI()

llm_chain = LLMChain(prompt=prompt, llm=llm, verbose=True)

question = "What NFL team won the Super Bowl in the year Justin Beiber was born?"

llm_chain.run(question)

我们应该看到这个回应:

[1m> Entering new chain...[0m

Prompt after formatting:

[[Question: What NFL team won the Super Bowl in the year Justin Beiber was born?

Answer: Let's think step by step.[0m

[1m> Finished chain.[0m

Justin Beiber was born on March 1, 1994\. The Super Bowl in 1994 was won by the San Francisco 49ers.

我已将 verbose 设置为 True,以便查看模型的推理过程。令人印象深刻的是,即使给出了名字的拼写错误,它也能给出正确的回应。逐步提示指导是得出正确答案的关键。在 Vertex 中有各种模型可用,例如:

| 模型 | 描述 | 属性 |

|---|---|---|

| text-bison | 经过微调以遵循自然语言指令 | 最大输入标记数:8,192 最大输出标记数:1,024 训练数据:截至 2023 年 2 月 |

| chat-bison | 专为多轮对话而调整 | 最大输入标记:4,096 最大输出标记:1,024 训练数据:截至 2023 年 2 月 最大轮数:2,500 |

| code-bison | 专为根据自然语言描述生成代码而调整 | 最大输入标记:4,096 最大输出标记:2,048 |

| codechat-bison | 专为帮助解决与代码相关问题的聊天机器人对话而调整 | 最大输入标记:4,096 最大输出标记:2,048 |

| code-gecko | 专为建议代码完成而调整 | 最大输入标记:2,048 最大输出标记:64 |

表 3.1:Vertex Generative AI 中可用的模型。您可以查看文档cloud.google.com/vertex-ai/docs/generative-ai。我们还可以生成代码。让我们看看Code-Bison模型是否能解决 FizzBuzz,这是入门和中级软件开发人员职位常见的面试问题:

question = """

Given an integer n, return a string array answer (1-indexed) where:

answer[i] == "FizzBuzz" if i is divisible by 3 and 5.

answer[i] == "Fizz" if i is divisible by 3.

answer[i] == "Buzz" if i is divisible by 5.

answer[i] == i (as a string) if none of the above conditions are true.

"""

llm = VertexAI(model_name="code-bison")

llm_chain = LLMChain(prompt=prompt, llm=llm)

print(llm_chain.run(question))

我们得到这个响应:

答案 = []

for i in range(1, n + 1):

如果 i % 3 == 0 并且 i % 5 == 0:

答案.append("FizzBuzz")

否则如果 i % 3 == 0:

答案.append("Fizz")

否则如果 i % 5 == 0:

答案.append("Buzz")

否则:

答案.append(str(i))

返回答案

你会雇用代码-野牛加入你的团队吗?

Anthropic

Anthropic 是一家总部位于美国的人工智能初创公司和公益公司。它由 OpenAI 的前成员,包括兄弟达尼埃拉·阿莫代和达里奥·阿莫代于 2021 年创立。该公司专注于开发通用人工智能系统和语言模型,重点关注负责任的人工智能使用。截至 2023 年 7 月,Anthropic 已筹集了 15 亿美元的资金。他们还致力于项目,如 Claude,一个类似于 OpenAI 的 ChatGPT 的 AI 聊天机器人,并对机器学习系统的可解释性进行研究,特别是变压器架构。不幸的是,Claude 目前尚不向普通公众开放。您需要申请访问权限以使用 Claude 并设置ANTHROPIC_API_KEY环境变量。

Jina AI

Jina AI 成立于 2020 年 2 月,由韩潇和何选斌创立,是一家总部位于柏林的德国人工智能公司,专注于提供基于云原生的神经搜索解决方案,涵盖文本、图像、音频和视频模型。他们的开源神经搜索生态系统使企业和开发人员能够轻松构建可扩展且高可用的神经搜索解决方案,实现高效的信息检索。最近,Jina AI推出了Finetuner,这是一款工具,可以对任何深度神经网络进行特定用例和需求的微调。该公司通过三轮融资共筹集了 3750 万美元,最近一轮融资是在 2021 年 11 月的 A 轮融资中获得的。Jina AI的知名投资者包括GGV Capital和Canaan Partners。您可以在cloud.jina.ai/上设置登录。在该平台上,我们可以为不同用例设置 API,如图像描述、文本嵌入、图像嵌入、视觉问答、视觉推理、图像放大或中文文本嵌入。在这里,我们正在设置一个视觉问答 API,并使用推荐的模型:

图 3.5:Jina AI 中的视觉问答 API。

我们可以在 Python 和 cURL 中获取客户端调用的示例,以及一个演示,我们可以提出问题。这很酷,不幸的是,这些 API 目前还不能通过LangChain使用。我们可以通过在LangChain中将LLM类子类化为自定义LLM接口来实现这些调用。让我们再设置一个聊天机器人,这次由 Jina AI 提供支持。我们可以生成 API 令牌,并将其设置为JINA_AUTH_TOKEN,在chat.jina.ai/api上设置。让我们在这里将英语翻译成法语:

from langchain.chat_models import JinaChat

from langchain.schema import HumanMessage

chat = JinaChat(temperature=0.)

messages = [

HumanMessage(

content="Translate this sentence from English to French: I love generative AI!"

)

]

chat(messages)

We should be seeing

AIMessage(content="J'adore l'IA générative !", additional_kwargs={}, example=False).

我们可以设置不同的温度,低温会使响应更可预测。在这种情况下,几乎没有什么区别。我们将以系统消息开始对话,澄清聊天机器人的目的。让我们询问一些食物推荐:

chat = JinaChat(temperature=0.)

chat(

[

SystemMessage(

content="You help a user find a nutritious and tasty food to eat in one word."

),

HumanMessage(

content="I like pasta with cheese, but I need to eat more vegetables, what should I eat?"

)

]

)

我在 Jupyter 中看到了这个响应:

AIMessage(content='A tasty and nutritious option could be a vegetable pasta dish. Depending on your taste, you can choose a sauce that complements the vegetables. Try adding broccoli, spinach, bell peppers, and zucchini to your pasta with some grated parmesan cheese on top. This way, you get to enjoy your pasta with cheese while incorporating some veggies into your meal.', additional_kwargs={}, example=False)

它忽略了单词指令,但我实际上很喜欢阅读这些想法。我想我可以尝试这个给我儿子。在其他聊天机器人中,我得到了 Ratatouille 的建议。了解 LangChain 中 LLMs 和 Chat Models 之间的区别很重要。LLMs 是文本完成模型,接受字符串提示作为输入,并输出字符串完成。Chat Models 类似于 LLMs,但专门设计用于对话。它们接受带有讲话者标签的聊天消息列表作为输入,并返回聊天消息作为输出。LLMs 和 Chat Models 都实现了 Base Language Model 接口,其中包括predict()和predict_messages()等方法。这种共享接口允许在应用程序中以及 Chat 和 LLM 模型之间实现不同类型模型的互换。

复制

成立于 2019 年的 Replicate Inc.是一家总部位于旧金山的初创公司,为人工智能开发者提供了一个简化的流程,他们可以通过利用云技术以最少的代码输入实现和发布人工智能模型。该平台可以与私有模型和公共模型一起工作,并实现模型推理和微调。该公司最近一轮融资来自一笔总额为 1250 万美元的 A 轮融资,由 Andreessen Horowitz 领投,Y Combinator、Sequoia 以及各种独立投资者参与其中。Ben Firshman 曾在 Docker 负责开源产品工作,Andreas Jansson 曾是 Spotify 的前机器学习工程师,他们共同创立了 Replicate Inc.,共同的愿景是消除阻碍人工智能大规模接受的技术障碍。因此,他们创建了 Cog,这是一个开源工具,可以将机器学习模型打包成标准的生产就绪容器,可以在任何当前操作系统上运行,并自动生成 API。这些容器也可以通过 Replicate 平台部署在 GPU 集群上。因此,开发者可以集中精力进行其他重要任务,从而提高他们的生产力。您可以在replicate.com/上使用您的 Github 凭据进行身份验证。然后,如果您点击左上角的用户图标,您会找到 API 令牌 - 只需复制 API 密钥并在您的环境中提供REPLICATE_API_TOKEN。为了运行更大的作业,您需要设置您的信用卡(在账单下)。您可以在replicate.com/explore找到许多可用的模型。这里有一个创建图像的简单示例:

from langchain.llms import Replicate

text2image = Replicate(

model="stability-ai/stable-diffusion:db21e45d3f7023abc2a46ee38a23973f6dce16bb082a930b0c49861f96d1e5bf",

input={"image_dimensions": "512x512"},

)

image_url = text2image("a book cover for a book about creating generative ai applications in Python")

我得到了这张图片:

图 3.7:一本关于使用 Python 进行生成式人工智能的书籍封面 - Stable Diffusion。

我认为这是一幅不错的图像 - 那是一个创作艺术的 AI 芯片吗?让我们快速看看如何在 Huggingface transformers 或 Llama.cpp 中本地运行模型!

本地模型

我们也可以从 LangChain 运行本地模型。在此之前,我想先提醒一下:LLM 很大,这意味着它会占用很多空间。如果您有一台旧电脑,您可以尝试托管服务,如 google colabs。这些服务可以让您在具有大量内存和不同硬件(包括 Tensor 处理单元(TPUs)或 GPU)的机器上运行。由于这两种用例可能需要很长时间才能运行或导致 Jupyter 笔记本崩溃,我没有在笔记本中包含此代码或在设置说明中包含依赖项。但我认为在这里讨论它仍然是值得的。本地运行模型的优势是完全控制模型,不会在互联网上传输任何数据。让我们首先看看 Hugging Face 的 transformers 库。

Hugging Face transformers

我将快速展示设置和运行流水线的一般步骤:

from transformers import pipeline

import torch

generate_text = pipeline(

model="aisquared/dlite-v1-355m",

torch_dtype=torch.bfloat16,

trust_remote_code=True,

device_map="auto",

framework="pt"

)

generate_text("In this chapter, we'll discuss first steps with generative AI in Python.")

这个模型非常小(3.55 亿个参数),但相对性能良好,并且针对对话进行了调整。请注意,对于本地模型,我们不需要 API 令牌!这将下载模型所需的一切,如分词器和模型权重。然后我们可以运行文本完成以为本章提供一些内容。为了将此流水线插入 LangChain 代理或链中,我们可以像之前看到的那样使用它:

from langchain import PromptTemplate, LLMChain

template = """Question: {question}

Answer: Let's think step by step."""

prompt = PromptTemplate(template=template, input_variables=["question"])

llm_chain = LLMChain(prompt=prompt, llm=generate_text)

question = "What is electroencephalography?"

print(llm_chain.run(question))

在这个示例中,我们还看到了使用PromptTemplate的示例,为任务提供具体的指令。接下来让我们来看看 Llama.cpp。

Llama.cpp

Llama.cpp 是一个 C++程序,执行基于 Llama 架构的模型,Llama 是 Meta AI 发布的第一个大型开源模型之一,随后衍生出许多其他模型的开发。请注意,您需要安装 md5 校验工具。这在几个 Linux 发行版中默认包含,如 Ubuntu。在 MacOs 上,您可以像这样使用 brew 安装:

brew install md5sha1sum

我们需要从 Github 下载 llama.cpp 存储库。您可以在线选择 Github 上的下载选项之一进行此操作,或者您可以从终端使用 git 命令,如下所示:

git clone https://github.com/ggerganov/llama.cpp.git

然后我们需要安装 python 要求,可以使用 pip 软件包安装程序来完成 - 为了方便起见,让我们也切换到 llama.cpp 项目根目录:

cd llama.cpp

pip install -r requirements.txt

您可能希望在安装要求之前创建一个 Python 环境 - 但这取决于您。现在我们需要编译 llama.cpp:

make -C . -j4 # runs make in subdir with 4 processes

我们可以使用 4 个进程并行构建。为了获得 Llama 模型权重,您需要注册并等待来自 Meta 的注册电子邮件。有一些工具,比如 pyllama 项目中的 llama 模型下载器,但请注意它们可能不符合 Meta 的许可规定。您可以从 Hugging Face 下载模型 - 这些模型应与 llama.cpp 兼容,比如 Vicuna 或 Alpaca。假设您已将 7B Llama 模型的模型权重下载到 models/7B 目录中。您可以下载更大尺寸的模型,如 13B、30B、65B,但是这里需要注意一点:这些模型在内存和磁盘空间方面都相当大。我们需要将模型转换为 llama.cpp 格式,称为ggml,使用转换脚本。然后我们可以选择对模型进行量化,以节省推理时的内存。量化是指减少用于存储权重的位数。

python3 convert.py models/7B/

./quantize ./models/ggml-model-f16.bin ./models/7B/ggml-model-q4_0.bin q4_0

这个最后的文件比之前的文件要小得多,在内存中占用的空间也要少得多,这意味着您可以在较小的机器上运行它。一旦我们选择了要运行的模型,我们可以将其集成到代理或链中,例如:

llm = LlamaCpp(

model_path="./ggml-model-q4_0.bin",

verbose=True

)

这结束了模型提供者的介绍。让我们构建一个应用程序!

客户服务助手

在本节中,我们将在 LangChain 中为客服代理构建一个文本分类应用程序。给定一个文档,比如一封电子邮件,我们希望将其分类为与意图相关的不同类别,提取情感,并提供摘要。客服代理负责回答客户查询,解决问题和处理投诉。他们的工作对于维护客户满意度和忠诚度至关重要,这直接影响公司的声誉和财务成功。生成式人工智能可以在几个方面帮助客服代理:

-

情感分类:这有助于识别客户情绪,并允许代理个性化回应。

-

摘要:这使代理能够理解冗长客户消息的要点并节省时间。

-

意图分类:类似于摘要,这有助于预测客户的目的,并允许更快地解决问题。

-

答案建议:这为代理提供了对常见查询的建议响应,确保提供准确和一致的消息。

这些方法的结合可以帮助客服代理更准确地并及时地回应,最终提高客户满意度。在这里,我们将集中讨论前三点。我们将记录查找,这可以用于答案建议在第五章,构建类似 ChatGPT 的聊天机器人。LangChain是一个非常灵活的库,具有许多集成,可以使我们解决各种文本问题。我们可以在执行这些任务时选择许多不同的集成。我们可以要求任何 LLM 为我们提供一个开放域(任何类别)分类或在多个类别之间进行选择。特别是由于它们的大训练规模,LLMs 是非常强大的模型,特别是在给定少量提示的情况下,用于情感分析,不需要任何额外的训练。这是由 Zengzhi Wang 等人在他们 2023 年 4 月的研究“ChatGPT 是一个好的情感分析器吗?初步研究”中分析的。对于情感分析的 LLM 的提示可能是这样的:

Given this text, what is the sentiment conveyed? Is it positive, neutral, or negative?

Text: {sentence}

Sentiment:

LLMs 在摘要方面也非常有效,比以往任何模型都要好。缺点可能是这些模型调用比传统的 ML 模型慢,成本更高。如果我们想尝试更传统或更小的模型。Cohere 和其他提供商将文本分类和情感分析作为其功能的一部分。例如,NLP Cloud 的模型列表包括 spacy 和许多其他模型:docs.nlpcloud.com/#models-list许多 Hugging Face 模型支持这些任务,包括:

-

文档问答

-

摘要

-

文本分类

-

文本问答

-

翻译

我们可以在本地执行这些模型,通过在 transformer 中运行pipeline,在 Hugging Face Hub 服务器上远程执行(HuggingFaceHub),或者作为load_huggingface_tool()加载器的工具。Hugging Face 包含了成千上万的模型,许多经过特定领域微调。例如,ProsusAI/finbert是一个在 Financial PhraseBank 数据集上训练的 BERT 模型,可以分析金融文本的情感。我们也可以使用任何本地模型。对于文本分类,模型往往要小得多,因此这对资源的消耗会较小。最后,文本分类也可能是嵌入的一个案例,我们将在第五章,构建类似 ChatGPT 的聊天机器人中讨论。我决定尽可能多地使用我在 Hugging Face 上找到的较小模型来进行这个练习。我们可以通过 huggingface API 列出 Hugging Face Hub 上用于文本分类的下载量最高的 5 个模型:

def list_most_popular(task: str):

for rank, model in enumerate(

list_models(filter=task, sort="downloads", direction=-1)

):

if rank == 5:

break

print(f"{model.id}, {model.downloads}\n")

list_most_popular("text-classification")

让我们看看列表:

| 模型 | 下载量 |

|---|---|

| nlptown/bert-base-multilingual-uncased-sentiment | 5805259 |

| SamLowe/roberta-base-go_emotions | 5292490 |

| cardiffnlp/twitter-roberta-base-irony | 4427067 |

| salesken/query_wellformedness_score | 4380505 |

| marieke93/MiniLM-evidence-types | 4370524 |

表 3.2:Hugging Face Hub 上最受欢迎的文本分类模型。我们可以看到这些模型涉及到情感、情绪、讽刺或格式良好等小范围的类别。让我们使用情感模型。

I've asked GPT-3.5 to put together a long rambling customer email complaining about a coffee machine. You can find the email on GitHub. Let's see what our sentiment model has to say:

from transformers import pipeline

sentiment_model = pipeline(

task="sentiment-analysis",

model="nlptown/bert-base-multilingual-uncased-sentiment"

)

print(sentiment_model(customer_email))

我得到了这个结果:

[{'label': '2 stars', 'score': 0.28999224305152893}]

不是一个开心的露营者。让我们继续!让我们也看看最受欢迎的 5 个摘要模型:

| 模型 | 下载量 |

|---|---|

| t5-base | 2710309 |

| t5-small | 1566141 |

| facebook/bart-large-cnn | 1150085 |

| sshleifer/distilbart-cnn-12-6 | 709344 |

| philschmid/bart-large-cnn-samsum | 477902 |

表 3.3:Hugging Face Hub 上最受欢迎的摘要模型。

所有这些模型与大型模型相比具有相对较小的占用空间。让我们在服务器上远程执行摘要模型:

from langchain import HuggingFaceHub

summarizer = HuggingFaceHub(

repo_id="facebook/bart-large-cnn",

model_kwargs={"temperature":0, "max_length":180}

)

def summarize(llm, text) -> str:

return llm(f"Summarize this: {text}!")

summarize(summarizer, customer_email)

请注意,您需要设置您的HUGGINGFACEHUB_API_TOKEN才能使其工作。我看到了这个摘要:一个顾客的咖啡机到达时已经破损,引发了一种深深的不信和绝望感。顾客写道:“这种令人心碎的疏忽行为粉碎了我对每天享受完美咖啡的梦想,让我情感上感到痛苦和无法安慰。”他补充道:“我希望这封邮件能在我写信时内心充满理解的氛围中找到你。”这个摘要还算过得去,但不是很令人信服。摘要中仍然有很多啰嗦的内容。我们可以尝试其他模型,或者直接使用一个带有摘要提示的 LLM。让我们继续。了解客户写的是什么问题可能会很有用。让我们问问VertexAI:

from langchain.llms import VertexAI

from langchain import PromptTemplate, LLMChain

template = """Given this text, decide what is the issue the customer is concerned about. Valid categories are these:

* product issues

* delivery problems

* missing or late orders

* wrong product

* cancellation request

* refund or exchange

* bad support experience

* no clear reason to be upset

Text: {email}

Category:

"""

prompt = PromptTemplate(template=template, input_variables=["email"])

llm = VertexAI()

llm_chain = LLMChain(prompt=prompt, llm=llm, verbose=True)

print(llm_chain.run(customer_email))

我们得到了“产品问题”的反馈,这在我这里使用的长电子邮件示例中是正确的。希望看到我们可以多快地将几个模型和工具组合在一起在 LangChain 中得到实际有用的东西是令人兴奋的。我们可以很容易地将其展示在一个界面中,供客服代理查看。让我们总结一下。

总结

在本章中,我们已经介绍了四种不同的安装 LangChain 和本书所需的其他库的方法作为一个环境。然后,我们介绍了几个文本和图像模型的提供者。对于每一个模型,我们解释了如何获取 API 令牌,并演示了如何调用模型。最后,我们为客服的文本分类开发了一个 LLM 应用程序。通过在 LangChain 中链接各种功能,我们可以帮助减少客服的响应时间,并确保答案准确且切题。在第三章和第四章中,我们将更深入地探讨诸如通过增强检索进行问答等用例,使用工具如网络搜索和依赖文档搜索通过索引的聊天机器人。让我们看看您是否记得本章的一些关键要点!

问题

请看看是否能够回答这些问题。如果您对其中任何问题不确定,我建议您回到本章的相应部分查看:

-

如何安装 LangChain?

-

除了 OpenAI,至少列出 4 家 LLM 的云服务提供商!

-

什么是 Jina AI 和 Hugging Face?

-

如何使用 LangChain 生成图像?

-

如何在本地机器上运行模型,而不是通过服务运行?

-

如何在 LangChain 中执行文本分类?

-

如何通过生成式人工智能帮助客服代理工作?

四、使用工具进行查询

在当今快节奏的商业和研究环境中,跟上不断增长的信息量可能是一项艰巨的任务。对于计算机科学和人工智能等领域的工程师和研究人员来说,保持对最新发展的了解至关重要。然而,阅读和理解大量论文可能是耗时且劳动密集的。这就是自动化发挥作用的地方。在本章中,我们将描述一种自动化研究论文摘要和回答问题的方法,使研究人员更容易消化和保持信息。通过利用语言模型和一系列问题,我们将开发的摘要可以以简洁和简化的格式总结论文的核心论点、含义和机制。这不仅可以节省研究主题时的时间和精力,还可以确保我们能有效地应对科学进步的加速步伐。我们还将尝试使用 OpenAI 模型的功能,并将其应用于信息提取。我们将看到它们如何(或尚未)用于解析简历(CVs)的应用。这个函数语法是特定于 OpenAI 的 API,并且有许多应用,然而,LangChain 提供了一个平台,允许创建用于任何大型语言模型(LLMs)的工具,增强它们的功能。这些工具使 LLMs 能够与 API 交互,访问实时信息,并执行各种任务,如检索搜索、数据库查询、撰写电子邮件,甚至打电话。我们将使用检索增强生成(RAG)实现一个问答应用程序。这是一种通过将相关数据注入上下文来更新大型语言模型(LLMs)如 GPT 的技术。最后,我们将讨论代理的不同决策策略。我们将实现两种策略,即计划和执行(或计划和解决)和一次性代理,并将它们集成到一个可视化界面中,作为浏览器中的可视化应用程序(使用 Streamlit)用于问答。主要部分包括:

-

什么是幻觉?

-

如何总结长篇文档?

-

从文档中提取信息

-

使用工具回答问题

-

推理策略

我们将从讨论 LLMs 的可靠性问题开始。

什么是幻觉?

生成式语言模型(如 GPT-3、Llama 和 Claude 2)的快速发展引起了人们对其局限性和潜在风险的关注。一个主要关注点是幻觉,即模型生成的输出是荒谬的、不连贯的或与提供的输入不符。幻觉在现实世界的应用中,如医学或机器翻译中,会带来性能和安全风险。幻觉的另一个方面是,LLM 生成包含敏感个人信息的文本,如电子邮件地址、电话号码和物理地址。这引发了重大的隐私问题,因为它表明语言模型可以从其训练语料库中记忆和恢复这些私人数据,尽管这些数据不在源输入中。

在 LLM 的背景下,幻觉指的是生成的文本与预期内容不忠实或荒谬的现象。这个术语与心理幻觉类似,涉及感知不存在的事物。在自然语言生成中,幻觉文本可能在提供的上下文中看起来流畅自然,但缺乏特定性或可验证性。忠实性,即生成的内容保持与源内容一致和真实,被认为是幻觉的反义词。

内在幻觉发生在生成的输出与源内容相矛盾时,而外在幻觉涉及生成无法验证或支持的信息。外在幻觉有时可能包含事实正确的外部信息,但其不可验证性引发了从事实安全角度的担忧。

解决幻觉的努力正在进行中,但需要在不同任务之间全面了解,以开发有效的缓解方法。LLM 中的幻觉可能由各种因素引起:

-

编码器的不完美表示学习。

-

错误解码,包括关注源输入的错误部分和解码策略的选择。

-

曝光偏差,即训练和推理时间之间的差异。

-

参数化知识偏见,即预训练模型优先考虑自己的知识而不是输入,导致生成过多的信息。

幻觉缓解方法可以分为两组:数据相关方法和建模与推理方法(根据“自然语言生成中的幻觉调查”,季子伟等人,2022 年):

数据相关方法:

构建忠实数据集:从头开始构建具有干净和忠实目标的数据集,或者在确保语义一致性的同时重写真实句子。

自动清理数据:识别和过滤现有语料库中的不相关或矛盾信息,以减少语义噪音。

信息增强:通过外部信息(如检索的知识或合成数据)增强输入,以改善语义理解并解决源目标分歧。

建模和推理方法:

架构:修改编码器架构以增强语义解释,注意机制以优先处理源信息,解码器结构以减少虚构并强制隐式或显式约束。

训练:结合规划、强化学习(RL)、多任务学习和可控生成技术,通过改善对齐、优化奖励函数和平衡忠实度和多样性来减轻虚构。

后处理:通过生成然后精炼策略或专门用于忠实度的后处理校正方法,纠正输出中的虚构。

虚构的结果是,自动事实核查可以应用,存在传播不正确信息或滥用政治目的的危险。错误信息,包括虚假信息、欺骗性新闻和谣言,对社会构成重大威胁,尤其是通过社交媒体轻松创作和传播内容。社会面临的威胁包括对科学、公共卫生叙事、社会极化和民主进程的不信任。新闻学和档案学已广泛研究了这个问题,事实核查倡议也在应对中不断增长。致力于事实核查的组织为独立事实核查员和记者提供培训和资源,从而扩大专家事实核查工作的规模。解决错误信息对保持信息的完整性和对抗其对社会的有害影响至关重要。在文献中,这种问题被称为文本蕴涵,其中模型预测文本对之间的方向性真实关系(即“句子 t 蕴含 h”如果,通常,阅读 t 的人会推断 h 最有可能是真实的)。在本章中,我们将重点关注通过信息增强和后处理进行自动事实核查。事实可以从 LLMs 或使用外部工具检索。在前一种情况下,预训练语言模型可以取代知识库和检索模块,利用其广泛的知识回答开放域问题,并使用提示检索特定事实。我们可以在这个图表中看到这个一般想法(来源:https://github.com/Cartus/Automated-Fact-Checking-Resources by Zhijiang Guo):

图 4.1:三个阶段的自动事实核查流程。

我们可以区分三个阶段:

-

主张检测 - 识别需要验证的主张

-

检索 - 检索证据���找到支持或反驳主张的来源

-

主张验证 - 根据证据评估主张的真实性

从 2018 年开始使用 24 层 BERT-Large,语言模型已经在大型知识库(如维基百科)上进行了预训练,因此能够从维基百科或其他来源(因为它们的训练集越来越多地包括其他来源)- 互联网、教科书、arxiv 和 Github 回答知识问题。查询事实的工作与简单提示(如掩码提示)一起进行。例如,为了回答问题“微软的总部在哪里?”,问题将被重写为“微软的总部在[MASK]”,然后输入到语言模型中以获取答案。在这种方法中,最终的激活在条件 LLM 接收到源文本(有条件 LLM)产生目标时的损失比未接收源文本的 LLM(无条件 LLM)产生目标时的损失更小,这表明生成的标记是幻觉的(Fillippova, 2020)。幻觉标记与目标标记总数的比率可以作为生成输出中幻觉程度的度量。在 LangChain 中,我们有一个可用于事实核查的链,其中模型通过提示链式提问对陈述中的假设进行主动质疑。在这个自检链中,LLMCheckerChain,模型被依次提示多次,首先明确做出假设 - 看起来像这样:

Here’s a statement: {statement}\nMake a bullet point list of the assumptions you made when producing the above statement.\n

请注意,这是一个字符串模板,其中花括号中的元素将被变量替换。接下来,这些假设将被反馈给模型,以便逐个用类似这样的提示检查它们:

Here is a bullet point list of assertions:

{assertions}

For each assertion, determine whether it is true or false. If it is false, explain why.\n\n

最后,模型被要求做出最终判断:

In light of the above facts, how would you answer the question '{question}'

LLMCheckerChain就像这个例子展示的那样自动完成所有这些。

from langchain.chains import LLMCheckerChain

from langchain.llms import OpenAI

llm = OpenAI(temperature=0.7)

text = "What type of mammal lays the biggest eggs?"

checker_chain = LLMCheckerChain.from_llm(llm, verbose=True)

checker_chain.run(text)

这个模型对这个问题可能会返回不同的结果,其中一些是错误的,而一些则会被正确识别为错误。当我尝试时,我得到了蓝鲸、北美海狸或已灭绝的巨型恐鸟等结果。我认为这是正确答案:

Monotremes, a type of mammal found in Australia and parts of New Guinea, lay the largest eggs in the mammalian world. The eggs of the American echidna (spiny anteater) can grow as large as 10 cm in length, and dunnarts (mouse-sized marsupials found in Australia) can have eggs that exceed 5 cm in length.

• Monotremes can be found in Australia and New Guinea

• The largest eggs in the mammalian world are laid by monotremes

• The American echidna lays eggs that can grow to 10 cm in length

• Dunnarts lay eggs that can exceed 5 cm in length

• Monotremes can be found in Australia and New Guinea – True

• The largest eggs in the mammalian world are laid by monotremes – True

• The American echidna lays eggs that can grow to 10 cm in length – False, the American echidna lays eggs that are usually between 1 to 4 cm in length.

• Dunnarts lay eggs that can exceed 5 cm in length – False, dunnarts lay eggs that are typically between 2 to 3 cm in length.

The largest eggs in the mammalian world are laid by monotremes, which can be found in Australia and New Guinea. Monotreme eggs can grow to 10 cm in length.

> Finished chain.

因此,虽然这并不能保证正确答案,但它可以阻止一些错误结果。至于增强检索(或 RAG),我们在本章中看到了这种方法,在关于问答的部分。事实核查方法涉及将声明分解为更小的可检查查询,这些查询可以被制定为问答任务。专为搜索领域数据集设计的工具可以帮助事实核查人员有效地找到证据。像谷歌和必应这样的现成搜索引擎也可以检索与主题和证据相关的内容,准确捕捉陈述的真实性。在下一节中,我们将应用这种方法基于网络搜索和其他工具返回结果。在下一节中,我们将实现一个链来总结文档。我们可以从这些文档中提出任何问题。

如何总结长篇文档?

在这一部分,我们将讨论自动化长文本和研究论文摘要的过程。在当今快节奏的商业和研究环境中,跟上不断增长的信息量可能是一项艰巨的任务。对于计算机科学和人工智能等领域的工程师和研究人员来说,了解最新发展至关重要。然而,阅读和理解大量论文可能是耗时且劳动密集的。这就是自动化发挥作用的地方。作为工程师,我们受到建设和创新的愿望驱使,通过创建管道和流程来自动化避免重复性任务。这种常被误解为懒惰的方法使工程师能够专注于更复杂的挑战,并更有效地利用他们的技能。在这里,我们将构建一个自动化工具,可以快速以更易消化的格式总结长文本的内容。该工具旨在帮助研究人员跟上每天发表的论文数量,特别是在人工智能等快速发展领域。通过自动化摘要过程,研究人员可以节省时间和精力,同时确保他们了解其领域的最新发展。该工具将基于 LangChain,并利用大型语言模型(LLMs)以更简洁和简化的方式总结论文的核心论点、含义和机制。它还可以回答关于论文的具体问题,使其成为文献综述和加速科学研究的宝贵资源。作者计划进一步开发该工具,以允许自动处理多个文档并针对特定研究领域进行定制。总体而言,该方法旨在通过提供更高效和更易访问的方式帮助研究人员跟上最新研究。LangChain 支持使用 LLMs 处理文档的映射减少方法,这允许对文档进行高效处理和分析。在阅读大文本并将其分割为适合 LLM 令牌上下文长度的文档(块)时,可以将链应用于每个文档,并将输出组合成单个文档。核心论点是映射减少过程涉及两个步骤:

-

映射步骤 - 将 LLM 链应用于每个文档,将输出视为新文档,并

-

减少步骤 - 所有新文档都传递到单独的组合文档链以获得单个输出。

这在这里的图中有所说明:

图 4.2:LangChain 中的映射减少链(来源:LangChain 文档)。

这种方法的影响是它允许对文档进行并行处理,并且使 LLMs 能够用于推理、生成或分析单个文档以及组合它们的输出。该过程的机制涉及压缩或折叠映射文档,以确保它们适合于组合文档链,这可能还涉及利用 LLMs。如果需要,压缩步骤可以递归执行。这里是加载 PDF 文档并对其进行摘要的简单示例:

from langchain.chains.summarize import load_summarize_chain

from langchain import OpenAI

from langchain.document_loaders import PyPDFLoader

pdf_loader = PyPDFLoader(pdf_file_path)

docs = pdf_loader.load_and_split()

llm = OpenAI()

chain = load_summarize_chain(llm, chain_type="map_reduce")

chain.run(docs)

变量pdf_file_path是一个包含 PDF 文件路径的字符串。地图和减少步骤的默认提示是这样的:

Write a concise summary of the following:

{text}

CONCISE SUMMARY:

我们可以为每个步骤指定任何提示。在为本章开发的文本摘要应用程序中,我们可以看到如何传递其他提示。在 LangChainHub 上,我们可以看到 qa-with sources 提示,它采用了一个类似于这样的减少/组合提示:

Given the following extracted parts of a long document and a question, create a final answer with references (\"SOURCES\"). \nIf you don't know the answer, just say that you don't know. Don't try to make up an answer.\nALWAYS return a \"SOURCES\" part in your answer.\n\nQUESTION: {question}\n=========\nContent: {text}

在这个提示中,我们会制定一个具体的问题,但同样我们也可以给 LLM 一个更抽象的指令,以提取假设和推论。文本将是地图步骤的摘要。这样的指令可以帮助防止幻觉。其他指令的例子可能是将文档翻译成另一种语言或以某种风格重新表述。一旦我们开始做很多调用,特别是在地图步骤中,我们会看到成本增加。我们正在做很多调用,并总共使用了很多令牌。是时候让这些变得更加可见了!

令牌使用

在使用模型时,特别是在长循环中,比如在地图操作中,跟踪令牌使用量并了解你花费了多少钱是很重要的。对于任何严肃的生成式人工智能使用,我们需要了解不同语言模型的能力、定价选项和用例。OpenAI 提供不同的模型,包括 GPT-4、ChatGPT 和 InstructGPT,以满足各种自然语言处理需求。GPT-4 是一个强大的语言模型,适用于解决自然语言处理中的复杂问题。它提供基于使用的令牌大小和数量的灵活定价选项。ChatGPT 模型,如 GPT-3.5-Turbo,专门用于对话应用,如聊天机器人和虚拟助手。它们擅长生成准确流畅的回应。ChatGPT 模型的定价基于使用的令牌数量。InstructGPT 模型专为单轮指令跟随而设计,并针对快速准确的响应生成进行了优化。InstructGPT 系列中的不同模型,如 Ada 和 Davinci,提供不同级别的速度和功率。Ada 是最快的模型,适用于速度至关重要的应用,而 Davinci 是最强大的模型,能够处理复杂的指令。InstructGPT 模型的定价取决于模型的能力,从像 Ada 这样的低成本选项到像 Davinci 这样的更昂贵选项。OpenAI 的 DALL·E、Whisper 和 API 服务用于图像生成、语音转录、翻译和访问语言模型。DALL·E 是一种 AI 驱动的图像生成模型,可以无缝集成到应用程序中,用于生成和编辑新颖的图像和艺术品。OpenAI 提供三个分辨率层次,允许用户选择他们需要的细节级别。更高的分辨率提供更复杂和详细的内容,而较低的分辨率提供更抽象的表示。每张图像的价格根据分辨率而变化。Whisper 是一种可以将语音转录为文本并将多种语言翻译成英语的 AI 工具。它有助于捕捉对话,促进交流,并提高跨语言理解。使用 Whisper 的成本基于每分钟的费率。OpenAI 的 API 提供对强大语言模型如 GPT-3 的访问,使开发人员能够创建高级应用程序。在注册 API 时,用户会获得一个初始令牌使用限制,代表在特定时间范围内与语言模型交互的令牌数量。随着用户的记录和使用增加,OpenAI 可能会增加令牌使用限制,为模型提供更多访问权限。用户还可以请求增加配额,如果他们的应用程序需要更多令牌。我们可以通过连接到 OpenAI 回调来跟踪 OpenAI 模型中的令牌使用:

with get_openai_callback() as cb:

response = llm_chain.predict(text=”Complete this text!”)

print(f"Total Tokens: {cb.total_tokens}")

print(f"Prompt Tokens: {cb.prompt_tokens}")

print(f"Completion Tokens: {cb.completion_tokens}")

print(f"Total Cost (USD): ${cb.total_cost}")

在这个例子中,带有llm_chain的行可以是对 OpenAI 模型的任何使用。我们应该看到一个包含成本和令牌的输出。还有另外两种获取令牌使用情况的方法。作为 OpenAI 回调的替代方案,llm类的generate()方法返回一个LLMResult类型的响应,而不是字符串。这包括令牌使用情况和完成原因,例如(来自 LangChain 文档):

input_list = [

{"product": "socks"},

{"product": "computer"},

{"product": "shoes"}

]

llm_chain.generate(input_list)

结果看起来像这样:

LLMResult(generations=[[Generation(text='\n\nSocktastic!', generation_info={'finish_reason': 'stop', 'logprobs': None})], [Generation(text='\n\nTechCore Solutions.', generation_info={'finish_reason': 'stop', 'logprobs': None})], [Generation(text='\n\nFootwear Factory.', generation_info={'finish_reason': 'stop', 'logprobs': None})]], llm_output={'token_usage': {'prompt_tokens': 36, 'total_tokens': 55, 'completion_tokens': 19}, 'model_name': 'text-davinci-003'})

最后,OpenAI API 中的聊天完成响应格式包括一个带有令牌信息的使用对象,例如它可能看起来像这样(摘录):

{

"model": "gpt-3.5-turbo-0613",

"object": "chat.completion",

"usage": {

"completion_tokens": 17,

"prompt_tokens": 57,

"total_tokens": 74

}

}

接下来,我们将看看如何使用 LangChain 中的 OpenAI 函数从文档中提取特定信息。

从文档中提取信息

2023 年 6 月,OpenAI 宣布了 OpenAI API 的更新,包括对函数调用的新功能,这将开启增强功能。开发人员现在可以描述函数给 gpt-4-0613 和 gpt-3.5-turbo-0613 模型,并让模型智能地生成一个包含调用这些函数参数的 JSON 对象。此功能旨在增强 GPT 模型与外部工具和 API 之间的连接,提供一种可靠的方式从模型中检索结构化数据。函数调用使开发人员能够创建能够使用外部工具或 OpenAI 插件回答问题的聊天机器人。它还允许将自然语言查询转换为 API 调用或数据库查询,并从文本中提取结构化数据。更新的机制涉及使用新的 API 参数,即functions,在/v1/chat/completions端点中。函数参数通过名称、描述、参数和要调用的函数本身进行定义。开发人员可以使用 JSON Schema 描述模型的函数,并指定要调用的所需函数。在 LangChain 中,我们可以使用这些函数调用在 OpenAI 中进行信息提取或调用插件。对于信息提取,我们可以从文本和文档中的提取链中使用 OpenAI 聊天模型来指定实体及其属性。例如,这可以帮助识别文本中提到的人物。通过使用 OpenAI 函数参数并指定模式,可以确保模型输出所需的实体和属性及其适当的类型。这种方法的影响是它允许通过定义具有所需属性和类型的模式来精确提取实体。它还可以指定哪些属性是必需的,哪些是可选的。模式的默认格式是字典,但我们也可以在 Pydantic 中定义属性及其类型,提供对提取过程的控制和灵活性。这里是一个关于 Curricum Vitae(简历)中信息的所需模式的示例:

from typing import Optional

from pydantic import BaseModel

class Experience(BaseModel):

start_date: Optional[str]

end_date: Optional[str]

description: Optional[str]

class Study(Experience):

degree: Optional[str]

university: Optional[str]

country: Optional[str]

grade: Optional[str]

class WorkExperience(Experience):

company: str

job_title: str

class Resume(BaseModel):

first_name: str

last_name: str

linkedin_url: Optional[str]

email_address: Optional[str]

nationality: Optional[str]

skill: Optional[str]

study: Optional[Study]

work_experience: Optional[WorkExperience]

hobby: Optional[str]

我们可以利用这个来从简历中提取信息。这里有一个来自github.com/xitanggg/open-resume的示例简历。

图 4.3:示例简历摘录。

我们将尝试从这份简历中解析信息。利用 LangChain 中的create_extraction_chain_pydantic()函数,我们可以将我们的模式作为输入提供,输出将是一个符合它的实例化对象。简单来说,我们可以尝试这段代码片段:

from langchain.chains import create_extraction_chain_pydantic

from langchain.chat_models import ChatOpenAI

from langchain.document_loaders import PyPDFLoader

pdf_loader = PyPDFLoader(pdf_file_path)

docs = pdf_loader.load_and_split()

# please note that function calling is not enabled for all models!

llm = ChatOpenAI(model_name="gpt-3.5-turbo-0613")

chain = create_extraction_chain_pydantic(pydantic_schema=Resume, llm=llm)

return chain.run(docs)

我们应该得到这样的输出:

[Resume(first_name='John', last_name='Doe', linkedin_url='linkedin.com/in/john-doe', email_address='hello@openresume.com', nationality=None, skill='React', study=None, work_experience=WorkExperience(start_date='May 2023', end_date='Present', description='Lead a cross-functional team of 5 engineers in developing a search bar, which enables thousands of daily active users to search content across the entire platform. Create stunning home page product demo animations that drives up sign up rate by 20%. Write clean code that is modular and easy to maintain while ensuring 100% test coverage.', company='ABC Company', job_title='Software Engineer'), hobby=None)]

这还远非完美 - 只有一个工作经验被解析出来。但考虑到我们迄今为止所付出的少量努力,这是一个很好的开始。请查看 Github 上的示例以获取完整示例。我们可以添加更多功能,例如猜测个性或领导能力。OpenAI 将这些函数调用注入到系统消息中,采用一定的语法,这是他们的模型经过优化的。这意味着函数会计入上下文限制,并相应地计入输入令牌。LangChain 本身具有将函数调用注入为提示的功能。这意味着我们可以在 LLM 应用程序中使用除 OpenAI 之外的模型提供者进行函数调用。我们现在将看看这一点,并将其构建为一个带有 Streamlit 的交互式 Web 应用程序。

用工具回答问题

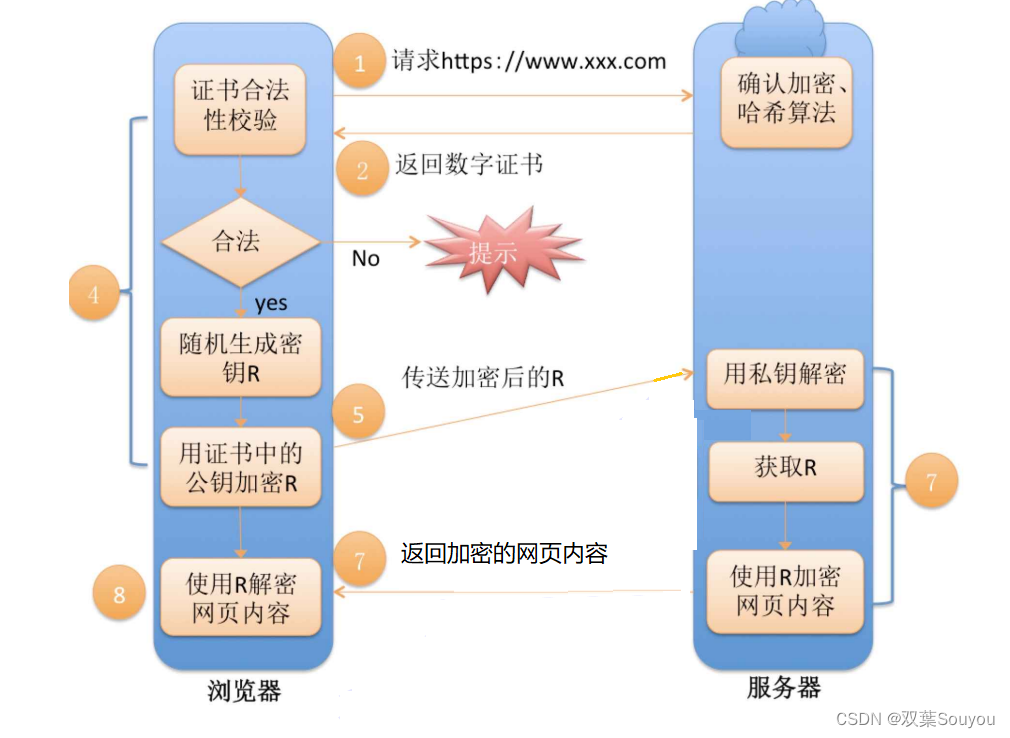

LLMs 是在一般语料库数据上训练的,可能对需要领域特定知识的任务不够有效。单独使用 LLMs 无法与环境互动和访问外部数据源,然而,LangChain 提供了一个平台,用于创建访问实时信息并执行任务的工具,如天气预报、预订、建议食谱和管理任务。代理和链框架内的工具允许开发由 LLMs 驱动的应用程序,这些应用程序具有数据感知和代理性,并且开辟了解决 LLMs 问题的广泛方法,扩展了它们的用例并使其更加多功能和强大。工具的一个重要方面是它们能够在特定领域内工作或处理特定输入。例如,LLM 缺乏固有的数学能力。然而,像计算器这样的数学工具可以接受数学表达式或方程式作为输入并计算结果。LLM 与这样的数学工具结合进行计算并提供准确答案。通常,这种检索方法和 LLMs 的组合被称为检索增强生成(RAG),通过从外部源中检索相关数据并将其注入上下文来解决 LLMs 的限制。这些检索到的数据作为附加信息用于增强提供给 LLMs 的提示。通过通过 RAG 将 LLMs 与用例特定信息联系起来,可以提高响应的质量和准确性。通过检索相关数据,RAG 有助于减少 LLMs 的幻觉响应。例如,在医疗应用中使用的 LLM 可以在推断过程中从外部源(如医学文献或数据库)检索相关医疗信息。然后,这些检索到的数据可以被整合到上下文中,以增强生成的响应并确保它们准确且与领域特定知识一致。在这种情况下实施 RAG 的好处是双重的。首先,尽管模型的训练数据截止日期,它允许将最新信息纳入响应中。这确保用户即使对于最新事件或不断发展的主题也能收到准确和相关的信息。其次,RAG 通过利用外部信息源检索特定上下文,增强了 ChatGPT 提供更详细和上下文答案的能力。通过从新闻文章或与特定主题相关的网站等来源检索特定上下文,响应将更加准确。

RAG(检索增强生成)通过从数据源中检索信息来补充提供给语言模型的提示,为模型提供生成准确响应所需的上下文。RAG 包括几个步骤:

-

提示:用户向聊天机器人提供提示,描述他们对输出的期望。

-

研究:执行上下文搜索并从各种数据源中检索相关信息。这可能涉及查询数据库,根据关键词搜索索引文档,或调用 API 从外部源检索数据。

-

更新资源:检索到的上下文被注入到原始提示中,用额外的事实信息增强它,与用户的查询相关。这种增强的提示提高了准确性,因为它提供了对事实数据的访问。

-

叙述:基于这个增强的输入,LLM 生成包含事实正确信息的响应,并将其发送回聊天机器人以传递给用户。

因此,通过结合外部数据源并将相关上下文注入提示中,RAG 增强了 LLMs 生成准确、最新且与特定领域或感兴趣主题相关的响应能力。通过工具和推理增强 LLMs 的示例如下(来源:https://github.com/billxbf/ReWOO,由 Binfeng Xu 等人于 2023 年 5 月撰写的论文“Decoupling Reasoning from Observations for Efficient Augmented Language Models Resources”实施):

图 4.4:工具增强的 LM 范式,利用语言模型的可预见推理能力来提高系统参数和提示效率

让我们看看这个过程!在 LangChain 中有很多可用的工具,如果这还不够的话,自己开发工具也不难。让我们设置一个带有几个工具的代理:

from langchain.agents import (

AgentExecutor, AgentType, initialize_agent, load_tools

)

from langchain.chat_models import ChatOpenAI

def load_agent() -> AgentExecutor:

llm = ChatOpenAI(temperature=0, streaming=True)

# DuckDuckGoSearchRun, wolfram alpha, arxiv search, wikipedia

# TODO: try wolfram-alpha!

tools = load_tools(

tool_names=["ddg-search", "wolfram-alpha", "arxiv", "wikipedia"],

llm=llm

)

return initialize_agent(

tools=tools, llm=llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

要知道AgentExecutor是一个链的重要细节,因此 - 如果我们愿意的话,我们可以将其集成到更大的链中。我们可以使用不同的语法初始化这个链,就像这样:

return MRKLChain.from_chains(llm, chains, verbose=True)

在这种语法中,我们将工具作为链配置传递。MRKL 代表 Modular Reasoning, Knowledge and Language。Zero-Shot Agent 是 MRKL 框架中最通用的操作代理。请注意ChatOpenAI构造函数中的streaming参数,设置为True。这样可以提供更好的使用体验,因为这意味着文本响应将在接收到时更新,而不是等到所有文本完成后再更新。目前只有 OpenAI、ChatOpenAI 和 ChatAnthropic 实现支持流式传输。所有提到的工具都有其特定的目的,这是描述的一部分,传递给语言模型。这些工具被插入到代理中:

-

DuckDuckGo - 一个专注于隐私的搜索引擎;一个额外的优势是它不需要开发者注册

-

Wolfram Alpha - 一种将自然语言理解与数学能力结合的集成,用于问题如“2x+5 = -3x + 7 是什么?”

-

Arxiv - 在学术预印本出版物中搜索;这对于研究导向的问题很有用

-

Wikipedia - 用于任何关于显著知名实体的问题