在此前推文中我们全面分析了生成式人工智能算法模型可能遇到的法律风险,那么这些风险应该如何应对呢?

1、隐私泄漏风险:企业需要遵守数据安全法和个人信息保护法的规定,确保数据来源合法,使用时获得用户授权,并对数据进行匿名化处理等。

2、偏见歧视风险:在训练数据选择和模型开发中,企业需要采取措施消除偏见,确保算法公平,并建立申诉机制接受用户反馈。

3、知识产权侵权风险:企业需尊重知识产权,获取使用数据的授权,或采用公开数据集,并建立知识产权风险评估机制。

4、产品责任风险:企业需对模型进行充分测试验证,确保其可靠性,并建立责任追溯机制,必要时进行产品召回。

5.不正当竞争风险:企业需遵循公平竞争原则,避免滥用市场支配地位,并建立反垄断风险评估机制。

6.滥用风险:企业需建立滥用风险评估机制,对高风险应用场景进行限制,并建立应急响应机制。

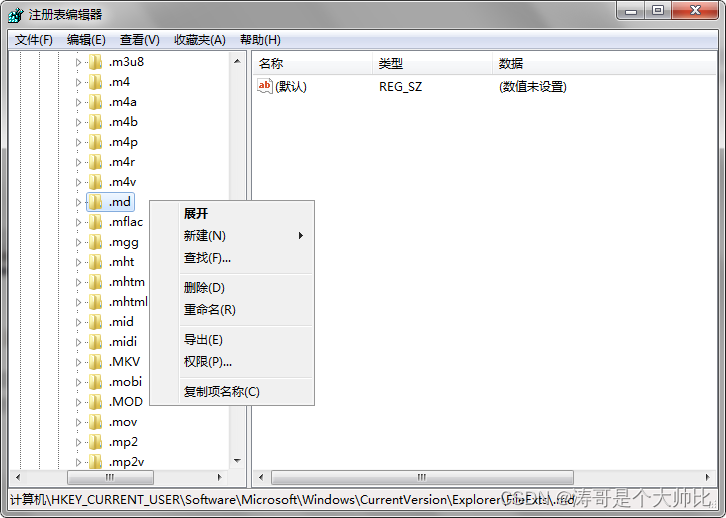

7.另外,产品合规风险尤其需要重视:商业化之前需要根据产品情况进行小程序 icp 备案、算法或者模型备案(如需专业指导可私信咨询);企业还可以建立法律风险管理部门,制定合规制度,进行法律风险评估,加强员工培训等。

.

具体而言,以消除数据偏见为例,有以下具体方法:

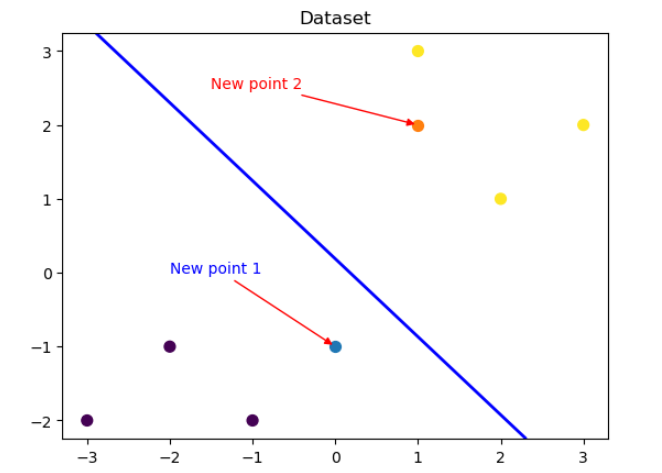

- 选择代表性样本:确保训练数据集具有足够的代表性,避免样本偏差导致算法偏见

- 数据清洗:对训练数据进行清洗,剔除含有歧视性或偏见性信息的样本。

- 特征工程:谨慎选择和使用特征,避免引入性别、年龄等敏感特征,并确保特征公平性。

- 数据增强:对少数群体进行数据增强,增加其在训练数据中的比例。

- 模型调试:对模型进行调试,检测并消除算法偏见,调整参数以消除偏见。

- 公平性检测:使用检测工具检测算法中的偏见,确保算法公平。

- 第三方审计:邀请独立第三方对算法进行审计,评估其公平性和无偏性。

- 透明度提升:提高算法透明度,使决策过程更加公开,以便发现和消除偏见。

- 用户反馈:建立申诉机制,接受用户反馈,发现并消除偏见。

- 伦理审查:进行伦理审查,确保算法开发符合伦理规范。

通过以上方法,可以在算法开发中有效消除数据偏见,提高算法的公平性和可靠性。

其他方面的法律风险具体应对措施会在之后发布,欢迎关注/评论/私信

如果您在合规备案问题上存在困难或疑问,欢迎扫描二维码或后台私信【AI咨询】即可获得AI合规一对一咨询!限时免费!