本文来源公众号“小白学视觉”,仅用于学术分享,侵权删,干货满满。

原文链接:神经网络训练trick总结

来自 | 知乎 作者 | Anticoder

链接 | https://zhuanlan.zhihu.com/p/59918821

本文仅作学术交流,如有侵权,请联系删除

神经网络构建好,训练不出好的效果怎么办?明明说好的拟合任意函数(一般连续) ,说好的足够多的数据(Occam's razor),仔细设计的神经网络都可以得到比其他算法更好的准确率和泛化性呢(当然不是我说的),怎么感觉不出来呢?

很直观,因为神经网络可以随意设计,先验假设较少,参数多,超参数更多,那模型的自由度就非常高了,精心设计对于新手就变得较难了。这里讲一些最简单的trick,肯定不全面,欢迎大家留言补充。因为我也是新手!

下面介绍一些值得注意的部分,有些简单解释原理,具体细节不能面面俱到,请参考专业文章。

那我们直接从拿到一个问题决定用神经网络说起。一般而言,

-

首先选定你要采用的结构,如一对一,固定窗口,数据维度粒度,MLP,RNN或者CNN等

-

非线性选择,sigmoid,tanh,ReLU,或者一些变体,一般tanh比sigmoid效果好一点(简单说明下,两者很类似,tanh是rescaled的sigmoid,sigmoid输出都为正数,根据BP规则,某层的神经元的权重的梯度的符号和后层误差的一样,也就是说,如果后一层的误差为正,则这一层的权重全部都要降低,如果为负,则这一层梯度全部为负,权重全部增加,权重要么都增加,要么都减少,这明显是有问题的;tanh是以0为对称中心的,这会消除在权重更新时的系统偏差导致的偏向性。当然这是启发式的,并不是说tanh一定比sigmoid的好),ReLU也是很好的选择,最大的好处是,当tanh和sigmoid饱和时都会有梯度消失的问题,ReLU就不会有这个问题,而且计算简单,当然它会产生dead neurons,下面会具体说。

-

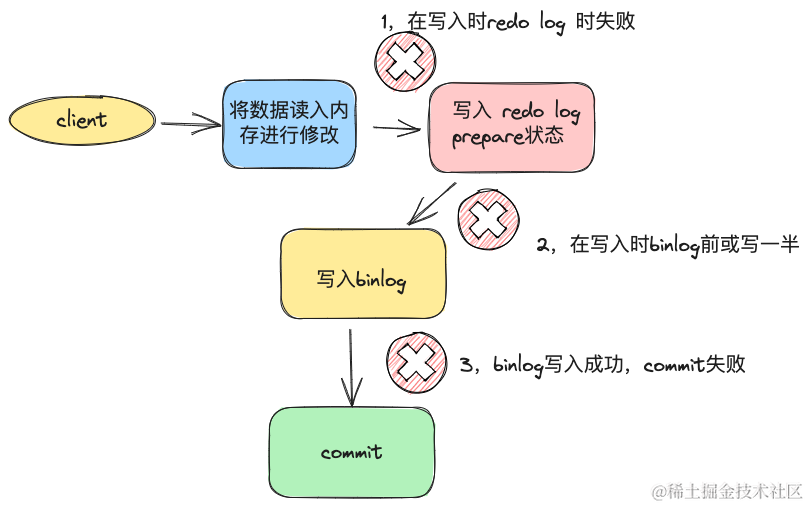

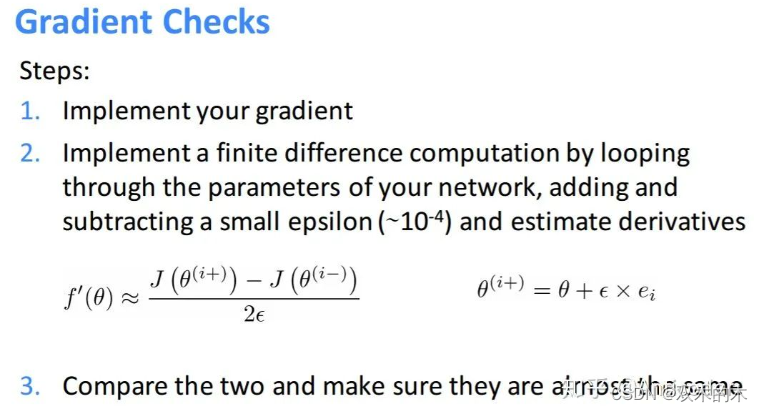

Gradient Check,如果你觉得网络feedforward没什么问题,那么GC可以保证BP的过程没什么bug。值得提的是,如果feedforward有问题,但是得到的误差是差不多的,GC也会感觉是对的。大多情况GC可帮你找到很多问题!步骤如下:

那如果GC失败,可能网络某些部分有问题,也有可能整个网络都有问题了!你也不知道哪出错了,那怎么办呢?构建一个可视化过程监控每一个环节,这可以让你清楚知道你的网络的每一地方是否有问题!!这里还有一个trick,先构建一个简单的任务(比如你做MNIST数字识别,你可以先识别0和1,如果成功可以再加入更多识别数字);然后从简单到复杂逐步来检测你的model,看哪里有问题。举个例子吧,先用固定的data通过单层softmax看feedforward效果,然后BP效果,然后增加单层单个neuron unit看效果;增加一层多个;增加bias。。。。。直到构建出最终的样子,系统化的检测每一步!

-

参数初始化也是重要滴!其主要考虑点在于你的激活函数的取值范围和梯度较大的范围!

隐层的bias一般初始化为0就可以;输出层的bias可以考虑用reverse activation of mean targets或者mean targets(很直观对不对) weights初始化一般较小的随机数,比如Uniform,Gaussion

更放心一点,可视化每一层feedforward输出的取值范围,梯度范围,通过修改使其落入激活函数的中间区域范围(梯度类似线性);如果是ReLU则保证不要输出大多为负数就好,可以给bias一点正直的噪声等。当然还有一点就是不能让神经元输出一样,原因很简单

-

优化算法,一般用mini-batch SGD,绝对不要用full batch gradient(慢)。一般情况下,大数据集用2nd order batch method比如L-BFGS较好,但是会有大量额外计算2nd过程;小数据集,L-BFGS或共轭梯度较好。(Large-batch L-BFGS extends the reach of L-BFGSLe et al. ICML 2001)

mini-batch好处主要有:可以用矩阵计算加速并行;引入的随机性可以避免困在局部最优值;并行化计算多个梯度等。在此基础上一些改进也是很有效的(因为SGD真的敏感),比如Momentum,他的意图就是在原先的跟新基础上增加一点摩擦力,有点向加速度对速度的作用,如果多次更新梯度都往一个方向,说明这个方向是对的,这时候增加跟新的步长,突然有一个方向,只会较少影响原来的方向,因为可以较少的数据带来的误差。当你使用momentum时可以适当减小global learning rate

momentum

-

学习率,跑过神经网络的都知道这个影响还蛮大。一般就是要么选用固定的lr,要么随着训练让lr逐步变小

方案一:当验证误差不再下降时,lr减小为原来的0.5

方案二:采用理论上可以保证收敛的减小比例,O(1/t),t是迭代次数

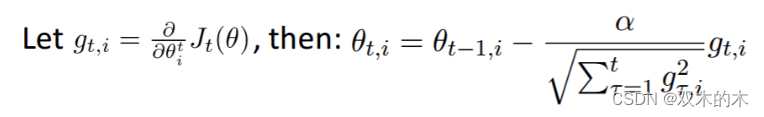

方案三:最好用自适应的学习率,比如Adagrad(Duchi et al. 2010)等

简要说明一下,Adagrad非常适合数据出现频度不一样的模型,比如word2vec,你肯定希望出现非常少的词语权重更新非常大,让它们远离常规词,学习到向量空间中距离度量的意义,出现非常多的词(the,very,often)每次更新比较小。

adagrad

按照上面式子,如果进入一个local optimum,参数可能无法更新时,可以考虑每隔一段epoch,reset sum项

-

看看你的模型有没有能力过拟合!(training error vs. validation error)

如果没有,想办法让它过拟合!(r u kidding?! 哈哈),一般而言,当参数多于training数据时,模型是有能力记住数据的,总归先保证模型的能力么

如果过拟合了,那么就可以进一步优化啦,一般深度学习breakthrough的方法都是来自于更好的regularization method,解决过拟合很多方法在此就不多论述了。比如减小模型(layers, units);L1,L2正则(weight decay);early stop(按照数据集大小,每隔一段epoch(比如小数据集每隔5epoch,大的每隔(1/3epoch))保存模型,最后选择validation error 最小的模型);sparsity constraints on hidden activation;Dropout;data

augumentation (CNN 一些变化不变性要注意)等

------

大体流程如上,再引一篇大神之作

Practical Recommendations for Gradient-Based Training of Deep Architectures Y. Bengio(2012)

https://link.springer.com/chapter/10.1007/978-3-642-35289-8_26

额外提到的有unsupervised预训练。其实数据不够时也可以找类似任务做迁移学习,fine-tuning等。

最后,可以看到一个网络那么多的超参数,怎么去选这些超参数呢?文章也说了:Random hyperparameter search!

以上提的多是supervised learning,对于unsupervised learning可以做fine tuning

接下来按一些模块具体列举下,欢迎补充!!

1 标准化(Normalization)

很多machine learning模型都需要,在此不多论述,神经网络假设inputs/outputs服从近似均值为0方差为1分布。主要为了公平对待每个特征;使优化过程变得平稳;消除量纲影响等

z-score; min-max; decimal scaling等

-

scale控制特征的重要性:大scale的output特征产生更大的error;大的scale的input的特征可以主导网络对此特征更敏感,产生大的update

-

一些特征本来取值范围很小需要格外注意,避免产生NaNs

-

就算没有标准化你的网络可以训练的话,那可能前几层也是做类似的事情,无形增加了网络的复杂程度

-

通常都是把所有inputs的特征独立地按同样的规则标准化,如果对任务有特殊需求,某些特征可以特别对待

2 检查结果(Results Check)

有点类似于在模型中按一个监控系统(预处理,训练,预测过程中都要),这个步骤可以帮助你发现你的模型在哪里出了问题,最好可以找到可视化的方法,一目了然,比如图像方面就很直观了。

-

需要注意的是,你需要理解你设定的error的意义,就算训练过程error在不断减少,也需要来和真实的error比较,虽然training error减少了,但是可能还不够,真实世界中需要更小的error,说明模型学习的还不够

-

当在training过程中work后,再去看在validation集上的效果

-

再更新网络结构前,最好确保每一个环节都有“监控”,不要盲目做无用功

3 预处理(Pre-Processing Data)

现实中同样的数据可以有不同的表达方式,比如移动的汽车,你从不同角度位置去观察,它做的都是同样的事情。你应该确保从南面观察和从西面观察的同样的数据,应该是相似的!

-

神经网络假设数据的分布空间是连续的

-

减少数据表示多样性带来的误差;间接减少了网络前几层做没必要的“等同”映射带来的复杂度

4 正则化(Regularization)

增加Dropout,随机过程,噪声,data augumentation等。就算数据足够多,你认为不可能over-fitting,那么最好还是有正则,如dropout(0.99)

-

一方面缓解过拟合,另一方面引入的随机性,可以平缓训练过程,加速训练过程,处理outliers

-

Dropout可以看做ensemble,特征采样,相当于bagging很多子网络;训练过程中动态扩展拥有类似variation的输入数据集。(在单层网络中,类似折中Naiive bayes(所有特征权重独立)和logistic regression(所有特征之间有关系);

-

一般对于越复杂的大规模网络,Dropout效果越好,是一个强regularizer!

-

最好的防止over-fitting就是有大量不重复数据

5 Batch Size太大

太大的batch size会减gradient descend的随机性,对模型的精度产生负面影响。

如果可以容忍训练时间过长,最好开始使用尽量小的batch size(16,8,1)

-

大的batch size需要更多的epoch来达到较好的水平

-

原因1:帮助训练过程中跳出local minima

-

原因2:使训练进入较为平缓的local minima,提高泛化性

6 学习率lr

去掉gradient clipping(一般默认有),训练过程中,找到最大的,使模型error不会爆掉的lr,然后用稍微小一点的lr训练

-

一般数据中的outliers会产生大的error,进而大的gradient,得到大的weight update,会使最优的lr比较难找

-

预处理好数据(去除outliers),lr设定好一般无需clipping

-

如果error explode,那么加gradient clipping只是暂时缓解,原因还是数据有问题

7 最后一层的激活函数

限制输出的范围,一般不用任何激活

需要仔细考虑输入是什么,标准化之后的输出的取值范围,如果输出有正有负,你用ReLU,sigmoid明显不行;多分类任务一般用softmax(相当于对输出归一化为概率分布)

-

激活只是一个映射,理论上都可以

-

如果输出没有error明显也不行,那就没有gradient,模型也学不到什么

-

一般用tanh,产生一个问题就是梯度在-1或1附近非常小,神经元饱和学习很慢,容易产生梯度消息,模型产生更多接近-1或1的值

8 Bad Gradient(Dead Neurons)

使用ReLU激活函数,由于其在小于零范围梯度为0,可能会影响模型性能,甚至模型不会在更新

当发现模型随着epoch进行,训练error不变化,可能所以神经元都“死”了。这时尝试更换激活函数如leaky ReLU,ELU,再看训练error变化

-

使用ReLU时需要给参数加一点噪声,打破完全对称避免0梯度,甚至给biases加噪声

-

相对而言对于sigmoid,因为其在0值附近最敏感,梯度最大,初始化全为0就可以啦

-

任何关于梯度的操作,比如clipping, rounding, max/min都可能产生类似的问题

-

ReLU相对Sigmoid优点:单侧抑制;宽阔的兴奋边界;稀疏激活性;解决梯度消失

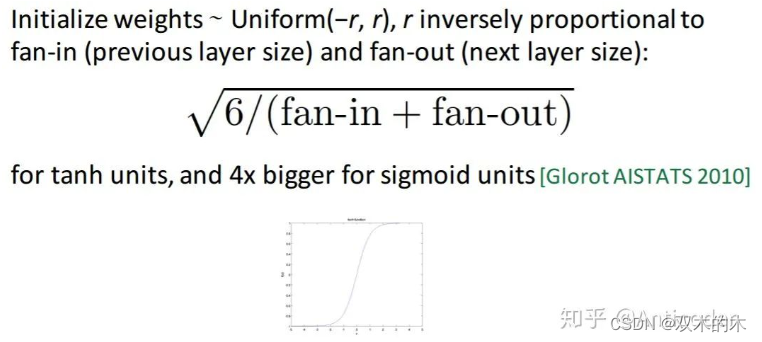

9 初始化权重

一般说随机初始化为一些小的数,没那么简单,一些网络结构需要一些特定的初始化方法,初始化不好很可能得不到文章上的效果!可以去尝试一些流行的找到有用的初始化

-

太小:信号传递逐渐缩小难以产生作用

-

太大:信号传递逐渐放大导致发散和失效

-

比较流行的有 'he', 'lecun', 'Xavier'(让权重满足0均值,2/(输入节点数+输出节点数))

-

biases一般初始化为0就可以

-

每一层初始化都很重要

10 网络太深

都说深度网络精度更高,但深度不是盲目堆起来的,一定要在浅层网络有一定效果的基础上,增加深度。深度增加是为了增加模型的准确率,如果浅层都学不到东西,深了也没效果。

开始一般用3-8层,当效果不错时,为了得到更高的准确率,再尝试加深网络

-

所以的优化方法在浅层也有用,如果效果不好,绝对不是深度不够

-

训练和预测过程随着网络加深变慢

11 Hidden neurons的数量

最好参考researcher在相似的任务上结构,一般256-1024

太多:训练慢,难去除噪声(over-fitting)

太少:拟合能力下降

-

考虑真实变量有多少信息量需要传递,然后再稍微增加一点(考虑dropout;冗余表达;估计的余地)

-

分类任务:初始尝试5-10倍类别个数

-

回归任务:初始尝试2-3倍输入/输出特征数

-

这里直觉很重要

-

最终影响其实不大,只是训练过程比较慢,多尝试

12 loss function

多分类任务一般用cross-entropy不用MSE

-

多分类一般用softmax,在小于0范围内梯度很小,加一个log可以改善此问题

-

避免MSE导致的学习速率下降,学习速率受输出误差控制(自己推一下就知道了)

13 AE降维

对中间隐层使用L1正则,通过惩罚系数控制隐含节点稀疏程度

14 SGD

不稳定算法,设定不同的学习速率,结果差距大,需要仔细调节

一般希望开始大,加速收敛,后期小,稳定落入局部最优解。

也可采用自适应的算法,Adam,Adagrad,Adadelta等减轻调参负担(一般使用默认值就可以)

-

对于SGD需要对学习率,Momentum,Nesterov等进行复杂调参

-

值得一提是神经网络很多局部最优解都可能达到较好的效果,而全局最优解反而是容易过拟合的解

15 CNN的使用

神经网络是特征学习方法,其能力取决隐层,更多的连接意味着参数爆炸的增长,模型复杂直接导致很多问题。比如严重过拟合,过高的计算复杂度。

CNN其优越的性能十分值得使用,参数数量只和卷积核大小,数量有关,保证隐含节点数量(与卷积步长相关)的同时,大量降低了参数的数量!当然CNN更多用于图像,其他任务靠你自己抽象啦,多多尝试!

这里简单介绍一些CNN的trick

-

pooling或卷积尺寸和步长不一样,增加数据多样性

-

data augumentation,避免过拟合,提高泛化,加噪声扰动

-

weight regularization

-

SGD使用decay的训练方法

-

最后使用pooling(avgpooling)代替全连接,减少参数量

-

maxpooling代替avgpooling,避免avgpooling带来的模糊化效果

-

2个3x3代替一个5x5等,减少参数,增加非线性映射,使CNN对特征学习能力强

-

3x3,2x2窗口

-

预训练方法等

-

数据预处理后(PCA,ZCA)喂给模型

-

输出结果窗口ensemble

-

中间节点作为辅助输出节点,相当于模型融合,同时增加反向传播的梯度信号,提供了额外的正则化

-

1x1卷积,夸通道组织信息,提高网络表达,可对输出降维,低成本,性价比高,增加非线性映射,符合Hebbian原理

-

NIN增加网络对不同尺度的适应性,类似Multi-Scale思想

-

Factorization into small convolution,7x7用1x7和7x1代替,节约参数,增加非线性映射

-

BN减少Internal Covariance Shift问题,提高学习速度,减少过拟合,可以取消dropout,增大学习率,减轻正则,减少光学畸变的数据增强

-

模型遇到退化问题考虑shortcut结构,增加深度

-

等等

16 RNN使用

小的细节和其他很像,简单说两句个人感觉的其他方面吧,其实RNN也是shortcut结构

-

一般用LSTM结构防止BPTT的梯度消失,GRU拥有更少的参数,可以优先考虑

-

预处理细节,padding,序列长度设定,罕见词语处理等

-

一般语言模型的数据量一定要非常大

-

Gradient Clipping

-

Seq2Seq结构考虑attention,前提数据量大

-

序列模型考率性能优良的CNN+gate结构

-

一般生成模型可以参考GAN,VAE,产生随机变量

-

RL的框架结合

-

数据量少考虑简单的MLP

-

预测采用层级结构降低训练复杂度

-

设计采样方法,增加模型收敛速度

-

增加多级shortcut结构

今天就到这了,欢迎补充。

THE END!

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。