P2基础优化算法

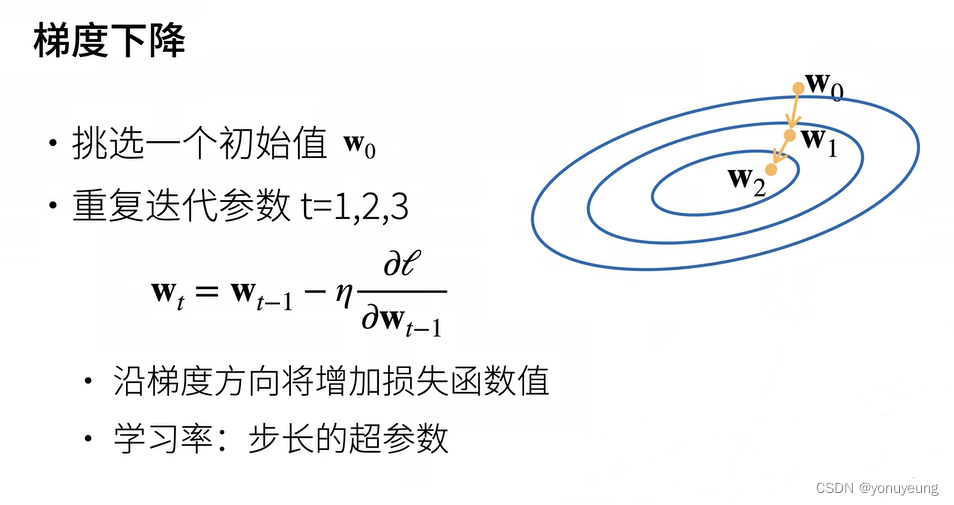

1.最常见的优化算法——梯度下降,用在模型没有显示解的情况下(线性回归有显示解,但是现实中很少有这样理想的情况)

2.梯度下降的实现方法:沿着反梯度更新方向参数求解

解释:

超参数:需要人为指定的值,而不是通过训练得到的参数值

反梯度方向:从外到内

步长:比如W0到W1的距离

学习率: ![]()

3.梯度下降的常见版本——小批量随机梯度下降

做法:采取b个样本来近似损失

批量大小:b,同样也是一个超参数,不能太大也不能太小

总结:1.梯度下降通过不断沿着反梯度方向更新参数求解

2.小批量随机梯度下降是深度学习默认的求解算法

3.重要的两个超参数:批量大小,学习率