这个专栏主要是用来分享一下我在 机器学习中的 学习笔记及一些 感悟,也希望对你的学习有帮助哦!感兴趣的小伙伴欢迎 私信或者 评论区留言!这一篇就更新一下《 白话机器学习中的数学——逻辑回归》!

- 什么是逻辑回归算法

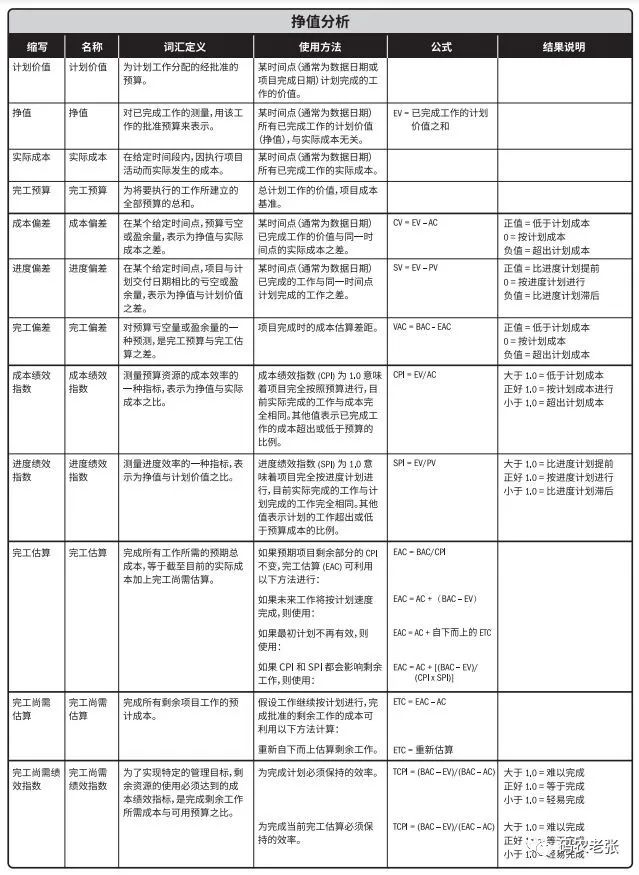

逻辑回归 (Logistic Regression)是一种 基于概率的模式识别算法,虽然名字中带"回归",但实际上是一种分类方法,在实际应用中,逻辑回归可以说是应用最广泛的机器学习算法之一。

- 案例分析

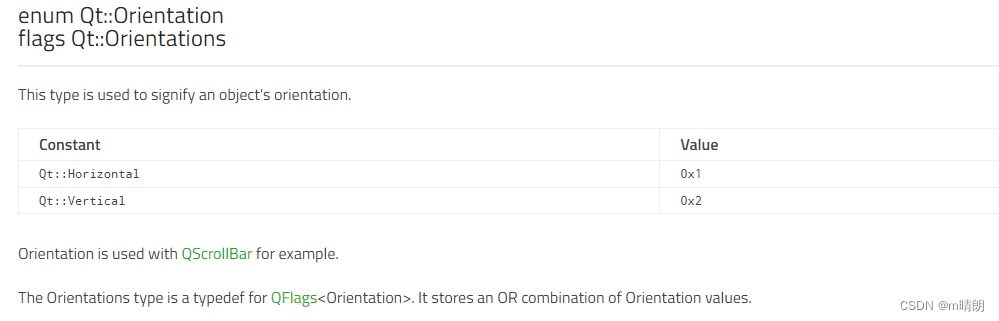

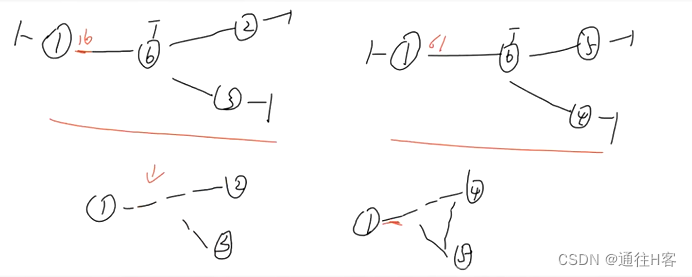

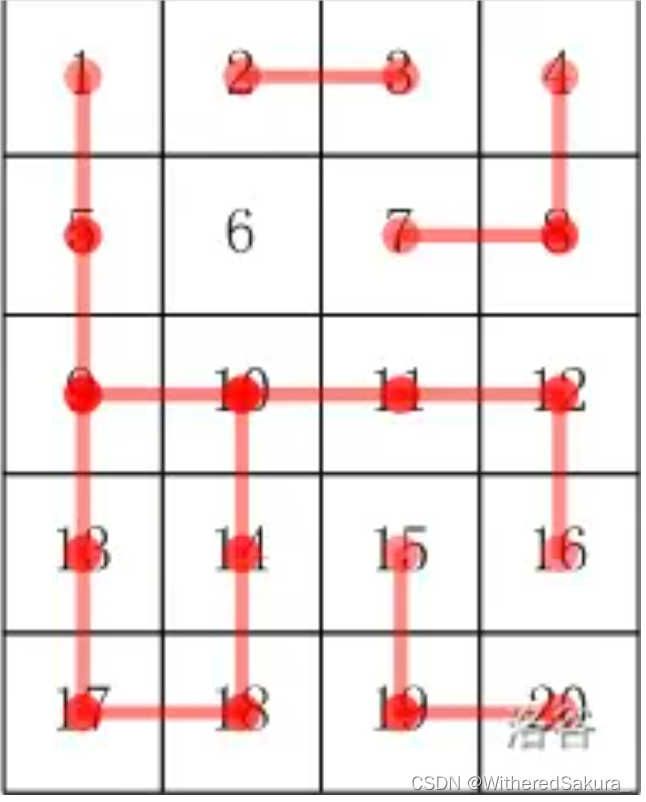

我们还是用刚才按横向和纵向对图像进行分类的例子,接下来要讲的算法与感知机的方法不一样,所以先考虑线性可分的问题比较好,这样有助于我们掌握基础知识。接下来要讲的算法与感知机的不同之处在于,它是把分类作为概率来考虑的。这里设横向的值为 1、纵向的值为 0。

2.1sigmoid 函数

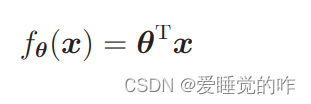

你还记得在学习回归时定义过这样一个带参数的函数吗?

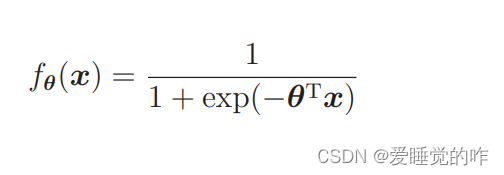

这是通过最速下降法或随机梯度下降法来学习参数 θ的表达式。使用这个 θ 能够求出对未知数据 x 的输出值。这里的思路是一样的。我们需要能够将未知数据分类为某个类别的函数 fθ(x)。这是和感知机的判别函数 fw(x)作用相同的东西,使用与回归时同样的参数 θ,函数的形式就是这样的。

exp 的全称是 exponential,即指数函数。exp(x) 与 ex 含义相同,只是写法不同。e 是自然常数,具体的值为 2.7182 . . .。也就是说 exp(−θTx) 可以换成 e−θTx 这样的写法。指数部分如果过于复杂,上标的字号太小会很难看清,所以这时候使用 exp 写法的情况比较多。

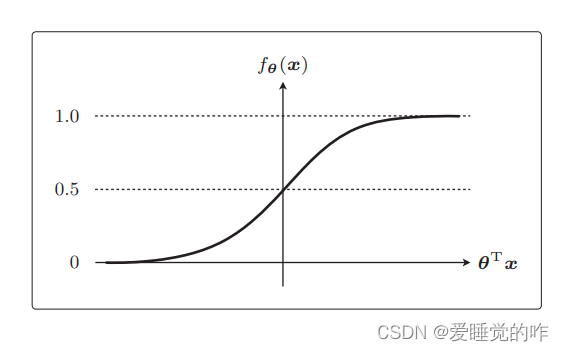

这个函数的名字叫 sigmoid 函数,设 θTx 为横轴,fθ(x)为纵轴,那么它的图形是这样的。

θTx = 0 时 fθ(x) = 0.5,以及 0 < fθ(x) < 1 是 sigmoid 函数的两个特征。首先,刚才说到我们要用概率来考虑分类。因为 sigmoid 函数的取值范围是 0 < fθ(x) < 1,所以它可以作为概率来使用。

2.2决策边界

刚才说到把表达式 的 fθ(x)当作概率来使用,那么接下来我们就把未知数据 x 是横向图像的概率作为 fθ(x)。其表达式是这样的

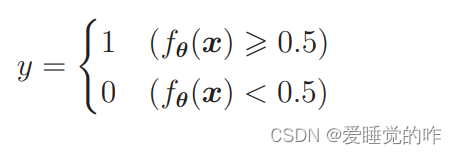

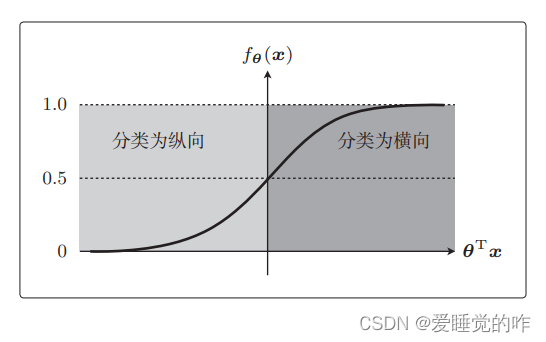

P 中的竖线是条件概率,这是在给出 x 数据时 y = 1,即图像为横向的概率。fθ(x) = 0.7 的意思是图像为横向的概率是 70% 。一般来说这样就可以把 x 分类为横向了,fθ(x) = 0.2 是说横向的概率为 20%、纵向的概率为 80%,这种状态可以分类为纵向我们是以 0.5 为阈值,然后把 fθ(x) 的结果与它相比较,从而分类横向或纵向的

之前我们所谈及的sigmoid函数中,也出现了0.5,在 θTx = 0 时,fθ(x) = 0.5

从图中可以看出在 fθ(x) ⩾ 0.5 时,θTx ⩾ 0,反过来在 fθ(x) < 0.5 时,θTx < 0。

所以我们可以把上面表达式改写为这种形式:

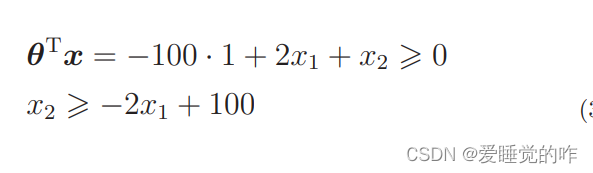

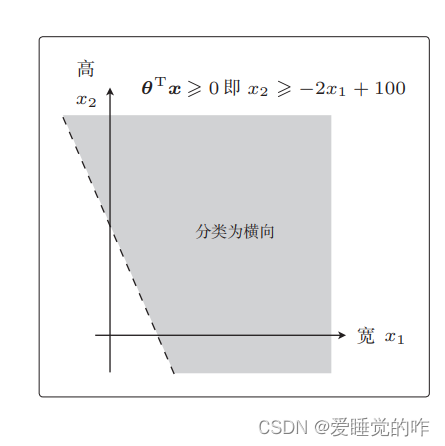

下面我们像学习感知机时那样,设横轴为图像的宽(x1)、纵轴为图像的高(x2),并且画出图来考虑。然后像学习回归时那样,先随便确定 θ 再具体地去考虑。比如当 θ 是这样的向量时,我们来画一下 θTx ⩾ 0 的图像。

这个不等式表示的范围也就是图像被分类为横向的范围了。

那分类为纵向的范围就在另一侧:

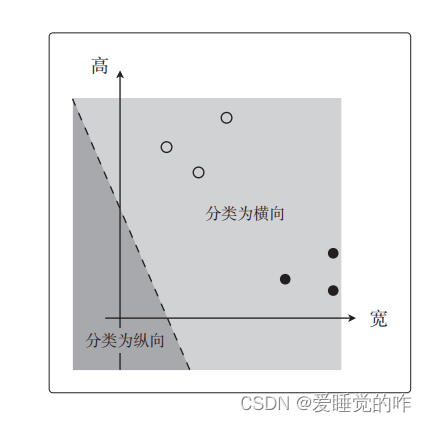

也就是说,我们将 θTx = 0 这条直线作为边界线,就可以把这条线两侧的数据分类为横向和纵向了。这样用于数据分类的直线称为决策边界。实际应用时这个决策边界似乎不能正确地分类图像

为了求得正确的参数 θ 而定义目标函数,进行微分,然后求参数的更新表达式。这种算法就称为逻辑回归!