UNIMO-G: Unified Image Generation through Multimodal Conditional Diffusion

公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群)

目录

1. 摘要

2. 方法

3. 结果

1. 摘要

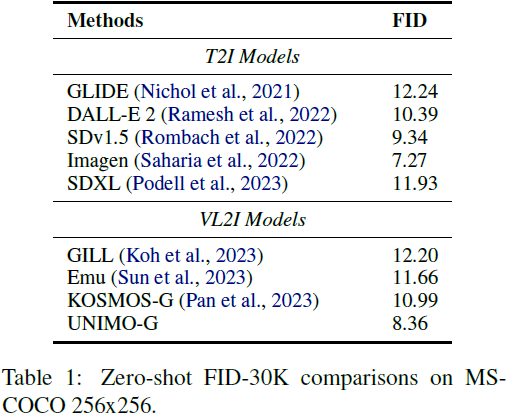

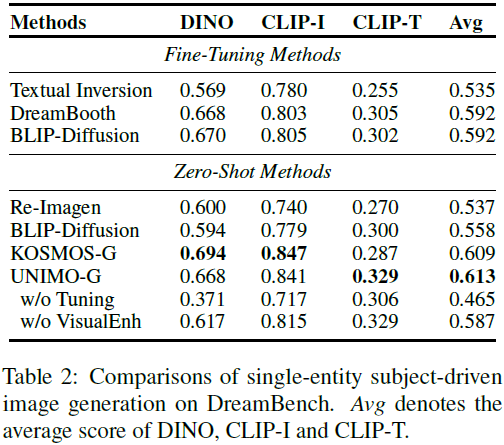

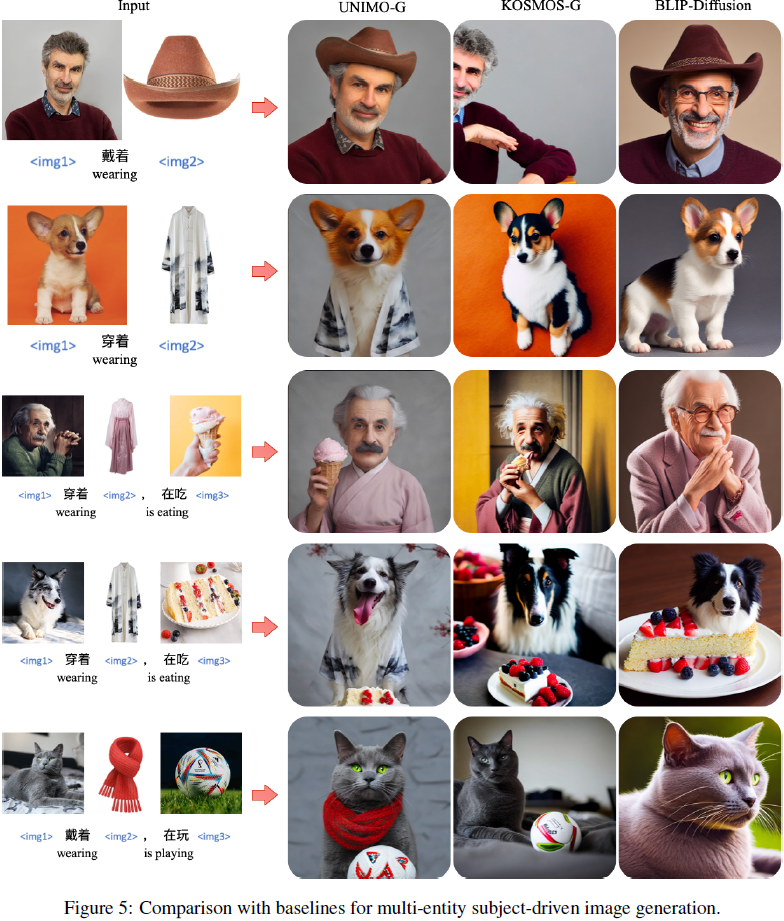

现有的文本到图像扩散模型主要从文本提示中生成图像。然而,文本描述的内在简洁性在忠实合成具有复杂细节的图像方面提出了挑战,例如特定实体或场景。本文介绍了 UNIMO-G,这是一个简单的多模态条件扩散框架,它在交错的文本和视觉输入的多模态提示上运行,展示了对文本驱动和主题驱动图像生成的统一能力。UNIMO-G 包括两个核心组件:一个用于编码多模态提示的多模态大语言模型(MLLM),以及一个用于基于编码的多模态输入生成图像的条件去噪扩散网络。我们采用两阶段训练策略来有效训练该框架:首先在大规模文本-图像对上进行预训练,以发展条件图像生成能力,然后通过多模态提示进行指导微调,以实现统一的图像生成熟练度。采用了精心设计的数据处理流水线,包括语言接地(对齐,language grounding)和图像分割,用于构建多模态提示。UNIMO-G 在文本到图像生成和零样本主题驱动合成方面表现出色,并且在生成涉及多个图像实体的复杂多模态提示的高保真图像方面特别有效。

2. 方法

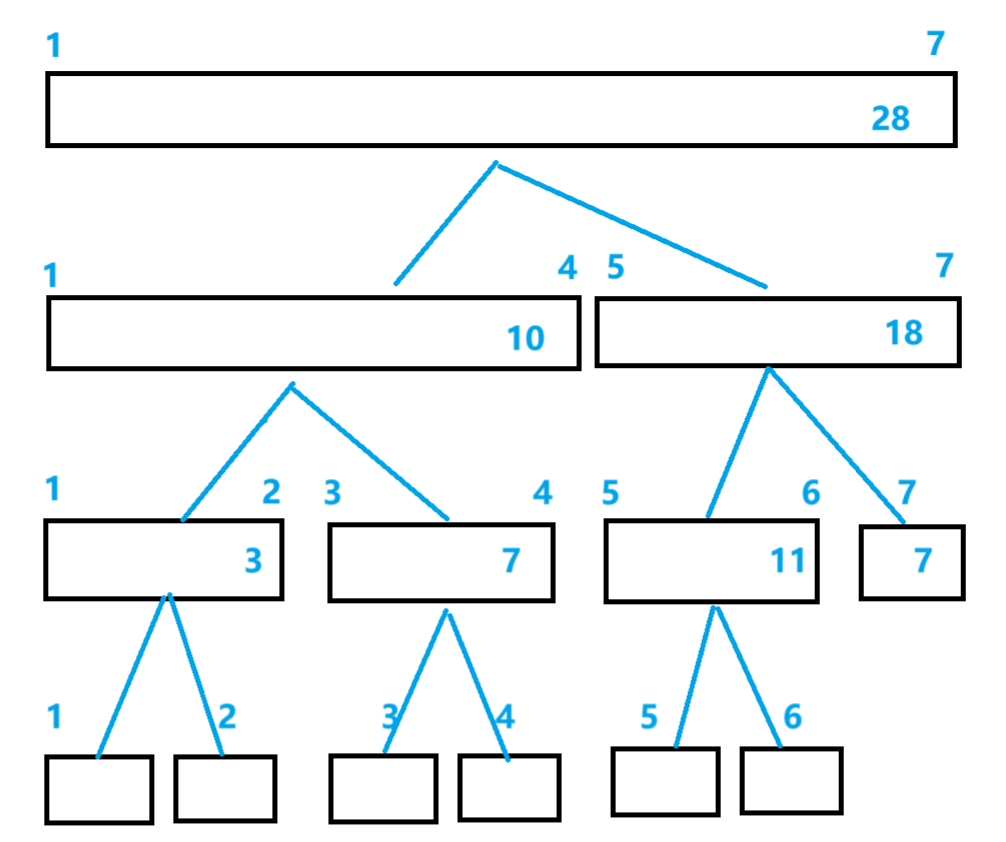

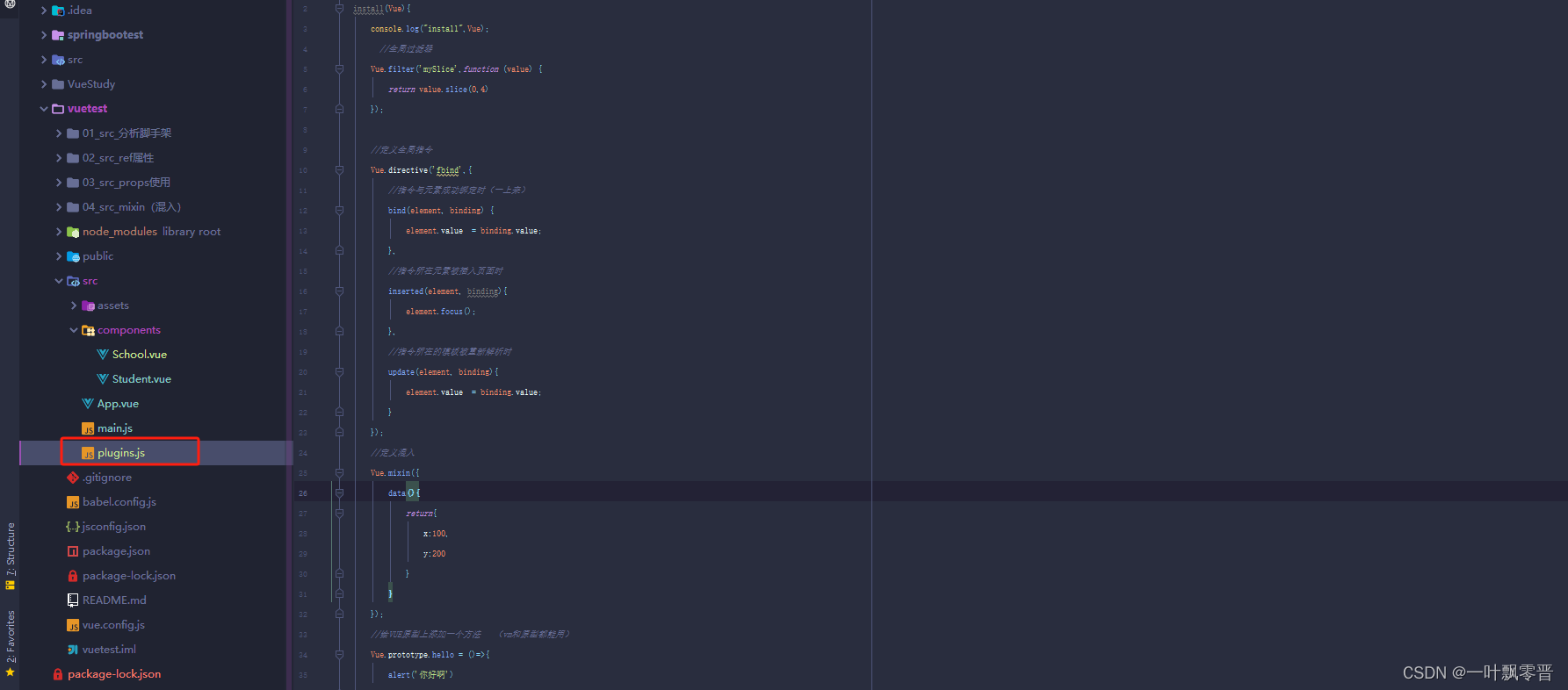

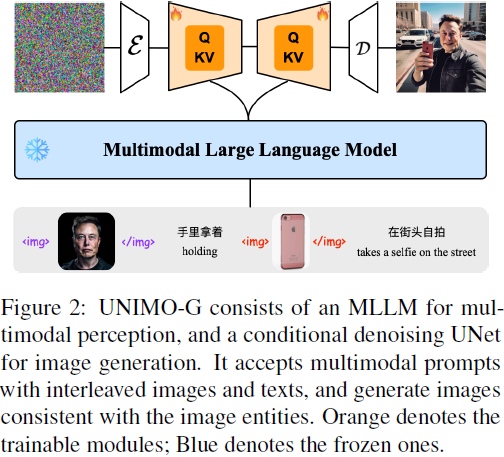

UNIMO-G 的架构,如图 2 所示,主要包括两个关键组件:一个负责编码多模态提示的多模态大语言模型(MLLM),以及一个基于编码表示进行图像生成的条件去噪扩散网络。

UNIMO-G 的训练分为两个阶段的过程:

- 文本到图像预训练:我们从头开始在大规模的中文文本-图像对上对条件去噪扩散网络进行预训练。我们采用了与 Rombach 等人(2022年)相同的 U-Net 网络架构,并使用交叉注意力机制以文本为条件。

- 多模态指导微调:我们进一步在数百万对多模态提示和图像上对 UNIMO-G 进行微调,以提高从多模态输入忠实生成图像的能力。

多模态提示。为了增强文本提示的代表性,我们引入了一种由交错的图像和文本组成的多模态提示格式。具体而言,文本标题中提到的实体可以用它们对应的图像替换,例如,“<img>埃隆·马斯克的图像</img> 手持他的 <img>iPhone 的图像</img>,在街上自拍”,如图 2 所示。

为了创建多模态提示和图像的配对,我们设计了一个数据处理流程,如图 3 所示。该流程首先由 MLLM 生成标题并提取标题中的实体。随后,它使用 Grounding DINO(Liu等,2023年)的语言基础和 SAM(Kirillov等,2023年)的图像分割的组合,获取每个实体的相应图像片段。

3. 结果