目录

- 一、chatGPT介绍

- 二、通过猿如意体验

- 三、在openAI官网体验

- 2.1注册openAI

- 2.2使用和问题说明

一、chatGPT介绍

ChatGPT是由人工智能研究实验室OpenAI在2022年11月30日发布的全新聊天机器人模型,一款人工智能技术驱动的自然语言处理工具。它能够通过学习和理解人类的语言来进行对话,还能根据聊天的上下文进行互动,真正像人类一样来聊天交流,甚至能完成撰写邮件、视频脚本、文案、翻译、代码等任务。

官方介绍: 👁👁

We’ve trained a model called ChatGPT which interacts in a conversational way. The dialogue format makes it possible for ChatGPT to answer followup questions, admit its mistakes, challenge incorrect premises, and reject inappropriate requests. ChatGPT is a sibling model to InstructGPT, which is trained to follow an instruction in a prompt and provide a detailed response.

We trained this model using Reinforcement Learning from Human Feedback (RLHF), using the same methods as InstructGPT, but with slight differences in the data collection setup. We trained an initial model using supervised fine-tuning: human AI trainers provided conversations in which they played both sides—the user and an AI assistant. We gave the trainers access to model-written suggestions to help them compose their responses. We mixed this new dialogue dataset with the InstructGPT dataset, which we transformed into a dialogue format.

To create a reward model for reinforcement learning, we needed to collect comparison data, which consisted of two or more model responses ranked by quality. To collect this data, we took conversations that AI trainers had with the chatbot. We randomly selected a model-written message, sampled several alternative completions, and had AI trainers rank them. Using these reward models, we can fine-tune the model using Proximal Policy Optimization. We performed several iterations of this process.

我们已经训练了一个名为 ChatGPT 的模型,它以对话方式进行交互。 对话格式使 ChatGPT 可以回答后续问题、承认错误、挑战不正确的前提并拒绝不适当的请求。 ChatGPT 是 InstructGPT 的同级模型,它经过训练可以按照提示中的说明进行操作并提供详细的响应。

我们使用与 InstructGPT 相同的方法,使用人类反馈强化学习 (RLHF) 训练该模型,但数据收集设置略有不同。 我们使用监督微调训练了一个初始模型:人类 AI 训练员提供对话,他们在对话中扮演双方——用户和 AI 助手。 我们让培训师可以访问模型编写的建议,以帮助他们撰写回复。 我们将这个新的对话数据集与 InstructGPT 数据集混合,我们将其转换为对话格式。

为了创建强化学习的奖励模型,我们需要收集比较数据,其中包含两个或多个按质量排序的模型响应。 为了收集这些数据,我们收集了 AI 培训师与聊天机器人的对话。 我们随机选择了一条模型编写的消息,抽取了几个备选的完成方式,并让 AI 培训师对它们进行排名。 使用这些奖励模型,我们可以使用近端策略优化来微调模型。 我们对这个过程进行了几次迭代。

本文介绍下面两种体验chatGPT的方式。

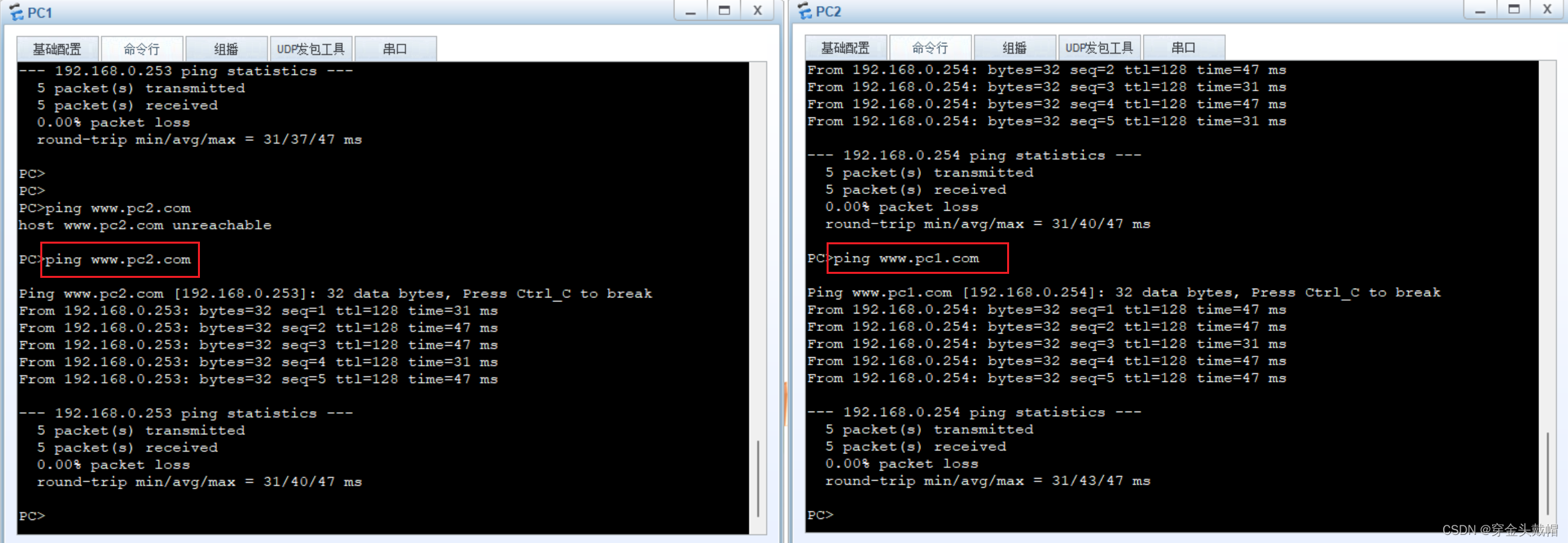

二、通过猿如意体验

这是最快捷的方式。

猿如意是csdn官方的一个客户端工具,我在另一篇文章中有介绍。

猿如意介绍

下载猿如意之后,就可以体验了

限制:

有次数限制,开通csdn会员后无限制。

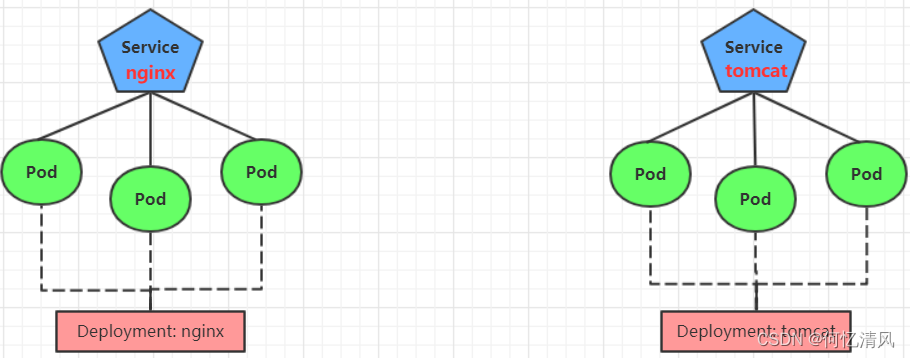

chatGPTP-openAI

CharGPT-猿如意

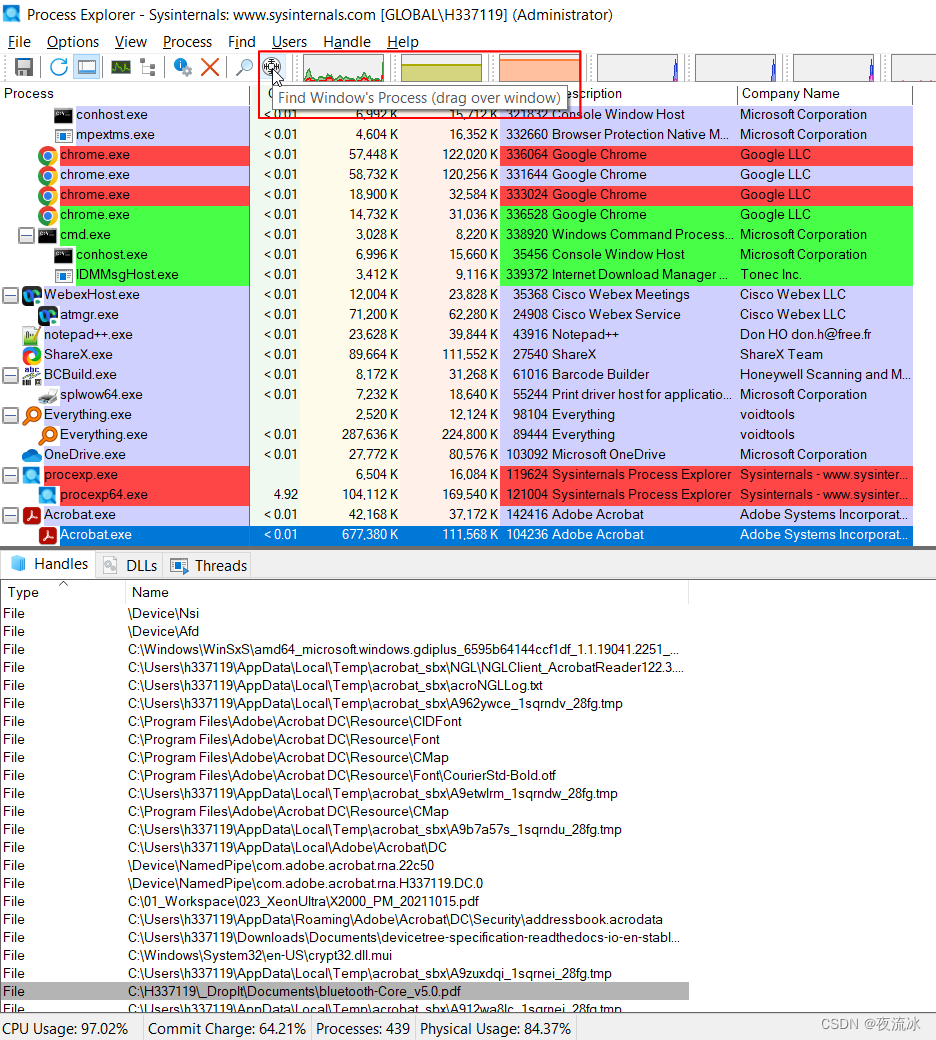

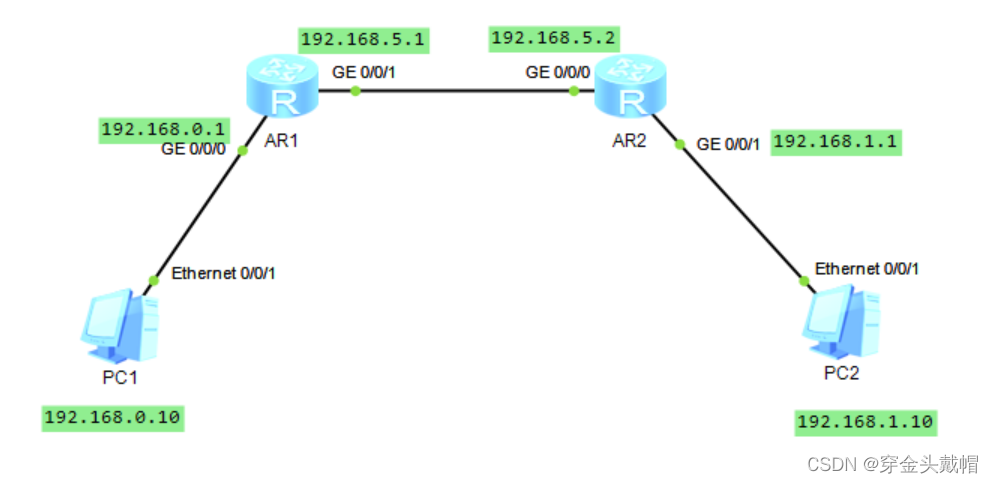

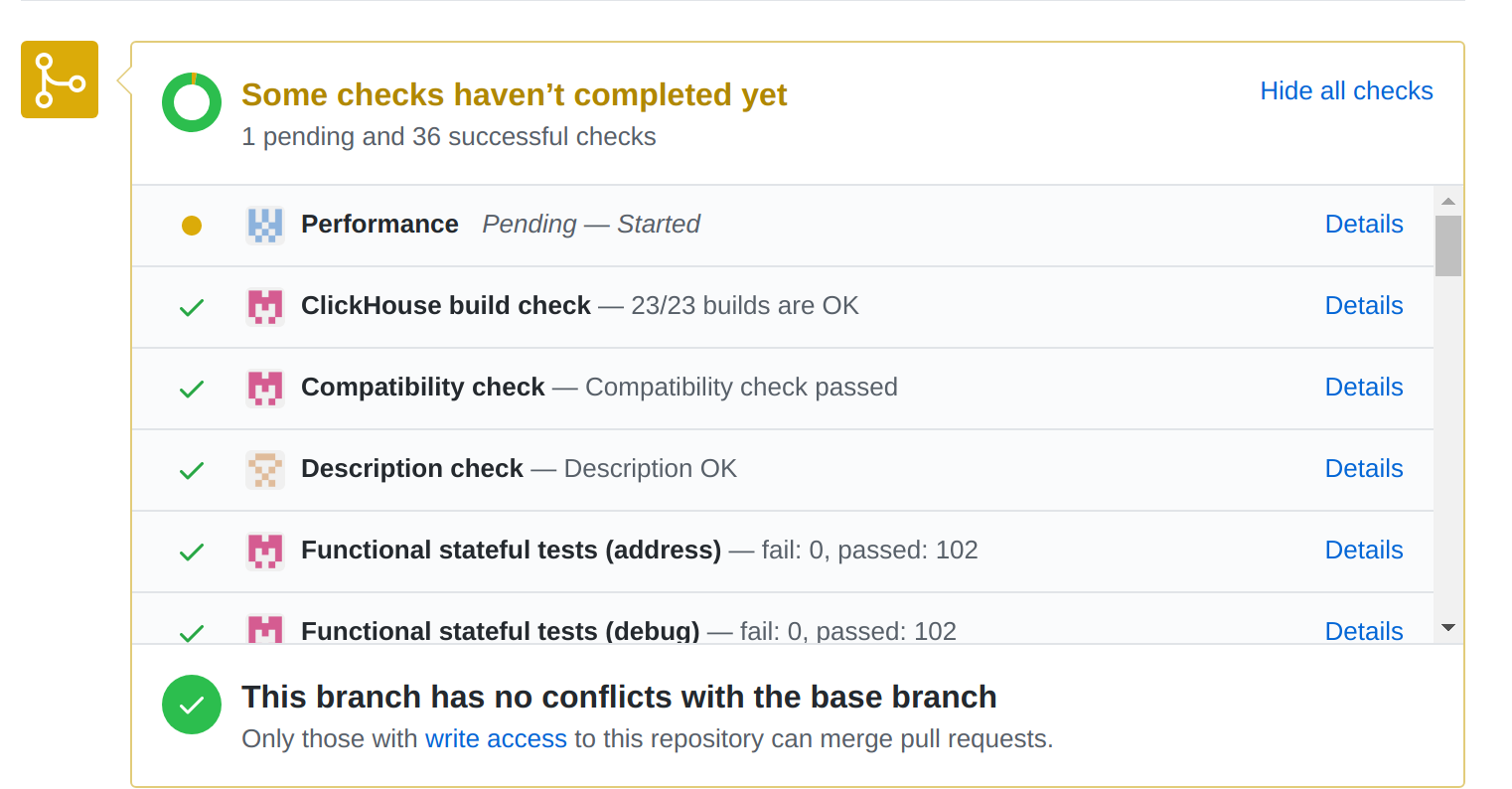

三、在openAI官网体验

前提条件:

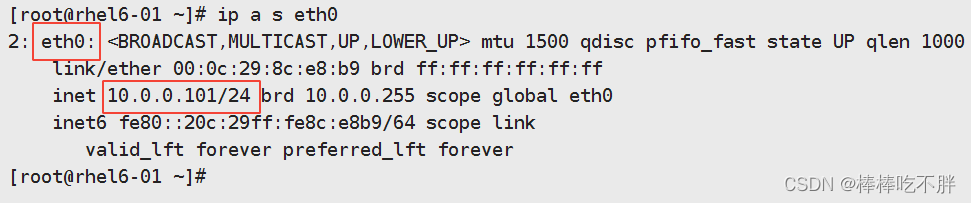

- 需要先注册openAI账号才能使用;

- 需要开启proxy才能访问,这个不会的话自己去github学。

chatGPTP2-openai

2.1注册openAI

- openAI官网:https://openai.com/

- 点击页面最上面的try chatGPT或者页面左下角;

- 弹出注册页面,填写相关信息,但是只支持一些国家的电话号码,+86当然也不支持了

- 使用SMS-MAN平台来接收openAI的验证短信;

- 网址:https://sms-man.com/;

- 进入注册即可,可以切换中文;

- 注册完之后充值,支持支付宝(应为你是租用人家的号码);

- 选择国家(Select a country),我选的是USA,有的国家不支持openAI注册;

- 选择之后选择服务(Select a service),在搜索框输入openAI,回车,点击购买,如果可以购买就ok,如果不行,就更换国家

- 购买完成后,页面上方出现一个号码,把这个号码输入到openAI注册页面的手机号处(国家一致),获取短信;

- 回到SMS接收短信,在openAI填写验证码即可。

其他的注册步骤就不必谈了,注册完成后就可以体验chatGPT了。

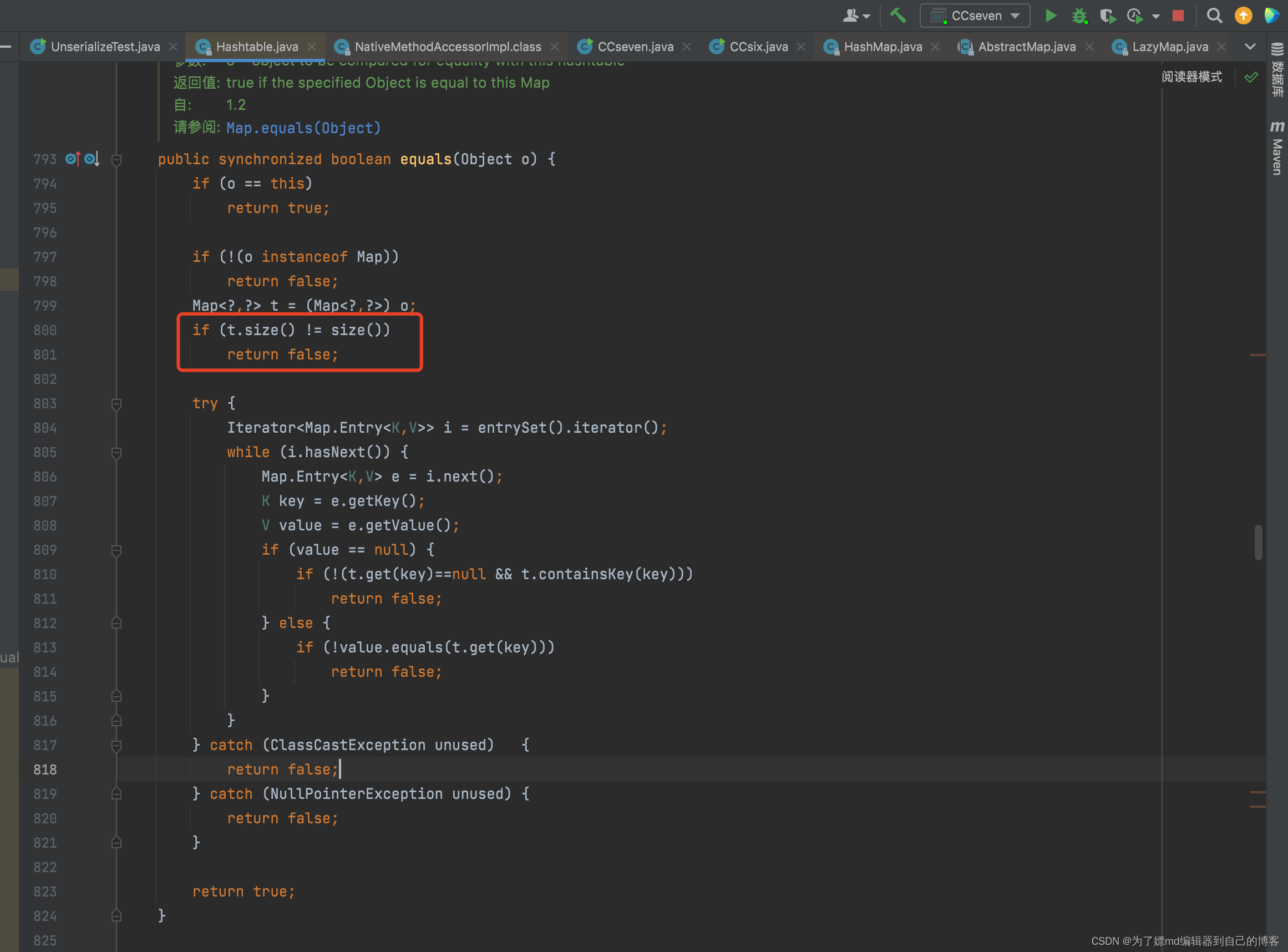

2.2使用和问题说明

chatGPT主要回答与技术相关的问题,当然它也能和你聊《三体》,但一些不合法的问题会被拒绝回答,还有一些没有学习到的问题也不会回答,比如问他明天天气如何,它只能让你去看天气预报。

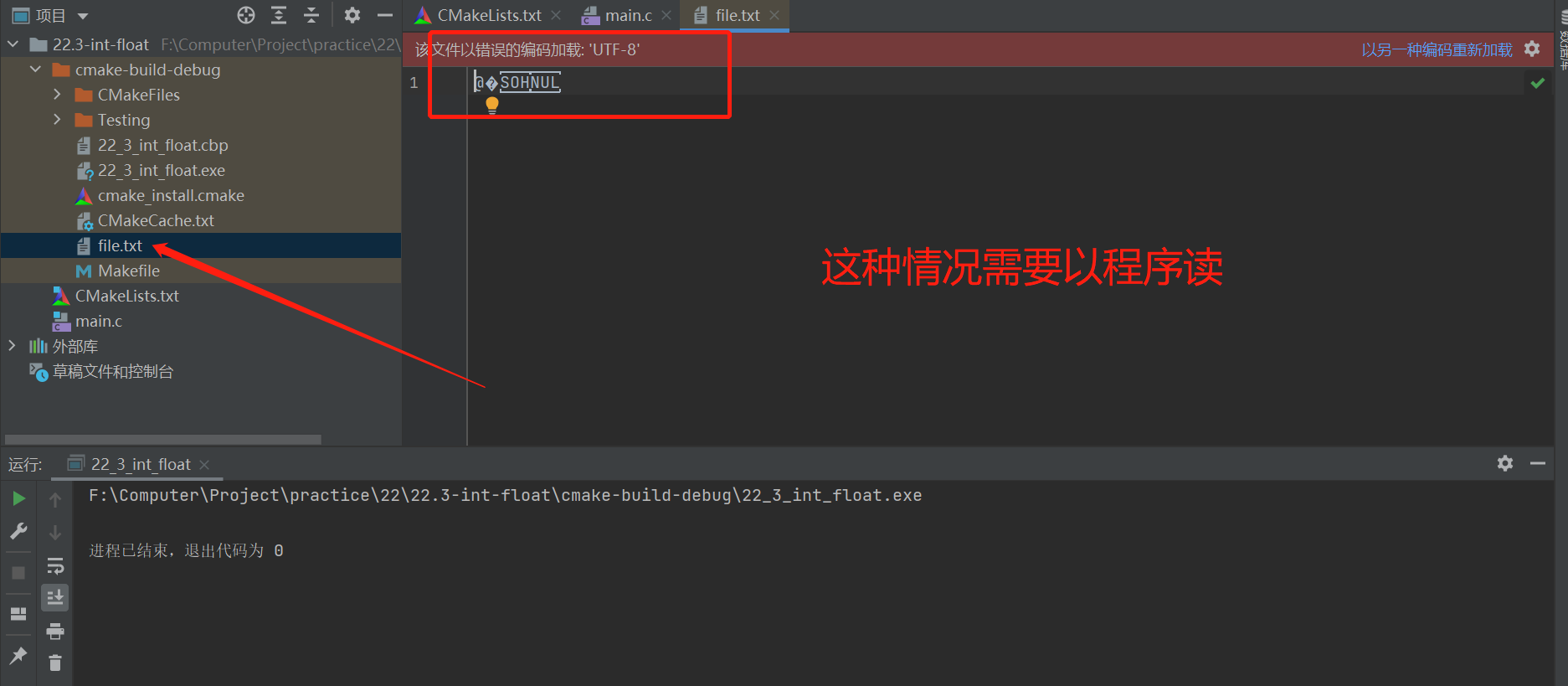

chatGPT官网会检查网络连接的安全性等问题,因此你的proxy质量比较重要,否则可能会出现 An error ....之类的报错

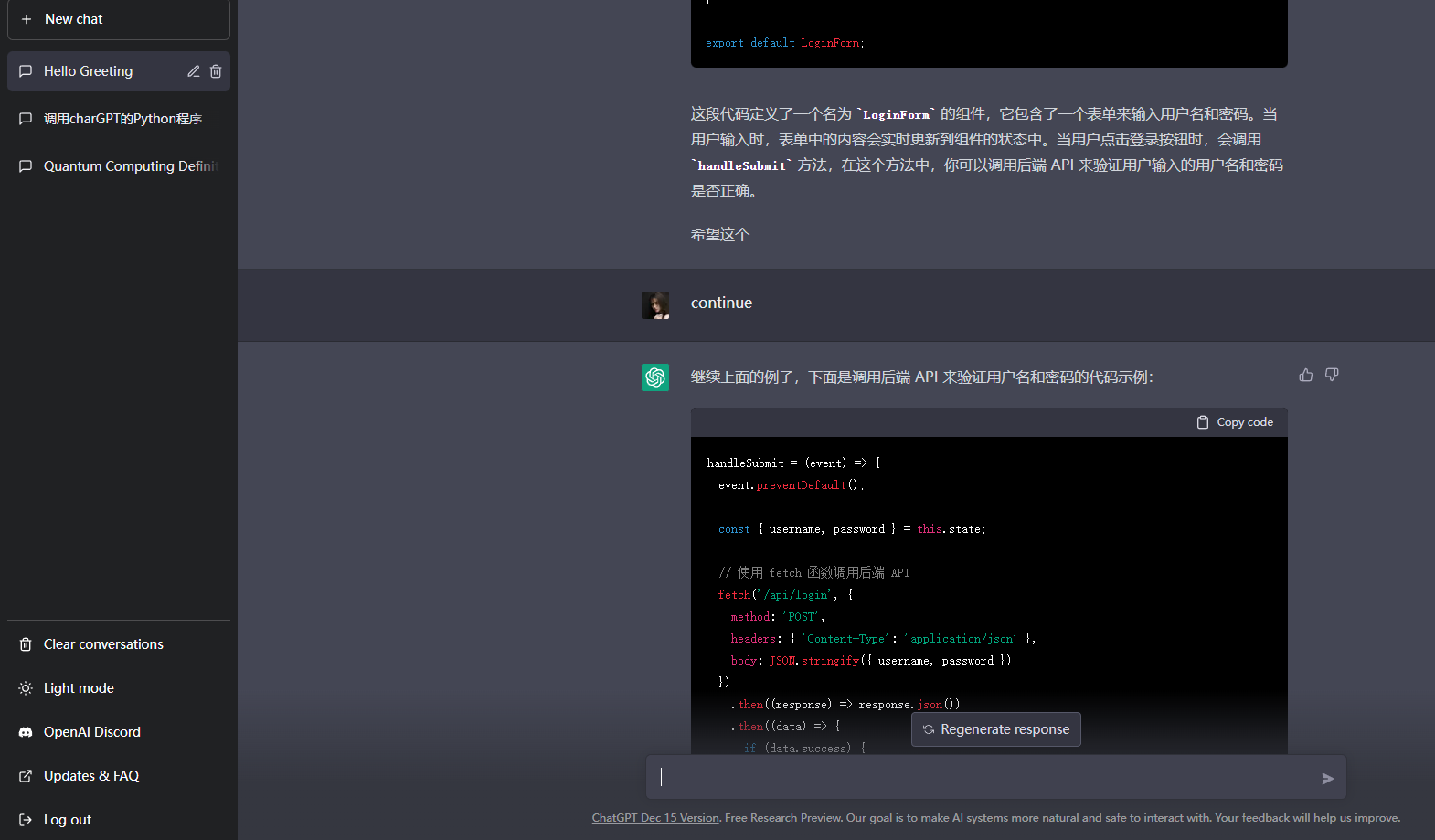

chatGPT输出长度有限制,没有显示完整可以使用continue继续显示,此外,它可以和你连续对话。

官网列举的Limitations:

ChatGPT 有时会写出看似合理但不正确或荒谬的答案。 解决这个问题具有挑战性,因为:

(1)在 RL 训练期间,目前没有真实来源;

(2) 训练模型更加谨慎导致它拒绝可以正确回答的问题;

(3) 监督训练会误导模型,因为理想的答案取决于模型知道什么,而不是人类演示者知道什么。

ChatGPT 对输入措辞的调整或多次尝试相同的提示很敏感。 例如,给定一个问题的措辞,模型可以声称不知道答案,但只要稍作改写,就可以正确回答。

该模型通常过于冗长并过度使用某些短语,例如重申它是 OpenAI 训练的语言模型。 这些问题源于训练数据的偏差(训练者更喜欢看起来更全面的更长答案)和众所周知的过度优化问题。

理想情况下,当用户提供模棱两可的查询时,模型会提出澄清问题。 相反,我们当前的模型通常会猜测用户的意图。

虽然我们已努力使模型拒绝不当请求,但它有时会响应有害指令或表现出有偏见的行为。 我们正在使用 Moderation API 来警告或阻止某些类型的不安全内容,但我们预计目前它会有一些漏报和漏报。 我们渴望收集用户反馈,以帮助我们正在进行的改进该系统的工作。