学习地址:大模型理论基础

一、什么是语言模型(Language Model)

语言模型其实是一个概率模型,给每一个句子列表计算一个概率值:

p(x1,…,xL)

例如:

p(the, mouse, ate, the, cheese)=0.02,

p(the, cheese ate, the, mouse)=0.01,p(the, cheese ate, the, mouse)=0.01

自回归语言模型(Autoregressive language models)

将一个句子的概率的表示成多个条件概率的相乘

二、信息理论、英语的熵、n-gram模型

2.1 信息熵:

信息熵也叫香侬熵,在物理上表示不确定性,熵越大,不确定性越高,包含的信息就越多。

2.2 交叉熵:

用来评估真实数据分布�p的样本的(语言)模型�q之间的差距

2.3 N-gram模型

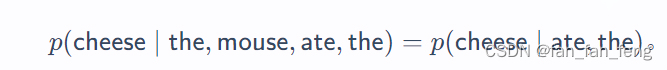

在一个n-gram模型中,关于Xi的预测只依赖于最后的 n−1 个字符 ,即Xi−(n−1):i−1 ,而不是整个历史:

比如:n = 3

n 太小,那么模型将无法捕获长距离的依赖关系,

n太大,无法得到一个好的概率评估

三、大模型

3.1 强大的生成能力

在给定提示的情况下生成完成的文本: prompt -> task competion

3.2 具备一定的推理能力

目前开源的GPT3.5,4.0已经具备了一些逻辑推理能力,能够独立完成一些任务

3.3 风险

当然大模型还存在一些风险:

比如:

可靠性不能保证,可能输出的一段一本正经的乱说

可能生成社会偏见,或者带有侮辱等一些道德方面的文本