virtio虚拟化

系统虚拟化技术是云计算最重要的核心技术之一。云计算平台的资源池化,资源统一管理以及后续的动态分配都是基于系统虚拟化技术才得以实现的。在计算机系统中,主要有计算资源,存储资源和网络资源。所以,系统虚拟化技术又可以细分为计算虚拟化,存储虚拟化和网络虚拟化。其中存储设备和网络设备一般都是以外设的形式和CPU通过I/O总线连接起来的,所以存储虚拟化和网络虚拟化又可以统一归类为I/O虚拟化技术。

virtio 是半虚拟化 hypervisor 中位于设备之上的抽象层。virtio 由 Rusty Russell 开发,他当时的目的是支持自己的虚拟化解决方案 lguest。

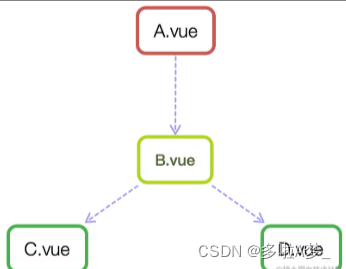

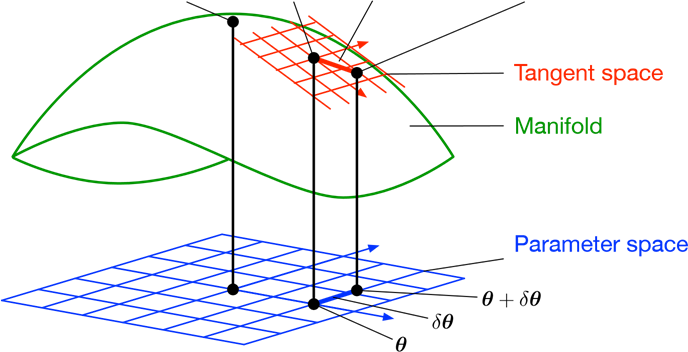

virtio 是对半虚拟化 hypervisor 中的一组通用模拟设备的抽象。该设置还允许 hypervisor 导出一组通用的模拟设备,并通过一个通用的应用编程接口(API)让它们变得可用。下图展示了为什么这很重要。有了半虚拟化 hypervisor 之后,来宾操作系统能够实现一组通用的接口,在一组后端驱动程序之后采用特定的设备模拟。后端驱动程序不需要是通用的,因为它们只实现前端所需的行为。

除了前端驱动程序(在来宾操作系统中实现)和后端驱动程序(在 hypervisor 中实现)之外,virtio 还定义了两个层来支持来宾操作系统到 hypervisor 的通信。在顶级(称为 virtio)的是虚拟队列接口,它在概念上将前端驱动程序附加到后端驱动程序。驱动程序可以使用 0 个或多个队列,具体数量取决于需求。例如,virtio 网络驱动程序使用两个虚拟队列(一个用于接收,另一个用于发送),而 virtio 块驱动程序仅使用一个虚拟队列。虚拟队列实际上被实现为跨越来宾操作系统和 hypervisor 的衔接点。但这可以通过任意方式实现,前提是来宾操作系统和 hypervisor 以相同的方式实现它。

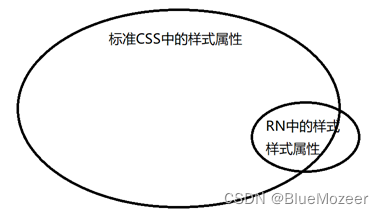

I/O虚拟化技术可以分为两种,一种是全虚拟化,另一种是半虚拟化。

- 全虚拟化:Guest OS不知道自己是虚拟机,所以也就不需要修改Guest OS的驱动程序。这样Guest OS移植性好,但是虚拟机的I/O性能不高。

- 半虚拟化:Guest OS知道自己是虚拟机,通过前端驱动和后端模拟设备互相配合实现IO虚拟化。和全虚拟化相比,半虚拟化技术可以帮助虚拟机大幅度提高I/O的性能。目前在云计算场景中广泛使用的就是virtio在Linux上的具体实现,而且virtio已经成为虚拟化I/O技术的抽象接口规范和事实标准,即使非Linux系统也可以适用。

virtio基本原理

virtio 是一个通用的 I/O 虚拟化框架, hypervisor 通过他模拟出一系列的虚拟化设备,例如:virtio-net、virtio-blk等,并使得这些设备在虚拟机内部通过 api 调用的方式变得可用。它包含4个部分:前端驱动、后端驱动、 vring 及通信间统一的接口。与其他的模拟 I/O 方式对比, virtio 减少了虚拟机的退出和数据拷贝,能够极大地提高 I/O 性能。计算机中存在不同的总线标准,而 virtio 采用的是 pci 总线(当然也可以用其他总线来实现)。每一个 virtio 设备就是一个 pci 设备。

virtio架构层次

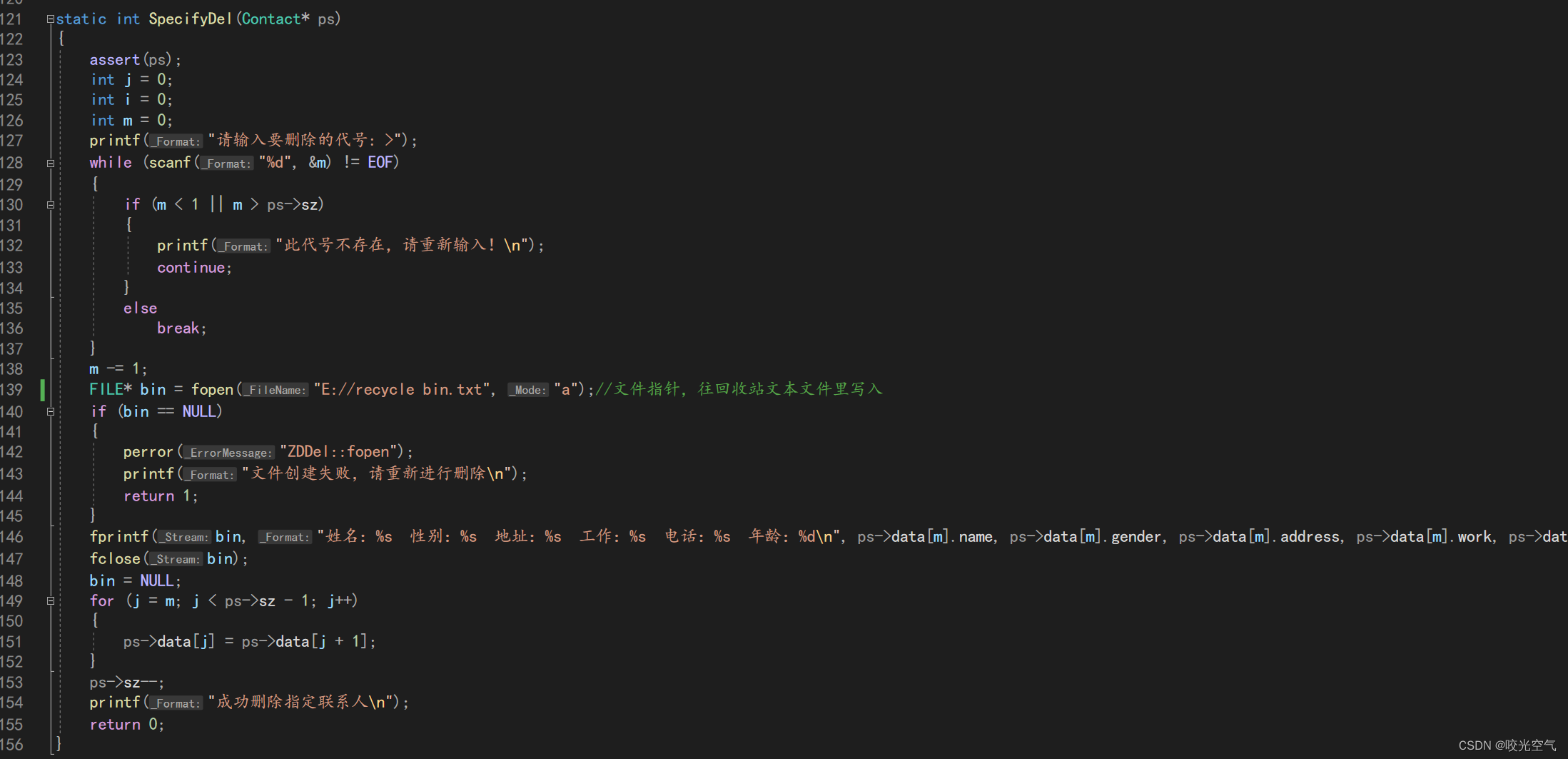

virtio前端驱动

virtio 前端驱动位于 Linux 内核中,运行在虚拟机 VM,针对不同类型的设备有不同类型的驱动程序,包括virtio-net、virtio-blk、virtio-pci等,这些驱动程序与后端驱动交互的接口都是统一的。

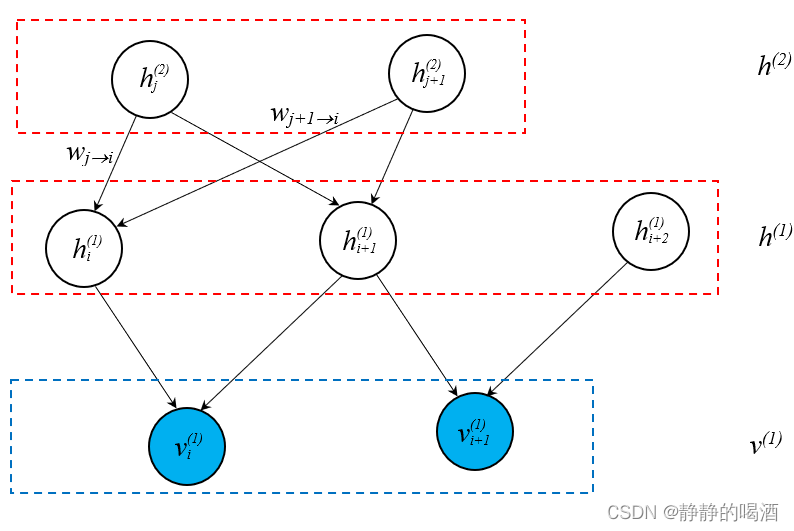

virtio层

virtio层实现虚拟队列接口,作为前后端通信的桥梁,不同类型的设备使用的虚拟队列数量不同,例如 virtio-net 使用两个虚拟队列,一个用于接收,一个用于发送;virtio-blk 驱动仅使用一个虚拟队列。虚拟队列实际上被实现为跨越客户机操作系统和 hypervisor 的衔接点,可以通过任意方式实现,前提是客户机操作系统和 virtio 后端程序都遵循一定的标准,以相互匹配的方式实现它。

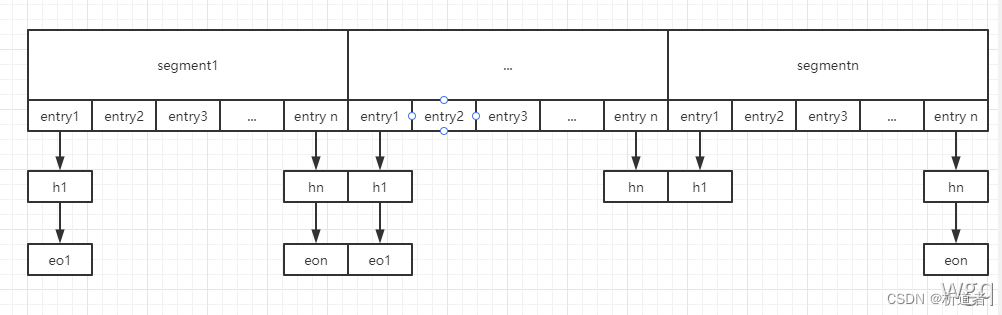

virtio-ring层

virtio-ring 是虚拟队列的具体实现,其中实现了环形缓冲区(ring buffer),用于保存前端驱动和后端处理程序执行的信息,并且它可以一次性保存前端驱动的多次I/O请求,并且交由后端驱动去批量处理,最后实际调用宿主机中设备驱动实现物理上的I/O操作,这样做就可以根据约定实现批量处理而不是客户机中每次I/O请求都需要处理一次,从而提高客户机与 hypervisor 信息交换的效率。

virtio后端驱动

virtio 后端驱动位于 qemu ,后端设备承担的主体功能分为两部分:

- virtio后端设备的模拟;

- 依据virtio协议处理来自虚拟机端发送的请求。

在 QEMU 的实现中, virtio 设备是 QEMU 为虚拟机模拟的 PCI 设备,遵循 PCI-SIG 定义的 PCI 规范,具有配置空间、中断配置等功能; virtio 后端驱动运行在宿主机中,用于实现 virtio 后端操作硬件设备,例如向内核协议栈发送一个数据包完成虚拟机对网络数据的操作。

virtio数据流交互机制

virtio 主要分为两部分:QEMU和内核驱动程序。Virtio设备的模拟通过QEMU完成的,QEMU代码在虚拟机启动之前,创建虚拟设备。虚拟机启动后检测到设备,调用内核的virtio设备驱动程序来加载这个virtio设备。

对于KVM虚拟机,都是通过QEMU这个用户空间程序创建的,每个KVM虚拟机都是一个QEMU进程,虚拟机的virtio设备是QEMU进程模拟的,虚拟机的内存也是从QEMU进程的地址空间内分配的。

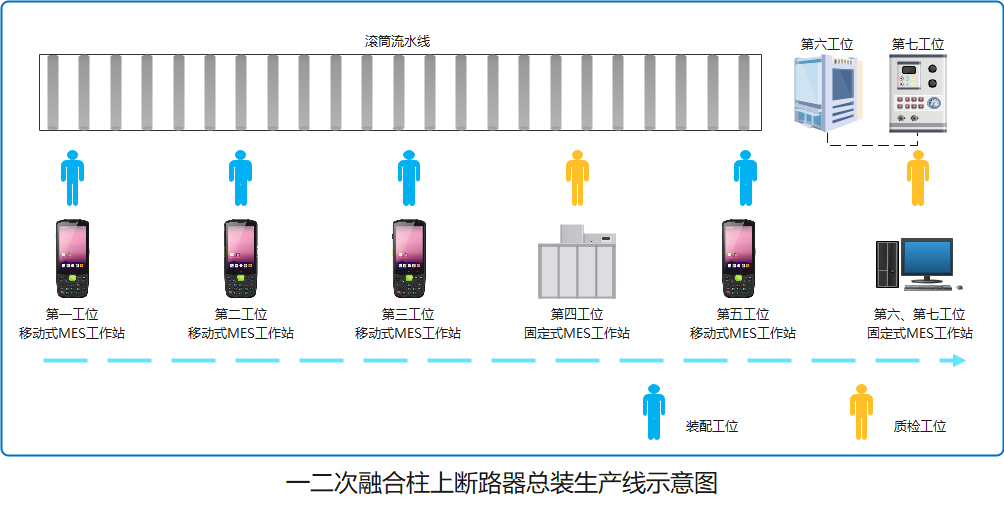

虚拟机IO请求的整个流程如下图所示:

步骤:

- 虚拟机产生的IO请求被前端的virtio设备接收,并存放在virtio设备散列表

scatterList中; - virtio设备的

virtio提供add_buf将散列表中的数据映射至前后端数据共享区域vring; - virtqueue通过

kick函数来通知后端qemu进程。kick通过写pci配置空间的寄存器产生kvm_exit; - Qemu端注册

ioport_write/read函数监听PCI配置空间的改变,获取前端的通知消息; - Qemu端维护的

virtqueue队列从数据共享区vring中获取数据; - Qemu将数据封装成

virtioreq; - Qemu进程将请求发送至硬件层。

前后端主要通过PCI配置空间的寄存器完成前后端的通信,而IO请求的数据地址则存在 vring 中,并通过共享 vring 这个区域来实现 I/O 请求数据的共享。

参考

virtio-net 实现机制_老王不让用的博客-CSDN博客_vring_interrupt

Virtual I/O Device (VIRTIO) Version 1.1 (oasis-open.org)virtio v1.1规范

virtio详细介绍和1.1新功能 - 知乎 (zhihu.com)

😶

🍟

🎨