Large-scale chemical language representations capture molecular structure and properties(2022,NMI)

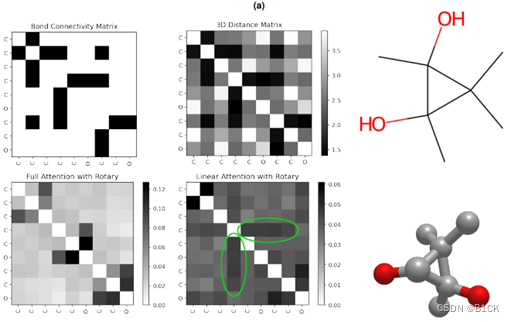

和原本transformer encoder的不同:

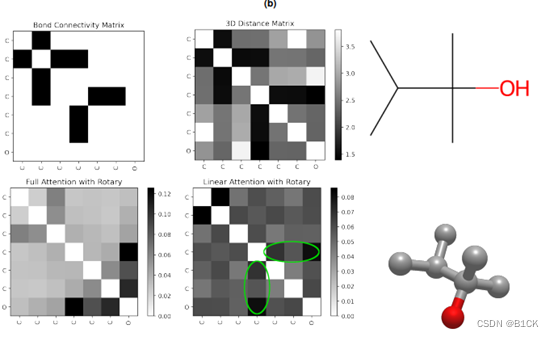

- 采用linear attention mechanism

- rotary positional embedding

模型

transformer encoder(BERT)

输入

构建好词汇表,分词

根据代码,分词用的是bos,eos,pad,mask(不是cls)

SMILES序列

输出

第一个是BOS处理后的feature

最后一个是EOS的feature

使用

用的是最后一层输出的所有向量的平均值而不是BOS

注意力可视化:选的是中间层

注意力图太noisy了