多智能体强化学习这个领域中,很多Paper都使用的一个环境是——星际争多智能体挑战(StarCraft Multi-Agent Challenge, SMAC)。最近也配置了这个环境,把中间一些步骤记录下来。2022.12.26

文章目录

- 1 环境介绍

- 1.1 相关论文

- 1.2 项目代码地址

- 2 安装过程

- 3 相关文献下载地址

- 4 算法复现部分结果

- 4.1 2s3z地图

- 4.2 3m地图

- 4.3 8m地图

1 环境介绍

1.1 相关论文

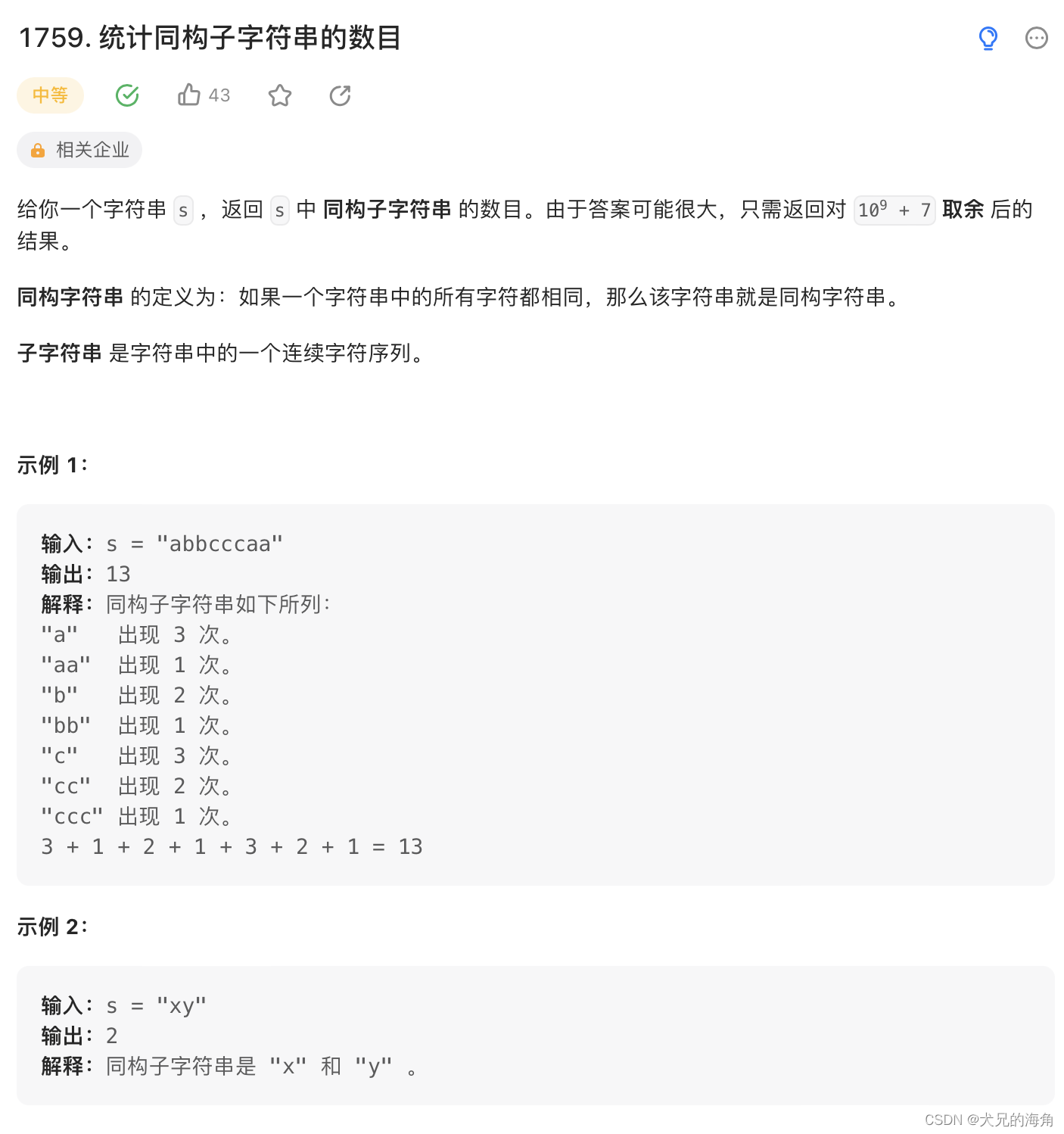

《The StarCraft Multi-Agent Challenge》。

1.2 项目代码地址

SMAC github地址:https://github.com/oxwhirl/smac

gitee地址:https://gitee.com/icze1i0n/smac

2 安装过程

按照官方的说明安装,还算顺利,我是在Win系统安装的。

去大陆官网下载《星际争霸II》游戏

安装用pip命令安装smac库,中间pysc2也自动安装好了。

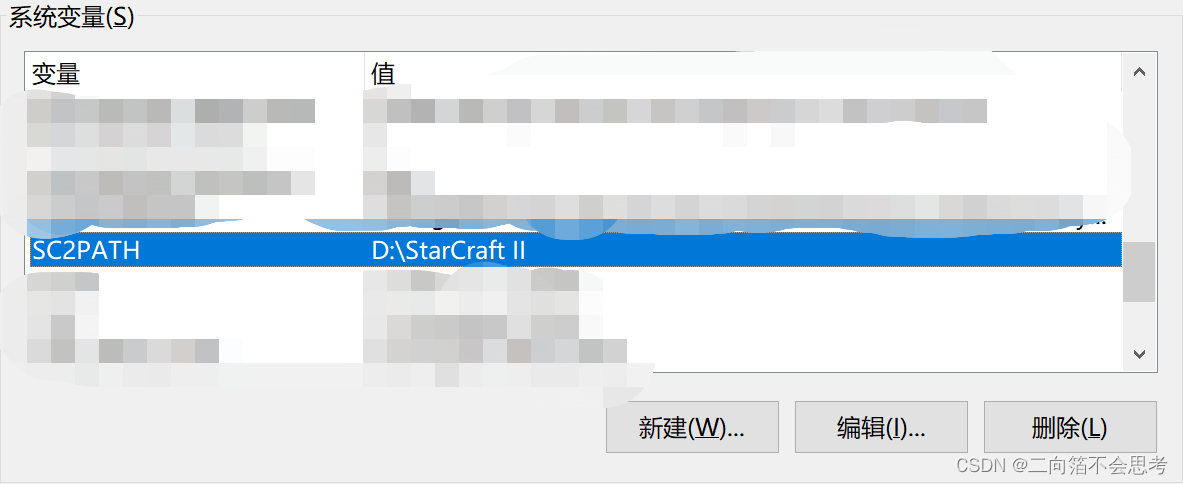

如果星际争霸安装路径不是默认的,需要在系统中添加一个叫做SC2PATH的环境变量,指向安装路径。

设置好后就能跑起来了

3 相关文献下载地址

- IQL: Independent Q-Learning

- QMIX: Monotonic Value Function Factorisation for Deep Multi-Agent Reinforcement Learning

- Value-Decomposition Networks For Cooperative Multi-Agent Learning

- Counterfactual Multi-Agent Policy Gradients

- QTRAN: Learning to Factorize with Transformation for Cooperative Multi-Agent Reinforcement Learning

- Learning Multiagent Communication with Backpropagation

- From Few to More: Large-scale Dynamic Multiagent Curriculum Learning

- Multi-Agent Game Abstraction via Graph Attention Neural Network

- MAVEN: Multi-Agent Variational Exploration

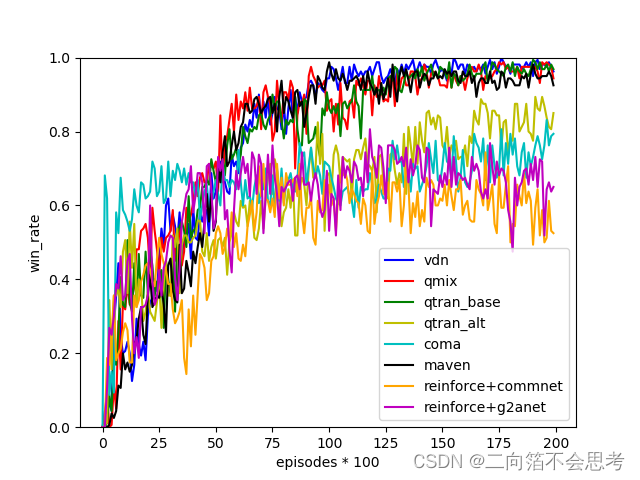

4 算法复现部分结果

下面这些结果印象中是国内一个公司的实验室复现的,github地址在这里。

4.1 2s3z地图

4.2 3m地图

4.3 8m地图