Multi-gpu问题

域在z方向划分为num_gpus段,其中num_gpus表示可用GPU的数量,然后每个GPU相应地负责一个大小为nx×ny×(nz/num_gpus)的子域。

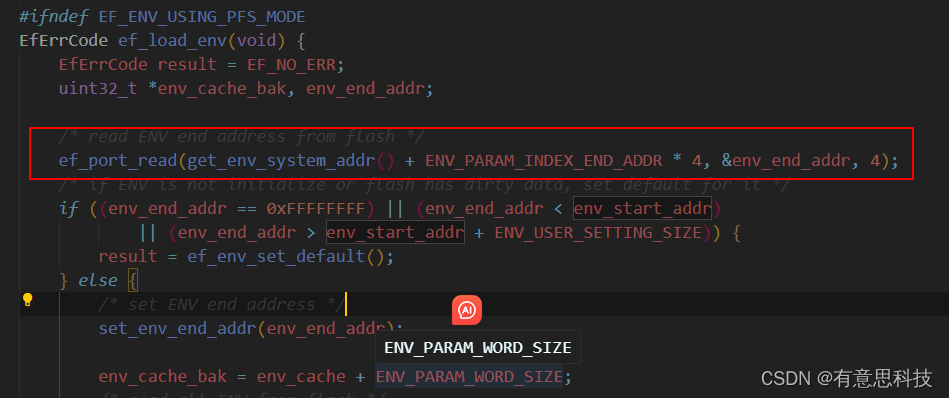

虽然整个域在主机端表示,但gpu只存储它们的子域。由于更新GPU k(k = 0,…,num_gpus -1)上的磁场和电场分量需要分别来自设备k+1和k-1的场值,因此我们需要在多GPU域分解边界上增加额外的nx×ny细胞来存储这些数据。

1.这些鬼细胞需要先复制到CPU上再进行GPU之间的传递,会增加时间

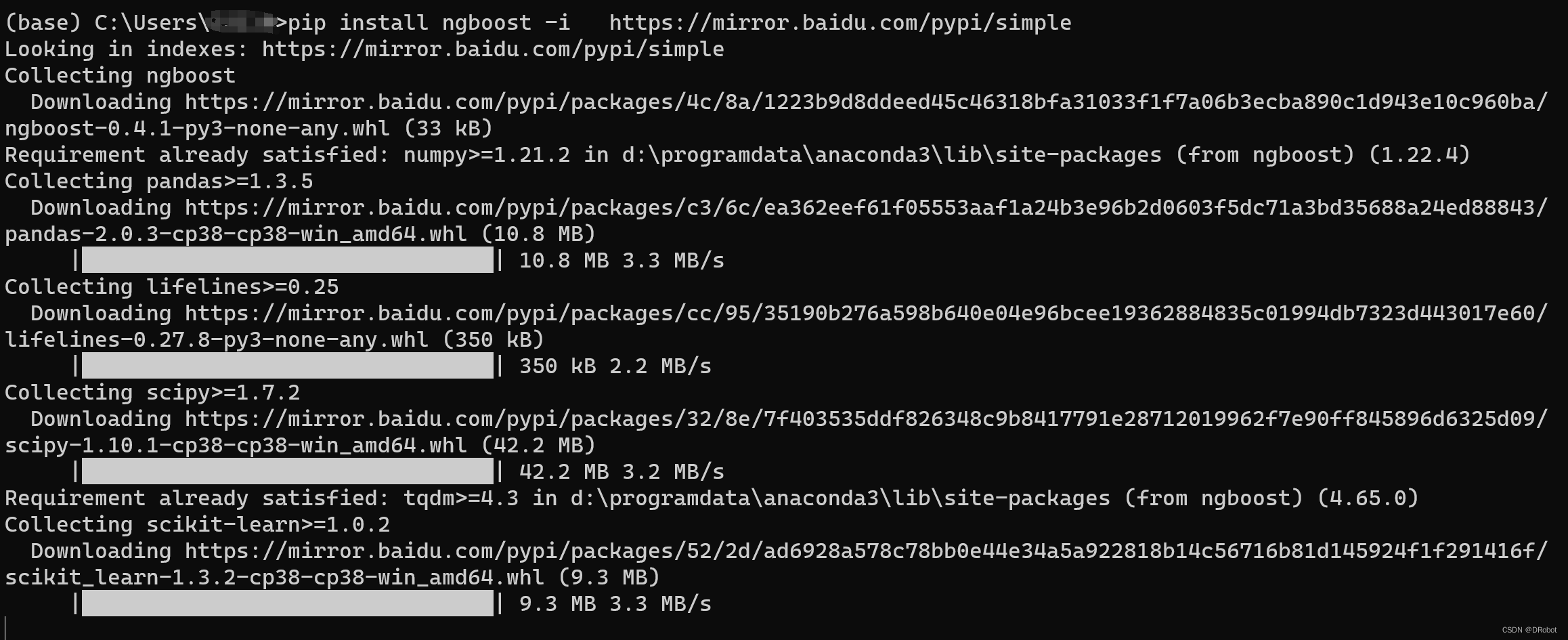

解决:使用Open-MP API将一个CPU线程分配给一个GPU,这样每个设备在主机上都有自己的上下文

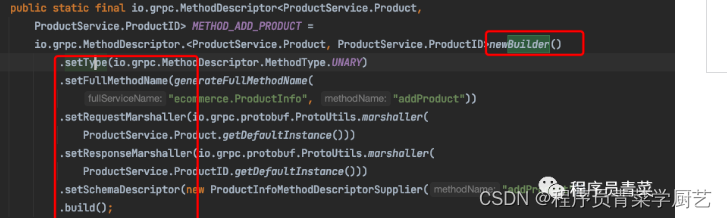

//如果没有在第一个设备上操作

//将电场边界单元从设备复制到主机(顶部)

//在读取更新的幽灵单元之前与其他线程同步

#pragama omp barrier

//如果没有在最后一个设备上运行

//将电场幽灵单元从主机复制到设备

//调用内核,以计算磁场分量

kH<<<dimGrid, dimBlock>>>(…, cpu_thread_id);

//如果未在最后一个设备上操作

//将磁场边界单元从设备复制到主机(底部)

//在读取更新的幽灵单元之前与其他线程同步

#pragama omp barrier

//如果没有在第一个设备上运行,

//将来自主机的磁场幽灵单元复制到设备

//调用内核,以计算电场组件

kH<<<dimGrid, dimBlock>>>(…, cpu_thread_id);

为了最大化我们使用的内核的计算效率,我们分别使用__mul24和__fdividef函数用于整数乘法和浮点除法。__mul24提供了传统32位乘法的24位整数乘法,相比于12个时钟周期,__fdividef执行20个时钟周期的单精度浮点除法,优于划分浮点值[1]通常需要的36个时钟周期。

我们使用OpenMP API对NVIDIA GPU卡上分散介质的FDTD分析。通过比较计算出的SAR值与使用mie序列近似得到的相应结果或已发表的结果,说明了我们实现的准确性。双方达成了很好的协议。我们进一步研究了在三代NVIDIA gpu上的FDTD方程的多gpu计算的优势。结果表明,尽管最近的卡提供了比GeForce 8800卡更好的性能,但使用任何一代都可能导致多个gpu的接近线性加速因素。我们还分析了将解剖人体模型暴露于不同角度入射正弦平面波入射的现实问题,并求解了全身平均比吸收率(SAR)。

![[C++]命名空间等——喵喵要吃C嘎嘎](https://img-blog.csdnimg.cn/f74c76d54537422ca5d9ba61d83b4bfb.png)