中值滤波器

中值滤波器是一种常用的非线性滤波器,其基本原理是:选择待处理像素的一个邻域中各像素值的中值来代替待处理的像素。主要功能使某像素的灰度值与周围领域内的像素比较接近,从而消除一些孤立的噪声点,所以中值滤波器能够很好的消除椒盐噪声。不仅如此,中值滤波器在消除噪声的同时,还能有效的保护图像的边界信息,不会对图像造成很大的模糊(相比于均值滤波器)。

中值滤波器的效果受滤波窗口尺寸的影响较大,在消除噪声和保护图像的细节存在着矛盾:滤波窗口较小,则能很好的保护图像中的某些细节,但对噪声的过滤效果就不是很好,因为实际中的噪声不可能只占一个像素位置;反之,窗口尺寸较大有较好的噪声过滤效果,但是会对图像造成一定的模糊。另外,根据中值滤波器原理,如果在滤波窗口内的噪声点的个数大于整个窗口内非噪声像素的个数,则中值滤波就不能很好的过滤掉噪声。

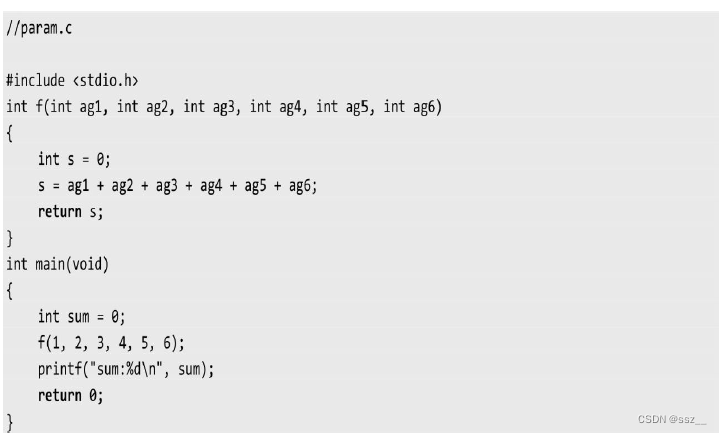

算法实现:

uchar adaptiveProcess(const Mat &im, int row,int col,int kernelSize,int maxSize)

{

vector<uchar> pixels;

for (int a = -kernelSize / 2; a <= kernelSize / 2; a++)

for (int b = -kernelSize / 2; b <= kernelSize / 2; b++)

{

pixels.push_back(im.at<uchar>(row + a, col + b));

}

sort(pixels.begin(), pixels.end());

auto min = pixels[0];

auto max = pixels[kernelSize * kernelSize - 1];

auto med = pixels[kernelSize * kernelSize / 2];

auto zxy = im.at<uchar>(row, col);

if (med > min && med < max)

{

// to B

if (zxy > min && zxy < max)

return zxy;

else

return med;

}

else

{

kernelSize += 2;

if (kernelSize <= maxSize)

return adpativeProcess(im, row, col, kernelSize, maxSize); // 增大窗口尺寸,继续A过程。

else

return med;

}

}高斯滤波

高斯滤波也是一种非常常见的滤波方法,其核的形式为:

其中是图像中的点的坐标, 为标准差,高斯模板就是利用这个函数来计算的,x和y都是代表,以核中心点为坐标原点的坐标值。这里想说一下 的作用,当 比较小的时候,生成的高斯模板中心的系数比较大,而周围的系数比较小,这样对图像的平滑效果不明显。而当 比较大时,生成的模板的各个系数相差就不是很大,比较类似于均值模板,对图像的平滑效果比较明显。

高斯滤波没有特别多可说的,最主要的作用是滤除高斯噪声,即符合正态分布的噪声。

实现的方式有两种,第一种是按照公式暴力实现,代码如下:

//O(m * n * ksize^2)

void GaussianFilter(const Mat &src, Mat &dst, int ksize, double sigma)

{

CV_Assert(src.channels() || src.channels() == 3); //只处理3通道或单通道的图片

double **GaussianTemplate = new double *[ksize];

for(int i = 0; i < ksize; i++){

GaussianTemplate[i] = new double [ksize];

}

generateGaussianTemplate(GaussianTemplate, ksize, sigma);

//padding

int border = ksize / 2;

copyMakeBorder(src, dst, border, border, border, border, BORDER_CONSTANT);

int channels = dst.channels();

int rows = dst.rows - border;

int cols = dst.cols - border;

for(int i = border; i < rows; i++){

for(int j = border; j< cols; j++){

double sum[3] = {0};

for(int a = -border; a <= border; a++){

for(int b = -border; b <= border; b++){

if(channels == 1){

sum[0] += GaussianTemplate[border+a][border+b] * dst.at<uchar>(i+a, j+b);

}else if(channels == 3){

Vec3b rgb = dst.at<Vec3b>(i+a, j+b);

auto k = GaussianTemplate[border+a][border+b];

sum[0] += k * rgb[0];

sum[1] += k * rgb[1];

sum[2] += k * rgb[2];

}

}

}

for(int k = 0; k < channels; k++){

if(sum[k] < 0) sum[k] = 0;

else if(sum[k] > 255) sum[k] = 255;

}

if(channels == 1){

dst.at<uchar >(i, j) = static_cast<uchar >(sum[0]);

}else if(channels == 3){

Vec3b rgb = {static_cast<uchar>(sum[0]), static_cast<uchar>(sum[1]), static_cast<uchar>(sum[2])};

dst.at<Vec3b>(i, j) = rgb;

}

}

}

for(int i = 0; i < ksize; i++)

delete[] GaussianTemplate[i];

delete[] GaussianTemplate;

}双边滤波

双边滤波是一种非线性滤波方法,是结合了图像的邻近度和像素值相似度的一种折中,在滤除噪声的同时可以保留原图的边缘信息。整个双边滤波是由两个函数构成:一个函数是由空间距离决定的滤波器系数,另外一个诗由像素差值决定的滤波器系数。整个双边滤波的公式如下:

其中权重系数 取决于定义域核:

和值域核

的乘积。其中定义域核影响的是空间位置,如果把图像看成一个二维函数,那么定义域就是图像的坐标,值域就是该坐标处对应的像素值。定义域核就是普通的高斯核,全局使用一个就可以。但值域核是需要对每个像素点滑动进行计算的。

那么如何理解双边滤波呢

高斯滤波的滤波核的意义是,滤波后的像素值等于窗口内的像素值的加权平均值,权值系数是符合高斯分布,距离该点越近,权值越大。但是没有考虑像素值与当前点的差距。现在加上值域核,意义就在,滤波后当前点的像素值还会受到领域内像素值与自身的像素值差异的影响,不仅仅是距离来决定。这样,在平缓的区域里,由于像素值差异非常小,则值域的权重趋向于1,所以双边滤波就近似为高斯滤波。而在边缘区域中,由于像素值的差异比较大,则值域核趋向于0,权重下降,即当前像素受到领域内像素影响比较小,从而保留了边缘信息。

双边滤波的代码

opencv中提供了bilateralFilter()函数来实现双边滤波操作,其原型如下:

void cv::bilateralFilter(InputArray src,

OutputArray dst,

int d,

double sigmaColor,

double sigmaSpace,

int borderType = BORDER_DEFAULT

)

-

InputArray src: 输入图像,可以是Mat类型,图像必须是8位整型或浮点型单通道、三通道的图像。

-

OutputArray dst: 输出图像,和原图像有相同的尺寸和类型。

-

int d: 表示在过滤过程中每个像素邻域的直径范围。如果这个值是非正数,则函数会从第五个参数sigmaSpace计算该值。

-

double sigmaColor: 颜色空间过滤器的值,这个参数的值月大,表明该像素邻域内有越宽广的颜色会被混合到一起,产生较大的半相等颜色区域。 (这个参数可以理解为值域核的 和 )

-

double sigmaSpace: 坐标空间中滤波器的sigma值,如果该值较大,则意味着越远的像素将相互影响,从而使更大的区域中足够相似的颜色获取相同的颜色。当d>0时,d指定了邻域大小且与sigmaSpace无关,否则d正比于sigmaSpace. (这个参数可以理解为空间域核的 和 )

-

int borderType=BORDER_DEFAULT: 用于推断图像外部像素的某种边界模式,有默认值BORDER_DEFAULT.

-

#include <iostream> #include <opencv2/opencv.hpp> using namespace std; using namespace cv; //定义全局变量 const int g_ndMaxValue = 100; const int g_nsigmaColorMaxValue = 200; const int g_nsigmaSpaceMaxValue = 200; int g_ndValue; int g_nsigmaColorValue; int g_nsigmaSpaceValue; Mat g_srcImage; Mat g_dstImage; //定义回调函数 void on_bilateralFilterTrackbar(int, void*); int main() { g_srcImage = imread("lena.jpg"); //判断图像是否加载成功 if(g_srcImage.empty()) { cout << "图像加载失败!" << endl; return -1; } else cout << "图像加载成功!" << endl << endl; namedWindow("原图像", WINDOW_AUTOSIZE); imshow("原图像", g_srcImage); //定义输出图像窗口属性和轨迹条属性 namedWindow("双边滤波图像", WINDOW_AUTOSIZE); g_ndValue = 10; g_nsigmaColorValue = 10; g_nsigmaSpaceValue = 10; char dName[20]; sprintf(dName, "邻域直径 %d", g_ndMaxValue); char sigmaColorName[20]; sprintf(sigmaColorName, "sigmaColor %d", g_nsigmaColorMaxValue); char sigmaSpaceName[20]; sprintf(sigmaSpaceName, "sigmaSpace %d", g_nsigmaSpaceMaxValue); //创建轨迹条 createTrackbar(dName, "双边滤波图像", &g_ndValue, g_ndMaxValue, on_bilateralFilterTrackbar); on_bilateralFilterTrackbar(g_ndValue, 0); createTrackbar(sigmaColorName, "双边滤波图像", &g_nsigmaColorValue, g_nsigmaColorMaxValue, on_bilateralFilterTrackbar); on_bilateralFilterTrackbar(g_nsigmaColorValue, 0); createTrackbar(sigmaSpaceName, "双边滤波图像", &g_nsigmaSpaceValue, g_nsigmaSpaceMaxValue, on_bilateralFilterTrackbar); on_bilateralFilterTrackbar(g_nsigmaSpaceValue, 0); waitKey(0); return 0; } void on_bilateralFilterTrackbar(int, void*) { bilateralFilter(g_srcImage, g_dstImage, g_ndValue, g_nsigmaColorValue, g_nsigmaSpaceValue); imshow("双边滤波图像", g_dstImage); }形态学滤波

在特殊领域运算形式——结构元素(Sturcture Element),在每个像素位置上与二值图像对应的区域进行特定的逻辑运算。运算结构是输出图像的相应像素。运算效果取决于结构元素大小内容以及逻辑运算性质。

结构元素简单地定义为像素的结构(形状)以及一个原点(又称为锚点),使用形态学滤波涉及对图像的每个像素应用这个结构元素,当结构元素的原点与给定的像素对齐时,它与图像相交部分定义了一组进行形态学运算的像素。原则上,结构元素可以是任何形状,但通常使用简单的形状,比如方形、圆形和菱形,而原点位于中心位置(基于效率的考虑)。

腐蚀和膨胀两个滤波操作也运算在每个像素周围像素集合上(邻域),这是由结构元素定义的。当应用到一个给定的像素时,结构元素的锚点与该像素的位置对齐,而所有与他相交的像素都被包括在当前像素集合中。腐蚀替换当前像素为像素集合中找到的最小的像素值,而膨胀则替换为像素集合中找到的最大像素值。当然,对于二值图像,每个像素只能被替换为白色像素或黑色像素。

图像滤波源码可参考:OpenCV+QT实现的图像边缘检测、滤波、特征匹配、特征提取源码