基于centos7 ,hadoop2.7.3, spark-2.4.4-bin-hadoop2.7.tgz

目录:

- 一.spark shell

- 二. 读取hdfs文件

- 三.Idea中编写wordcount

一.spark shell

在spark shell中编写wordcount程序读取本地文件

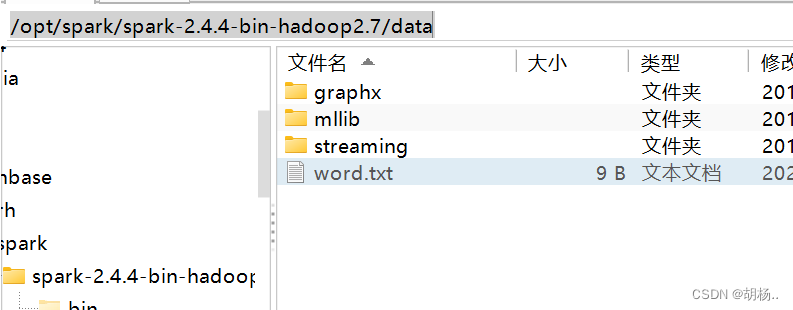

1、准备数据源(创建目录,创建文件)

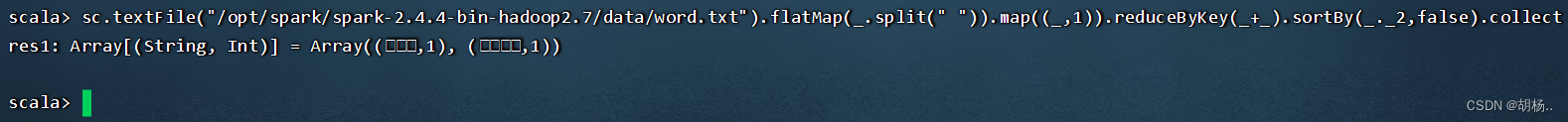

2.代码:

--注意修改文件地址--

sc.textFile("/opt/spark/spark-2.4.4-bin-hadoop2.7/data/word.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).sortBy(_._2,false).collect

二. 读取hdfs文件

1.在hadoop创建目录和文件

![[力扣c++实现]85. 最大矩形](https://img-blog.csdnimg.cn/071ec42ac0ca450a8b114e8fc44087e2.png#pic_center)