报错时我使用的环境如下:

windows10中运行,非linux虚拟机

使用微软的Terminal软件进入powershell环境

scala 2.12.10

spark-3.1.1-bin-hadoop3.2

没有单独安装hadoop环境

java 8

注意一:该spark-3.1.1-bin-hadoop3.2在centos 7、树莓派4b+官方32位系统均可正常运行样例SparkPi,但唯独在window10中频繁报错

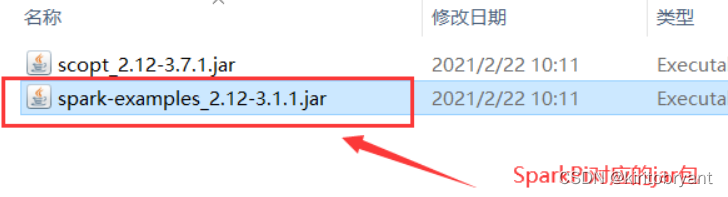

注意二:大家首先要确保自己的路径没有问题,spark-shell和spark-submit都是在bin目录下,而样例sparkPi是在examples目录下,所以要先返回到上级目录再进入examples目录中

注意三:还是路径问题。一定要确保SparkPi的样例名称是当前版本下的spark对应的名称。不同的spark版本有不同的sparkPi名称。名称一定要完全符合。

注意四:还是路径问题。一定要全英文路径。不论是spark还是hadoop(如果你安装了的话)等,为了确保不是路径问题引起的,所有环境路径均设为纯英文。

注意五:下文中的报错信息是循序渐进的,每次报错都会修改设置 甚至 是增加环境配置

最终使用的命令如下,一定要看清楚自己的版本和文件名

bin/spark-submit --class org.apache.spark.examples.SparkPi --master local[2] ./examples/jars/spark-examples_2.12-3.3.1.jar 10

![[思维模式-9]:《如何系统思考》-5- 认识篇 - 改变开环、组合逻辑的线性思考,实施闭环、时序逻辑的动态思考。](https://img-blog.csdnimg.cn/df87183378194fef920384ccdade9c9c.png)