AIGC Artificial Intelligence Generated Content, 或者Generative Artificial Intelligence,它能够生成新的数据、图像、语音、视频、音乐等内容,从而扩展人工智能系统的应用范围。

生成式人工智能有可能给全球经济带来彻底的变化。根据高盛(Goldman Sachs)的数据,未来10年,生成式人工智能可以推动全球GDP增长7%(或近7万亿美元),并在10年内将生产率增长1.5个百分点。

这场AIGC的火热,最早是由ChatGPT带来的,相信很多朋友已经尝试过,目前GPT4已经开放使用,相比3.5又有了长足的进步,国内互联网公司也都在竞相快速跟进,百度最早发布了文心一言,华为云最近也发布了盘古大模型3.0,阿里云推出了通义千问和通义万相,前者针对问答场景,后者面向的是绘画创作,也就是文生图场景。腾讯云推出了VectorDB ,向量数据库,作为知识库构建问答场景的一个工具。我有一个朋友,也算是资深的业内专家,他评价国内厂商在LLM大语言模型方面的水平,大概到年底能接近或追到GPT3.0的水平,那时候估计GPT5.0已经发布了,所以大致可以认为国内的大语言模型和OpenAI有两代的差距,还需要继续努力。由于中美之间大家都明白的关系,OpenAI不给国内商用,虽然有一些套壳的平台,但大规模2B的应用很难落地,从这个角度,实际给了国内厂商一个机会,谁能把基础做扎实,真正达到降本增效,提升生产力,国内的庞大市场,诸多行业及客户,还是有很大想象空间的。正因如此,国内厂商都不愿意错过,无论是对于股市、估值、融资,还是对于存量业务下滑的恐惧,GenAI都是不得不押的赛道。如今的「百模大战」让人想到了百团大战,共享单车大战,谁能笑到最后远未可知。

说到AIGC,大模型,不得不提的还有底层算力,非常烧钱,为了训练GPT-3.5模型, OpenAI使用了大约10,000个英伟达的 GPU,它被认为是用于大型模型训练的门票,GPT-3训练一次的成本约为140万美元,GPT3.5 共有1750亿参数量,训练一次成本1200万美金。10亿美元的硬件开销,对于许多厂商来说,都是一道难以逾越的鸿沟。

目前,英伟达的GPU,A100,H100,一卡难求,限制了对中国的出口,最近又有消息传出,美国政府不排除对中国公司使用云上的GPU做出限制,这就很令人难受了,目前不少国内公司是使用美国三大云厂商来训练和部署自己的AIGC模型的,一旦做出这种限制,估计很多公司需要在海外注册公司来绕开限制,继续使用GPU机型,对国内的人才储备、创新环境又是一个打击。

生成式AI虽然如火如荼,但还在发展的很早期阶段,真正在2B领域落地的案例很少,或者说都还在早期摸索和尝试中。我们总结AIGC主要的创造商业价值的方向有以下四个方向,一个是新体验,在客户和员工互动方面,比如客服、问答系统,能够用AIGC打造更吸引人的创新方式,第二是效率工具,比如生成文章、总结段落大意,生成代码,微软有copilot,亚马逊发布了codewhisperer,这些可以使一些文案创意工作者,软件工程师的生产效率提高,给企业带来价值;第三,见解、洞察, 从海量企业信息中,提取见解和洞察,作为决策支持的工具,基于互联网海量信息的大模型,结合行业知识库,企业知识库,相信能在很多问题的回答中,给出有别于员工、管理层认知的一些深层次洞察,这些内容不乏能够帮助企业做决策的信息;第四,创造力工具,包括生成故事、图像、视频、音乐,AI能够在围棋方面战胜人类,说明机器在围棋可能性方面的计算能力已经超越人类,换句话说就是机器比人毕其一生看到的棋局可能性已经多了很多个数量级,那么在GC方面,也可以认为机器可以比人类有更多的创新空间,不排除可以创造出我们没有见过的,甚至没有想过的音乐,图像,视频,这些都将大大拓展人类的思维空间。

目前已经小规模应用的领域,比如广告、媒体行业,图片、视频的生成,影视作品配乐,游戏社交电商行业, 营销文案,配图生成,logo图标生成,头像生成等等。主要使用开源的模型做个性化构建,应用最广泛的就是Stable Diffusion,Stable Diffusion 2.0 训练花费 200,000 A100 小时,成本不菲,所以目前有人说,大模型的PK实际目前格局已定,只有一些一线大厂可以玩的起,和当年的云计算类似,如今剩下来的也就是几个巨头,连美团、360这样的公司,最后都放弃了云计算方向,相信现在下场玩大模型的厂商,也会逐渐收敛到头部,大模型也有赢者通吃效应,做的越好,投入越大,生态越完备,行业、企业应用越多,推动厂商更多的投入,最终形成一个闭环的增长飞轮,迫使一些排名靠后的厂商放弃开发和维护,最终一定是这个结果。目前除了Top3的巨头公司,其他公司更应该聚焦行业和企业,看看如何将AIGC和行业企业做更好的结合,把大模型到最终2B用户的最后一公里做好,这方面应该能养活很多公司,就如同做SAP/Oracle咨询和实施,做AWS/Azure解决方案的无数生态合作伙伴一样。

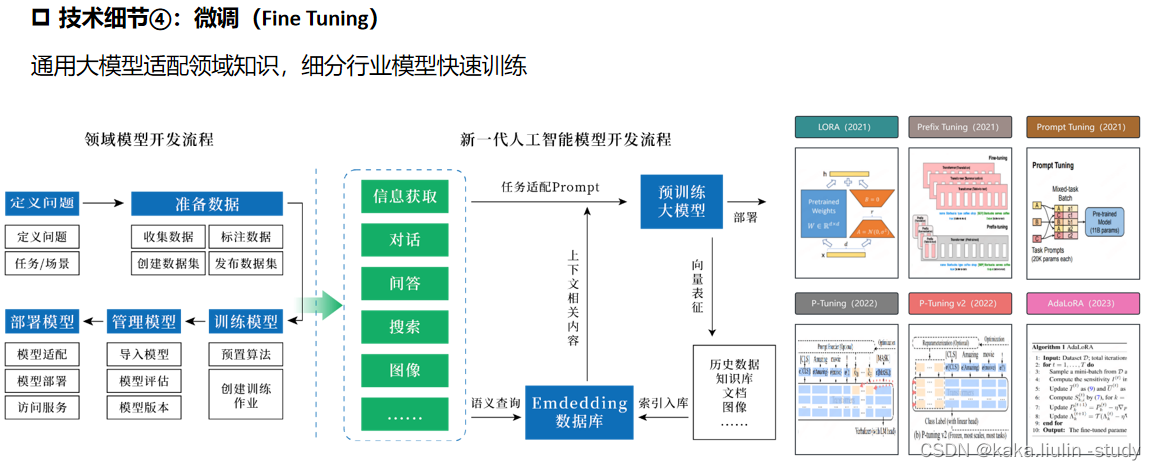

对于希望在AIGC方向有所发力的IT公司,除了开源解决方案的搭建和调优,也不妨去看看各大云厂商的相关服务,比如微软Azure的openAI service,copilot, amazon推出的bedrock,语言大模型titan,当然,也需要关注头部GenAI厂商的开源模型,如meta开源的LLama2,Anthropic的Claude,Stable AI的Stable diffusion,这些模型区别于chatGPT的中心化模式,更接近企业的私有化部署和数据隐私需要,百度阿里华为发布的产品也值得关注,不管是从中美目前大家都心知肚明的科技现状考虑,还是从国内数据隐私、自主可控角度考虑,国内厂商的大模型,大概率是国内企业应用落地的不二选择,研究研究如何集成到现有产品里,或者如何包装成产品给最终用户带来价值,在这个角度来看,大模型更像是一个基础设施功能,当年利用手机的定位功能,可以开发出打车、外卖、导航等一系列应用,颠覆了用户交互方式,大模型也一定不会仅仅是用户问答这一个缺乏想象力的场景,如何在其之上,结合用户场景去改进交互方式,开发出具体应用,未来将是关键点。

对于企业界,管理层也应该高度关注,一边学习和跟进AIGC的技术发展,一边和头部厂商保持沟通,还要一边留意竞争对手的尝试和动作,对于上规模的企业来说,提升哪怕1%的效率也都是不少的钱,关键是生产机制如果变了,极有可能甩掉竞争对手几条街,大概相当于机枪对手枪的关系,在任何有可能被AIGC改造的场景上,都应该保持关注和警惕。

对于工程师来说,保持学习,能把这些工具用起来,对自身也是生产率提高,增强了竞争优势,这些工具就像游戏里的装备一样,装备越好,战斗力越强。

据说已经有prompt engineer,提示词专家,能够月入十万了,各种先入坑的大佬也拉了很多社群,做了各种培训,赚得盆满钵满,各种历史的风口无不是如此,金矿边上卖铲子,沙漠里卖水,都是一本万利的生意,虚拟币挖矿时期的矿机,如今的英伟达,都是类似。

总体来看,AIGC比这些年局部大热的AR/VR,区块链,虚拟币看起来更有普遍价值,潜在的对2C,2B的渗透率都要高不少,基于AIGC的想象空间更大,技术的早期发展到成熟,一般会经历大火爬高和随之而来的低谷,最终进入成熟阶段,被业界广泛采纳,AIGC大概率也是这个曲线。至于现在到底是爬高冲顶还是已经回落正在进入低谷的冷静期,并无公论,需要更长时间的观察。