数据标注一直以来都是人工智能的基础,是机器学习得以训练的不可或缺的步骤。随着互联网的兴起,如何创建和维护一个健康的网络环境将成为互联网平台不断解决的问题,但对于与日俱增的用户增长和铺天盖地的网络信息,人工审核内容变得不切实际,企业纷纷转向机器学习的研发以便高效进行内容审核。

机器学习如何优化内容审核

互联网用户已经超过 45 亿,这个数字还在成指数增长。这些用户每天产生数十亿张图像、视频、消息、帖子和其他内容类型。必须以某种方式对这些内容进行把控,因为大多数互联网用户都希望在访问自己喜欢的社交媒体平台或在线零售商时获得安全、积极的体验。内容审核是针对这一目的的解决方案:它会删除所有隐私、粗话或毁谤、伪造、欺诈、有害或对企业不友好的数据。 传统意义上,各公司依靠人工来完成必要的内容审核,但随着使用量和内容的增长,这种方法不再经济有效。许多企业改为投资机器学习 策略,以创建可自动审核内容的算法。 借助人工智能进行内容审核,在线企业可以更快地扩展规模,并以对用户而言更为一致的方式优化内容审核。这并不能消除对人工审核员(人机协同)的需求,人工审核员仍能提供真实监控,在确保准确性的同时处理更多前后相关的更细微内容问题。但这的确减少了审核员需审阅的内容量,这是积极的一面:过多接触有害内容会对心理健康产生不利影响。将这项艰巨的任务交由机器完成,对公司、员工和用户都有好处。

内容审核在现实世界中的应用

各公司将基于机器学习的内容审核用于各种数字媒体的使用场景,从视频游戏到聊天机器人和聊天室。但是,常见的两大应用是社交媒体和在线零售。

社交媒体

社交媒体存在内容问题。仅 Facebook 就有超过 20 亿用户,他们平均每天观看 1 亿小时的视频并上传 3.5 亿张照片。要手动检查如此庞大的流量产生的内容量,需要雇佣足够多的人员,不但成本高昂,而且很耗时。AI 可以自动检查文本、用户名、图像和视频中是否包含仇恨言论、网络霸凌、隐私或有害内容、虚假新闻和垃圾邮件。然后,算法可以删除不符合公司条款和条件的内容或用户。

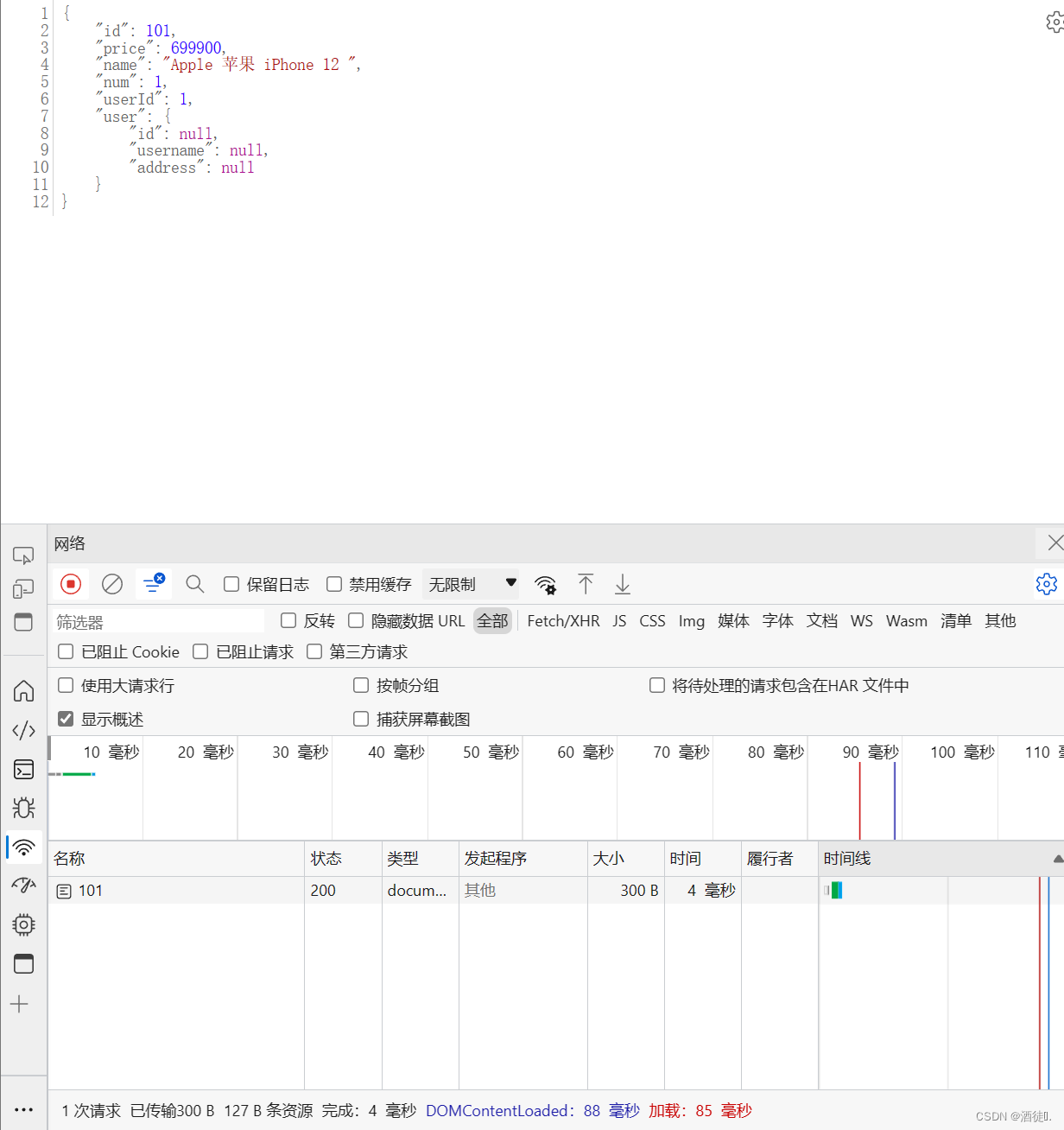

在线零售

内容审核不仅限于社交平台。在线零售商也会使用内容审核工具只向消费者显示高质量、对企业友好的内容。例如,酒店预订网站可以利用 AI 扫描所有酒店房间图像,并删除任何违反网站规则的图像(例如照片中不能出现任何人)。零售商还利用多种机器学习技术的组合来定制业务需求。

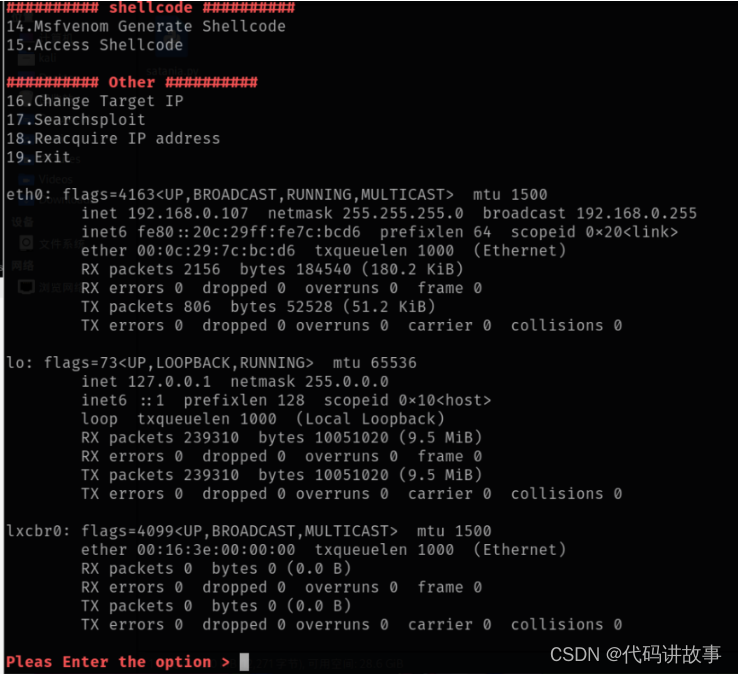

内容审核如何运作?

基于机器学习的审阅系统的内容队列和上报规则因公司而异,但通常会在第一步、第二步或两者中包括 AI 审核:

- 预审。AI 对用户内容进行审核后再发布。然后,将归类为无害的内容设置为对用户可见。被视为很可能有害或对企业不友好的内容会被删除。如果 AI 模型对其预测缺乏信心,则会标记该内容以进行人工审阅。

- 审核后。用户报告不良内容,然后由 AI 或人工进行审阅。如果由 AI 进行审阅,它将遵循第一步中所述工作流程,并自动删除任何被视为不良的内容。

根据媒体类型的不同,AI 将使用各种机器学习技术进行内容预测。

文本

应对不同场景进行文本数据标注,标记后的数据将应用于训练机器模型以便识别不同类型的文本内容。

- 自然语言处理 (NLP):为了理解人类语言,计算机要依赖 NLP。它们可能会使用关键字过滤等技术识别不恰当的语言以进行删除。

- 情感分析:互联网上的上下文很重要,情感分析可以帮助计算机识别讽刺或愤怒等语气。

- 知识库:依靠已知信息数据库,计算机可以预测哪些文章可能是假新闻或识别常见骗局。

图像和视频

应对不同场景进行图像视频数据标注,标记后的数据将应用于训练机器模型以便识别不同类型的图像和视频内容。

- 物体检测:图像分析可以识别图像和视频中不符合平台标准的目标对象,例如裸体。

- 场景理解:计算机将学习理解场景中所发生情况的背景,从而推动更准确的决策。

所有数据类型

无论数据类型如何,各公司都可以使用用户信誉技术识别哪些内容可以信任。计算机会将曾经发布过垃圾邮件或露骨内容的用户归类为“不可信”,并对他们将来发布的任何内容进行更严格的审查。信誉技术还可以打击虚假新闻:计算机更有可能将来自不可靠新闻来源的内容标记为虚假内容。 幸运的是,内容审核不断产生新的训练数据。如果计算机将内容发送给人工审阅员,审阅员会将内容标记为有害或无害,然后将标注数据反馈给算法以提高将来的准确性。

克服内容审核的挑战

内容审核为 AI 模型带来了许多挑战。庞大的内容量需要在不牺牲准确性的前提下创建快速模型。开发准确模型的难点在于数据。数字平台内容的公共数据集数量有限,因为大多数数据是收集该数据的公司的保留财产。 还有语言问题。互联网是全球性的,这意味着内容审核 AI 必须识别数种不同的语言,以及使用这些语言的各种文化的社会背景。语言会随时间变化,因此定期使用新数据更新模型至关重要。 定义之间也存在不一致之处。网络霸凌是什么意思?裸体雕像应该被视为艺术还是露骨?在平台内保持这些定义的一致性很重要,这样才能使用户对审核流程保持信任。用户富有创造力,不断改进方法来发现审核中的漏洞。为解决这个问题,都必须不断重新训练模型,以解决骗局或虚假新闻等问题。 最后,要注意内容审核中的偏见。如果内容涉及语言或用户特征,则可能发生歧视。使训练数据多元化并教会模型了解背景对于减少偏见至关重要。 所有这些挑战似乎是打造有效内容审核平台不可逾越的障碍。但成功是可能的:许多组织都向第三方供应商求助,这些供应商可以提供足够的训练数据,还可以提供全球范围内大量讲各种语言的个人来标注这些数据。第三方合作伙伴还带来机器学习赋能内容审核数据标注工具所需的专业知识,可提供可扩展的高效模型。

澳鹏内容审核专家贾斯汀·亚当 (Justin Adam) 的观点

澳鹏依靠自身的专家团队帮助您构建先进的模型,确保您能够进行成功的内容审核、提供优质的客户体验并提高业务投资回报率。项目经理贾斯汀·亚当 (Justin Adam) 是我们团队的资深专家之一,他负责多个内容审核相关项目,确保客户在通过机器学习实施和改进内容审核时取得成功。贾斯汀对成功的内容审核项目的三大见解:

- 根据现实世界的要求更新政策:每个内容审核决策都应遵循既定的政策;但是,政策必须迅速发展以弥补出现的空白、灰色地带或边缘案例,尤其是对于敏感话题。监控特定市场的内容趋势,发现政策空白,提供建议并部署政策变更,以确保所提供的数据是基于审阅员根据实时、全面的政策指南做出的决策。

- 管理人口统计学偏见:当审阅员代表的是所审核市场中的一般人群时,内容审核有效、可靠也值得信赖。重要的是要定义所需的人口统计学信息,并处理多样性来源的各个方面,以使输入到模型中的数据不会受到人口统计学偏见的影响。

- 通过质量管理策略和专家资源来提供支持:在当今的政治环境中,内容审核决策容易受审查的影响。有效识别和纠正错误,且重要的是防范错误需要全面的策略。我们通常会根据客户的具体需求建议并帮助实施适当的策略,包括组建一支由训练有素的政策主题专家组成的完整团队、建立质量控制审阅层次结构以及量身定制的质量分析和报告。