目录

Apache Hudi 数据湖介绍

Hudi 历程

Hudi Features

Apache Hudi 数据湖介绍

Apache Hudi(发音为“hoodie”)是下一代流媒体数据湖平台源于Uber 。Apache Hudi将核心仓库和数据库功能直接引入数据湖。Hudi提供了表、事务、高效的追加/删除、高级索引、流式接收服务、数据集群/压缩优化和并发,同时将数据保持为开源文件格式。

Apache Hudi 不仅非常适合流式工作负载,还允许您创建高效的增量批处理管道。阅读文档以了解更多用例描述,并查看谁在使用Hudi,了解世界上一些最大的数据湖,包括Uber、Amazon、Bytedance等,是如何利用Hudi改造其生产数据湖的。

Apache Hudi 可以在任何云存储平台上轻松使用。Hudi的高级性能优化,使任何流行的查询引擎(包括Apache Spark、Flink、Presto、Trino、Hive等)的分析工作负载更快。

Apache Hudi 在 “Hudi、Delta lake、Iceberg” 三大主流数据湖中社区、生态发展是比较好的,在助力湖仓一体、流式数仓起到了很大的作用。

GitHub - apache/hudi: Upserts, Deletes And Incremental Processing on Big Data.

Hello from Apache Hudi | Apache Hudi

Hudi 历程

2015 年:发表了增量处理的核心思想/原则(O'reilly 文章);

2016 年:由 Uber 创建并为所有数据库/关键业务提供支持;

2017 年:由 Uber 开源,并支撑 100PB 数据湖;

2018 年:吸引大量使用者,并因云计算普及;

2019 年:成为 ASF 孵化项目,并增加更多平台组件;

2020 年:毕业成为 Apache 顶级项目,社区、下载量、采用率增长超过 10 倍;

2021 年:支持 Uber 500PB 数据湖,SQL DML、Flink 集成、索引、元服务器、缓存。

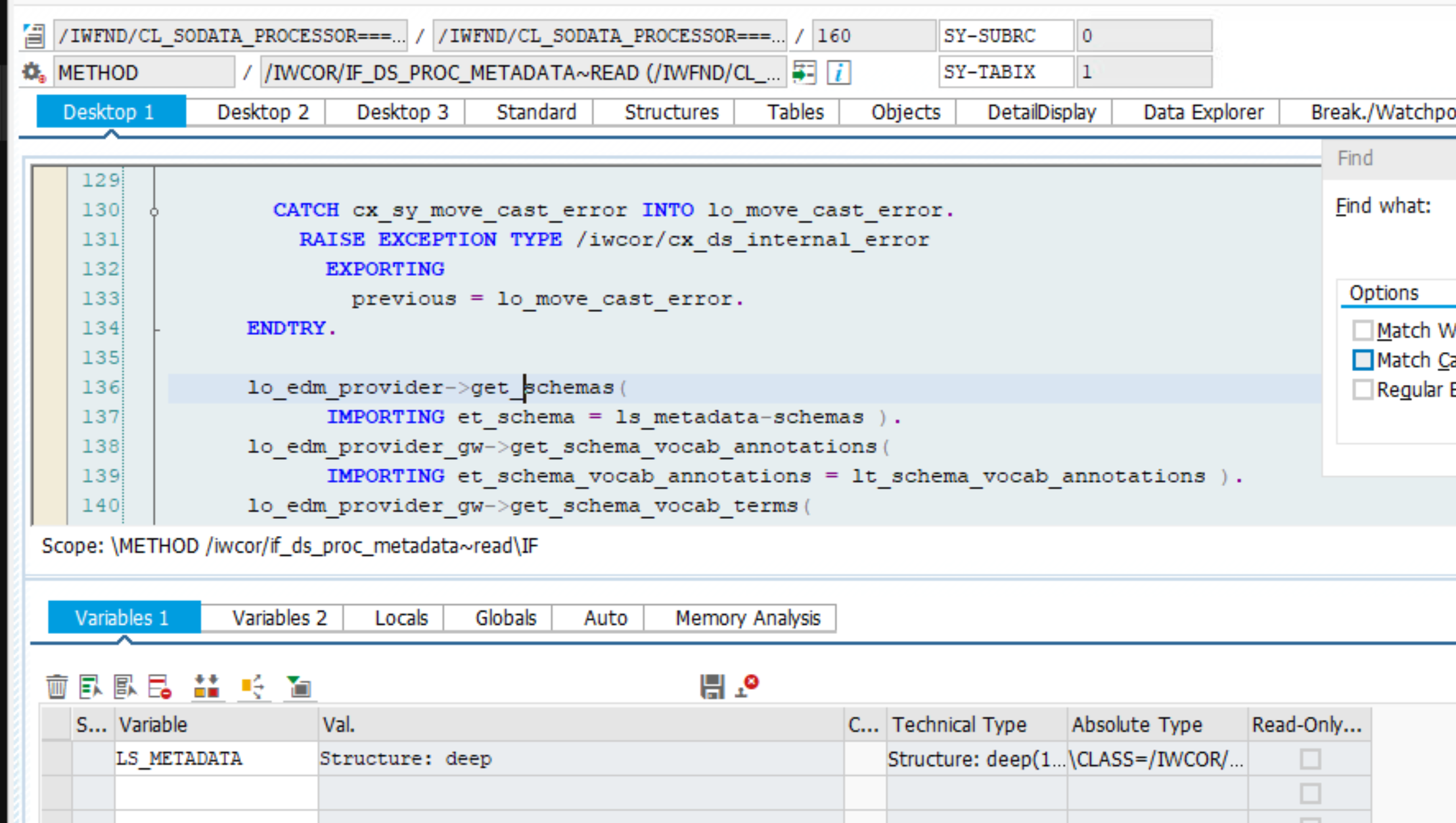

Hudi Features

![[附源码]Nodejs计算机毕业设计基于云数据库的便民民宿租赁系统Express(程序+LW)](https://img-blog.csdnimg.cn/8a9cf9dfebc34ec2b040b1363bd4980d.png)

![[CocosCreator]封装行为树(一)](https://img-blog.csdnimg.cn/202ee5b1a395497fbf8371fd31938ce2.png)