一、MapReduce编程实例——词频统计实现

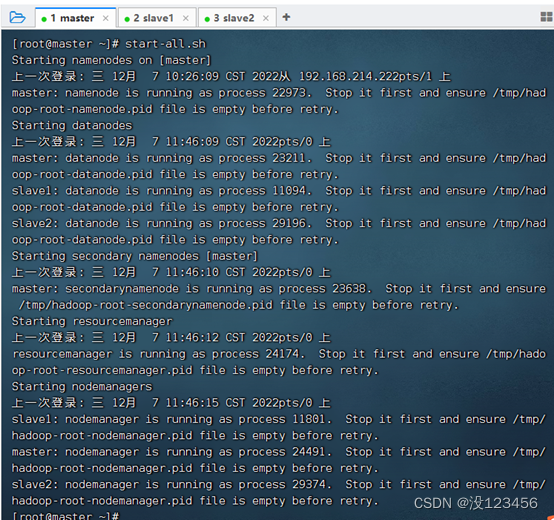

启动hadoop服务

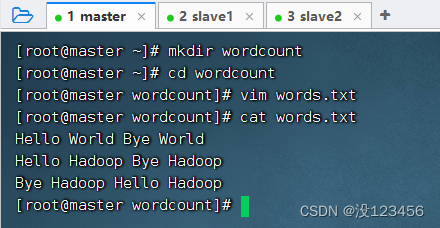

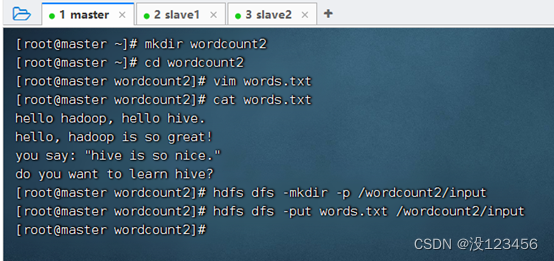

1、准备数据文件

(1)在虚拟机上创建文本文件

创建wordcount目录,在里面创建words.txt文件

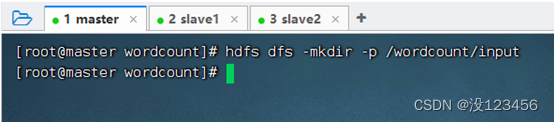

(2)上传文件到HDFS指定目录

创建/wordcount/input目录,执行命令:hdfs dfs -mkdir -p /wordcount/input

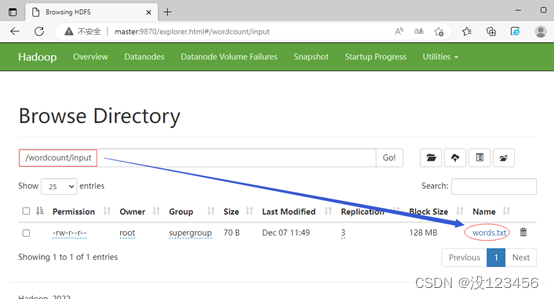

将文本文件words.txt,上传到HDFS的/wordcount/input目录

在Hadoop WebUI界面上查看上传的文件

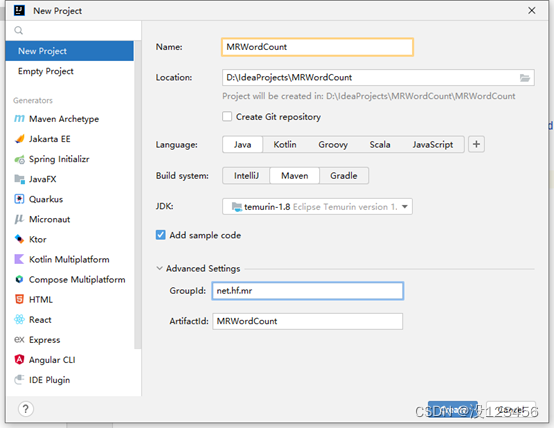

2、创建Maven项目

创建Maven项目 - MRWordCount

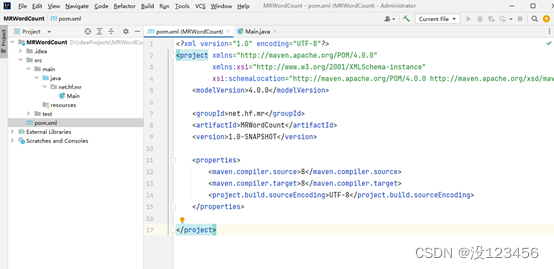

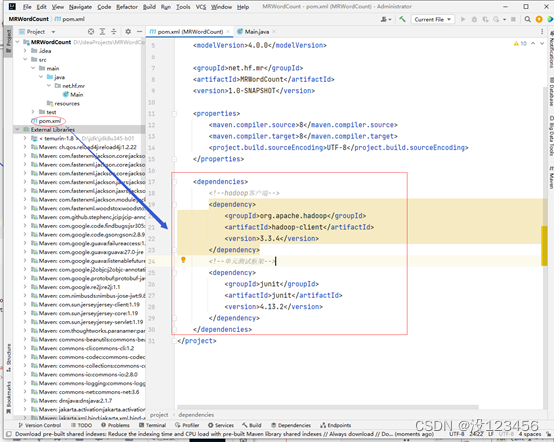

3、添加相关依赖

在pom.xml文件里添加hadoop和junit依赖

<dependencies>

<!--hadoop客户端-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<!--单元测试框架-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

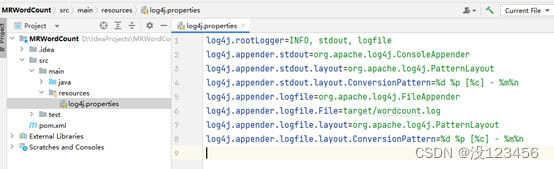

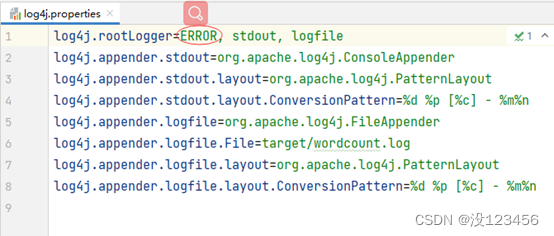

4、创建日志属性文件

在resources目录里创建log4j.properties文件

log4j.rootLogger=INFO, stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/wordcount.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

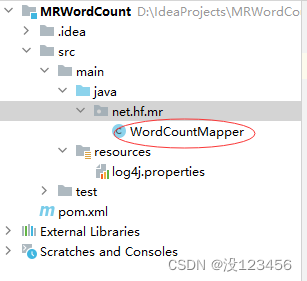

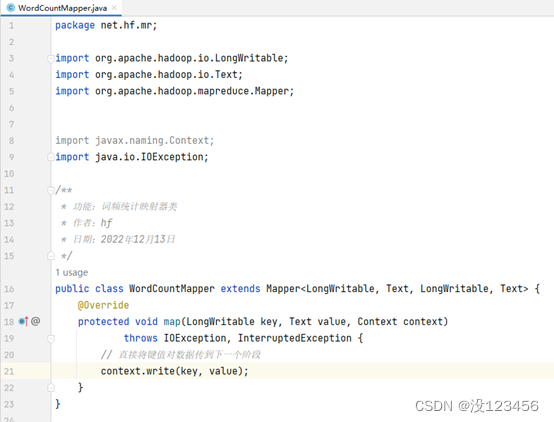

5、创建词频统计映射器类

创建net.hf.mr包,在包里创建WordCountMapper类

package net.hw.mr;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

/**

* 功能:词频统计映射器类

* 作者:hf

* 日期:2022年12月13日

*/

public class WordCountMapper extends Mapper<LongWritable, Text, LongWritable, Text> {

@Override

protected void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

// 直接将键值对数据传到下一个阶段

context.write(key, value);

}

}

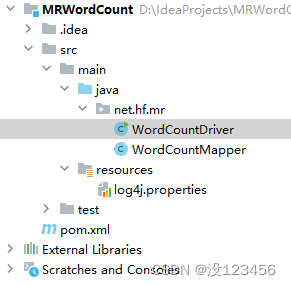

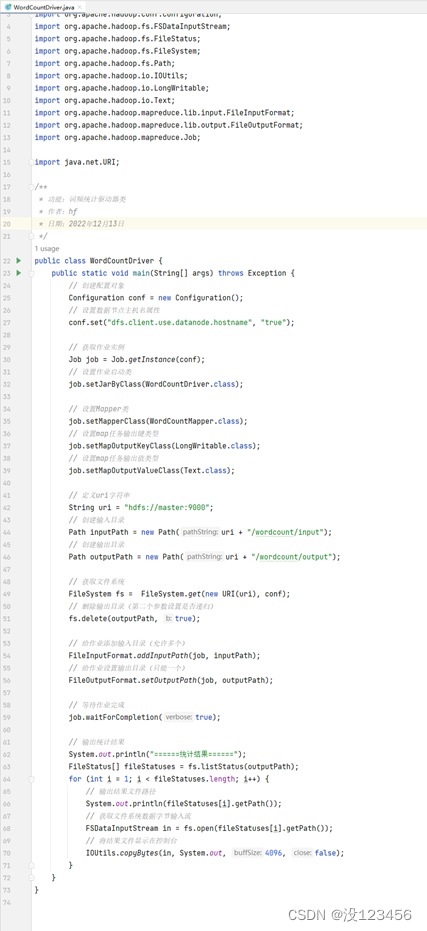

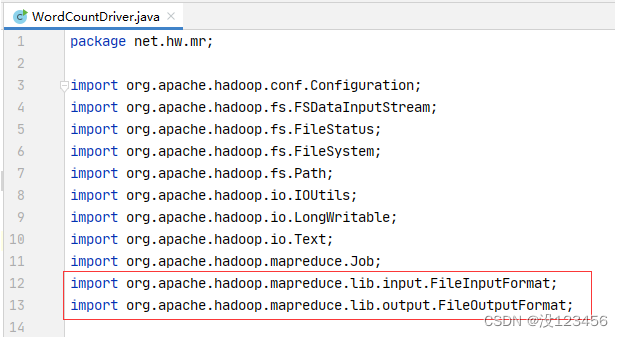

6、创建词频统计驱动器类

在net.hf.mr包里创建WordCountDriver类

package net.hw.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.net.URI;

/**

* 功能:词频统计驱动器类

* 作者:hf

* 日期:2022年12月13日

*/

public class WordCountDriver {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 获取作业实例

Job job = Job.getInstance(conf);

// 设置作业启动类

job.setJarByClass(WordCountDriver.class);

// 设置Mapper类

job.setMapperClass(WordCountMapper.class);

// 设置map任务输出键类型

job.setMapOutputKeyClass(LongWritable.class);

// 设置map任务输出值类型

job.setMapOutputValueClass(Text.class);

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建输入目录

Path inputPath = new Path(uri + "/wordcount/input");

// 创建输出目录

Path outputPath = new Path(uri + "/wordcount/output");

// 获取文件系统

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 删除输出目录(第二个参数设置是否递归)

fs.delete(outputPath, true);

// 给作业添加输入目录(允许多个)

FileInputFormat.addInputPath(job, inputPath);

// 给作业设置输出目录(只能一个)

FileOutputFormat.setOutputPath(job, outputPath);

// 等待作业完成

job.waitForCompletion(true);

// 输出统计结果

System.out.println("======统计结果======");

FileStatus[] fileStatuses = fs.listStatus(outputPath);

for (int i = 1; i < fileStatuses.length; i++) {

// 输出结果文件路径

System.out.println(fileStatuses[i].getPath());

// 获取文件系统数据字节输入流

FSDataInputStream in = fs.open(fileStatuses[i].getPath());

// 将结果文件显示在控制台

IOUtils.copyBytes(in, System.out, 4096, false);

}

}

}

注意导包问题

不要导成org.apache.hadoop.mapred包下的FileInputFormat与FileOutputFormat了

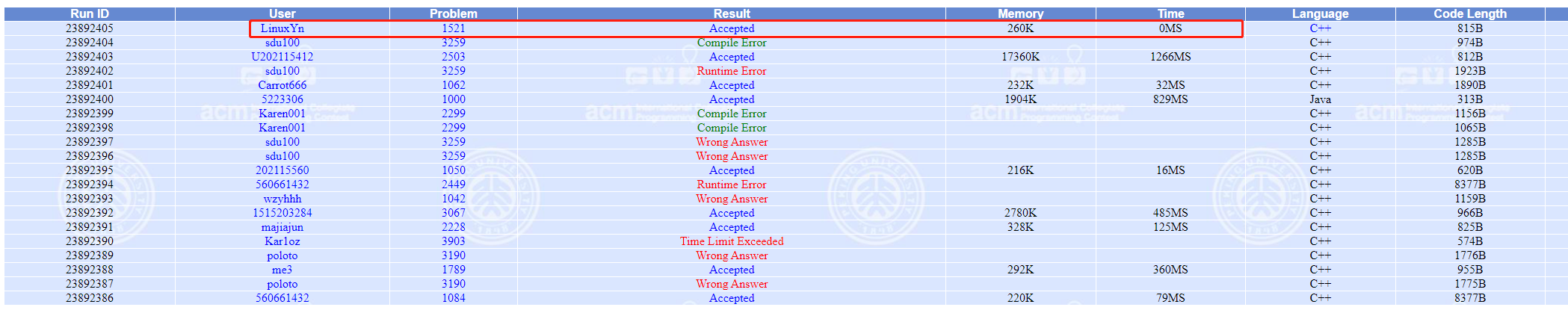

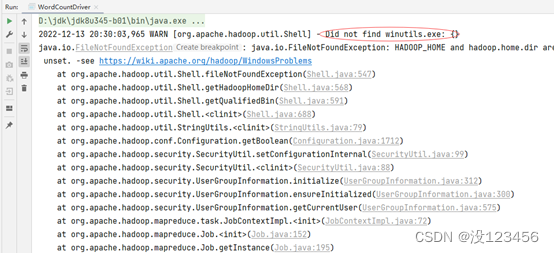

7、运行词频统计驱动器类,查看结果

运行报错,提示:Did not find winutils.exe

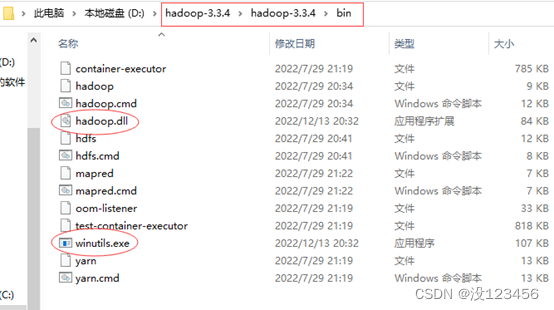

解决办法:下载对应版本的winutils.exe和hadoop.dll,放在hadoop安装目录的bin子目录里

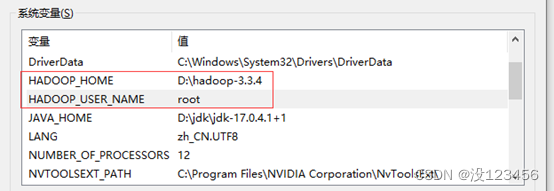

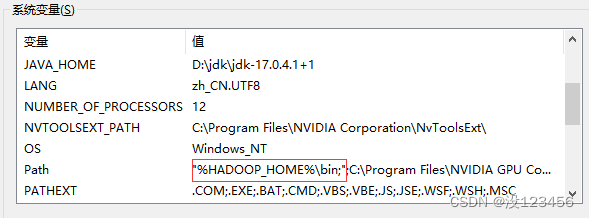

配置环境变量

| 环境变量 | 值 |

|---|---|

| HADOOP_HOME | D:\hadoop-3.3.4 |

| HADOOP_USER_NAME | root |

| Path | %HADOOP_HOME%\bin; |

此时,重启IDEA,打开MRWordCount项目,运行WordCountDriver类,就没有问题了

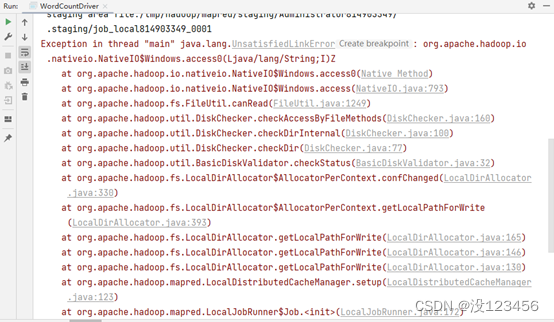

如果还出现了以下问题

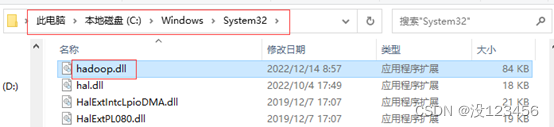

解决方法:将hadoop.dll文件拷贝到Windows目录C:\Windows\System32中

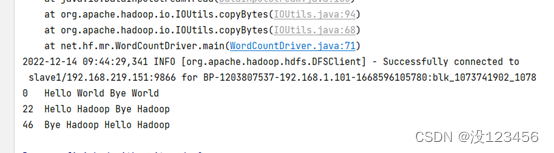

然后再运行WordCountDriver类

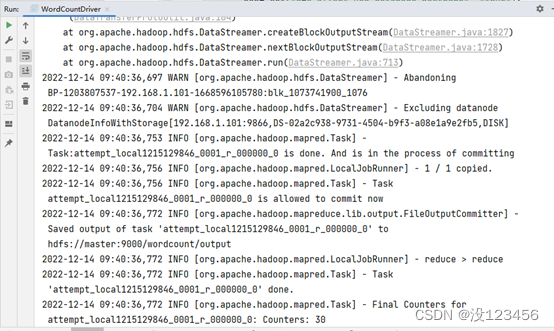

运行统计结果之前会显示大量信息

如果不想看到统计结果之前的大堆信息,可以修改log4j.properties文件,将INFO改为ERROR

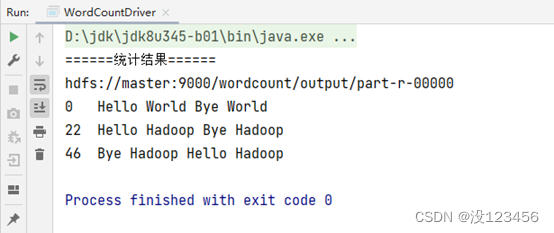

再运行程序,查看结果

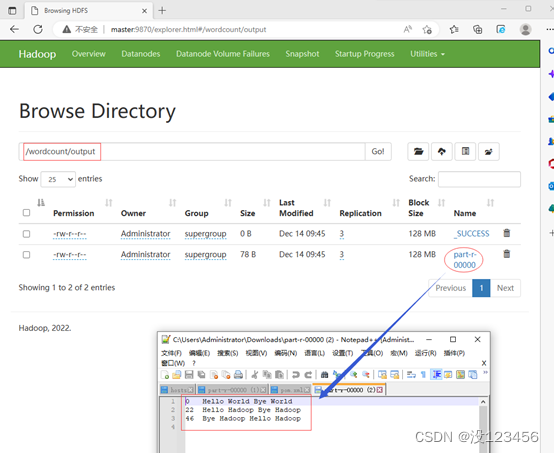

利用Hadoop WebUI界面查看结果文件

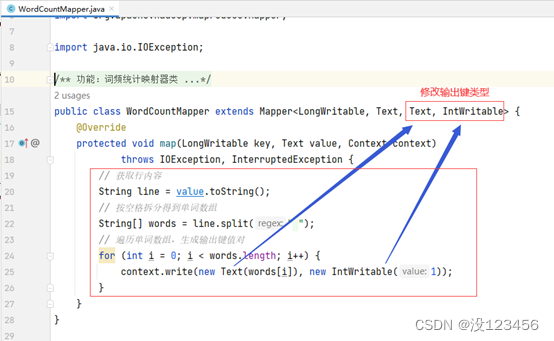

8、修改词频统计映射器类

行首数字对于我们做单词统计没有任何用处,只需要拿到每一行内容,按空格拆分成单词,每个单词计数1,因此,WordCoutMapper的输出应该是单词和个数,于是,输出键类型为Text,输出值类型为IntWritable。

将每行按空格拆分成单词数组,输出<单词, 1>的键值对

package net.hf.mr;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

/**

* 功能:词频统计映射器类

* 作者:hf

* 日期:2022年12月13日

*/

public class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

@Override

protected void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

// 获取行内容

String line = value.toString();

// 按空格拆分得到单词数组

String[] words = line.split(" ");

// 遍历单词数组,生成输出键值对

for (int i = 0; i < words.length; i++) {

context.write(new Text(words[i]), new IntWritable(1));

}

}

}

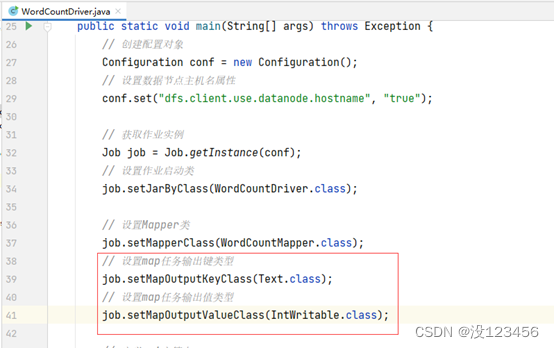

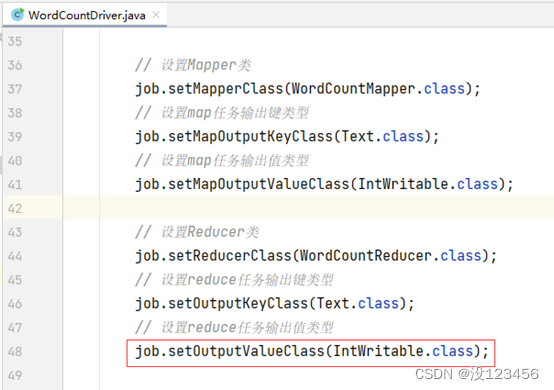

由于WordCountMapper的输出键值类型发生变化,所以必须告诉WordCountDriver

9、修改词频统计驱动器类

修改map任务输出键值类型

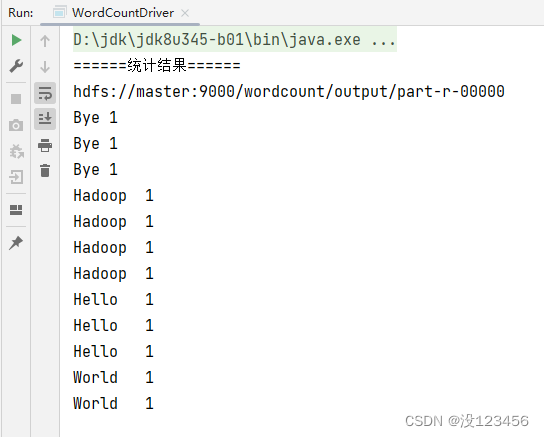

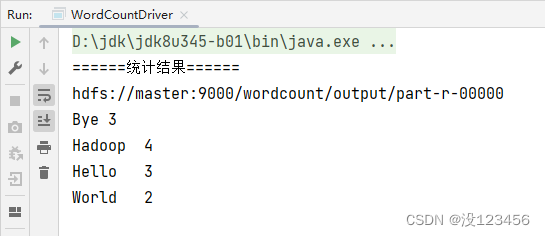

10、启动词频统计驱动器类,查看结果

观察输出结果,map阶段会按键排序输出

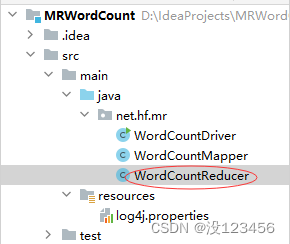

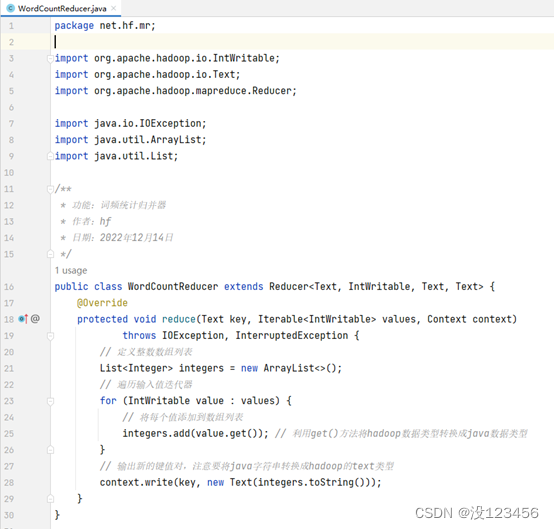

11、创建词频统计归并器类

在net.hf.mr包里创建WordCountReducer

package net.hw.mr;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

/**

* 功能:词频统计归并器

* 作者:hf

* 日期:2022年12月14日

*/

public class WordCountReducer extends Reducer<Text, IntWritable, Text, Text> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

// 定义整数数组列表

List<Integer> integers = new ArrayList<>();

// 遍历输入值迭代器

for (IntWritable value : values) {

// 将每个值添加到数组列表

integers.add(value.get()); // 利用get()方法将hadoop数据类型转换成java数据类型

}

// 输出新的键值对,注意要将java字符串转换成hadoop的text类型

context.write(key, new Text(integers.toString()));

}

}

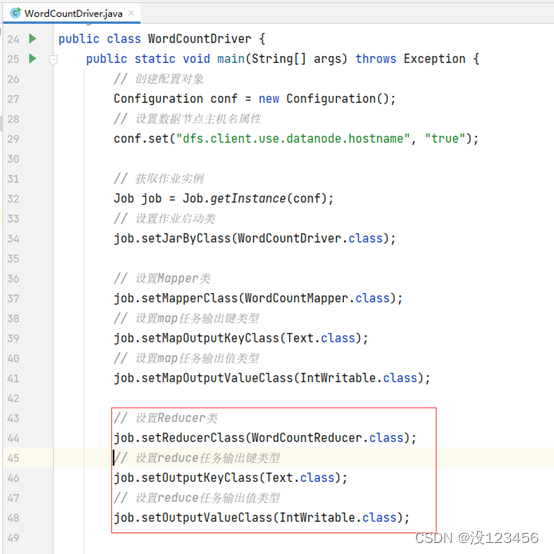

创建了词频统计归并器之后,我们一定要告知词频统计驱动器类

12、修改词频统计驱动器类

设置词频统计的Reducer类及其输出键类型和输出值类型(Text,Text)

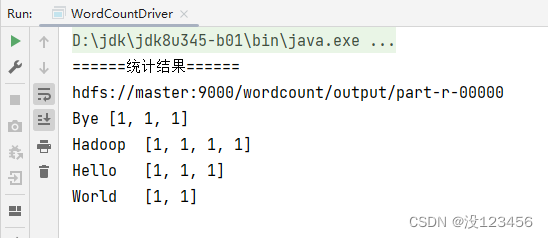

13、运行词频统计驱动器类,查看结果

运行WordCountDriver类,查看结果

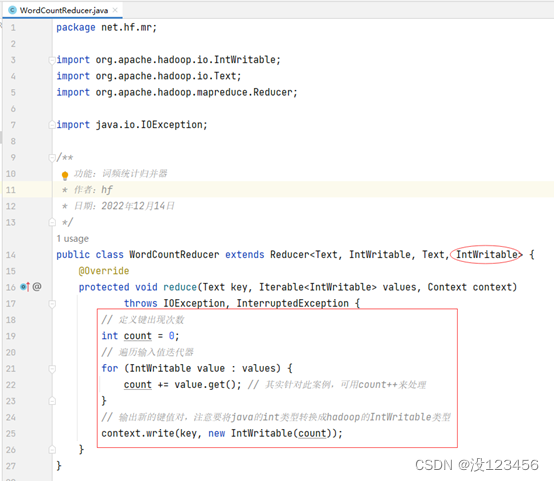

14、修改词频统计归并器类

输出键值类型改为IntWritable,遍历值迭代器,累加得到单词出现次数

package net.hf.mr;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

/**

* 功能:词频统计归并器

* 作者:hf

* 日期:2022年12月14日

*/

public class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

// 定义键出现次数

int count = 0;

// 遍历输入值迭代器

for (IntWritable value : values) {

count += value.get(); // 其实针对此案例,可用count++来处理

}

// 输出新的键值对,注意要将java的int类型转换成hadoop的IntWritable类型

context.write(key, new IntWritable(count));

}

}

由于修改了词频统计归并器的输出值类型(由Text类型改成了IntWritable类型),必须在词频统计驱动器类里进行设置

15、修改词频统计驱动器类

修改归并任务的输出值类型(IntWritable类型)

16、启动词频统计驱动器类,查看结果

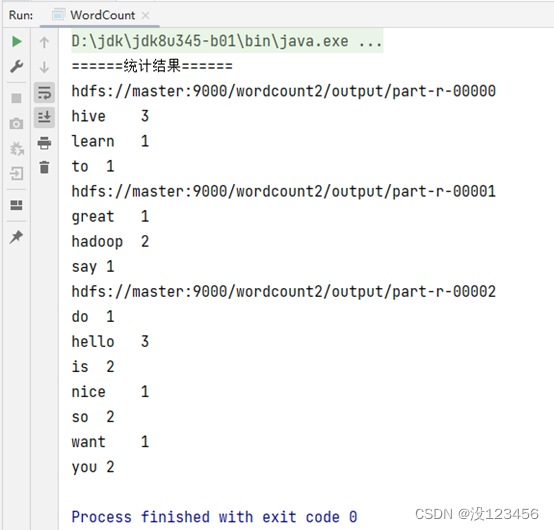

此时,可以看到每个单词出现的次数

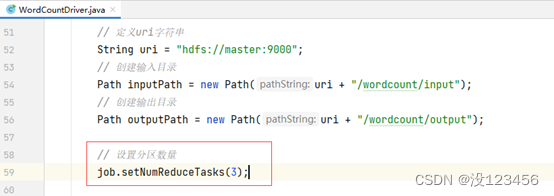

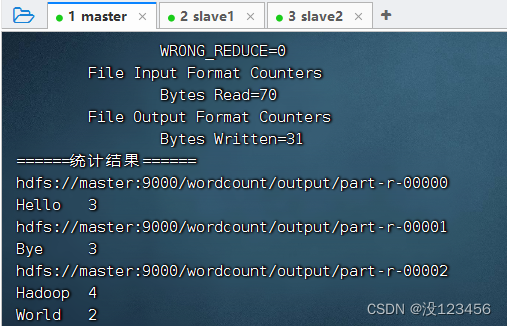

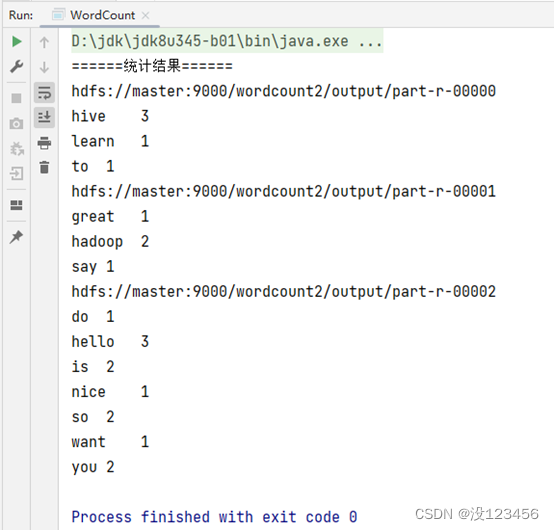

17、采用多个Reduce做合并

相同key的键值对必须发送同一分区

修改词频统计驱动器类,设置分区数量

设置分区数量:3

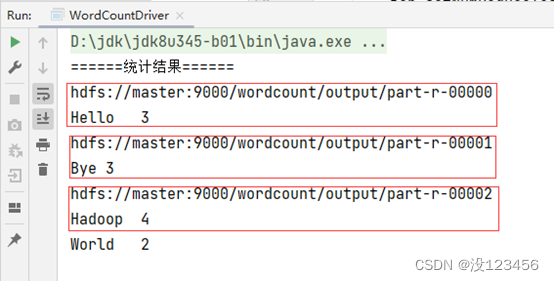

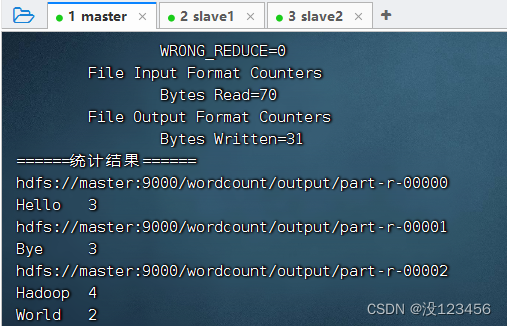

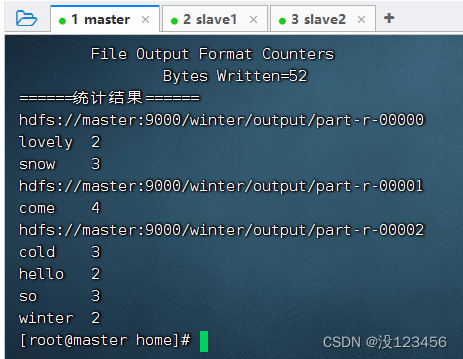

此时,运行程序,查看结果

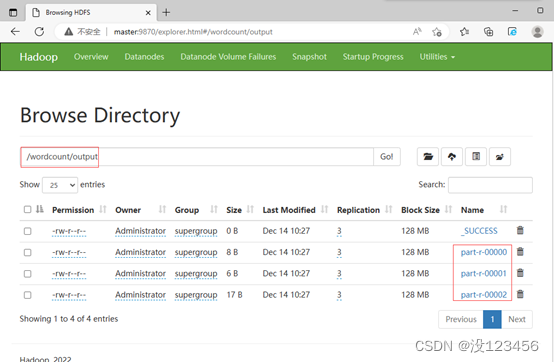

在Hadoop WebUI界面上可以看到,产生了三个结果文件

18、打包上传到虚拟机上运行

MR程序可以在IDEA里运行,也可以打成jar包,上传到虚拟机,利用hadoop jar命令来运行

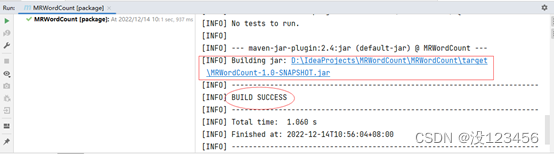

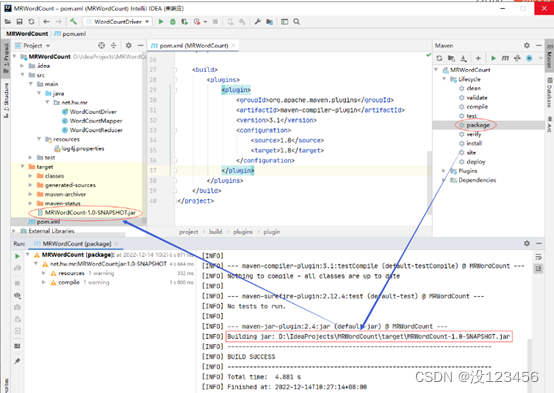

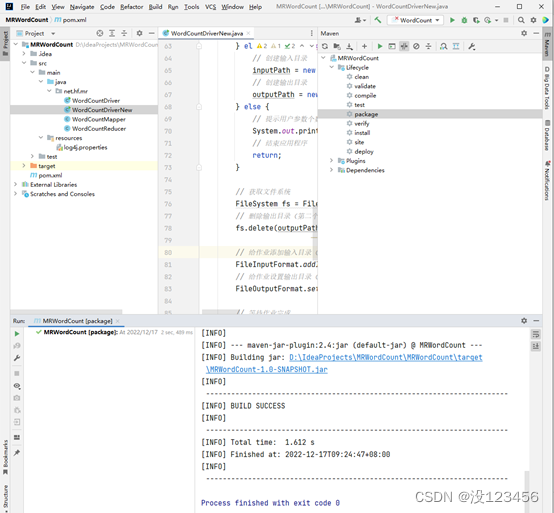

(1)利用Maven打包

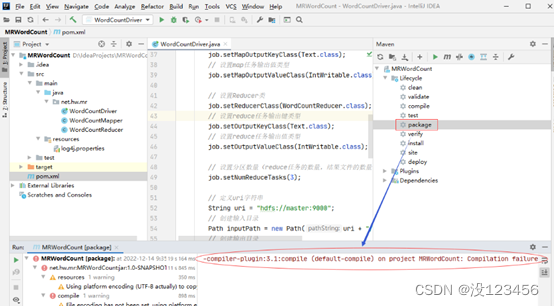

打开Maven管理窗口,找到项目的LifeCycle下的package命令

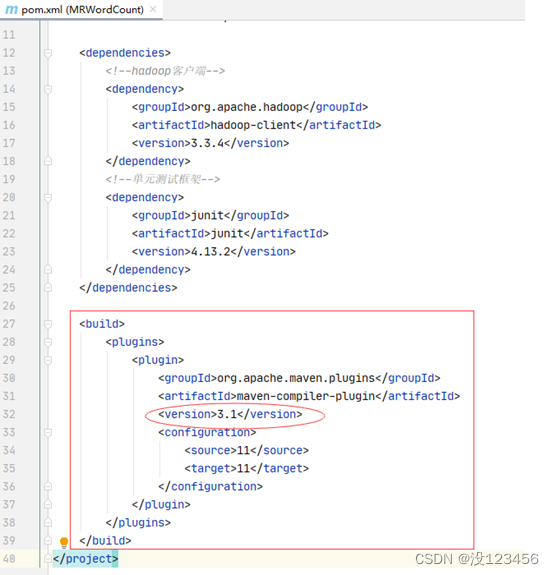

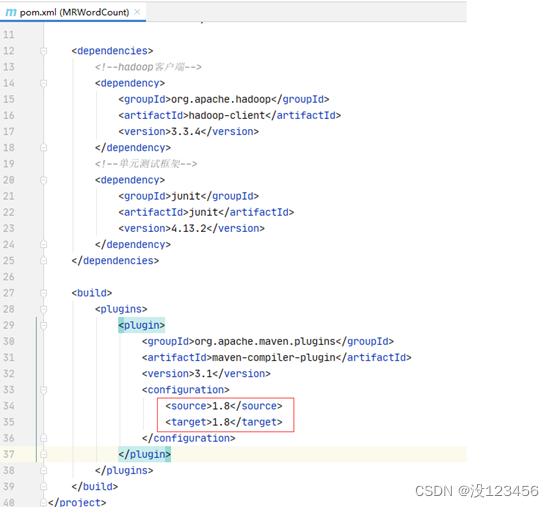

双击package命令,如果报错,maven插件版本不对

修改pom.xml文件,添加maven插件,记得要刷新maven

再次打包,即可生成MRWordCount-1.0-SNAPSHOT.jar

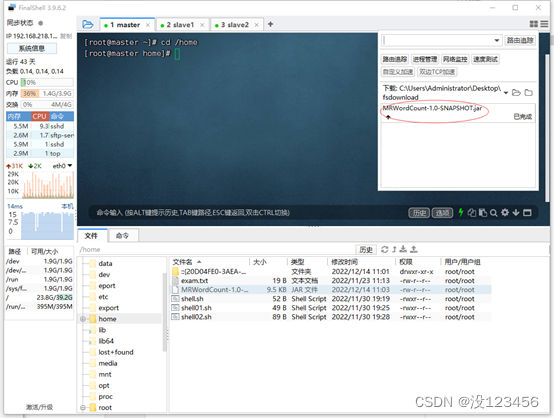

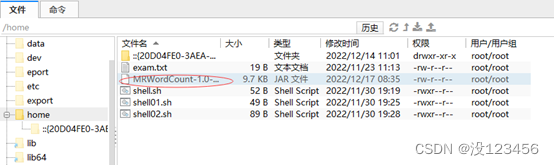

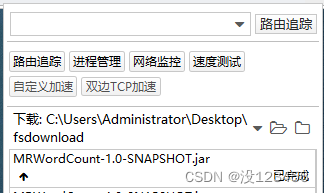

(2)将jar包上传到虚拟机

将MRWordCount-1.0-SNAPSHOT.jar上传到master虚拟机/home目录

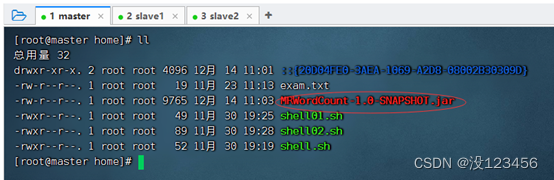

查看上传的jar包

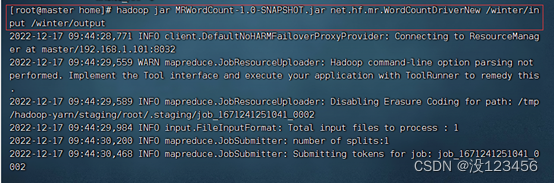

(3)运行jar包,查看结果

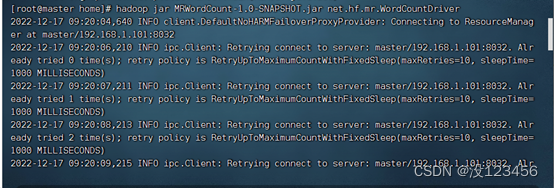

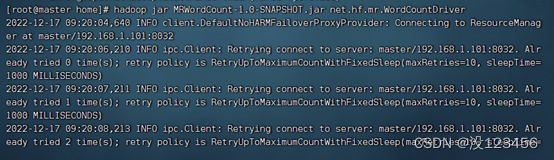

执行命令:hadoop jar MRWordCount-1.0-SNAPSHOT.jar net.hf.mr.WordCountDriver

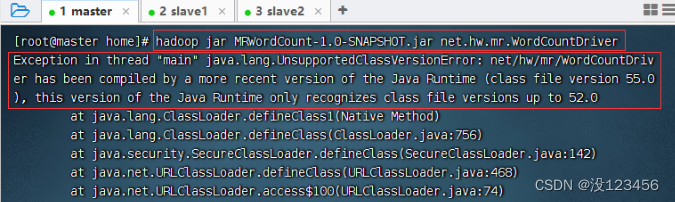

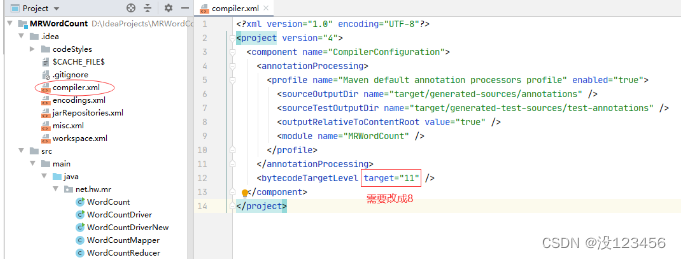

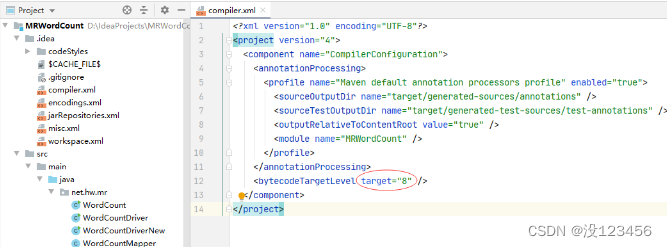

如果出现以下错误,是Java编译版本不一致导致错误

解决方法:降低项目JDK版本,重新打包

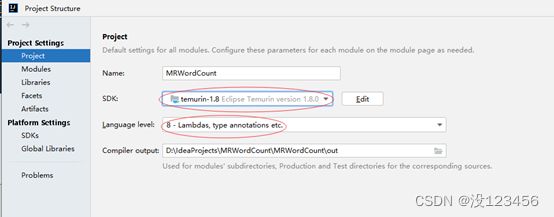

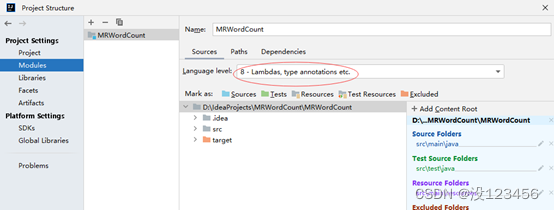

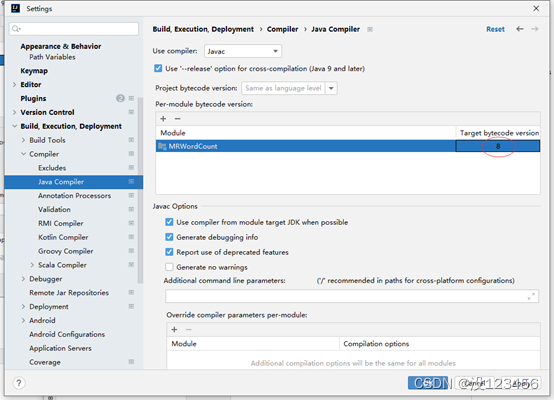

修改项目JDK

修改语言级别

修改Java编译器版本

修改pom.xml文件

重新利用maven打包

重新上传jar包到虚拟机

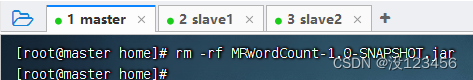

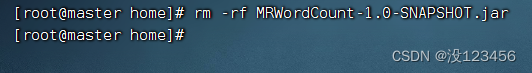

删除master虚拟机上的jar包

重新上传jar包

运行jar包,查看结果

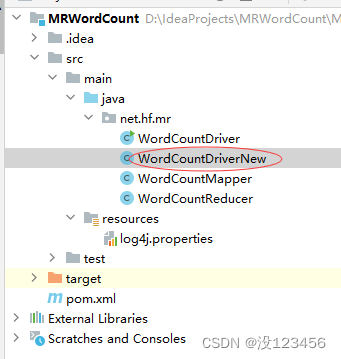

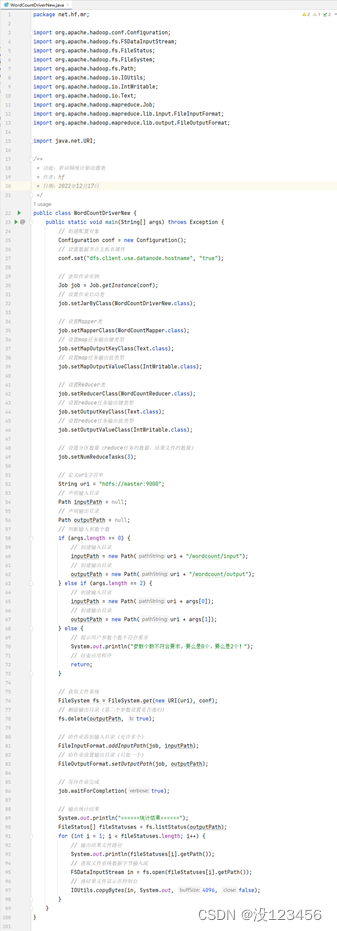

19、创建新词频统计驱动器类

由用户指定输入路径和输出路径,如果用户不指定,那么由程序来设置

在net.hf.mr包里创建WordCountDriverNew类

package net.hf.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.net.URI;

/**

* 功能:新词频统计驱动器类

* 作者:hf

* 日期:2022年12月17日

*/

public class WordCountDriverNew {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 获取作业实例

Job job = Job.getInstance(conf);

// 设置作业启动类

job.setJarByClass(WordCountDriverNew.class);

// 设置Mapper类

job.setMapperClass(WordCountMapper.class);

// 设置map任务输出键类型

job.setMapOutputKeyClass(Text.class);

// 设置map任务输出值类型

job.setMapOutputValueClass(IntWritable.class);

// 设置Reducer类

job.setReducerClass(WordCountReducer.class);

// 设置reduce任务输出键类型

job.setOutputKeyClass(Text.class);

// 设置reduce任务输出值类型

job.setOutputValueClass(IntWritable.class);

// 设置分区数量(reduce任务的数量,结果文件的数量)

job.setNumReduceTasks(3);

// 定义uri字符串

String uri = "hdfs://master:9000";

// 声明输入目录

Path inputPath = null;

// 声明输出目录

Path outputPath = null;

// 判断输入参数个数

if (args.length == 0) {

// 创建输入目录

inputPath = new Path(uri + "/wordcount/input");

// 创建输出目录

outputPath = new Path(uri + "/wordcount/output");

} else if (args.length == 2) {

// 创建输入目录

inputPath = new Path(uri + args[0]);

// 创建输出目录

outputPath = new Path(uri + args[1]);

} else {

// 提示用户参数个数不符合要求

System.out.println("参数个数不符合要求,要么是0个,要么是2个!");

// 结束应用程序

return;

}

// 获取文件系统

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 删除输出目录(第二个参数设置是否递归)

fs.delete(outputPath, true);

// 给作业添加输入目录(允许多个)

FileInputFormat.addInputPath(job, inputPath);

// 给作业设置输出目录(只能一个)

FileOutputFormat.setOutputPath(job, outputPath);

// 等待作业完成

job.waitForCompletion(true);

// 输出统计结果

System.out.println("======统计结果======");

FileStatus[] fileStatuses = fs.listStatus(outputPath);

for (int i = 1; i < fileStatuses.length; i++) {

// 输出结果文件路径

System.out.println(fileStatuses[i].getPath());

// 获取文件系统数据字节输入流

FSDataInputStream in = fs.open(fileStatuses[i].getPath());

// 将结果文件显示在控制台

IOUtils.copyBytes(in, System.out, 4096, false);

}

}

}

20、重新打包上传虚拟机并执行

重新打包

删除先前的jar包

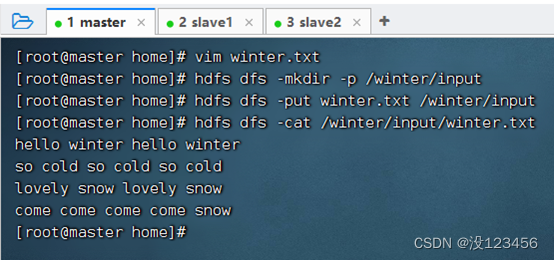

上传新的单词文件

上传新的jar包

执行命令:hadoop jar MRWordCount-1.0-SNAPSHOT.jar net.hf.mr.WordCountDriverNew,不指定输入路径和输出路径参数

执行命令:hadoop jar MRWordCount-1.0-SNAPSHOT.jar net.hf.mr.WordCountDriverNew /winter/input /winter/output,指定输入路径和输出路径参数

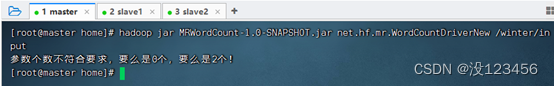

执行命令:hadoop jar MRWordCount-1.0-SNAPSHOT.jar net.hf.mr.WordCountDriverNew /winter/input,指定输入路径参数,不指定输出路径参数

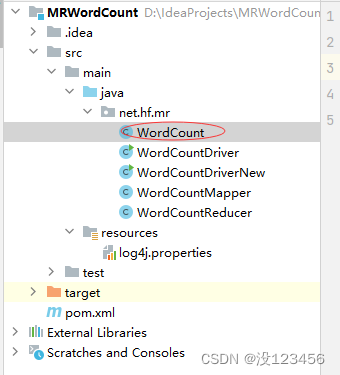

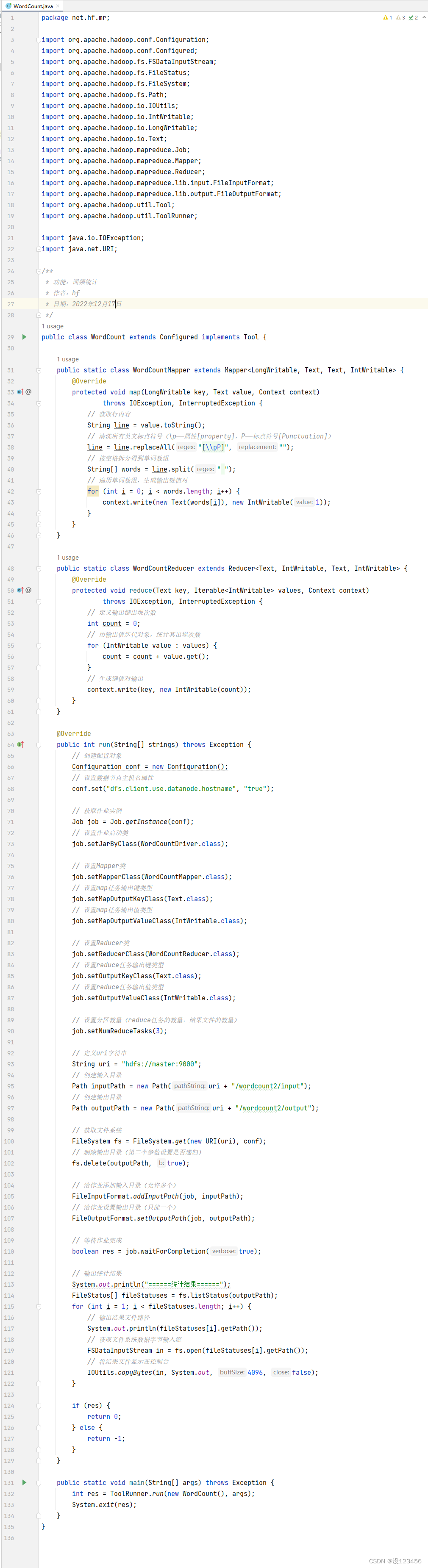

21、将三个类合并成一个类完成词频统计

在net.hf.mr包里创建WordCount类

package net.hf.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner;

import java.io.IOException;

import java.net.URI;

/**

* 功能:词频统计

* 作者:hf

* 日期:2022年12月17日

*/

public class WordCount extends Configured implements Tool {

public static class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

@Override

protected void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

// 获取行内容

String line = value.toString();

// 清洗所有英文标点符号(\p——属性[property],P——标点符号[Punctuation])

line = line.replaceAll("[\\pP]", "");

// 按空格拆分得到单词数组

String[] words = line.split(" ");

// 遍历单词数组,生成输出键值对

for (int i = 0; i < words.length; i++) {

context.write(new Text(words[i]), new IntWritable(1));

}

}

}

public static class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

// 定义输出键出现次数

int count = 0;

// 历输出值迭代对象,统计其出现次数

for (IntWritable value : values) {

count = count + value.get();

}

// 生成键值对输出

context.write(key, new IntWritable(count));

}

}

@Override

public int run(String[] strings) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 获取作业实例

Job job = Job.getInstance(conf);

// 设置作业启动类

job.setJarByClass(WordCountDriver.class);

// 设置Mapper类

job.setMapperClass(WordCountMapper.class);

// 设置map任务输出键类型

job.setMapOutputKeyClass(Text.class);

// 设置map任务输出值类型

job.setMapOutputValueClass(IntWritable.class);

// 设置Reducer类

job.setReducerClass(WordCountReducer.class);

// 设置reduce任务输出键类型

job.setOutputKeyClass(Text.class);

// 设置reduce任务输出值类型

job.setOutputValueClass(IntWritable.class);

// 设置分区数量(reduce任务的数量,结果文件的数量)

job.setNumReduceTasks(3);

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建输入目录

Path inputPath = new Path(uri + "/wordcount2/input");

// 创建输出目录

Path outputPath = new Path(uri + "/wordcount2/output");

// 获取文件系统

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 删除输出目录(第二个参数设置是否递归)

fs.delete(outputPath, true);

// 给作业添加输入目录(允许多个)

FileInputFormat.addInputPath(job, inputPath);

// 给作业设置输出目录(只能一个)

FileOutputFormat.setOutputPath(job, outputPath);

// 等待作业完成

boolean res = job.waitForCompletion(true);

// 输出统计结果

System.out.println("======统计结果======");

FileStatus[] fileStatuses = fs.listStatus(outputPath);

for (int i = 1; i < fileStatuses.length; i++) {

// 输出结果文件路径

System.out.println(fileStatuses[i].getPath());

// 获取文件系统数据字节输入流

FSDataInputStream in = fs.open(fileStatuses[i].getPath());

// 将结果文件显示在控制台

IOUtils.copyBytes(in, System.out, 4096, false);

}

if (res) {

return 0;

} else {

return -1;

}

}

public static void main(String[] args) throws Exception {

int res = ToolRunner.run(new WordCount(), args);

System.exit(res);

}

}

上传一个有标点符号的单词文件

运行程序,查看结果

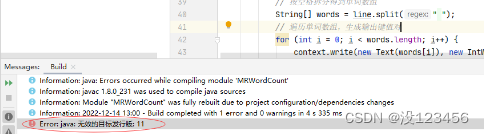

如果出现以下错误

先前为了打包上传能在虚拟机上运行jar包,将JDK版本降低到8,因此还得修改编译器配置文件

再次运行程序,查看结果

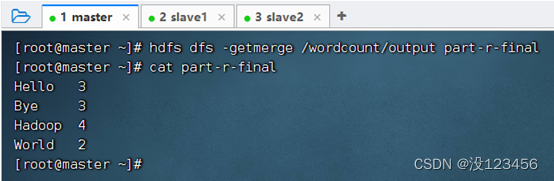

22、合并分区导致的多个结果文件

利用hadoop的-getmerge命令来完成:hdfs dfs -getmerge /wordcount/outoput part-r-final

23、统计不同单词数

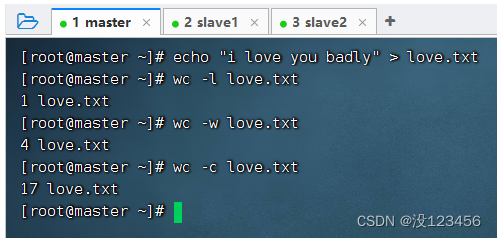

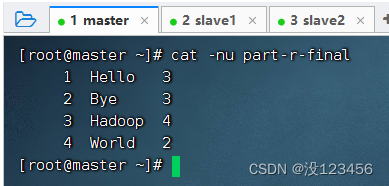

利用cat -nu命令,带行号显示文件内容

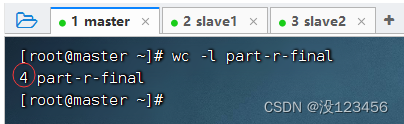

利用wc -l命令,统计文件行数,即不同单词数

wc命令还有其它参数