系列文章目录

提示:这里可以添加系列文章的所有文章的目录,目录需要自己手动添加

例如:第一章 Python 机器学习入门之pandas的使用

提示:写完文章后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 系列文章目录

- 前言

- 一、创建hadoop用户

- 二、安装SSH、配置SSH无密码登陆

- 三、安装JDK

- 二、Hadoop2.7.6下载、安装及配置

- 1. 下载

- 2. 安装过程如下

- 3. Hadoop伪分布式配置

- 总结

- 参考

前言

提示:这里可以添加本文要记录的大概内容:

例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。

提示:本篇文章参考:Hadoop3.1.3安装教程_单机/伪分布式配置_Hadoop3.1.3/Ubuntu18.04(16.04)

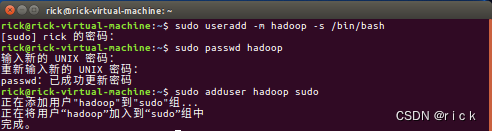

一、创建hadoop用户

如果你安装 Ubuntu 的时候不是用的 “hadoop” 用户,那么需要增加一个名为 hadoop 的用户。

首先按 ctrl+alt+t 打开终端窗口,输入如下命令创建新用户 :

sudo useradd -m hadoop -s /bin/bash

接着使用如下命令设置密码,可简单设置为 hadoop,按提示输入两次密码:

sudo passwd hadoop

可为 hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题:

sudo adduser hadoop sudo

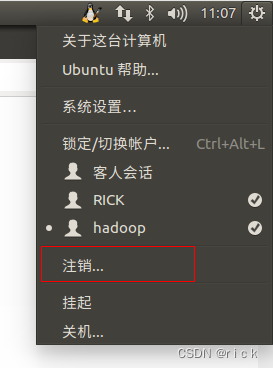

最后注销当前用户(点击屏幕右上角的齿轮,选择注销),返回登陆界面。在登陆界面中选择刚创建的 hadoop 用户进行登陆。

更新apt

sudo apt-get update

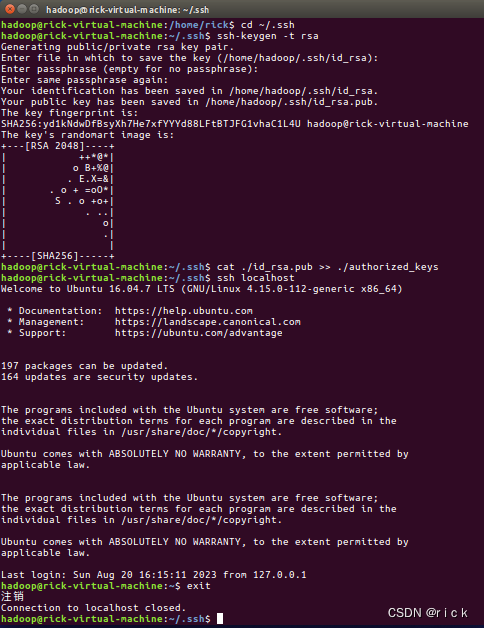

二、安装SSH、配置SSH无密码登陆

集群、单节点模式都需要用到 SSH 登陆(类似于远程登陆,你可以登录某台 Linux 主机,并且在上面运行命令),Ubuntu 默认已安装了 SSH client,此外还需要安装 SSH server:

sudo apt-get install openssh-server

安装后,可以使用如下命令登陆本机:

ssh localhost

此时会有如下提示(SSH首次登陆提示),输入 yes 。然后按提示输入密码 hadoop,这样就登陆到本机了。

但这样登陆是需要每次输入密码的,我们需要配置成SSH无密码登陆比较方便。

首先退出刚才的 ssh,就回到了我们原先的终端窗口,然后利用 ssh-keygen 生成密钥,并将密钥加入到授权中:

exit # 退出刚才的 ssh localhost

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa # 会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权

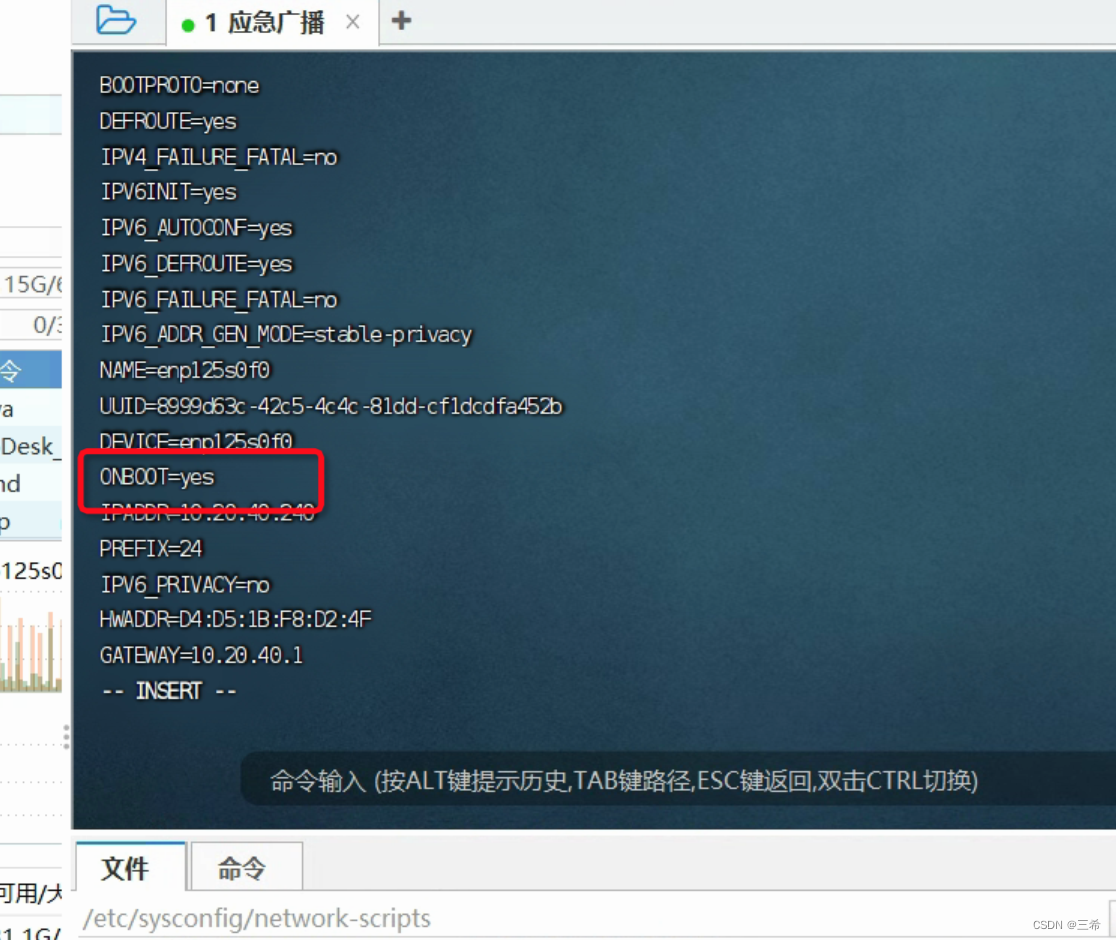

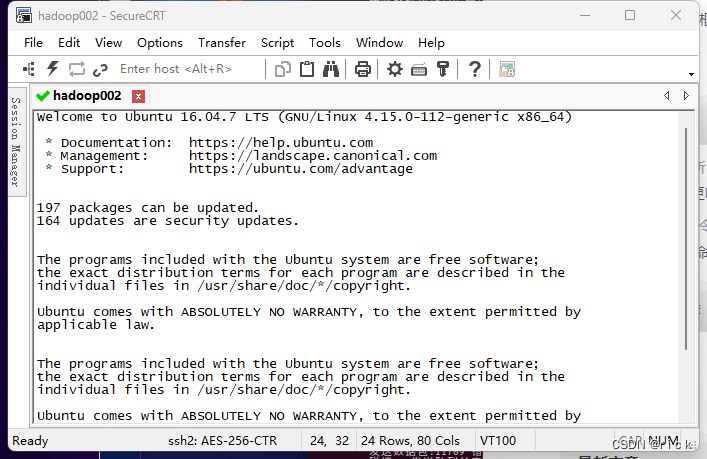

CRT连接虚拟机Ubuntu

三、安装JDK

-

在安装oracle的jdk之前,我们需要先将Linux自带的openjdk卸载掉,因为自带的jdk不太好用,此处可也参考文章在ubuntu16.04上卸载openjdk8,安装oracle的jdk8卸载

-

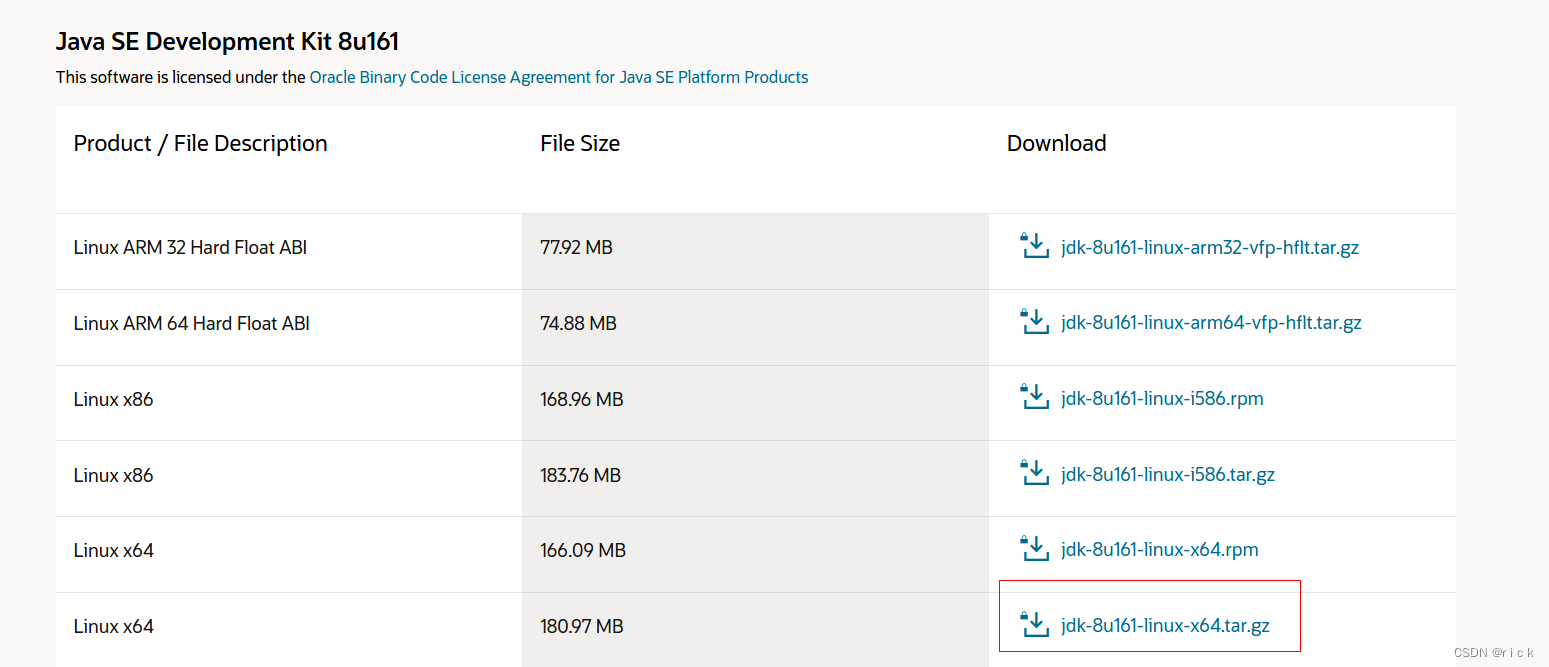

下载jdk-8u161-linux-x64压缩包

- 官方下载链接:https://www.oracle.com/rs/java/technologies/javase/javase8-archive-downloads.html

但需要去oracle官网注册一个帐号才能下载。

- 提供百度网盘下载。

- 官方下载链接:https://www.oracle.com/rs/java/technologies/javase/javase8-archive-downloads.html

-

在Ubuntu下打开终端输入一下命令

cd /usr/lib

sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

cd ~ #进入hadoop用户的主目录

cd Downloads #注意区分大小写字母,刚才已经通过FTP软件把JDK安装包jdk-8u162-linux-x64.tar.gz上传到该目录下

sudo tar -zxvf ./jdk-8u161-linux-x64.tar.gz -C /usr/lib/jvm #把JDK文件解压到/usr/lib/jvm目录下

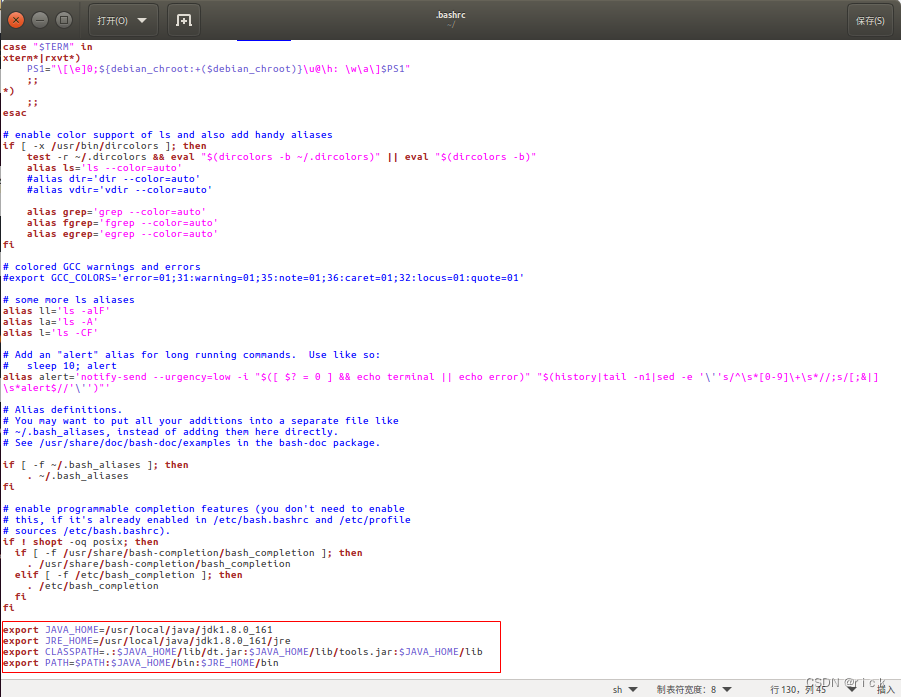

- 设置环境变量

sudo gedit ~/.bashrc

在这个文件的末尾添加如下几行内容:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_161

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

保存.bashrc文件并退出gedit编辑器。然后,继续执行如下命令让.bashrc文件的配置立即生效:

保存.bashrc文件并退出gedit编辑器。然后,继续执行如下命令让.bashrc文件的配置立即生效:

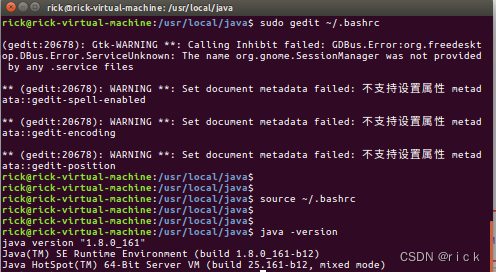

sudo source ~/.bashrc //使得环境变量文件生效

- 查看是否安装成功

java -version

出现java版本,说明JDK配置成功。接下来安装Hadoop

二、Hadoop2.7.6下载、安装及配置

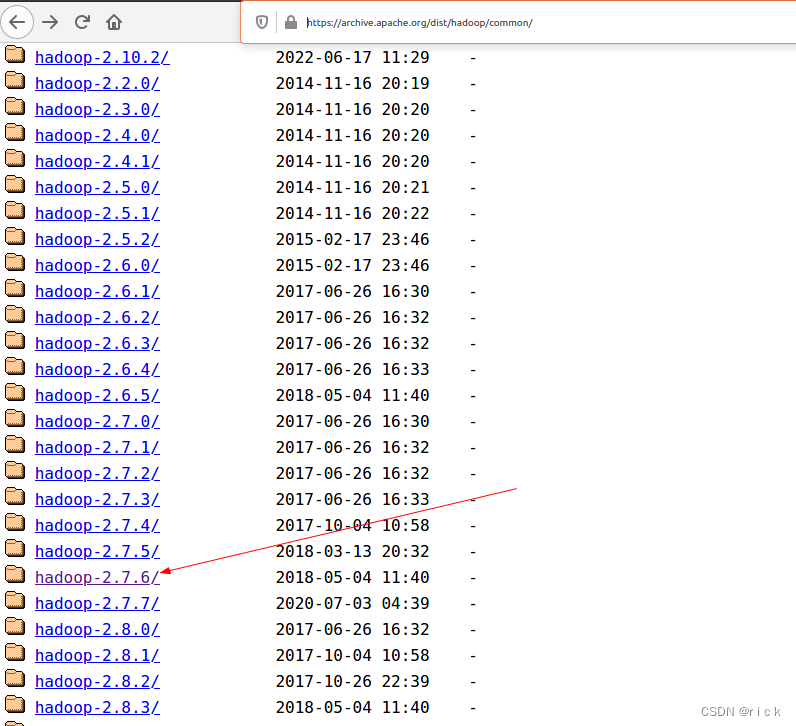

1. 下载

官网下载

官网下载速度太慢,可以从百度网盘下载

2. 安装过程如下

找到hadoop-2.7.6.tar包的位置,解压到/usr/local位置下

sudo tar -zxf ~/下载/hadoop-3.1.3.tar.gz -C /usr/local # 解压到/usr/local中

cd /usr/local/

sudo mv ./hadoop-3.1.3/ ./hadoop # 将文件夹名改为hadoop

sudo chown -R hadoop ./hadoop # 修改文件权限

解压之后进入配置文件

vim ~/.bashrc

在配置文件中输入

export HADOOP_HOME=/usr/local/hadoop-2.7.6

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:

退出后使配置文件生效

source ~/.bashrc

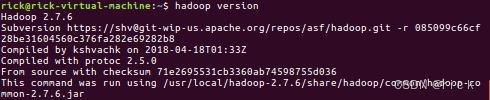

查看hadoop是否成功

hadoop version

3. Hadoop伪分布式配置

可以参考:ubuntu16.04Hadoop伪分布模式环境搭建

修改配置文件 core-site.xml (通过 gedit 编辑会比较方便: gedit ./etc/hadoop/core-site.xml),将当中的

<configuration>

</configuration>

修改为:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

同样的,修改配置文件 hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

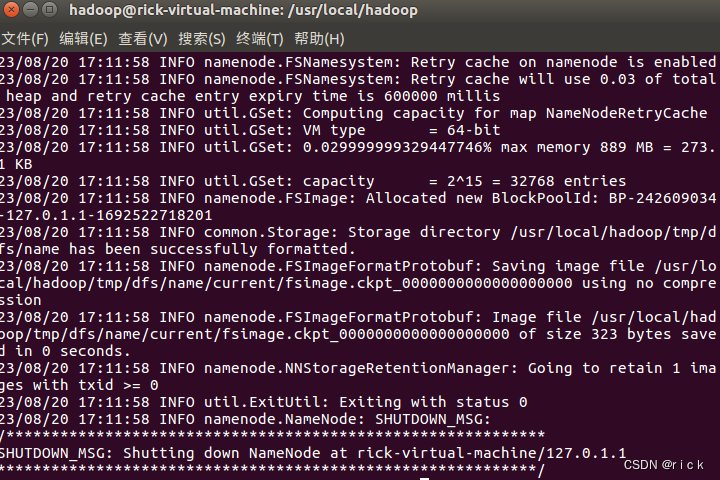

配置完成后,执行 NameNode 的格式化:

cd /usr/local/hadoop

./bin/hdfs namenode -format

成功的话,会看到 “successfully formatted” 的提示,具体返回信息类似如下

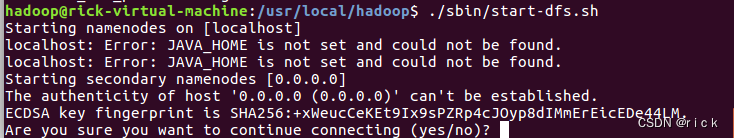

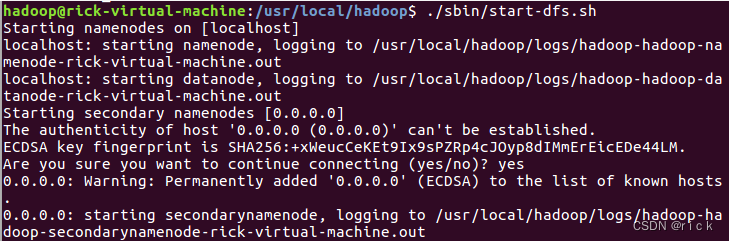

接着开启 NameNode 和 DataNode 守护进程

cd /usr/local/hadoop

./sbin/start-dfs.sh #start-dfs.sh是个完整的可执行文件,中间没有空格

若出现如下SSH提示,输入yes即可。

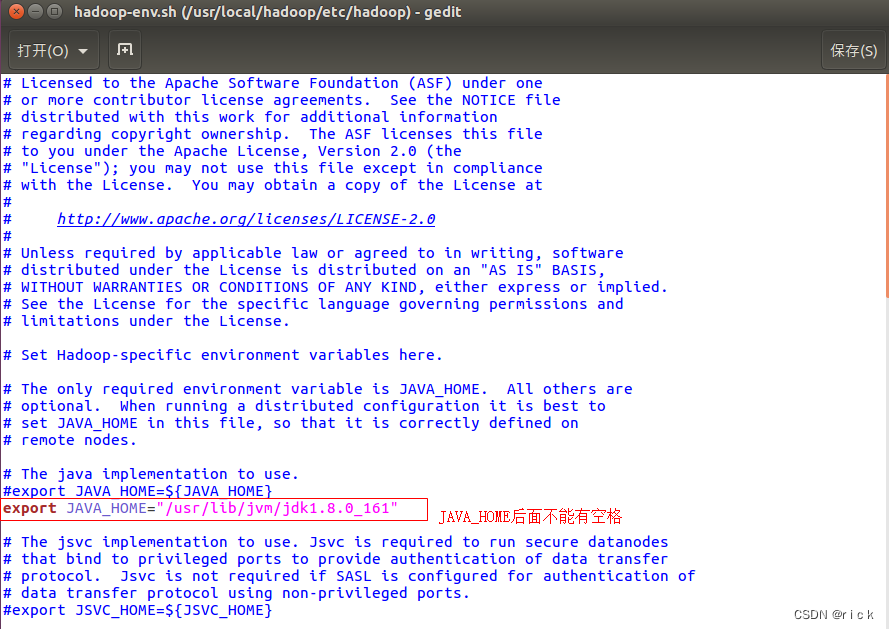

如果在这一步时提示 Error: JAVA_HOME is not set and could not be found. 的错误,则说明之前设置 JAVA_HOME 环境变量那边就没设置好,到hadoop的安装目录修改配置文件

gedit /usr/local/hadoop/etc/hadoop/hadoop-env.sh

在里面找到“export JAVA_HOME=${JAVA_HOME}”这行,然后,把它修改成JAVA安装路径的具体地址,比如,

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_161

然后,再次启动Hadoop。

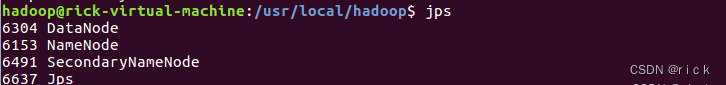

启动完成后,可以通过命令 jps 来判断是否成功启动

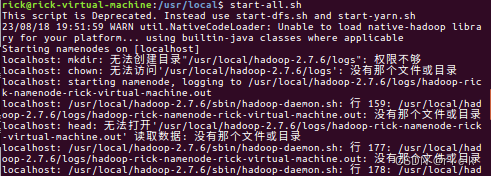

如果出以下错误

Starting namenodes on [localhost]

localhost: mkdir: 无法创建目录"/usr/local/hadoop-2.7.6/logs": 权限不够

localhost: chown: 无法访问’/usr/local/hadoop-2.7.6/logs’: 没有那个文件或目录

localhost: starting namenode, logging to /usr/local/hadoop-2.7.6/logs/hadoop-rick-namenode-rick-virtual-machine.out

这是因为hadoop-2.7.6这个文件没有权限,需要执行下面的命令

sudo chmod 777 /usr/local/hadoop-2.7.6

总结

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。

参考

- Ubuntu安装JDK教程

- 在ubuntu16.04上卸载openjdk8,安装oracle的jdk8

- Hadoop3.1.3安装教程_单机/伪分布式配置_Hadoop3.1.3/Ubuntu18.04(16.04)

- ubuntu16.04Hadoop伪分布模式环境搭建

- UBuntu linux 安装hadoop 中到一些问题

- Ubuntu下配置Hadoop2.7.6