文章目录

- HPA

- 部署 metrics-server

- 部署HPA

- Rancher

- 部署Rancher

- rancher添加集群

- 仪表盘创建 namespace

- 仪表盘创建 Deployments

- 仪表盘创建 service

- 总结

HPA

- HPA(Horizontal Pod Autoscaling)Pod 水平自动伸缩,Kubernetes 有一个 HPA 的资源,HPA 可以根据 CPU 利用率自动伸缩一个 Replication Controller、 Deployment 或者Replica Set 中的 Pod 数量。

- HPA 基于 Master 上的 kube-controller-manager 服务启动参数 horizontal-pod-autoscaler-sync-period 定义的时长(默认为30秒),周期性的检测 Pod 的 CPU 使用率。

- HPA 与之前的 RC、Deployment 一样,也属于一种 Kubernetes 资源对象。通过追踪分析 RC 控制的所有目标 Pod 的负载变化情况, 来确定是否需要针对性地调整目标Pod的副本数,这是HPA的实现原理。

- metrics-server 也需要部署到集群中, 它可以通过 resource metrics API 对外提供度量数据。

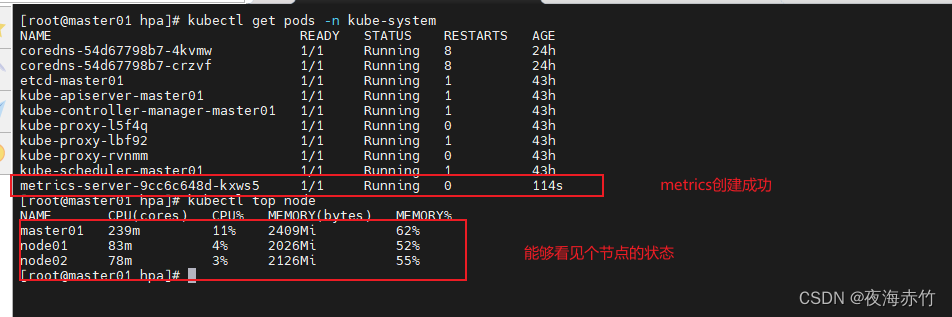

部署 metrics-server

##上传 文件到 所有的node节点

components.yaml

cd /opt/

mkdir hpa

cd /opt/hpa/

apiVersion: v1

kind: ServiceAccount

metadata:

labels:

k8s-app: metrics-server

name: metrics-server

namespace: kube-system

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

labels:

k8s-app: metrics-server

rbac.authorization.k8s.io/aggregate-to-admin: "true"

rbac.authorization.k8s.io/aggregate-to-edit: "true"

rbac.authorization.k8s.io/aggregate-to-view: "true"

name: system:aggregated-metrics-reader

rules:

- apiGroups:

- metrics.k8s.io

resources:

- pods

- nodes

verbs:

- get

- list

- watch

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

labels:

k8s-app: metrics-server

name: system:metrics-server

rules:

- apiGroups:

- ""

resources:

- pods

- nodes

- nodes/stats

- namespaces

- configmaps

verbs:

- get

- list

- watch

---

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

labels:

k8s-app: metrics-server

name: metrics-server-auth-reader

namespace: kube-system

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: extension-apiserver-authentication-reader

subjects:

- kind: ServiceAccount

name: metrics-server

namespace: kube-system

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

labels:

k8s-app: metrics-server

name: metrics-server:system:auth-delegator

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:auth-delegator

subjects:

- kind: ServiceAccount

name: metrics-server

namespace: kube-system

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

labels:

k8s-app: metrics-server

name: system:metrics-server

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:metrics-server

subjects:

- kind: ServiceAccount

name: metrics-server

namespace: kube-system

---

apiVersion: v1

kind: Service

metadata:

labels:

k8s-app: metrics-server

name: metrics-server

namespace: kube-system

spec:

ports:

- name: https

port: 443

protocol: TCP

targetPort: https

selector:

k8s-app: metrics-server

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

k8s-app: metrics-server

name: metrics-server

namespace: kube-system

spec:

selector:

matchLabels:

k8s-app: metrics-server

strategy:

rollingUpdate:

maxUnavailable: 0

template:

metadata:

labels:

k8s-app: metrics-server

spec:

hostNetwork: true

containers:

- args:

- --cert-dir=/tmp

- --secure-port=4443

- --kubelet-preferred-address-types=InternalIP

- --kubelet-use-node-status-port

- --kubelet-insecure-tls

image: registry.cn-beijing.aliyuncs.com/dotbalo/metrics-server:v0.4.1

imagePullPolicy: IfNotPresent

livenessProbe:

failureThreshold: 3

httpGet:

path: /livez

port: https

scheme: HTTPS

periodSeconds: 10

name: metrics-server

ports:

- containerPort: 4443

name: https

protocol: TCP

readinessProbe:

failureThreshold: 3

httpGet:

path: /readyz

port: https

scheme: HTTPS

periodSeconds: 10

securityContext:

readOnlyRootFilesystem: true

runAsNonRoot: true

runAsUser: 1000

volumeMounts:

- mountPath: /tmp

name: tmp-dir

nodeSelector:

kubernetes.io/os: linux

priorityClassName: system-cluster-critical

serviceAccountName: metrics-server

volumes:

- emptyDir: {}

name: tmp-dir

---

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

labels:

k8s-app: metrics-server

name: v1beta1.metrics.k8s.io

spec:

group: metrics.k8s.io

groupPriorityMinimum: 100

insecureSkipTLSVerify: true

service:

name: metrics-server

namespace: kube-system

version: v1beta1

versionPriority: 100

##运行文件

kubectl apply -f components.yaml

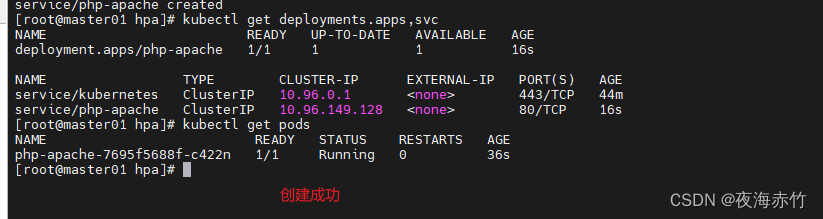

部署HPA

##所有的node节点拉取镜像 hpa-example

##hpa-example 是谷歌基于 PHP 语言开发的用于测试 HPA 的镜像,其中包含了一些可以运行 CPU 密集计算任务的代码

docker pull mirrorgooglecontainers/hpa-example

##创建用于测试的pod

vim hpa-pod.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

run: php-apache

name: php-apache

spec:

replicas: 1

selector:

matchLabels:

run: php-apache

template:

metadata:

labels:

run: php-apache

spec:

containers:

- image: mirrorgooglecontainers/hpa-example

name: php-apache

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

resources:

requests:

cpu: 200m

---

apiVersion: v1

kind: Service

metadata:

name: php-apache

spec:

ports:

- port: 80

protocol: TCP

targetPort: 80

selector:

run: php-apache

kubectl apply -f hpa-pod.yaml

##创建hpa

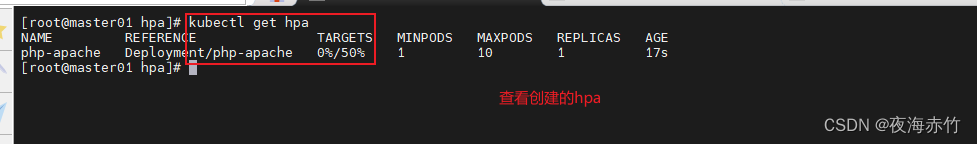

kubectl autoscale deployment php-apache --min=1 --max=10 --cpu-percent=50

apiVersion: autoscaling/v1

kind: HorizontalPodAutoscaler

metadata:

creationTimestamp: null

name: php-apache

spec:

maxReplicas: 10

minReplicas: 1

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: php-apache

targetCPUUtilizationPercentage: 50

status:

currentReplicas: 0

desiredReplicas: 0

##创建运行的pod

kubectl run test01 --image=busybox -o yaml --dry-run=client > test.yaml

kubectl run -it load-generator --image=busybox /bin/sh

apiVersion: v1

kind: Pod

metadata:

labels:

run: test01

name: test01

spec:

containers:

- image: busybox

name: test01

command: ["/bin/sh", "-c", "sleep 3600"]

resources: {}

dnsPolicy: ClusterFirst

restartPolicy: Always

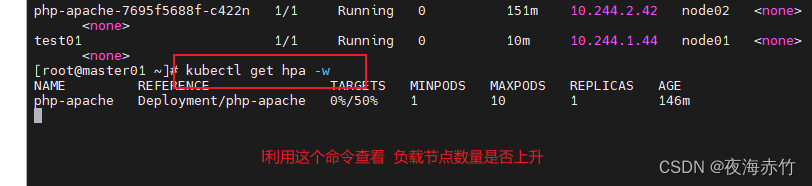

##进入到容器中,做循环,模拟容器运行

kubectl exec -it test01 sh

while true

do

wget -q -O- 10.96.149.128

done

- HPA 扩容的时候,负载节点数量上升速度会比较快;但回收的时候,负载节点数量下降速度会比较慢。

- 原因是防止在业务高峰期时因为网络波动等原因的场景下,如果回收策略比较积极的话,K8S集群可能会认为访问流量变小而快速收缩负载节点数量,而仅剩的负载节点又承受不了高负载的压力导致崩溃,从而影响业务

Rancher

- Rancher 是一个开源的企业级多集群 Kubernetes 管理平台,实现了 Kubernetes 集群在混合云+本地数据中心的集中部署与管理, 以确保集群的安全性,加速企业数字化转型

- Rancher 和 k8s 的区别

- Rancher 和 k8s 都是用来作为容器的调度与编排系统。

- 但是 rancher 不仅能够管理应用容器,更重要的一点是能够管理 k8s 集群。 Rancher2.x 底层基于 k8s 调度引擎,通过 Rancher 的封装,用户可以在不熟悉 k8s 概念的情况下轻松的通过 Rancher 来部署容器到k8s集群当中。

- 官网:https://docs.rancher.cn/

部署Rancher

##在所有的 node节点下载 rancher-agent 镜像

docker pull rancher/rancher-agent:v2.5.7

##在rancher 节点下载 rancher 镜像

docker pull rancher/rancher:v2.5.7

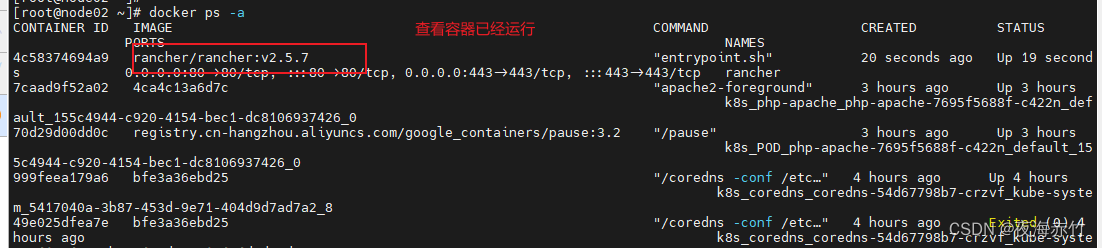

##运行 在rancher 节点

docker run -d --restart=unless-stopped -p 80:80 -p 443:443 --privileged --name rancher rancher/rancher:v2.5.7

##在浏览器访问服务器器的80端口

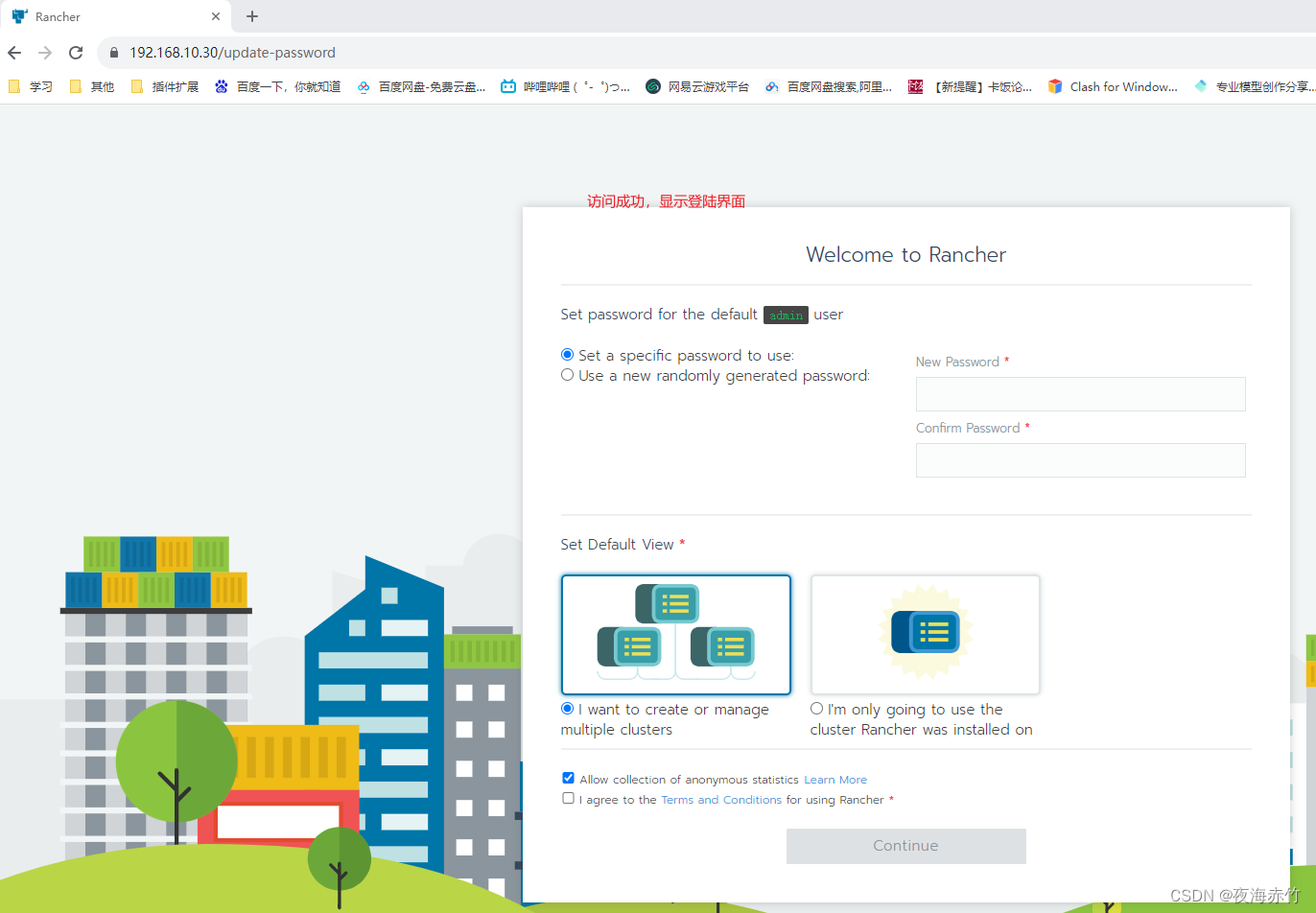

http://192.168.10.30

设置密码后,进入主页

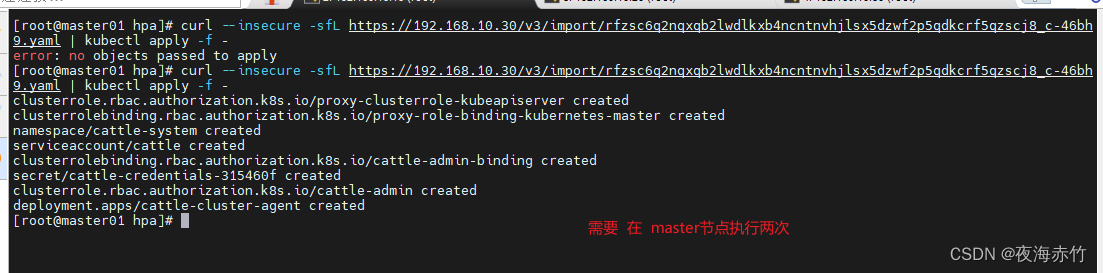

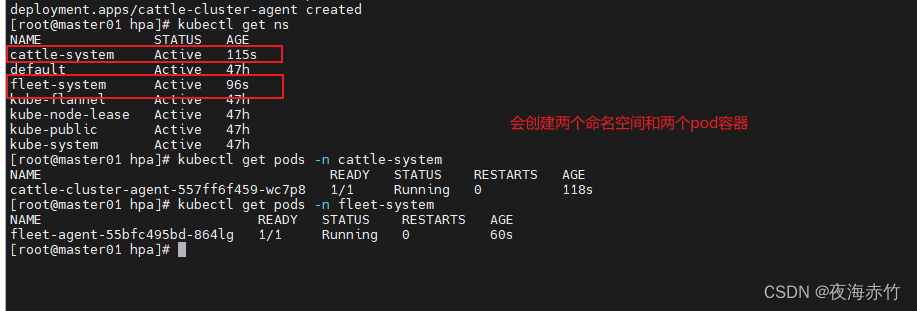

rancher添加集群

--》添加集群

--》导入

--》自定义集群名称

--》创建

--》根据提示在master节点执行

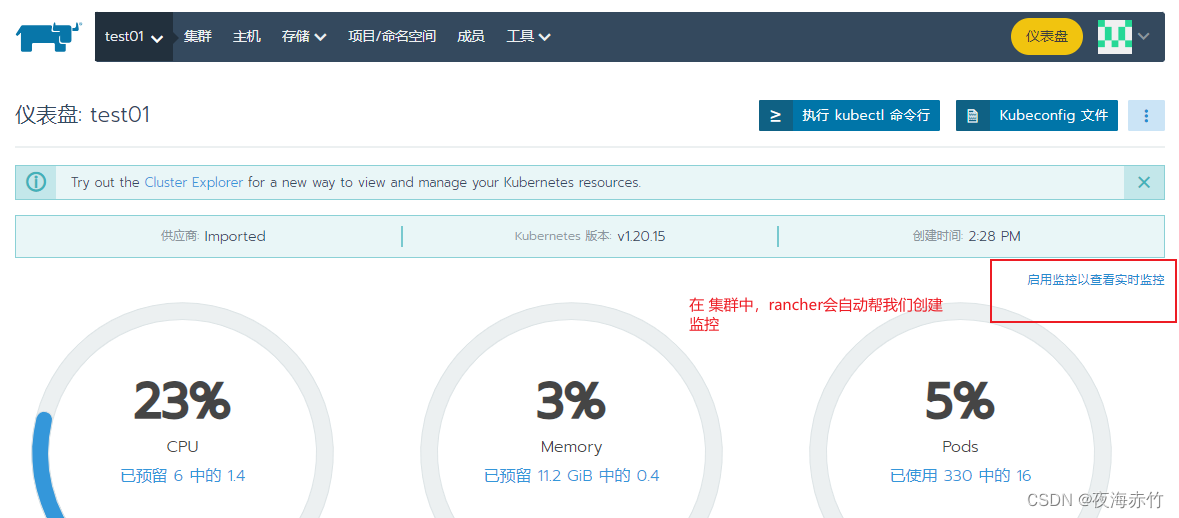

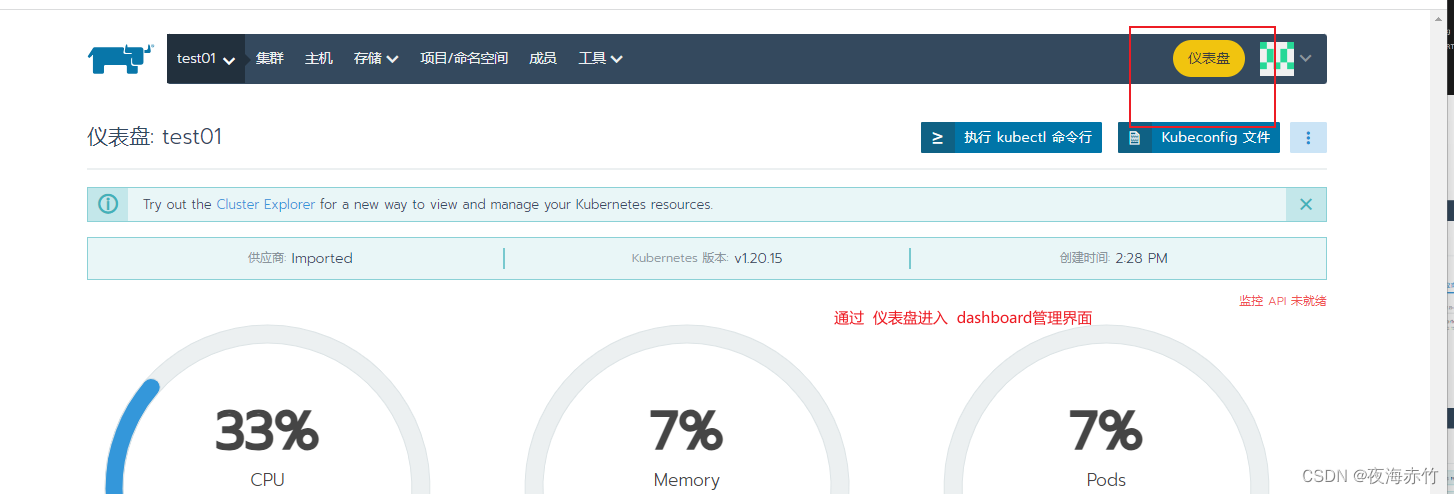

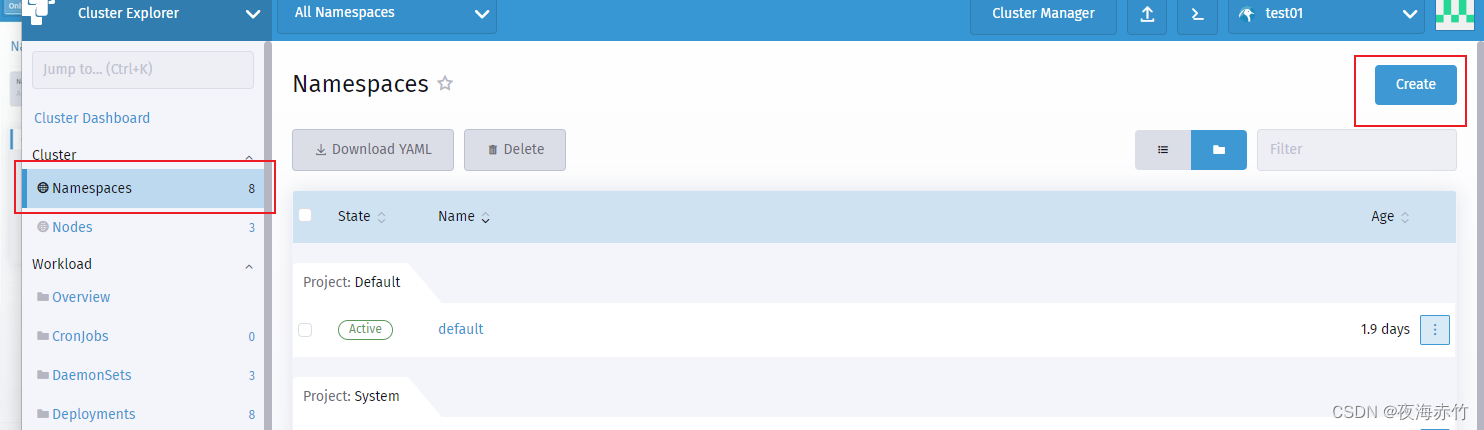

仪表盘创建 namespace

--》左侧Namespaces

--》右上角create

--》输入名称,create

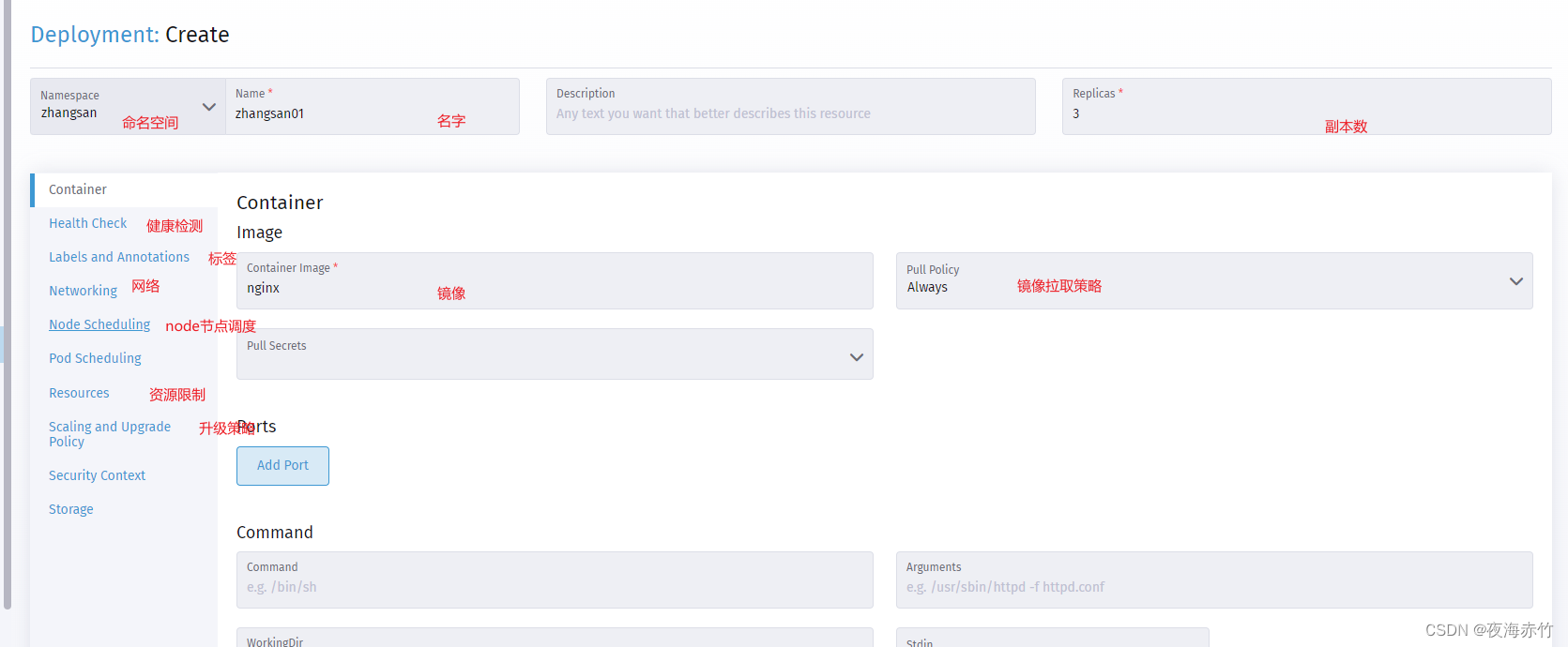

仪表盘创建 Deployments

--》左侧Deployments

--》右上角create

--》输入名称

——》根据需要选择不同的项目

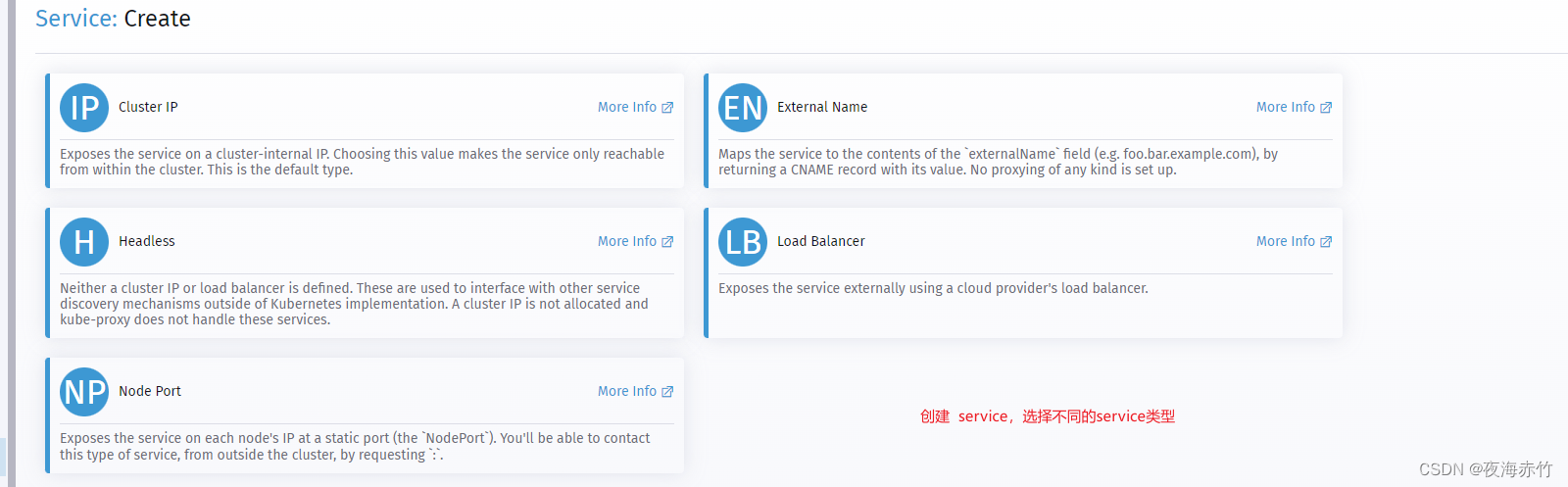

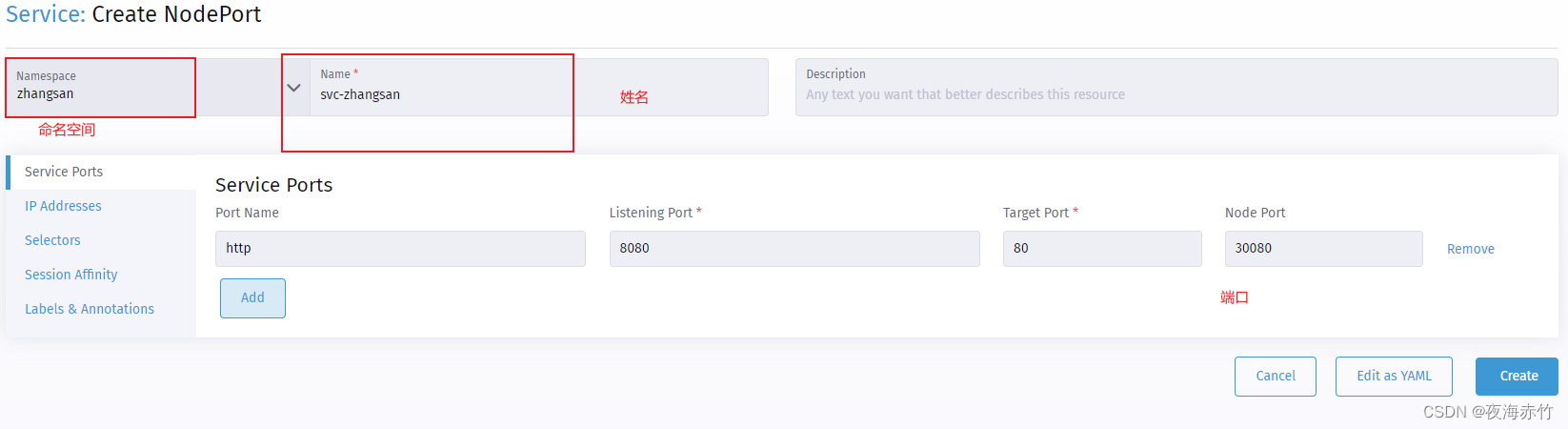

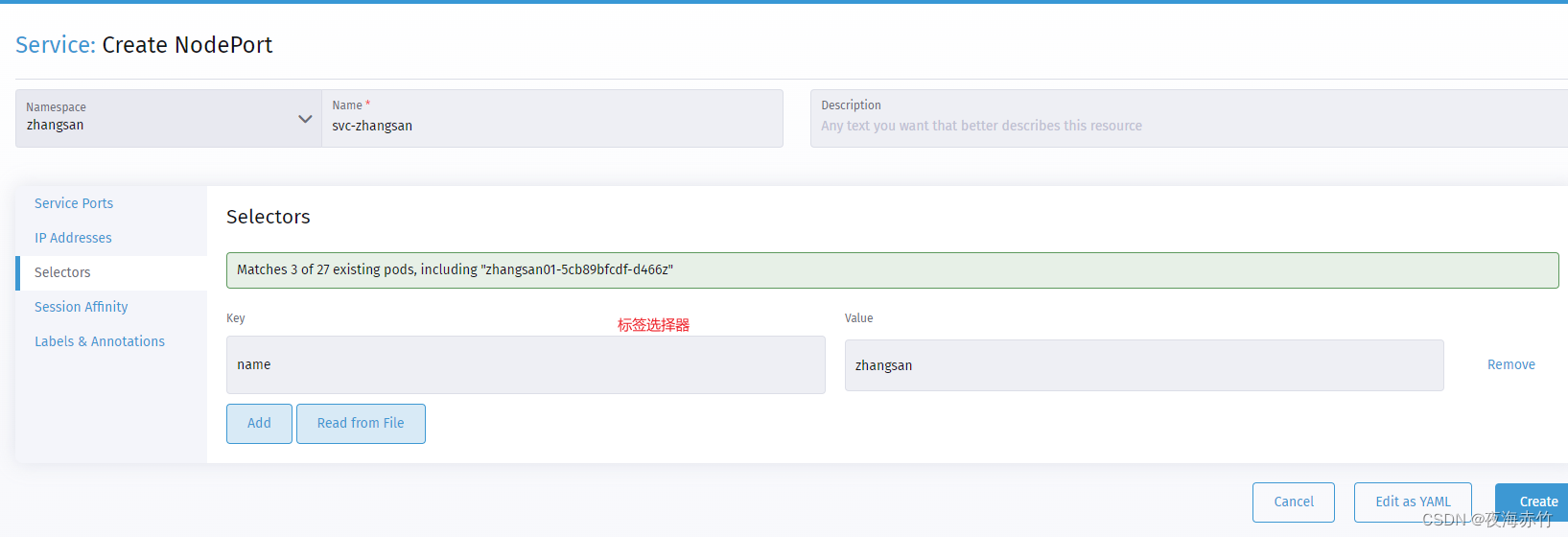

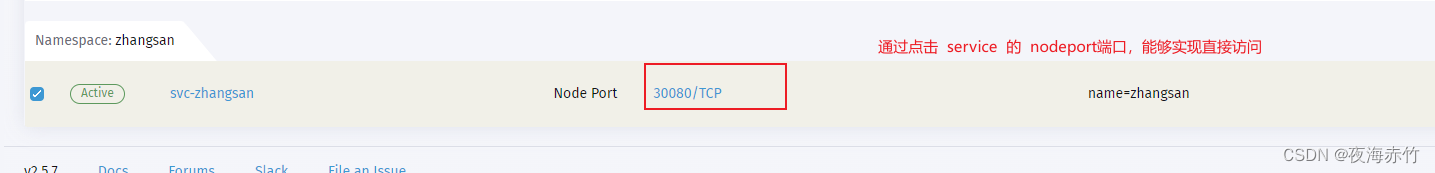

仪表盘创建 service

--》左侧Deployments

--》右上角create

--》输入名称

——》根据需要选择不同的项目

总结

- Pod 的自动伸缩

- HPA:Pod水平自动伸缩 为控制器管理的Pod资源副本数量实现自动扩缩容

- VPA:Pod垂直自动伸缩 据容器资源使用率自动设置CPU和内存的requests

- HPA的实现原理:

- 利用 metrics-server 定期收集 Pod 资源的平均 CPU 负载情况,根据HPA配置的 CPU/内存 requests 百分比阈值来动态调整 Pod 的副本数量

- HPA 扩容时,Pod 副本数量上升会比较快;缩容时,Pod 副本数量下降会比较慢

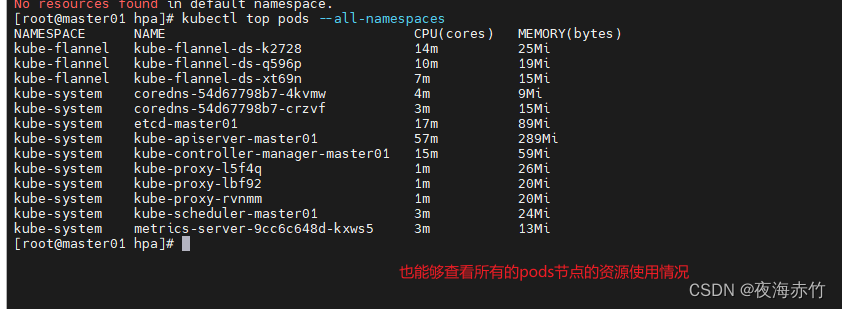

kubectl top nodes|pods

kubectl autoscale <Pod控制器资源> <资源名称> --min=<最小副本数> --max=<最大副本数> --cpu-percent=<CPU requests百分比阈值>

-

K8S集群管理工具:

- kubectl命令行管理工具 dashboard(K8S官方的UI界面图形化管理工具) 只能管理单个K8S集群

- 同时管理多个K8S集群:rancher kubesphere k9s

![[LeetCode111双周赛LeetCode359周赛] DP双指针](https://img-blog.csdnimg.cn/c17d9f8164d4447f87a5288aa724b9dd.png)