推荐:使用 NSDT场景编辑器助你快速搭建可二次编辑的3D应用场景

首席执行官Sam Altman曾多次谈到AI的安全性,例如在美国参议院委员会上,他说:

“我认为如果这项技术出错,它可能会出错......我们想对此直言不讳。我们希望与政府合作,防止这种情况发生。

话虽如此,OpenAI的团队已经将事情掌握在自己手中。许多人关心超级智能,这是一个如此智能的人工智能系统,它超越了人类的思维。一些人认为,技术可以解决世界上许多当前的问题,但是围绕它的信息或理解很少 - 很难权衡利弊。

现在谈论超级智能可能还为时过早,但这绝对是需要进行的对话。最好的方法是在这些潜在风险成为无法处理的更大问题之前尽早管理它们。

OpenAI 的方法

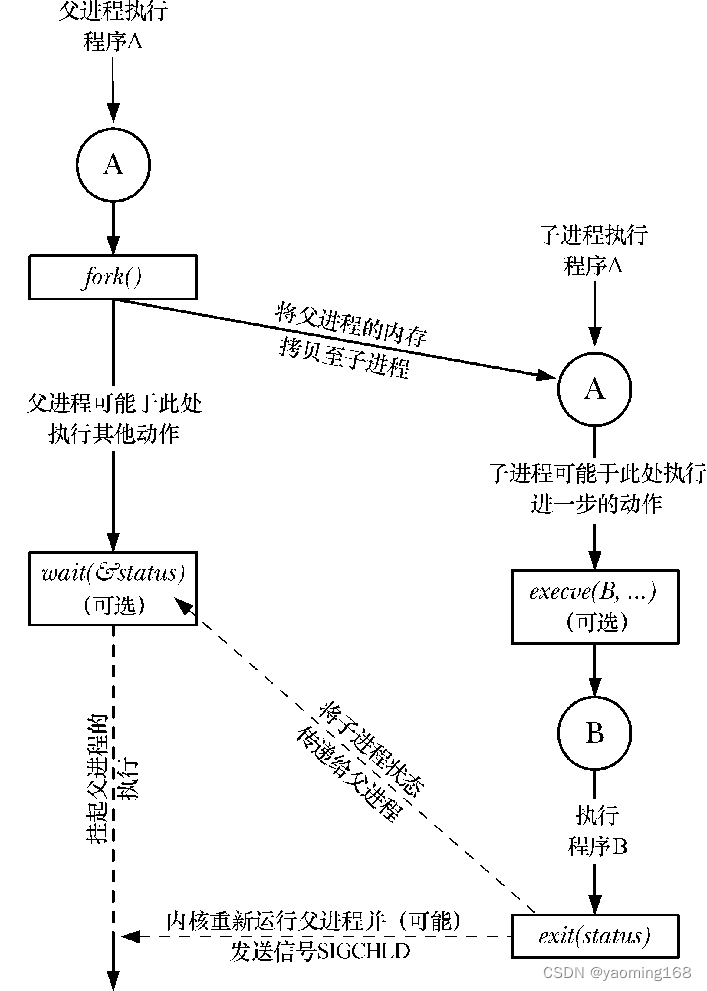

OpenAI表示,他们目前没有超级智能AI的解决方案,但是,这是他们正在与新团队Superalignment合作的事情。他们目前正在使用诸如从人类反馈中进行强化学习之类的技术,这些技术严重依赖人类来监督人工智能。然而,人们担心人类无法可靠地监督人工智能的未来挑战,以及需要新的科学突破来解决这个问题。

话虽如此,OpenAI正在考虑建立一个人类水平的自动对齐研究人员,该研究人员将能够从人类反馈中学习并协助人类评估AI,以及能够解决其他对齐问题。OpenAI已经将他们迄今为止保护的计算的20%用于这项工作,以迭代地调整超级智能。

为了使superalignment团队在这方面取得成功,他们需要:

1. 开发可扩展的培训方法

他们的目标是利用其他人工智能系统来帮助评估其他人工智能系统,同时能够更好地了解模型如何概括人类无法监督的监督。

2. 验证生成的模型

为了验证系统对齐的结果,OpenAI计划自动搜索有问题的行为,以完善模型的鲁棒性以及自动可解释性。

3. 对整个对准管道进行压力测试

测试,测试,测试!OpenAI计划通过故意训练未对齐的模型来测试其整个对齐过程。这将确保所使用的技术能够检测到任何形式的错位,特别是最糟糕的对抗性测试。

OpenAI已经进行了初步实验,并显示出良好的效果。他们的目标是使用有用的指标和研究模型的持续工作来推进这些工作。

总结

OpenAI旨在创造一个未来,在这个未来,人工智能系统和人类可以和谐相处,而不会感到彼此受到威胁。superalignment团队的发展是一个雄心勃勃的目标,但是,它将为更广泛的社区提供有关使用机器学习和能够创建安全环境的证据。

原文链接:通过 OpenAI 引入superalignment (mvrlink.com)