Searching a Hierarchically Aggregated Fusion Architecture for Fast Multi-Modality Image Fusion

(搜索用于快速多模态图像融合的分层聚合融合架构)

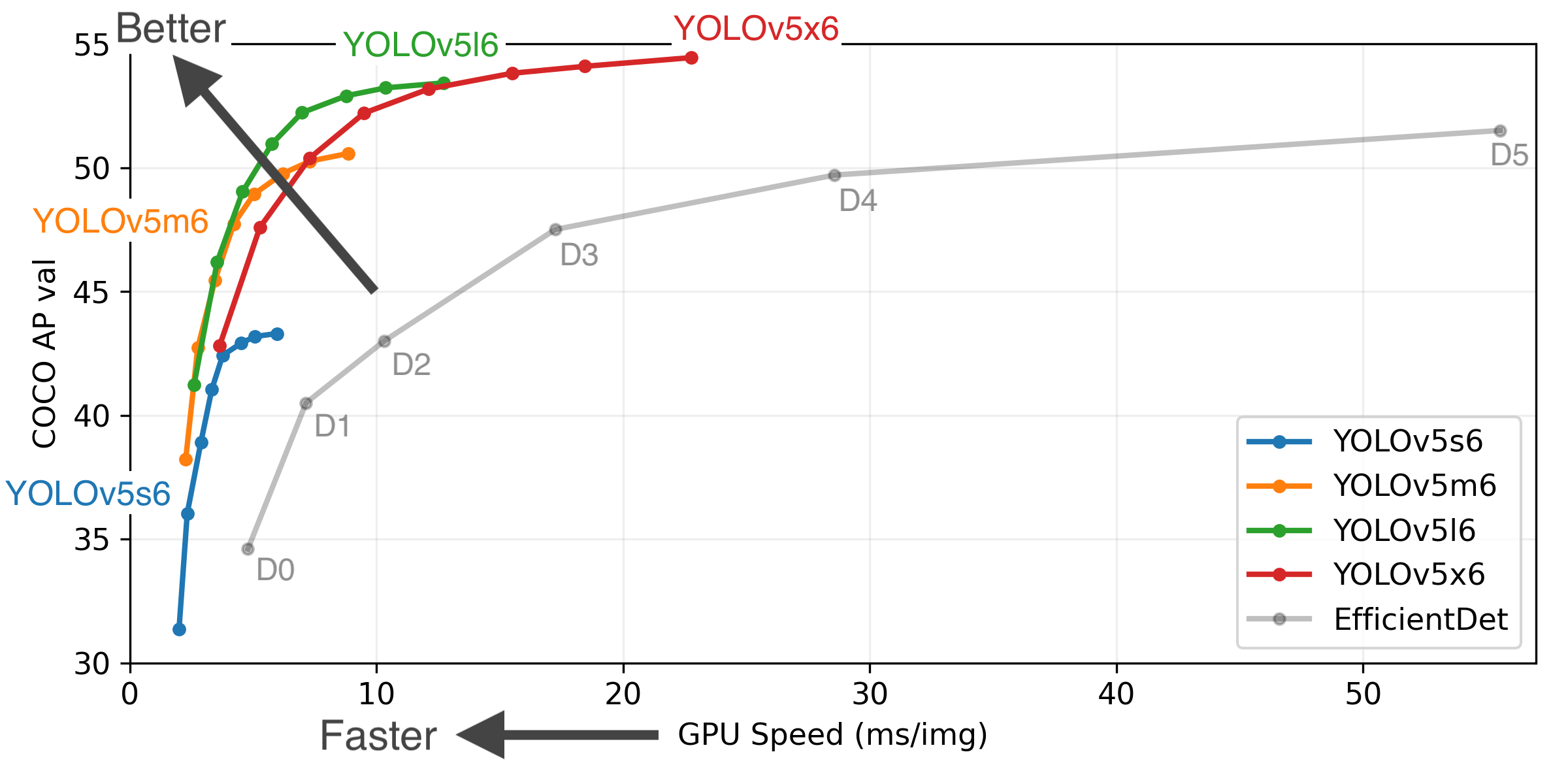

现有的基于CNN的方法使主要点在于设计各种体系结构,以端到端的方式实现这些任务。但是,这些手工设计无法应对高要求的融合任务,导致目标模糊和纹理细节丢失。为了缓解这些问题,本文提出了一种新颖的方法,旨在根据各种模态原理和融合机制搜索有效的体系结构。具体来说,我们构建了一个分层聚合的融合体系结构,从特征级和对象级融合视角提取和细化融合的特征,该融合的特征负责获得互补的目标/细节表示。然后,通过研究各种有效的实践,我们复合了一个更灵活的融合特定搜索空间。受协作原理的激励,我们采用了一种新的搜索策略,该策略具有不同的原则损失和硬件约束,可以充分发现组件。结果,我们可以获得具有快速推理时间的特定于任务的体系结构。

介绍

最近,神经架构搜索 (NAS) 方法取得了重大进展,可以分为三类,早期进化算法,基于强化学习的 和基于可微梯度的搜索。具体来说,可微方案已广泛用于各种视觉任务,例如图像恢复和分类。最近,NAS方案提供了多模态融合的工具。这些方法追求最终预测的准确性,而忽略了融合过程。原始搜索空间 (例如,可分离的卷积和池化) 忽略了使NAS停留在初始阶段的特定于任务的领域知识。因此,设计适当的搜索方案需要对探索融合图像特征的良好认识。

为了部分克服上述限制,这项工作提出了一种分层聚合的体系结构,而不是使用简单的网络为各种融合任务构建宏结构。具体而言,我们首先提出了一个特征级融合模块来获得初始融合结果。然后,我们研究了不同模态图像的典型属性,并设计了一个对象级融合模块,以基于目标/细节对象的内部信息来完善结果。通过引入聚合模块,我们可以获得具有不同目标和丰富文本细节的互补和全面的融合结果。此外,与当前的手工CNN方案不同,我们基于所提出的高效灵活的搜索空间来构造结构。考虑到特定于融合的知识,我们将高/低频分解和多尺度融合机制以及有效的块 (例如,残余,密集和注意模块) 集成到搜索空间中。然后,我们提供了一种协作学习策略,这是一种基于可区分搜索的新解决方案,可以逐步从不同的模块中发现整个体系结构,从而确保对每个原则组件进行充分的搜索。在不同阶段,各种损失被用来约束这些模块的基本作用。

贡献

1)为了解决基于cnn的方法中的主要绊脚石,我们首先构建一个分层聚合的体系结构来获得互补的融合图像,通过特征级融合和面向模态的特性进行整合。

2) 我们提出了一种面向融合的搜索空间,该空间利用融合原理,包括高/低频表示和多尺度机制,并引入有效的基本操作来促进图像融合。

3) 协作搜索策略旨在搜索整体在不同的原则损失和硬件约束的帮助下,从模块化级别逐步构建体系。所提出的搜索策略可确保结构的设计原理得到充分表征。

方法

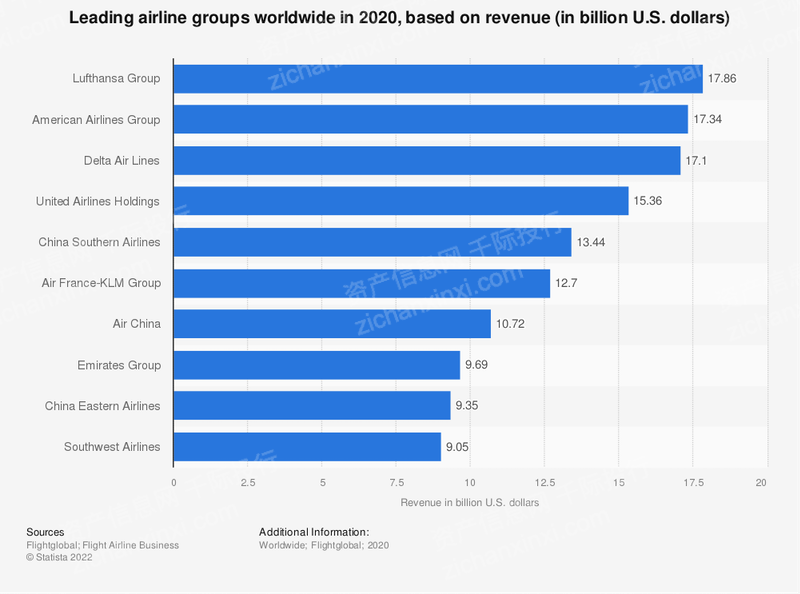

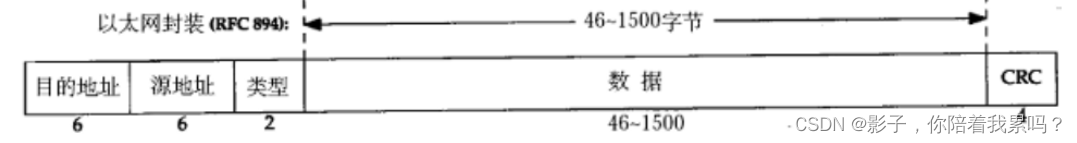

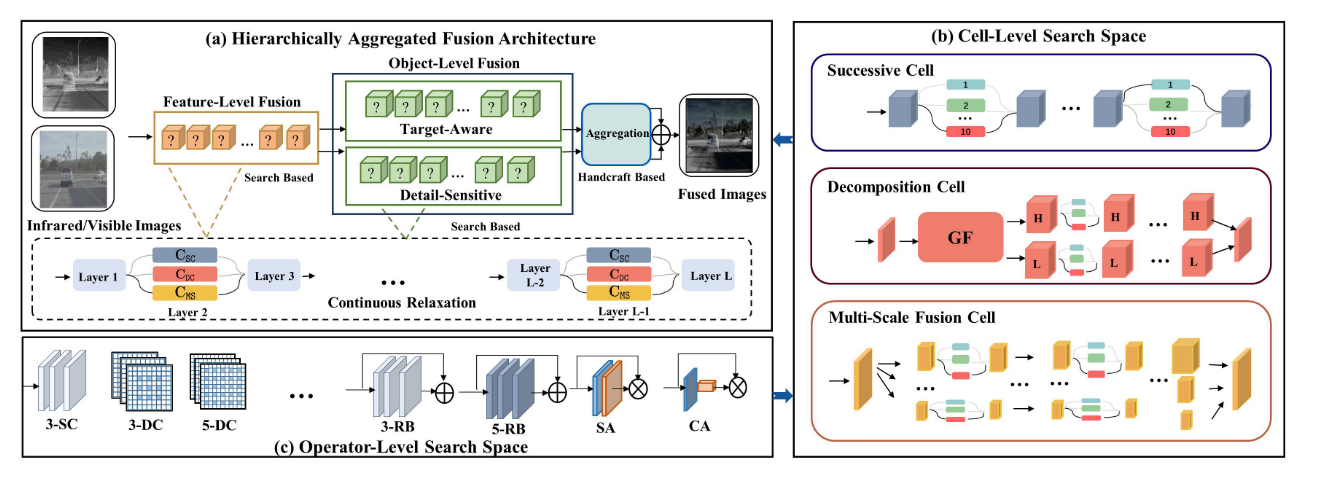

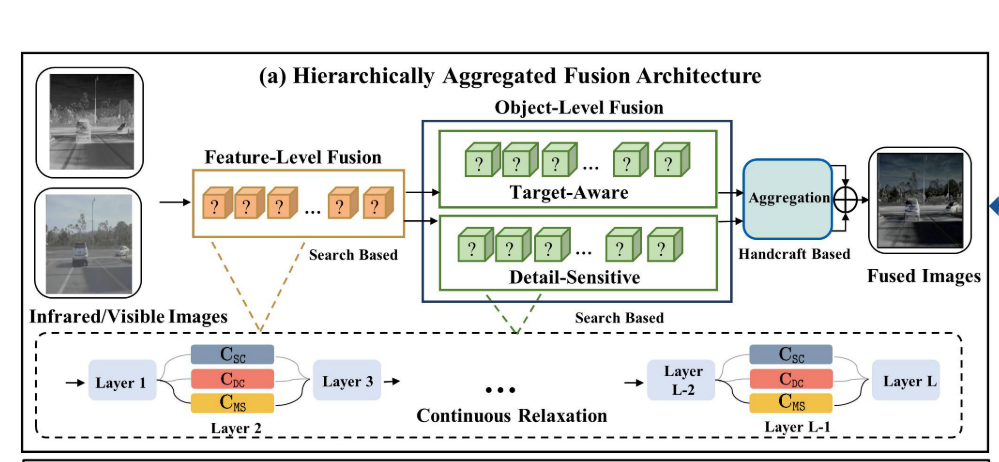

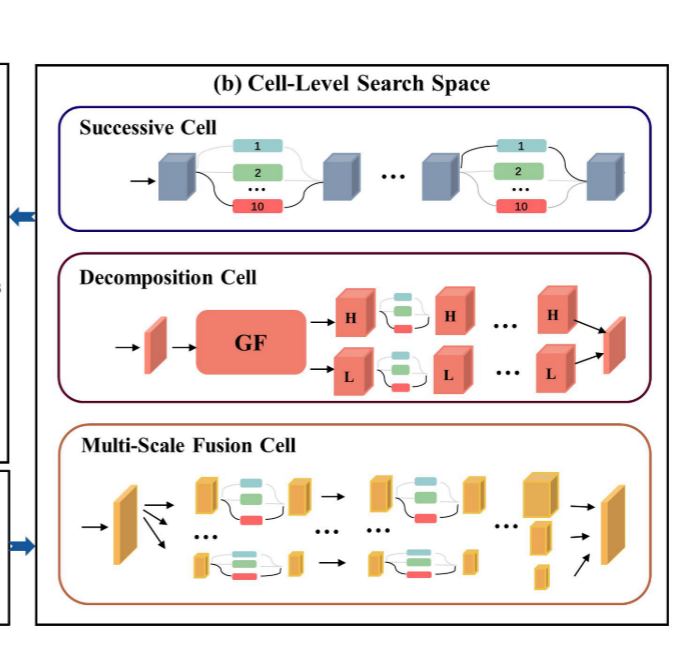

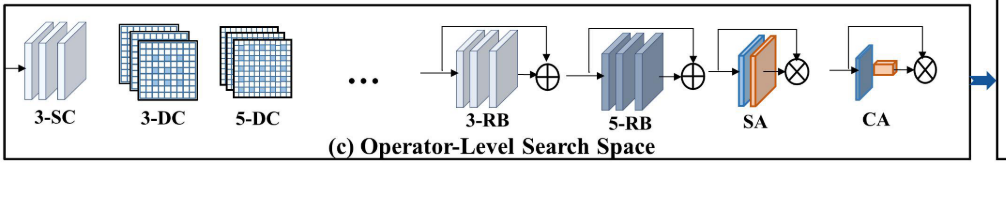

图1: 我们提出的体系结构和搜索空间的主要组成部分的示意图。在子图 (a) 中,我们说明了分层聚合的融合体系结构,包括融合级融合,特定于目标/细节的对象级融合和聚合模块。我们根据 (b) 和 © 中的三个原则单元和几个基本运算符绘制搜索空间。如两个蓝色箭头所示,这些单元由操作员级搜索空间组成,整个体系结构可以视为单元的集成。“GF” 表示引导过滤器。“H” 和 “L” 表示高频/低频特征。

Hierarchically Aggregated Fusion(分层聚合融合)

当前基于启发式深度学习的方法遇到了一些常见问题。(i) 大多数建议的体系结构都不复杂,无法充分利用模态信息的不同统计信息,因此,融合结果上可能会出现模糊的边缘或不清楚的目标。(ii) 由于计算复杂性和大参数量,导致大多数现有的融合方法在时间上通常竞争力较低。

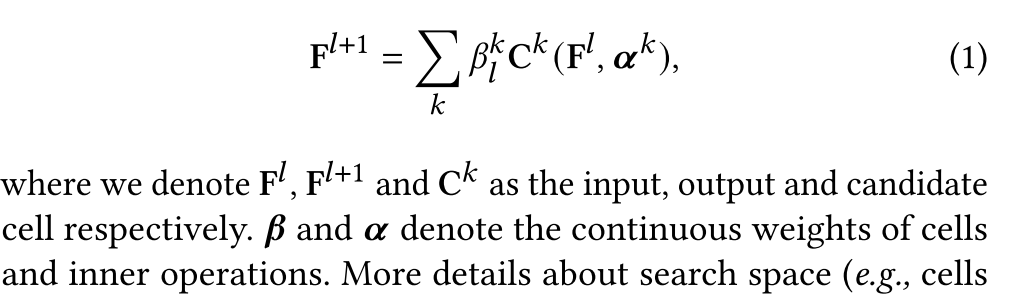

为了解决这些问题,我们首先提出了一种分层聚合的融合体系结构,它被解耦为三个重要的原则层次结构,即特征级融合、对象级融合和聚合机制,如图1的子图 (a) 所示。注意到这种分层体系结构可以通过自主搜索来构建,被认为是一个超级网络 (即各种潜在架构的集成)。我们提出了一个主要的模块,称为特征级融合模块 (FFM),旨在设计一个通用融合模块来提取,重建特征并生成融合图像。详细而言,FFM除了候选操作之外,还由一系列候选单元组成,与手动设计密集或残差块相比,它提供了更通用但更灵活的架构,如子图 (a) 的最后一行所示。第 𝑙 层的单元级连续弛豫可以用输出的加权和来实现,这使得整个体系结构是可区分的,并与

与现有的CNN方法相比,基于架构设计调查来自源图像的不同特征和互补信息是主要区别。来自多模态图像的目标信息和可见/结构细节也需要一种以不同方式提取特定于对象的信息的方案。因此,我们引入了对象级融合模块 (Object-level Fusion Module (OFM) )来优化融合图像。

在OFM中,我们将融合对象解耦为两个部分,即目标对象和细节敏感对象。详细地说,对于目标信息,热辐射通常代表红外图像中的目标,并且像素强度明显不同。另一方面,对于细节信息,具有更多纹理细节的可见观察可以提高场景意识。在以下小节中设计的不同原则损失的监督下,可以实现设计目标/细节对象模块的目标。最后,我们还构建了一个聚合模块来确认不同特征的保留程度。它是通过具有两层卷积和sigmoid函数的空间注意机制来实现的,以生成用于聚合两个目标/细节特定输出的权重掩码M。请注意,此聚合模块是预先定义的,无需架构搜索。

Fusion-Oriented Search Space(面向融合的搜索空间)

Fusion-Specific Cell Architectures

我们将三种类型的cells组成到cells级搜索空间中,这提供了这种分层体系结构的外部潜在结构构造,同时考虑了用于融合任务的有效实践,即高/低频表示和多尺度融合。

Successive cells。处理特定于硬件的场景,许多NAS方法采用连续小区 (也称为 “选择块”) 来降低搜索成本。N个选择块串联到复合单元 (表示为CSC)。自然地,几个运算符 (在搜索空间中定义) 被嵌入到具有连续权重的每个块中。最后,在每个块中选择权重最大的运算符。整个结构显示在子图 (b) 的第一行中,其中颜色不同的框表示运算符。

Decomposition Cell。基本单元 (即CDC) 由三个部分组成,即特征分解,并行流和特征融合。执行深度图像引导滤波器 以解耦高频/低频特征。着眼于两种特征,每行连接多个神经块。每个块都表示一个可能的操作。我们定义这个单元格有N个 𝑑 块。请注意,由于硬件计算限制,两行单元格中的块共享相同的体系结构。最后,执行conv 1 × 1层以融合高/行频率分量。整个体系结构显示在子图 (b) 的第二行。

多尺度融合Cell。基于多尺度融合原理,我们构建了以下单元。详细结构显示在子图 (b) 的最后一行。多尺度融合单元 (即CMS) 包括四个关键元素,即下采样,并行流,上采样和融合。我们利用strided卷积来降低特征的分辨率。在本文中,我们定义了多尺度特征的分辨率为1x,0.5x和0.25x。然后与分解单元格相同,单元格的每一行包含N个 𝑚 块。对调整大小的特征进行上采样后,我们通过conv 1 × 1层连接并融合它们。

运算符

子图 © 显示了操作员的主要具体插图。详细来说,我们放弃了跳过连接,池化和零/无操作,这不适合融合任务。

Collaborative Search Strategy

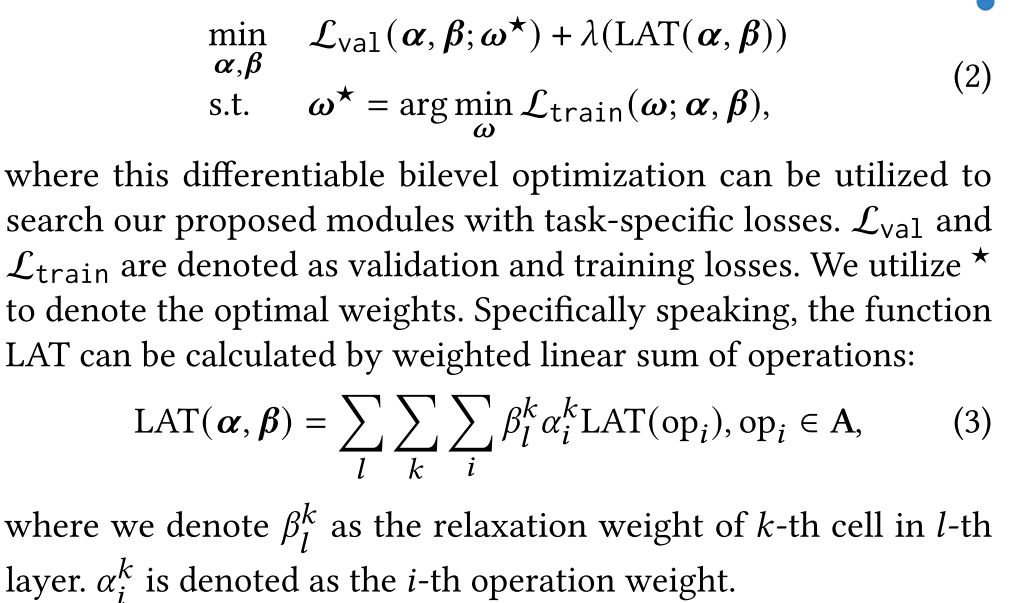

在这一部分中,我们介绍了执行连续松弛的三个关键外延,即矢量化形式 𝜶 := {𝜶𝐹,𝜶𝑂} 作为FFM和OFM的内部架构,𝜷 := {𝜷𝐹,𝜷𝑂} 作为外部架构,𝝎 := {𝝎𝐹,𝝎𝑂} 作为权重参数。请注意,我们定义了 𝝎𝑂 表示OFM和聚合模块的权重。在定义搜索空间之后,我们提出了一种协作搜索策略,以逐步发现整个体系结构,与朴素搜索策略相比,这是一种新的解决方案。这是因为当前基于梯度的搜索范例仅直接优化 {𝜶,𝜷} 和 𝝎,而忽略了我们提出的融合原理,难以利用这种复杂的搜索空间。

Bilevel Learning with Hardware-Aware Constraint. (具有硬件感知约束的二级学习)

为了限制搜索模块的计算成本,我们利用推理延迟作为硬件感知约束。我们将此延迟约束项引入为正则化损失,以复合搜索阶段的验证损失。从超级网络中发现低延迟结构的搜索过程可以表述为:

Collaborative Architecture Search.(协作架构搜索)

图1显示出了为分层架构执行的整个协作搜索策略。我们详细介绍了最初的战略,并考虑了两个关键因素。首先,行为良好的FFM可以提供具有足够特征的融合图像,以帮助OFM从全局到局部的搜索过程。换句话说,OFM的性能从有利的FFM中受益匪浅。其次,寻求外部架构可以指导内部运算符的构建从宏观到微观。这表明FFM和OFM的搜索关系是协作的。因此,我们提出了一种新的渐进式体系结构搜索策略来解决Eq(2)。详细地说,整个体系结构的搜索策略可以分为两个阶段,分别是FFM和opm的发现。我们首先使用一阶近似对FFM执行策略。L 𝐹 ′ val表示具有延迟约束的验证损失。在获得具有固定架构的FFM的最佳结构之后,我们执行OFM的学习过程。请注意,网络参数 𝝎𝑭 仍在优化,以保持整个架构的一致性。具体地,对于每个模块的搜索,从外部到内部搜索结构,即替换地更新 𝜷 和 𝜶,如Alg中的步骤 (4-13) 所示.

Loss Functions

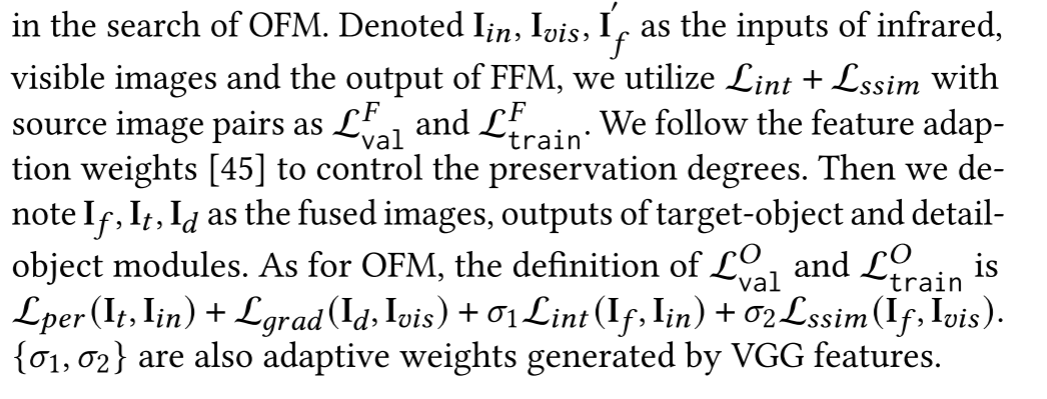

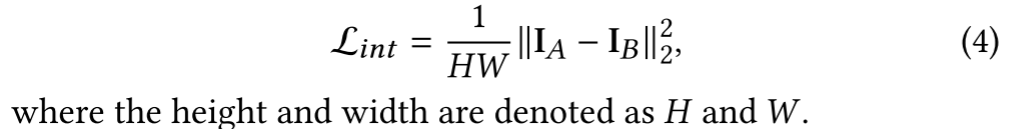

四种类型的损失被用来搜索/训练我们的候选网络。引入了旨在捕获对比度信息 (例如,以像素强度突出显示的热辐射) 的强度损失,其定义为

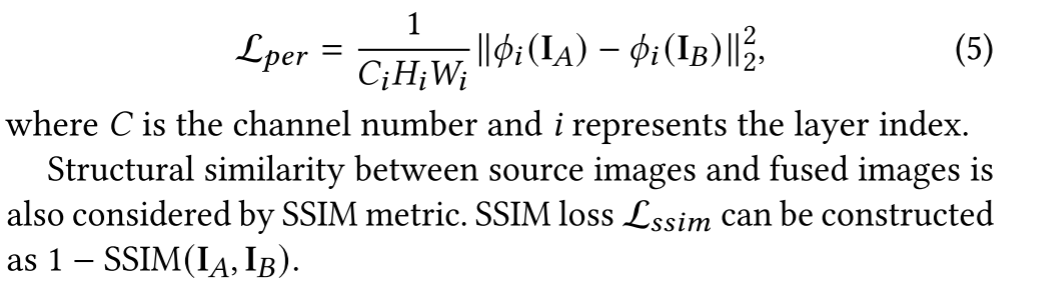

最近,感知损失被用来测量特征域 (例如VGG网络 𝜙) 中的差异,这可以表示像素不同和全局目标的差异。我们将感知损失定义为:

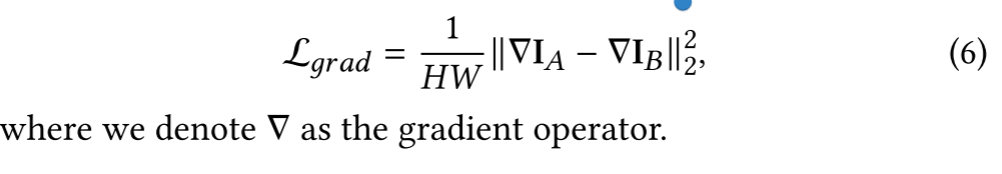

此外,图像的梯度信息始终表征纹理细节和场景结构。因此,我们使用梯度损失来约束这些文本因素,即:

Configuration for Infrared-Visible Image Fusion.

显然,此任务的目的是保留来自红外图像的目标的对比度强度和可见图像的纹理细节 (在梯度域中明显显示)。我们在OFM的搜索中引入了这一原理。