1 一言以蔽之

- (1) DPG是属于确定性策略梯度算法

- (2)用于解决连续动作空间问题

2 优点和缺点

- 2.1 优点

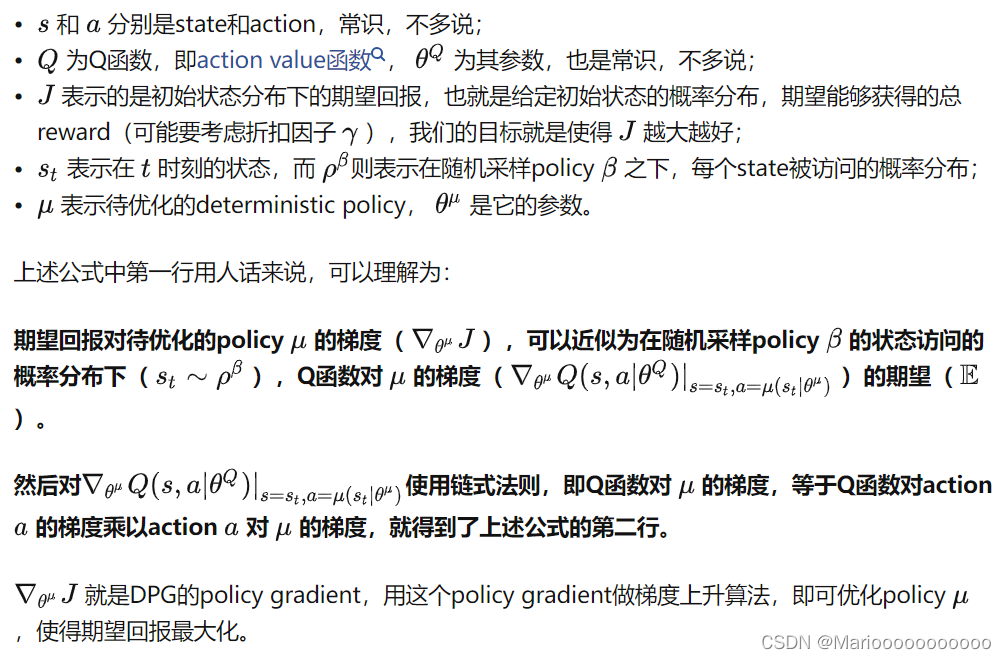

- (1)从理论上可以证明,deterministic policy的梯度就是Q函数梯度的期望,这使得deterministic方法在计算上比stochastic方法更高效;

- 2.2 缺点

- (1)对于每个state,下一步的action是确定的。这就导致只能做exploitation而不能做exploration。这可能也是为什么policy gradient一开始就采用stochastic算法的原因。

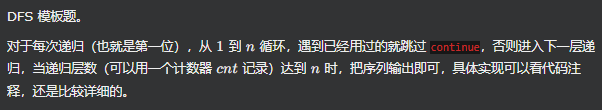

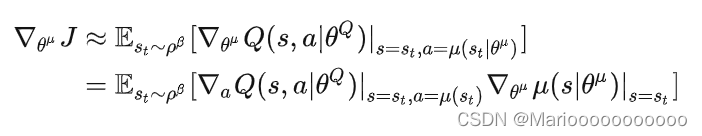

3 核心理论

- (1)策略梯度是Q对动作参数

θ

μ

\theta^{\mu}

θμ进行求导。

参考链接