论文题目(Title):UniMSE: Towards Unified Multimodal Sentiment Analysis and Emotion Recognition

研究问题(Question):短情绪emotions和长情绪sentiments的分析和识别

研究动机(Motivation):从心理学的角度来看,emotions是短时间内情感或感受的表达,而sentiments的形成和保持时间较长。然而,现有的大多数著作都是分开研究emotions和sentiments的,忽略了emotions和sentiments之间的相似性和互补性,没有充分挖掘两者背后的互补知识。

之前关于多层次文本特征的多模态融合的工作就像语法和语义一样,是缺乏的。

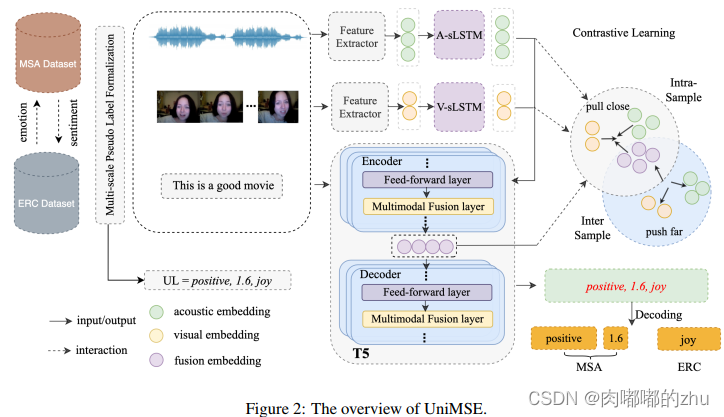

主要贡献(Contribution):在本文中,作者提出了一个多模态情感知识共享框架(UniMSE),它统一了来自特征、标签和模型的MSA和ERC任务。

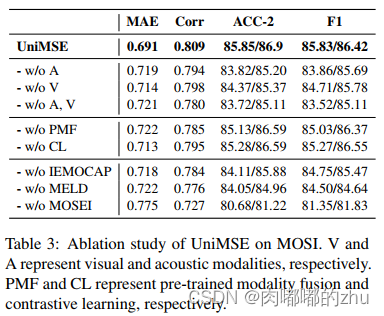

研究思路(Idea):作者提出了一个预训练的模态融合层(PMF),并将其嵌入到T5的Transformer 层中,该层将具有不同级别文本特征的声学和视觉信息融合在一起,以探测更丰富的信息。另外,执行跨模态对比学习(CL)来最小化类内方差和最大化跨模态的类间方差。

研究方法(Method):

数据来源:文本、视频和音频

主要创新:多层融合、对比学习(2022年情感分析中利用对比学习的文章多得一批,多层融合早在之前已经被广泛用于视觉方面,如目标检测尤其多,因此个人觉得创新性不是很大)

研究过程(Process):

1.数据集(Dataset):4个

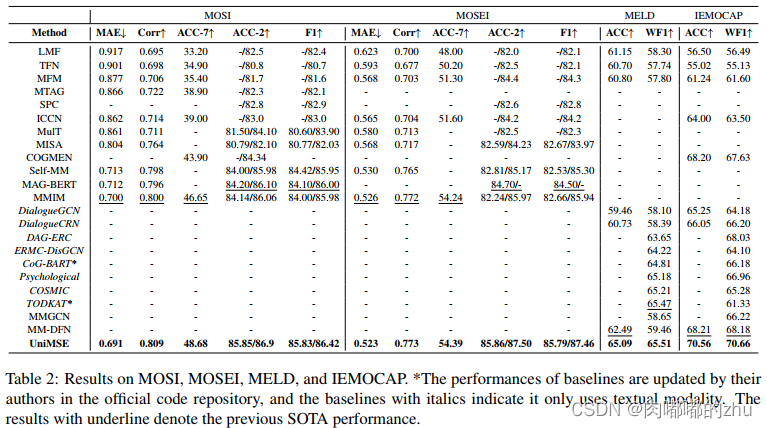

MSA和ERC的四个公开基准数据集上进行了实验,包括多模态意见水平情绪强度数据集 (MOSI),多模态观点、情绪与情绪强度(MOSEI),Multimodal EmotionLines数据集(MELD) ,交互式情感二元动作捕捉数据库(IEMOCAP)

2.评估指标(Evaluation)

以平均绝对误差(MAE)、皮尔逊相关(Corr)、七类分类正确率(ACC-7)、二元分类正确率(ac -2)、正/负分类和非负/负分类计算F1分为评价指标。对于MELD和IEMOCAP,使用精度(ACC)和加权F1 (WF1)进行评估。

3.实验结果(Result)

总结(Conclusion):从心理学的角度论证了情感与情感联合建模的可行性和合理性。作者提出了一个统一的多模式知识共享框架,UniMSE,解决MSA和ERC任务。UniMSE不仅捕获情绪和情感的知识,而且还对齐输入特征和输出标签。此外,还融合了具有多层次文本特征的听觉和视觉模态表示,并引入了跨模态对比学习。在四个基准数据集上进行了广泛的实验,并在所有指标上实现了SOTA结果。