目前在自动驾驶领域,多模态3D目标检测是一个非常重要的研究热点。由于引入了其他传感器数据,多模态3D目标检测在性能上明显优于纯视觉的方案,可以同时预测周围物体的类别、位置和大小,因此对于自动驾驶领域的同学来说,多模态3D目标检测是必须要掌握的部分。

今天要和大家分享的论文正是多模态3D目标检测方向,研究自动驾驶的同学必看!目前共汇总了21篇最新论文,来看看大佬们都有哪些成果吧!

决策融合

1.CLOCs: Camera-LiDAR Object Candidates Fusion for 3D Object Detection

标题:CLOCs:用于3D目标检测的Camera-LiDAR对象候选融合

内容:作者提出了一种新颖的 Camera-LiDAR 对象候选(CLOCs)融合网络,可以在保持较低复杂度的情况下,显著提高单模态检测器的性能。CLOCs 在任意2D和3D检测器的非极大值抑制(NMS)之前,对其输出的候选目标进行融合,利用两者的几何和语义一致性进行训练,从而产生更准确的最终3D和2D检测结果。在具有挑战性的KITTI目标检测基准测试中,CLOCs 在3D和鸟瞰图指标上都取得了显著提高,尤其在长距离情况下优于当前最先进的基于融合的方法。

2.Frustum Pointnets for 3D Object Detection from RGB-D Data

作者的方法不仅仅依赖于3D建议,还利用成熟的2D目标检测器和先进的3D深度学习进行目标定位,实现了效率和针对小目标的高召回率。

点/体素融合

1.PointPainting: Sequential Fusion for 3D Object Detection

标题:PointPainting: 3D目标检测的顺序融合

内容:作者提出了PointPainting,一种顺序融合方法来填补这一差距。PointPainting 的工作原理是将激光雷达点投影到仅图像语义分割网络的输出中,并将类别评分追加到每个点上。然后可以将追加(绘制)后的点云馈送到任何仅激光雷达的方法。实验结果显示,在KITTI和nuScenes数据集上,三种不同的最新方法Point-RCNN、VoxelNet和PointPillars都有了很大的改进。在KITTI基准测试的鸟瞰图检测任务中,绘制后的PointRCNN代表了一种新的最先进状态。

2.PointAugmenting: Cross-Modal Augmentation for 3D Object Detection

作者提出了一种新颖的跨模态3D目标检测算法,名为PointAugmenting,受益于一种新的跨模态数据增强算法,该算法在网络训练期间一致地将虚拟对象粘贴到图像和点云中。在大规模的nuScenes和Waymo数据集上的大量实验证明了PointAugmenting的有效性和效率。

3.Multimodal Virtual Point 3D Detection

作者提出了一种无缝融合RGB传感器到基于激光雷达的3D识别的方法,采用一组2D检测来生成密集的3D虚拟点,以增强否则稀疏的3D点云。该方法以显著的6.6 mAP提高了强大的CenterPoint基准,并优于竞争的融合方法。

4.Multi-task Multi-Sensor Fusion for 3D Object Detection

在本文中,作者提出利用多个相关任务来进行精确的多传感器3D目标检测,还提出了一个端到端的可学习架构,可以进行2D和3D目标检测以及地面估计和深度补全推理。实验结果表明,所有这些任务都是互补的,通过在各个层面融合信息,帮助网络学习到更好的表示。

5.MVX-Net: Multimodal VoxelNet for 3D Object Detection

论文提出了PointFusion和VoxelFusion:两种简单而有效的早期融合方法,通过利用最近引入的VoxelNet架构来组合RGB和点云模态。在KITTI数据集上的评估表明,与仅使用点云数据的方法相比,性能有显著改进。

6.PI-RCNN: An Efficient Multi-Sensor 3D Object Detector with Point-based Attentive Cont-Conv Fusion Module

论文提出了一种新颖的融合方法,称为基于点的注意力Cont-conv融合(PACF)模块,它直接在3D点上融合多传感器特征。除了连续卷积之外,作者还额外添加了一个点池化和一个注意力聚合,以使融合特征更加表达。此外,基于PACF模块,作者提出了一个处理图像分割和3D目标检测任务的3D多传感器多任务网络,称为点云图像RCNN(PI-RCNN简称)。

7.EPNet: Enhancing Point Features with Image Semantics for 3D Object Detection

作者提出了一种新颖的融合模块,以点式方式增强点特征与语义图像特征,而不需要任何图像注释。此外,采用一致性约束损失来明确鼓励定位和分类置信度的一致性,设计了一个端到端可学习的框架EPNet来集成这两个组件。在KITTI和SUN-RGBD数据集上的大量实验证明了EPNet优于当前最先进方法的优势。

特征融合

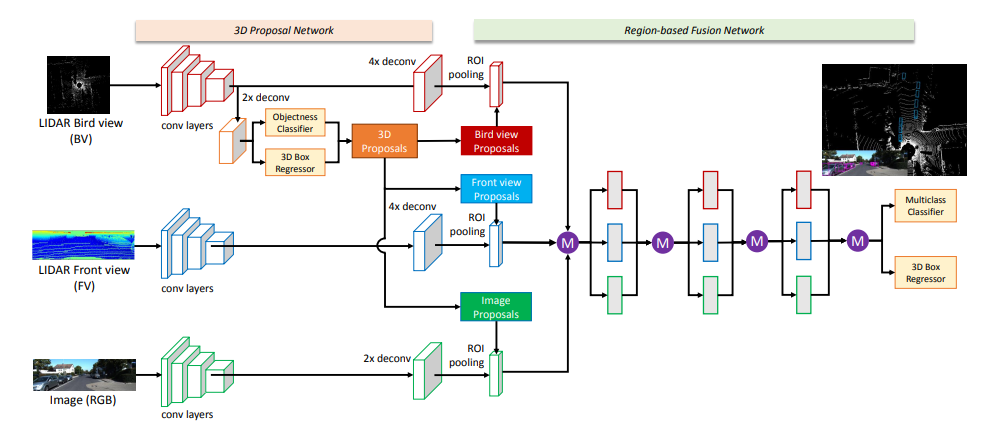

1.Multi-View 3D Object Detection Network for Autonomous Driving

标题:多视角3D目标检测网络用于自动驾驶

内容:论文提出了MV3D多视角3D网络,将激光雷达点云和RGB图像作为输入,预测oriented 3D bounding boxes,对稀疏3D点云进行了紧凑的多视角表示编码。网络由两个子网络组成:一个用于3D对象提议生成,另一个用于多视角特征融合。提案网络高效地从鸟瞰图上生成3D候选框。

作者设计了深度融合方案。结合来自多个视角的区域特征,启用不同路径之间的中间层交互。在KITTI数据集上,该方法的3D定位和检测性能优于目前state-of-the-art 25%和30%,2D检测方面也超过10.3%的AP。

2.Joint 3D Proposal Generation and Object Detection from View Aggregation

本文提出了AVOD,这是一个用于自动驾驶场景的聚合视角目标检测网络。该神经网络架构使用激光雷达点云和RGB图像生成两个子网络共享的特征:区域提议网络(RPN)和第二阶段检测器网络。提出的RPN使用了一种新颖的架构,能在高分辨率特征图上执行多模态特征融合,为多类别道路场景生成可靠的3D对象提议。

3.Cross-Modality 3D Object Detection

该文提出了一个两阶段的多模态融合网络,同时使用双目图像和原始点云作为输入。整个架构实现两阶段的特征融合。此外,该方法还使用伪LiDAR点作为数据增强方法来稠化LiDAR点,因为缺失的目标大多点数太少,尤其是远处目标。实验表明,该多阶段融合机制帮助网络学习到了更好的表示。

4.Sparse Fuse Dense: Towards High Quality 3D Detection with Depth Completion

本文提出了一种新颖的多模态框架SFD,利用深度补全生成的伪点云来解决仅LiDAR 3D检测中点云稀疏性的问题。不同于以往工作,本文提出了一种新的RoI融合策略3D-GAF,以更充分地利用不同类型点云的信息。此外,本文提出了SynAugment,使多模态框架能够利用所有针对仅LiDAR方法定制的数据增强方法。最后,本文定制了一个有效高效的伪点云特征提取器CPConv,可以同时探索2D图像特征和3D几何特征。

5.EPNet++: Cascade Bi-directional Fusion for Multi-Modal 3D Object Detection

本文提出了EPNet++,通过引入新的串联双向融合(CB-Fusion)模块和多模态一致性(MC)损失,实现多模态3D目标检测。在KITTI、JRDB和SUN-RGBD数据集上的实验表明,EPNet++优于当前最先进的方法。此外,文章强调了一个关键但易被忽略的问题,即探索检测器在更稀疏场景下的性能和鲁棒性。

6.AutoAlign: Pixel-Instance Feature Aggregation for Multi-Modal 3D Object Detection

本文提出了AutoAlign,一个用于3D目标检测的自动特征融合策略。该方法没有依赖确定性的摄像机投影矩阵,而是采用了可学习的对齐映射来建模图像和点云之间的映射关系,以动态的数据驱动方式实现非同构特征的自动对齐。

7.AutoAlignV2: Deformable Feature Aggregation for Dynamic Multi-Modal 3D Object Detection

作者提出了Cross-Domain DeformCAFA模块,用于解决AutoAlign中全局注意力引入的高计算量问题,该模块仅关注可学习的稀疏采样点来进行跨模态关系建模,增强了对校准误差的容忍性,大大加速了不同模态之间的特征聚合。为解决多模态下复杂的GT-AUG,作者还设计了一种简单有效的跨模态数据增强策略,在图像patch的深度信息条件下进行凸组合。另外,还提出了图像级dropout训练方案,使模型能够动态推理。

8.DeepFusion: Lidar-Camera Deep Fusion for Multi-Modal 3D Object Detection

本文提出了InverseAug逆向增强和LearnableAlign可学习对齐两种新技术,使得激光点和图像像素之间实现准确的几何对齐,以及图像和激光特征之间的动态相关性建模。在此基础上开发了通用的多模态3D检测模型系列DeepFusion,优于之前的方法。

9.TransFusion: Robust LiDAR-Camera Fusion for 3D Object Detection with Transformers

本文提出了TransFusion,一种具有软关联机制的激光雷达-摄像头融合的鲁棒解决方案,以处理inferior image conditions。此外,作者还设计了基于图像的查询初始化策略,以处理在点云中难以检测的对象。该方法在大规模数据集上达到最优性能,并通过大量实验证明其对劣质图像和误校准的鲁棒性。

10.DeepInteraction: 3D Object Detection via Modality Interaction

本文提出了一种新颖的模态交互策略,其中学习和维护各个单模态表示,以发掘其独特特征用于目标检测。为实现该策略,作者设计了具有多模态表征交互编码器和多模态预测交互解码器的DeepInteraction架构。在大规模nuScenes数据集上的实验表明,与所有之前方法相比,提出的方法取得了明显的性能提升。

11.Cross Modal Transformer: Towards Fast and Robust 3D Object Detection

本文提出了一种称为Cross Modal Transformer(CMT)的鲁棒3D检测器,用于端到端的3D多模态检测。CMT无需显式的视角变换,直接以图像和点云作为输入,输出准确的3D边界框。多模态tokens的空间对齐是通过将3D点编码成多模态特征来实现的。CMT的核心设计非常简单,但性能出色,它在nuScenes测试集上达到74.1% NDS(单模型最优),同时保持更快的推理速度。

12.SparseFusion: Fusing Multi-Modal Sparse Representations for Multi-Sensor 3D Object Detection

作者提出了 SparseFusion,一种新颖的多传感器 3D 检测方法,它仅使用稀疏候选框和稀疾表示。作者通过解耦对象表示来将摄像头候选框变换到激光雷达坐标空间。然后,可以在统一的 3D 空间中通过轻量级的自注意力模块融合多模态候选框。为缓解模态之间的负迁移,作者提出了新颖的语义和几何跨模态迁移模块,在特定模态检测器之前应用。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“3D检测”免费领取论文原文+代码合集

码字不易,欢迎大家点赞评论收藏!