Feature aggregation network for RGBD saliency detection

1. 动机

如何将RGB和Depth充分挖掘和融合仍是一个关键问题。

第一个问题是如何从深度图中充分挖掘几何信息,从而可以可靠地反映场景的空间结构。

第二个问题是如何有效地融合外观信息和几何信息,即有效的RGB和深度特征,其中RGB图像和深度图的内在属性存在很大差异。

2. 方法

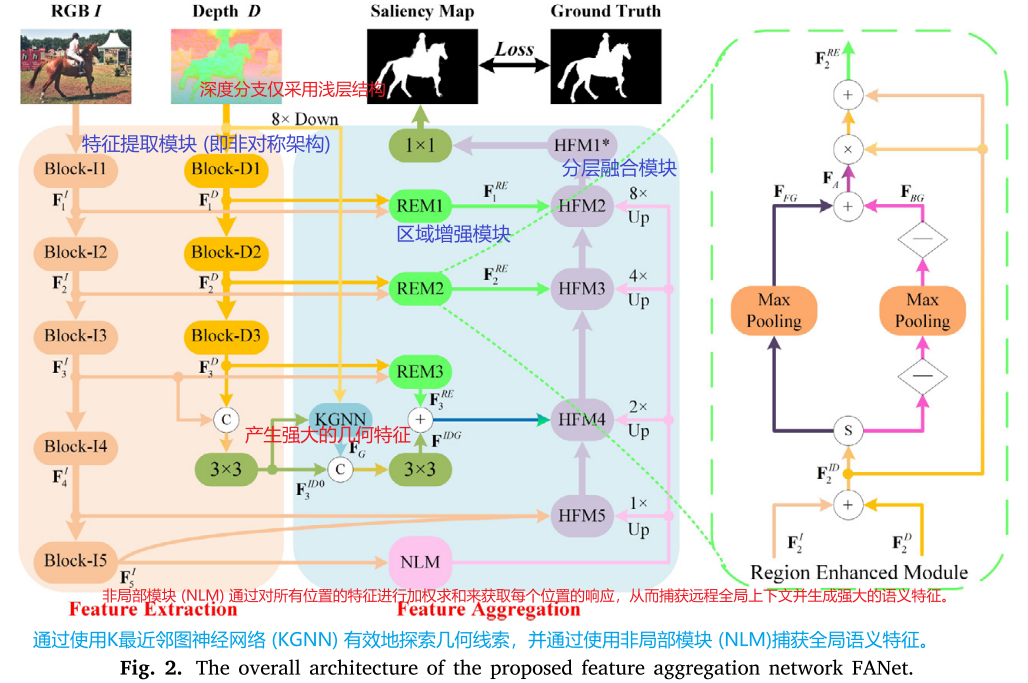

提出FANet,主要包括两个部分

1. 特征提取模块(非对称架构)

2. 特征聚合模块(主要特点),由两部分组成:REM(区域增强模块),HFM(分层融合模块)

REM(区域增强模块):用于区分显著目标和背景

HFM(分层融合模块):用于逐步整合高级语义信息和低级空间细节,其中K最近邻图神经网络 (KGNNs) 和非局部模块 (NLM) 嵌入HFM中,以分别挖掘几何信息并增强高级外观特征。

3. 网络框架

KGNN(K最近邻图神经网络):充分挖掘几何信息。

NLM(非局部模块):获取全局语义特征。

为什么深度分支只有3层?

深度数据包含更丰富的空间位置信息,并且通常被视为RGBD显着性检测的辅助组件。同时,浅层的深层特征通常传达空间信息,而深层特征则呈现丰富的语义信息。因此,我们的模型部署了浅层结构来提取深度特征,这足以使depth branch从深度图中获取空间线索。

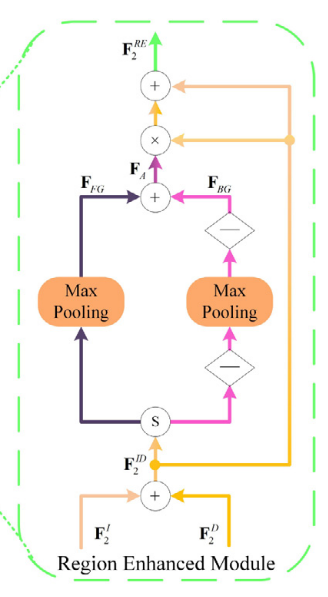

3.1 REM(区域增强模块)

REM作用:初步融合,大致定位显著目标并融合跨模态特征。

具体过程:针对于提取前三层的RGB和深度特征

1. 元素求和:用于初步融合。

2.sigmoid激活函数:将特征值范围映射为从0-1。

3.做大池化:特征选择。

4.反向最小池化:突出非显著区域。(“-”表示反向操作)

以上操作的作用:能够更加关注显著对象和背景

5. FFG和FBG元素求和:得到关注引导特征 𝐅𝐴,它充当注意力图,分别突出显示显著目标和抑制非显著区域。

6.将特征𝐅𝐼𝐷 𝑖 与 特征 𝐅𝐴 相乘再相加:得到深度特征𝐅𝑅𝐸 𝑖,关注显著对象,同时保留原始信息。

REM使模型能够产生更准确的显着性预测结果,因为它不仅可以增强显着对象,而且可以有效地抑制非显着区域。

3.3 KGNNs (K-最近邻图神经网络)

重点是为了充分挖掘几何信息.。。。。。。。(不太关注省略)

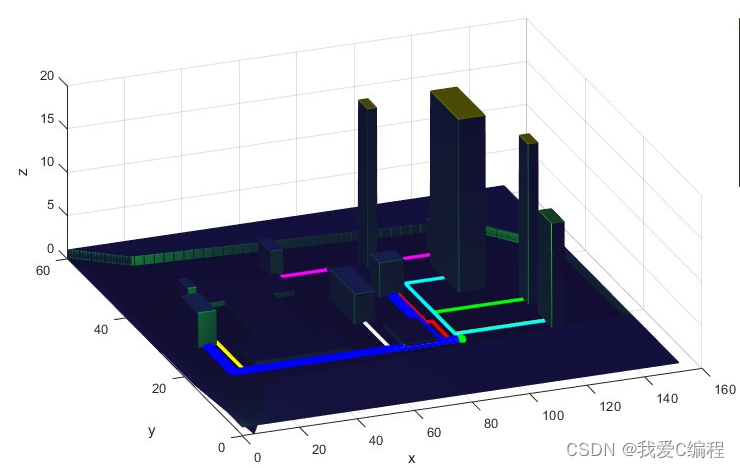

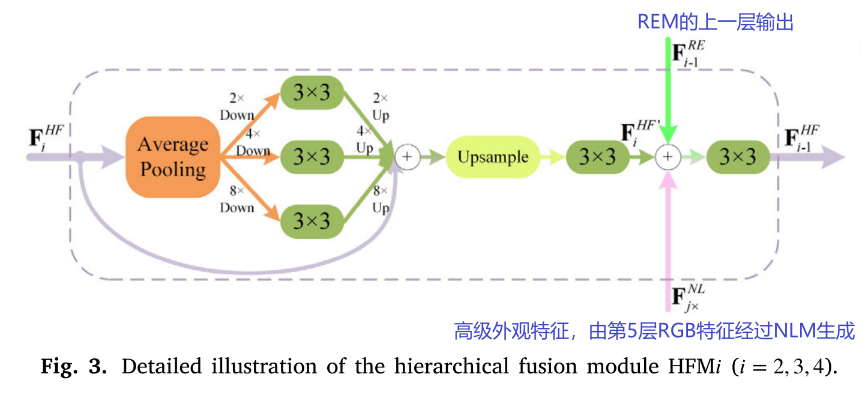

3.4 HFM (分层融合模块)

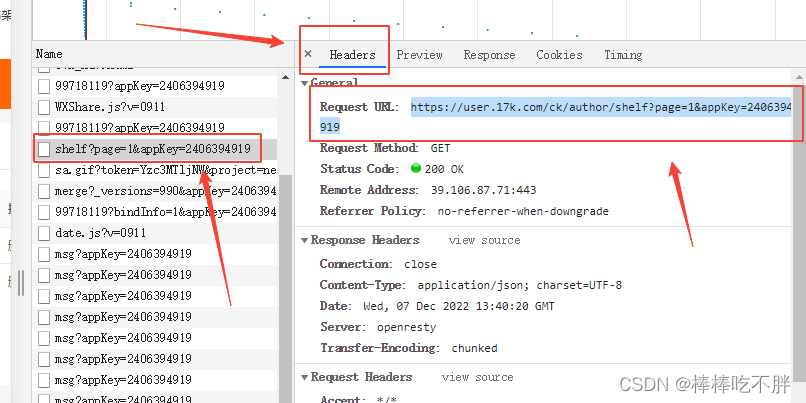

具体地,图3所示的HFM是基于池化的结构,它引入了多尺度体系结构,并以粗到精的方式集成了多级深度特征。 图2中,HFM 𝑖 (𝑖 = 2, 3,4) 努力对HFM(𝑖 +1)的输出进行据聚合 (意思就是第4层聚合第5层,第3层聚合第4层,第2层聚合第3层),jX 表示上采样与 ![]() 同样空间大小。

同样空间大小。

具体而言,首先,对于每个HFM 𝑖 (𝑖 = 2,3,4),它包含四个子分支: 一个本身和三个子分支,它们是平均池化 (降采样) 层,采样率分别为2、4和8。然后,在每个平均池化层之后,有一个3 × 3卷积层和一个双线性插值层。依次通过元素求和来融合四个子分支的特征图。接下来,部署双线性插值层 (upsample) 和3 × 3卷积层以进一步促进深度特征。这样,前面的分层融合模块HFM(𝑖 +1) 的输出 (即![]() ) 首先用这个结构进行处理,我们就可以得到初始的深度融合特征

) 首先用这个结构进行处理,我们就可以得到初始的深度融合特征![]()

最后,如前所述,REM(𝑖 − 1) 的输出 (即![]() ) 和高级外观特征 (即

) 和高级外观特征 (即 ![]() ) 也被馈送到

) 也被馈送到![]() ,产生融合的深度特征

,产生融合的深度特征 ![]() ,也是

,也是![]() 的输入。总的来说,这个过程可以定义如下:

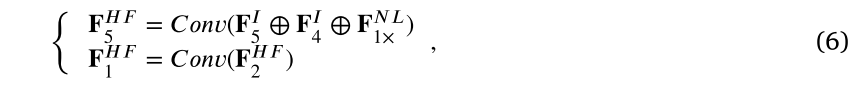

的输入。总的来说,这个过程可以定义如下:

当 𝑖 = 4时,我们将 ![]() 与使用KGNNs生成的

与使用KGNNs生成的![]() 结合起来,为分层深度特征融合产生了更具代表性的深度特征。因此,HFM4的输入,即

结合起来,为分层深度特征融合产生了更具代表性的深度特征。因此,HFM4的输入,即 ![]() ,可以表述如下:

,可以表述如下:

其中,图2所示的 𝐅𝐼𝐷𝐺 表示完全集成了外观信息和几何信息的混合特征,[⋅] 表示串联操作。

此外,包括HFM5和HFM1 ∗ 的第5和第1分层融合模块与HFM 𝑖 不同 (𝑖 = 2、3、4)。具体地说,首先,根据图2,我们可以发现HFM5的输入包含来自RGB分支的深层特征,包括 𝐅𝐼 5和 𝐅𝐼 4,以及NLM特征 ![]() 。对于HFM1 ∗,其输入仅包括HFM2的输出 (即 𝐅𝐻𝐹 2)。其次,HFM5和HFM1 ∗ 仅配备3 × 3卷积层。因此,整个计算过程可以定义为

。对于HFM1 ∗,其输入仅包括HFM2的输出 (即 𝐅𝐻𝐹 2)。其次,HFM5和HFM1 ∗ 仅配备3 × 3卷积层。因此,整个计算过程可以定义为