神经网络搭建八股“六步法”编写手写数字识别训练模型

- Sequential用法

- model.compile(optimizer=优化器,loss=损失函数,metrics=["准确率"])

- model.fit

- model.summery

- 六步法搭建鸢尾花分类网络

- class搭建具有非顺序网络结构

- MNIST数据集

- Fashion MNIST数据集

用Tensorflow API:tf.keras搭建网络八股

六步法

1.import (import相关模块,比如import tensorflow as tf)

2.train test (喂入网络的训练集和测试集,指定训练集的输入特征x_train和训练集的标签y_train ,还可以指定测试集的输入特征x_test和测试集的标签y_test)

3.model=tf.keras.models.Sequential (搭建网络结构,逐层描述每层网络)

4.model.compile (配置训练方法,告知训练时选择哪种优化器、损失函数、评测指标)

5.model.fit (执行训练过程,告知训练集和测试集的输入特征和标签,告知每个batch是多少、要迭代多少次数据集)

6.model.summary (打印网络的结构和参数统计)

Sequential用法

可以认为Sequential()是个容器,在这个容器中封装了一个神经网络结构

在Sequential要描述从输入层到输出层每一层的网络结构

例如:

1.拉直层:tf.keras.layers.Flatten()

2.全连接层:tf.keras.layers.Dense(神经元个数,activation='激活函数',kernel_regularizer=哪种正则化)

activation可选:relu、softmax、sigmoid、tanh

kernel_regularizer可选:tf.keras.regularizers.l1()、tf.keras.regularizers.l2()

3.卷积层:tf.keras.Conv2D(filter=卷积核个数,kernel_size=卷积核尺寸,strides=卷积步长,padding="valid" or "same")

4.LSTM层:tf.keras.layers.LSTM()

model.compile(optimizer=优化器,loss=损失函数,metrics=[“准确率”])

optimizer可选:

#优化器,可以是字符串形式的名字,还可以是函数形式(函数形式可以设置学习率、动量等超参数)

"sgd" or tf.keras.optimizers.SGD(lr=学习率,momentum=动量参数)

"adagrad" or tf.keras.optimizers.Adagrad(lr=学习率)

"adadelta" or tf.keras.optimizers.Adadelta(lr=学习率)

"adam" or tf.keras.optimizers.Adam(lr=学习率,beta_1=0.9,beta_2=0.999)

loss可选:

#优损失函数,可以是字符串形式的名字,还可以是函数形式

"mse" or tf.keras.losses.MeanSquaredError()

"sparse_categorical_crossentropy" or tf.keras.SparseCategoricalCrossentropy(from_logits=False)#from_logits=False 询问是否是原始输出(指未经过softmax概率输出的,经过False,未经过True)

Metrics可选:

"accuracy":y_和y都是值

"categorical_accuracy":y与y_都是独热码

"sparse_categorical":y_是值,y是独热码

model.fit

modelfit(训练集输入特征,训练集的标签,

batch_size= , epochs= ,

validation_data=(测试集的输入特征,测试集的标签)

vaildation_split=从训练集划分多少比例给测试集

vaildation_freq=多少epoch测试一次)

#validation_data与vaildation_split二选一

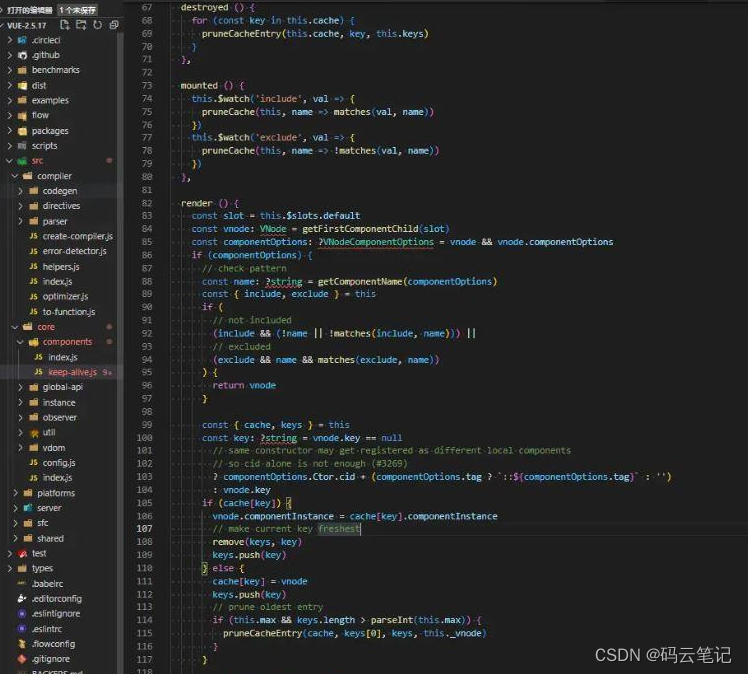

model.summery

model.summery可以打印网络的结构和参数统计

以鸢尾花分类的网络为例

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Si0hqkbk-1670672738651)(C:\Users\98306\AppData\Roaming\Typora\typora-user-images\image-20221206171521697.png)]](https://img-blog.csdnimg.cn/cbd0ca1cb63c4786ad3459f3d54cd897.png)

六步法搭建鸢尾花分类网络

import tensorflow as tf

from sklearn import datasets

import numpy as np

x_train = datasets.load_iris().data

y_train = datasets.load_iris().target

np.random.seed(116)

np.random.shuffle(x_train)

np.random.seed(116)

np.random.shuffle(y_train)

tf.random.set_seed(116)

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(3, activation='softmax', kernel_regularizer=tf.keras.regularizers.l2())

])

model.compile(optimizer=tf.keras.optimizers.SGD(lr=0.1),

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),

metrics=['sparse_categorical_accuracy'])

model.fit(x_train, y_train, batch_size=32, epochs=500, validation_split=0.2, validation_freq=20)

model.summary()

class搭建具有非顺序网络结构

#想要搭建非顺序的网络结构,可以用class

1.import

2.train、test

3.class MyModel(model) model=MyModel

4.model.compile

5.model.fit

6.model.sunmmary

用class类来封装一个网络结构

class MyModel(Model)

class MyModel(Model):#MyModel为神经网络的名字,继承了Tensorflow的Model类

def __init__(self):

super(MyModel,self).__init__()

定义网络结构模块

def call(self,x):

调用网络结构模块,实现前向传播

return y

model=MyModel()

###

__init__() 定义所需的网络结构块

call() 写出前向传播

###

例子:

class IrisModel(Model):

def __init__(self):

supper(IrisModel,self).__init__()

self.d1=Dens(3)

def call(self,x):

y=self.d1(x)

return y

model=IrisModel()

用类实网络结构实现鸢尾花分类的代码:

import tensorflow as tf

from tensorflow.keras.layers import Dense#添加的部分

from tensorflow.keras import Model#添加的部分

import numpy as np

from sklearn import datasets

x=datasets.load_iris().data

y=datasets.load_iris().target

np.random.seed(116)

np.random.shuffle(x)

np.random.seed(116)

np.random.shuffle(y)

class IrisModel(Model):

def __init__(self):

super().__init__()

self.d1=Dense(3,activation='sigmoid',kernel_regularizer=tf.keras.regularizers.l2())

def call(self,x):

y=self.d1(x)

return y

model=IrisModel()

# model=tf.keras.models.Sequential([tf.keras.layers.Dense(3,activation="softmax",kernel_regularizer=tf.keras.regularizers.l2())])

model.compile(optimizer=tf.keras.optimizers.SGD(learning_rate=0.1),loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),metrics=['sparse_categorical_accuracy'])

model.fit(x,y,batch_size=32,epochs=500,validation_split=0.2,validation_freq=20)

model.summary()

结果为

Epoch 500/500

4/4 [==============================] - 0s 11ms/step

- loss: 0.4527

- sparse_categorical_accuracy: 0.8500

- val_loss: 1.0348

- val_sparse_categorical_accuracy: 0.5333

Model: "iris_model"

____________________________________________________________

Layer (type) Output Shape Param

============================================================

dense (Dense) multiple 15

============================================================

Total params: 15

Trainable params: 15

Non-trainable params: 0

____________________________________________________________

其中:

loss:训练集loss

val_loss:测试集loss

sparse_categorical_accuracy:训练集准确率

val_sparse_categorical_accuracy:测试集准确率

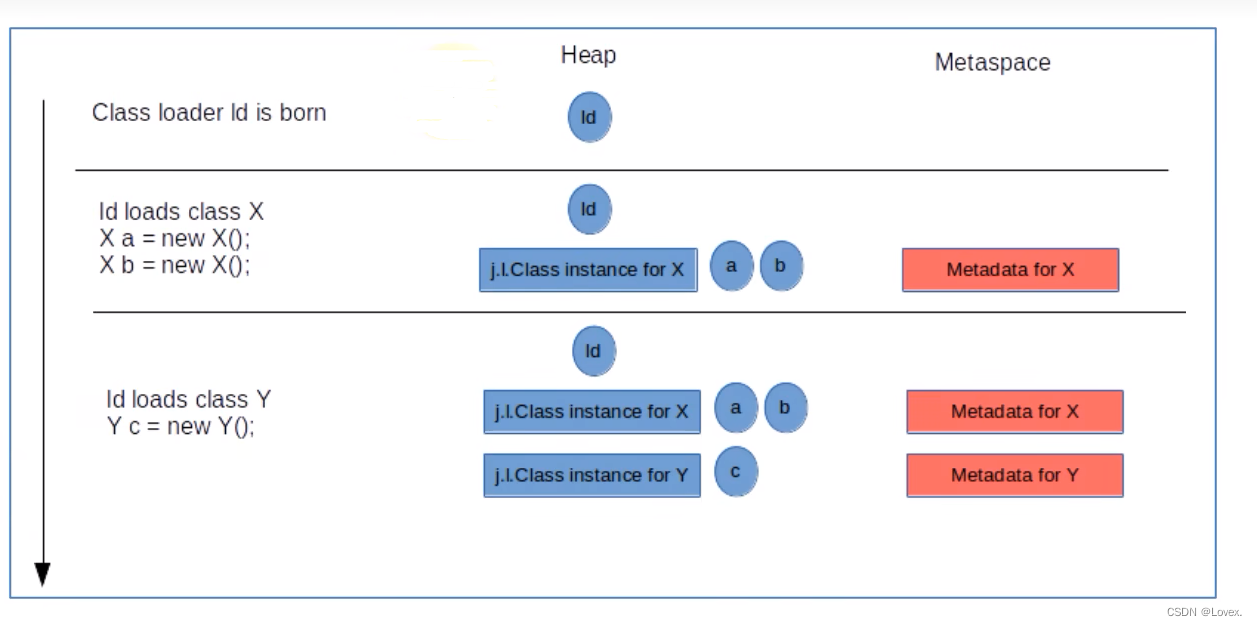

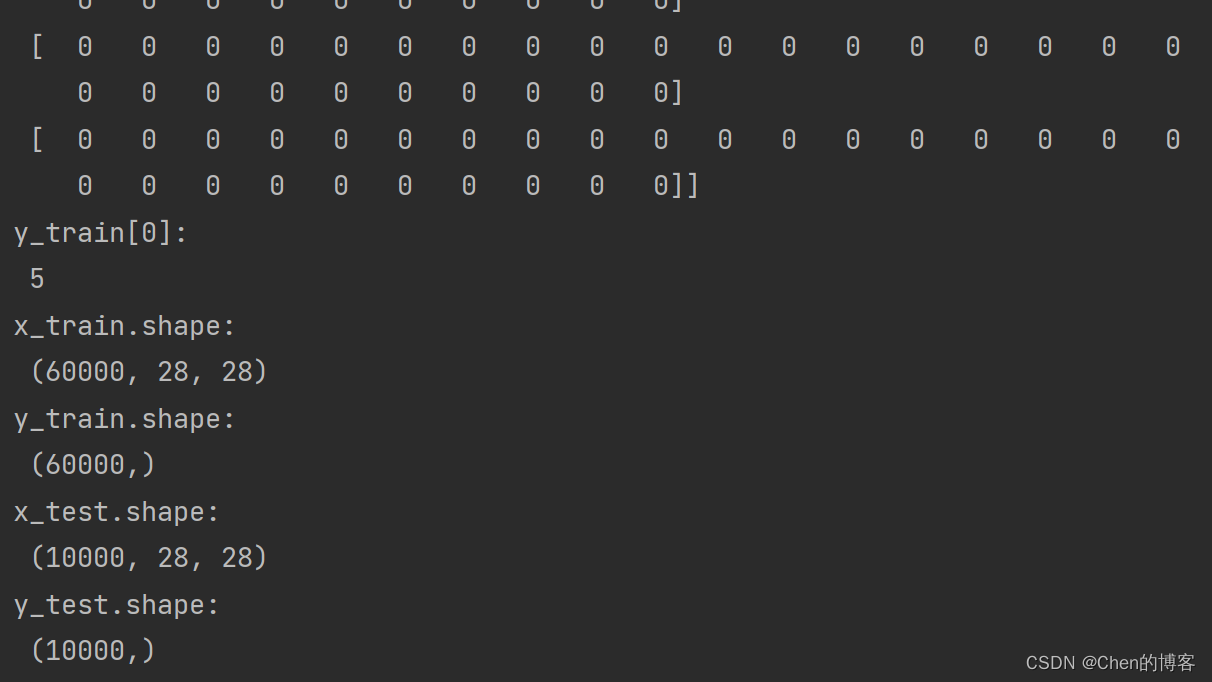

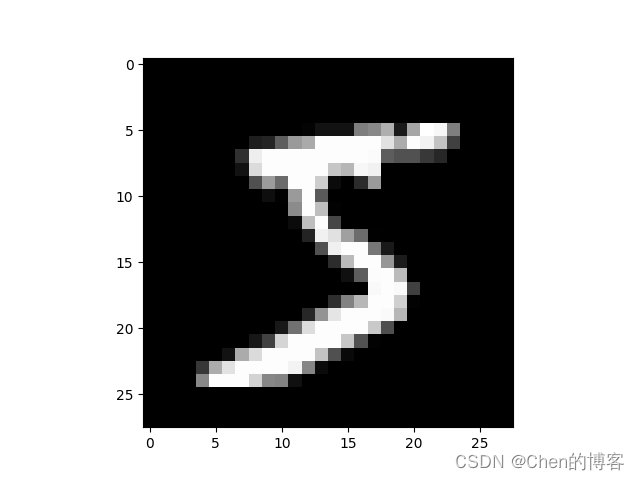

MNIST数据集

MNIST数据集

提供6w张 28*28像素的0~9手写数字图片和标签,用于训练

提供1w张 28*28像素的0~9手写数字图片和标签,用于测试

导入数据集:

minist=tf.keras.datasets.mnist

(x_train,y_train),(x_test,y_test)=mnist.load_data()

作为输入特征,输入神经网络时,将数据拉伸为一维

tf.keras.layers.Flatten()

import tensorflow as tf

from matplotlib import pyplot as plt

mnist = tf.keras.datasets.mnist

(x_train, y_train), (x_test, y_test) = mnist.load_data(r"这里填mnist数据集路径")#把minist数据集先下载到电脑中,再导入,直接下载容易出错

# 可视化训练集输入特征的第一个元素

plt.imshow(x_train[0], cmap='gray') # 绘制灰度图

plt.show()

# 打印出训练集输入特征的第一个元素

print("x_train[0]:\n", x_train[0])

# 打印出训练集标签的第一个元素

print("y_train[0]:\n", y_train[0])

# 打印出整个训练集输入特征形状

print("x_train.shape:\n", x_train.shape)

# 打印出整个训练集标签的形状

print("y_train.shape:\n", y_train.shape)

# 打印出整个测试集输入特征的形状

print("x_test.shape:\n", x_test.shape)

# 打印出整个测试集标签的形状

print("y_test.shape:\n", y_test.shape)

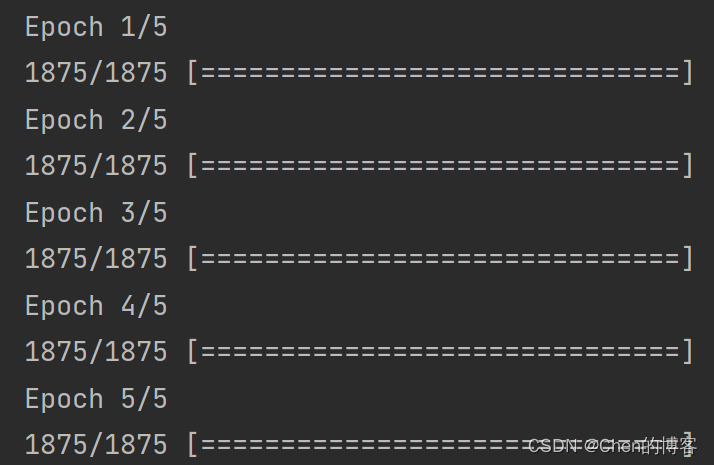

用mnist数据集的训练代码

import tensorflow as tf

mnist=tf.keras.datasets.mnist

(x_train,y_train),(x_test,y_test)=mnist.load_data(r"这里填mnist数据集路径")

x_train,x_test=x_train/255.0,x_test/255.0#归一化到[0,1]

model=tf.keras.models.Sequential([

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128,activation='relu'),

tf.keras.layers.Dense(10,activation='softmax')

])

model.compile(optimizer='adam',loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),metrics=["sparse_categorical_accuracy"])

model.fit(x_train,y_train,batch_size=32,epochs=5,validation_data=(x_test,y_test),validation_freq=1)#执行训练过程

model.summary()

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-B827fFda-1670672738653)(C:\Users\98306\AppData\Roaming\Typora\typora-user-images\image-20221210192009223.png)]](https://img-blog.csdnimg.cn/a7b4b2379aac41eaa71b8609fc4cbf04.png)

用类实现手写字识别

import tensorflow as tf

from tensorflow.keras.layers import Dense,Flatten

from tensorflow.keras import Model

mnist=tf.keras.datasets.mnist

(x_train,y_train),(x_test,y_test)=mnist.load_data(r"C:\Users\98306\Desktop\Tensorflow\中国大学MOOCTF笔记2.1共享给所有学习者\class3\mnist.npz")

x_train,x_test=x_train/255.0,x_test/255.0 #归一化到[0,1]

class MnistModel(Model):

def __init__(self):

super(MnistModel, self).__init__()

self.flatten=Flatten()

self.d1=Dense(128,activation='relu')

self.d2=Dense(10,activation='softmax')

def call(self,x):

x=self.flatten(x)

x=self.d1(x)

y=self.d2(x)

return y

model=MnistModel()

# model=tf.keras.models.Sequential([

# tf.keras.layers.Flatten(),

# tf.keras.layers.Dense(128,activation='relu'),

# tf.keras.layers.Dense(10,activation='softmax')

# ])

model.compile(optimizer='adam',loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=False),metrics=["sparse_categorical_accuracy"])

model.fit(x_train,y_train,batch_size=32,epochs=5,validation_data=(x_test,y_test),validation_freq=1)

model.summary()

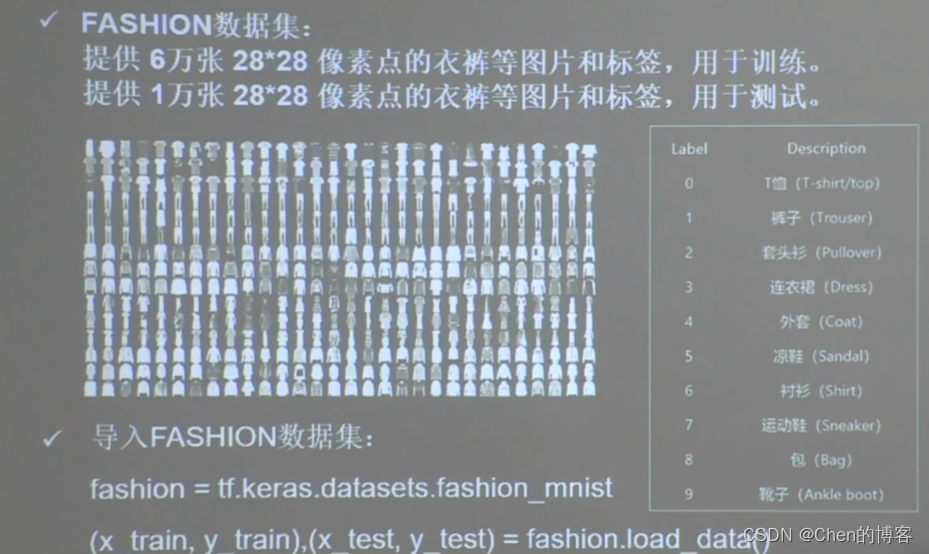

Fashion MNIST数据集

Fashion MNIST数据集

提供6w张 28*28像素的0~9手写衣服裤子等图片和标签,用于训练

提供1w张 28*28像素的0~9手写衣服裤子等图片和标签,用于测试

一共十个分类

导入数据集:

minist=tf.keras.datasets.mnist

(x_train,y_train),(x_test,y_test)=mnist.load_data()

作为输入特征,输入神经网络时,将数据拉伸为一维

tf.keras.layers.Flatten()

Fashion MNIST数据集没法直接代码下载的话可以参考这篇博客