batch norm是列标准化,layer norm是行标准化

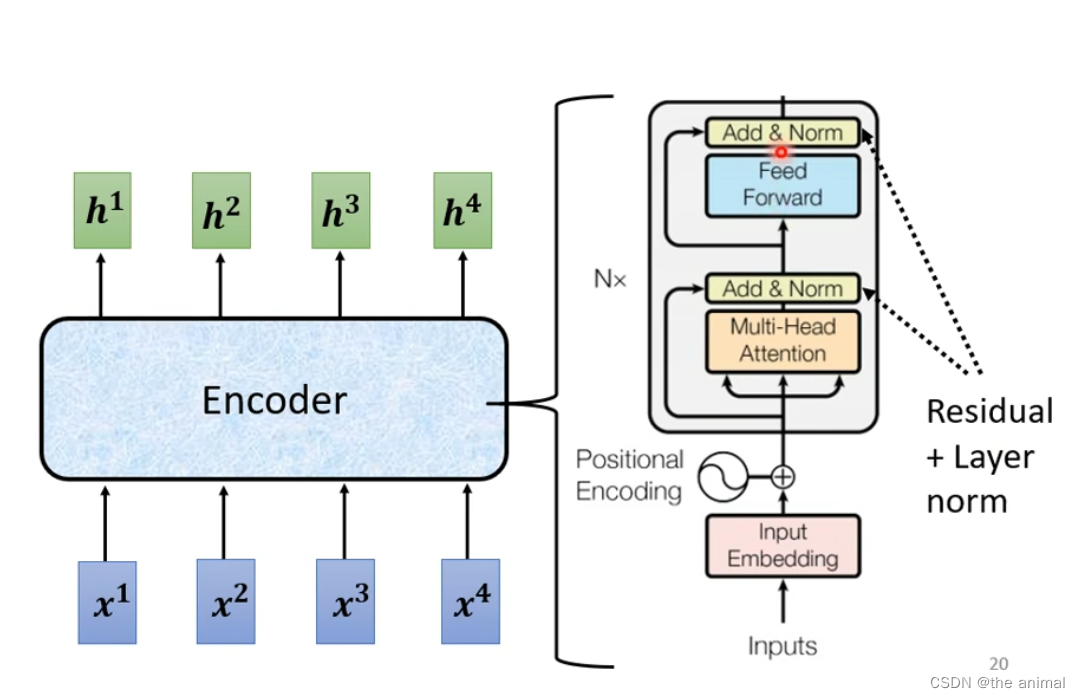

transforms的encoder,这里省略了一些东西。每一个block都是输入一段向量,然后输出一段向量。每一个block不仅仅是一层layer。每一个block所做的事情,大概是先输出一段向量,做self-attention,考虑整个seq,然后输出。再将输出输入到全连接层中,最后的输出就是block的输出。

在transforms的encoder中,所做的事更为复杂。在经过self-attention后,我们在输出a上加上了自身b。将相加的结果,也就是residual,再经过规范化。这里用的规范化不再是batch normalization 而是layer normalization。将规范化后的结果作为全连接层的输出,再输出的时候,仍然要加上自身。最后在经过规范化,就是block的输出。

在输入的时候,除了词向量之外,还需要加入位置编码,用来确定其相对位置。

transforms

news2026/2/11 6:34:02

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/768129.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

Elasticsearch 集群某一节点修改 IP 后无法启动问题复盘

1、集群环境及问题描述 集群版本:6.8.X集群节点:5节点(三个节点为主数据节点,另外两个独立数据节点)。问题描述:由于IP冲突,修改了一台服务器的IP,然后5台配置改了一下一次重启&…

基于51单片机和proteus的电流采集系统

此系统是基于51单片机和proteus的仿真设计,功能如下:

1. LCD1602实时显示获取到电流值及设定值。

2. 按键可调整电流设定值。

3. 电流值过高则蜂鸣器报警。

4. 指示灯指示电流及系统状态。

5. 系统信息可通过串口实时更新。 功能框图如下࿱…

C#窗体添加自定义控件

C#窗体添加自定义控件。 新建一个窗体项目: 在左侧工具箱点击右键选择添加选项卡: 将自定义控件的动态链接库(.dll)放到项目中:文件夹名字随意 在工具箱中选中刚刚添加的工具项,点击右键,选择添…

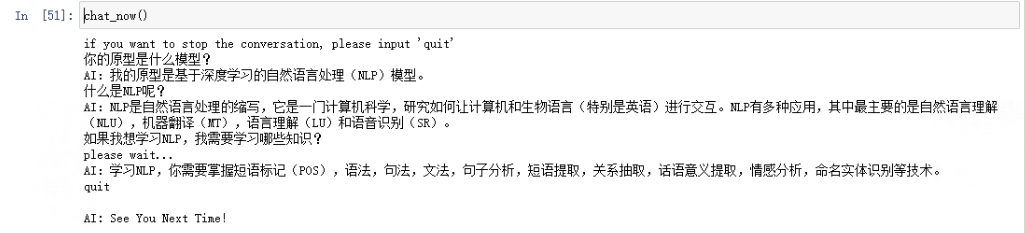

大模型开发(六):OpenAI Completions模型详解并实现多轮对话机器人

全文共8500余字,预计阅读时间约17~30分钟 | 满满干货(附代码),建议收藏! 代码下载点这里

一、 Completions与Chat Completions基本概念

经过海量文本数据训练的大模型会在全量语义空间内学习语法关系和表达风格,并通过某些微调过…

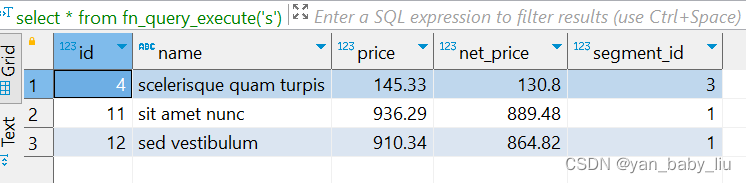

13.postgresql--函数

文章目录 标量示例复合示例有返回值函数返回voidRETURN NEXT ,RETURN QUERYRETURN EXECUTEIF THEN END IFFOREACH,LOOPSLICE (1)如果函数返回一个标量类型,表达式结果将自动转行成函数的返回类型。但要返回一个复合(行)…

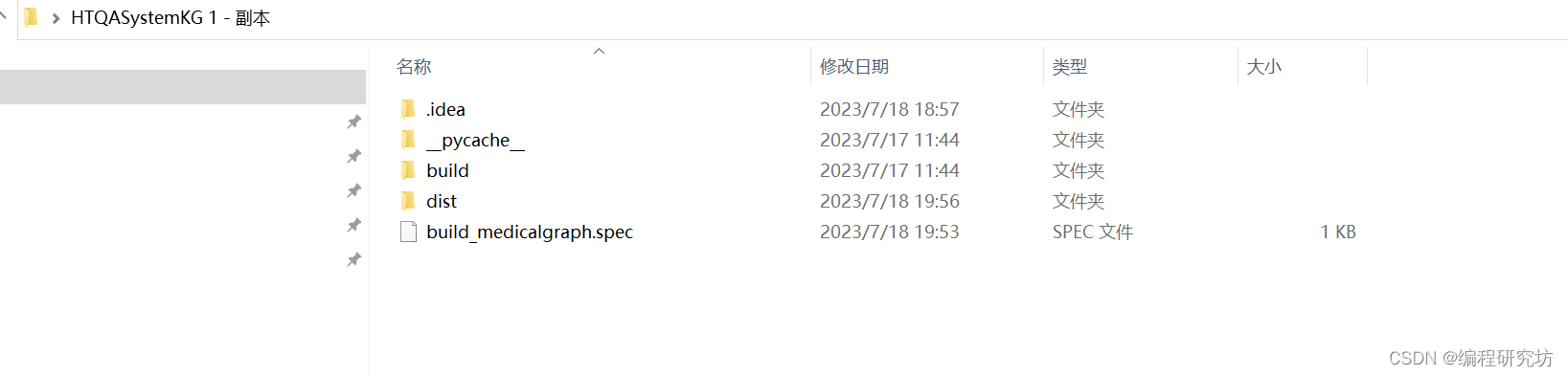

python如何打包整个项目成exe文件?

首先需要进入项目打包文件所在的目录

运行以下命令打包 build_medicalgraph.py文件

pyinstaller -D build_medicalgraph.py 打包完成后一定要记得下面这个步骤,否则运行会发现报错

把数据文件给放到exe文件同级别目录下 除了以下文件保留,其他文件可以…

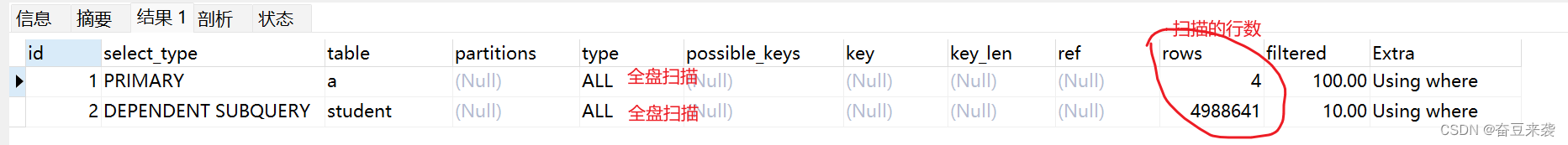

EXISTS和IN的区别

一.EXISTS和IN的介绍

1. exists

exists返回的是true(空)和flase(非空)

对user表的每行数据逐条取出,每取一行,就判断exists后面的子语句的结果是否为空,是空,这行数据就不要,不是空,这行数据就留下. 如下: select * from user where exists (select 1); 对user表…

js计算数组中每个元素出现的次数

tip:空值合并运算符(??)是一个逻辑运算符,当左侧的操作数为 null 或者 undefined 时,返回其右侧操作数,否则返回左侧操作数。reduce() 方法对数组中的每个元素按序执行一个提供的 reducer 函数࿰…

VUE之基本组成和使用

参考资料:

参考视频

视频资料及个人demo

vue官网

vue官网-vue.js组成说明 VUE之基本部署及VScode常用插件

关闭驼峰命名法的使用异常 VUE项目结构介绍:

通过上文步骤(VUE之基本部署及VScode常用插件),我们创建了一个基本的…

【业务功能篇48】后端接口开发的统一规范

业务背景:日常工作中,我们开发接口时,一般都会涉及到参数校验、异常处理、封装结果返回等处理。而我们项目有时为了快速迭代,在这方面上有所疏忽,后续导致代码维护比较难,不同的开发人员的不同习惯…

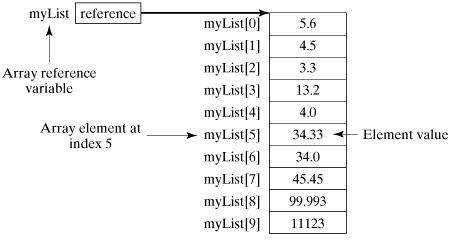

5、Java入门教程【数组】

数组是用于存储同种类型的多个数据的容器。

一、声明

//语法

dataType[] arrayRefVar; // 首选的方法

或

dataType arrayRefVar[]; // 效果相同,但不是首选方法//示例

double[] myList; // 首选的方法

或

double myList[]; // 效果相同&…

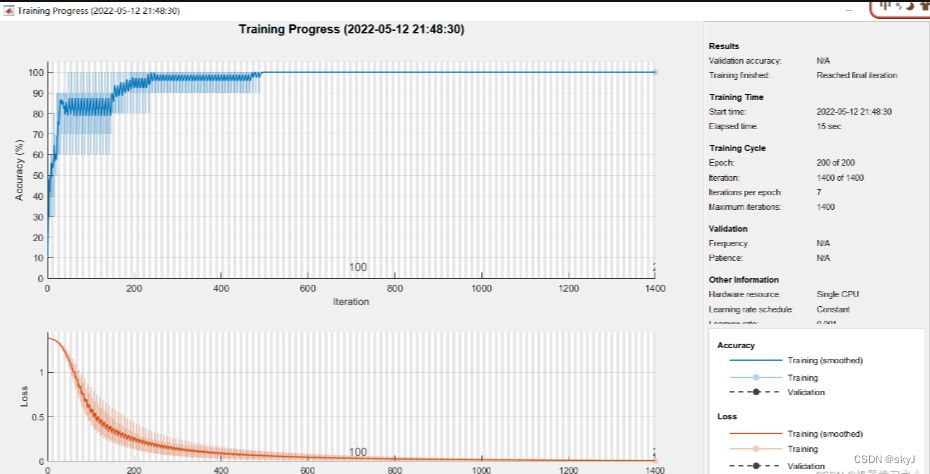

分类预测 | MATLAB实现LSTM(长短期记忆神经网络)分类预测

分类效果 基本介绍

长短期记忆网络Q通常被称为LSTM,是一种特殊的RNN,能够学习长期依赖性。由Hochreiter和Schmidhuber(1997)提出的,并且在接下来的工作中被许多人改进和推广。 LSTM在各种各样的问题上表现非常出色,现在被广泛使用。LSTM被明确设计用来避免长期依赖性问…

vue3基础+进阶(一、Vue3项目创建并相比vue2熟悉项目结构)

目录

第一章、认识create-vue

1.1 简介

1.2 使用create-vue创建项目

1.2.1 创建步骤以及注意事项

1.2.2 注意事项

1.2.3 熟悉项目,与vue2区分 第一章、认识create-vue

1.1 简介

create-vue是Vue官网新的脚手架工具,底层切换到了vite(下一代前端工…

苍穹外卖-【day03】-【公共字段自动填充】-【新增】-【分页】-【删除】-【修改】

苍穹外卖-day03

课程内容

公共字段自动填充新增菜品菜品分页查询删除菜品修改菜品

**功能实现:**菜品管理

菜品管理效果图: 1. 公共字段自动填充

1.1 问题分析

在上一章节我们已经完成了后台系统的员工管理功能和菜品分类功能的开发,在…

SeLa:Self Labeling Via Simultaneous Clustering and Representation Learning

方法论

有监督的分类任务实现

给定一个将数据I映射至特征向量 x ∈ R D x ∈ R^D x∈RD 的深度神经网络 Φ Φ Φ ,即 x Φ ( I ) x Φ ( I ) xΦ(I)。使用有N个样本 I 1 , … , I N I_1 , … , I_N I1,…,IN, 且具有标签 y 1 , … , y N ∈ { 1 , … , K }…

线性DP———最长公共子序列问题(LCS)

LCS问题 求两序列具有相同元素的最长子序列,我们可以用到动态规划的方法来解决问题 我们用 来表示序列 与序列 能组成的LCS的长度,的状态转移方程如下: 使用两层for循环就可以解决此问题,时间复杂度为,可以处理n<7000左右…

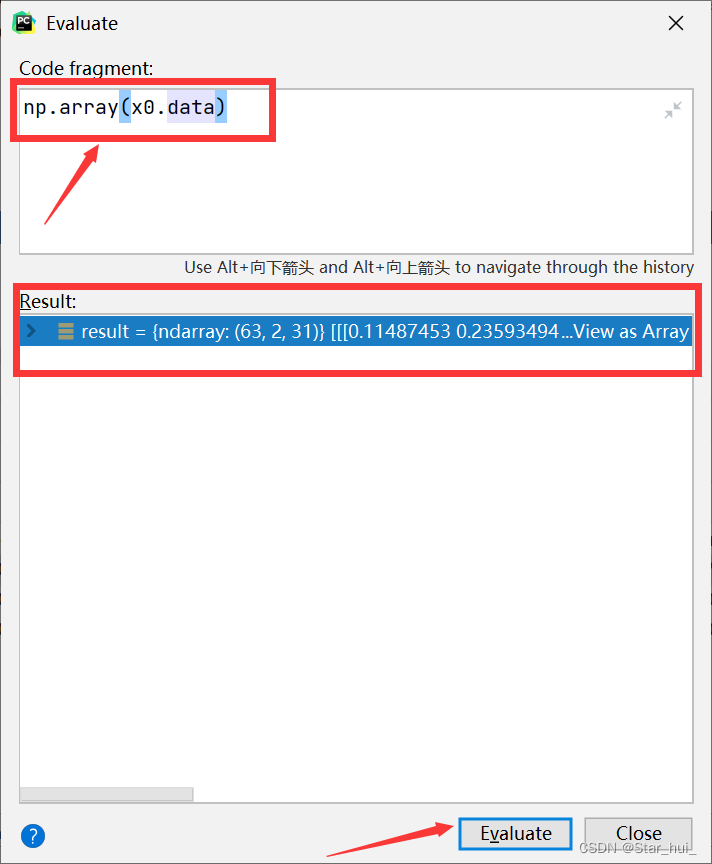

pycharm里debug时torch数组显示不全

pycharm里查看torch数组全部值 一、在Pycharm运行torch数组时,通常只能看到数组的一部分二、解决办法1、debug后,鼠标右键想要查看完整的数组,选择Evaluate Expression2、输入np.array(x0.data),x0为想要查看的数组名,…

C#中的抽象类(abstract)

C#中的抽象类(abstract)。 1:抽象方法只作声明,而不包含实现,可以看成是没有实现体的虚方法 2:抽象类不能被实例化 3:抽象类可以但不是必须有抽象属性和抽象方法,但是一旦有了抽象方…