目录

- 前言

- 1. Runtime API概述

- 总结

前言

杜老师推出的 tensorRT从零起步高性能部署 课程,之前有看过一遍,但是没有做笔记,很多东西也忘了。这次重新撸一遍,顺便记记笔记。

本次课程学习精简 CUDA 教程-Runtime API 概述

课程大纲可看下面的思维导图

1. Runtime API概述

对于 Runtime API 你需要知道:

- 对于 runtime API,与 driver 最大区别是懒加载

- 即,第一个 runtime API 调用时,会进行 cuInit 初始化,避免驱动 api 的初始化窘境

- 即,第一个需要 context 的 API 调用时,会进行 context 关联并创建 context 和设置当前 context,调用 cuDevicePrimaryCtxRetain 实现

- 绝大部分 api 需要 context,例如查询当前显卡名称、参数、内存分配、释放等

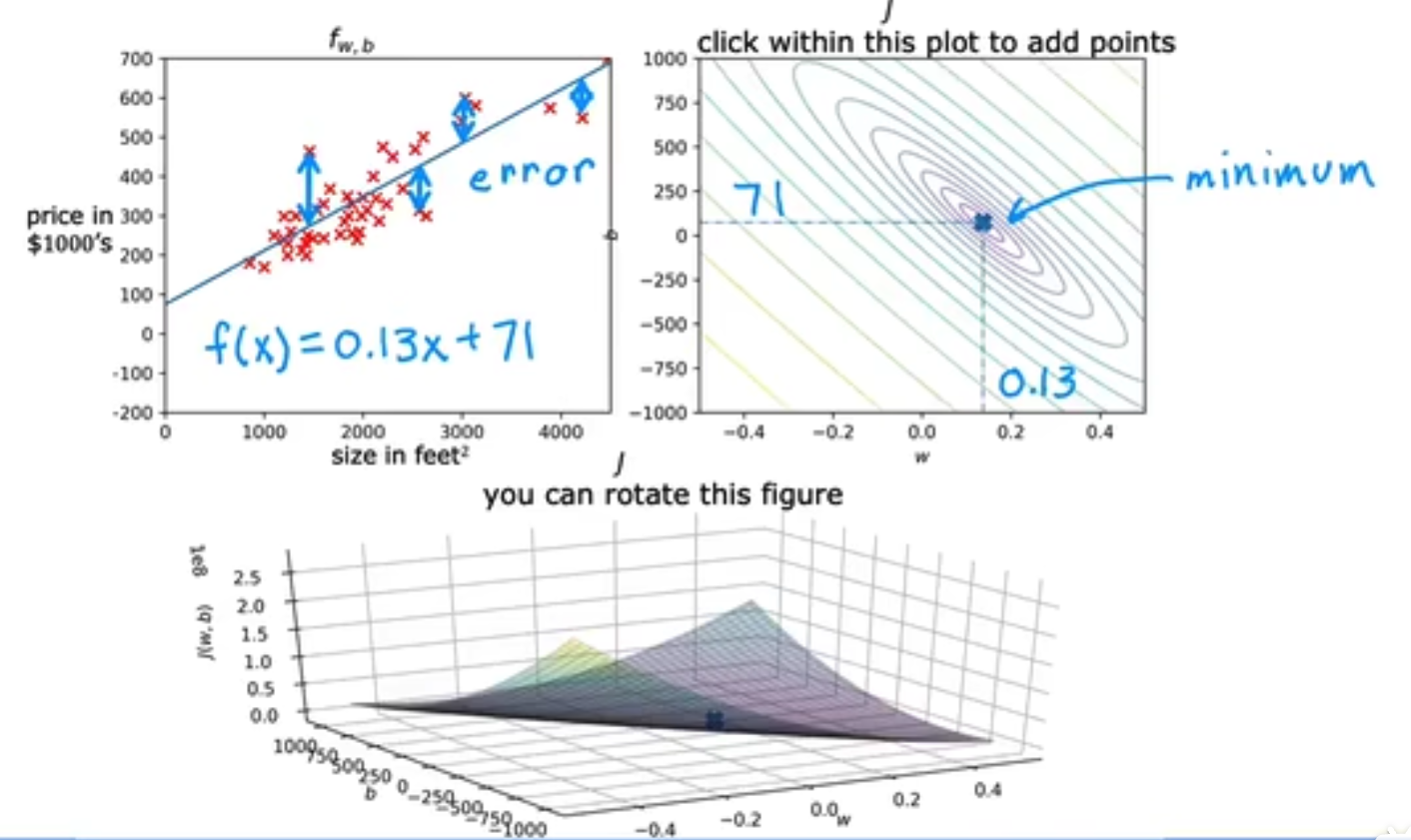

Runtime API 所处位置如下图所示

对于 Runtime API 你还需要知道:

- CUDA Runtime 是封装了 CUDA Driver 的高级别更友好的 API

- 使用 cuDevicePrimaryCtxRetain 为每个设备设置 context,不再手工管理 context,并且不提供直接管理 context 的 API(可 Driver API 管理,通常不需要)

- 可以更友好的执行核函数,.cpp 可以与 .cu 文件无缝对接

- 对应 cuda_runtime.h 和 libcudart.so

- runtime api 随 cuda toolkit 发布

- 主要知识点是核函数的使用、线程束布局、内存模型、流的使用

- 主要实现归纳求和、仿射变换、矩阵乘法、模型后处理,就可以解决绝大部分问题

总结

本次课程是关于 Runtime API 的概述,它是 Driver API 更高级的封装,可自动管理 context 的创建,对于 Runtime API 我们需要知道核函数、线程束、内存模型以及流的使用。而案例方面需要掌握仿射变换、模型预处理、模型后处理部分。

内存模型以及流的使用。而案例方面需要掌握仿射变换、模型预处理、模型后处理部分。

![[已解决]Springboot项目启动时端口被占用](https://img-blog.csdnimg.cn/c7e90a70dfff48fabd1871be5b602ac2.png)