目录

1、安装yolov8的虚拟环境

(1)创建虚拟环境

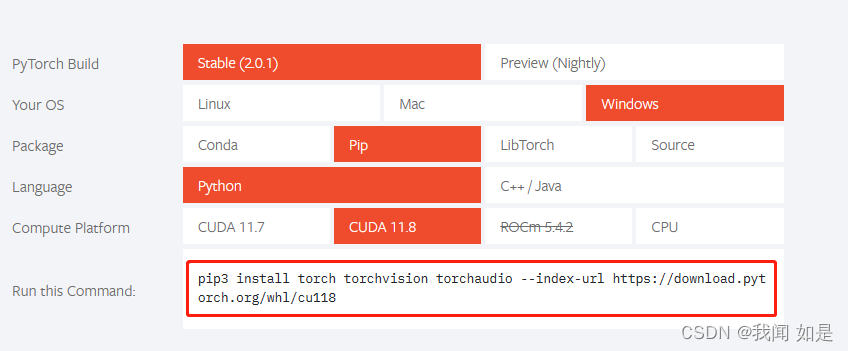

(2)安装pytorch

编辑

2、下载yolov8模型

3、解压缩,解压后的文件

4、将转换数据集(以口罩检测为准)

5、配置和执行

6、验证

7、测试

1、安装yolov8的虚拟环境

安装的过程可以参照参考资料【3】的视频。

步骤如下:

(1)创建虚拟环境

名字就定为yolov8,输入命令:

conda create -n yolov8 python=3.8 anaconda(2)安装pytorch

打开pytorch官网:pytorch官网

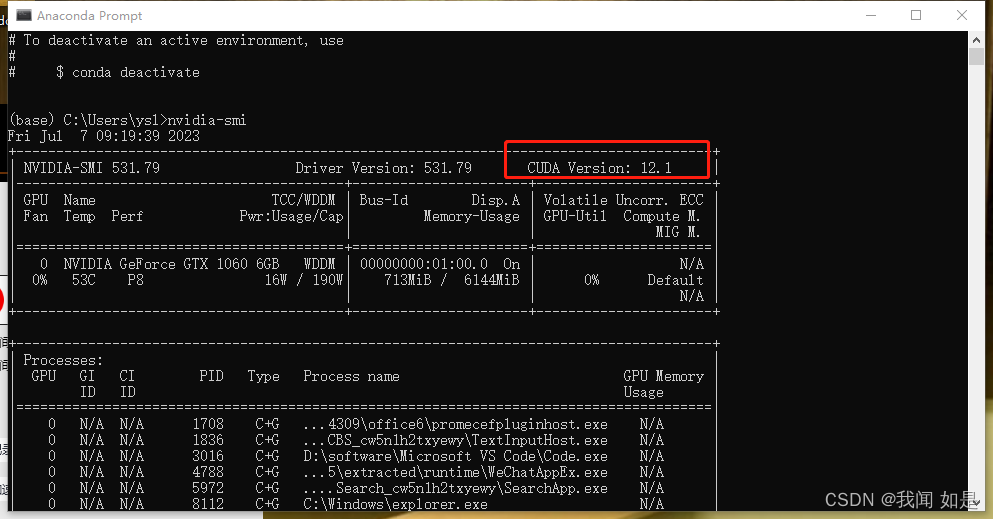

检查电脑cuda版本,命令:

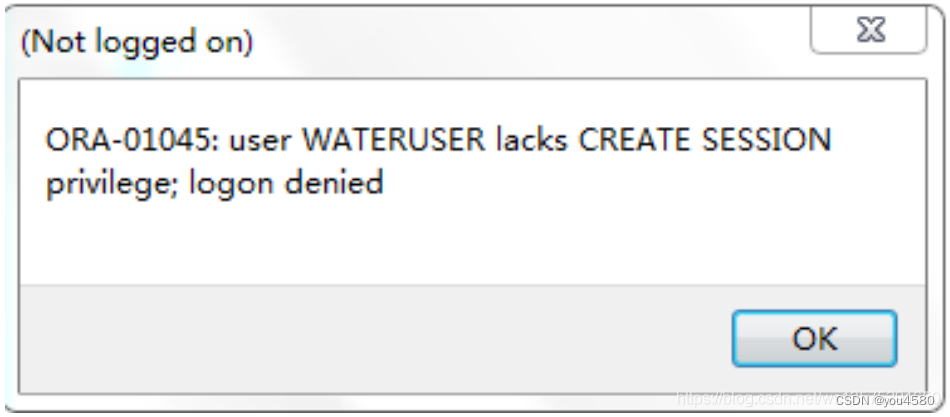

nvidia-smi我的cuda版本是12.1.pytorch中选择pip安装,运行下图框中的命令执行。

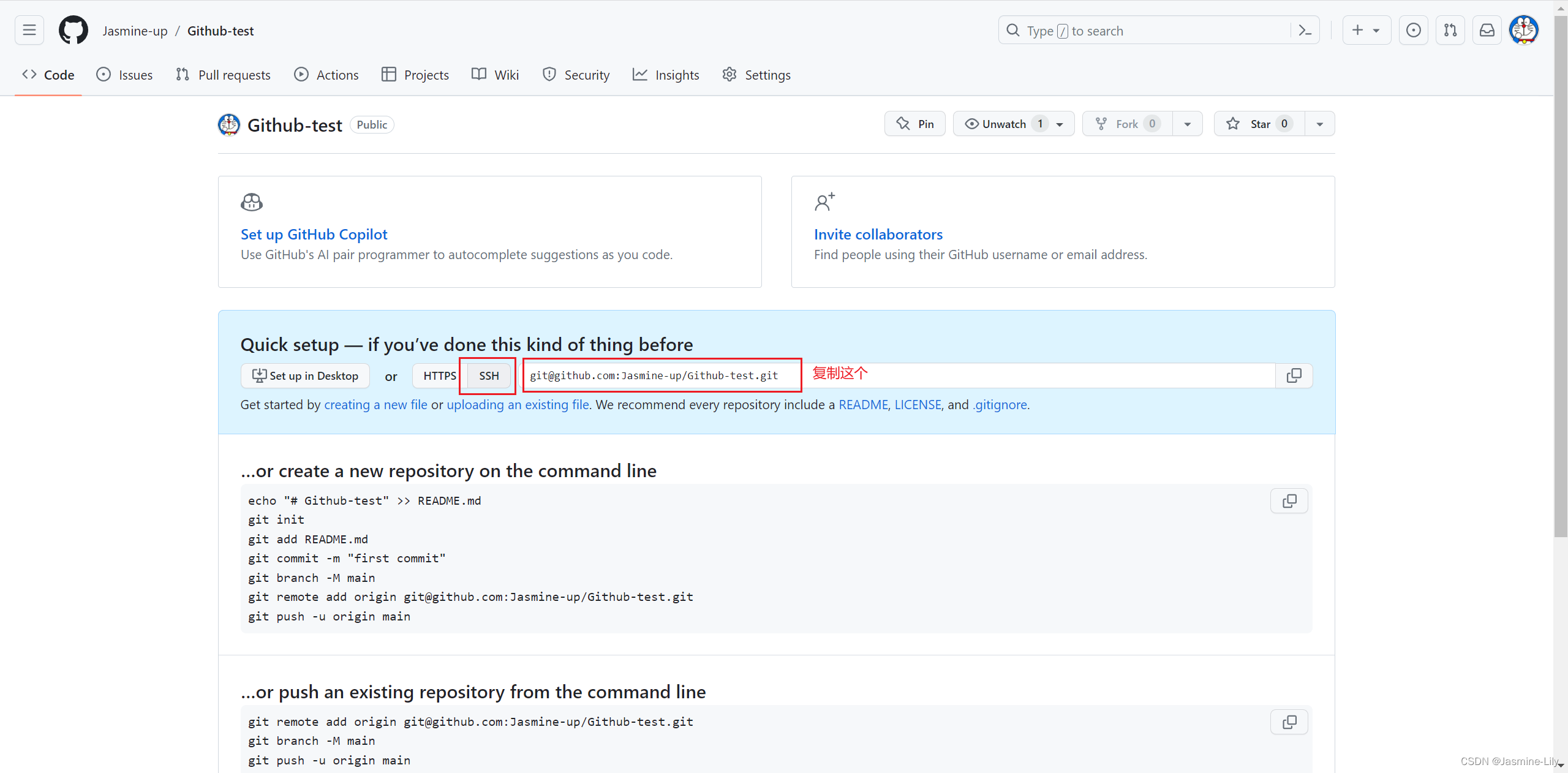

2、下载yolov8模型

下载地址:yolov8

3、解压缩,解压后的文件

用vscode打开

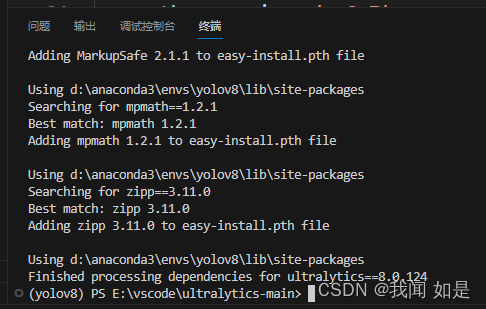

里面是一个安装文件。切换到yolov8的虚拟环境,然后执行安装,安装需要使用命令:

python setup.py install很快就会完成安装。

4、将转换数据集(以口罩检测为准)

转换程序地址:数据转换程序

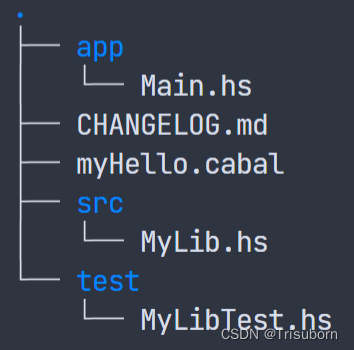

解压后的文件,里面有很多模块。数据转换在yolo文件夹下。

选择yolo文件夹,里面只有三个文件,将这三个文件复制到yolov8的目录下。

数据集:网上找的口罩数据集

数据处理比较简单,看B站视频就可以。

数据处理步骤:

(1)将图片复制到dataset\VOCdevkit\JPEGImages文件夹下

(2)将标签复制到dataset\VOCdevkit\Annotations文件夹下。

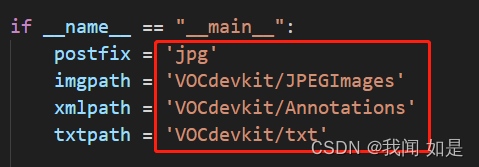

(3)找到xml2txt.py程序,修改下面的几项就可以了。

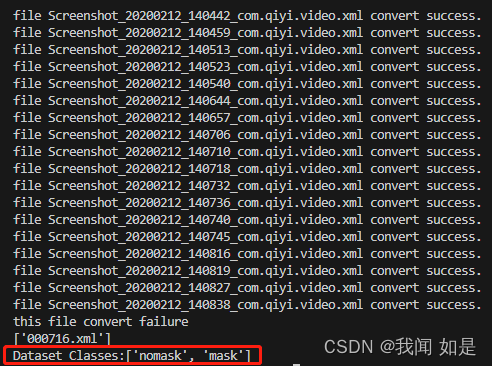

完成后会显示分类

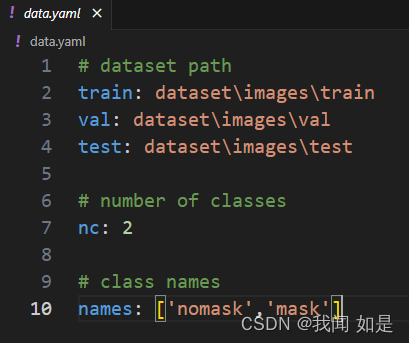

将这两个classes填写好data.yaml里面。

(4)执行split_data.py。

(5)打开data.yaml修改

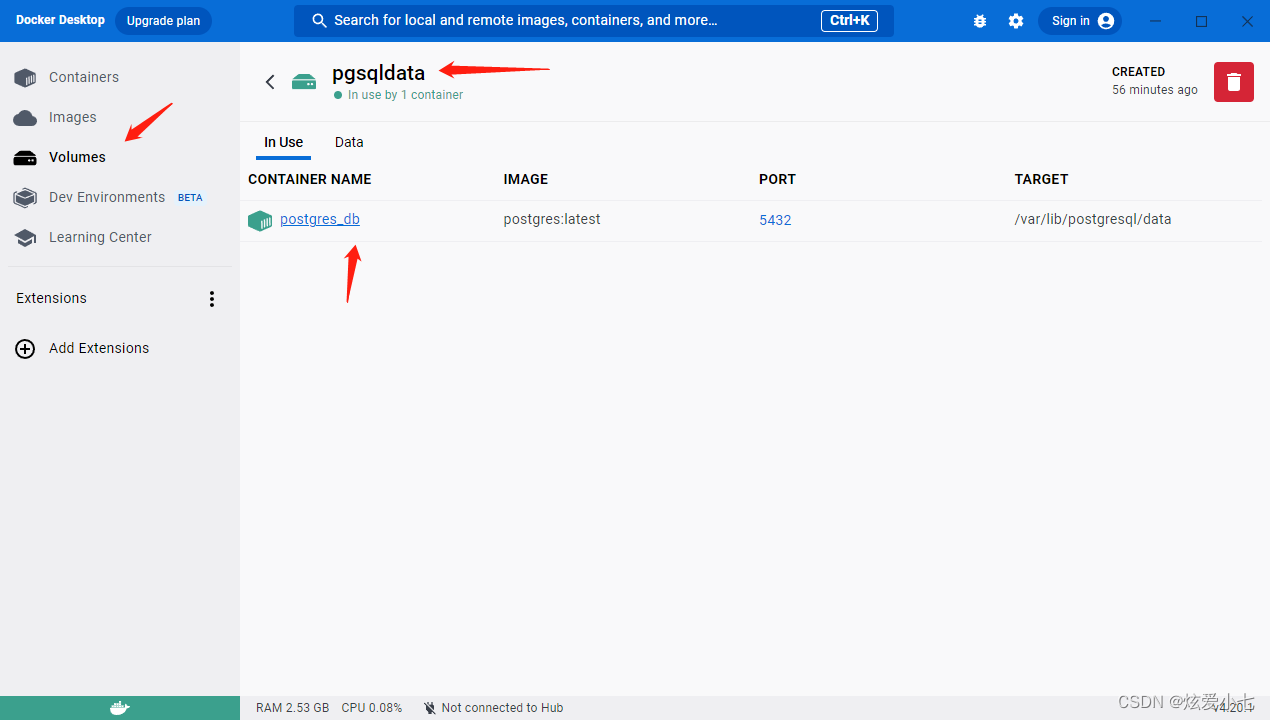

5、配置和执行

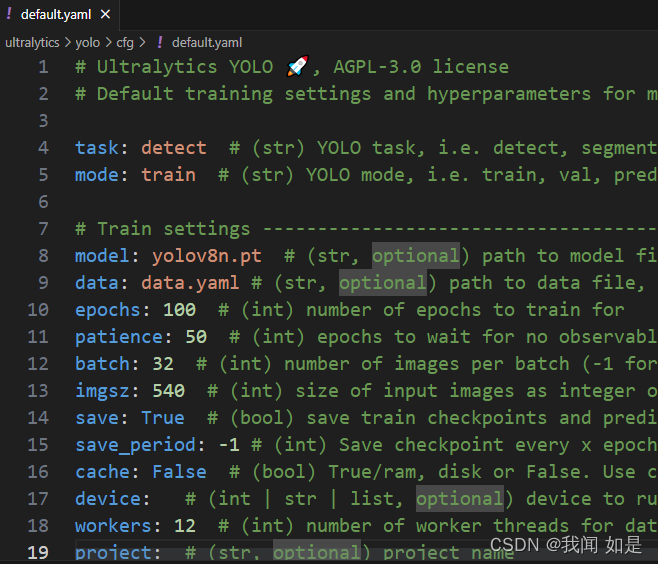

配置default.yaml文件,根据需要进行配置。

命令:

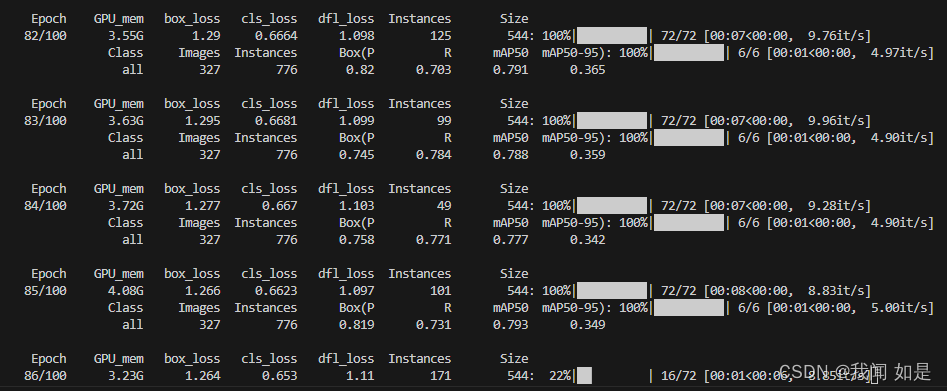

yolo cfg=ultralytics\yolo\cfg\default.yaml开始训练

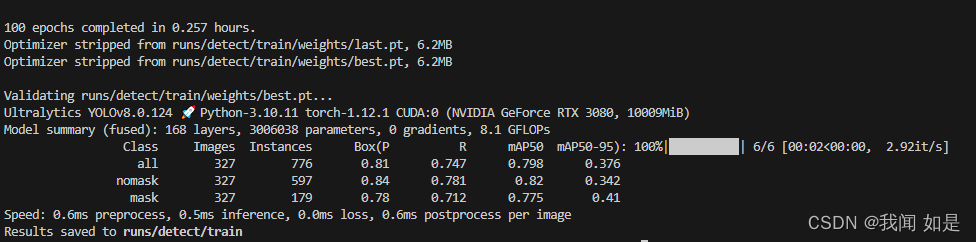

训练完成

6、验证

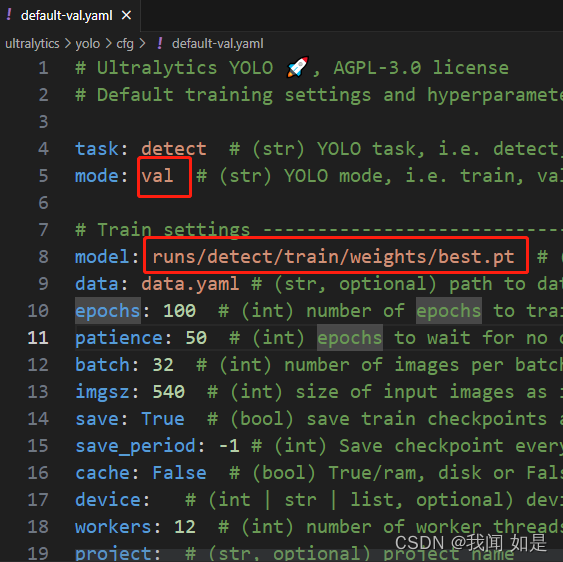

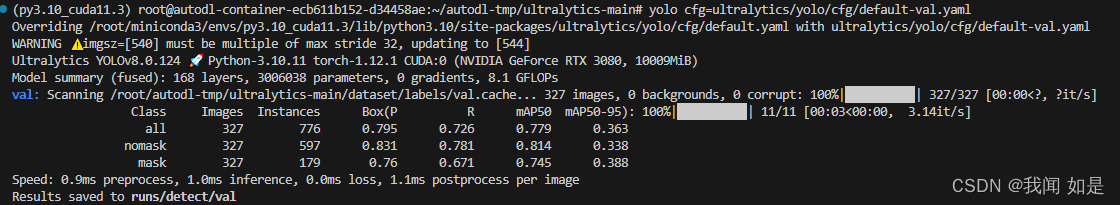

验证的时候需要重新配置default.yaml

model,使用train训练以后生成的pt文件。我用的是best.pt。

yolo cfg=路径

7、测试

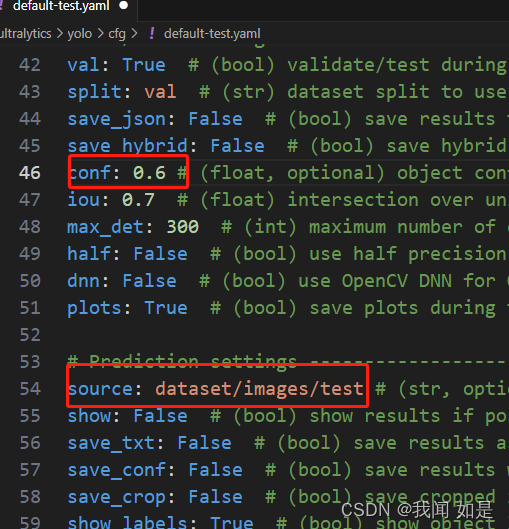

修改配置

conf默认为0.25,改为0.6测试。source修改为保存test图片的路径。

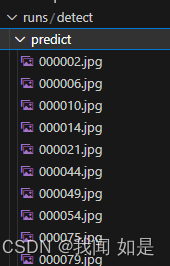

运行,命令和train和val一样。

运行后的结果都保存在runs下面。

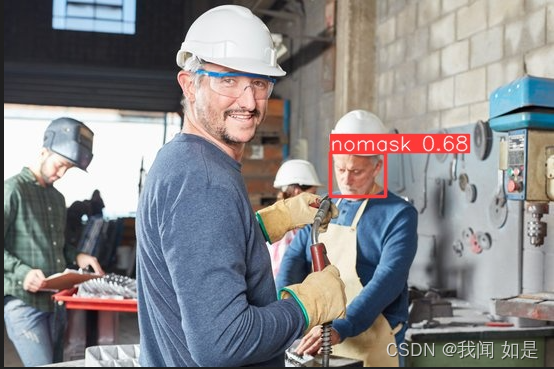

效果图:

有的还是没检测出来。

参考资料:

【1】参考的博客:YOLOV8最强操作教程._魔鬼面具的博客-CSDN博客

【2】对应的视频:YOLOV8保姆级教学视频._哔哩哔哩_bilibili

【3】yolo环境安装:安装yolo环境

![[已解决]Springboot项目启动时端口被占用](https://img-blog.csdnimg.cn/c7e90a70dfff48fabd1871be5b602ac2.png)

![[SSM]MyBatis查询语句与动态SQL](https://img-blog.csdnimg.cn/91652b2aa0fb4541a9ba0e98f9abfaba.png)