采用宽卷积的好处有什么

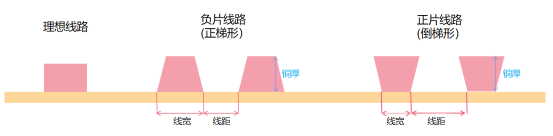

窄卷积和宽卷积

对于窄卷积来说,是从第一个点开始做卷积,每次窗口滑动固定步幅。比如下图左部分为窄卷积。那么注意到越在边缘的位置被卷积的次数越少。于是有了宽卷积的方法,可以看作在卷积之前在边缘用 0

补充,常见有两种情况,一个是全补充,入下图右部分,这样输出大于输入的维度。另一种常用的方法是补充一部 0

值,使得输出和输入的维度一致。这里文中给了一个公式 。npadding

在全补充里是

filter-1

,在输入输出相等时,就要主要奇偶性了,注意到卷积核常为奇数。

为什么采用宽卷积

通过将输入边角的值纳入到滑窗中心进行计算,以便损失更少的信息。

卷积层输出的深度与哪个部件的个数相同

输出深度(通道)与卷积核(过滤器)的个数相等。

激活函数通常放在卷积神经网络的那个操作之后

通常放在卷积层之后。

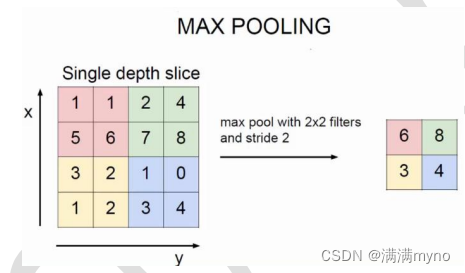

如何理解最大池化层有几分缩小

池化层:对输入的特征图进行压缩,一方面使特征图变小,简化网络计算复杂度;一方面

进行特征压缩,提取主要特征。

池化操作一般有两种,一种是

Avy Pooling,

一种是

max Pooling

注 1:(Avy pooling 现在不怎么用了,方法是对每一个 2*2 的区域元素求和,再除以 4,得到主要特征),而一般的 filter 取 2*2,最大取 3*3,stride 取 2,压缩为原来的 1/4.

注 2:这里的 pooling 操作是特征图缩小,有可能影响网络的准确度,因此可以通过增加特征图的深度来弥补。