声明:以下文章链接仅用于个人学习与备忘。

基础知识

1:零基础解析教程 [推荐]

https://zhuanlan.zhihu.com/p/609271490

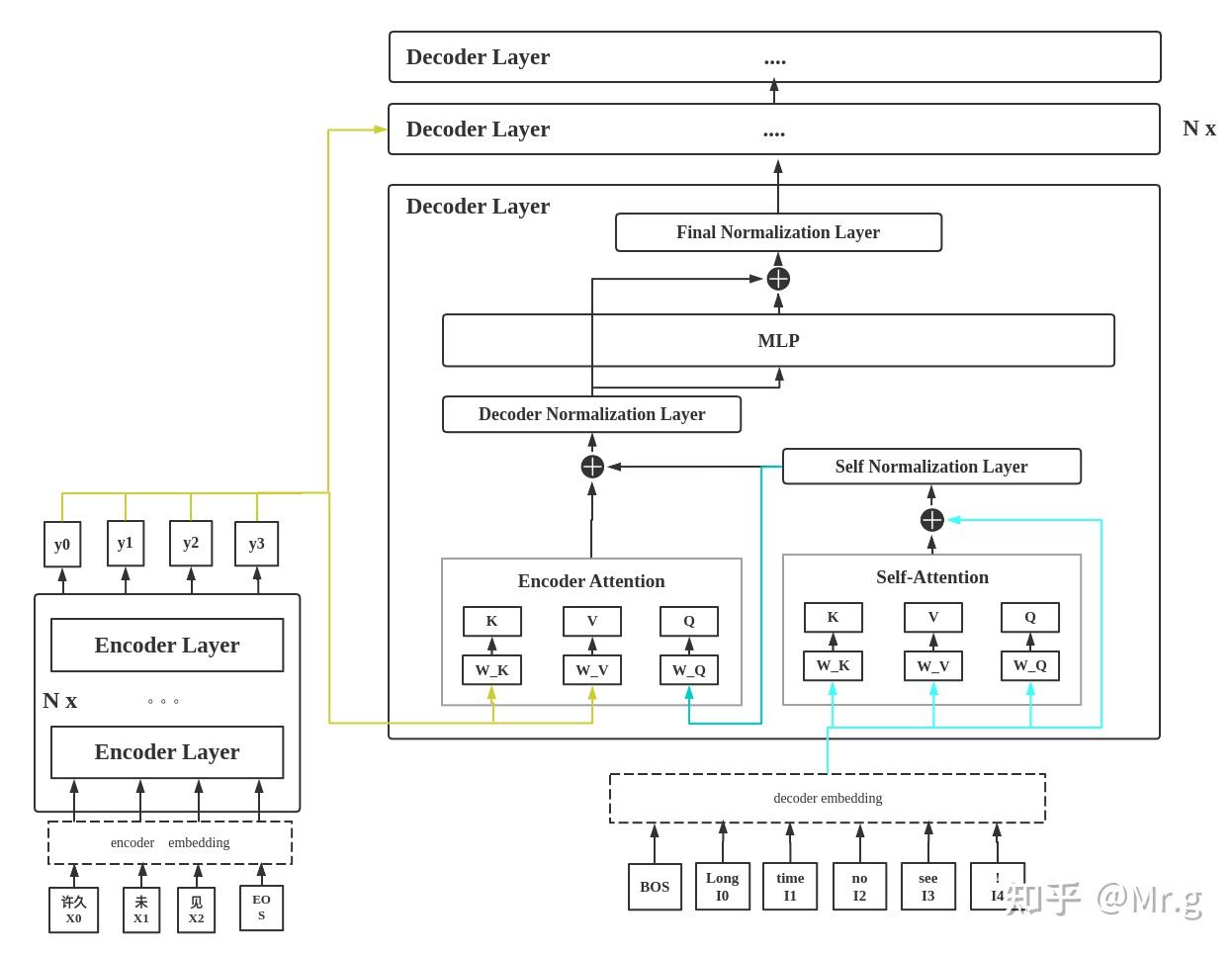

2:Transformer 详解 [推荐]

https://wmathor.com/index.php/archives/1438/

3:如何从浅入深理解transformer?

https://www.zhihu.com/question/471328838/answer/3011638037

4:Transformer模型详解(图解最完整版)[推荐]

Transformer模型详解(图解最完整版) - 知乎

5:万字长文解读Transformer模型和Attention机制 [推荐]

【经典精读】万字长文解读Transformer模型和Attention机制 - 知乎

疑惑解析

1:transformer decoder里的K和V为什么要用encoder输出的K和V?

https://www.zhihu.com/question/458687952

2: Teacher Forcing 、 Autoregressive、Exposure Bias 解释

关于Teacher Forcing 和Exposure Bias的碎碎念 - 知乎

3: decoder部分训练是怎么并行化的?

浅析Transformer训练时并行问题 - 知乎

浅析Transformer训练时并行问题_transformer并行化体现在哪里_思考实践的博客-CSDN博客

Transformer decoder中masked attention的理解_寺里LZS的博客-CSDN博客

4:在测试或者预测时,Transformer里decoder为什么还需要seq mask?

在测试或者预测时,Transformer里decoder为什么还需要seq mask? - 知乎

深入理解transformer源码_赵队的博客-CSDN博客