前言

人工智能生成内容(Artificial Intelligence Generated Content,简称 AIGC)是当下最火的概念之一。AIGC 被认为是继专业生成内容(Professional Generated Content, PGC)和用户生成内容(User Generated Content, UGC)之后,利用人工智能技术自动生成内容的新型生产方式。

AI 生成内容的形式相当丰富,除了文字外,还可以进行绘画、作曲、演唱、编剧、设计等。最近热度非常高的 Text to Image 就是 AI 加持下非常时髦的一种图片创造方式。看看下面这些图片,你一定很难想象它们都是 AI 生成的吧。

许多人可能觉得,使用 AIGC 有很高的门槛,普通人是很难入门的。其实不然,随着 AI 技术的快速发展以及众多开源项目的诞生,我们每个人都可以很轻松且廉价的使用到 AIGC。谁能想到,在 2018 年,人工智能生成的画作在佳士得拍卖价还高达 43.25 万美元,而时隔才数年,让 AI 为我们创作绘画已经成了人人触手可及的事情。

许多人可能觉得,使用 AIGC 有很高的门槛,普通人是很难入门的。其实不然,随着 AI 技术的快速发展以及众多开源项目的诞生,我们每个人都可以很轻松且廉价的使用到 AIGC。谁能想到,在 2018 年,人工智能生成的画作在佳士得拍卖价还高达 43.25 万美元,而时隔才数年,让 AI 为我们创作绘画已经成了人人触手可及的事情。

在这些开源项目中,Stable Diffusion 无疑是优秀生之一。Stable Diffusion 是一种扩散模型(Diffusion Model)的变体,称为“潜在扩散模型”(Latent Diffusion Model),由CompVis、Stability AI 和 LAION 的研究人员和工程师创建。它使用来自 LAION-5B 数据库子集的图像进行训练。使用这个模型,可以生成包括人脸在内的任何图像,因为有开源的预训练模型,所以我们也可以在自己的机器上运行它。Stable Diffusion 能够根据我们提供的一些提示词以及可以调整的部分参数,通过模型计算生成一张不错的图片。

我整理了一份 Stable Diffusion 的上手教程,分享给大家。这其中包括了 Stable Diffusion 的安装和基本使用方法,以及使用 Lora 模型调整图片生成的风格。这是一项接近零基础的教程,其中并不会包含复杂的概念或者深奥的算法。换句话说,只要你稍有计算机基础,了解如何敲入命令,知道怎么使用浏览器打开网页,你就能很轻松的学会。

搭建运行环境

环境配置

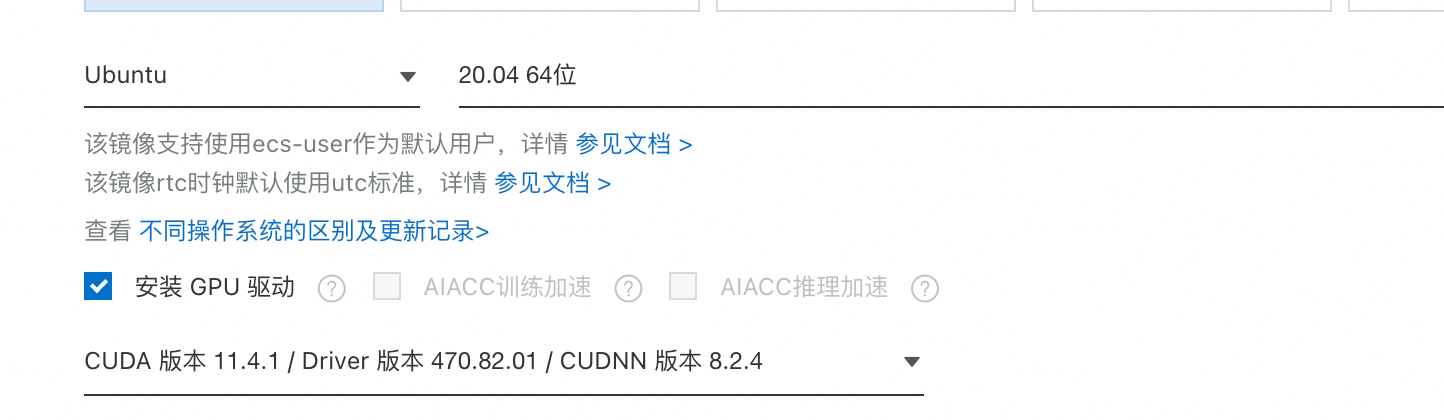

硬件环境

- Windows、Linux、MacOS操作系统均可

- 最好有GPU显卡,显存越高越好,否则生图效率很低

软件环境

- Python 3.10.6 版本,建议使用Anaconda管理python的env,多版本一键切换,非常方便

- Git,版本控制必备

本地部署SD

克隆SD WebUI源码

命令行进入工作目录,执行以下命令克隆SD WebUI源码

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git执行启动文件

如果是Windows系统,执行webui-user.bat,若执行过程报错,按照错误提示配置webui-user.bat文件中的COMMANDLINE_ARGS参数即可。

如果是Mac系统,需要先从这里下载模型(可选择Stable Diffusion 1.5 (v1-5-pruned-emaonly.ckpt)模型)到目录stable-diffusion-webui/models/Stable-diffusion下,然后命令行cd到项目目录后,执行./webui.sh命令。

如果是Linux系统,可以参考这里。

执行之后,脚本会安装一些依赖库,可能需要等待一段时间。

最终安装完成之后,命令行会弹出这句话,即表示服务已经启动成功。

Running on local URL: http://127.0.0.1:7860此时浏览器打开http://127.0.0.1:7860 即可看到SD WebUI的界面。

生成第一张图

在默认的txt2img这个tab下的Prompt种输入cute cat,然后点击右侧的Generate按钮就开始生成了,等待一段时间(几秒到几分钟不等,取决于机器性能)后便能看到生成的画面。至此,便已经完成运行环境搭建的步骤了。

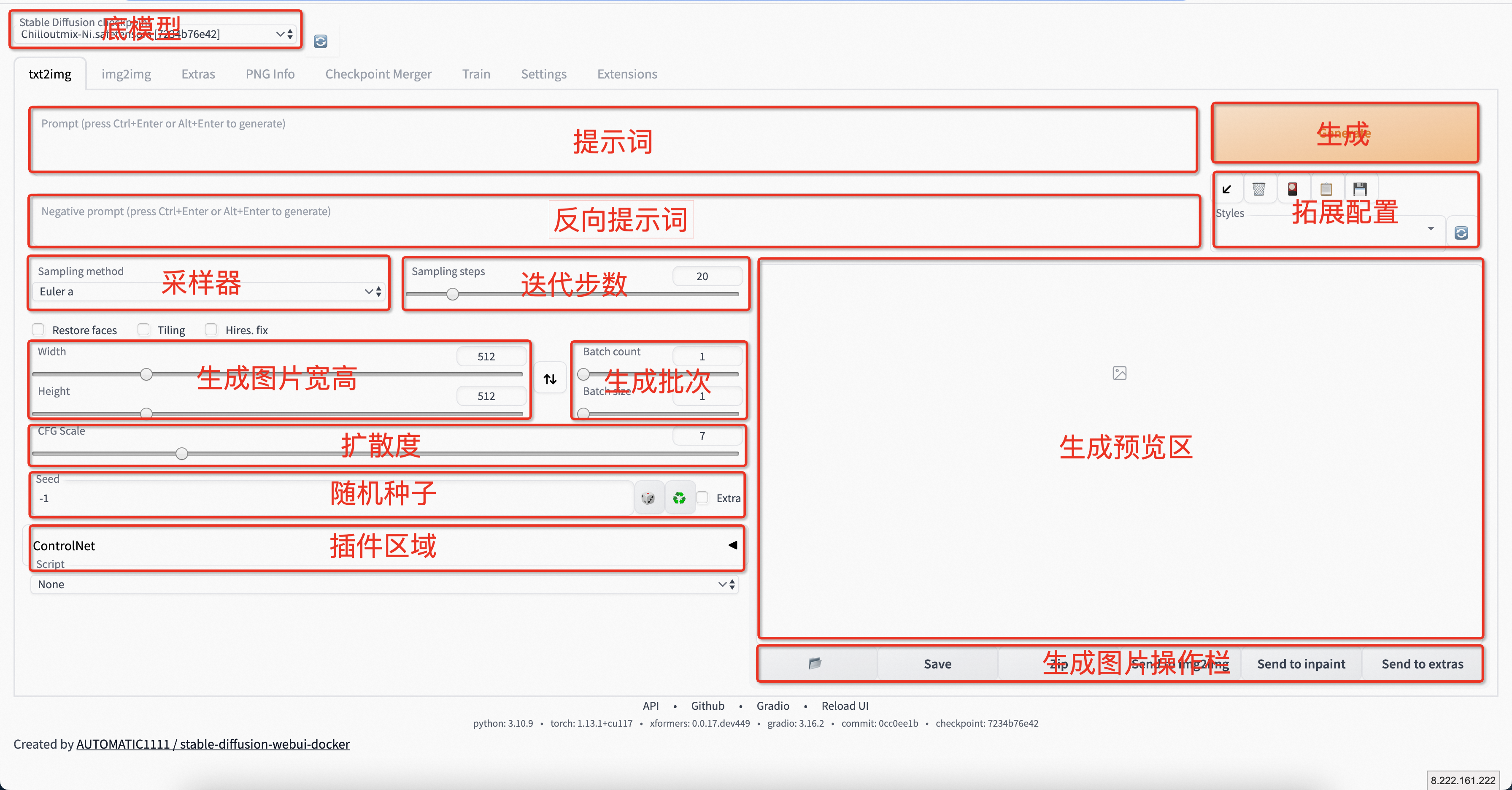

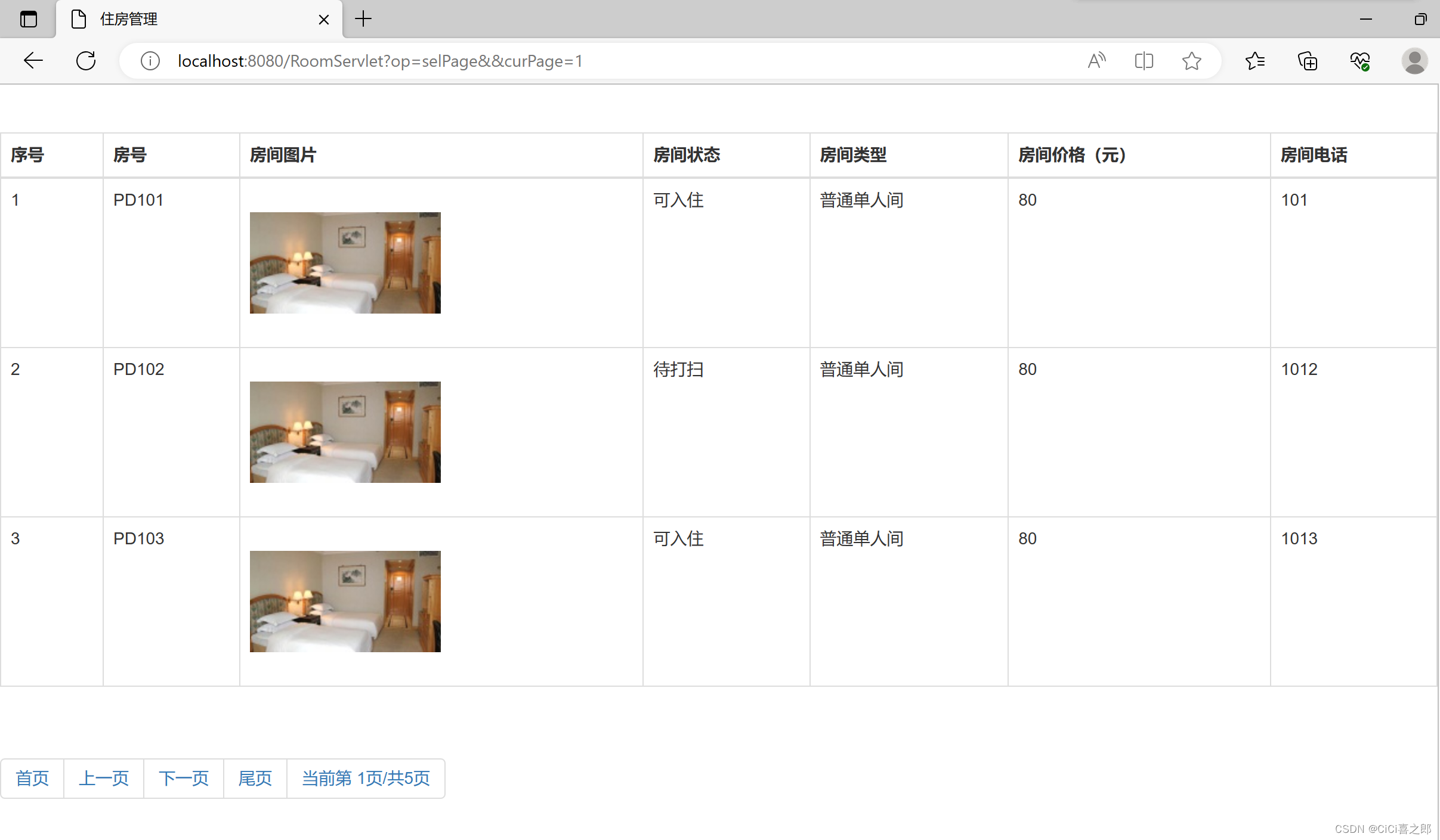

主页布局简介

主页面包含以下内容,我对关键部分已经做了标记处理,如下。