目录

- 智能网联环境下面向语义通信的网络架构

- 模型驱动和数据驱动

- 资源分配算法对比

- 计算卸载和协同计算

- 未来研究方向

- 参考文献

智能网联环境下面向语义通信的网络架构

车辆借助车联网将基于语义理解的计算任务进一步卸载到计算资源丰富的移动边缘计算服务器(通常部署在路边单元RSU侧)或者远端云服务器进行协同计算,以支持智能网联环境下多种不同业务的需求。

针对时延敏感类的安全业务(如轨迹预测和目标检测等),通常采用边缘计算服务器和车辆协同计算(即端边协同计算),对采集的数据(文本、图像、视频等)进行实时理解和决策;

针对非实时需求的信息类和交通效率类业务(如路径优化和交通分析等),车辆和边缘计算服务器的数据可进一步汇聚到远端的云服务器上,进行更密集型计算(即边云协同计算),实现大数据分析挖掘以及算法模型的训练和升级

模型驱动和数据驱动

个人感觉,模型驱动就是基于数学模型;数据驱动就是基于网络;

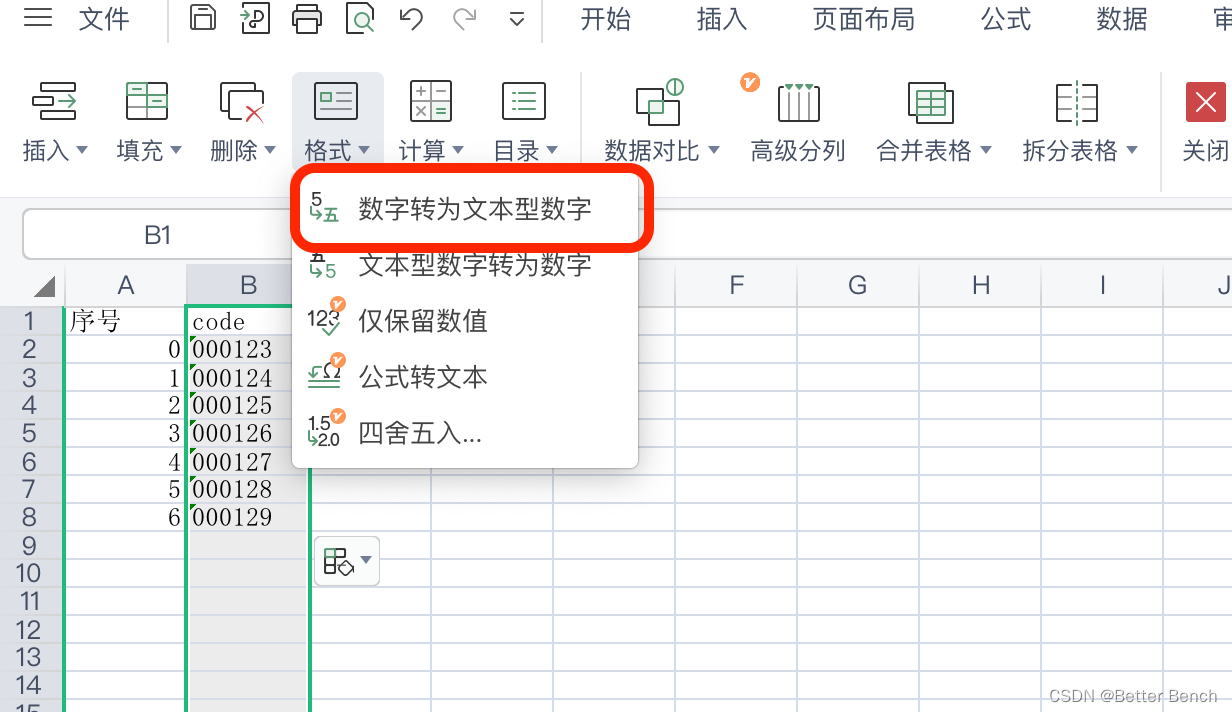

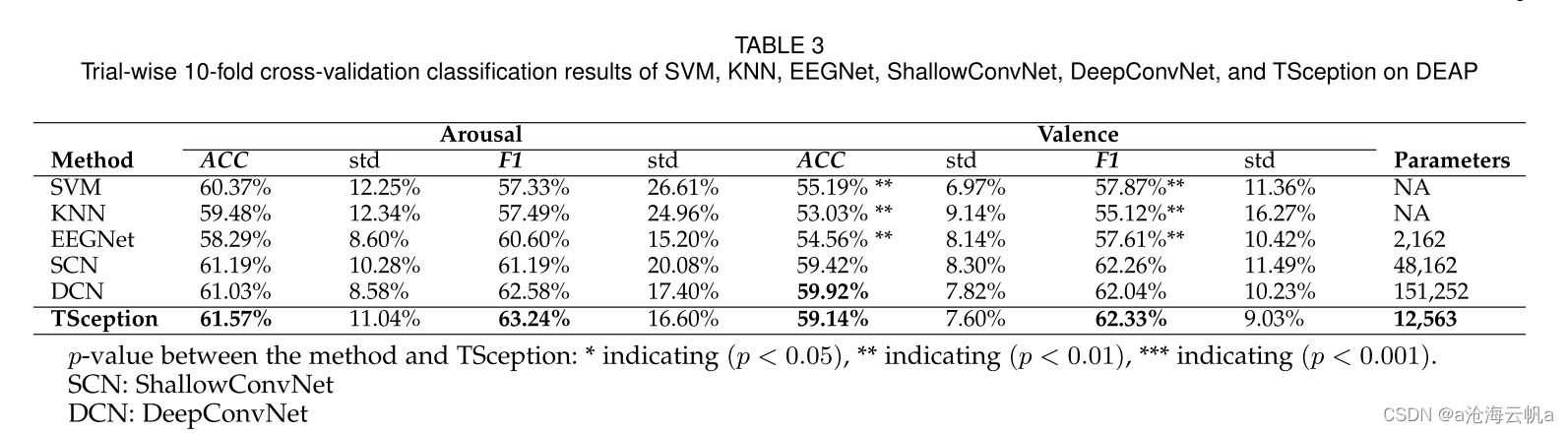

资源分配算法对比

计算卸载和协同计算

传统方式将 DNN 的训练和推理任务直接部署在车辆或者将其加载至远端云服务器执行,但这两种方式性能较差(即端到端时延),难以实时地支持智能网联场景具有严格时延和超可靠要求的安全驾驶业务。

目前有两种解决方案:

①计算卸载

结合新兴的边缘计算技术,充分运用从云端下沉到网络边缘(如路边单元、蜂窝网络基站或Wi-Fi接入点等)端的计算能力,从而在具有适当计算能力的边缘计算设备(也称为边缘计算服务器)上实现边缘计算设备覆盖范围内低时延与高可靠的深度学习模型训练和推理,车辆只负责采集数据并进行简单预处理。DNN模型的训练和推理主要在边缘计算服务器上实现。

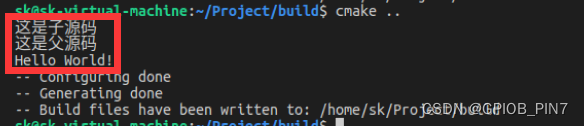

②协同计算 可能相关与我的研究

车辆承担了本地模型训练或部分推理任务,不再需要上传完整的数据,而是将本地训练的 DNN 模型参数或推理模型中间参数上传至服务器。

协同计算的可行性得益于DNN模型分割技术[1]。DNN是由多层神经网络相互叠加而成的,不同网络层的计算资源需求以及输出数据量(由模型每层输出的中间参数的大小决定,直接决定带宽需求量)都具有显著的差异性。为减小整个模型的计算时延,同时最小化通信带宽资源需求,需要寻找合适的模型切分点,尽量将计算量小的工作留在车辆,然后在通信量最少的地方进行切割,将中间结果传输至服务器执行复杂的计算任务,实现计算量和通信量之间的权衡。

见博客 面向智简通信的语义模型分组技术(私密)

未来研究方向

1)语义信息的价值评估:

针对接收端而言,不是所有的语义信息对完成智能任务都是有益的或必需的,如何评估语义的价值或重要程度是未来需要解决的问题。

2)面向语义通信的虚拟资源管理与编排:

在下一代网络中,除了通信、计算以及缓存资源,还存在网络切片等虚拟资源,如何对这些资源进行管理与编排也是智能网联场景需要解决的问题。

3)面向语义通信系统需求差异化的资源分配:

实际中存在用户需求差异以及业务差异等情况,如部分用户需要完成时延敏感型业务,另外的用户需要完成密集计算型业务,针对差异化的需求如何优化资源分配是语义通信中所面临的挑战。

参考文献

[1] Edge AI: on-demand accelerating deep neural network inference via edge computing