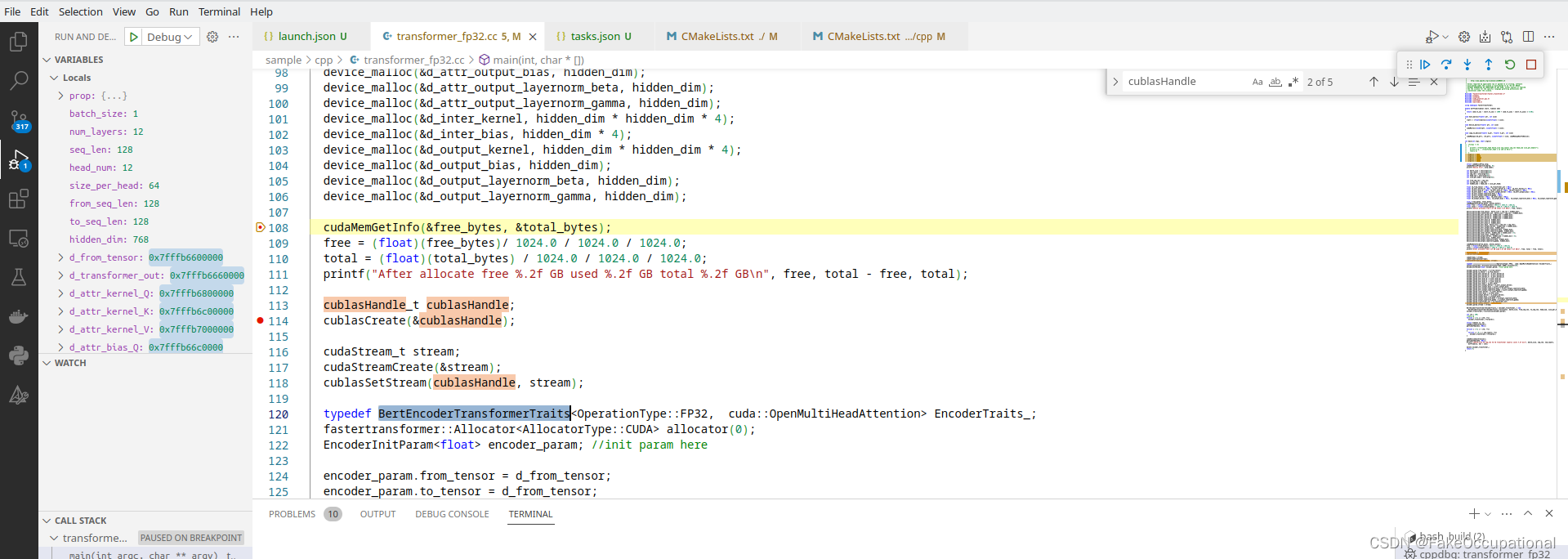

本文主要记录TensorRT8.6的环境配置过程!

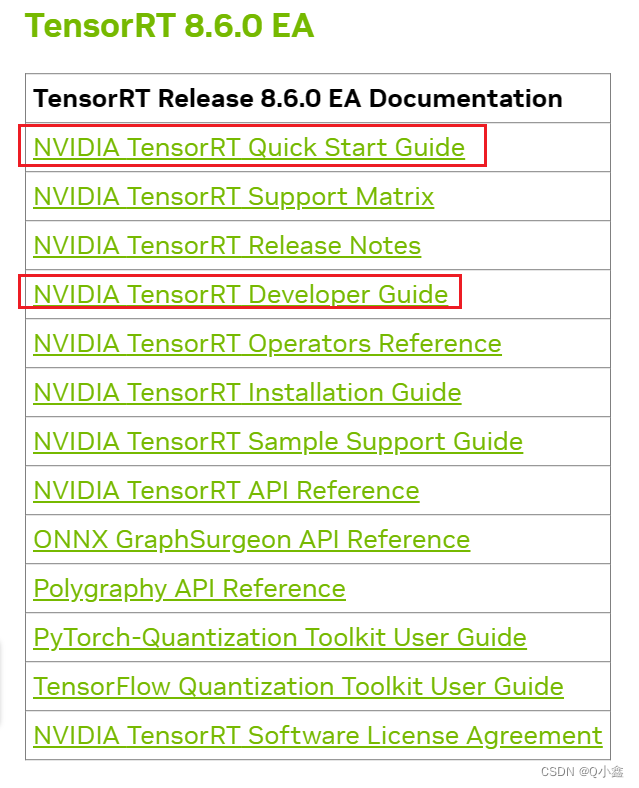

官方文档:NVIDIA TensorRT - NVIDIA Docs

TensorRT相关版本的文档: Documentation Archives :: NVIDIA Deep Learning TensorRT Documentation

一 、下载CUDA和cudann

CUDA下载:CUDA Toolkit Archive | NVIDIA Developer

CUDA安装:(我使用的是CUDA 11.0)

百度网盘(CUDA 11.0):

链接:https://pan.baidu.com/s/1ZpPkNRDtcbQURIEgpF7t5Q

提取码:dn6q

1、(Window版本)安装

① CUDA安装与测试

双击下载的exe文件即可

一路默认安装即可,最后测试一下:

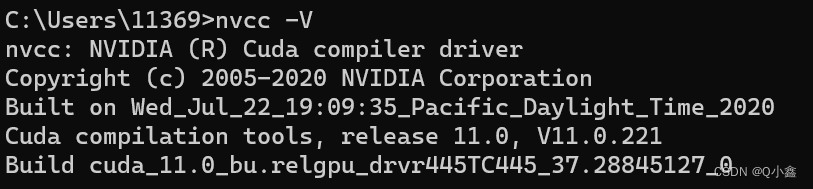

nvcc -V

这样CUDA 11.0就安装完成啦!

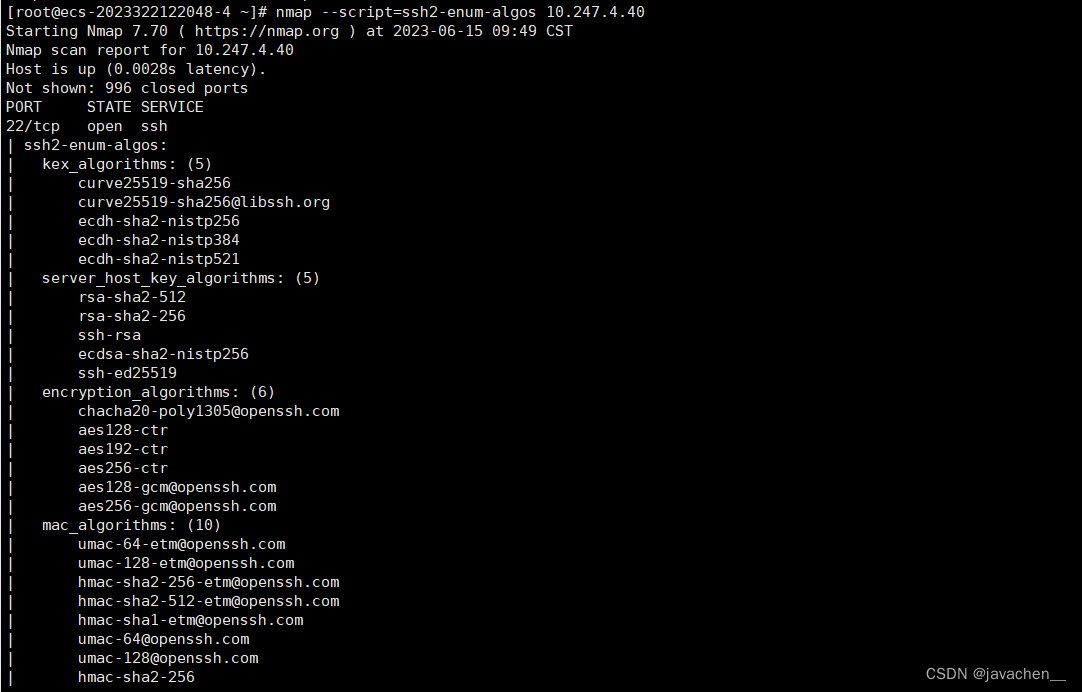

②cudann安装与测试

cudann下载:cuDNN Archive | NVIDIA Developer

![]()

百度网盘(cudann8.0.2):

链接:https://pan.baidu.com/s/13JDfexry0hP1GV0fgnbbBg

提取码:r83z

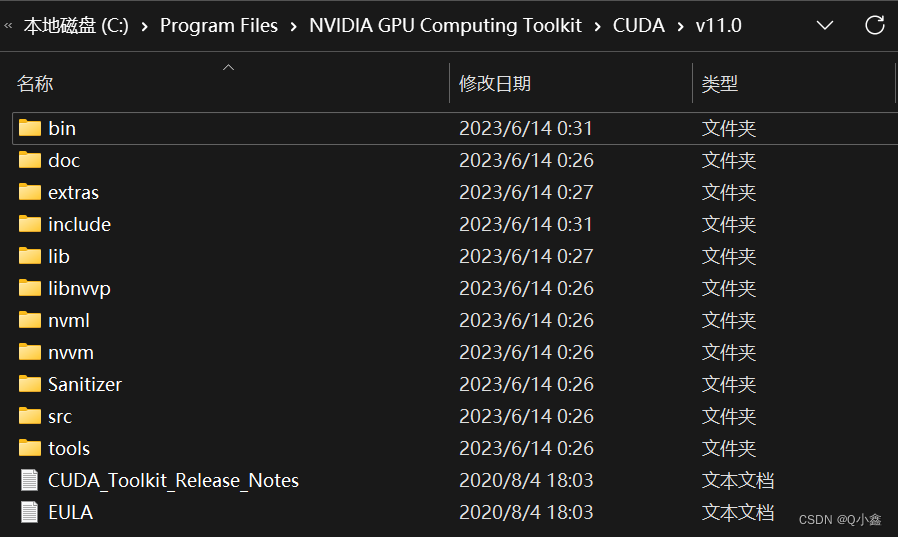

下载完成后是个压缩文件,解压后,把(bin,include,lib)复制到安装成功的cuda目录下

我的路径是这个 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.0

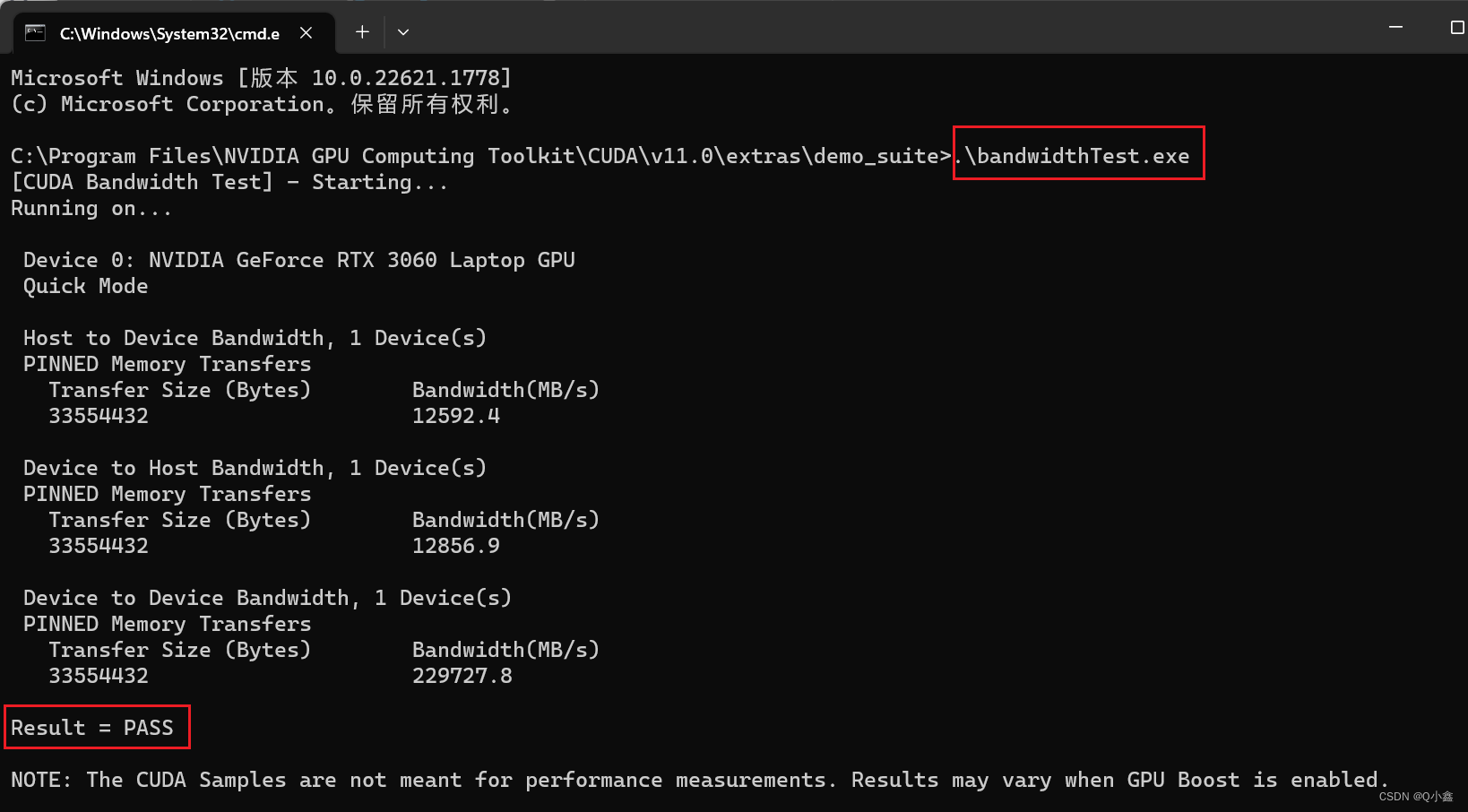

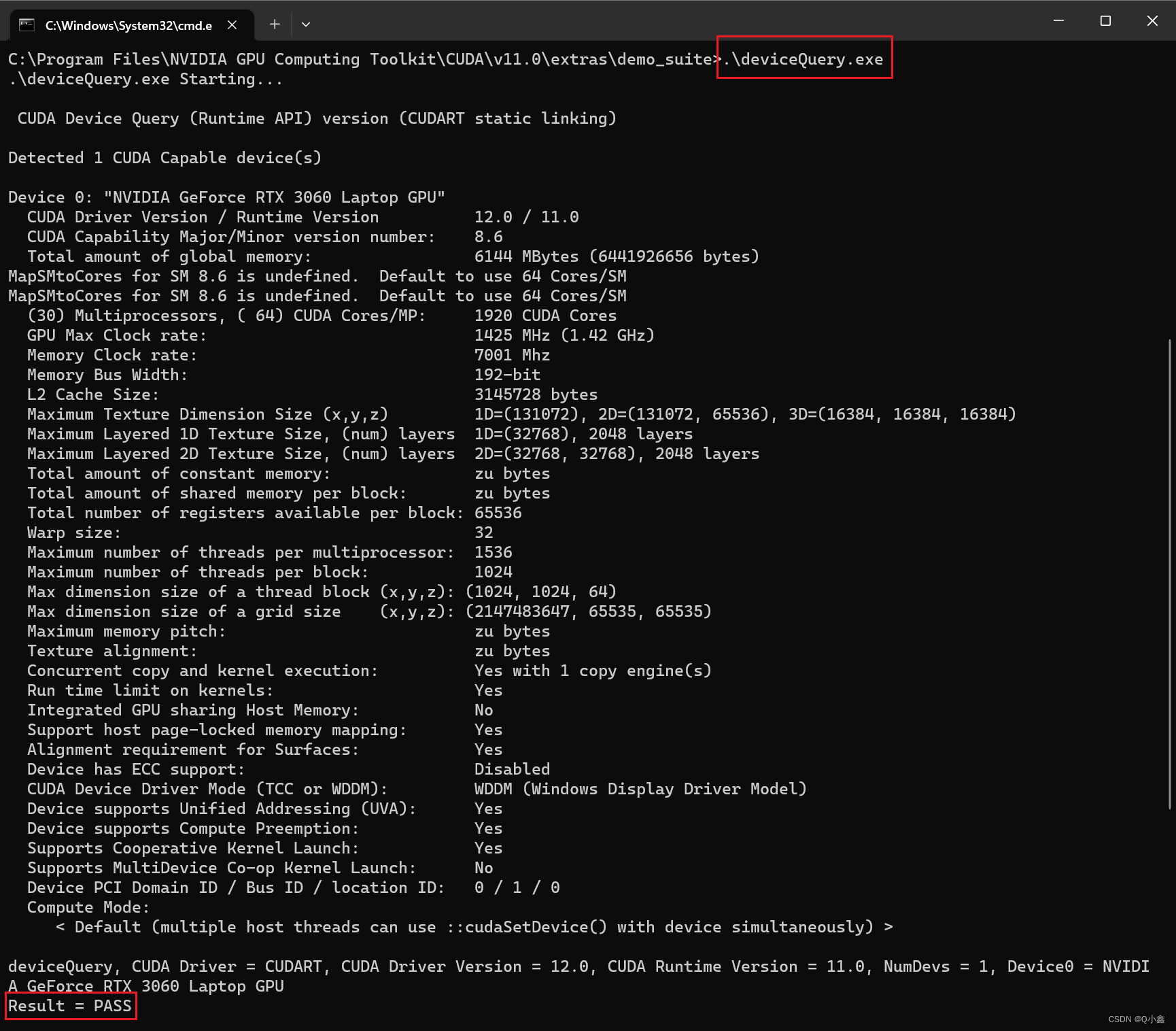

测试一下:

这样cudann就安装成功啦!

二、TensorRT的下载与安装

下载地址:TensorRT SDK | NVIDIA Developer

百度网盘(TensorRT8.6):

链接:https://pan.baidu.com/s/1KFkUFNZhNfj0Wo0fKSLbNg

提取码:tec5

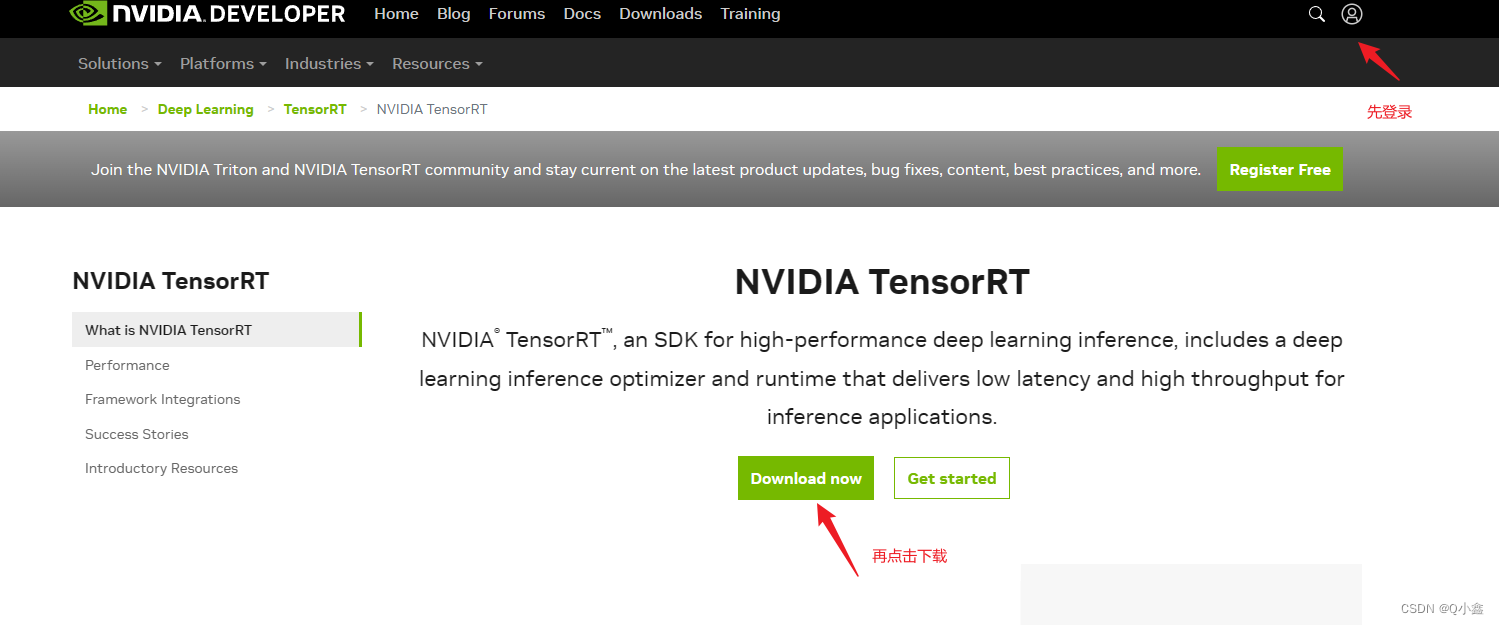

1、下载TensorRT

1、先登录账号后再点击下载

2、选择TensorRT 8

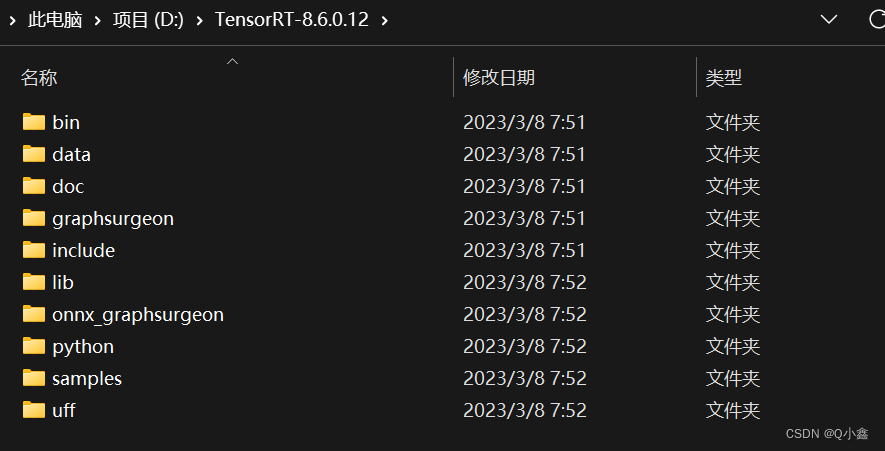

2、安装TensorRT

将下载好的TensorRT压缩包解压出来(我是解压到D盘)这样其实就安装完了,就是这么简单!

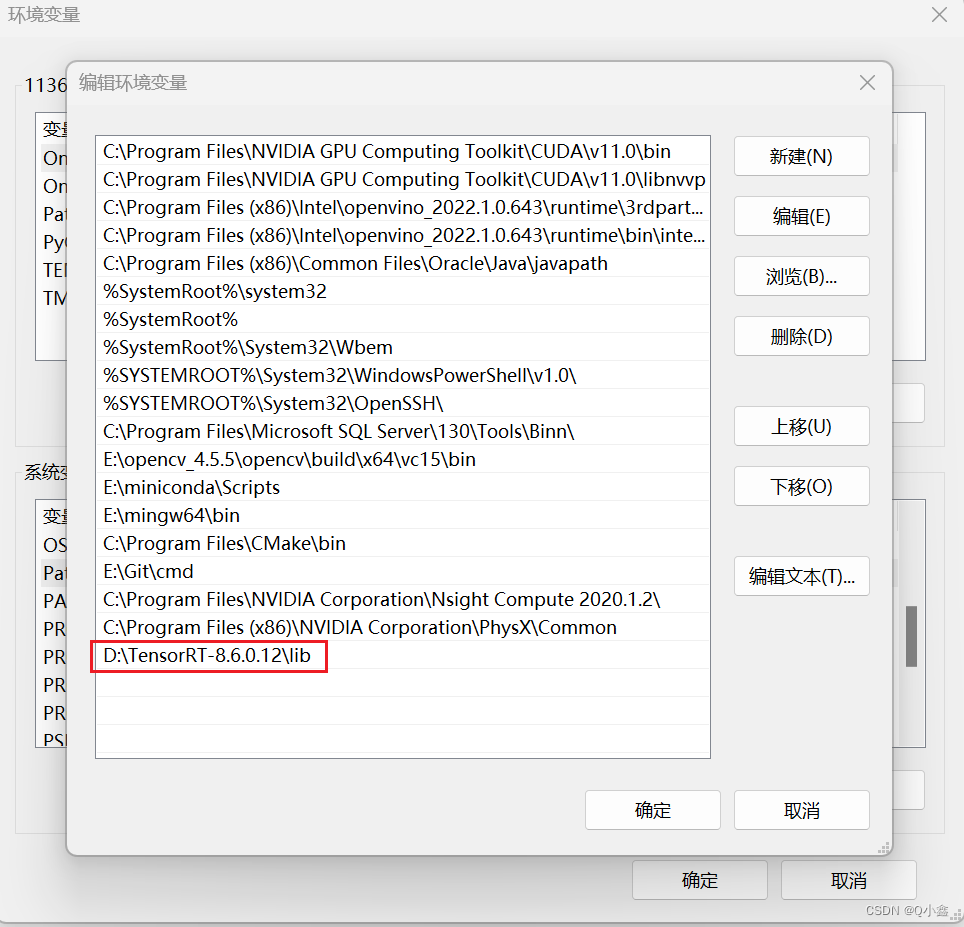

接下来配置环境变量:

D:\TensorRT-8.6.0.12\lib

三、配置VS2017开发环境

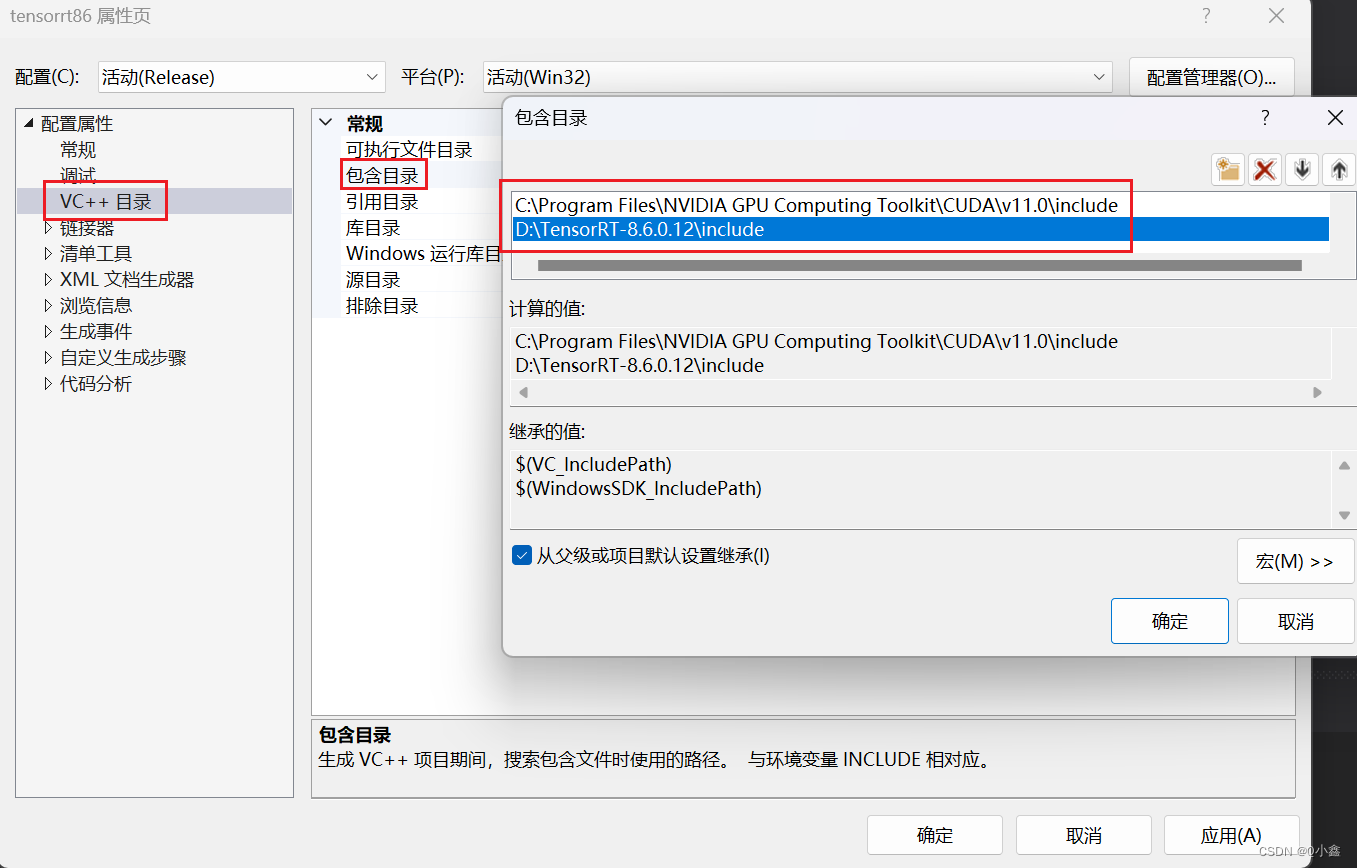

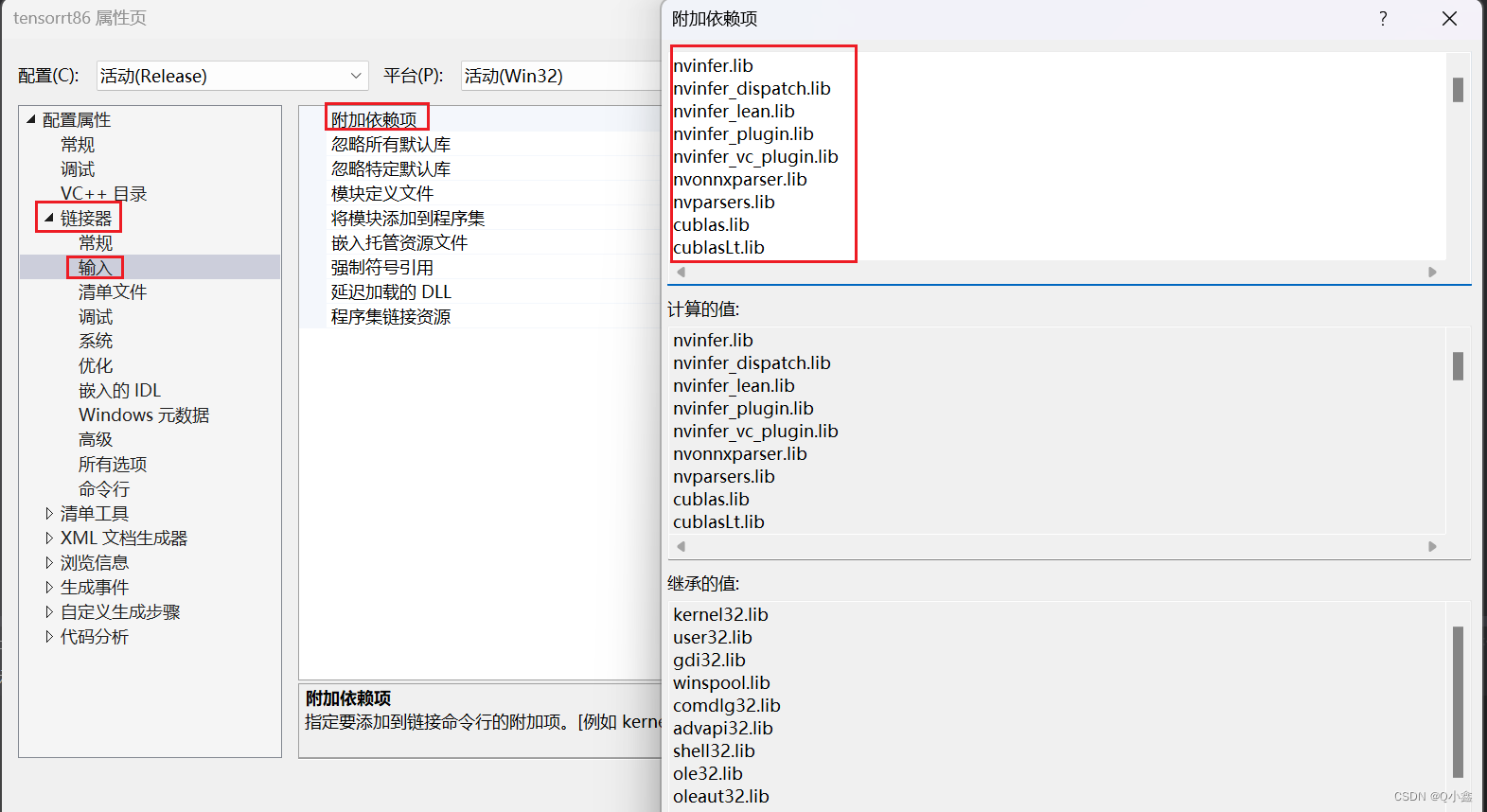

注:需要设置为Release x64 哦!

1、包含目录配置

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.0\include

D:\TensorRT-8.6.0.12\include

2、库目录

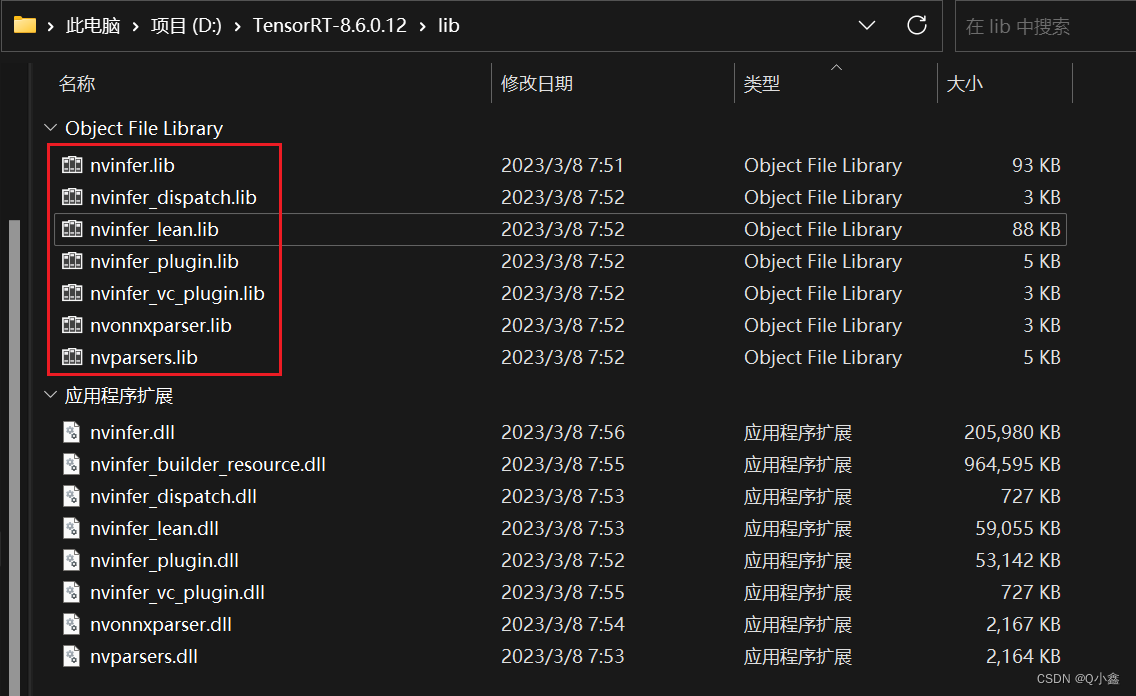

D:\TensorRT-8.6.0.12\lib

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.0\lib\x64

3、链接器,附加依赖项

nvinfer.lib

nvinfer_dispatch.lib

nvinfer_lean.lib

nvinfer_plugin.lib

nvinfer_vc_plugin.lib

nvonnxparser.lib

nvparsers.lib

cublas.lib

cublasLt.lib

cuda.lib

cudadevrt.lib

cudart.lib

cudart_static.lib

cudnn.lib

cudnn_adv_infer.lib

cudnn_adv_infer64_8.lib

cudnn_adv_train.lib

cudnn_adv_train64_8.lib

cudnn_cnn_infer.lib

cudnn_cnn_infer64_8.lib

cudnn_cnn_train.lib

cudnn_cnn_train64_8.lib

cudnn_ops_infer.lib

cudnn_ops_infer64_8.lib

cudnn_ops_train.lib

cudnn_ops_train64_8.lib

cudnn64_8.lib

cufft.lib

cufftw.lib

curand.lib

cusolver.lib

cusolverMg.lib

cusparse.lib

nppc.lib

nppial.lib

nppicc.lib

nppidei.lib

nppif.lib

nppig.lib

nppim.lib

nppist.lib

nppisu.lib

nppitc.lib

npps.lib

nvblas.lib

nvjpeg.lib

nvml.lib

nvrtc.lib

OpenCL.lib

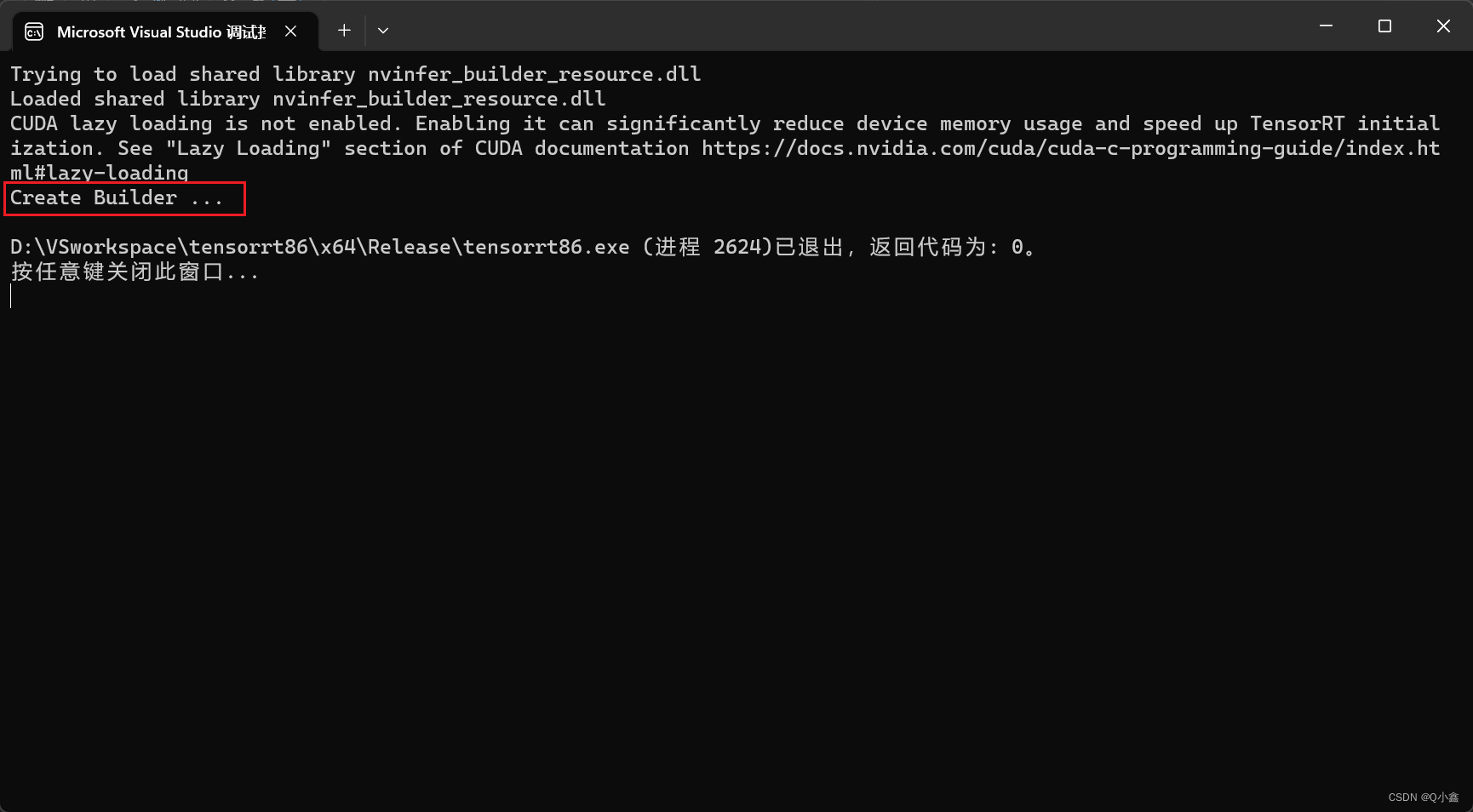

测试代码:

#include <iostream>

#include "NvInfer.h"

#include "NvOnnxParser.h"

using namespace nvinfer1;

using namespace nvonnxparser;

class Logger : public ILogger

{

void log(Severity severity, const char* msg) noexcept

{

if (severity != Severity::kINFO)

std::cout << msg << std::endl;

}

}gLogger;

int main(int argc, char** argv)

{

auto builder = createInferBuilder(gLogger);

builder->getLogger()->log(nvinfer1::ILogger::Severity::kERROR, "Create Builder ...");

return 0;

}

这样Windows环境就搭建配置完成啦!