前几章我们讨论了off-policy方式,其同on-policy方式最大的不同之处在于其在训练所采取的动作,是根据behavior policy进行决策的,而不是根据target policy。这种方式的好处在于兼顾了exploitation and exploration。本节将讨论如何通过模型近似的方式来应用off policy强化学习。

1. Importance sampling

off-policy策略一个很大问题在于target policy和behavior policy之间存在偏差,这个偏差可以通过重要性采样来扭正:

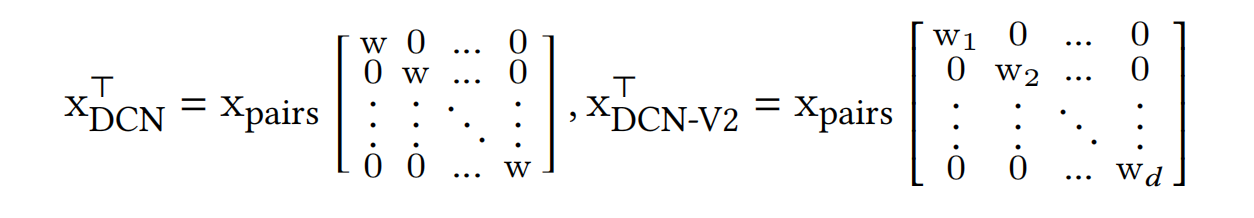

此时之前的价值模型的参数更新公式:

这里的可以通过上一节所根据TD(0) VS TD(n)以及discounted rewards VS average rewards分别进行设置:

- TD(0) discounted rewards:

- TD(n) discounted rewards:

- TD(0) average rewards:

- TD(n) average rewards:

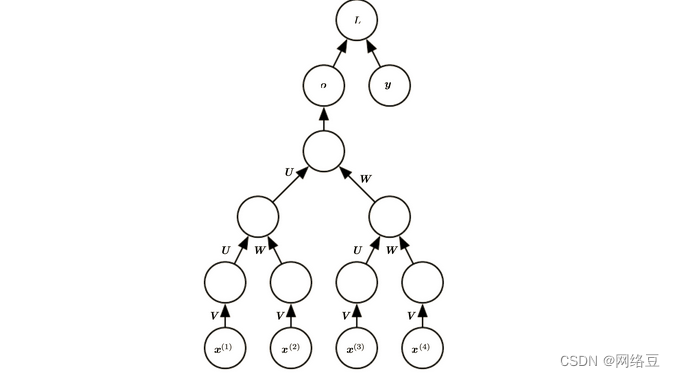

另外在第7章介绍了另一种不通过重新性采样的off-policy策略:tree-backup algorithm

2. Off-policy Divergence

由于target policy和behavior policy之间存在偏差,当这个偏差过大时,会使得价值模型的参数无法收敛。因为off-policy策略可能会系统中大量某些无用状态一直被重复更新,而这些状态的更新会推动整体参数一直增大。

要解决这个问题,一种思路是采用Q-learning方式,然后在下一动作时采用根据结合ε-greedy来选择。

3. Bellman error

之前价值模型的参数是根据累积收益同预估值的平方差VE损失来学习的,这么做对于MC算法是合理的,但对于TD算法却不完全合适,因此按Bellman式子定义如下损失

在TD(0)的情况下可以改写为,Bellman error 其实就是 TD error 的期望值。

![[CKA]考试之备份还原 etcd](https://img-blog.csdnimg.cn/0bbe0ce002c64fe482fbb023b5b488e6.png)