Python安装PySpark:从入门到精通

PySpark是使用Python编写的Apache Spark API。它提供了一个Python接口来与Spark的分布式计算引擎进行交互。本文将介绍如何在Python中安装PySpark。

环境准备

在安装PySpark之前,您需要先安装以下依赖项:

- Python 2.7.x 或 3.x

- Java 8 或更高版本

在安装Java时,请确保将JAVA_HOME设置为正确的Java安装路径。

安装PySpark

第一步:安装Spark

在安装PySpark之前,您需要先安装Spark,可以前往Apache Spark官网下载最新版本的Spark。选择合适的版本并将其解压缩到您的本地目录。

第二步:配置环境变量

在您的系统环境变量中添加以下两个环境变量:

SPARK_HOME = your_spark_path

PYTHONPATH = $SPARK_HOME/python/:$PYTHONPATH

将“your_spark_path”替换为Spark的文件路径。

第三步:安装PySpark

使用本地Python包管理器(如pip)安装PySpark:

pip install pyspark

或者,您也可以从源码安装:

git clone https://github.com/apache/spark.git

cd spark

./build/mvn -Ppython -DskipTests clean package

到Spark的目录下建立软连接:

ln -s /path/to/your/spark-<version>-bin-hadoop2.7/python/pyspark /path/to/python/lib/pythonX.Y/site-packages/pyspark

第四步:测试安装

启动Python终端并输入以下代码,以确定PySpark是否已成功安装:

from pyspark import SparkContext

sc = SparkContext("local", "PySpark Test")

rdd = sc.parallelize([1,2,3,4,5])

print(rdd.count())

如果打印出了结果“5”,则表示安装成功。

结论

在本文中,我们介绍了如何在Python中安装PySpark。要安装PySpark,请首先安装Spark,然后配置环境变量,并使用Python包管理器安装PySpark。最后,您可以通过简单的代码片段来测试PySpark是否已成功安装。通过这些步骤,您可以在Python中成功使用PySpark,与Spark的分布式计算引擎进行交互,充分发挥大数据的能力。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

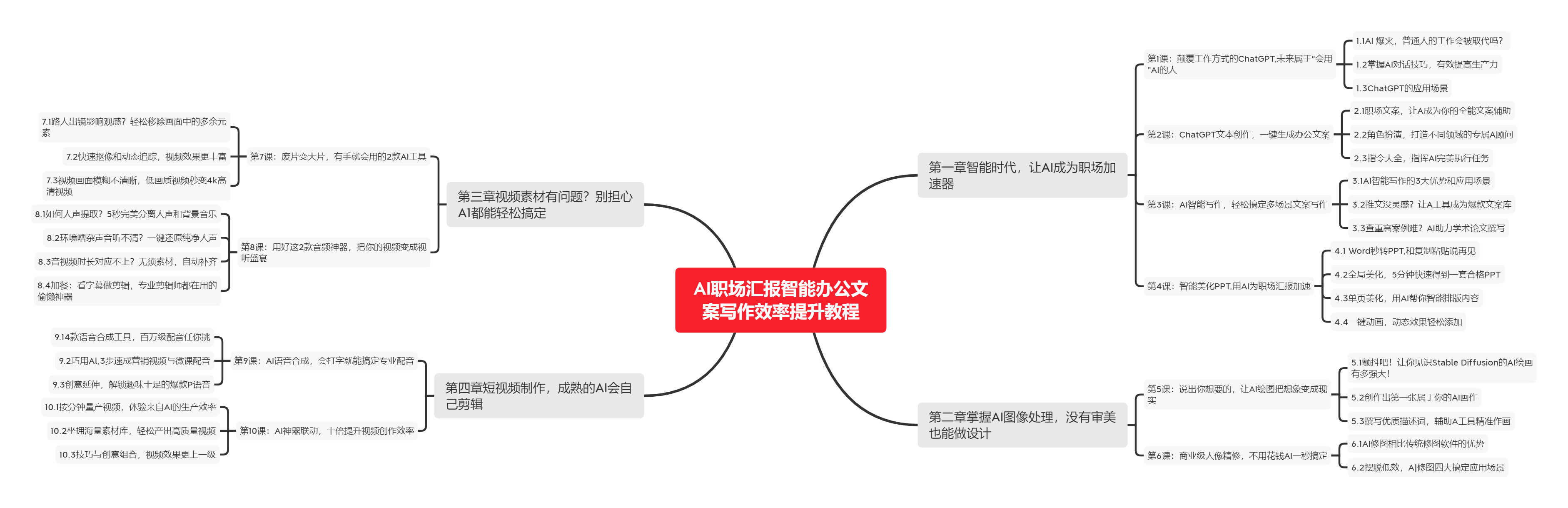

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

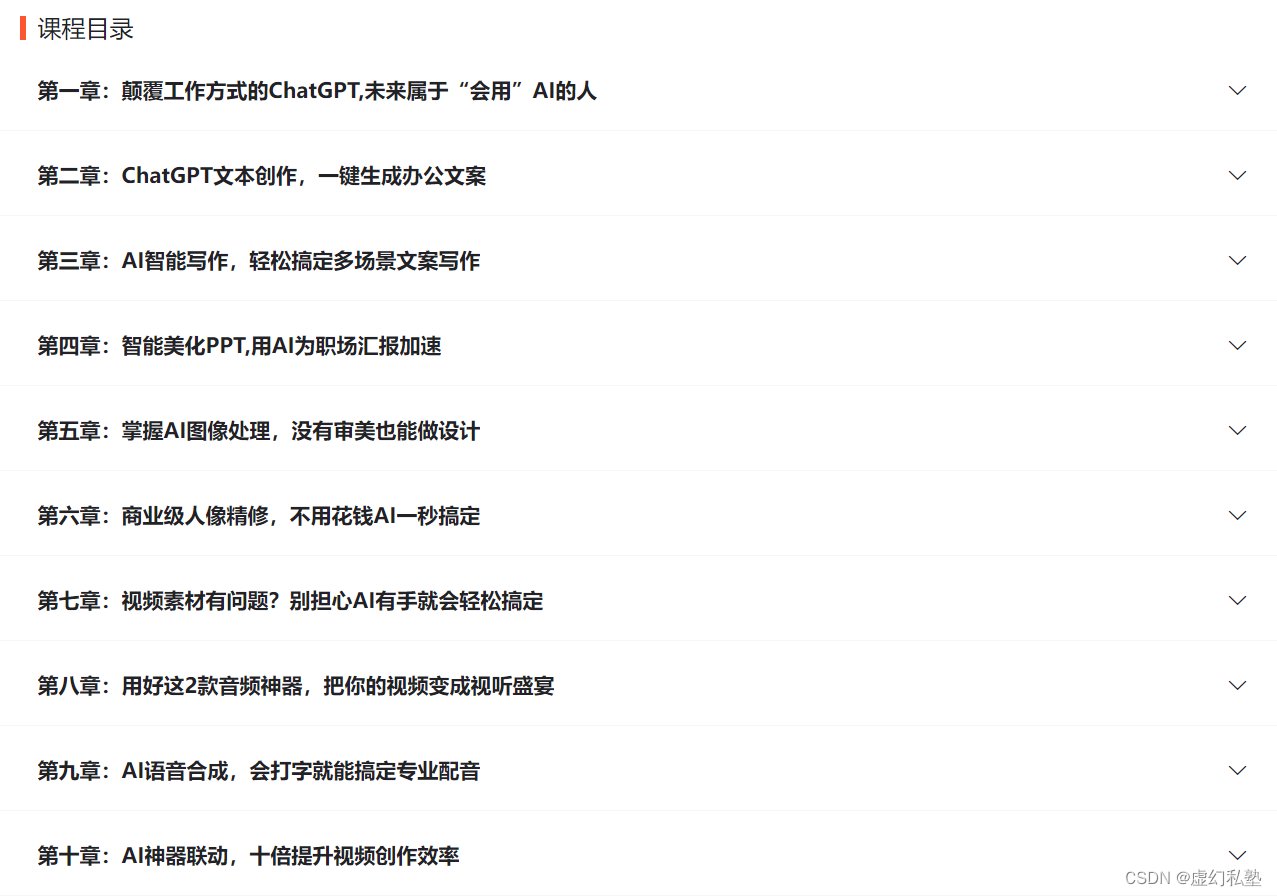

下图是课程的整体大纲

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |

![[java]关于Session关于Token关于JWT](https://img-blog.csdnimg.cn/7c563572afd54f4f9fe0b2ed2fed488e.png)