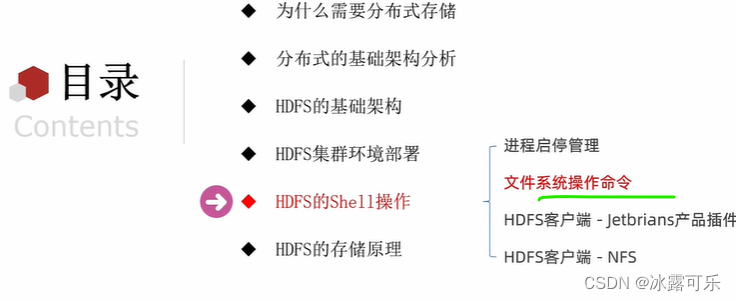

大数据:HDFS的Shell操作,进程启动管理,文件系统操作命令,创建文件文件夹,下载上传,复制移动,删除,展示

2022找工作是学历、能力和运气的超强结合体,遇到寒冬,大厂不招人,可能很多算法学生都得去找开发,测开

测开的话,你就得学数据库,sql,oracle,尤其sql要学,当然,像很多金融企业、安全机构啥的,他们必须要用oracle数据库

这oracle比sql安全,强大多了,所以你需要学习,最重要的,你要是考网络警察公务员,这玩意你不会就别去报名了,耽误时间!

与此同时,既然要考网警之数据分析应用岗,那必然要考数据挖掘基础知识,今天开始咱们就对数据挖掘方面的东西好生讲讲 最最最重要的就是大数据,什么行测和面试都是小问题,最难最最重要的就是大数据技术相关的知识笔试

文章目录

- 大数据:HDFS的Shell操作,进程启动管理,文件系统操作命令,创建文件文件夹,下载上传,复制移动,删除,展示

- @[TOC](文章目录)

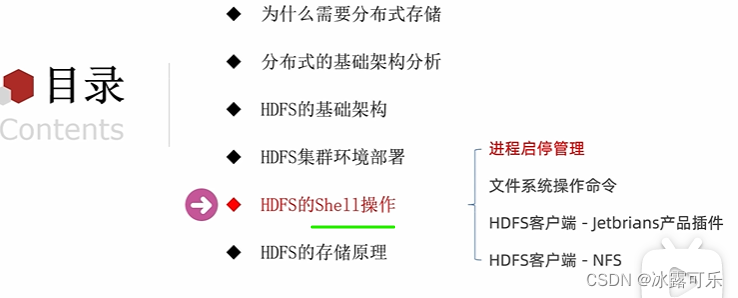

- 大数据进程启动管理

- HDFS文件系统操作命令

- 命令权限不足咋搞

- 总结

文章目录

- 大数据:HDFS的Shell操作,进程启动管理,文件系统操作命令,创建文件文件夹,下载上传,复制移动,删除,展示

- @[TOC](文章目录)

- 大数据进程启动管理

- HDFS文件系统操作命令

- 命令权限不足咋搞

- 总结

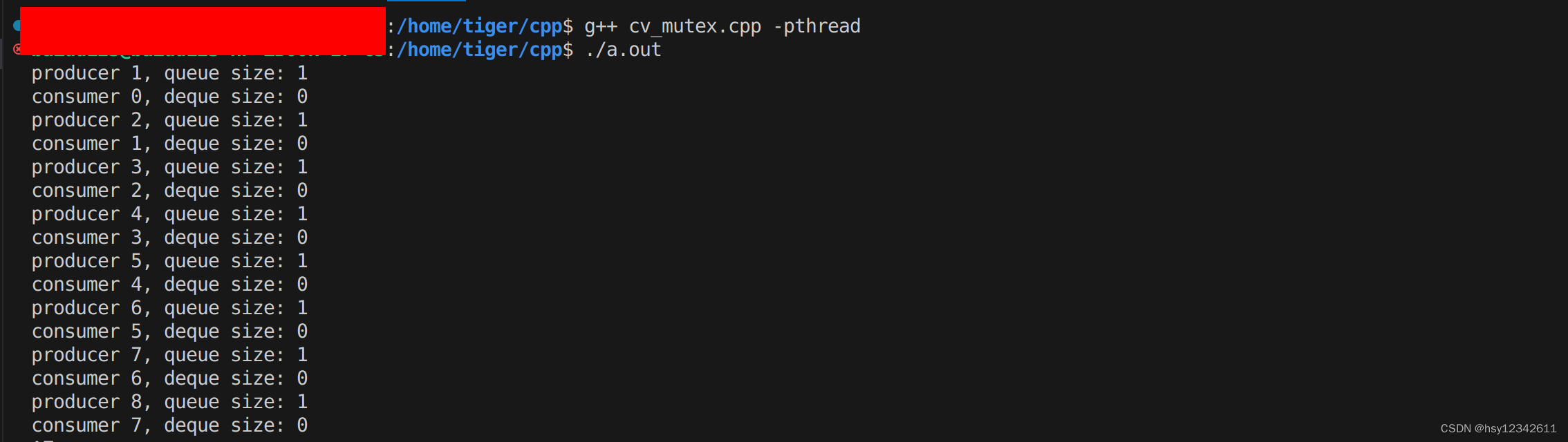

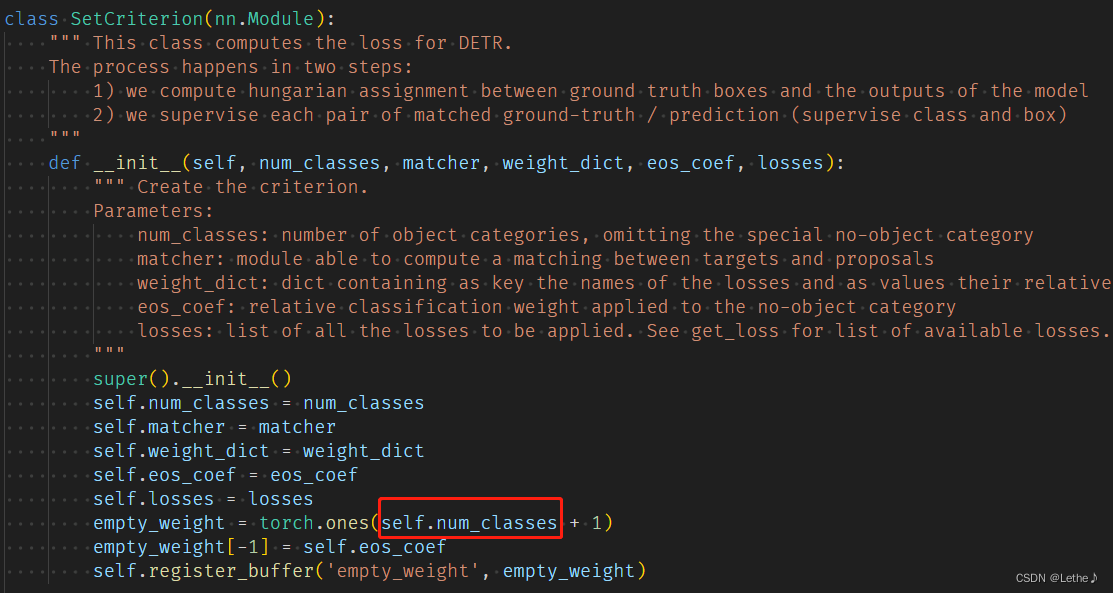

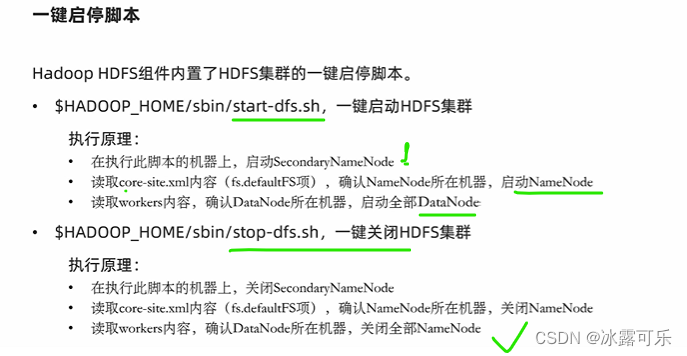

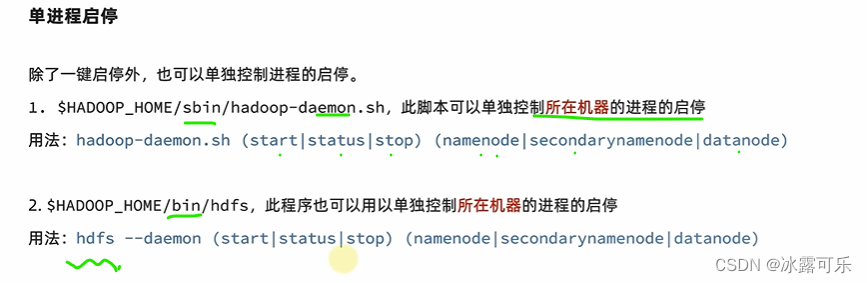

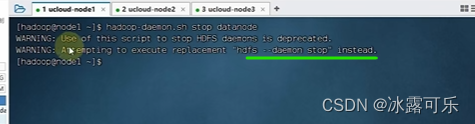

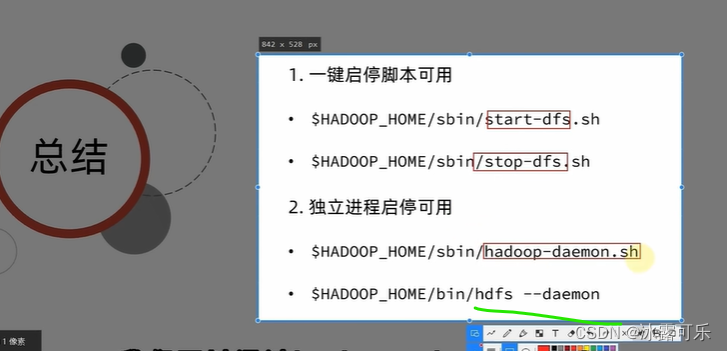

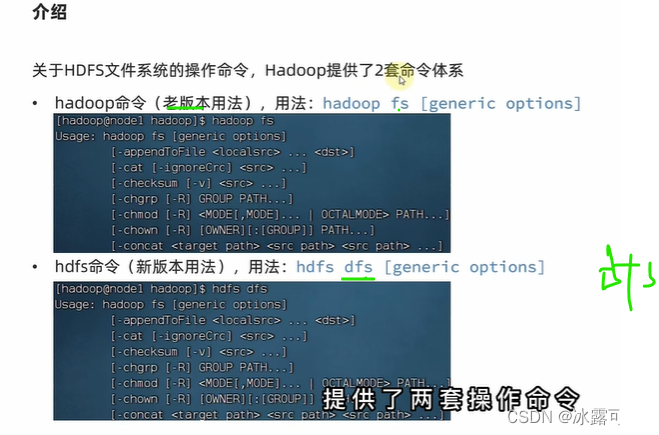

大数据进程启动管理

两个横线,给参数,给对象

hdfs命令也行

还是hdfs更好哦

daemon

jps看看状态

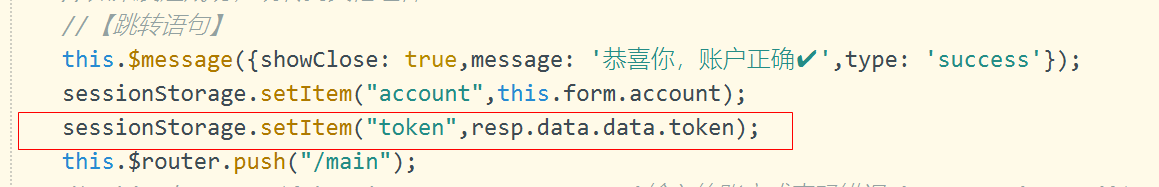

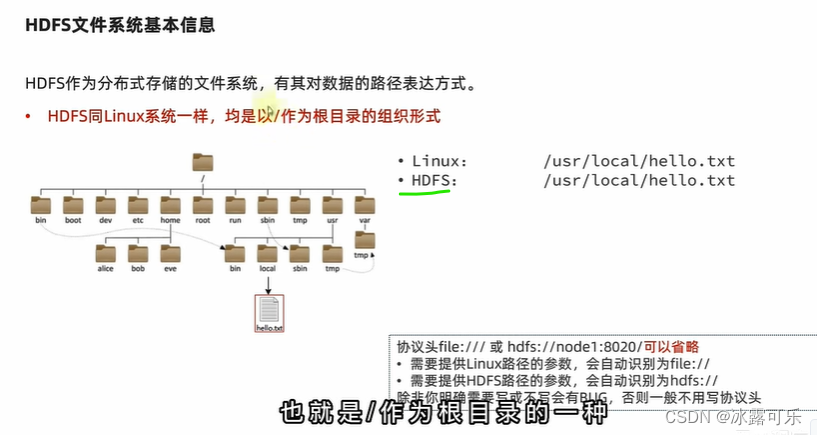

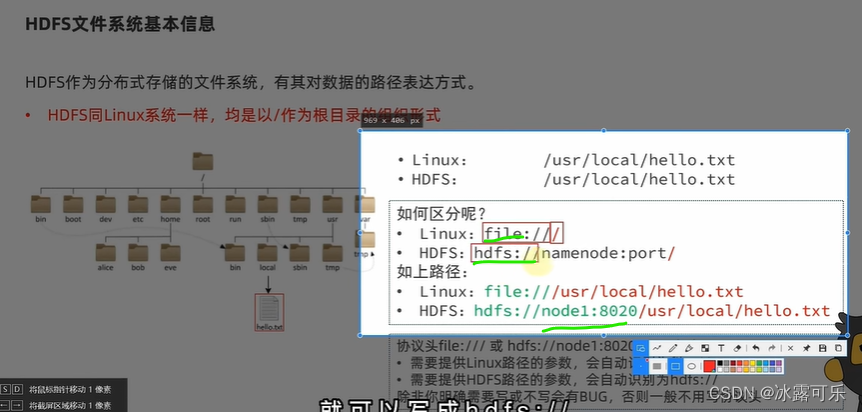

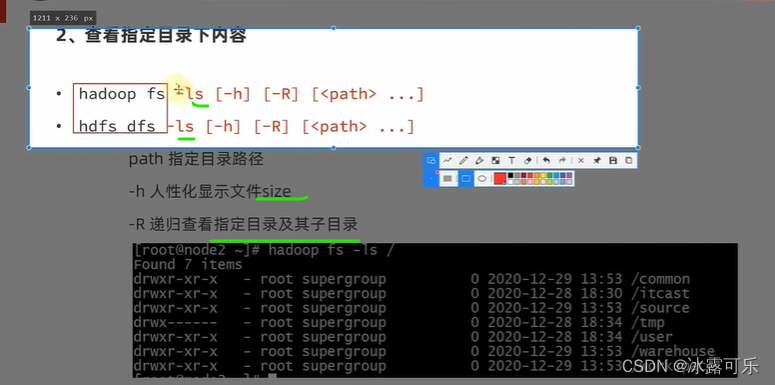

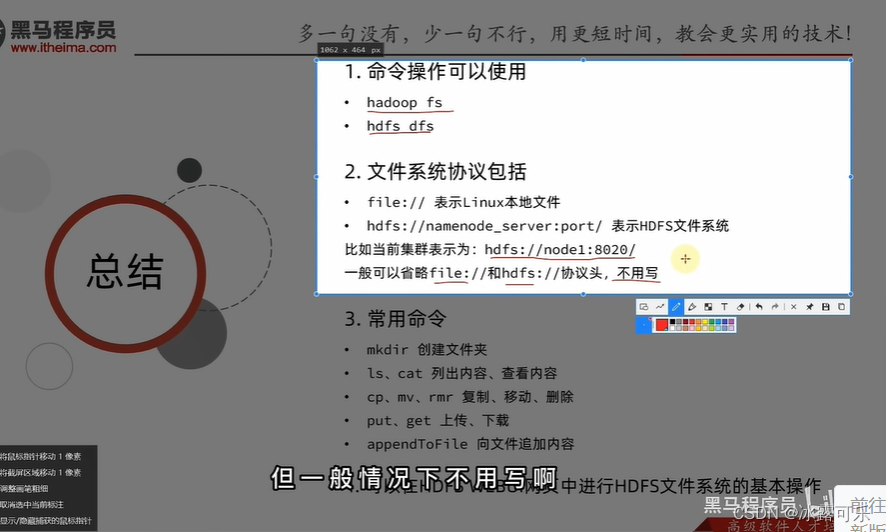

HDFS文件系统操作命令

通过协议来区分

操作不同的系统,就可以搞定了

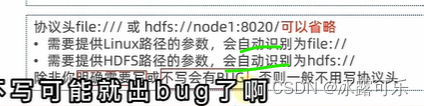

有协议头

真的使用过程中,我们省略即可

它根据hdfs命令自动识别

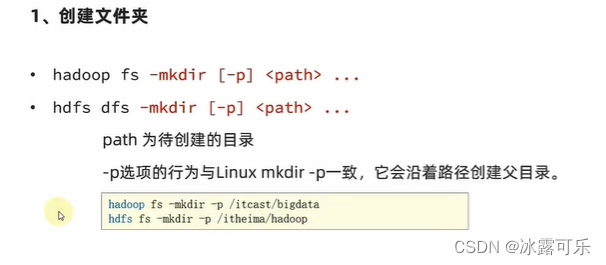

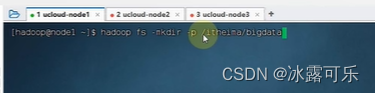

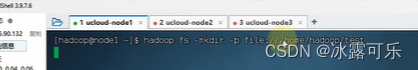

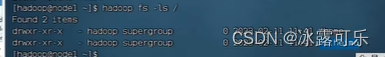

hadoop创建文件夹

新老版本差不多

-mkdir本来就是Linux的命令

相当于hadoop都是建立在Linux上的命令

协议头加上就是不同的地方

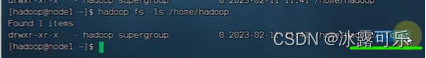

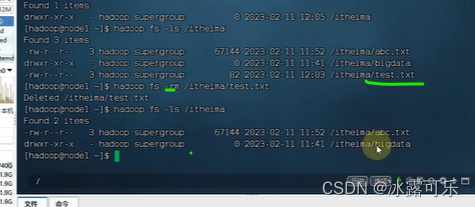

查看hadoop文件

那就是用Linux来组装命令

没有协议头,默认走hadoop系统哦

hadoop组装Linux命令

很骚

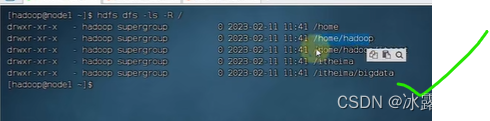

-R是根和子目录全部打印

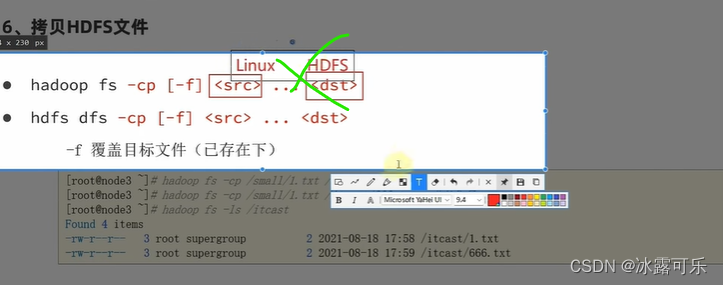

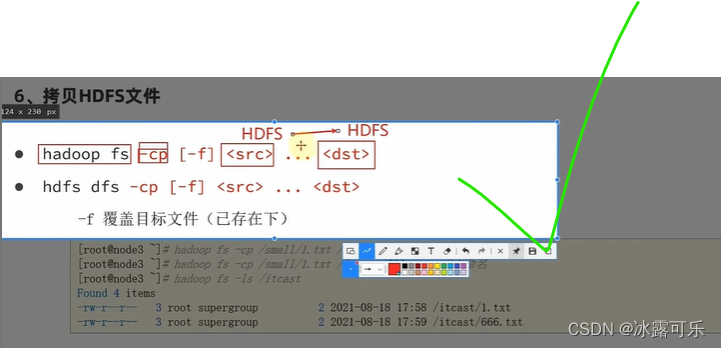

复制src到dst

协议头写不写都行

反正hdfs命令自动加

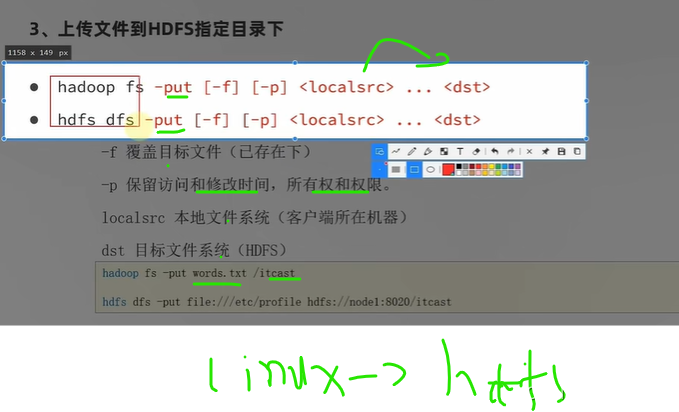

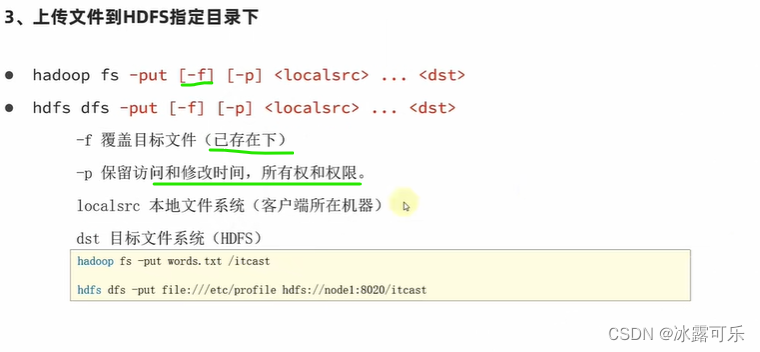

这-f就是强制覆盖

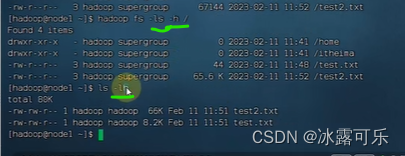

如果你想让内存大小变得直观

用ls -h

ls -lh

这样就是K的标准格式

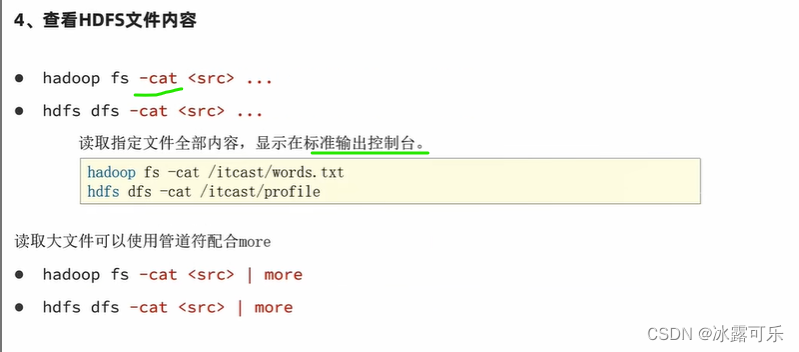

src仅仅一个那就是给打印台打印

如果有dst那就是往另一个文件中打印

加内容

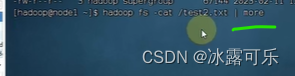

正常看

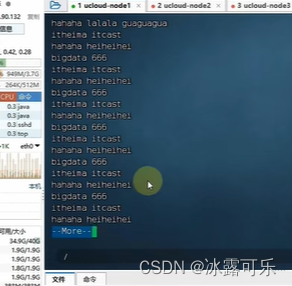

贼多内容

大数据的话,可能顶不住啊

那最好是别打印这么多

部分打印即可

用管道服务,more,翻页

hadoop fs+Linux命令

hdfs dfs+Linux命令

按空格翻页即可

方便美滋滋

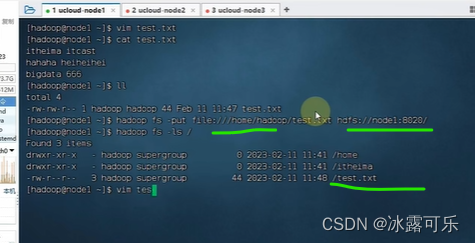

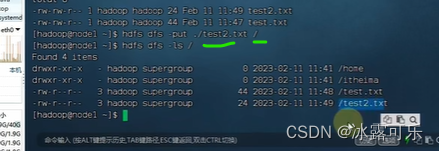

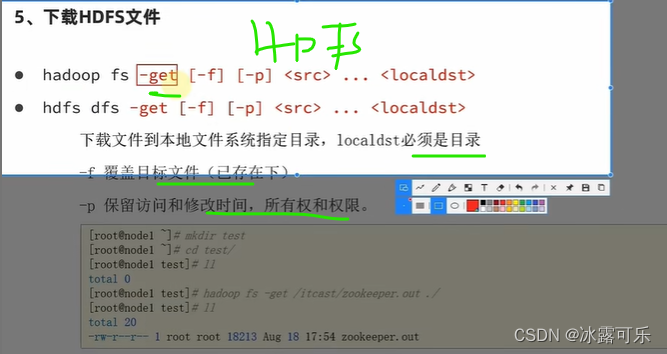

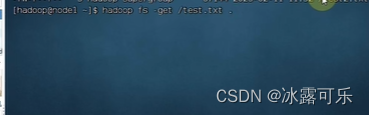

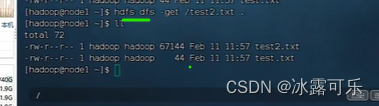

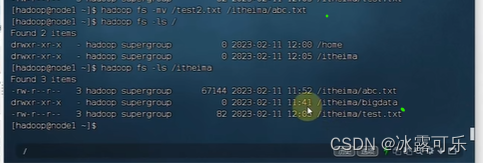

下载反着来

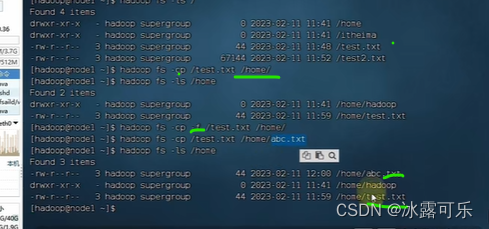

复制,当然只能是hdfs系统哦

cp是copy

美滋滋

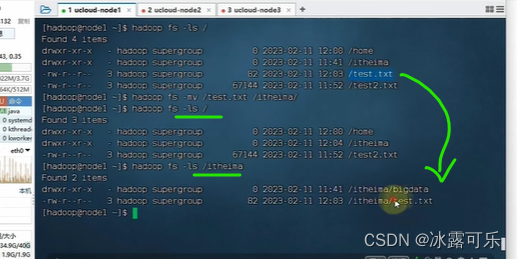

可以改名可以不改

还有移动命令

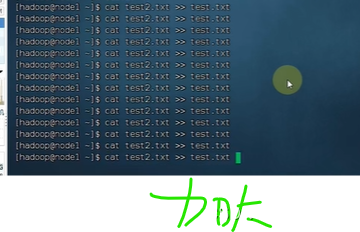

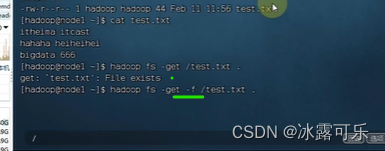

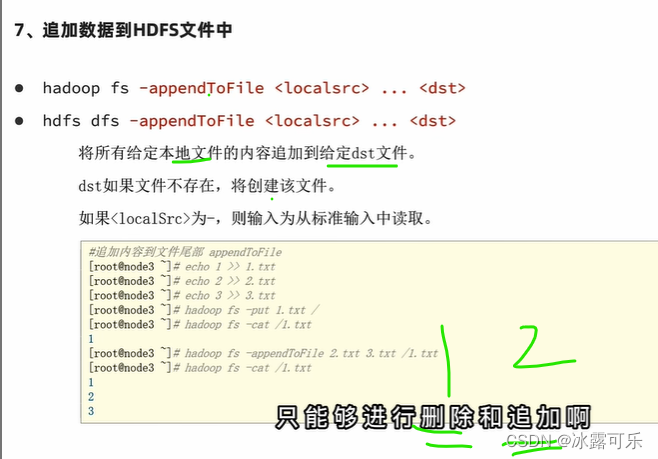

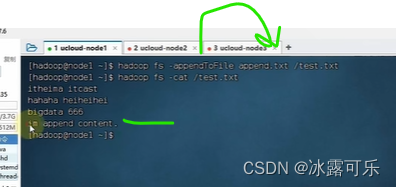

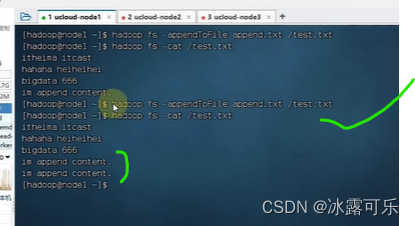

追加

hdfs只能追加,或者删除

不能修改,跟vim不同哦

查test简单

-cat

三行,本地构造append文件

写追加内容

反正只能追加或者删除,就是不能修改

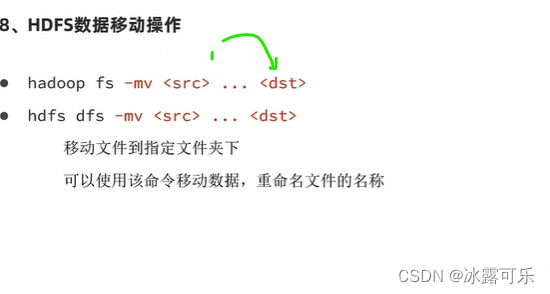

mv

可以改名字哦

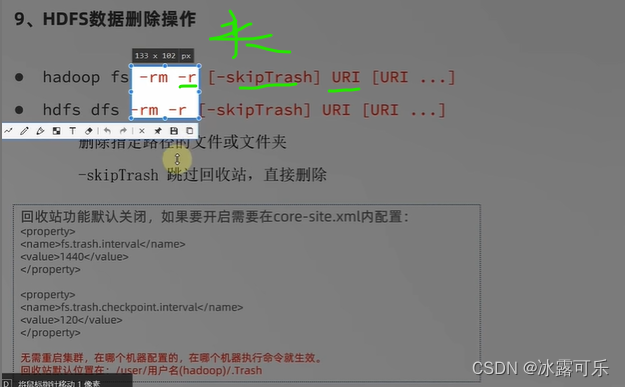

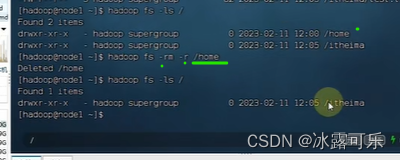

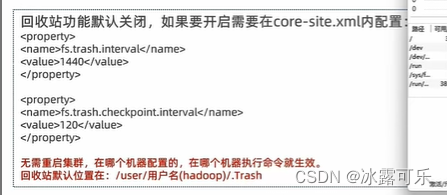

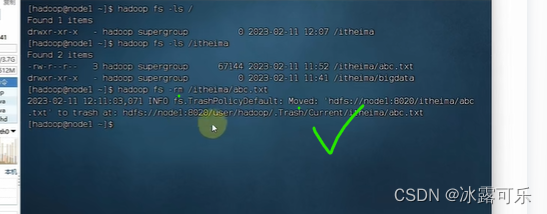

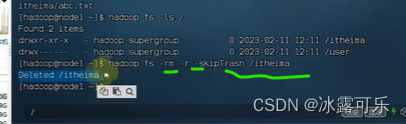

删除

hone文件夹,删除-r

文件rm

强制删除

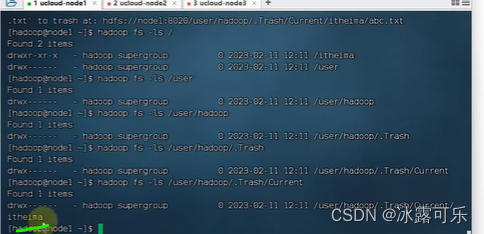

回收站也被删除了

如果不想删除回收站

就配置回收站,

保存时间1440限制之内,保留,1440分钟,一天保留,之后删除

120是检查间隔120分钟

回收站可以不用的

直接查阅官方文档即可

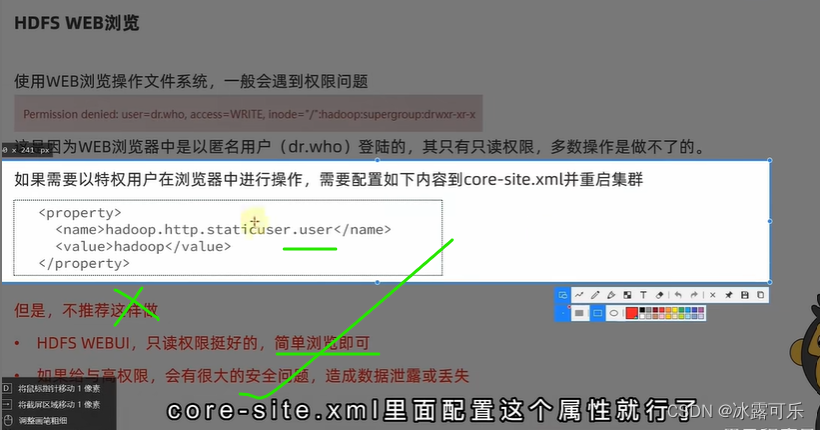

完全可以通过可视化工具,查看文件系统

通过案件搞定就行了

不建议给页面提供权限

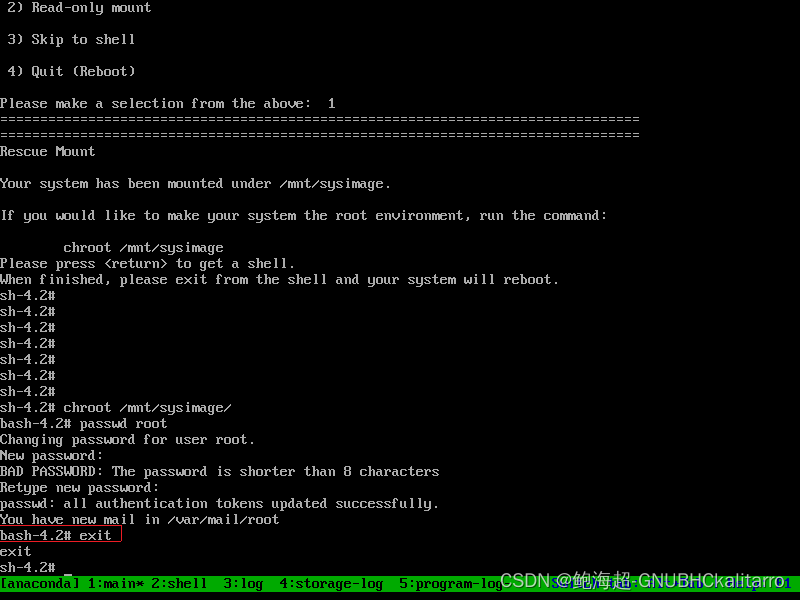

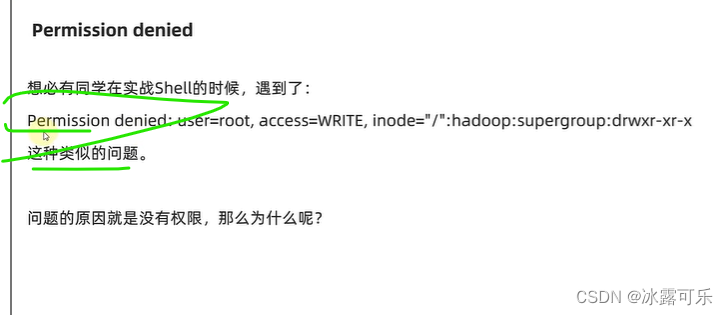

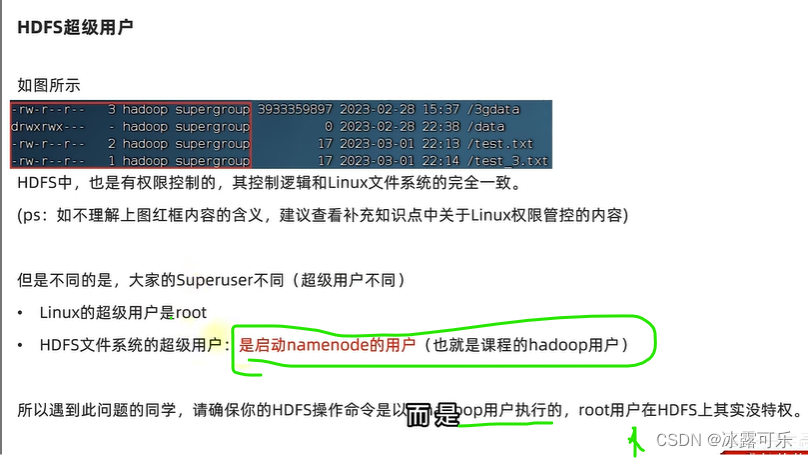

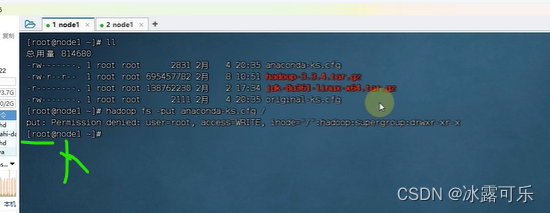

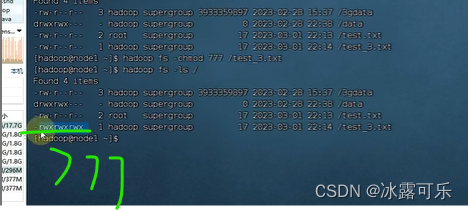

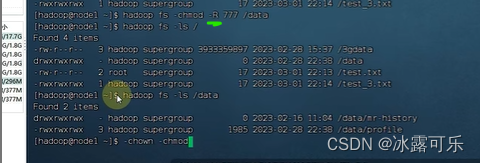

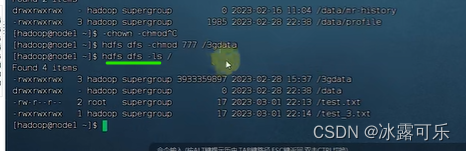

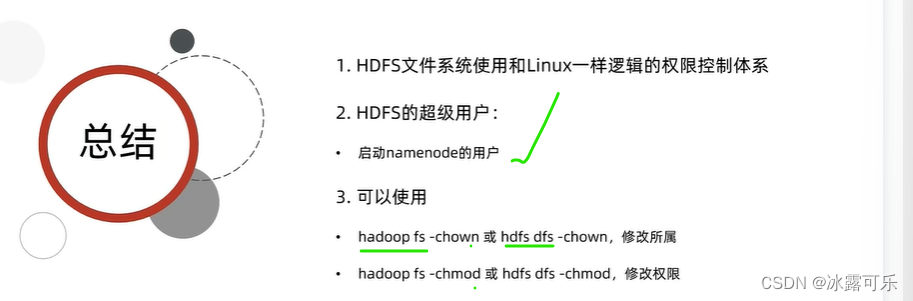

命令权限不足咋搞

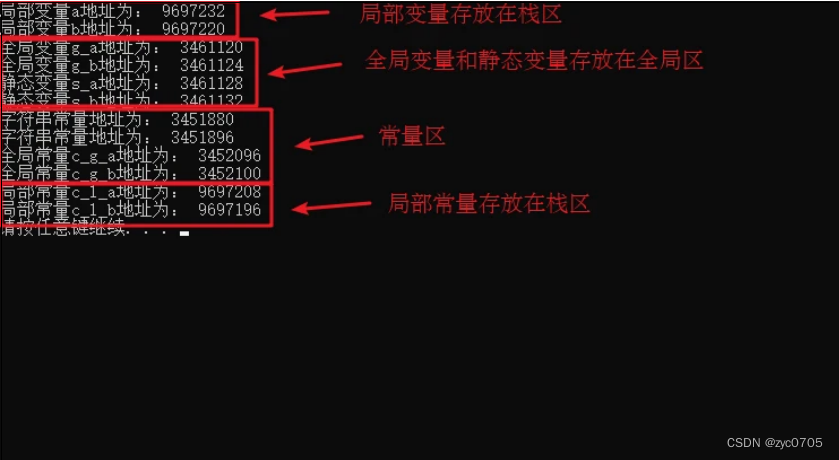

跟Linux本地的文件类似的

它都需要权限控制

root没有权限

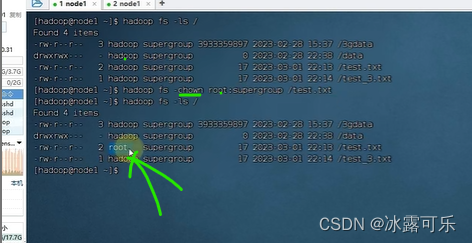

hdfs得hadoop启动了namenode的人才有权限哦

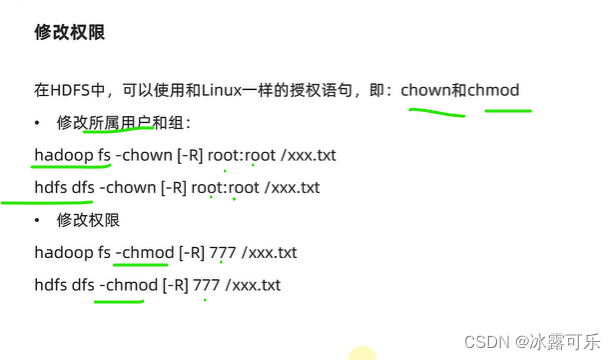

chown和chmod

其他用户的权限x

没写

开头新老写法都一样

总结

提示:重要经验:

1)

2)学好oracle,即使经济寒冬,整个测开offer绝对不是问题!同时也是你考公网络警察的必经之路。

3)笔试求AC,可以不考虑空间复杂度,但是面试既要考虑时间复杂度最优,也要考虑空间复杂度最优。