1、简介

1.1、Presto的由来

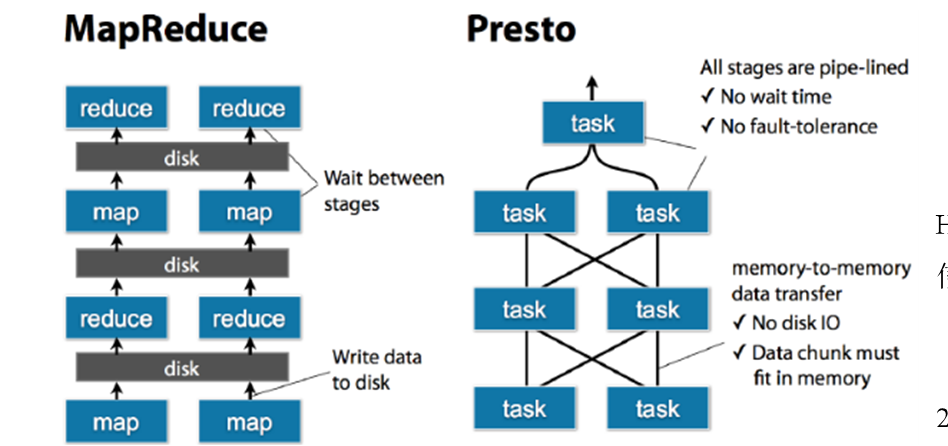

Presto最初由Facebook公司开发,旨在解决Facebook内部大规模数据处理和数据分析的问题。在传统的Hadoop生态圈中,MapReduce作为数据处理框架,虽然能够处理海量数据,但是其查询性能却比较低下,尤其是对于需要进行交互式查询(如数据探索、数据挖掘等)的应用场景,更是不够灵活。

为了解决这一问题,Facebook团队在2012年开始开发Presto,其目标是建立一个高性能、可扩展、支持SQL查询语言的跨平台数据处理引擎,以适应Facebook内部不断增长的数据规模和业务需求。在Presto出现之前,Facebook使用Hive来处理数据,但随着数据量和查询复杂度的增加,Hive的查询性能已经不能满足需求,因此Facebook决定开发Presto替代Hive。

Presto是一个开源的分布式SQL查询引擎,适用于交互式分析查询,数据量支持GB到PB字节。

1.2、Presto的特点

Presto是一个高性能、可扩展、支持多数据源的分布式SQL查询引擎,其作用主要有以下几个方面:

-

查询大规模数据集:Presto可以查询PB级别的数据,并且可以对数据进行分布式处理。因此,Presto非常适用于需要查询大规模数据集的场景,比如数据分析、数据仓库等。

-

提供高性能查询:Presto利用内存计算技术,将计算结果放在内存中进行实时查询,相比于Hadoop MapReduce的磁盘IO,其性能更快,可以实现秒级响应。因此,Presto非常适用于对查询性能要求较高的场景,比如数据探索、数据挖掘等。

-

支持多数据源查询:Presto提供了对多种数据源的支持,包括传统的关系型数据库和同类系统,还有一些NoSQL数据库和分布式存储系统。因此,Presto非常适用于需要对多种数据源进行查询和集成分析的场景。

-

易用性:Presto提供了一个CLI(Command-Line Interface)工具和Web界面,使用户可以轻松地提交查询语句、查看执行状态和结果。因此,Presto非常适用于需要方便易用的数据处理场景。

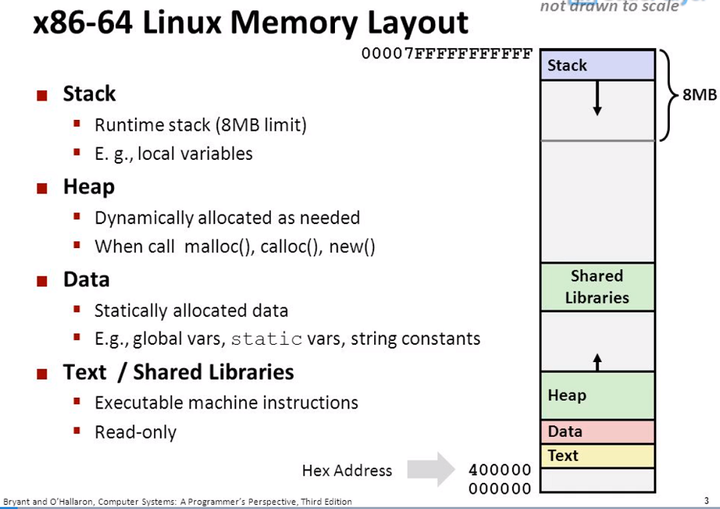

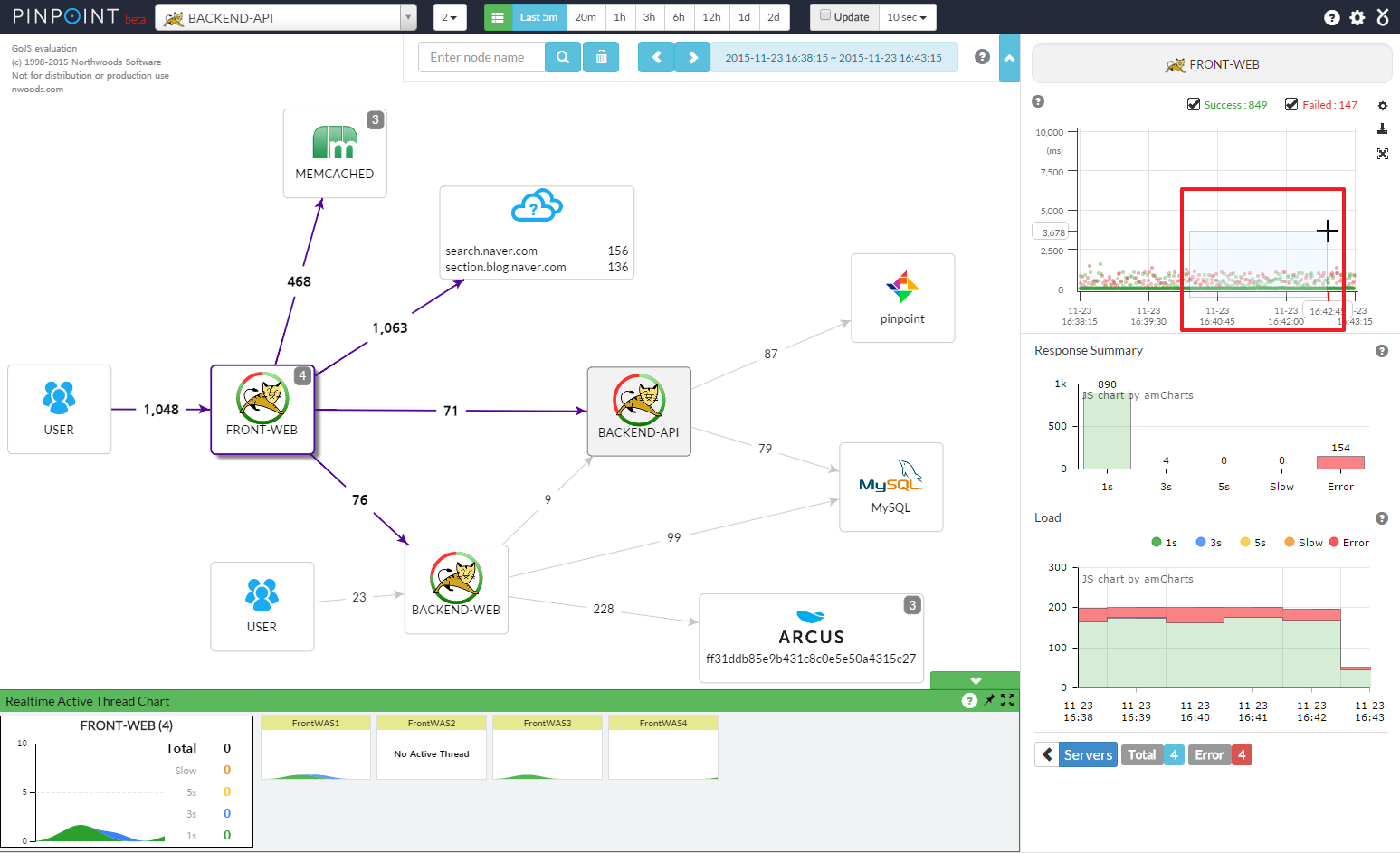

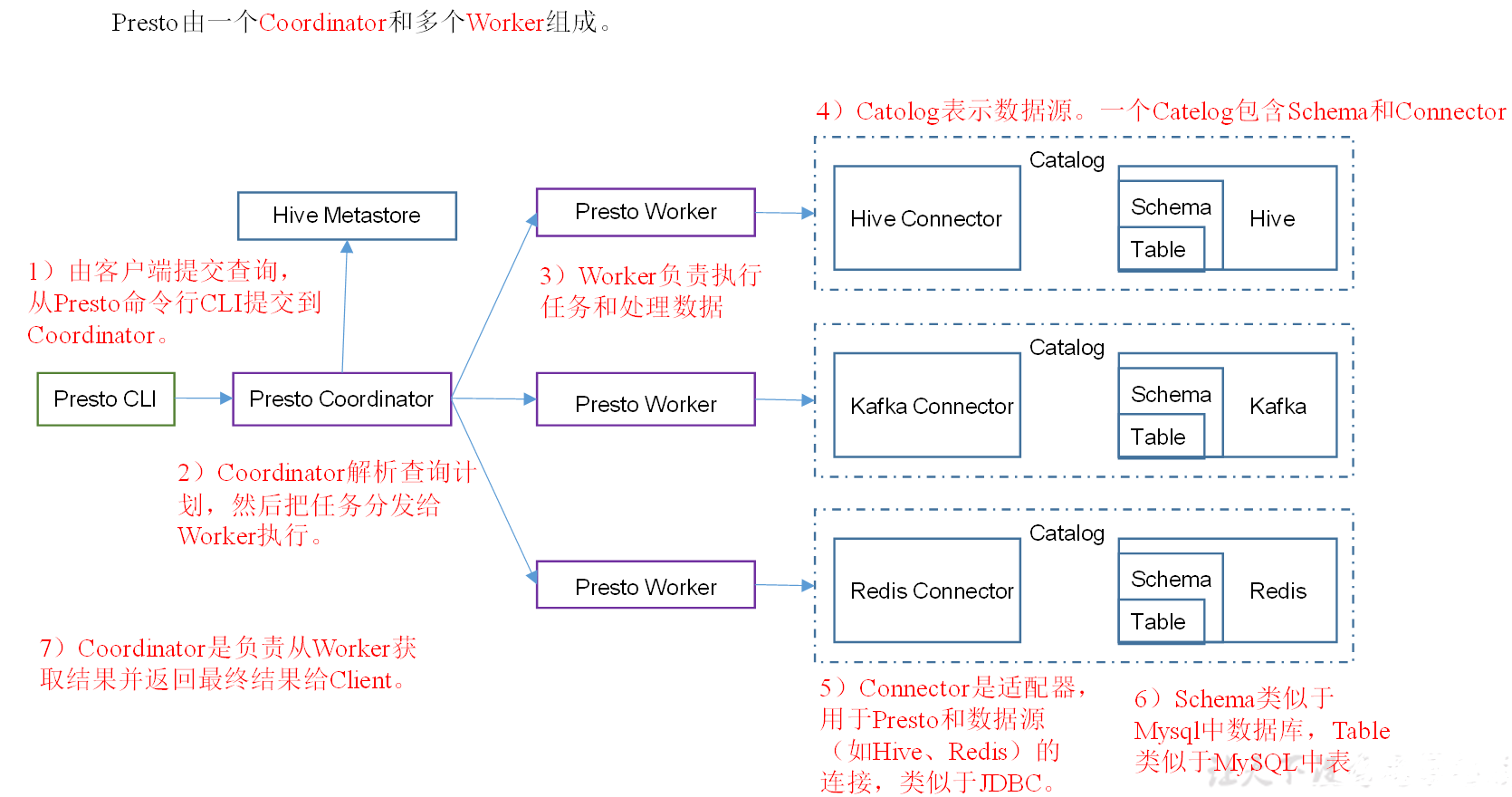

1.3、Presto的架构

Presto 集群中一共有两种服务器进程: Coordinator服务进程,Worker服务进程。

- Coordinator进程: 接受查询请求,解析查询语句,生成查询执行计划,任务调度,Worker管理。

- Worker进程: 执行被分解后端而查询执行任务–>Task

执行流程如下图所示:

- Connector Presto访问不同数据源的驱动程序。每种Connector都实现Presto中标准SPI接口。当年需要使用某种Connector访问特定的数据源时,需要在

$PRESTO_HOME/etc/catalog中配置文件:example.properties,并在配置文件中设置一个属性:connector.name,Presto中Connector Manager就是通过该配置属性来决定使用哪一个Connector去访问数据。 - Catalog 对应某一类数据源,例如hive的数据,或mysql的数据。当你访问Catalog中某个表时,该表的全名总是以Catalog的名字开始。例如 名字为

example.schema1.table1的表,指的是表table1位于名schema1下的schema中,而schema1又位于example的Catalog中。 - Schema 对应mysql中的数据库

- Table 对应mysql中的表

Presto查询步骤

- 客户端通过Http协议发送一个查询语句给Presto集群的

Coordinator Coordinator接到客户端传递过来的查询语句,会对该查询语句进行解析,生成查询执行计划,Coordinator会根据数据本地行生成对应的HttpRemoteTask。Coordiantor将每一个Task都分发到其所需要处理的数据所在的Worker上进行执行。这个过程是通过HttpRemoteTask中的HttpClient将创建或者更新Task请求发送给数据所在节点上TaskResource所提供的RestFul接口,TaskResource接收到请求之后最终会在对应的Worker上启动一个SqlTaskExecution对象或者更新对应的SqlTaskExecution对象需要处理的Split。- 执行处于上游的

Source Stage中的Task,这些Task通过各种Connector从相应的数据源中读取所需要的数据。 - 处于下游的会读取上游

Stage产生的输出结果,并在该Stage每隔Task所在Worker的内存中进行后续的计算和处理。 Coordinator从分发的Task之后,就会一直持续不断的从Single Stage中的Task获取计算结果,并将计算结果缓存到Buffer中,直到所有的计算结束。Client从提交查询语句之后,就会不断地从Coordinator中获取本次查询的计算结果,直到获得了所有的计算记过。并不是等到所有的查询结果都产生完毕之后一次全部显示出来,而是每产生一部分,就会显示一部分,直到所有的查询结果都显示完毕。

1.4、Presto的优缺点

1.4.1、优点

- Presto是基于内存运算,减少没必要的硬盘IO,所以更快。

- 能够连接多个数据源,跨数据源连表查,如从Hive查询大量网站访问记录,然后从Mysql中匹配出设备信息。

1.4.2、缺点

-

虽然能够处理PB级别的海量数据分析,但不是代表Presto把PB级别都放在内存中计算的。而是根据场景,如count,avg等聚合运算,是边读数据边计算,再清内存,再读数据再计算,这种耗的内存并不高。但是连表查,就可能产生大量的临时数据,因此速度会变慢,反而hive此时会更擅长。

-

为了达到实时查询,可能会想到用它直连MySql来操作查询,这效率并不会提升,瓶颈依然在MySql,此时还引入网络瓶颈,所以会比原本直接操作数据库要慢。

-

虽然Presto可以解析SQL,但它不是一个标准的数据库。不是MySQL、PostgreSQL或者Oracle的代替品,也不能用来处理在线事务(OLTP)。

2、Presto的安装

2.1、Presto Server安装

-

官网地址

-

下载地址

https://repo1.maven.org/maven2/com/facebook/presto/presto-server/0.196/presto-server-0.196.tar.gz

- 将

presto-server-0.196.tar.gz导入hadoop102的/opt/software目录下,并解压到/opt/model目录

[song@hadoop102 software]$ tar -zxvf presto-server-0.196.tar.gz -C /opt/model/

- 修改名称为presto

[song@hadoop102 model]$ mv presto-server-0.196/ presto

- 进入到/opt/model/presto目录,并创建存储数据文件夹

[song@hadoop102 presto]$ mkdir data

- 进入到

/opt/model/presto目录,并创建存储配置文件文件夹

[song@hadoop102 presto]$ mkdir etc

- 配置在

/opt/model/presto/etc目录下添加jvm.config配置文件

[song@hadoop102 etc]$ vim jvm.config

添加如下内容

-server

-Xmx16G

-XX:+UseG1GC

-XX:G1HeapRegionSize=32M

-XX:+UseGCOverheadLimit

-XX:+ExplicitGCInvokesConcurrent

-XX:+HeapDumpOnOutOfMemoryError

-XX:+ExitOnOutOfMemoryError

Presto可以支持多个数据源,在Presto里面被叫做catalog,这里我们配置支持Hive的数据源,配置一个Hive的catalog

[song@hadoop102 etc]$ mkdir catalog

[song@hadoop102 catalog]$ vim hive.properties

添加如下内容

connector.name=hive-hadoop2

hive.metastore.uri=thrift://hadoop102:9083

- 将hadoop102上的presto分发到hadoop103、hadoop104

[song@hadoop102 module]$ xsync presto

- 分发之后,分别进入

hadoop102、hadoop103、hadoop104三台主机的/opt/model/presto/etc的路径。配置node属性,node id每个节点都不一样。

[song@hadoop102 etc]$vim node.properties

node.environment=production

node.id=ffffffff-ffff-ffff-ffff-ffffffffffff

node.data-dir=/opt/module/presto/data

[song@hadoop103 etc]$vim node.properties

node.environment=production

node.id=ffffffff-ffff-ffff-ffff-fffffffffffe

node.data-dir=/opt/module/presto/data

[song@hadoop104 etc]$vim node.properties

node.environment=production

node.id=ffffffff-ffff-ffff-ffff-fffffffffffd

node.data-dir=/opt/module/presto/data

-

Presto是由一个

coordinator节点和多个worker节点组成。在hadoop102上配置成coordinator,在hadoop103、hadoop104上配置为worker。- hadoop102上配置coordinator节点

[song@hadoop102 etc]$ vim config.properties添加内容如下

coordinator=true node-scheduler.include-coordinator=false http-server.http.port=8881 query.max-memory=50GB discovery-server.enabled=true discovery.uri=http://hadoop102:8881- hadoop103、hadoop104上配置worker节点

[song@hadoop103 etc]$ vim config.properties添加内容如下

coordinator=false http-server.http.port=8881 query.max-memory=50GB discovery.uri=http://hadoop102:8881[song@hadoop104 etc]$ vim config.properties添加内容如下

coordinator=false http-server.http.port=8881 query.max-memory=50GB discovery.uri=http://hadoop102:8881 -

在hadoop102的

/opt/model/hive目录下,启动Hive Metastore,用song角色

[song@hadoop102 hive]$

nohup bin/hive --service metastore >/dev/null 2>&1 &

- 分别在

hadoop102、hadoop103、hadoop104上启动Presto Server

- 前台启动Presto,控制台显示日志

[song@hadoop102 presto]$ bin/launcher run

[song@hadoop103 presto]$ bin/launcher run

[song@hadoop104 presto]$ bin/launcher run

- 后台启动Presto

[song@hadoop102 presto]$ bin/launcher start

[song@hadoop103 presto]$ bin/launcher start

[song@hadoop104 presto]$ bin/launcher start

- 日志查看路径

/opt/model/presto/data/var/log

2.2、Presto命令行Client安装

- 下载Presto的客户端

https://repo1.maven.org/maven2/com/facebook/presto/presto-cli/0.196/presto-cli-0.196-executable.jar

- 将

presto-cli-0.196-executable.jar上传到hadoop102的/opt/model/presto文件夹下 - 修改文件名称

[song@hadoop102 presto]$ mv presto-cli-0.196-executable.jar prestocli

- 增加执行权限

[song@hadoop102 presto]$ chmod +x prestocli

- 启动prestocli

[song@hadoop102 presto]$ ./prestocli --server hadoop102:8881 --catalog hive --schema default

- Presto命令行操作

Presto的命令行操作,相当于Hive命令行操作。每个表必须要加上schema。例如:select * from schema.table limit 100

2.3、Presto可视化Client安装

- 将

yanagishima-18.0.zip上传到hadoop102的/opt/model目录 - 解压缩yanagishima

[song@hadoop102 module]$ unzip yanagishima-18.0.zip

[song@hadoop102 module]$ cd yanagishima-18.0

- 进入到

/opt/model/yanagishima-18.0/conf文件夹,编写yanagishima.properties配置

[song@hadoop102 conf]$ vim yanagishima.properties

添加如下内容

jetty.port=7080

presto.datasources=atguigu-presto

presto.coordinator.server.atguigu-presto=http://hadoop102:8881

catalog.atguigu-presto=hive

schema.atguigu-presto=default

sql.query.engines=presto

- 在

/opt/model/yanagishima-18.0路径下启动yanagishima

[song@hadoop102 yanagishima-18.0]$ nohup bin/yanagishima-start.sh >y.log 2>&1 &

-

启动web页面

http://hadoop102:7080 -

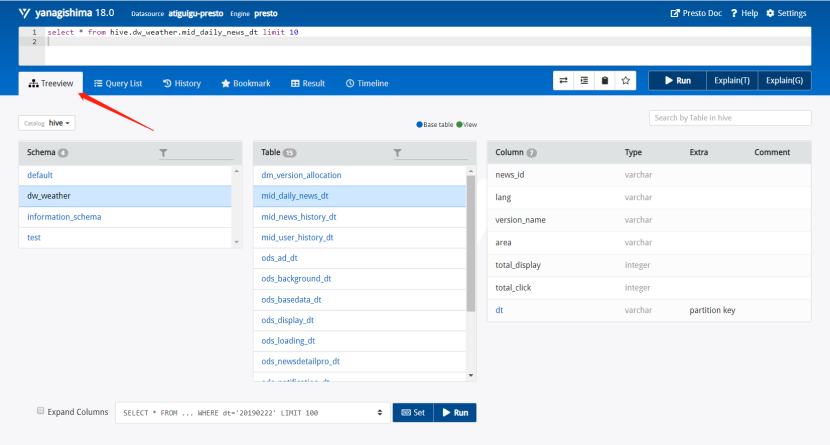

查看表结构

这里有个Tree View,可以查看所有表的结构,包括Schema、表、字段等。

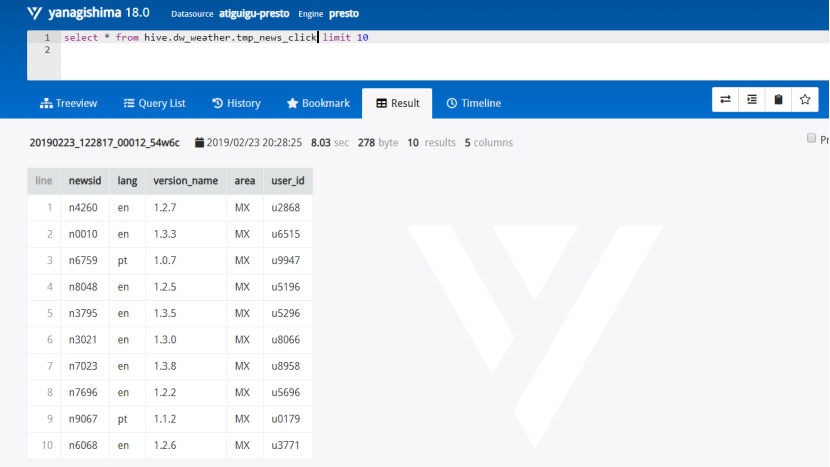

比如执行select * from hive.dw_weather.tmp_news_click limit 10,这个句子里Hive这个词可以删掉,是上面配置的Catalog

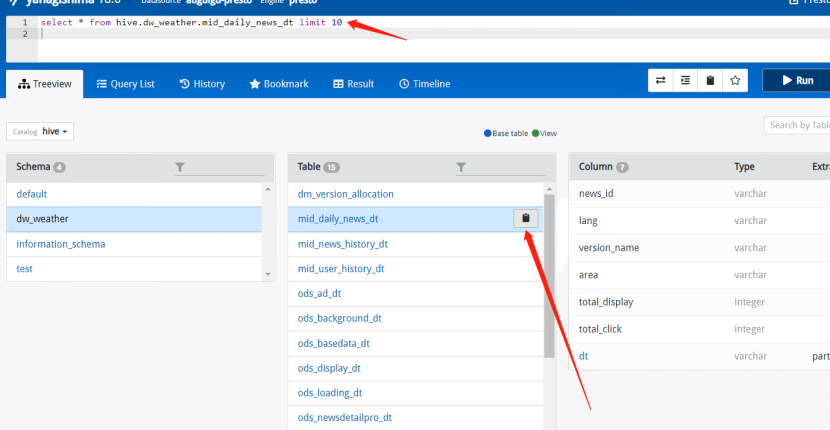

每个表后面都有个复制键,点一下会复制完整的表名,然后再上面框里面输入sql语句,ctrl+enter键执行显示结果

3、Presto的优化

3.1、Presto优化之数据存储

3.1.1、合理设置分区

与Hive类似,Presto会根据元数据信息读取分区数据,合理的分区能减少Presto数据读取量,提升查询性能。

3.1.2、使用列式存储

Presto对ORC文件读取做了特定优化,因此在Hive中创建Presto使用的表时,建议采用ORC格式存储。相对于Parquet,Presto对ORC支持更好。

3.1.3、使用压缩

数据压缩可以减少节点间数据传输对IO带宽压力,对于即席查询需要快速解压,建议采用Snappy压缩。

3.2、Presto优化之查询SQL

3.2.1、只选择使用的字段

由于采用列式存储,选择需要的字段可加快字段的读取、减少数据量。避免采用*读取所有字段。

[GOOD]: SELECT time, user, host FROM tbl

[BAD]: SELECT * FROM tbl

3.2.2、过滤条件最好加上分区字段

对于有分区的表,where语句中优先使用分区字段进行过滤。acct_day是分区字段,visit_time是具体访问时间。

[GOOD]: SELECT time, user, host FROM tbl where acct_day=20171101

[BAD]: SELECT * FROM tbl where visit_time=20171101

3.2.3、Group By语句优化

合理安排Group by语句中字段顺序对性能有一定提升。将Group By语句中字段按照每个字段distinct数据多少进行降序排列。

[GOOD]: SELECT GROUP BY uid, gender

[BAD]: SELECT GROUP BY gender, uid

3.2.4、Order by时最好使用Limit

Order by需要扫描数据到单个worker节点进行排序,导致单个worker需要大量内存。如果是查询Top N或者Bottom N,使用limit可减少排序计算和内存压力。

[GOOD]: SELECT * FROM tbl ORDER BY time LIMIT 100

[BAD]: SELECT * FROM tbl ORDER BY time

3.2.5、使用Join语句时将大表放在左边

Presto中join的默认算法是broadcast join,即将join左边的表分割到多个worker,然后将join右边的表数据整个复制一份发送到每个worker进行计算。如果右边的表数据量太大,则可能会报内存溢出错误。

[GOOD] SELECT ... FROM large_table l join small_table s on l.id = s.id

[BAD] SELECT ... FROM small_table s join large_table l on l.id = s.id

3.3、注意事项

3.3.1、字段名引用

避免和关键字冲突:MySQL对字段加反引号、Presto对字段加双引号分割

当然,如果字段名称不是关键字,可以不加这个双引号。

3.3.2、时间函数

对于Timestamp,需要进行比较的时候,需要添加Timestamp关键字,而MySQL中对Timestamp可以直接进行比较。

/*MySQL的写法*/

SELECT t FROM a WHERE t > '2017-01-01 00:00:00';

/*Presto中的写法*/

SELECT t FROM a WHERE t > timestamp '2017-01-01 00:00:00';

3.3.3、不支持INSERT OVERWRITE语法

Presto中不支持insert overwrite语法,只能先delete,然后insert into。

3.3.4、PARQUET格式

Presto目前支持Parquet格式,支持查询,但不支持insert。