环境

- python 3.9

- numpy 1.24.1

- pytorch 2.0.0+cu117

一、Batch Normalize 作用

- 加快收敛、提升精度:对输入进行归一化,从而使得优化更加容易

- 减少过拟合:可以减少方差的偏移

- 可以使得神经网络使用更高的学习率:BN 使得神经网络更加稳定,从而可以使用更大的学习率,加速训练过程

- 甚至可以减少 Dropout 的使用:因为 BN 可以减少过拟合,所以有了 BN,可以减少其他正则化技术的使用

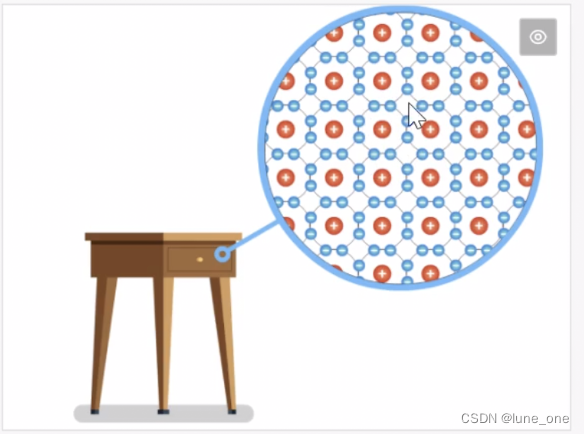

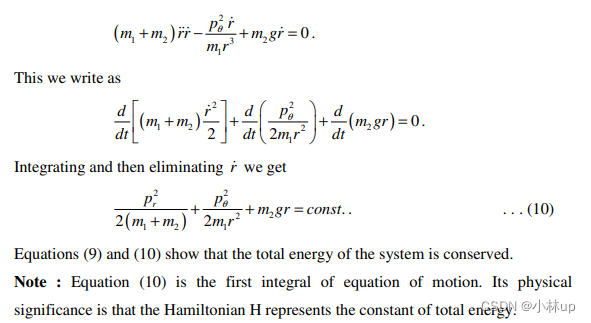

二、数据归一化

方法1) [0,1]归一化,使结果值映射到[0,1]之间

方法2)正态分布归一化,这种方法给予原始数据的均值(mean)和标准差(standard deviation)进行数据的标准化。经过处理的数据符合标准正态分布,即均值为0,标准差为1

![[CF复盘] Codeforces Round 874 (Div. 3) 20230520】](https://img-blog.csdnimg.cn/a1023d0502f64d65877a22a7d9611454.png)