同品:

filebeat:只做数据收集,讲数据输出到指定目的地,占用资源小

logstash:收集日志数据,还能过滤,转换数据,组需要更多资源

目录

1.logstash的安装

2.配置文件

3.创建容器

4.引入依赖

5.添加logback文件

6.查询使用

7.Filebeat安装以及使用

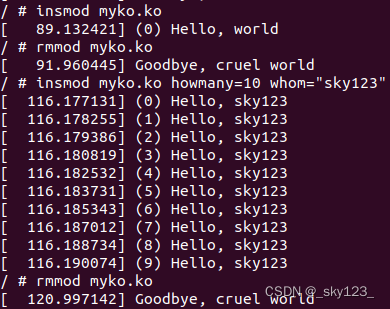

1.logstash的安装

docker pull logstash:7.8.0

2.配置文件

vim /mydata/logstash/logstash.conf

input {

tcp {

mode => "server"

host => "0.0.0.0"

port => 5044

codec => json_lines

}

}

filter{

}

output {

elasticsearch {

#指定安装的es的地址

hosts => "192.168.200.128:9200"

index => "gmall-%{+YYYY.MM.dd}"

}

}3.创建容器

docker run --name gmalldocker_logstash -p 5044:5044 \

--restart=always \

--link gmalldocker_elasticsearch:es \

-v /mydata/logstash/logstash.conf:/usr/share/logstash/pipeline/logstash.conf \

-d logstash:7.8.04.引入依赖

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.1</version>

</dependency>5.添加logback文件

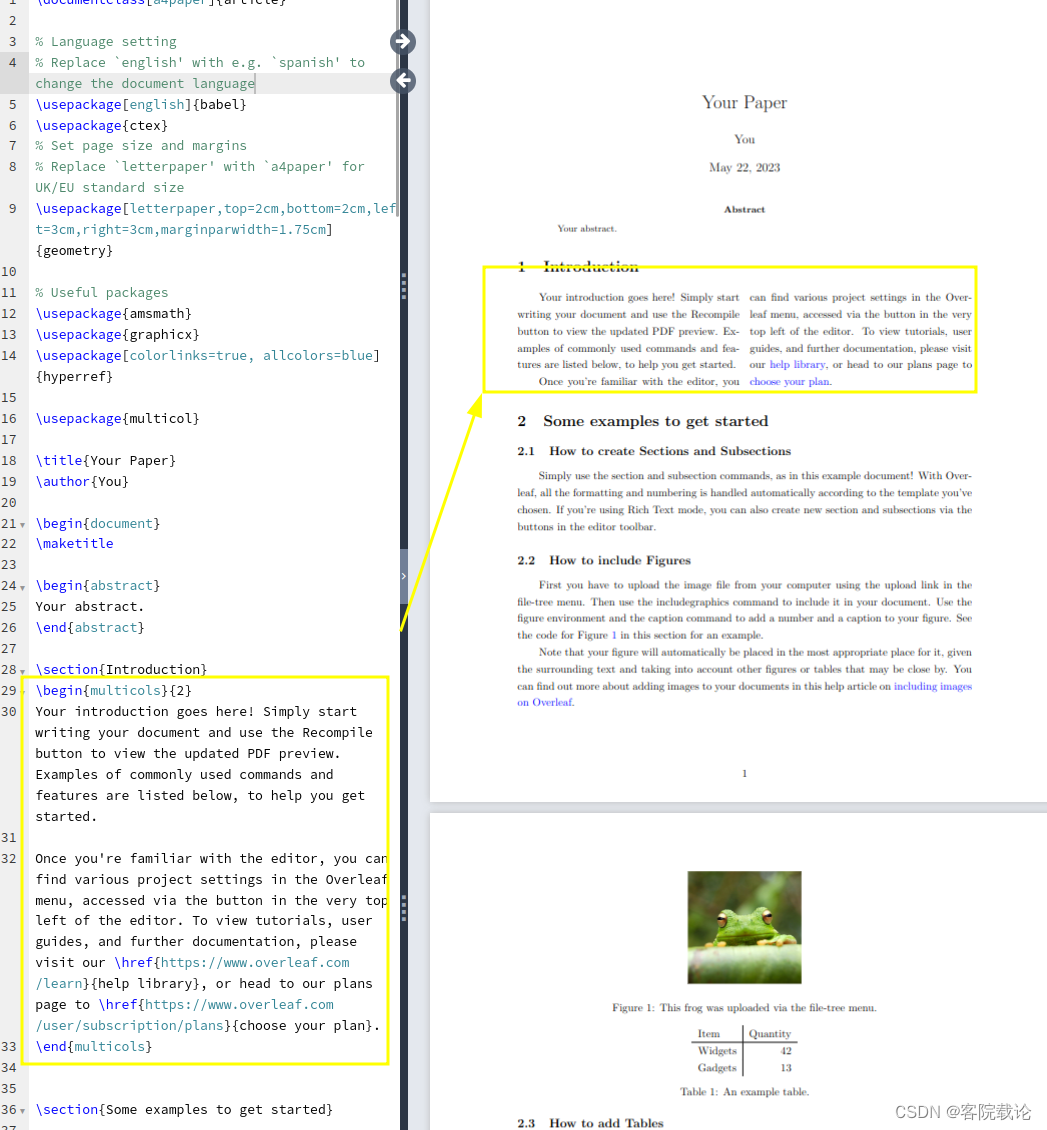

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<contextName>logback</contextName>

<!-- 日志的输出目录 -->

<property name="log.path" value="D:/logs/gmall/list" />

<!--控制台日志格式:彩色日志-->

<!-- magenta:洋红 -->

<!-- boldMagenta:粗红-->

<!-- cyan:青色 -->

<!-- white:白色 -->

<!-- magenta:洋红 -->

<property name="CONSOLE_LOG_PATTERN"

value="%yellow(%date{yyyy-MM-dd HH:mm:ss}) %highlight([%-5level]) %green(%logger) %msg%n"/>

<!--文件日志格式-->

<property name="FILE_LOG_PATTERN"

value="%date{yyyy-MM-dd HH:mm:ss} [%-5level] %thread %file:%line %logger %msg%n" />

<!--编码-->

<property name="ENCODING"

value="UTF-8" />

<!-- 控制台日志 -->

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<!-- 临界值过滤器 -->

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>INFO</level>

</filter>

<encoder>

<!--CONSOLE_LOG_PATTERN 控制台格式 FILE_LOG_PATTERN 文件格式-->

<pattern>${CONSOLE_LOG_PATTERN}</pattern>

<charset>${ENCODING}</charset>

</encoder>

</appender>

<!-- 文件日志 -->

<appender name="FILE" class="ch.qos.logback.core.FileAppender">

<!--日志输出的目录是在哪?-->

<file>${log.path}/log.log</file>

<append>true</append>

<encoder>

<pattern>${FILE_LOG_PATTERN}</pattern>

<charset>${ENCODING}</charset>

</encoder>

</appender>

<appender name="ROLLING_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 级别过滤器 -->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>ACCEPT</onMatch><!-- 当前要输出的日志如果是ERROR级别,则输出 -->

<onMismatch>DENY</onMismatch><!-- 当前要输出的日志如果不是ERROR级别,则拒绝输出 -->

</filter>

<!-- 要区别于其他的appender中的文件名字 -->

<file>${log.path}/log-rolling-error.log</file>

<encoder>

<pattern>${FILE_LOG_PATTERN}</pattern>

<charset>${ENCODING}</charset>

</encoder>

<!-- 设置滚动日志记录的滚动策略 -->

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 日志归档路径以及格式 -->

<fileNamePattern>${log.path}/info/log-rolling-error-%d{yyyy-MM-dd}.%i.log</fileNamePattern>

<!--归档日志文件保留的最大数量-->

<maxHistory>15</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>100MB</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

</appender>

<!-- logstash日志 -->

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<!-- logstash ip和暴露的端口,logback就是通过这个地址把日志发送给logstash -->

<destination>192.168.200.128:5044</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder" />

</appender>

<!-- 开发环境 -->

<springProfile name="dev">

<!-- com.atguigu日志记录器:业务程序INFO,debug,warn,error级别 -->

<logger name="com.atguigu" level="INFO" />

<!-- 根日志记录器:INFO级别 -->

<root level="INFO">

<!--控制台输出模式-->

<appender-ref ref="CONSOLE" />

<!--FILE 文件基本输出-->

<!--<appender-ref ref="FILE" />-->

<!--有回滚日志记录-->

<appender-ref ref="ROLLING_FILE" />

<!--配置logstash 日志!-->

<appender-ref ref="LOGSTASH" />

</root>

</springProfile>

<!-- 生产或和试环境 -->

<!-- <springProfile name="test,prod">-->

<!-- <logger name="com.atguigu" level="INFO" additivity="false">-->

<!-- <appender-ref ref="CONSOLE" />-->

<!-- </logger>-->

<!-- <root level="ERROR">-->

<!-- <appender-ref ref="CONSOLE" />-->

<!-- <appender-ref ref="ROLLING_FILE" />-->

<!-- </root>-->

<!-- </springProfile>-->

</configuration>6.查询使用

启动后进行查询,查看索引。并进行查询相关内容。

进行查询相关值。

GET /gmall-2023.05.22/_search

{

"query": {

"match": {

"level": "error"

}

},

"aggs": {

"infoAgg": {

"terms": {

"field": "level.keyword",

"size": 10

}

}

}

}

7.Filebeat安装以及使用

先授权权限

chmod 777 -R /var/log/messages

docker run -d \

--name=filebeat \

--restart=always \

-v filebeat-conf:/usr/share/filebeat \

-v /var/log/messages:/var/log/messages \

--link 906eb54816be:gmalldocker_elasticsearch \

elastic/filebeat:7.8.0

#906eb54816be是容器名字

修改配置文件,是yml形式的

ps:set nu:表示显示文件的行号

dd:删除当行

%d:删除n行数据

d行号

进入到目录:

cd /var/lib/docker/volumes/filebeat-conf/_data

修改配置文件

vim filebeat.yml

内容如下

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/messages

filebeat.config:

modules:

path: ${path.config}/modules.d/*.yml

reload.enabled: false

processors:

- add_cloud_metadata: ~

- add_docker_metadata: ~

output.elasticsearch:

hosts: 'es网址:9200'

indices:

- index: "filebeat-%{+yyyy.MM.dd}"重启filebeat