学到如今,我实在明白了一个至关重要的东西,那就是目标很重要,有了清晰的目标我们就知道该做什么,不至于迷茫,否则每天都在寻找道路。所以我一直在规划这样一条道路,让想学习的人可以抛下不知道该怎么做的顾虑,不至于每天迷茫在该怎么做当中。力量是宝贵的,应该被花在真正知识的学习上,而不是被消耗在寻找道路的迷惘上。所以,我自己也一直在探索学习方法,如何不偏离主线。

其次,学习一样东西,一定要先弄清楚其本源,要搞明白它是什么,原理、机制、应用…在此基础之上去学习就会少走许多弯路。

今天跑代码时突然遇到一个问题

Traceback (most recent call last):

File "<input>", line 1, in <module>

File "C:\Program Files\JetBrains\PyCharm 2021.2.2\plugins\python\helpers\pydev\_pydev_bundle\pydev_umd.py", line 198, in runfile

pydev_imports.execfile(filename, global_vars, local_vars) # execute the script

File "C:\Program Files\JetBrains\PyCharm 2021.2.2\plugins\python\helpers\pydev\_pydev_imps\_pydev_execfile.py", line 18, in execfile

exec(compile(contents+"\n", file, 'exec'), glob, loc)

File "C:/Python program/DeepRL-CNN-LSTM_dlsf/Deep-Learning/DeepRL-CUDA.py", line 21, in <module>

torch.set_default_tensor_type('torch.cuda.FloatTensor')

File "C:\Users\admin\anaconda3\envs\py37\lib\site-packages\torch\__init__.py", line 348, in set_default_tensor_type

_C._set_default_tensor_type(t)

TypeError: type torch.cuda.FloatTensor not available. Torch not compiled with CUDA enabled.

没有cuda,我没搞明白,前两天我刚升级了pytorch的版本,因为有个程序必须要设计torch版本才能运行,所以我就以为是升级导致的问题,然后我再去看一个代码,发现:

Could not load dynamic library 'cudart64_101.dll'; dlerror: cudart64_101.dll not found

结合代码

use_cuda = torch.cuda.is_available()

if use_cuda:

device = torch.device('cuda')

print("using GPU")

else:

device = torch.device('cpu')

print("using CPU")

我这里是不是就是没有装cuda啊,我突然想到。但是我又不太明白cuda是什么具体作用,于是请教ChatGPT。

问:cuda的作用是什么?

答:

CUDA(Compute Unified Device Architecture)是由 NVIDIA 开发的并行计算平台和编程模型,用于利用 NVIDIA GPU 进行高性能计算和加速各种计算任务。CUDA 的作用如下:

并行计算加速:CUDA 允许开发者在 GPU 上并行执行计算任务,从而大幅提升计算性能。相比于传统的 CPU,GPU 拥有更多的处理核心和高并行计算能力,能够同时处理大量的数据和任务。CUDA 提供了编程模型和工具,使开发者能够有效地利用 GPU 的并行计算能力,加速各种计算密集型任务,如科学计算、深度学习、图形处理等。

深度学习加速:CUDA 在深度学习领域发挥着重要作用。深度学习模型通常具有大量的计算和参数,需要进行大规模的矩阵计算和神经网络训练。通过利用 CUDA,可以将这些计算任务映射到 GPU 上并行执行,加快深度学习模型的训练和推理速度,使其更加高效。

科学计算和数值模拟:CUDA 适用于各种科学计算和数值模拟任务,如物理模拟、天气预报、流体力学、分子动力学模拟等。这些任务通常需要大量的计算和数据处理,通过利用 GPU 的并行计算能力,可以大幅加速这些计算过程,缩短计算时间。

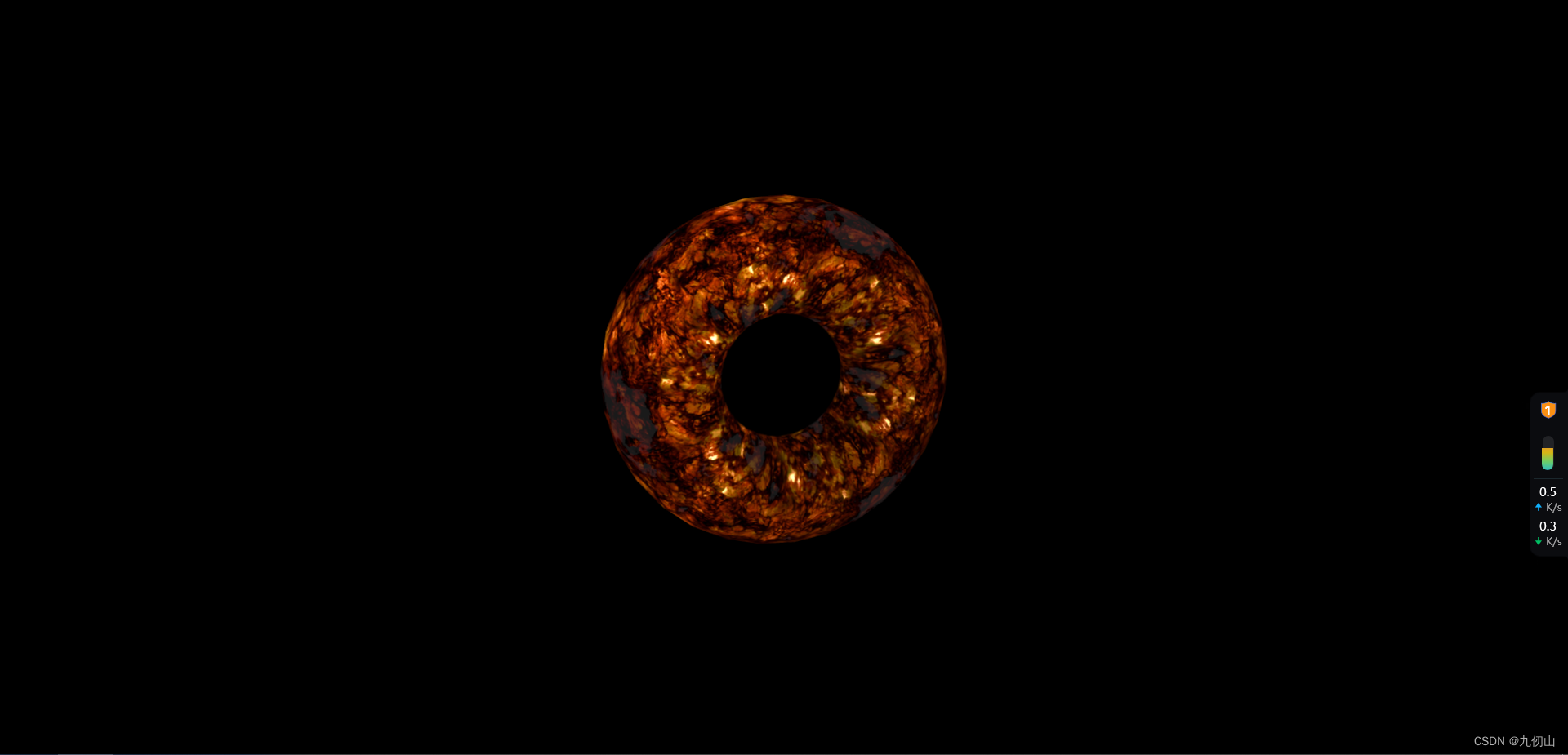

图形处理和渲染:CUDA 也用于图形处理和渲染领域。通过利用 GPU 的并行计算能力,可以加速图形渲染过程,实现更高质量的图形效果和更流畅的动画。

总的来说,CUDA 提供了一种强大的工具和编程模型,使开发者能够利用 GPU 的并行计算能力,加速各种计算密集型任务,包括深度学习、科学计算、图形处理等。它对于需要大规模并行计算的任务具有重要的意义,能够显著提升计算性能和效率。

问:没有cuda也可以使用GPU吗?

答:是的,即使没有 CUDA,也可以使用 GPU 进行计算加速,但 CUDA 是目前最常用和广泛支持的 GPU 计算平台和编程模型之一。

在没有 CUDA 的情况下,可以使用其他的 GPU 计算框架和库来进行 GPU 加速,例如 OpenCL、AMD ROCm、DirectX Compute Shader 等。这些框架和库提供了类似于 CUDA 的并行计算功能,并允许开发者在 GPU 上执行并行计算任务。

一些深度学习框架(如 TensorFlow 和 PyTorch)也提供了与多个 GPU 计算框架兼容的接口,以便在不同的 GPU 计算环境中进行加速计算。这些框架通常会根据可用的计算后端选择使用 CUDA 或其他 GPU 计算框架来进行计算加速。

总的来说,虽然 CUDA 是最常用和广泛支持的 GPU 计算平台,但在没有 CUDA 的情况下,仍然有其他的 GPU 计算框架和库可供选择,以实现 GPU 加速的计算任务。具体选择哪种 GPU 计算框架取决于你的需求和所使用的工具和库的兼容性。

问:cuda和pytorch有什么区别

ChatGPT

CUDA(Compute Unified Device Architecture)是由 NVIDIA 开发的并行计算平台和编程模型,用于利用 NVIDIA GPU 进行高性能计算和加速各种计算任务。它提供了一种方式,使开发者能够在 GPU 上编写并行计算任务,从而实现计算加速。

PyTorch 是一个开源的深度学习框架,它提供了丰富的工具和接口,用于构建和训练深度神经网络模型。PyTorch 支持使用 CUDA 进行 GPU 加速,允许在 GPU 上执行深度学习计算,从而加速模型的训练和推理过程。

区别如下:

功能和目的:CUDA 是一个并行计算平台和编程模型,旨在利用 GPU 进行高性能计算和加速各种计算任务。而 PyTorch 是一个深度学习框架,旨在提供丰富的工具和接口,简化构建和训练深度神经网络模型的过程。

使用范围:CUDA 可以用于各种计算密集型任务,包括科学计算、数值模拟、图形处理等。而 PyTorch 主要用于深度学习任务,如图像分类、目标检测、自然语言处理等。

编程模型:CUDA 提供了一种编程模型,允许开发者在 GPU 上编写并行计算任务,使用 CUDA C/C++、CUDA Python 等编程语言进行开发。而 PyTorch 使用 Python 作为主要的编程语言,并提供了高级的深度学习接口和自动求导功能。

生态系统和社区支持:CUDA 拥有广泛的生态系统和强大的社区支持,包括各种 GPU 计算库、工具和开发者社区。PyTorch 也拥有庞大的社区支持,并与其他深度学习框架兼容,提供了丰富的预训练模型和扩展库。

总的来说,CUDA 是一个 GPU 计算平台和编程模型,用于利用 GPU 进行高性能计算。而 PyTorch 是一个深度学习框架,使用 CUDA 来实现在 GPU 上进行深度学习计算的加速。CUDA 提供了底层的 GPU 编程能力,而 PyTorch 则提供了高级的深度学习接口和功能。

问:cuda是编程语言吗

答:

CUDA(Compute Unified Device Architecture)不是一种编程语言,而是由 NVIDIA 开发的并行计算平台和编程模型。

CUDA 平台允许开发者使用不同的编程语言(如 CUDA C/C++、CUDA Python、CUDA Fortran)来编写并行计算任务。这些编程语言使用 CUDA 提供的扩展和库函数,以利用 NVIDIA GPU 的并行计算能力。

CUDA C/C++ 是最常用的 CUDA 编程语言,它是一种基于 C/C++ 的编程语言扩展,提供了针对 GPU 的并行计算的语法和库函数。CUDA C/C++ 可以与常规的 C/C++ 代码混合使用,通过编写 CUDA 核函数和使用 CUDA 线程层次结构,开发者可以在 GPU 上进行并行计算。

除了 CUDA C/C++,CUDA 还提供了针对其他编程语言的扩展和工具。CUDA Python 是使用 Python 语言进行 GPU 编程的一种方式,通过使用 CUDA 提供的 Python 接口和库函数,开发者可以在 Python 中进行 GPU 加速的计算。此外,CUDA 还支持 Fortran 和其他编程语言的扩展,以满足不同开发者的需求。

总结来说,CUDA 并不是一种独立的编程语言,而是提供了对不同编程语言的扩展和支持,使开发者能够在 GPU 上进行并行计算任务。开发者可以使用 CUDA 提供的编程语言扩展来编写并行计算任务,并利用 NVIDIA GPU 的并行计算能力。

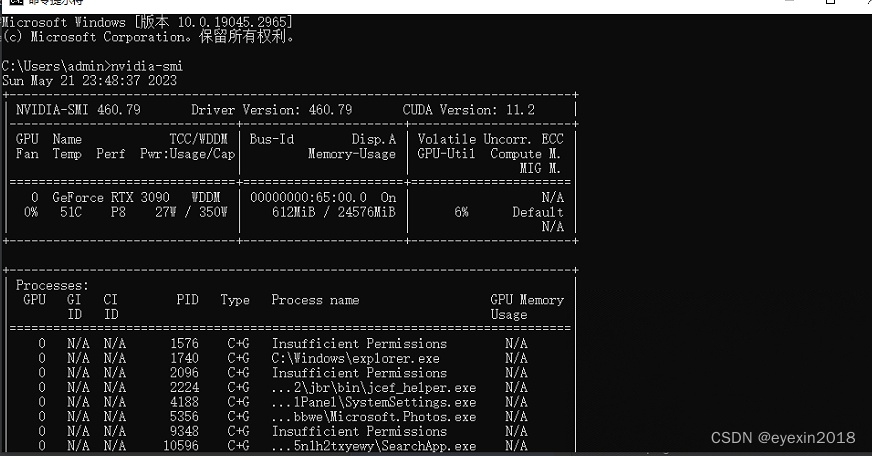

然后,自己在电脑是查一查

nvidia-smi

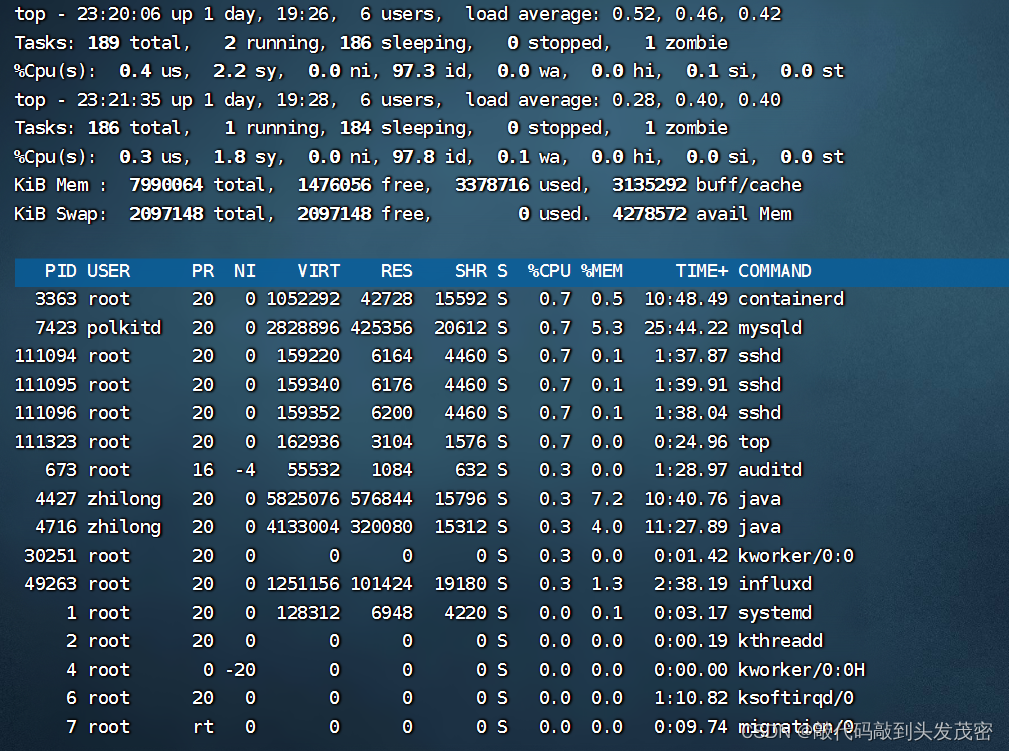

注意看,我这里cuda的版本是11.2,可我前两天把torch升级到version 1.13.1了,这是最新版,而它已经不支持cuda10.2和11.3版本了,哎,太悲伤了。

具体版本的对应请直接去官网查看,非常详细,一一对应

https://pytorch.org/get-started/previous-versions/

利用anaconda安装的方法

# CUDA 11.3

conda install pytorch==1.12.1 torchvision==0.13.1 torchaudio==0.12.1 cudatoolkit=11.3 -c pytorch

# CUDA 11.6

conda install pytorch==1.12.1 torchvision==0.13.1 torchaudio==0.12.1 cudatoolkit=11.6 -c pytorch -c conda-forge

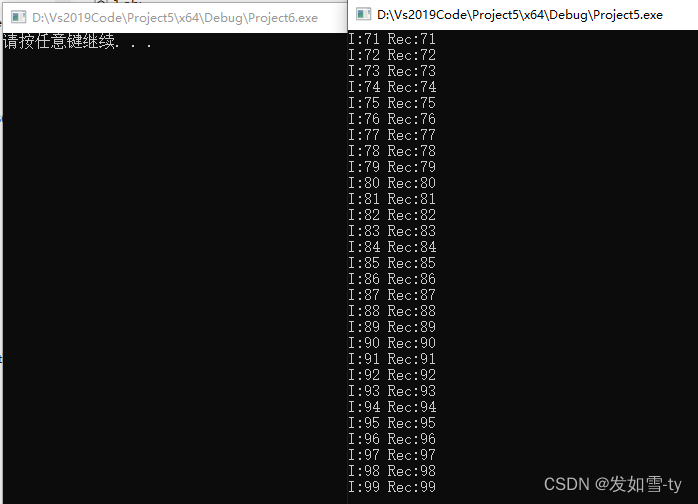

选择自己适合的安装即可。这么处理后cuda的问题就解决了,现在代码已经可以运行了

安装的时候注意区分,因为有pytorch和torch,虽然它俩是同一个对象,但是你要进行替换的话还是看清楚