大家好,我是微学AI,今天给大家介绍一下人工智能基础部分16-神经网络与GPU加速训练的原理与应用,在深度学习领域,神经网络已经成为了一种流行的、表现优秀的技术。然而,随着神经网络的规模越来越大,训练神经网络所需的时间和计算资源也在快速增长。为加速训练过程,研究者们开始利用图形处理器(GPU)来进行并行计算。在本文中,我们将研究神经网络与GPU的关系,以及如何使用GPU加速神经网络训练。

一、神经网络与GPU的关系

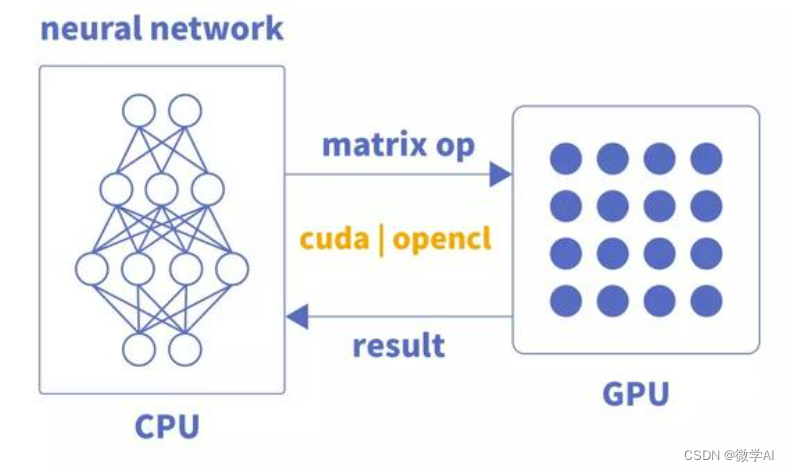

神经网络是一种模拟人脑神经元连接的计算系统,具有非常强大的表达和学习能力。与传统的计算机程序不同,神经网络是一个大规模并行的计算系统,因此天然适合于使用GPU进行并行计算。

GPU,全称是Graphical Processing Unit,中文为图形处理器。最初设计用于图形渲染任务。随着计算能力的提升,现在的GPU也被广泛应用于通用计算任务,如深度学习。相较于通用的CPU(中央处理器),GPU具有更多的内核,更大的内存带宽,从而能够更好地完成这些并行计算任务。

深度学习框架如TensorFlow和PyTorch等已经实现了利用GPU加速神经网络训练的功能。在接下来的部分,我们将详细介绍一个简单的神经网络实现,并展示如何使用PyTorch库和GPU加速训练。

二、 GPU的原理

GPU的基本原理是将大规模的并行计算任务拆分成更小的任务,并将其分发给GPU上的多个内核同时进行处理。这种基于数据并行的计算方式非常适合神经网络的训练。在神经网络的训练过程中,包括前向传播、反向传播和权重更新等步骤可以很容易地拆分成并行任务,因此利用GPU进行加速非常有效。

GPU是一种专门用于图形渲染、计算和加速的处理器。与CPU相比,GPU在大规模并行计算方面具有优势,因此被广泛应用于深度学习、科学计算、密码学等领域。

GPU的底层原理:

架构结构:GPU通过一系列流处理器来进行并行计算。每个流处理器(Stream Processor,SP)类似于CPU中的核心,可以执行独立的指令序列。不同的GPU架构会有不同的流处理器数量和组织方式。

内存结构:GPU通常使用全局内存和共享内存来存储数据。全局内存是所有流处理器都可以访问的内存,在访问时需要花费较长时间。而共享内存则位于每个流处理器的本地存储器中,访问速度更快,但容量较小。

计算模型:GPU采用SIMD(Single Instruction Multiple Data,单指令多数据)计算模型。即将一个指令同时应用于多个数据元素,从而实现高效的并行计算。例如,在矩阵乘法中,GPU可以同时对多个矩阵元素进行计算,极大地提高了计算速度。

数据传输:GPU与主机之间的数据传输通常通过PCIe总线进行。由于PCIe带宽较小,因此在大规模计算中可能会成为瓶颈。一些新型GPU支持NVLink技术,可以实现更高速的GPU-GPU和GPU-CPU数据传输。

编程模型:GPU编程通常使用CUDA、OpenCL等框架进行开发。这些框架提供了丰富的API和工具,方便开发者进行并行计算任务的编写和调试。

三、代码示例

为了演示如何使用PyTorch和GPU进行神经网络训练,我们以一个简单的多层感知机(MLP)为例。这是一个简单的线性二分类问题,我们使用随机生成的数据集进行训练。利用代码生成了一个包含1000个样本的数据集,每个样本具有20个特征。类别标签为0或1。

import numpy as np

np.random.seed(0)

NUM_SAMPLES = 1000

NUM_FEATURES = 20

X = np.random.randn(NUM_SAMPLES, NUM_FEATURES)

y = np.random.randint(0, 2, (NUM_SAMPLES,))

print("X shape:", X.shape)

print("y shape:", y.shape)

### 构建简单的神经网络

#接下来,我们使用PyTorch框架来构建一个简单的多层感知机。这个感知机包括一个输入层、一个隐藏层和一个输出层。

import torch

import torch.nn as nn

class SimpleMLP(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(SimpleMLP, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(hidden_size, output_size)

def forward(self, x):

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

return x

INPUT_SIZE = 20

HIDDEN_SIZE = 10

OUTPUT_SIZE = 1

model = SimpleMLP(INPUT_SIZE, HIDDEN_SIZE, OUTPUT_SIZE)

print(model)

### 训练神经网络

#现在,我们将训练这个简单神经网络。为了使用GPU进行训练,请确保已经安装了适当的PyTorch GPU版本。

# 判断是否有GPU可用,如果有,则将模型和数据移动到GPU

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

### 训练循环

#下面的代码将执行训练循环,并在每个循环后输出训练损失。

# 超参数设置

learning_rate = 0.001

num_epochs = 500

batch_size = 40

num_batches = NUM_SAMPLES // batch_size

# 创建优化器和损失函数

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

criterion = nn.BCEWithLogitsLoss()

# 转换数据为PyTorch张量

X = torch.tensor(X, dtype=torch.float32)

y = torch.tensor(y, dtype=torch.float32).unsqueeze(1)

# 训练循环

for epoch in range(num_epochs):

for i in range(num_batches):

start = i * batch_size

end = start + batch_size

inputs = X[start:end].to(device) # 将数据移动到GPU

targets = y[start:end].to(device) # 将数据移动到GPU

outputs = model(inputs)

loss = criterion(outputs, targets)

optimizer.zero_grad()

loss.backward()

optimizer.step()

print(f"Epoch [{epoch + 1}/{num_epochs}], Loss: {loss.item()}")运行结果:

,,,

Epoch [489/500], Loss: 0.476614773273468

Epoch [490/500], Loss: 0.47668877243995667

Epoch [491/500], Loss: 0.47654348611831665

Epoch [492/500], Loss: 0.47667455673217773

Epoch [493/500], Loss: 0.4764176309108734

Epoch [494/500], Loss: 0.476365864276886

Epoch [495/500], Loss: 0.47667425870895386

Epoch [496/500], Loss: 0.47667378187179565

Epoch [497/500], Loss: 0.4764541685581207

Epoch [498/500], Loss: 0.47650662064552307

Epoch [499/500], Loss: 0.47656387090682983

Epoch [500/500], Loss: 0.4765079915523529